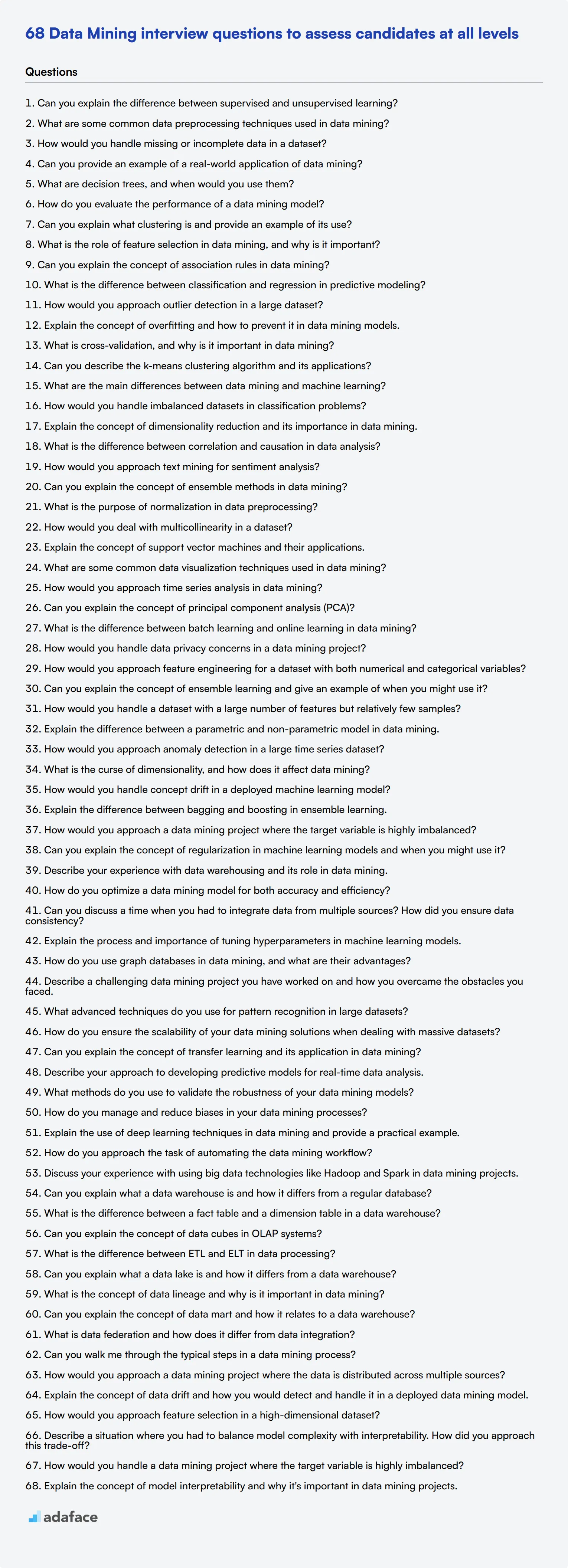

68 preguntas de entrevista sobre minería de datos para evaluar a candidatos de todos los niveles

La minería de datos es una habilidad crítica para muchos roles en el mundo empresarial actual, impulsado por los datos. Como reclutador o gerente de contratación, tener una lista de preguntas de entrevista específicas puede ayudarlo a evaluar eficazmente la experiencia en minería de datos de los candidatos y encontrar la persona adecuada para su equipo.

Este artículo proporciona un conjunto completo de preguntas de entrevista sobre minería de datos, organizado por nivel de experiencia y área temática. Desde conceptos generales para analistas junior hasta técnicas avanzadas para roles senior, encontrará preguntas para evaluar a los candidatos en cada etapa de su carrera en minería de datos.

Utilice estas preguntas para obtener información más profunda sobre las habilidades y los procesos de pensamiento de los solicitantes durante las entrevistas. Para una evaluación aún más completa, considere incorporar una evaluación de habilidades de minería de datos como parte de su proceso de selección.

Tabla de contenido

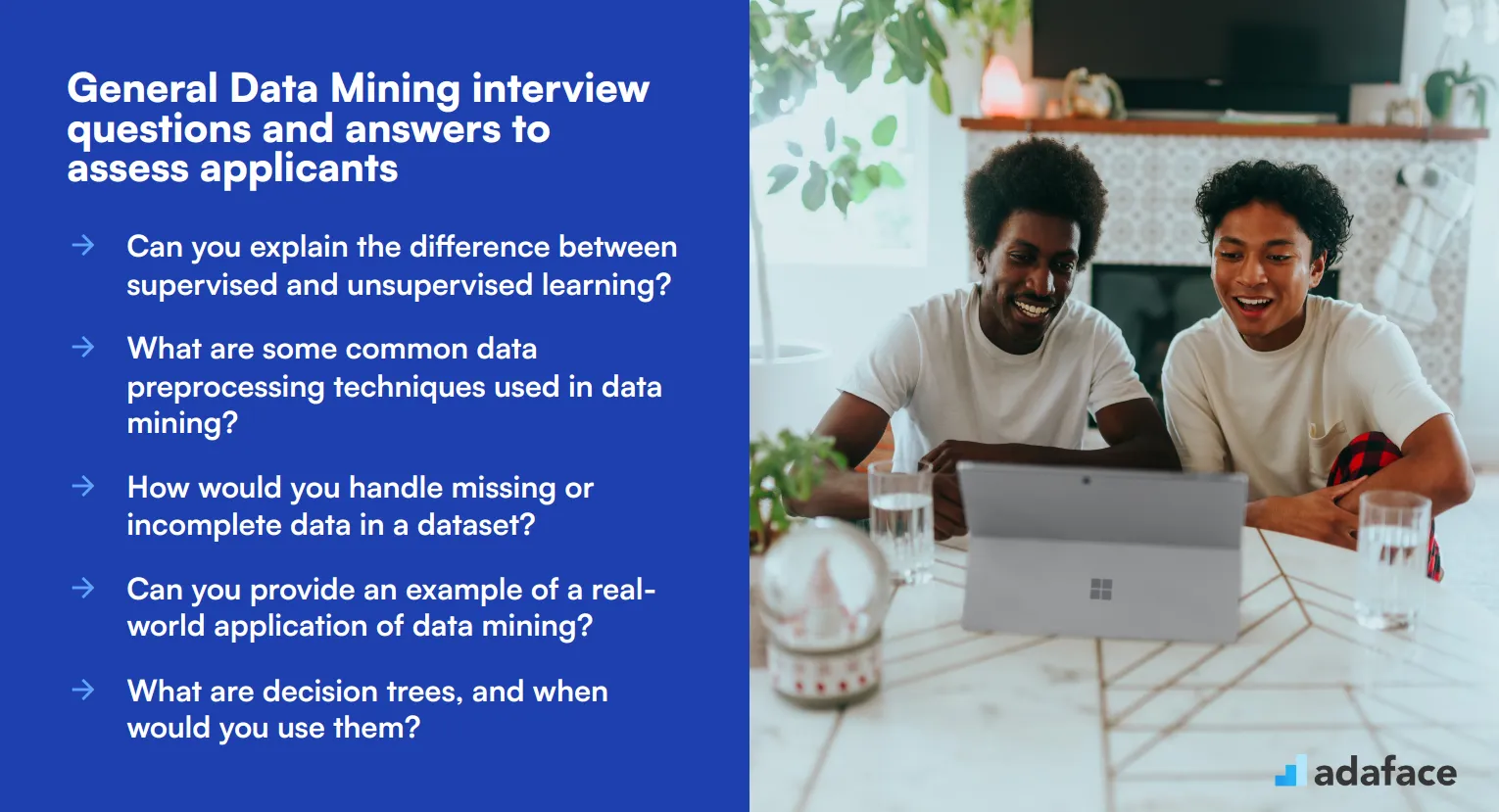

8 preguntas y respuestas generales de entrevista sobre minería de datos para evaluar a los solicitantes

20 preguntas de entrevista sobre minería de datos para hacer a los analistas junior

10 preguntas y respuestas intermedias de entrevista sobre minería de datos para hacer a los analistas de nivel medio

15 preguntas de entrevista avanzadas sobre minería de datos para hacer a los analistas senior

8 preguntas y respuestas de entrevista sobre minería de datos relacionadas con definiciones técnicas

7 preguntas y respuestas de entrevista sobre minería de datos relacionadas con procesos

¿Qué habilidades de minería de datos debe evaluar durante la fase de entrevista?

Contrata al mejor talento en minería de datos con pruebas de habilidades y preguntas de entrevista específicas.

Descarga la plantilla de preguntas para entrevistas de minería de datos en múltiples formatos.

8 preguntas y respuestas generales de entrevistas de minería de datos para evaluar a los candidatos

Para evaluar eficazmente si sus candidatos poseen una sólida comprensión de los conceptos de minería de datos y pueden aplicarlos en escenarios del mundo real, utilice estas preguntas de entrevista cuidadosamente seleccionadas. Estas preguntas están diseñadas para medir tanto sus conocimientos teóricos como sus habilidades prácticas en minería de datos.

1. ¿Puede explicar la diferencia entre el aprendizaje supervisado y el no supervisado?

El aprendizaje supervisado implica entrenar un modelo con datos etiquetados, lo que significa que los datos incluyen los pares de entrada-salida. El modelo aprende a predecir la salida a partir de los datos de entrada basándose en este entrenamiento.

El aprendizaje no supervisado, por otro lado, trata con datos no etiquetados. El modelo intenta identificar patrones y relaciones en los datos sin ninguna variable de salida específica que lo guíe. Ejemplos incluyen la agrupación y la asociación.

Busque candidatos que puedan articular claramente estas diferencias y proporcionar ejemplos de algoritmos utilizados en cada tipo. Continúe preguntando por aplicaciones del mundo real para asegurarse de que pueden contextualizar los conceptos.

2. ¿Cuáles son algunas técnicas comunes de preprocesamiento de datos utilizadas en la minería de datos?

El preprocesamiento de datos es crucial para preparar los datos sin procesar para el análisis. Las técnicas comunes incluyen la limpieza de datos, que implica el manejo de valores faltantes y valores atípicos; la normalización o escalado de datos, que asegura que las diferentes características de los datos estén en una escala similar; y la transformación de datos, que incluye la codificación de variables categóricas y la reducción de la dimensionalidad a través de métodos como PCA (Análisis de Componentes Principales).

Comprender estas técnicas es esencial para una minería de datos efectiva, ya que impactan directamente en la calidad de los resultados. Los candidatos deben demostrar familiaridad con estos métodos y su importancia para garantizar la precisión y confiabilidad de los resultados de la minería de datos.

3. ¿Cómo manejaría los datos faltantes o incompletos en un conjunto de datos?

El manejo de datos faltantes se puede abordar de varias maneras, dependiendo del contexto y la extensión de los valores faltantes. Los métodos comunes incluyen la eliminación de filas o columnas con valores faltantes, lo cual es factible cuando la pérdida de datos es mínima, o la imputación de valores faltantes utilizando métodos estadísticos como la imputación de la media, la mediana o la moda, o técnicas más sofisticadas como la imputación K-Nearest Neighbors (KNN).

Los candidatos también deben ser conscientes de las implicaciones de cada método en la integridad del conjunto de datos y el análisis posterior. Una respuesta ideal discutiría las compensaciones involucradas y la importancia del conocimiento del dominio para tomar la mejor decisión. ### 4. ¿Puede proporcionar un ejemplo de una aplicación real de la minería de datos?

Una aplicación común de la minería de datos es en la industria minorista para el análisis de la cesta de la compra. Esta técnica ayuda a los minoristas a comprender el comportamiento de compra de los clientes al identificar asociaciones entre diferentes productos. Por ejemplo, si los clientes a menudo compran pan y mantequilla juntos, las tiendas pueden colocar estos artículos cerca unos de otros para aumentar las ventas.

Otros ejemplos incluyen la detección de fraudes en la banca, donde se utilizan técnicas de minería de datos para identificar patrones inusuales que pueden indicar actividad fraudulenta, y el marketing personalizado, donde se analizan los datos de los clientes para adaptar las campañas de marketing a las preferencias individuales.

Busque candidatos que puedan proporcionar ejemplos claros y del mundo real y articular los beneficios y desafíos de estas aplicaciones. Esto demuestra su capacidad para aplicar el conocimiento teórico a situaciones prácticas. ### 5. ¿Qué son los árboles de decisión y cuándo los usaría?

Los árboles de decisión son un tipo de algoritmo de modelado predictivo utilizado para tareas de clasificación y regresión. Funcionan dividiendo los datos en subconjuntos basados en el valor de las características de entrada, creando una estructura de decisiones similar a un árbol. Cada nodo en el árbol representa una característica, cada rama representa una regla de decisión y cada hoja representa un resultado.

Los árboles de decisión son particularmente útiles cuando se necesita un modelo que sea fácil de interpretar y visualizar. Manejan tanto datos numéricos como categóricos y pueden capturar relaciones no lineales. Sin embargo, pueden ser propensos al sobreajuste si no se podan adecuadamente.

Un candidato ideal debe demostrar una comprensión tanto de las fortalezas como de las limitaciones de los árboles de decisión y discutir escenarios donde son particularmente efectivos, como en la segmentación de clientes o la evaluación de riesgos.

6. ¿Cómo se evalúa el rendimiento de un modelo de minería de datos?

Evaluar el rendimiento de un modelo de minería de datos implica varias métricas, dependiendo del tipo de tarea. Para las tareas de clasificación, las métricas comunes incluyen exactitud, precisión, recall, F1-score y AUC-ROC. Para las tareas de regresión, a menudo se utilizan métricas como el Error Absoluto Medio (MAE), el Error Cuadrático Medio (MSE) y el R-cuadrado.

La validación cruzada es otra técnica importante para la evaluación del modelo, ya que ayuda a garantizar que el modelo se generalice bien a datos no vistos. Implica dividir el conjunto de datos en múltiples pliegues y entrenar el modelo en diferentes subconjuntos mientras se evalúa en los datos restantes.

Los candidatos deben comprender la importancia de utilizar múltiples métricas para obtener una visión completa del rendimiento del modelo y evitar la dependencia excesiva de una sola métrica. Busque explicaciones que demuestren una clara comprensión de por qué estas métricas son importantes y cómo se pueden aplicar en la práctica.

7. ¿Puede explicar qué es el clustering y proporcionar un ejemplo de su uso?

El clustering es una técnica de aprendizaje no supervisado que se utiliza para agrupar puntos de datos similares en clústeres en función de sus características. El objetivo es maximizar la similitud dentro de los clústeres y minimizar la similitud entre los diferentes clústeres. K-means y el clustering jerárquico son algoritmos populares utilizados para este propósito.

Un ejemplo práctico de clustering se puede encontrar en la segmentación de clientes, donde las empresas agrupan a los clientes en función de su comportamiento de compra, datos demográficos u otros atributos. Esto ayuda a adaptar las estrategias de marketing y mejorar el servicio al cliente.

Evalúe si el candidato puede explicar claramente el concepto y discutir sus aplicaciones prácticas. Una respuesta ideal incluiría cómo el clustering ayuda a comprender mejor los datos y a tomar decisiones comerciales informadas.

8. ¿Cuál es el papel de la selección de características en la minería de datos y por qué es importante?

La selección de características implica elegir un subconjunto de características relevantes (variables) para usar en la construcción de modelos. Este proceso ayuda a mejorar el rendimiento del modelo al reducir el sobreajuste, mejorar la generalización del modelo y disminuir el tiempo de entrenamiento.

Las técnicas importantes para la selección de características incluyen métodos de filtro (como los coeficientes de correlación), métodos envolventes (como la eliminación recursiva de características) y métodos embebidos (como la importancia de las características de los modelos basados en árboles).

Los candidatos deben enfatizar la importancia de la selección de características en la creación de modelos eficientes y efectivos. Busque explicaciones detalladas de las diferentes técnicas y escenarios donde la selección de características ha mejorado notablemente los resultados de su modelo.

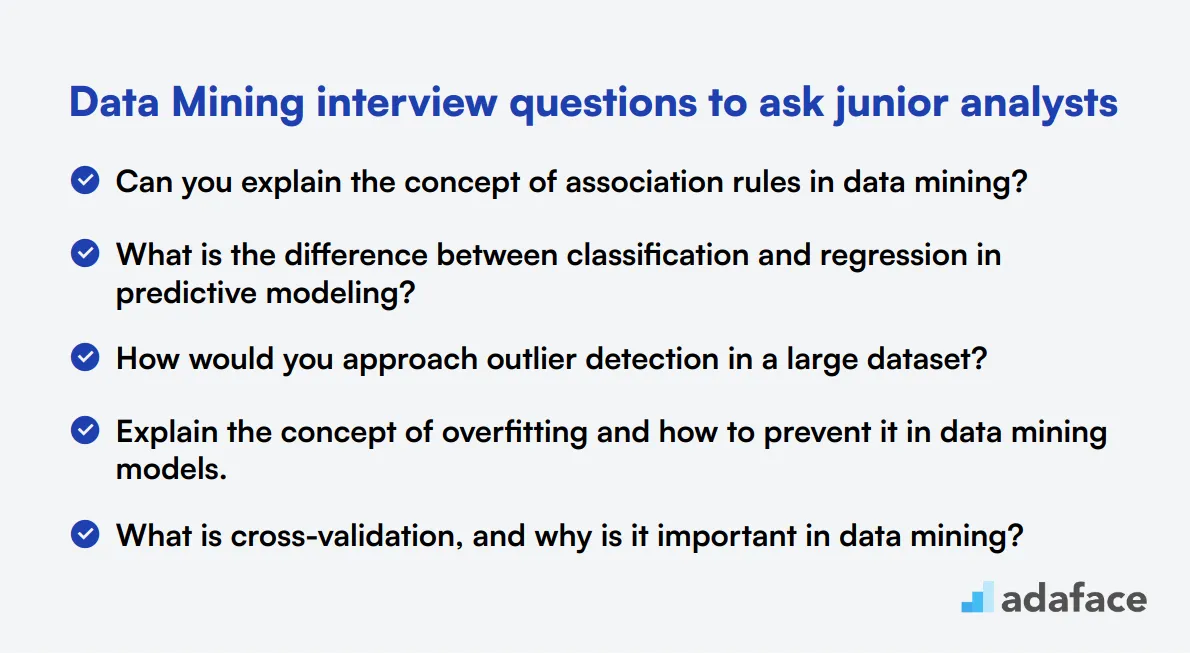

20 preguntas de entrevista de minería de datos para preguntar a analistas junior

Para evaluar a los analistas de datos junior data analysts de manera efectiva, use estas 20 preguntas de entrevista de minería de datos. Ayudan a medir la comprensión fundamental y las habilidades prácticas en técnicas de minería de datos, lo que garantiza que identifique a los candidatos con el potencial adecuado para su equipo.

- ¿Puedes explicar el concepto de reglas de asociación en la minería de datos? 2. ¿Cuál es la diferencia entre clasificación y regresión en modelado predictivo? 3. ¿Cómo abordarías la detección de valores atípicos en un conjunto de datos grande? 4. Explica el concepto de sobreajuste y cómo prevenirlo en los modelos de minería de datos. 5. ¿Qué es la validación cruzada y por qué es importante en la minería de datos? 6. ¿Puedes describir el algoritmo de agrupamiento k-means y sus aplicaciones? 7. ¿Cuáles son las principales diferencias entre la minería de datos y el aprendizaje automático? 8. ¿Cómo manejarías conjuntos de datos desequilibrados en problemas de clasificación? 9. Explica el concepto de reducción de dimensionalidad y su importancia en la minería de datos. 10. ¿Cuál es la diferencia entre correlación y causalidad en el análisis de datos? 11. ¿Cómo abordarías la minería de texto para el análisis de sentimiento? 12. ¿Puedes explicar el concepto de métodos de ensemble en la minería de datos? 13. ¿Cuál es el propósito de la normalización en el preprocesamiento de datos? 14. ¿Cómo lidiarías con la multicolinealidad en un conjunto de datos? 15. Explica el concepto de máquinas de vectores de soporte y sus aplicaciones. 16. ¿Cuáles son algunas técnicas comunes de visualización de datos utilizadas en la minería de datos? 17. ¿Cómo abordarías el análisis de series temporales en la minería de datos? 18. ¿Puedes explicar el concepto de análisis de componentes principales (PCA)? 19. ¿Cuál es la diferencia entre el aprendizaje por lotes y el aprendizaje en línea en la minería de datos? 20. ¿Cómo abordarías las preocupaciones sobre la privacidad de los datos en un proyecto de minería de datos?

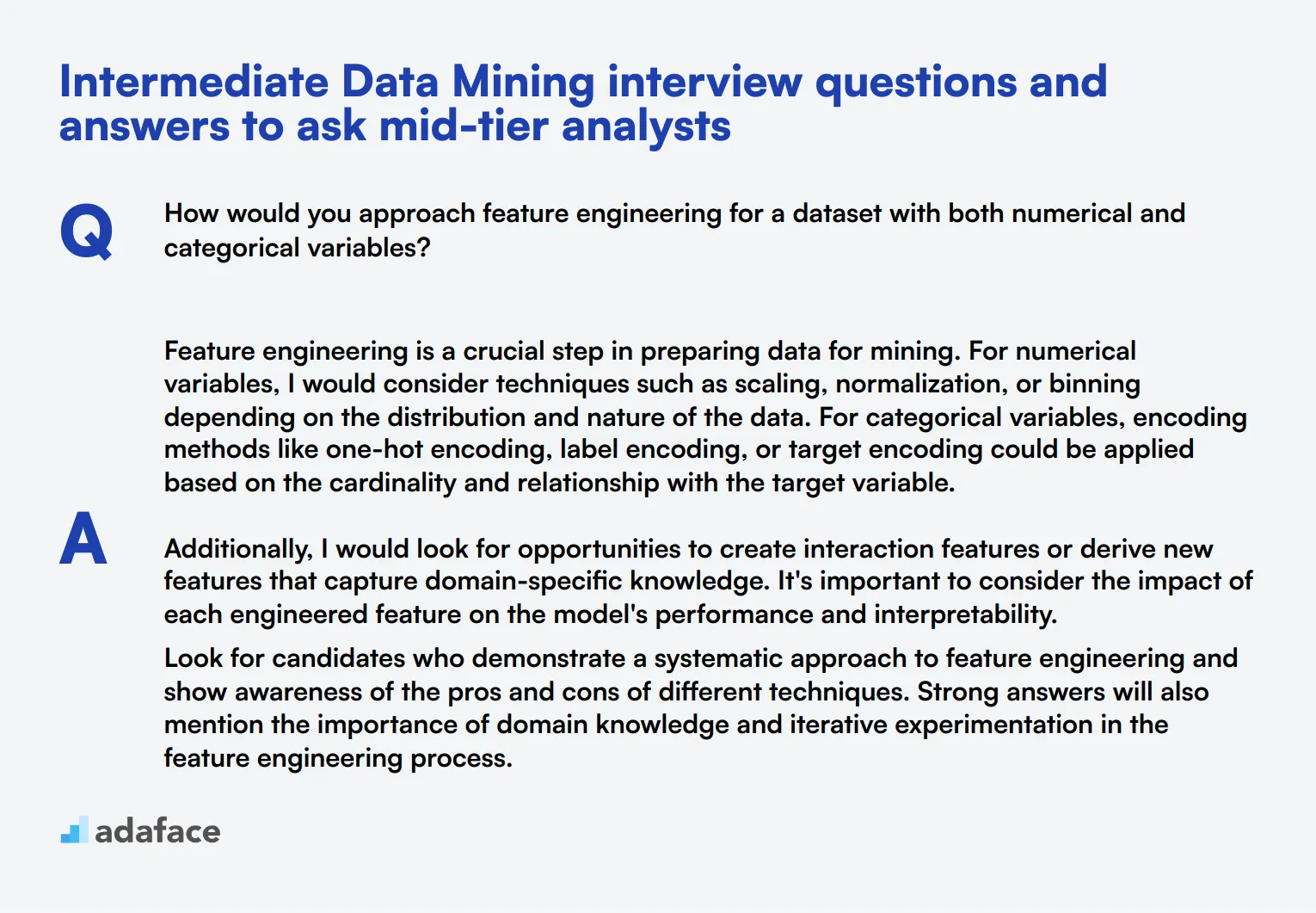

10 preguntas y respuestas intermedias de entrevistas de minería de datos para hacer a analistas de nivel medio

¿Listo para poner a prueba a sus analistas de minería de datos de nivel medio? Estas 10 preguntas intermedias le ayudarán a evaluar sus habilidades y comprensión de los conceptos clave. Ya sea que esté realizando una entrevista cara a cara o una evaluación virtual, estas preguntas le darán información sobre cómo los candidatos abordan los desafíos del mundo real de la minería de datos.

1. ¿Cómo abordaría la ingeniería de características para un conjunto de datos con variables numéricas y categóricas?

La ingeniería de características es un paso crucial en la preparación de datos para la minería. Para las variables numéricas, consideraría técnicas como el escalado, la normalización o la agrupación en función de la distribución y la naturaleza de los datos. Para las variables categóricas, se podrían aplicar métodos de codificación como la codificación one-hot, la codificación de etiquetas o la codificación objetivo en función de la cardinalidad y la relación con la variable objetivo.

Además, buscaría oportunidades para crear características de interacción o derivar nuevas características que capturen el conocimiento específico del dominio. Es importante considerar el impacto de cada característica diseñada en el rendimiento y la interpretabilidad del modelo.

Busque candidatos que demuestren un enfoque sistemático de la ingeniería de características y que muestren conciencia de los pros y los contras de las diferentes técnicas. Las respuestas sólidas también mencionarán la importancia del conocimiento del dominio y la experimentación iterativa en el proceso de ingeniería de características.

2. ¿Puede explicar el concepto de aprendizaje por conjunto y dar un ejemplo de cuándo podría usarlo?

El aprendizaje por conjunto (ensemble learning) es una técnica que combina múltiples modelos para crear un modelo predictivo más robusto y preciso. La idea es que al agregar las predicciones de varios modelos, podemos reducir el sesgo, la varianza y el sobreajuste, lo que lleva a un mejor rendimiento general.

Un ejemplo de cuándo usar el aprendizaje por conjunto podría ser en un proyecto de predicción de abandono de clientes (churn). Podríamos combinar árboles de decisión, bosques aleatorios y máquinas de gradient boosting para crear una predicción más confiable de qué clientes es probable que se vayan. Cada modelo podría capturar diferentes aspectos del comportamiento del cliente, y el conjunto proporcionaría una visión más completa.

Busque candidatos que puedan explicar el concepto con claridad y proporcionar ejemplos relevantes. También deben ser capaces de discutir métodos de conjunto comunes como bagging, boosting y stacking, y comprender cuándo el aprendizaje por conjunto puede ser preferible a usar un solo modelo.

3. ¿Cómo manejaría un conjunto de datos con una gran cantidad de características pero relativamente pocos ejemplos?

Al tratar con un conjunto de datos que tiene muchas características pero pocos ejemplos, existe el riesgo de sobreajuste. Para abordar esto, consideraría varios enfoques:

- Selección de características: Utilice técnicas como el análisis de correlación, la información mutua o la regularización LASSO para identificar las características más relevantes.

- Reducción de la dimensionalidad: Aplique métodos como PCA o t-SNE para reducir el número de características mientras se retiene la mayor parte de la información.

- Regularización: Implemente técnicas de regularización en el modelo para evitar el sobreajuste.

- Validación cruzada: Utilice la validación cruzada k-fold para asegurar que el modelo generalice bien a pesar del tamaño limitado de la muestra.

- Aumento de datos: Si es aplicable, genere muestras sintéticas para aumentar el tamaño del conjunto de datos.

Un candidato fuerte debe reconocer los desafíos de la alta dimensionalidad con muestras limitadas y proponer múltiples estrategias para abordarlos. Busque respuestas que demuestren una comprensión del compromiso entre sesgo y varianza y la importancia de la validación del modelo en tales escenarios.

4. Explique la diferencia entre un modelo paramétrico y no paramétrico en la minería de datos.

Los modelos paramétricos hacen fuertes suposiciones sobre la distribución subyacente de los datos y tienen un número fijo de parámetros, independientemente del tamaño del conjunto de entrenamiento. Ejemplos de esto son la regresión lineal y la regresión logística. Estos modelos suelen ser más simples y rápidos de entrenar, pero es posible que no capturen patrones complejos en los datos.

Los modelos no paramétricos, por otro lado, hacen menos suposiciones sobre la distribución de datos y pueden tener un número flexible de parámetros que crece con el tamaño del conjunto de entrenamiento. Ejemplos incluyen árboles de decisión, k-vecinos más cercanos y métodos de kernel. Estos modelos pueden capturar relaciones más complejas, pero pueden requerir más datos y ser propensos al sobreajuste.

Busque candidatos que puedan articular claramente las diferencias y proporcionar ejemplos de cada tipo. También deben ser capaces de discutir las compensaciones entre los modelos paramétricos y no paramétricos, como la interpretabilidad, la flexibilidad y la complejidad computacional.

5. ¿Cómo abordaría la detección de anomalías en un conjunto de datos de series temporales grande?

La detección de anomalías en datos de series temporales requiere un enfoque cuidadoso. Consideraría los siguientes pasos:

- Preprocesamiento de datos: Limpiar los datos, manejar los valores faltantes y realizar las transformaciones necesarias.

- Análisis de tendencias y estacionalidad: Identificar y eliminar cualquier tendencia subyacente o patrones estacionales.

- Métodos estadísticos: Utilizar técnicas como medias móviles, suavizado exponencial o modelos ARIMA para establecer una línea base.

- Enfoques de aprendizaje automático: Considerar métodos no supervisados como bosques de aislamiento o autoencoders, o métodos supervisados si se dispone de datos etiquetados.

- Establecimiento de umbrales: Determinar umbrales apropiados para señalar anomalías, posiblemente utilizando conocimientos del dominio o medidas estadísticas.

- Visualización: Crear gráficos para ayudar a identificar y validar las anomalías detectadas.

Un candidato fuerte debe demostrar conocimiento de enfoques estadísticos y de aprendizaje automático para la detección de anomalías. Busque respuestas que consideren los desafíos específicos de los datos de series temporales, como las dependencias temporales y la deriva de conceptos.

6. ¿Qué es la maldición de la dimensionalidad y cómo afecta a la minería de datos?

La maldición de la dimensionalidad se refiere al fenómeno en el que el rendimiento de los algoritmos de aprendizaje automático se deteriora a medida que el número de características (dimensiones) aumenta en relación con el número de muestras. Esto ocurre porque a medida que aumenta el número de dimensiones, los datos se vuelven cada vez más dispersos en el espacio de características, lo que dificulta la búsqueda de patrones significativos.

En la minería de datos, esta maldición puede generar varios problemas:

- Mayor complejidad computacional y requerimientos de memoria

- Sobreajuste, ya que los modelos pueden ajustarse al ruido en espacios de alta dimensión

- Reducción de la efectividad de los algoritmos basados en la distancia

- Dificultad para visualizar e interpretar datos de alta dimensión

Busque candidatos que puedan explicar el concepto con claridad y discutir sus implicaciones para las tareas de minería de datos. Las respuestas sólidas también mencionarán estrategias para mitigar la maldición de la dimensionalidad, como la selección de características, las técnicas de reducción de la dimensionalidad y el uso de algoritmos apropiados para datos de alta dimensión.

7. ¿Cómo manejaría la deriva de conceptos en un modelo de aprendizaje automático implementado?

La deriva de conceptos ocurre cuando las propiedades estadísticas de la variable objetivo cambian con el tiempo, lo que potencialmente hace que un modelo implementado sea menos preciso. Para manejar la deriva de conceptos, consideraría los siguientes enfoques:

- Monitoreo: Implementar un sistema para monitorear continuamente el rendimiento del modelo y la distribución de datos.

- Reentrenamiento: Reentrenar periódicamente el modelo con datos recientes para capturar nuevos patrones.

- Aprendizaje en línea: Usar algoritmos que puedan adaptarse a los datos cambiantes en tiempo real.

- Métodos de conjunto: Mantener múltiples modelos y ponderarlos en función del rendimiento reciente.

- Ingeniería de características: Desarrollar características dependientes del tiempo que puedan capturar las tendencias cambiantes.

- Detección de deriva: Implementar pruebas estadísticas para detectar cuándo se ha producido una deriva significativa.

Un candidato fuerte debe demostrar conocimiento de los desafíos que plantea la deriva de concepto en aplicaciones del mundo real. Busque respuestas que propongan una combinación de estrategias proactivas y reactivas, y muestren comprensión de las compensaciones entre la estabilidad y la adaptabilidad del modelo.

8. Explique la diferencia entre bagging y boosting en el aprendizaje de conjunto.

Bagging (Agregación Bootstrap) y Boosting son técnicas de aprendizaje de conjunto, pero difieren en su enfoque:

Bagging:

- Crea múltiples subconjuntos del conjunto de datos original mediante muestreo aleatorio con reemplazo

- Entrena un modelo separado en cada subconjunto

- Combina predicciones mediante votación (clasificación) o promediado (regresión)

- Reduce la varianza y ayuda a prevenir el sobreajuste

- Ejemplo: Bosques Aleatorios

Boosting:

- Entrena modelos secuencialmente, con cada modelo tratando de corregir los errores de los anteriores

- Asigna pesos más altos a las instancias mal clasificadas en iteraciones subsiguientes

- Combina modelos mediante votación ponderada o promediado

- Reduce el sesgo y la varianza, pero puede ser propenso al sobreajuste si no se ajusta cuidadosamente

- Ejemplos: AdaBoost, Máquinas de Gradiente Boosting

Busque candidatos que puedan explicar claramente las diferencias en cómo funcionan estas técnicas y su impacto en el rendimiento del modelo. Las respuestas sólidas también discutirán las compensaciones entre bagging y boosting, como la interpretabilidad, el tiempo de entrenamiento y la sensibilidad a los datos ruidosos.

9. ¿Cómo abordaría un proyecto de minería de datos donde la variable objetivo está muy desequilibrada?

Al tratar con una variable objetivo desequilibrada, se pueden emplear varias estrategias:

- Técnicas de remuestreo:

- Sobremuestreo de la clase minoritaria (por ejemplo, SMOTE)

- Submuestreo de la clase mayoritaria

- Combinación de ambas

- Enfoques algorítmicos:

- Utilizar algoritmos que manejen bien los datos desequilibrados (por ejemplo, árboles de decisión)

- Ajustar los pesos de las clases o utilizar aprendizaje sensible a los costos

- Métodos de conjunto:

- Técnicas como BalancedRandomForestClassifier o EasyEnsemble

- Métricas de evaluación:

- Utilizar métricas apropiadas como F1-score, ROC AUC o curva de precisión-exhaustividad en lugar de exactitud

- Detección de anomalías:

- Enmarcar el problema como detección de anomalías si el desequilibrio es extremo

Un candidato fuerte debería reconocer los desafíos planteados por los datos desequilibrados y proponer múltiples estrategias para abordarlos. Busque respuestas que demuestren una comprensión de las limitaciones de los enfoques estándar y la importancia de elegir métricas de evaluación apropiadas para conjuntos de datos desequilibrados.

10. ¿Puede explicar el concepto de regularización en los modelos de aprendizaje automático y cuándo podría usarla?

La regularización es una técnica utilizada para evitar el sobreajuste en los modelos de aprendizaje automático, agregando un término de penalización a la función de pérdida. Esta penalización disuade al modelo de ajustar el ruido en los datos de entrenamiento demasiado de cerca, lo que lleva a una mejor generalización en datos no vistos.

Los tipos comunes de regularización incluyen:

- L1 (Lasso): Agrega el valor absoluto de los coeficientes a la función de pérdida, puede conducir a modelos dispersos

- L2 (Ridge): Agrega el valor al cuadrado de los coeficientes, tiende a reducir los coeficientes hacia cero

- Elastic Net: Combina la regularización L1 y L2

La regularización es particularmente útil cuando:

- El modelo tiene alta varianza (sobreajuste)

- El conjunto de datos tiene un gran número de características en relación con el número de muestras

- Hay multicolinealidad entre las características

- Se desea la selección de características (especialmente con la regularización L1)

Busque candidatos que puedan explicar el concepto con claridad y discutir los diferentes tipos de regularización. Las respuestas sólidas también demostrarán la comprensión de cómo la regularización afecta la complejidad del modelo y el equilibrio entre sesgo y varianza.

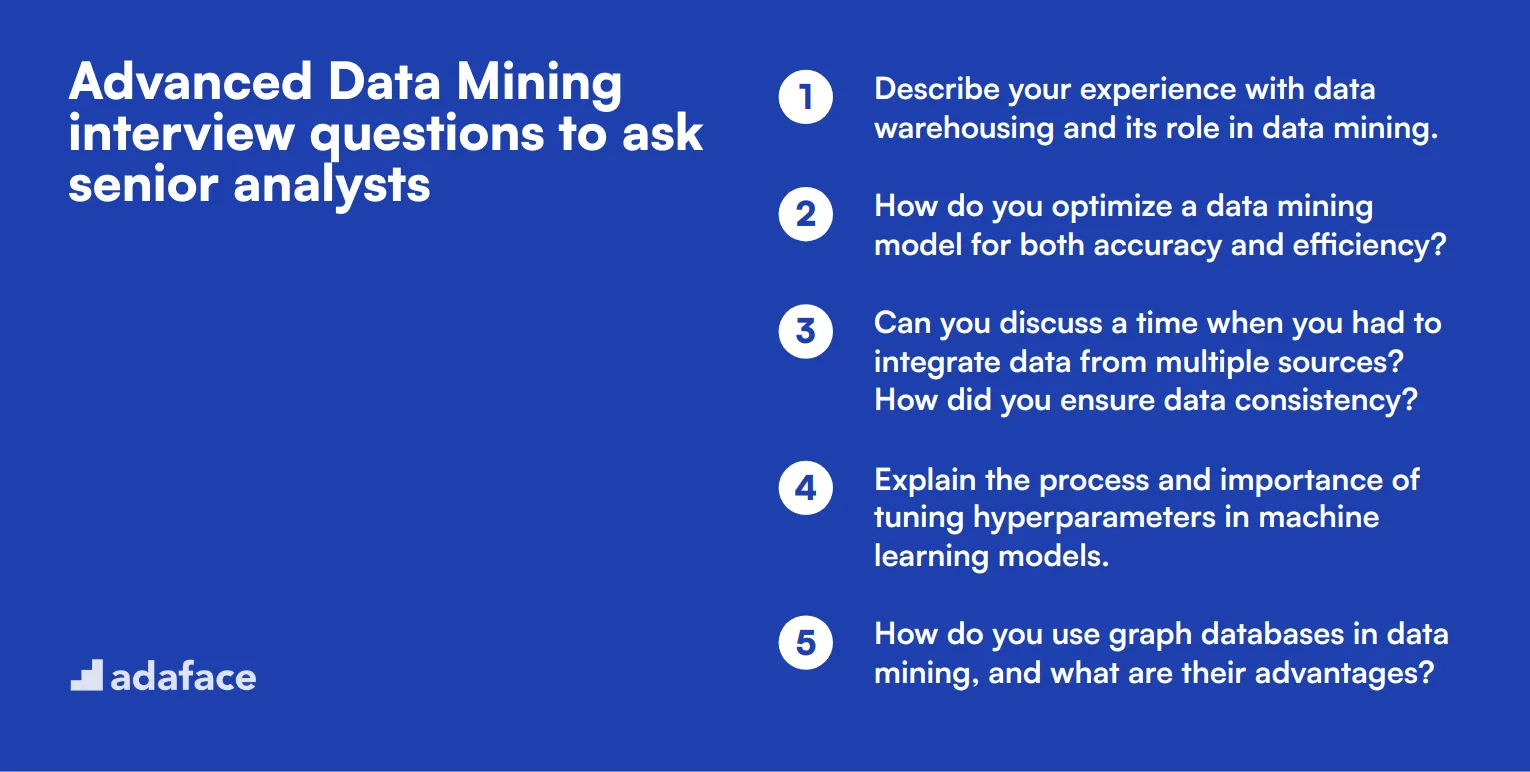

15 preguntas avanzadas de entrevista sobre minería de datos para hacer a analistas sénior

Para determinar si sus candidatos a analistas de datos sénior poseen la profunda experiencia técnica requerida para tareas avanzadas de minería de datos, considere usar estas 15 preguntas avanzadas de entrevista. Estas preguntas están diseñadas para desafiar a los candidatos y evaluar su capacidad para manejar escenarios complejos de minería de datos, asegurando que estén bien equipados para roles que requieren habilidades analíticas de alto nivel. Para obtener descripciones de roles más detalladas, puede consultar la descripción del puesto de trabajo de analista de datos.

- Describa su experiencia con el almacenamiento de datos (data warehousing) y su papel en la minería de datos. 2. ¿Cómo optimiza un modelo de minería de datos para la precisión y la eficiencia? 3. ¿Puede hablar de una vez que tuvo que integrar datos de múltiples fuentes? ¿Cómo aseguró la consistencia de los datos? 4. Explique el proceso y la importancia de ajustar los hiperparámetros en los modelos de aprendizaje automático. 5. ¿Cómo utiliza las bases de datos de grafos en la minería de datos y cuáles son sus ventajas? 6. Describa un proyecto desafiante de minería de datos en el que haya trabajado y cómo superó los obstáculos que enfrentó. 7. ¿Qué técnicas avanzadas utiliza para el reconocimiento de patrones en conjuntos de datos grandes? 8. ¿Cómo asegura la escalabilidad de sus soluciones de minería de datos al tratar con conjuntos de datos masivos? 9. ¿Puede explicar el concepto de aprendizaje por transferencia y su aplicación en la minería de datos? 10. Describa su enfoque para desarrollar modelos predictivos para el análisis de datos en tiempo real. 11. ¿Qué métodos utiliza para validar la robustez de sus modelos de minería de datos? 12. ¿Cómo gestiona y reduce los sesgos en sus procesos de minería de datos? 13. Explique el uso de técnicas de aprendizaje profundo en la minería de datos y proporcione un ejemplo práctico. 14. ¿Cómo aborda la tarea de automatizar el flujo de trabajo de la minería de datos? 15. Discuta su experiencia con el uso de tecnologías de big data como Hadoop y Spark en proyectos de minería de datos.

8 preguntas y respuestas de entrevista de minería de datos relacionadas con definiciones técnicas

Para evaluar la comprensión de los candidatos sobre los conceptos de minería de datos y su capacidad para aplicarlos en escenarios del mundo real, considere usar estas 8 preguntas de definición técnica. Estas preguntas le ayudarán a evaluar la profundidad del conocimiento de un candidato y su capacidad para explicar conceptos complejos en términos sencillos, lo cual es crucial para los científicos de datos y analistas que trabajan con equipos diversos.

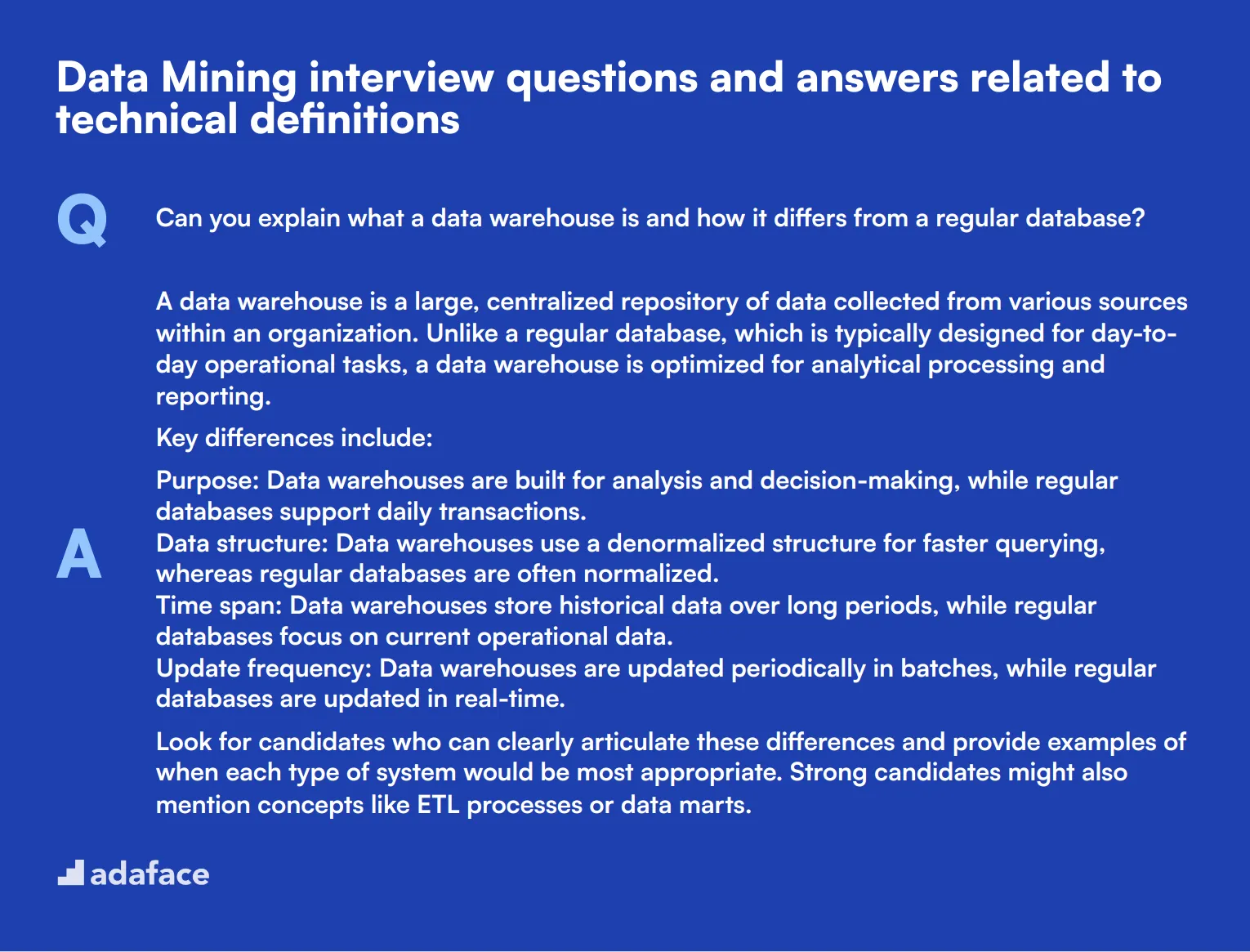

1. ¿Puede explicar qué es un almacén de datos y en qué se diferencia de una base de datos regular?

Un almacén de datos es un repositorio centralizado y grande de datos recopilados de varias fuentes dentro de una organización. A diferencia de una base de datos regular, que generalmente está diseñada para tareas operativas diarias, un almacén de datos está optimizado para el procesamiento analítico y la generación de informes.

Las diferencias clave incluyen:

- Propósito: Los almacenes de datos están construidos para el análisis y la toma de decisiones, mientras que las bases de datos regulares admiten las transacciones diarias.

- Estructura de datos: Los almacenes de datos usan una estructura desnormalizada para una consulta más rápida, mientras que las bases de datos regulares a menudo están normalizadas.

- Período de tiempo: Los almacenes de datos almacenan datos históricos durante largos períodos, mientras que las bases de datos regulares se enfocan en los datos operativos actuales.

- Frecuencia de actualización: Los almacenes de datos se actualizan periódicamente en lotes, mientras que las bases de datos regulares se actualizan en tiempo real.

Busque candidatos que puedan articular claramente estas diferencias y proporcionar ejemplos de cuándo sería más apropiado cada tipo de sistema. Los candidatos fuertes también podrían mencionar conceptos como procesos ETL o data marts.

2. ¿Cuál es la diferencia entre una tabla de hechos y una tabla de dimensiones en un data warehouse?

En un data warehouse, las tablas de hechos y las tablas de dimensiones son dos componentes clave del esquema estrella, un patrón de diseño común:

- Tablas de hechos: Contienen datos cuantitativos sobre procesos de negocio (por ejemplo, transacciones de ventas, visitas a sitios web).

- Tablas de dimensiones: Proporcionan atributos descriptivos que dan contexto a los hechos (por ejemplo, detalles del producto, información del cliente, períodos de tiempo).

Las tablas de hechos típicamente tienen muchas filas pero pocas columnas, que consisten principalmente en claves externas a las tablas de dimensiones y medidas numéricas. Las tablas de dimensiones tienen menos filas pero más columnas, proporcionando información descriptiva rica.

Un candidato fuerte debería ser capaz de explicar cómo estas tablas trabajan juntas para facilitar la consulta y el análisis eficientes. También podrían discutir el concepto de granularidad en las tablas de hechos o las dimensiones de cambio lento.

3. ¿Puede explicar el concepto de cubos de datos en sistemas OLAP?

Un cubo de datos es una estructura de datos multidimensional utilizada en sistemas de procesamiento analítico en línea (OLAP). Permite un análisis rápido de datos a través de múltiples dimensiones. Piense en ello como una forma de precalcular y almacenar agregaciones de datos a lo largo de varias dimensiones.

Por ejemplo, un cubo de datos de ventas podría tener dimensiones como tiempo, producto y ubicación. Los usuarios pueden recuperar rápidamente datos agregados (por ejemplo, ventas totales) para cualquier combinación de estas dimensiones, como 'ventas totales del Producto A en la región Noreste durante el segundo trimestre'.

Busque candidatos que puedan explicar cómo los cubos de datos permiten un análisis rápido y flexible. Deben comprender conceptos como dimensiones, medidas y jerarquías. Los candidatos fuertes también podrían discutir las compensaciones entre el espacio de almacenamiento y el rendimiento de las consultas en los sistemas OLAP.

4. ¿Cuál es la diferencia entre ETL y ELT en el procesamiento de datos?

ETL (Extraer, Transformar, Cargar) y ELT (Extraer, Cargar, Transformar) son dos enfoques para procesar datos para análisis:

- ETL: Los datos se extraen de los sistemas de origen, se transforman para ajustarse al esquema de destino y luego se cargan en el almacén de datos.

- ELT: Los datos se extraen de las fuentes, se cargan en el sistema de destino en su forma sin procesar y luego se transforman según sea necesario.

La diferencia clave radica en el orden y la ubicación del paso de transformación. ETL transforma los datos antes de cargarlos, a menudo utilizando un motor de transformación independiente. ELT carga primero los datos sin procesar y aprovecha el poder de los almacenes de datos modernos para realizar transformaciones.

Busque candidatos que puedan explicar los pros y los contras de cada enfoque. Deben comprender que ELT se está volviendo más popular con los almacenes de datos basados en la nube debido a su capacidad para manejar transformaciones a gran escala. Un candidato sólido podría discutir escenarios en los que se podría preferir un enfoque sobre el otro.

5. ¿Puede explicar qué es un lago de datos y en qué se diferencia de un almacén de datos?

Un lago de datos es un gran repositorio que almacena datos sin procesar, no estructurados o semiestructurados en su formato nativo. A diferencia de un almacén de datos, que almacena datos estructurados optimizados para tareas analíticas específicas, un lago de datos puede contener una vasta cantidad de tipos de datos diversos sin un esquema predefinido.

Las diferencias clave incluyen:

- Estructura de datos: Los lagos de datos almacenan datos sin procesar, mientras que los almacenes de datos almacenan datos procesados y estructurados.

- Esquema: Los lagos de datos utilizan un enfoque de esquema en lectura, mientras que los almacenes de datos utilizan un esquema en escritura.

- Usuarios: Los lagos de datos a menudo son utilizados por científicos de datos para análisis exploratorios, mientras que los almacenes de datos suelen ser utilizados por analistas de negocios para informes regulares.

- Flexibilidad: Los lagos de datos ofrecen más flexibilidad para almacenar y analizar diversos tipos de datos, pero requieren más habilidad para consultar de manera efectiva.

Busque candidatos que entiendan las fortalezas y debilidades de cada enfoque. Deben ser capaces de discutir escenarios donde un lago de datos podría ser preferido sobre un almacén de datos, como cuando se trata de grandes volúmenes de datos no estructurados o cuando el uso final de los datos aún no está definido.

6. ¿Qué es el concepto de linaje de datos y por qué es importante en la minería de datos?

El linaje de datos se refiere al ciclo de vida de los datos, incluyendo sus orígenes, movimientos, transformaciones y dónde se utilizan. Proporciona un rastro documentado del recorrido de los datos a través de varios sistemas y procesos.

El linaje de datos es crucial en la minería de datos por varias razones:

- Calidad de los datos: Ayuda a rastrear y resolver problemas de calidad de los datos.

- Cumplimiento: Es esencial para el cumplimiento normativo, especialmente en industrias como las finanzas y la atención médica.

- Análisis de impacto: Permite a los científicos de datos comprender cómo los cambios en una parte del sistema podrían afectar a los procesos posteriores.

- Solución de problemas: Cuando surgen problemas, el linaje de datos ayuda a identificar rápidamente la fuente del problema.

- Confianza: Aumenta la confianza en las decisiones basadas en datos al proporcionar transparencia en el procesamiento de datos.

Un candidato fuerte debería ser capaz de explicar cómo funcionan las herramientas de linaje de datos y proporcionar ejemplos de cómo han utilizado el linaje de datos en sus proyectos de minería de datos. Busque la comprensión de las implicaciones tanto técnicas como comerciales de mantener un buen linaje de datos.

7. ¿Puede explicar el concepto de data mart y cómo se relaciona con un data warehouse?

Un data mart es un subconjunto de un data warehouse que se centra en una línea de negocio, departamento o área temática específica. Está diseñado para satisfacer las necesidades de un grupo particular de usuarios, proporcionándoles datos relevantes en un formato que sea fácil de acceder y comprender.

Características clave de los data marts:

- Alcance: Enfoque más estrecho en comparación con un data warehouse

- Tamaño: Típicamente más pequeño y más manejable

- Usuarios: A menudo diseñado para un grupo o departamento específico

- Implementación: Puede ser más rápido y menos complejo que un data warehouse completo

- Fuente de datos: Puede provenir de un data warehouse central (dependiente) o directamente de sistemas operativos (independiente)

Busque candidatos que puedan explicar la relación entre los data marts y los data warehouses. Deben comprender cuándo y por qué una organización podría optar por implementar data marts. Los candidatos fuertes podrían discutir las compensaciones entre los enfoques centralizados (data warehouse empresarial) y descentralizados (múltiples data marts) para la gestión de datos.

8. ¿Qué es la federación de datos y en qué se diferencia de la integración de datos?

La federación de datos es un enfoque que permite a una organización ver y acceder a datos de múltiples fuentes dispares a través de una única base de datos virtual. En lugar de mover o copiar físicamente datos a un repositorio central, la federación de datos proporciona una vista unificada de los datos que permanecen en sus ubicaciones originales.

- Movimiento de datos: La federación no mueve datos, mientras que la integración a menudo implica procesos ETL.

- Acceso en tiempo real: La federación típicamente proporciona acceso en tiempo real a los datos de origen.

- Complejidad: La federación puede ser menos compleja de configurar inicialmente, pero puede tener limitaciones de rendimiento para análisis a gran escala.

- Casos de uso: La federación se utiliza a menudo para decisiones operativas en tiempo real, mientras que la integración se utiliza típicamente para análisis y generación de informes históricos.

Busque candidatos que puedan explicar escenarios donde la federación de datos podría ser preferible a la integración de datos tradicional. Deben comprender los beneficios (como la reducción de la duplicación de datos y el acceso en tiempo real) y los desafíos (como los posibles problemas de rendimiento con consultas complejas) de la federación. Los candidatos fuertes podrían discutir tecnologías utilizadas para la federación de datos o enfoques híbridos que combinan la federación y la integración.

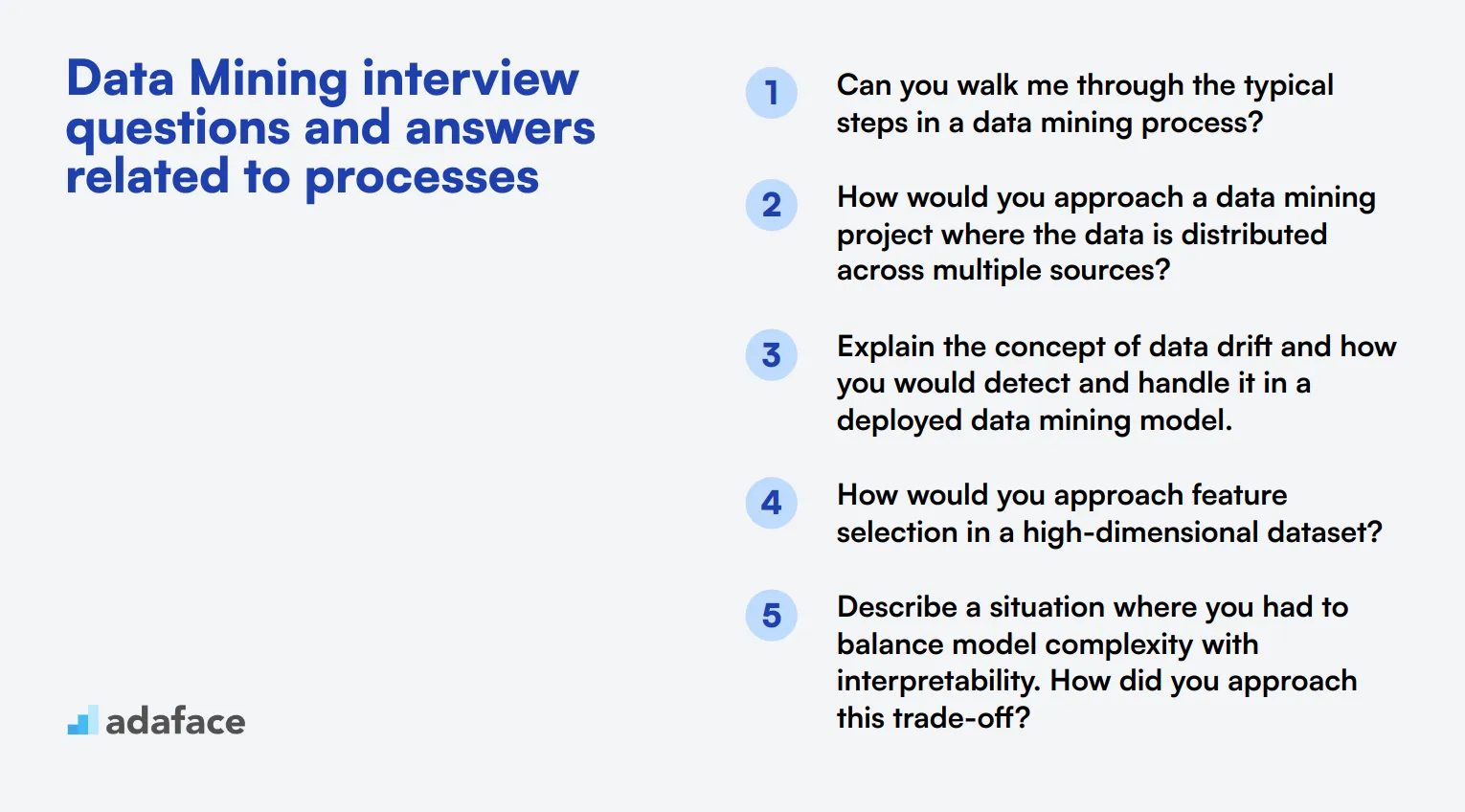

7 preguntas y respuestas de entrevistas de minería de datos relacionadas con los procesos

Para evaluar la comprensión de los candidatos sobre los procesos de minería de datos y su aplicación práctica, considere usar estas 7 preguntas perspicaces. Estas consultas le ayudarán a evaluar la capacidad de un candidato para navegar por el complejo mundo del análisis de datos y extraer información valiosa. Recuerde, las mejores respuestas demostrarán tanto conocimientos teóricos como habilidades de resolución de problemas del mundo real.

1. ¿Puede guiarme a través de los pasos típicos en un proceso de minería de datos?

Un candidato fuerte debe ser capaz de describir los pasos principales del proceso de minería de datos, que típicamente incluyen:

- Definición del problema: Declarar claramente el problema u objetivo del negocio

- Recopilación de datos: Recopilar datos relevantes de diversas fuentes

- Limpieza y preprocesamiento de datos: Manejar valores faltantes, valores atípicos e inconsistencias

- Análisis de datos exploratorio: Comprender los patrones y relaciones de los datos

- Selección e ingeniería de características: Elegir variables relevantes y crear nuevas

- Selección y entrenamiento del modelo: Elegir algoritmos apropiados y entrenar modelos

- Evaluación del modelo: Evaluar el rendimiento utilizando métricas apropiadas

- Implementación y monitoreo del modelo: Implementar el modelo en un entorno de producción

Busque candidatos que puedan explicar cada paso concisamente y proporcionar ejemplos de cómo han aplicado estos pasos en proyectos del mundo real. Una gran respuesta también podría tocar la naturaleza iterativa del proceso y la importancia de la calidad de los datos en todo momento.

2. ¿Cómo abordaría un proyecto de minería de datos donde los datos están distribuidos en múltiples fuentes?

Una respuesta ideal debe cubrir los siguientes puntos clave:

- Estrategia de integración de datos: Esbozar un plan para combinar datos de diversas fuentes, considerando factores como formatos de datos, esquemas e inconsistencias potenciales.

- Proceso ETL: Describir el proceso de Extracción, Transformación y Carga para consolidar datos en un repositorio central o almacén de datos.

- Evaluación de la calidad de los datos: Explicar métodos para garantizar la coherencia y precisión de los datos en todas las fuentes.

- Gestión de metadatos: Discutir la importancia de mantener una documentación clara del linaje y las definiciones de los datos.

- Consideraciones tecnológicas: Mencionar herramientas o plataformas relevantes para manejar fuentes de datos distribuidas, como Hadoop o soluciones basadas en la nube.

Buscar candidatos que enfaticen la importancia de comprender el contexto y los requisitos del negocio antes de sumergirse en soluciones técnicas. Las respuestas sólidas también podrían abordar desafíos potenciales como las preocupaciones sobre la privacidad de los datos o la necesidad de una integración de datos en tiempo real.

3. Explicar el concepto de deriva de datos (data drift) y cómo lo detectaría y manejaría en un modelo de minería de datos implementado.

Una respuesta completa debe incluir los siguientes elementos:

- Definición: La deriva de datos ocurre cuando las propiedades estadísticas de la variable objetivo cambian con el tiempo, lo que puede afectar el rendimiento del modelo.

- Tipos de deriva: Deriva de concepto (cambios en la relación entre las características y el objetivo) y deriva de características (cambios en la distribución de las características de entrada).

- Métodos de detección: Monitoreo de métricas de rendimiento del modelo, pruebas estadísticas para cambios de distribución o el uso de algoritmos especializados de detección de deriva.

- Estrategias de manejo: Reentrenamiento regular del modelo, métodos de conjunto con diferentes ventanas de tiempo o técnicas de aprendizaje adaptativo.

Los candidatos fuertes también podrían discutir la importancia de configurar sistemas de monitoreo para alertar a las partes interesadas sobre una deriva significativa, y la necesidad de equilibrar la estabilidad del modelo con la adaptabilidad. Busque respuestas que demuestren una comprensión de los desafíos prácticos para mantener el rendimiento del modelo en entornos dinámicos.

4. ¿Cómo abordaría la selección de características en un conjunto de datos de alta dimensión?

Una respuesta sólida debería cubrir varias técnicas de selección de características y sus aplicaciones:

- Métodos de filtro: Uso de medidas estadísticas como la correlación, la prueba de chi-cuadrado o la información mutua para seleccionar características.

- Métodos de envoltura: Evaluación de subconjuntos de características utilizando el modelo predictivo como una caja negra (por ejemplo, eliminación recursiva de características).

- Métodos integrados: Técnicas que realizan la selección de características como parte del proceso de entrenamiento del modelo (por ejemplo, regresión LASSO).

- Reducción de la dimensionalidad: Métodos como el Análisis de Componentes Principales (PCA) o t-SNE para crear nuevos espacios de características de menor dimensión.

Busque candidatos que puedan explicar las compensaciones entre diferentes enfoques, como la complejidad computacional frente al rendimiento del modelo. Una gran respuesta también podría tocar la importancia del conocimiento del dominio en la selección de características y la necesidad de validar el impacto de las características seleccionadas en el rendimiento del modelo. Los candidatos que mencionan las habilidades requeridas para los científicos de datos en este contexto demuestran una comprensión holística del campo.

5. Describa una situación en la que tuvo que equilibrar la complejidad del modelo con la interpretabilidad. ¿Cómo abordó esta compensación?

Una respuesta ideal debería demostrar la capacidad del candidato para navegar la tensión común entre el rendimiento y la explicabilidad del modelo:

- Contexto: Describa un proyecto o escenario específico donde esta compensación fue relevante.

- Análisis de las partes interesadas: Explique cómo se consideraron las necesidades de las diferentes partes interesadas (por ejemplo, científicos de datos, usuarios comerciales, reguladores).

- Selección del modelo: Discuta la elección entre modelos más complejos y de alto rendimiento (por ejemplo, aprendizaje profundo, métodos de conjunto) y modelos más simples y más interpretables (por ejemplo, regresión lineal, árboles de decisión).

- Técnicas de interpretabilidad: Mencione los métodos utilizados para explicar modelos complejos, como los valores SHAP, LIME o gráficos de dependencia parcial.

- Criterios de evaluación: Describa cómo se evaluó el equilibrio, posiblemente utilizando una combinación de métricas de rendimiento y medidas de interpretabilidad.

Busque respuestas que demuestren una consideración reflexiva del impacto empresarial y las implicaciones éticas de las elecciones de modelos. Los candidatos fuertes también podrían discutir estrategias para introducir gradualmente modelos más complejos manteniendo la confianza y la comprensión entre las partes interesadas.

6. ¿Cómo manejaría un proyecto de minería de datos en el que la variable objetivo está muy desequilibrada?

Una respuesta completa debería cubrir varias estrategias para tratar con conjuntos de datos desequilibrados:

- Técnicas a nivel de datos:

- Sobremuestreo de la clase minoritaria (por ejemplo, SMOTE)

- Submuestreo de la clase mayoritaria

- Combinación de sobremuestreo y submuestreo

- Técnicas a nivel de algoritmo:

- Uso de algoritmos que manejan bien el desequilibrio (por ejemplo, árboles de decisión)

- Ajuste de los pesos de clase o los umbrales de decisión

- Métodos de conjunto:

- Bagging o boosting con enfoque en la clase minoritaria

- Combinación de múltiples técnicas de remuestreo

- Métricas de evaluación:

- Uso de métricas apropiadas como F1-score, ROC AUC o curva de precisión-recall en lugar de precisión

Busque candidatos que enfaticen la importancia de comprender el contexto empresarial y el costo de diferentes tipos de errores. Las respuestas sólidas también podrían discutir la necesidad de validar el enfoque elegido utilizando validación cruzada y considerar la posible introducción de sesgo o sobreajuste al aplicar técnicas de remuestreo.

7. Explique el concepto de interpretabilidad del modelo y por qué es importante en los proyectos de minería de datos.

Una respuesta sólida debe cubrir los siguientes puntos clave:

- Definición: La interpretabilidad del modelo se refiere al grado en que los humanos pueden entender las razones detrás de las predicciones o decisiones de un modelo.

- Importancia:

- Construir confianza en los resultados del modelo

- Identificar posibles sesgos o errores en el modelo

- Garantizar el cumplimiento normativo (por ejemplo, el 'derecho a la explicación' del RGPD)

- Facilitar la depuración y mejora del modelo

- Permitir que los expertos en el dominio validen y proporcionen información

- Técnicas para mejorar la interpretabilidad:

- Usar modelos inherentemente interpretables (por ejemplo, regresión lineal, árboles de decisión)

- Aplicar métodos de explicación post-hoc (por ejemplo, valores SHAP, LIME)

- Análisis de importancia de características

- Gráficos de dependencia parcial

Busque candidatos que puedan discutir las compensaciones entre el rendimiento del modelo y la interpretabilidad, y cómo equilibrar estos factores según las necesidades específicas de un proyecto. Las respuestas sólidas también podrían abordar los desafíos de interpretar modelos complejos como las redes neuronales profundas y la investigación en curso en esta área. Los candidatos que mencionan la importancia de la interpretabilidad en el contexto de la IA ética y la ciencia de datos responsable demuestran una comprensión más amplia de las implicaciones del campo.

¿Qué habilidades de minería de datos debe evaluar durante la fase de entrevista?

Si bien una sola entrevista puede no revelar todo sobre las capacidades de un candidato, centrarse en habilidades básicas específicas durante la entrevista de minería de datos puede proporcionar información crucial sobre su efectividad potencial en el puesto. Estas habilidades son fundamentales para sus responsabilidades diarias y el éxito dentro de su organización.

Análisis estadístico

El análisis estadístico es la columna vertebral de la minería de datos, lo que permite a los analistas interpretar datos y hacer predicciones. Comprender los métodos estadísticos ayuda a extraer patrones y tendencias significativos de grandes conjuntos de datos, lo cual es fundamental para la toma de decisiones basada en datos.

Considere emplear una prueba MCQ personalizada para evaluar la competencia de un candidato en análisis estadístico. Puede utilizar el Test de Análisis de Datos Estadísticos de Adaface para filtrar a los candidatos de manera efectiva.

Para evaluar aún más esta habilidad, puede hacerle a los candidatos una pregunta específica que desafíe su comprensión de las estadísticas en el contexto de la minería de datos.

¿Puede explicar cómo usaría un valor p para determinar la significancia de los resultados de su minería de datos?

Busque respuestas que demuestren una clara comprensión de las pruebas de hipótesis y la capacidad de aplicar la significancia estadística en escenarios de minería de datos del mundo real.

Aprendizaje Automático

Las técnicas de aprendizaje automático son integrales para la minería de datos moderna, automatizando la extracción de información y predicciones de los datos. La competencia en algoritmos de aprendizaje automático puede mejorar significativamente la precisión y la eficiencia de los procesos de análisis de datos.

Una prueba de evaluación que incluya MCQs relevantes puede medir eficazmente el conocimiento de aprendizaje automático de los candidatos. El Test de Aprendizaje Automático de Adaface está diseñado para identificar a los candidatos con la experiencia necesaria.

Para profundizar en sus habilidades prácticas, considere preguntarles la siguiente pregunta durante la entrevista:

Describa una situación en la que eligió un modelo de aprendizaje automático específico sobre otros para un proyecto de minería de datos. ¿Qué factores influyeron en su decisión?

La respuesta debe mostrar su capacidad no solo para aplicar modelos apropiados, sino también para justificar sus elecciones en función de los requisitos específicos y las características de los datos del proyecto.

Visualización de Datos

La visualización de datos es una habilidad clave para la minería de datos, ya que permite a los analistas presentar información compleja de datos de manera comprensible y procesable. El dominio de las herramientas y técnicas de visualización es necesario para comunicar eficazmente los hallazgos a las partes interesadas.

Para evaluar esta habilidad, considere usar una prueba MCQ estructurada. El Adaface Data Visualization Test puede ayudar a evaluar la capacidad de los candidatos para interpretar y visualizar datos.

Durante la entrevista, puede hacer la siguiente pregunta para evaluar sus capacidades de visualización de datos:

¿Qué técnicas de visualización utilizaría para representar datos de series temporales de las métricas de rendimiento de una campaña de marketing?

Espere que los candidatos discutan una variedad de gráficos y diagramas, como gráficos de líneas o mapas de calor, demostrando conocimiento de cuándo y cómo usar diferentes tipos según la naturaleza de los datos y los objetivos del análisis.

Contrate a los mejores talentos de minería de datos con pruebas de habilidades y preguntas de entrevista específicas

Al contratar para puestos de Minería de Datos, es importante verificar con precisión las habilidades de los candidatos. Esto garantiza que incorpores a profesionales que realmente puedan contribuir a tus proyectos y procesos de toma de decisiones basados en datos.

Una de las formas más efectivas de evaluar las habilidades de Minería de Datos es a través de pruebas especializadas. El Data Mining Test de Adaface está diseñado para evaluar la competencia de los candidatos en áreas clave del campo.

Después de usar la prueba para preseleccionar a los mejores, puedes invitarlos a entrevistas. Las preguntas de la entrevista proporcionadas en esta publicación te ayudarán a profundizar en su conocimiento y experiencia, lo que te permitirá tomar decisiones de contratación informadas.

¿Listo para optimizar tu proceso de contratación de Minería de Datos? Regístrate en Adaface para acceder a nuestro completo conjunto de herramientas de evaluación y encontrar el ajuste perfecto para tu equipo.

Data Mining Test

40 minutos | 17 MCQs

El Data Mining Test evalúa a los candidatos en su conocimiento de técnicas de minería de datos, preprocesamiento de datos, minería de reglas de asociación, clasificación, clustering y visualización de datos utilizando MCQs basados en escenarios. Además de estas habilidades clave, la prueba también evalúa la comprensión del candidato sobre el almacenamiento de datos, la limpieza de datos y las tecnologías de big data.

Descargar la plantilla de preguntas de la entrevista de Data Mining en múltiples formatos

Busca habilidades en análisis estadístico, aprendizaje automático, programación (por ejemplo, Python, R), gestión de bases de datos y visualización de datos. Las habilidades de resolución de problemas y el conocimiento del dominio también son importantes.

Pregunta sobre proyectos específicos en los que han trabajado, desafíos que han enfrentado y soluciones que han implementado. Solicita ejemplos de técnicas de minería de datos que hayan aplicado en escenarios del mundo real.

Sé cauteloso con los candidatos que no pueden explicar conceptos básicos con claridad, carecen de experiencia práctica o muestran poco interés en mantenerse actualizados con las últimas tendencias y tecnologías en el campo.

Pídeles que expliquen un concepto o proceso complejo de minería de datos como si lo estuvieran presentando a un interesado no técnico. Esto ayudará a evaluar sus habilidades de comunicación y simplificación.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento