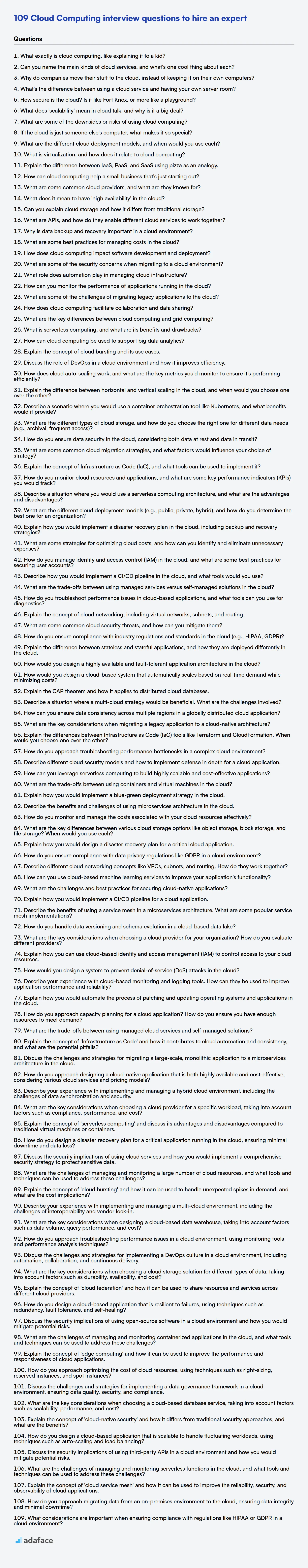

109 preguntas de entrevista sobre computación en la nube para contratar a un experto

La computación en la nube está transformando los negocios, e identificar candidatos calificados es más crítico que nunca; encontrar al ingeniero de la nube adecuado se trata de asegurar que las decisiones tecnológicas sean sólidas. A medida que crece la demanda de habilidades en la nube, los reclutadores necesitan las preguntas correctas para evaluar la experiencia de los candidatos.

Esta publicación de blog proporciona una lista seleccionada de preguntas de entrevista sobre computación en la nube, categorizadas por dificultad, desde básicas hasta expertas. También incluimos preguntas de opción múltiple (MCQ) sobre computación en la nube, lo que garantiza un enfoque estructurado para evaluar a los candidatos en varios niveles de habilidad.

Al usar estas preguntas, podrá contratar a grandes profesionales de la computación en la nube, y si desea evaluar a los candidatos incluso antes de la entrevista, use la prueba de computación en la nube de Adaface para automatizar su proceso de selección y enfocarse en el mejor talento.

Tabla de contenido

Preguntas básicas de entrevista sobre computación en la nube

Preguntas intermedias de entrevista sobre computación en la nube

Preguntas avanzadas de entrevista sobre computación en la nube

Preguntas de entrevista de expertos en computación en la nube

Preguntas de opción múltiple (MCQ) sobre computación en la nube

¿Qué habilidades de computación en la nube debe evaluar durante la fase de entrevista?

Optimice su contratación en computación en la nube con pruebas de habilidades

Descargue la plantilla de preguntas de entrevista sobre computación en la nube en múltiples formatos

1. ¿Qué es exactamente la computación en la nube, como explicárselo a un niño?

Imagina que tienes muchos juguetes, pero en lugar de guardarlos todos en tu casa, los guardas en una sala de juegos gigante que todos pueden compartir. Esa sala de juegos es como la "nube". En lugar de almacenar cosas como fotos, videos o programas en tu propia computadora o teléfono, los almacenas en computadoras en esa sala de juegos gigante. Puedes acceder a ellos desde cualquier lugar con internet, como si visitaras esa sala de juegos.

Así, la computación en la nube es como usar las computadoras de otra persona para almacenar tus cosas y ejecutar programas. Esto significa que no necesitas computadoras súper potentes o grandes en casa, ¡y puedes acceder a tus cosas desde cualquier dispositivo, en cualquier lugar, siempre que tengas internet!

2. ¿Puedes nombrar los principales tipos de servicios en la nube y cuál es una cosa genial de cada uno?

Los principales tipos de servicios en la nube son Infraestructura como Servicio (IaaS), Plataforma como Servicio (PaaS) y Software como Servicio (SaaS).

- IaaS: Lo genial es el control total. Usted administra el sistema operativo, el almacenamiento, las aplicaciones implementadas, etc. Como tener un centro de datos virtual, lo que permite la personalización.

- PaaS: Lo genial es el desarrollo simplificado. Concéntrese únicamente en su aplicación. El proveedor de la nube maneja la infraestructura subyacente, lo que facilita la implementación. Permite ciclos de desarrollo rápidos.

- SaaS: Lo genial es la accesibilidad. Use software a través de Internet en cualquier dispositivo, como usar Gmail o Salesforce. El mantenimiento lo gestiona el proveedor, muy fácil de usar.

3. ¿Por qué las empresas trasladan sus datos a la nube, en lugar de mantenerlos en sus propios ordenadores?

Las empresas se trasladan a la nube por varias razones, principalmente relacionadas con el coste, la escalabilidad y la fiabilidad. Los proveedores de la nube ofrecen un modelo de pago por uso, lo que reduce la inversión inicial en hardware y los gastos de mantenimiento continuos. Esto lo hace más barato que ejecutarlo todo ellos mismos. Los recursos de la nube pueden aumentar o disminuir fácilmente según la demanda, lo que garantiza que el sistema pueda manejar los picos de tráfico y también reduce la necesidad de sobreaprovisionar en previsión de picos ocasionales de carga.

Además, los proveedores de la nube ofrecen una infraestructura robusta con redundancia integrada y capacidades de recuperación ante desastres. Esto reduce el tiempo de inactividad y garantiza la disponibilidad de los datos, cosas que son mucho más costosas y complejas de implementar localmente. Los entornos de nube también simplifican la colaboración y el acceso a los datos desde cualquier lugar. La seguridad es otro aspecto importante. Los proveedores de la nube invierten mucho en infraestructura y experiencia en seguridad, lo que puede no ser factible para una empresa individual.

4. ¿Cuál es la diferencia entre usar un servicio en la nube y tener su propia sala de servidores?

Usar un servicio en la nube significa que está alquilando recursos informáticos (servidores, almacenamiento, etc.) de un proveedor como AWS, Azure o Google Cloud. Solo paga por lo que usa, y ellos se encargan de todo el mantenimiento de la infraestructura subyacente, la seguridad y la escalabilidad. Esto ofrece beneficios como la reducción de costos iniciales, mayor agilidad y una implementación más rápida.

Tener su propia sala de servidores implica ser propietario y mantener todo el hardware físico usted mismo. Esto significa una inversión inicial significativa, costos continuos de electricidad, refrigeración y personal de TI. Sin embargo, proporciona un mayor control sobre la seguridad y el cumplimiento de los datos, y podría ser preferible si tiene requisitos de hardware o software muy específicos que no son fáciles de cumplir por parte de los proveedores de la nube, o por requisitos legales de localización de datos.

5. ¿Qué tan segura es la nube? ¿Es como Fort Knox, o más como un parque infantil?

La seguridad de la nube no es una analogía absoluta de 'Fort Knox' o 'parque infantil'. Es más preciso describirla como un modelo de responsabilidad compartida. Los proveedores de la nube invierten mucho en medidas de seguridad como la seguridad física, la seguridad de la red y las certificaciones de cumplimiento. Sin embargo, la seguridad de sus datos y aplicaciones en la nube depende en gran medida de sus configuraciones y prácticas de seguridad.

Factores como la configuración adecuada de los controles de acceso (IAM), el cifrado de datos en reposo y en tránsito, la aplicación regular de parches a los sistemas y la implementación de una supervisión y registro robustos son cruciales. Descuidar estas responsabilidades puede dejarlo vulnerable, independientemente de la seguridad inherente del proveedor de la nube. Piense en ello como un edificio seguro (la infraestructura del proveedor de la nube), donde usted es responsable de cerrar con llave su apartamento (sus datos y aplicaciones).

6. ¿Qué significa 'escalabilidad' en el lenguaje de la nube, y por qué es tan importante?

En la computación en la nube, la escalabilidad se refiere a la capacidad de un sistema, aplicación o infraestructura para manejar una creciente cantidad de carga de trabajo o usuarios. Significa que el sistema puede adaptarse fácilmente a una mayor demanda sin afectar negativamente el rendimiento o la disponibilidad. Hay dos tipos principales: Escalabilidad vertical (escalar hacia arriba), que implica agregar más recursos (CPU, memoria) a un servidor existente, y Escalabilidad horizontal (escalar hacia afuera), que implica agregar más servidores al sistema.

La escalabilidad es crucial porque permite a las empresas gestionar eficientemente las cargas de trabajo fluctuantes, satisfacer las crecientes demandas de los clientes y evitar cuellos de botella en el rendimiento. Sin escalabilidad, un aumento repentino del tráfico podría sobrecargar el sistema, lo que provocaría tiempos de respuesta lentos, fallos en las aplicaciones y, en última instancia, una mala experiencia para el usuario y una posible pérdida de ingresos. Las plataformas en la nube proporcionan herramientas y servicios que facilitan y son más rentables la escalabilidad en comparación con la infraestructura tradicional local.

7. ¿Cuáles son algunas de las desventajas o riesgos de usar la computación en la nube?

Si bien la computación en la nube ofrece numerosos beneficios, algunas desventajas y riesgos incluyen:

- Riesgos de seguridad: Las filtraciones de datos, las vulnerabilidades en la infraestructura del proveedor de la nube y el acceso no autorizado son preocupaciones importantes. Estás confiando tus datos a un tercero, y su seguridad se convierte en tu seguridad.

- Tiempo de inactividad y disponibilidad: Los servicios en la nube pueden experimentar interrupciones, lo que afecta la disponibilidad de tu aplicación. La dependencia de la infraestructura del proveedor de la nube significa que estás sujeto a sus garantías de tiempo de actividad y a posibles interrupciones del servicio.

- Dependencia del proveedor (Vendor Lock-in): Migrar de un proveedor de nube a otro puede ser complejo y costoso, lo que lleva a la dependencia del proveedor. Estandarizar los servicios y las API de un proveedor de nube específico puede dificultar el cambio.

- Gestión de costos: Si bien la computación en la nube puede ser rentable, los patrones de uso inesperados, las tarifas ocultas y la asignación ineficiente de recursos pueden generar sobrecostos. El monitoreo y la optimización cuidadosos son cruciales.

- Cumplimiento y problemas regulatorios: Dependiendo de tu industria y la ubicación de los datos, la computación en la nube puede introducir desafíos de cumplimiento. Cumplir con regulaciones como GDPR o HIPAA puede ser más complejo en un entorno de nube.

- Pérdida de control: Renuncias a cierto control sobre tu infraestructura y datos al utilizar servicios en la nube. Dependes del proveedor de la nube para el mantenimiento, las actualizaciones de seguridad y otros aspectos operativos.

- Dependencia de la red: Los servicios en la nube dependen de una conexión a Internet estable y confiable. La mala conectividad de la red puede afectar significativamente el rendimiento y la accesibilidad de la aplicación.

8. Si la nube es solo la computadora de otra persona, ¿qué la hace tan especial?

Si bien la nube utiliza servidores físicos en centros de datos, su poder reside en la abstracción y la automatización. No es solo la computadora de otra persona porque proporciona acceso bajo demanda a una vasta reserva de recursos (cómputo, almacenamiento, bases de datos, etc.) administrados por el proveedor. Esta abstracción permite a los usuarios escalar los recursos hacia arriba o hacia abajo rápidamente, pagar solo por lo que usan y descargar las cargas de gestión de la infraestructura.

Además, las plataformas en la nube ofrecen una gama de servicios y herramientas administrados que serían complejos y consumirían mucho tiempo construir y mantener en un entorno tradicional. Estos incluyen cosas como el equilibrio de carga, el escalado automático, la supervisión, la seguridad y la computación sin servidor (por ejemplo, AWS Lambda, Azure Functions). Esto reduce la sobrecarga operativa y permite a las organizaciones centrarse en su negocio principal y la innovación en lugar de la infraestructura de TI.

9. ¿Cuáles son los diferentes modelos de implementación en la nube y cuándo usaría cada uno?

Los modelos de implementación en la nube dictan dónde reside su infraestructura en la nube y cómo se gestiona. Los tipos principales son:

- Nube pública: Los recursos son propiedad y están operados por un proveedor externo (por ejemplo, AWS, Azure, GCP) y se comparten entre múltiples inquilinos. Úsela cuando la rentabilidad, la escalabilidad y la mínima sobrecarga de gestión sean prioridades. Adecuada para aplicaciones de propósito general, desarrollo/pruebas y manejo de cargas de trabajo variables.

- Nube privada: Los recursos están dedicados a una única organización, ya sea en las instalaciones o alojados por un tercero. Úsela cuando se requieran seguridad, cumplimiento y control estrictos. Adecuada para datos confidenciales, industrias reguladas y aplicaciones heredadas.

- Nube híbrida: Una combinación de nubes públicas y privadas, que permite compartir datos y aplicaciones entre ellas. Úsela cuando necesite aprovechar los beneficios de ambos modelos, como escalar a la nube pública durante la demanda máxima mientras mantiene los datos confidenciales en una nube privada. Buena para la migración por fases, la recuperación ante desastres y la optimización de la carga de trabajo.

- Nube comunitaria: Los recursos se comparten entre varias organizaciones con intereses o requisitos similares (por ejemplo, seguridad, cumplimiento). Úsela cuando un grupo de organizaciones necesite colaborar y compartir recursos en un entorno seguro, como agencias gubernamentales o instituciones de investigación.

10. ¿Qué es la virtualización y cómo se relaciona con la computación en la nube?

La virtualización es el proceso de crear una representación basada en software (o virtual) de algo físico, como una computadora, un servidor, una red o un sistema operativo. Le permite ejecutar múltiples sistemas operativos o aplicaciones en una sola máquina física, maximizando la utilización de recursos y reduciendo los costos de hardware.

La virtualización es una tecnología central que sustenta la computación en la nube. Los proveedores de la nube utilizan la virtualización para crear y administrar máquinas virtuales (VM) que los clientes pueden alquilar y usar. Esto permite el escalado y la asignación de recursos bajo demanda, que son características clave de los servicios en la nube. Sin la virtualización, la computación en la nube no sería tan eficiente ni rentable.

11. Explica la diferencia entre IaaS, PaaS y SaaS usando una analogía de pizza.

Imagina que quieres comer pizza. Con IaaS (Infraestructura como servicio), construyes toda la pizza desde cero. Compras el horno, los ingredientes (masa, salsa, queso, ingredientes) y haces la pizza tú mismo. Lo gestionas todo.

Con PaaS (Plataforma como servicio), compras una base de masa y salsa prefabricada, quizás incluso se proporciona el horno. Agregas tu propio queso y coberturas, y lo horneas. Te preocupas por tus coberturas y el proceso de horneado, pero no por obtener los ingredientes o proporcionar el horno. Con SaaS (Software como servicio), simplemente pides una pizza que ya está hecha y se entrega en tu puerta. Simplemente te la comes; la empresa de pizza se encarga de todo lo demás (ingredientes, horno, horneado, entrega).

12. ¿Cómo puede la computación en la nube ayudar a una pequeña empresa que recién está comenzando?

La computación en la nube ofrece varias ventajas para las empresas emergentes. Elimina la necesidad de una inversión inicial significativa en hardware y software, lo que reduce los gastos de capital. En lugar de comprar servidores y licencias, las empresas pueden pagar por los recursos a medida que los consumen (modelo de pago por uso). Esto puede mejorar significativamente el flujo de caja y permitir que la empresa asigne recursos a otras áreas críticas como el desarrollo de productos o el marketing.

Además, los servicios en la nube ofrecen escalabilidad y flexibilidad. Una startup puede ajustar fácilmente sus recursos informáticos según la demanda, escalando durante las temporadas altas y reduciendo la escala durante los períodos de menor actividad. Esto evita el aprovisionamiento excesivo y el desperdicio de recursos. Los proveedores de la nube también se encargan del mantenimiento de la infraestructura, las actualizaciones y la seguridad, lo que libera al personal técnico de la pequeña empresa para que se centre en las actividades comerciales principales, además, los datos de la nube se respaldan. Esta mayor eficiencia y continuidad del negocio es una gran ventaja para las empresas más pequeñas y menos establecidas.

13. ¿Cuáles son algunos proveedores de nube comunes y por qué son conocidos?

Algunos proveedores de nube comunes incluyen:

- Amazon Web Services (AWS): Conocido por su amplia gama de servicios, plataforma madura y gran cuota de mercado. Es adecuado para prácticamente cualquier caso de uso.

- Microsoft Azure: Fuerte integración con los productos de Microsoft (Windows Server, .NET), capacidades de nube híbrida y una red global. Bueno para las empresas que ya utilizan tecnologías de Microsoft.

- Google Cloud Platform (GCP): Conocido por sus fortalezas en análisis de datos, aprendizaje automático y Kubernetes. A menudo elegido para aplicaciones intensivas en datos y soluciones innovadoras.

- DigitalOcean: Plataforma sencilla y fácil de usar para desarrolladores que se centra en máquinas virtuales e implementaciones sencillas. Una buena opción para proyectos más pequeños y desarrolladores individuales.

- IBM Cloud: Proporciona una gama de servicios, que incluyen infraestructura, plataforma y software, con un enfoque en soluciones empresariales y entornos de nube híbrida.

14. ¿Qué significa tener 'alta disponibilidad' en la nube?

La alta disponibilidad (HA) en la nube significa que sus aplicaciones y servicios son accesibles y operativos de forma constante, minimizando el tiempo de inactividad. Asegura que su sistema puede soportar fallos (hardware, software o red) sin interrupción significativa para los usuarios. La HA se logra a través de la redundancia y la tolerancia a fallos. Los aspectos clave incluyen:

- Redundancia: Múltiples instancias de su aplicación o servicio ejecutándose en diferentes zonas de disponibilidad.

- Mecanismos de conmutación por error: Cambio automático a una instancia en buen estado cuando otra falla.

- Supervisión: Supervisión continua del estado del sistema para detectar y responder a fallos rápidamente.

- Equilibrio de carga: Distribución del tráfico entre múltiples instancias para prevenir la sobrecarga y mejorar la resiliencia.

- Recuperación automatizada: Implementación de procesos automatizados para restaurar el servicio después de una falla.

15. ¿Puedes explicar qué es el almacenamiento en la nube y en qué se diferencia del almacenamiento tradicional?

El almacenamiento en la nube es un servicio donde los datos se almacenan en servidores remotos accesibles a través de Internet, administrados por un proveedor externo. El almacenamiento tradicional, por otro lado, implica almacenar datos en dispositivos locales como discos duros o almacenamiento conectado a la red (NAS) dentro de su propia infraestructura.

Las principales diferencias radican en la accesibilidad, la escalabilidad y la gestión. El almacenamiento en la nube ofrece acceso en cualquier momento y lugar, fácil escalabilidad para ajustar la capacidad de almacenamiento y una reducción de la sobrecarga de gestión, ya que el proveedor se encarga del mantenimiento y la seguridad. El almacenamiento tradicional requiere acceso físico, tiene una escalabilidad limitada ligada al hardware y requiere la gestión interna de la infraestructura, las copias de seguridad y la seguridad.

16. ¿Qué son las API y cómo permiten que los diferentes servicios en la nube funcionen juntos?

Las API (Interfaces de Programación de Aplicaciones) son conjuntos de reglas y especificaciones que los programas de software pueden seguir para comunicarse entre sí. Definen los métodos y formatos de datos que las aplicaciones utilizan para solicitar e intercambiar información, actuando como intermediarios que permiten que diferentes sistemas interactúen sin necesidad de conocer los detalles de implementación subyacentes de cada uno. Piense en ello como un menú de restaurante: usted (la aplicación) pide platos específicos (solicitudes de API) sin necesidad de saber cómo el chef (el servicio) los prepara.

En el contexto de los servicios en la nube, las API son cruciales para la interoperabilidad. Permiten que los servicios ofrecidos por diferentes proveedores o incluso diferentes servicios dentro del mismo proveedor trabajen juntos sin problemas. Por ejemplo, un servicio de almacenamiento en la nube puede usar una API para permitir que un servicio de procesamiento de imágenes basado en la nube acceda y modifique las imágenes almacenadas. Esta interconexión permite a los desarrolladores construir aplicaciones complejas aprovechando las capacidades de múltiples servicios en la nube independientes, fomentando la innovación y la eficiencia.

17. ¿Por qué la copia de seguridad y la recuperación de datos son importantes en un entorno de nube?

La copia de seguridad y la recuperación de datos son cruciales en la nube debido a los riesgos inherentes de pérdida de datos. Estos riesgos pueden provenir de diversas fuentes, incluyendo: fallos de hardware, errores de software, eliminaciones accidentales, violaciones de seguridad (como ataques de ransomware) y desastres naturales. Sin estrategias sólidas de copia de seguridad y recuperación, las empresas enfrentan posibles pérdidas financieras, daños a la reputación y responsabilidades legales. Las copias de seguridad regulares aseguran que los datos se puedan restaurar a un estado anterior, minimizando el tiempo de inactividad y la pérdida de datos en caso de un incidente.

Los mecanismos de recuperación garantizan la continuidad del negocio. Los entornos en la nube, aunque generalmente fiables, aún son susceptibles a fallos. Las estrategias de copia de seguridad y recuperación también facilitan la migración de datos y la recuperación ante desastres, lo que permite a las organizaciones mantener la resiliencia operativa y cumplir con los requisitos de cumplimiento normativo. Las estrategias eficaces incluyen copias de seguridad automatizadas, almacenamiento geográficamente diverso y procedimientos de recuperación bien definidos.

18. ¿Cuáles son algunas de las mejores prácticas para gestionar los costes en la nube?

Algunas de las mejores prácticas para gestionar los costes en la nube incluyen: Dimensionamiento correcto de los recursos, lo que significa elegir los tipos de instancia y tamaños de almacenamiento adecuados para sus cargas de trabajo. Supervisar regularmente la utilización de los recursos y ajustarlos según sea necesario. Implementar el escalado automático para escalar automáticamente los recursos hacia arriba o hacia abajo en función de la demanda, evitando el aprovisionamiento excesivo durante los periodos de baja actividad. Utilizar instancias reservadas o descuentos por uso comprometido para cargas de trabajo predecibles para reducir significativamente los costes en comparación con los precios bajo demanda.

Otro aspecto importante es la asignación de costos mediante el uso de etiquetas para rastrear los costos por departamento, proyecto o entorno. Esto permite una mejor visibilidad y responsabilidad. Además, identifique y elimine los recursos inactivos que ya no están en uso. También puede aprovechar las herramientas de gestión de costos del proveedor de la nube para obtener información sobre los patrones de gasto e identificar oportunidades de optimización. Revisar y optimizar regularmente su arquitectura en la nube también puede ayudar a minimizar los costos.

19. ¿Cómo impacta la computación en la nube en el desarrollo e implementación de software?

La computación en la nube impacta significativamente el desarrollo y la implementación de software al ofrecer recursos escalables y bajo demanda, lo que agiliza todo el proceso. Los desarrolladores pueden aprovechar los IDE basados en la nube, los entornos de prueba y las herramientas de colaboración, acelerando los ciclos de desarrollo.

Para la implementación, las plataformas en la nube proporcionan tuberías de implementación automatizadas, capacidades de integración continua y entrega continua (CI/CD) y redes de entrega de contenido (CDN) globales. Esto se traduce en ciclos de lanzamiento más rápidos, una mejor disponibilidad de las aplicaciones y una reducción de la sobrecarga de gestión de la infraestructura. El uso de servicios como AWS Lambda o Azure Functions permite arquitecturas sin servidor, lo que permite a los desarrolladores centrarse únicamente en el código. Estas tecnologías cambian el enfoque de las preocupaciones de la infraestructura a la calidad del código y las características.

20. ¿Cuáles son algunas de las preocupaciones de seguridad al migrar a un entorno de nube?

La migración a la nube introduce varias preocupaciones de seguridad. Las filtraciones de datos son una preocupación principal, ya que los datos confidenciales almacenados en la nube se convierten en un objetivo. Controles de acceso insuficientes y servicios en la nube mal configurados pueden exponer datos. El cumplimiento es otra preocupación, asegurando que el entorno de nube cumpla con los requisitos reglamentarios como el RGPD o HIPAA.

Otra área clave es la dependencia del proveedor y garantizar que las prácticas de seguridad del proveedor de la nube se alineen con las de su organización. Las amenazas internas de los empleados del proveedor de la nube o las cuentas comprometidas también son riesgos potenciales. Además, los ataques de denegación de servicio (DoS) y las amenazas persistentes avanzadas (APT) dirigidos a la infraestructura en la nube pueden interrumpir los servicios y comprometer los datos. Finalmente, el modelo de responsabilidad compartida, donde la seguridad se divide entre el proveedor de la nube y el cliente, puede generar lagunas si las responsabilidades no están claramente definidas y gestionadas.

21. ¿Qué papel juega la automatización en la gestión de la infraestructura en la nube?

La automatización es crucial para la gestión eficiente de la infraestructura en la nube. Reduce el esfuerzo manual, minimiza los errores y mejora la escalabilidad. Los casos de uso comunes incluyen el aprovisionamiento y la configuración automatizados de recursos, la implementación automatizada de aplicaciones utilizando pipelines de CI/CD, el escalado automatizado basado en la demanda y el monitoreo y la corrección automatizados de problemas. Las herramientas de Infraestructura como Código (IaC) como Terraform y CloudFormation permiten la gestión declarativa de la infraestructura, garantizando la consistencia y la repetibilidad.

22. ¿Cómo se puede monitorear el rendimiento de las aplicaciones que se ejecutan en la nube?

Monitorear el rendimiento de las aplicaciones en la nube implica varias estrategias clave. Los proveedores de nube ofrecen herramientas de monitoreo nativas como AWS CloudWatch, Azure Monitor y Google Cloud Monitoring que brindan métricas, registros y capacidades de rastreo. Estas herramientas le permiten rastrear la utilización de la CPU, el consumo de memoria, la latencia de la red y otras estadísticas vitales. También puede configurar alertas basadas en umbrales para ser notificado de degradaciones o anomalías en el rendimiento. Además, las herramientas de Monitoreo del Rendimiento de Aplicaciones (APM) como New Relic, DataDog y Dynatrace ofrecen información más profunda sobre el código de la aplicación, las consultas de la base de datos y las dependencias externas.

Además de las herramientas nativas de la nube y APM, los agregadores de registros como la pila ELK (Elasticsearch, Logstash, Kibana) o Splunk pueden ser invaluables para el análisis centralizado de registros. La monitorización sintética, que simula el tráfico de usuarios para probar la disponibilidad y la capacidad de respuesta de la aplicación desde diferentes ubicaciones geográficas, también es beneficiosa. Revisar regularmente los registros y las métricas y abordar proactivamente los cuellos de botella identificados es crucial para mantener un rendimiento óptimo de la aplicación en la nube.

23. ¿Cuáles son algunos de los desafíos de migrar aplicaciones heredadas a la nube?

La migración de aplicaciones heredadas a la nube presenta varios desafíos. Un obstáculo clave es a menudo la compatibilidad. Los sistemas heredados pueden depender de tecnologías obsoletas o configuraciones de hardware específicas que no se traducen bien al entorno de la nube. Esto puede requerir una refactorización de código significativa, una re-arquitectura o incluso la sustitución completa de la aplicación, lo que puede ser costoso y llevar mucho tiempo.

Otro desafío importante es la migración de datos. Mover grandes volúmenes de datos de sistemas locales a la nube puede ser complejo, especialmente cuando se trata de datos sensibles que requieren el cumplimiento de las regulaciones. Además, se deben abordar cuidadosamente problemas como las limitaciones del ancho de banda de la red, las inconsistencias de los datos y el tiempo de inactividad durante el proceso de migración. La seguridad es primordial, es fundamental garantizar que el entorno de la nube cumpla o supere los estándares de seguridad existentes.

24. ¿Cómo facilita la computación en la nube la colaboración y el intercambio de datos?

La computación en la nube facilita significativamente la colaboración y el intercambio de datos a través del almacenamiento y la accesibilidad centralizados. Múltiples usuarios pueden acceder y trabajar en los mismos datos simultáneamente desde diferentes ubicaciones, eliminando las barreras geográficas.

Los mecanismos clave incluyen:

- Almacenamiento centralizado: Los datos se almacenan en un repositorio central en la nube. Lo que lo hace accesible a los usuarios.

- Control de acceso: Los mecanismos de control de acceso basado en roles gestionan quién puede ver, editar o compartir datos específicos.

- Control de versiones: Las plataformas en la nube a menudo mantienen historiales de versiones de archivos, lo que permite a los usuarios realizar un seguimiento de los cambios y revertir a versiones anteriores si es necesario.

- Herramientas de colaboración: Muchos servicios en la nube integran funciones de colaboración como la coedición en tiempo real (por ejemplo, Google Docs) o la realización de comentarios, lo que mejora el trabajo en equipo.

- Opciones para compartir: Las plataformas en la nube ofrecen varias opciones para compartir, como la generación de enlaces compartibles con permisos específicos, lo que facilita la distribución de datos.

25. ¿Cuáles son las diferencias clave entre la computación en la nube y la computación en cuadrícula?

La computación en la nube y la computación en cuadrícula son ambos paradigmas de computación distribuida, pero difieren en su enfoque y gestión. La computación en la nube proporciona acceso bajo demanda a un conjunto compartido de recursos informáticos configurables (por ejemplo, redes, servidores, almacenamiento, aplicaciones y servicios) que se pueden aprovisionar y liberar rápidamente con un esfuerzo mínimo de gestión o interacción con el proveedor de servicios. Enfatiza la escalabilidad, la elasticidad y los modelos de pago por uso.

La computación en cuadrícula, por otro lado, se centra en agregar recursos geográficamente dispersos (a menudo heterogéneos) para resolver problemas complejos que requieren una potencia computacional masiva. Se utiliza típicamente para investigación y aplicaciones científicas. Mientras que la computación en la nube tiene como objetivo proporcionar un entorno disponible y gestionado, la computación en cuadrícula se trata más de compartir recursos y colaborar entre diferentes organizaciones o individuos, con un mayor grado de participación del usuario en la gestión de recursos.

26. ¿Qué es la computación sin servidor y cuáles son sus beneficios y desventajas?

La computación sin servidor es un modelo de ejecución de computación en la nube donde el proveedor de la nube gestiona dinámicamente la asignación de recursos de la máquina. No tiene que aprovisionar ni gestionar servidores. Simplemente implementa su código y el proveedor de la nube se encarga del resto. Ejemplos comunes incluyen AWS Lambda, Azure Functions y Google Cloud Functions.

Los beneficios incluyen la reducción de los costos operativos (pago por uso), el escalado automático, una implementación más rápida y una mayor productividad del desarrollador. Las desventajas incluyen la posible dependencia del proveedor, los inicios en frío (latencia inicial), las limitaciones en el tiempo de ejecución y los recursos, las complejidades de la depuración y la complejidad arquitectónica al componer muchas funciones juntas.

27. ¿Cómo se puede utilizar la computación en la nube para dar soporte al análisis de big data?

La computación en la nube proporciona una infraestructura escalable y rentable para el análisis de big data. Las plataformas en la nube ofrecen servicios como almacenamiento de objetos (por ejemplo, AWS S3, Azure Blob Storage) para almacenar conjuntos de datos masivos y servicios de computación (por ejemplo, AWS EC2, Azure Virtual Machines) para procesarlos. Los servicios gestionados, como el almacenamiento de datos (por ejemplo, Amazon Redshift, Google BigQuery), el procesamiento de datos (por ejemplo, AWS EMR, Azure HDInsight) y la computación sin servidor (por ejemplo, AWS Lambda, Azure Functions) simplifican aún más la canalización de análisis.

La elasticidad de la nube permite a los usuarios escalar los recursos hacia arriba o hacia abajo según la demanda, optimizando los costos. Por ejemplo, puede iniciar un clúster de máquinas para ejecutar un trabajo de Spark y luego apagarlas cuando el trabajo se complete. Además, las plataformas en la nube se integran bien con herramientas y marcos de análisis de big data como Hadoop, Spark y Kafka, lo que permite un procesamiento y análisis de datos sin problemas. La nube también proporciona funciones de seguridad y certificaciones de cumplimiento para proteger los datos confidenciales.

28. Explique el concepto de "cloud bursting" y sus casos de uso.

"Cloud bursting" es una estrategia de nube híbrida donde una aplicación o carga de trabajo normalmente se ejecuta en una nube privada o en un centro de datos local, pero "explota" a una nube pública cuando la demanda aumenta. Esto permite a las organizaciones manejar aumentos inesperados en el tráfico o las necesidades de procesamiento sin invertir en infraestructura local adicional que estaría inactiva la mayor parte del tiempo. Utiliza eficazmente los recursos de la nube pública como una extensión de la nube privada.

Los casos de uso comunes incluyen: manejo de picos de tráfico estacional para comercio electrónico, procesamiento de grandes conjuntos de datos para investigación científica, provisión de potencia de cómputo bajo demanda para renderización de medios y garantizar la continuidad del negocio durante escenarios de recuperación ante desastres. "Cloud bursting" también es beneficioso cuando las empresas quieren probar o implementar nuevas aplicaciones en el entorno de nube pública sin realizar una inversión inicial significativa.

29. Discuta el papel de DevOps en un entorno de nube y cómo mejora la eficiencia.

DevOps en un entorno de nube agiliza el desarrollo y la implementación de software. Cierra la brecha entre los equipos de desarrollo y operaciones, lo que permite ciclos de lanzamiento más rápidos, una mejor colaboración y una mayor fiabilidad. DevOps aprovecha las herramientas y servicios nativos de la nube para la automatización, la integración continua (CI) y la entrega continua (CD).

Específicamente, los entornos en la nube se benefician de DevOps a través de la infraestructura como código (IaC) para el aprovisionamiento automatizado de recursos, las pruebas y la monitorización automatizadas y las capacidades de auto-escalado, lo que mejora la utilización de los recursos y reduce los costes. Esto se traduce en una mayor eficiencia al reducir las intervenciones manuales, un tiempo de comercialización más rápido para las nuevas funciones y una mayor estabilidad general del sistema. Al utilizar las tuberías CI/CD específicas de la nube, las organizaciones pueden automatizar las compilaciones, las pruebas y las implementaciones en diversos entornos de nube con facilidad.

Preguntas de entrevista intermedias sobre computación en la nube

1. ¿Cómo funciona el auto-escalado en la nube y cuáles son las métricas clave que se deben supervisar para garantizar que funciona eficazmente?

El auto-escalado en la nube ajusta automáticamente el número de recursos informáticos (por ejemplo, máquinas virtuales) en función de la demanda. Normalmente funciona mediante la monitorización de la utilización de los recursos y la activación de acciones de escalado (añadiendo o eliminando recursos) cuando se cruzan los umbrales predefinidos. El proceso de escalado suele implicar estos pasos: monitorización de recursos, toma de decisiones (evaluación de políticas y umbrales) y ejecución (aprovisionamiento/desaprovisionamiento de instancias).

Métricas clave para monitorear para un autoescalado eficiente incluyen: utilización de CPU, utilización de memoria, tráfico de red, latencia de las solicitudes, el número de solicitudes activas y la longitud de la cola. Es crucial monitorear los costos asociados con las operaciones de escalado, así como el número de eventos de escalado (el escalado demasiado frecuente podría indicar una configuración subóptima). Adicionalmente, métricas específicas de la aplicación, como transacciones por segundo o tasas de error, pueden ser importantes. Monitorear eficazmente estas métricas permite ajustar la configuración del autoescalado para equilibrar el rendimiento, el costo y la capacidad de respuesta.

2. Explique la diferencia entre el escalado horizontal y vertical en la nube, y cuándo elegiría uno sobre el otro?

El escalado horizontal (escalado horizontalmente) implica agregar más máquinas a su grupo de recursos, mientras que el escalado vertical (escalado verticalmente) implica agregar más potencia (CPU, RAM) a una máquina existente.

Elegiría el escalado horizontal cuando su aplicación está diseñada para distribuirse en múltiples máquinas, lo que le permite manejar más tráfico simplemente agregando más servidores. A menudo se prefiere para entornos en la nube debido a su elasticidad y tolerancia a fallos. Elegiría el escalado vertical cuando el rendimiento de su aplicación se ve restringido por los recursos de una sola máquina y puede beneficiarse de más CPU o RAM. Sin embargo, el escalado vertical tiene limitaciones, ya que solo se puede escalar hasta la capacidad máxima de una sola máquina y puede requerir tiempo de inactividad durante las actualizaciones.

3. Describe un escenario donde utilizarías una herramienta de orquestación de contenedores como Kubernetes, y qué beneficios proporcionaría?

Considera un escenario donde estás implementando una aplicación de comercio electrónico basada en microservicios. Esta aplicación consta de múltiples servicios independientes como catálogo de productos, gestión de pedidos, autenticación de usuarios y procesamiento de pagos. Cada servicio se empaqueta como un contenedor Docker.

Usar Kubernetes ofrece varios beneficios. En primer lugar, automatiza la implementación, el escalado y la gestión de estos contenedores. Kubernetes asegura una alta disponibilidad al reiniciar automáticamente los contenedores fallidos y distribuir el tráfico. En segundo lugar, simplifica las actualizaciones con implementaciones graduales, minimizando el tiempo de inactividad. Finalmente, mejora la utilización de recursos al asignar dinámicamente recursos a los contenedores según la demanda. Esto conduce a una mejor eficiencia y ahorro de costos en comparación con la gestión manual de estos servicios en servidores individuales.

4. ¿Cuáles son los diferentes tipos de almacenamiento en la nube y cómo se elige el adecuado para diferentes necesidades de datos (por ejemplo, archivo, acceso frecuente)?

El almacenamiento en la nube viene en varios tipos principales: almacenamiento de objetos (como AWS S3), almacenamiento en bloques (como AWS EBS) y almacenamiento de archivos (como AWS EFS o AWS Storage Gateway). El almacenamiento de objetos es ideal para datos no estructurados como imágenes, videos y copias de seguridad, y a menudo se usa para el archivado debido a su rentabilidad y escalabilidad. El almacenamiento en bloques es similar a tener un disco duro virtual; es mejor para bases de datos, máquinas virtuales y aplicaciones que necesitan acceso de baja latencia. El almacenamiento de archivos proporciona un sistema de archivos compartido para múltiples usuarios o aplicaciones y es adecuado para escenarios como repositorios de contenido, entornos de desarrollo o flujos de trabajo multimedia.

La elección depende de la frecuencia de acceso, el tipo de datos, las necesidades de rendimiento y el costo. Para datos de archivo que necesitan acceso poco frecuente, el almacenamiento de objetos es generalmente la mejor opción. Para aplicaciones que requieren acceso frecuente y de baja latencia, el almacenamiento en bloques suele ser la opción preferida. El almacenamiento de archivos destaca cuando se necesita un sistema de archivos compartido entre múltiples recursos.

5. ¿Cómo se garantiza la seguridad de los datos en la nube, considerando tanto los datos en reposo como los datos en tránsito?

Para garantizar la seguridad de los datos en la nube, tanto en reposo como en tránsito, es crucial un enfoque de múltiples capas. Para los datos en reposo, el cifrado es primordial. Esto incluye cifrar los datos almacenados en bases de datos, almacenamiento de objetos y sistemas de archivos. La gestión de claves también es fundamental, utilizando servicios como KMS (Key Management Service) para almacenar y gestionar de forma segura las claves de cifrado. Se deben implementar listas de control de acceso (ACL) y políticas de gestión de identidades y accesos (IAM) para restringir el acceso a los datos basándose en el principio del privilegio mínimo. El análisis de vulnerabilidades y las pruebas de penetración periódicas ayudan a identificar y abordar posibles debilidades.

Para los datos en tránsito, el cifrado mediante protocolos como TLS/SSL (HTTPS) es esencial cuando los datos se transmiten a través de Internet. Las VPN o las conexiones de red privada dedicadas se pueden utilizar para una comunicación segura entre entornos locales y la nube. La supervisión del tráfico de red y la implementación de sistemas de detección/prevención de intrusiones (IDS/IPS) pueden ayudar a detectar y prevenir el acceso no autorizado. Además, el empleo de API seguras con mecanismos de autenticación y autorización protege los datos que se intercambian entre las aplicaciones.

6. ¿Cuáles son algunas estrategias comunes de migración a la nube y qué factores influirían en la elección de la estrategia?

Las estrategias comunes de migración a la nube incluyen: Rehosting (levantar y trasladar), Replatforming (levantar, modificar y trasladar), Refactorización (re-arquitectura), Recompra (cambiar a un nuevo producto) y Retirar (descomisionar). Cada una tiene diferentes niveles de complejidad y costos asociados.

Los factores que influyen en la elección de la estrategia incluyen: la complejidad y criticidad empresarial de la aplicación, las limitaciones de tiempo, el presupuesto, las habilidades técnicas disponibles y el nivel deseado de optimización en la nube. Por ejemplo, si una aplicación es simple y el tiempo es limitado, el rehosting podría ser apropiado. Sin embargo, para una aplicación crítica donde la optimización de costos es importante y el tiempo lo permite, la refactorización podría ser una mejor opción. Además, los requisitos de cumplimiento también pueden influir en el enfoque a adoptar.

7. Explique el concepto de Infraestructura como código (IaC) y qué herramientas se pueden usar para implementarlo?

La Infraestructura como código (IaC) es la práctica de administrar y aprovisionar la infraestructura a través de archivos de definición legibles por máquina, en lugar de procesos manuales o herramientas de configuración interactivas. Piense en ello como tratar la configuración de su infraestructura como trata el código de la aplicación: escríbalo, versionelo, pruébelo e implementelo. Esto permite la automatización, la consistencia, la repetibilidad y el control de versiones de su infraestructura.

Se pueden usar varias herramientas para implementar IaC. Algunas opciones populares incluyen:

- Terraform: Una herramienta de infraestructura como código de código abierto que le permite definir y aprovisionar infraestructura usando un lenguaje de configuración declarativo.

- Ansible: Un motor de automatización de código abierto que utiliza playbooks (archivos YAML) para definir configuraciones de infraestructura y automatizar tareas.

- CloudFormation: Un servicio ofrecido por AWS que le permite definir y aprovisionar infraestructura de AWS usando plantillas JSON o YAML.

- Plantillas de Azure Resource Manager (ARM): Un servicio ofrecido por Azure que le permite definir y aprovisionar infraestructura de Azure usando plantillas JSON.

- Pulumi: Una herramienta IaC de código abierto que le permite definir y aprovisionar infraestructura utilizando lenguajes de programación familiares como Python, TypeScript, Go y C#.

8. ¿Cómo supervisa los recursos y las aplicaciones en la nube, y cuáles son algunos indicadores clave de rendimiento (KPI) que rastrearía?

Superviso los recursos y las aplicaciones en la nube utilizando una combinación de herramientas nativas del proveedor de la nube (como AWS CloudWatch, Azure Monitor o Google Cloud Monitoring) y soluciones de supervisión de terceros (como Prometheus, Datadog o New Relic). Estas herramientas me permiten recopilar métricas, registros y rastreos de varios recursos y aplicaciones.

Los indicadores clave de rendimiento (KPI) que rastrearía incluyen: utilización de la CPU, uso de memoria, E/S de disco, tráfico de red, latencia de las solicitudes, tasas de error (por ejemplo, errores 5xx), tiempo de respuesta de la aplicación, rendimiento de las consultas de la base de datos y el número de usuarios activos. Para entornos en contenedores, también supervisaría el uso de recursos del contenedor y el número de reinicios del contenedor. Para sin servidor, supervisaría los recuentos de invocaciones, la duración de la ejecución y los inicios en frío.

9. Describa una situación en la que usaría una arquitectura de computación sin servidor, y cuáles son las ventajas y desventajas?

Un buen escenario para la computación sin servidor es el procesamiento de imágenes cargadas en un sitio web. Cuando un usuario carga una imagen, una función sin servidor (como AWS Lambda) se puede activar para redimensionar automáticamente la imagen, convertirla a diferentes formatos (por ejemplo, JPEG, PNG, WebP) y almacenar las versiones optimizadas en el almacenamiento en la nube (por ejemplo, AWS S3). Esto elimina la necesidad de administrar un servidor dedicado para el procesamiento de imágenes.

Las ventajas incluyen escalado automático (maneja cargas de trabajo variables sin problemas), rentabilidad (solo se paga por el tiempo de cómputo utilizado) y reducción de la sobrecarga operativa (sin mantenimiento de servidores). Las desventajas pueden incluir arranques en frío (latencia inicial cuando una función no se ha utilizado recientemente), potencial bloqueo del proveedor y limitaciones en el tiempo de ejecución y los recursos (memoria, espacio en disco). La depuración y el monitoreo también pueden ser más complejos en comparación con las aplicaciones tradicionales basadas en servidores.

10. ¿Cuáles son los diferentes modelos de implementación en la nube (por ejemplo, pública, privada, híbrida) y cómo se determina el mejor para una organización?

Los modelos de implementación en la nube incluyen nubes públicas, privadas, híbridas y comunitarias. Las nubes públicas ofrecen recursos a través de Internet, gestionados por un proveedor externo (por ejemplo, AWS, Azure, GCP). Las nubes privadas proporcionan recursos dedicados para una sola organización, ya sea en las instalaciones o alojadas por un proveedor. Las nubes híbridas combinan nubes públicas y privadas, lo que permite compartir datos y aplicaciones entre ellas. Las nubes comunitarias sirven a una comunidad específica con preocupaciones compartidas (por ejemplo, cumplimiento normativo).

Elegir el mejor modelo depende de factores como el costo, la seguridad, el cumplimiento, el control y la escalabilidad. Las nubes públicas son generalmente rentables para aplicaciones con demandas fluctuantes. Las nubes privadas ofrecen más control y seguridad para datos sensibles. Las nubes híbridas brindan flexibilidad y escalabilidad, lo que permite a las organizaciones aprovechar los beneficios tanto de las nubes públicas como de las privadas. Una evaluación exhaustiva de las necesidades y restricciones específicas de una organización es crucial para seleccionar el modelo de implementación óptimo.

11. Explique cómo implementaría un plan de recuperación ante desastres en la nube, incluidas las estrategias de copia de seguridad y recuperación.

La implementación de un plan de recuperación ante desastres (DR) en la nube implica varias estrategias clave. En primer lugar, la copia de seguridad y la replicación son cruciales. Se deben realizar copias de seguridad periódicas de datos y aplicaciones, almacenadas en una región geográfica diferente a la implementación principal en la nube. Los proveedores de la nube ofrecen servicios para copias de seguridad y replicación automatizadas en diferentes regiones. Por ejemplo, AWS ofrece snapshots de EBS, replicación entre regiones para buckets de S3 y copias de seguridad de RDS. Las estrategias de recuperación deben incluir la definición de Objetivos de Tiempo de Recuperación (RTO) y Objetivos de Punto de Recuperación (RPO).

En segundo lugar, la infraestructura como código (IaC) permite una rápida recuperación de todo el entorno. Al definir la infraestructura en código (por ejemplo, utilizando Terraform o CloudFormation), el entorno se puede recrear rápidamente en una nueva región en caso de desastre. Los procedimientos de conmutación por error (failover) y conmutación por recuperación (failback) deben estar documentados y probarse regularmente. Esto incluye automatizar el proceso de cambio de tráfico a la región secundaria y de vuelta a la región primaria una vez que se restaure. Los sistemas de monitoreo y alerta deben estar implementados para detectar fallos y activar el plan de recuperación ante desastres (DR) automáticamente. Los simulacros regulares de DR son esenciales para asegurar la efectividad del plan e identificar áreas de mejora.

12. ¿Cuáles son algunas estrategias para optimizar los costos en la nube y cómo se pueden identificar y eliminar gastos innecesarios?

Las estrategias para optimizar los costos en la nube involucran varias áreas clave. El dimensionamiento correcto de los recursos es crucial; analiza la utilización de CPU y memoria para evitar el sobreaprovisionamiento. Implementa el autoescalado para ajustar dinámicamente los recursos en función de la demanda. Aprovecha las instancias reservadas o los descuentos por uso comprometido para cargas de trabajo predecibles. Utiliza instancias spot para tareas tolerantes a fallos para ahorrar dinero.

Para identificar y eliminar gastos innecesarios, monitorea regularmente el uso y el gasto en la nube con herramientas de análisis de costos. Busca recursos inactivos o subutilizados, como máquinas virtuales y bases de datos. Identifica y elimina recursos huérfanos (por ejemplo, volúmenes no adjuntos, snapshots no utilizados). Implementa el etiquetado para mejorar la asignación de costos y la responsabilidad. Revisa regularmente los modelos de precios y explora opciones más rentables para tus necesidades. Considera el uso de funciones sin servidor (por ejemplo, AWS Lambda) cuando sea aplicable.

13. ¿Cómo gestionas la identidad y el control de acceso (IAM) en la nube y cuáles son algunas de las mejores prácticas para proteger las cuentas de usuario?

En la nube, la gestión de IAM se realiza a través de servicios proporcionados por el proveedor de la nube (por ejemplo, AWS IAM, Azure Active Directory, Google Cloud IAM). Estos servicios permiten crear y gestionar identidades de usuario, definir roles con permisos específicos y controlar el acceso a los recursos en la nube. Normalmente utilizo un enfoque de mínimo privilegio, otorgando a los usuarios solo los permisos que necesitan para desempeñar sus funciones laborales. La autenticación multifactor (MFA) es crucial para todas las cuentas de usuario, especialmente aquellas con privilegios administrativos.

Algunas de las mejores prácticas para proteger las cuentas de usuario incluyen: usar contraseñas fuertes y únicas; rotar regularmente las credenciales; implementar el control de acceso basado en roles (RBAC); auditar las configuraciones y la actividad de IAM; usar grupos para gestionar los permisos de manera eficiente; aplicar políticas de contraseñas (complejidad, caducidad); y monitorizar la actividad inusual que pueda indicar cuentas comprometidas. También es importante eliminar las cuentas y los permisos innecesarios de forma inmediata cuando los usuarios abandonan la organización o cambian de rol. También automatizo las tareas de IAM con herramientas como Infrastructure as Code (IaC) para garantizar la coherencia y la auditabilidad.

14. Describa cómo implementaría un pipeline de CI/CD en la nube y qué herramientas usaría?

Para implementar un pipeline de CI/CD en la nube, aprovecharía los servicios nativos de la nube y las herramientas de código abierto. Para la gestión del código fuente, usaría Git, alojado en GitHub, GitLab o AWS CodeCommit. Para CI, usaría Jenkins, GitLab CI, GitHub Actions o AWS CodePipeline para automatizar la compilación, las pruebas y el análisis de código estático (usando herramientas como SonarQube). Los artefactos se almacenarían en un repositorio como JFrog Artifactory o AWS S3.

Para CD, usaría una herramienta como Spinnaker, Argo CD o AWS CodeDeploy para desplegar en entornos como staging y producción. Infrastructure as Code (IaC) usando Terraform o CloudFormation se utilizaría para aprovisionar y gestionar los recursos de la nube, garantizando la coherencia entre los entornos. La monitorización y las alertas se integrarían utilizando herramientas como Prometheus, Grafana o CloudWatch para garantizar la salud y el rendimiento de la aplicación después del despliegue.

15. ¿Cuáles son las ventajas y desventajas de usar servicios gestionados frente a soluciones autogestionadas en la nube?

Los servicios gestionados ofrecen operaciones simplificadas, una reducción de la sobrecarga (parches, escalado, copias de seguridad) y, a menudo, menores costos de configuración inicial. Permiten centrarse en la lógica empresarial principal en lugar de la gestión de la infraestructura. Sin embargo, pueden ser más caros a largo plazo, ofrecer menos personalización y control, e introducir un bloqueo del proveedor. La optimización del rendimiento y la depuración pueden ser más difíciles debido al acceso limitado a la infraestructura subyacente.

Las soluciones autogestionadas ofrecen control total y personalización, lo que puede generar ahorros de costos con una utilización optimizada de los recursos. Evitan la dependencia del proveedor. Pero requieren una experiencia y recursos significativos para la configuración, el mantenimiento, el escalado y la seguridad. La organización es responsable de todos los aspectos de la infraestructura, incluida la respuesta a incidentes y la garantía de alta disponibilidad, lo que puede llevar mucho tiempo y ser costoso.

16. ¿Cómo soluciona los problemas de rendimiento en aplicaciones basadas en la nube y qué herramientas puede utilizar para el diagnóstico?

La resolución de problemas de rendimiento en aplicaciones en la nube implica un enfoque sistemático. Primero, identifique el cuello de botella: ¿Es el código de la aplicación, la base de datos, la red o la infraestructura? Comenzaría por monitorear las métricas clave utilizando herramientas del proveedor de la nube como AWS CloudWatch, Azure Monitor o Google Cloud Monitoring. Busque alta utilización de CPU, fugas de memoria, consultas lentas a la base de datos, latencia de la red y tasas de error.

A continuación, diagnostique la causa raíz: Use herramientas de perfilado como AWS X-Ray, Azure Application Insights o Google Cloud Trace para rastrear las solicitudes e identificar las rutas de ejecución de código lentas. Examine el rendimiento de las consultas de bases de datos usando herramientas como SQL Server Profiler o pgAdmin. Analice el tráfico de red usando herramientas como tcpdump o Wireshark. Para el código de la aplicación, usaría el registro extensivamente y posiblemente usaría un depurador para recorrer el código e identificar problemas. Finalmente, usaría herramientas de pruebas de carga como JMeter o Gatling para simular el tráfico de usuarios e identificar los cuellos de botella en el rendimiento bajo carga.

17. Explique el concepto de redes en la nube, incluyendo redes virtuales, subredes y enrutamiento.

Las redes en la nube se refieren a la creación y gestión de recursos de red dentro de un entorno de computación en la nube. Permite a las organizaciones construir y operar redes sin la necesidad de infraestructura física. Las redes virtuales son redes lógicamente aisladas dentro de la nube, lo que permite a los usuarios definir su propia topología de red. Las subredes son divisiones dentro de una red virtual, utilizadas para segmentar aún más la red y mejorar la seguridad y el rendimiento. El enrutamiento determina la ruta que el tráfico de red toma entre diferentes subredes, redes virtuales o hacia redes externas.

Componentes clave incluyen: Redes Virtuales (espacios de red aislados), Subredes (divisiones dentro de las redes virtuales), Enrutamiento (determinación de la ruta del tráfico), Grupos de Seguridad de Red (reglas de firewall) y Appliances Virtuales (por ejemplo, firewalls, equilibradores de carga). Los proveedores de nube ofrecen servicios para gestionar estos componentes, como AWS VPC, Azure Virtual Network y Google Cloud VPC.

18. ¿Cuáles son algunas amenazas comunes a la seguridad en la nube y cómo se pueden mitigar?

Las amenazas comunes a la seguridad en la nube incluyen violaciones de datos, configuraciones incorrectas, control de acceso insuficiente, API inseguras y ataques de denegación de servicio. El malware y el ransomware también plantean riesgos significativos, explotando vulnerabilidades en la infraestructura o aplicaciones en la nube.

Las estrategias de mitigación implican la implementación de controles de acceso sólidos (como la autenticación de múltiples factores), la supervisión y auditoría periódicas de las configuraciones de la nube, el uso de cifrado para datos en reposo y en tránsito, la protección de las API con mecanismos de autenticación y autorización, y el empleo de sistemas de detección/prevención de intrusiones. El escaneo de vulnerabilidades y las pruebas de penetración periódicas pueden identificar y abordar de forma proactiva las debilidades. Los proveedores de nube a menudo ofrecen herramientas y servicios de seguridad que se pueden aprovechar para mejorar la postura de seguridad, como AWS Security Hub o Azure Security Center.

19. ¿Cómo se asegura el cumplimiento de las regulaciones y estándares de la industria en la nube (por ejemplo, HIPAA, GDPR)?

Para garantizar el cumplimiento de las regulaciones y estándares de la industria en la nube, es crucial un enfoque multifacético. Esto incluye la implementación de políticas sólidas de gobernanza de datos, la realización de evaluaciones de riesgos periódicas y el establecimiento de controles de seguridad robustos. Específicamente, para HIPAA, esto significa implementar salvaguardias técnicas como cifrado, controles de acceso y registro de auditoría. Para GDPR, requiere garantizar la privacidad de los datos por diseño, obtener el consentimiento adecuado para el procesamiento de datos y proporcionar a las personas el derecho a acceder, rectificar y borrar sus datos.

Además, aproveche las herramientas y servicios de cumplimiento del proveedor de la nube (por ejemplo, AWS Artifact, Azure Compliance Manager) para evaluar y mantener el cumplimiento. Supervise y audite regularmente los sistemas para verificar el cumplimiento de las políticas y estándares. Las comprobaciones de cumplimiento automatizadas y la supervisión continua son vitales para identificar y abordar rápidamente las posibles violaciones. También es fundamental capacitar a los empleados sobre los requisitos de cumplimiento.

20. Explique la diferencia entre aplicaciones sin estado y con estado, y cómo se implementan de manera diferente en la nube.

Las aplicaciones sin estado no almacenan ningún dato del cliente (estado) en el servidor entre solicitudes. Cada solicitud de un cliente se trata como una transacción nueva e independiente. Esto las hace altamente escalables, ya que cualquier servidor puede manejar cualquier solicitud. Se implementan en la nube utilizando equilibradores de carga para distribuir las solicitudes entre múltiples instancias, lo que permite una fácil escalabilidad horizontal. Las estrategias de implementación comunes incluyen el uso de plataformas de orquestación de contenedores como Kubernetes o funciones sin servidor.

Las aplicaciones con estado, por otro lado, almacenan los datos del cliente (estado) en el servidor. Las peticiones subsiguientes dependen de estos datos almacenados. Esto las hace más complejas de escalar, ya que es necesario asegurar que las peticiones de un cliente se enruten al mismo servidor o tener un mecanismo para compartir el estado entre los servidores. La implementación en la nube a menudo implica el uso de soluciones de almacenamiento persistente (por ejemplo, bases de datos, cachés distribuidas) y sesiones fijas (enrutamiento de peticiones del mismo cliente al mismo servidor). Las herramientas de orquestación también deben configurarse para gestionar conjuntos con estado y asegurar la consistencia y disponibilidad de los datos. Por ejemplo, la implementación de una aplicación con estado con Kubernetes podría requerir el uso de PersistentVolumes y StatefulSets.

21. ¿Cómo diseñaría una arquitectura de aplicación altamente disponible y tolerante a fallos en la nube?

Para diseñar una arquitectura de aplicación altamente disponible y tolerante a fallos en la nube, aprovecharía varios principios clave. Primero, la redundancia es fundamental. Esto implica la implementación de múltiples instancias de la aplicación en diferentes zonas de disponibilidad (AZ) o regiones. Los equilibradores de carga distribuirían el tráfico entre estas instancias, asegurando que si una instancia falla, otras puedan asumir el control sin problemas. La replicación de datos en múltiples AZ/regiones también es esencial para la durabilidad de los datos.

En segundo lugar, implementaría mecanismos de monitoreo y conmutación por error automatizados. Las herramientas de monitoreo rastrearían el estado de las instancias de la aplicación y los componentes de la infraestructura. Si se detecta una falla, los procedimientos automatizados de conmutación por error cambiarían rápidamente el tráfico a instancias en buen estado, minimizando el tiempo de inactividad. La infraestructura inmutable y las prácticas de infraestructura como código mejoran aún más la resiliencia, lo que permite el aprovisionamiento rápido de recursos de reemplazo. Por último, la utilización de servicios administrados como bases de datos y colas de mensajes mejora la disponibilidad, ya que el proveedor de la nube gestiona gran parte de la gestión de la infraestructura subyacente.

Preguntas de entrevista de computación en la nube avanzada

1. ¿Cómo diseñaría un sistema basado en la nube que se escale automáticamente según la demanda en tiempo real y, al mismo tiempo, minimice los costos?

Un sistema de escalado automático basado en la nube minimiza los costos ajustando dinámicamente los recursos en función de la demanda en tiempo real. Los componentes clave incluyen: herramientas de monitoreo (por ejemplo, Prometheus, CloudWatch) para rastrear métricas como la utilización de la CPU, el uso de la memoria y la latencia de las solicitudes; un servicio de escalado automático (por ejemplo, AWS Auto Scaling, Azure Autoscale) configurado con políticas de escalado (por ejemplo, escalar horizontalmente cuando la CPU > 70%, escalar verticalmente cuando la CPU < 30%); y un equilibrador de carga (por ejemplo, Nginx, HAProxy, equilibradores de carga del proveedor de la nube) para distribuir el tráfico de manera uniforme entre las instancias. Implemente un período de enfriamiento para evitar fluctuaciones rápidas de escalado. Utilice estrategias de optimización de costos, como instancias reservadas o instancias puntuales, cuando corresponda. Además, revise periódicamente las políticas de escalado y el uso de recursos para identificar áreas de optimización adicional.

Para minimizar aún más los costos, considere funciones sin servidor (por ejemplo, AWS Lambda, Azure Functions) para cargas de trabajo impulsadas por eventos, ya que se escalan automáticamente sin necesidad de gestión de servidores. Implemente mecanismos de almacenamiento en caché (por ejemplo, Redis, Memcached) para reducir la carga de la base de datos y mejorar los tiempos de respuesta. El código debe optimizarse para el rendimiento. Por ejemplo:

def procesar_datos(datos): # Lógica de procesamiento de datos optimizada aquí pass

2. Explique el teorema CAP y cómo se aplica a las bases de datos distribuidas en la nube.

El teorema CAP establece que en un sistema distribuido, solo se pueden garantizar dos de las tres propiedades siguientes: Consistencia (todos los nodos ven los mismos datos al mismo tiempo), Disponibilidad (cada solicitud recibe una respuesta, sin garantía de que contenga la versión más reciente de la información) y Tolerancia a la partición (el sistema continúa operando a pesar de la partición arbitraria debido a fallas de la red).

En el contexto de las bases de datos en la nube distribuidas, el teorema CAP dicta las decisiones de diseño. Por ejemplo, una base de datos que prioriza la Consistencia y la Disponibilidad (CA) podría sacrificar la tolerancia a particiones, quedando no disponible durante las particiones de la red. Por el contrario, un sistema que prioriza la Disponibilidad y la Tolerancia a Particiones (AP) podría sacrificar la consistencia inmediata, empleando técnicas como la consistencia eventual. De manera similar, un sistema CP prioriza la Consistencia y la Tolerancia a Particiones, potencialmente sacrificando la disponibilidad durante las particiones, lo que significa que algunas solicitudes pueden agotar el tiempo de espera o fallar. Elegir el equilibrio adecuado depende de los requisitos específicos de la aplicación. Las bases de datos en la nube a menudo ofrecen niveles de consistencia configurables para permitir a los usuarios ajustar el equilibrio entre las propiedades CAP.

3. Describa una situación en la que una estrategia multi-nube sería beneficiosa. ¿Cuáles son los desafíos involucrados?

Una estrategia multi-nube puede ser beneficiosa cuando las organizaciones quieren evitar la dependencia de un proveedor, mejorar la resiliencia u optimizar los costos. Por ejemplo, una empresa de comercio electrónico podría usar AWS para su motor de recomendación de productos de alto rendimiento de cómputo, Azure para sus aplicaciones empresariales estrechamente integradas con los servicios de Microsoft y Google Cloud Platform para sus cargas de trabajo de análisis de datos y aprendizaje automático, aprovechando las fortalezas de cada nube. Esta diversificación asegura que si un proveedor de nube experimenta una interrupción, todo el sistema no fallará y pueden elegir la solución más rentable para cada tarea específica.

Sin embargo, la multi-nube introduce complejidades. Los desafíos incluyen la gestión de la consistencia de los datos en diferentes entornos de nube, el aumento de las preocupaciones de seguridad debido a una mayor superficie de ataque, la necesidad de conjuntos de habilidades especializadas para operar diferentes plataformas en la nube y la dificultad de mantener procedimientos consistentes de implementación y monitoreo de aplicaciones en las diferentes nubes. Además, la gestión y optimización de costos puede volverse más difícil ya que los modelos de precios difieren entre los proveedores de nube.

4. ¿Cómo puede garantizar la consistencia de los datos en múltiples regiones en una aplicación en la nube distribuida globalmente?

Garantizar la consistencia de los datos en una aplicación en la nube distribuida globalmente implica varias estrategias. La replicación de datos es fundamental, donde los datos se copian en múltiples regiones. Sin embargo, la replicación simple puede generar inconsistencias. Los modelos de consistencia fuerte, como la linealizabilidad o la consistencia secuencial, garantizan que todas las lecturas vean la escritura más reciente, pero estos pueden impactar significativamente la latencia. Técnicas como Paxos o Raft se pueden emplear para el consenso distribuido, asegurando que los datos se actualicen consistentemente en todas las regiones. La fragmentación o partición de datos también puede ayudar distribuyendo los datos geográficamente, lo que reduce la latencia, pero requiere una cuidadosa consideración para evitar puntos críticos.

Alternativamente, la consistencia eventual ofrece mayor disponibilidad y menor latencia, pero acepta que los datos podrían ser temporalmente inconsistentes. Estrategias como mecanismos de resolución de conflictos (por ejemplo, el último que escribe gana, relojes vectoriales) son entonces cruciales. La implementación de sistemas robustos de monitoreo y alerta ayuda a detectar y resolver las inconsistencias de datos rápidamente. Elegir el modelo de consistencia adecuado depende de los requisitos específicos de la aplicación, equilibrando la necesidad de una consistencia fuerte con el nivel aceptable de latencia y disponibilidad.

5. ¿Cuáles son las consideraciones clave al migrar una aplicación heredada a una arquitectura nativa de la nube?

Migrar una aplicación heredada a una arquitectura nativa de la nube requiere una planificación y ejecución cuidadosas. Las consideraciones clave incluyen: la refactorización (o reescritura) de la aplicación para alinearse con los microservicios y la contenerización. Elegir el proveedor de nube y los servicios adecuados para computación, almacenamiento y bases de datos es crucial. Las estrategias de migración de datos para garantizar un tiempo de inactividad mínimo y la integridad de los datos también son muy importantes. También considere las implicaciones de seguridad al pasar de una configuración local potencialmente aislada a un entorno de nube distribuida.

Además, los equipos necesitan adaptarse a las prácticas de DevOps con automatización para CI/CD, infraestructura como código y monitoreo. La optimización de costos también es vital, evaluando cuidadosamente los precios de los servicios en la nube y la utilización de recursos. Las aplicaciones heredadas pueden tener dependencias que crean desafíos, como dependencias de sistemas operativos, bibliotecas o marcos específicos, que deben abordarse durante el proceso de migración.

6. Explique las diferencias entre las herramientas de Infraestructura como Código (IaC) como Terraform y CloudFormation. ¿Cuándo elegiría una sobre la otra?

Terraform y CloudFormation son herramientas de Infraestructura como Código (IaC), pero difieren en alcance y funcionalidad. Terraform es una herramienta independiente del proveedor, lo que significa que puede gestionar infraestructura en múltiples proveedores de nube (AWS, Azure, GCP, etc.) e incluso en entornos locales. CloudFormation, por otro lado, es específico de AWS, lo que limita su uso solo a los recursos de AWS. Esto hace que Terraform sea una mejor opción para implementaciones multi-nube o cuando se anticipa la necesidad de mover la infraestructura entre proveedores. CloudFormation a menudo tiene soporte más temprano o el mismo día para los nuevos servicios de AWS, mientras que el soporte de Terraform puede ir un poco rezagado. El lenguaje subyacente utilizado por Terraform es HashiCorp Configuration Language (HCL), que muchos consideran intuitivo, mientras que CloudFormation utiliza YAML o JSON.

7. ¿Cómo aborda la solución de problemas de cuellos de botella de rendimiento en un entorno de nube complejo?

La solución de problemas de cuellos de botella de rendimiento en un entorno de nube complejo implica un enfoque sistemático. Primero, identificaría el cuello de botella usando herramientas de monitoreo como CloudWatch, Prometheus o Datadog para observar métricas como la utilización de la CPU, el uso de la memoria, la latencia de la red y la E/S del disco. Una vez identificado, analizaría los registros (de aplicación, sistema y red) para comprender los eventos que conducen al cuello de botella. Luego, usaría herramientas de perfilado o rastreo distribuido para identificar las partes lentas de la ejecución del código o el flujo de solicitudes a través del sistema.

A continuación, formularía y probaría hipótesis. Por ejemplo, si la base de datos es lenta, verificaría el rendimiento de las consultas y la indexación. Si el problema es la red, examinaría el enrutamiento, las reglas del firewall y el ancho de banda. Luego, implementaría soluciones como escalar recursos, optimizar el código o las consultas, el almacenamiento en caché o la re-arquitectura de componentes, mientras monitoreo continuamente para confirmar que mis acciones han mejorado el rendimiento y para evitar regresiones. También usaría la infraestructura como código para gestionar los cambios y evitar desviaciones de la configuración. Finalmente, automatizar la alerta y los mecanismos de autocuración es esencial para la gestión proactiva de cuellos de botella en la nube.

8. Describe los diferentes modelos de seguridad en la nube y cómo implementar la defensa en profundidad para una aplicación en la nube.

Los modelos de seguridad en la nube giran en torno a la responsabilidad compartida. El proveedor asegura la infraestructura (cómputo, almacenamiento, red), mientras que el cliente asegura lo que pone en la nube (datos, aplicaciones, configuraciones). Los modelos clave incluyen:

- IaaS (Infraestructura como Servicio): Usted gestiona la mayor parte, controlando el sistema operativo, el almacenamiento y las aplicaciones desplegadas. La seguridad es en gran medida su responsabilidad.

- PaaS (Plataforma como Servicio): El proveedor gestiona el sistema operativo, la aplicación de parches y la infraestructura. Usted se centra en el desarrollo de aplicaciones y la seguridad de su código/datos.

- SaaS (Software como Servicio): El proveedor gestiona casi todo, incluida la propia aplicación. Sus principales preocupaciones de seguridad son el acceso a los datos y la gestión de usuarios.

La defensa en profundidad para una aplicación en la nube implica múltiples capas de controles de seguridad. Esto puede incluir:

- Gestión de Identidades y Accesos (IAM): Autenticación fuerte (MFA), principio del mínimo privilegio.

- Seguridad de la red: Cortafuegos, segmentación de la red, sistemas de detección/prevención de intrusiones (IDS/IPS).

- Cifrado de datos: Cifrar datos en reposo y en tránsito.

- Seguridad de la aplicación: Prácticas de codificación segura, escaneo de vulnerabilidades, firewalls de aplicaciones web (WAF).

- Registro y supervisión: Registro centralizado, gestión de eventos e información de seguridad (SIEM).

- Evaluaciones de seguridad periódicas: Pruebas de penetración, evaluaciones de vulnerabilidades, auditorías de seguridad.

9. ¿Cómo puede aprovechar la computación sin servidor para crear aplicaciones altamente escalables y rentables?

La computación sin servidor permite construir aplicaciones altamente escalables y rentables al abstraer la gestión de servidores. Solo paga por el tiempo de cómputo consumido, escalando automáticamente según la demanda. Esto elimina la necesidad de aprovisionar y gestionar servidores, reduciendo la sobrecarga operativa y los costos de infraestructura.

Para aprovechar esto, puedes dividir tu aplicación en funciones independientes y sin estado que se activan por eventos (por ejemplo, solicitudes HTTP, cambios en la base de datos, mensajes). Servicios como AWS Lambda, Azure Functions y Google Cloud Functions te permiten implementar y ejecutar estas funciones sin administrar la infraestructura subyacente. Este enfoque simplifica el desarrollo, la implementación y el escalado, lo que resulta en la optimización de costos y una mayor eficiencia, especialmente para aplicaciones con cargas de trabajo variables o impredecibles. Por ejemplo, el procesamiento de imágenes cargadas en el almacenamiento en la nube se puede lograr fácilmente a través de funciones sin servidor que se activan en eventos de carga. Considera el siguiente ejemplo:

import boto3 def lambda_handler(event, context): s3 = boto3.client('s3') bucket = event['Records'][0]['s3']['bucket']['name'] key = event['Records'][0]['s3']['object']['key'] print(f"Processing image {key} from bucket {bucket}") # Image processing logic here return { 'statusCode': 200, 'body': 'Image processed successfully!' }

10. ¿Cuáles son las ventajas y desventajas de usar contenedores y máquinas virtuales en la nube?

Los contenedores y las máquinas virtuales ofrecen diferentes compensaciones en la nube. Las máquinas virtuales proporcionan un fuerte aislamiento, garantizando recursos dedicados y seguridad a nivel de hipervisor. Esto tiene el costo de una mayor sobrecarga debido a un sistema operativo completo por máquina virtual, lo que lleva a tiempos de inicio más lentos y una utilización de recursos menos eficiente.

Por otro lado, los contenedores ofrecen una virtualización ligera al compartir el kernel del sistema operativo anfitrión. Esto resulta en tiempos de inicio más rápidos, mejor eficiencia de recursos y mayor densidad. Sin embargo, ofrecen un aislamiento más débil que las máquinas virtuales (VM), ya que un contenedor comprometido podría afectar potencialmente a otros contenedores o al sistema operativo anfitrión. Elegir entre ellos depende de las necesidades de seguridad de la aplicación, los requisitos de recursos y las prioridades de rendimiento.

11. Explique cómo implementaría una estrategia de despliegue azul-verde en la nube.