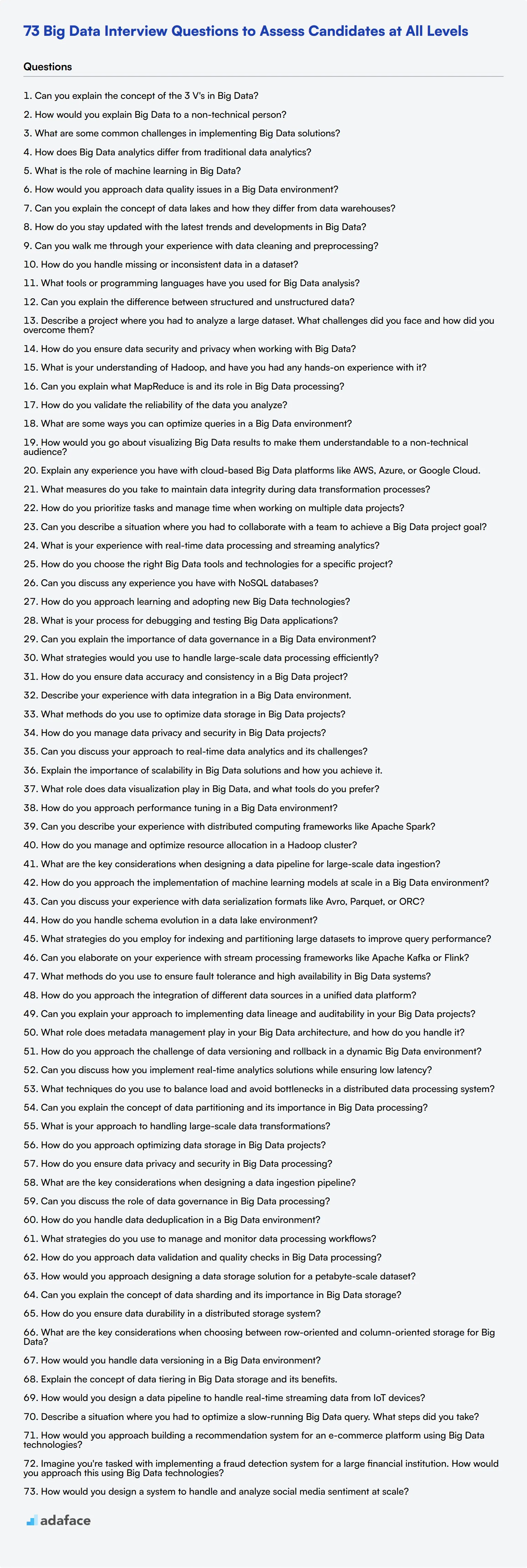

73 preguntas de entrevista de Big Data para evaluar a los candidatos en todos los niveles

Contratar el talento adecuado en Big Data puede cambiar las reglas del juego para cualquier organización. En esta publicación, proporcionamos una lista completa de preguntas y respuestas de entrevistas de Big Data, esenciales para que los entrevistadores tomen decisiones informadas.

Esta publicación de blog cubre una variedad de preguntas adecuadas para evaluar a los candidatos en diferentes niveles: analistas junior, analistas de nivel medio y analistas senior. También incluimos preguntas relacionadas con el procesamiento de datos, el almacenamiento de datos y escenarios situacionales para ayudarlo a evaluar la competencia técnica y las habilidades de resolución de problemas.

Al usar estas preguntas, puede evaluar con confianza las capacidades de los posibles candidatos y asegurarse de que se ajusten a las necesidades de su equipo. Para optimizar aún más su proceso de contratación, considere usar nuestras pruebas de evaluación de Big Data.

Tabla de contenido

8 preguntas y respuestas generales de entrevistas de Big Data para evaluar a los candidatos

20 preguntas de entrevista de Big Data para hacer a los analistas junior

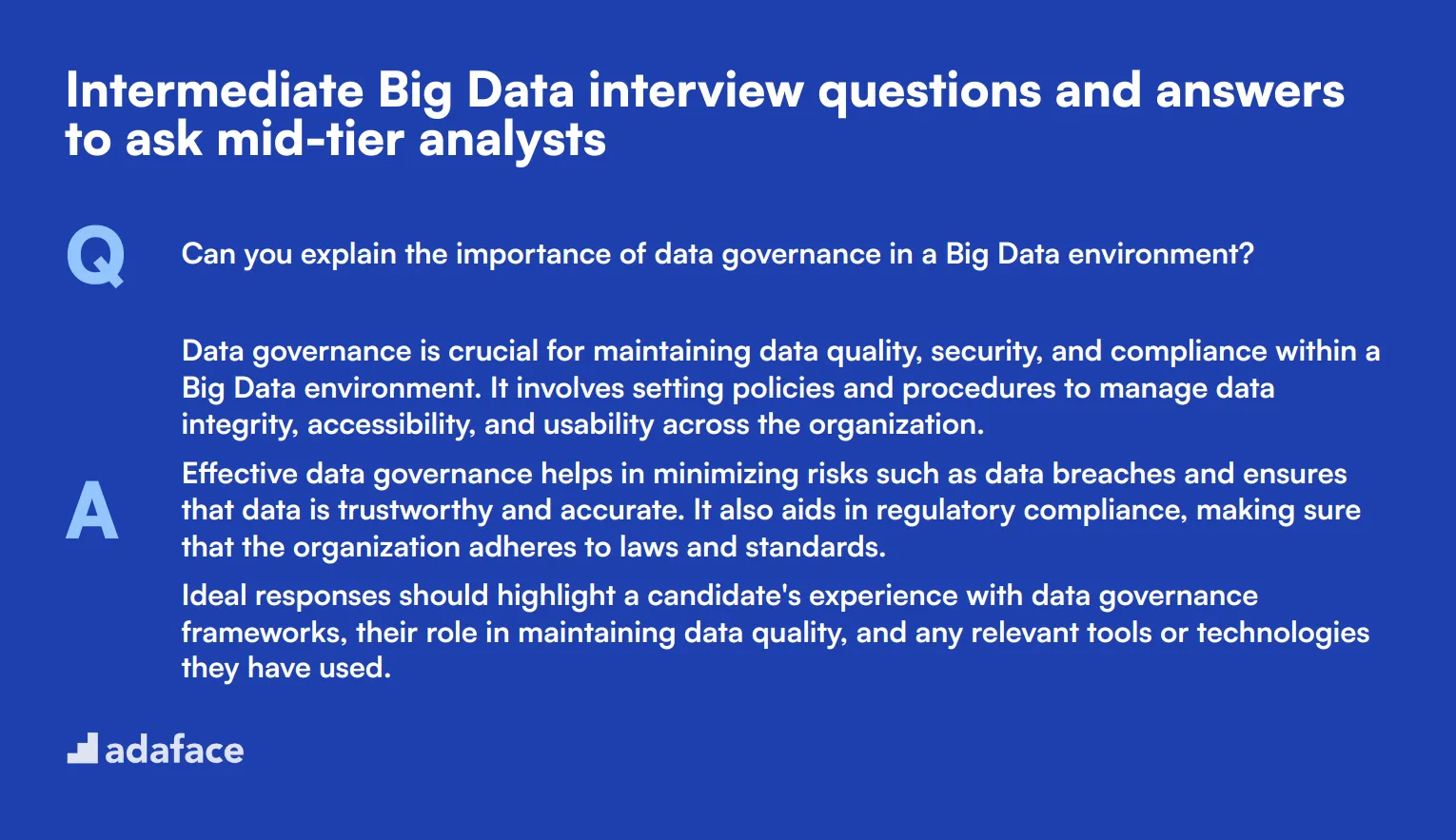

10 preguntas y respuestas de entrevistas de Big Data de nivel intermedio para hacer a los analistas de nivel medio

15 preguntas de entrevista de Big Data avanzadas para hacer a los analistas senior

9 preguntas y respuestas de entrevistas de Big Data relacionadas con el procesamiento de datos

6 preguntas y respuestas de entrevistas de Big Data relacionadas con el almacenamiento de datos

5 preguntas de entrevista de Big Data situacionales con respuestas para contratar a los mejores analistas

¿Qué habilidades de Big Data debe evaluar durante la fase de la entrevista?

Consejos para entrevistas efectivas de Big Data

Use preguntas de entrevistas de Big Data y pruebas de habilidades para contratar analistas talentosos

Descargue la plantilla de preguntas de entrevista de Big Data en múltiples formatos

8 preguntas y respuestas generales sobre entrevistas de Big Data para evaluar a los candidatos

¿Listo para sumergirte en el mundo de las entrevistas de Big Data? Estas 8 preguntas generales te ayudarán a evaluar la comprensión de los candidatos sobre los conceptos clave y su capacidad para aplicarlos. Usa esta lista para medir el conocimiento del candidato, sus habilidades para resolver problemas y sus habilidades de pensamiento crítico en el campo en constante evolución de Big Data.

1. ¿Puedes explicar el concepto de las 3 V en Big Data?

Las 3 V en Big Data se refieren a Volumen, Velocidad y Variedad. Estas son las tres propiedades o dimensiones definitorias de Big Data:

• Volumen: Esto se refiere a la gran cantidad de datos generados cada segundo. Big Data a menudo involucra petabytes y exabytes de datos.

• Velocidad: Esto representa la velocidad a la que se generan nuevos datos y el ritmo al que los datos se mueven. Piensa en la entrega de información en tiempo real o casi en tiempo real.

• Variedad: Esto se refiere a los diferentes tipos de datos disponibles. Los tipos de datos tradicionales eran estructurados y encajaban perfectamente en una base de datos relacional. Con Big Data, los datos vienen en nuevos tipos de datos no estructurados, incluyendo texto, audio y video.

Busca candidatos que puedan explicar claramente cada "V" y proporcionar ejemplos relevantes. Los candidatos fuertes también podrían mencionar "V" adicionales que se han propuesto, como Veracidad (la fiabilidad de los datos) y Valor (el valor de los datos que se extraen).

2. ¿Cómo explicarías Big Data a una persona no técnica?

Una buena explicación para una persona no técnica podría ser algo como esto: 'Big Data es como tener una biblioteca gigante con millones de libros en diferentes idiomas y formatos. Algunos son libros de texto, algunos son audiolibros, algunos incluso son películas. Ahora imagina intentar encontrar información específica en todos estos libros rápidamente. Ese es el desafío de Big Data.'

'No se trata solo de tener mucha información, sino de poder darle sentido a todo. Las tecnologías de Big Data nos ayudan a organizar, buscar y comprender esta enorme cantidad de información, para que podamos usarla para tomar mejores decisiones o crear nuevos productos y servicios.'

Busque candidatos que puedan simplificar conceptos complejos sin perder su esencia. La capacidad de comunicar ideas técnicas a las partes interesadas no técnicas es crucial para muchos roles de Big Data.

3. ¿Cuáles son algunos desafíos comunes en la implementación de soluciones de Big Data?

Los candidatos deben ser capaces de identificar varios desafíos en la implementación de soluciones de Big Data, tales como:

• Calidad y limpieza de datos: Asegurar que los datos sean precisos, completos y consistentes.

• Integración de datos: Combinar datos de varias fuentes y formatos.

• Seguridad y privacidad de los datos: Proteger la información sensible y cumplir con las regulaciones.

• Escalabilidad: Diseñar sistemas que puedan manejar crecientes volúmenes de datos.

• Brecha de habilidades: Encontrar profesionales con la experiencia adecuada para trabajar con tecnologías de Big Data.

• Costo: Gestionar los gastos asociados con el almacenamiento y procesamiento de grandes volúmenes de datos.

Un candidato fuerte no solo enumerará estos desafíos, sino que también discutirá posibles soluciones o estrategias para abordarlos. Podrían mencionar técnicas como la gobernanza de datos, la computación distribuida o programas de aprendizaje continuo para abordar la brecha de habilidades.

4. ¿En qué se diferencia el análisis de Big Data del análisis de datos tradicional?

Al responder a esta pregunta, los candidatos deben resaltar las diferencias clave como:

• Escala: El análisis de Big Data se ocupa de volúmenes de datos mucho mayores, a menudo en petabytes o exabytes.

• Tipos de datos: El análisis tradicional suele funcionar con datos estructurados, mientras que el análisis de Big Data puede manejar datos no estructurados y semiestructurados.

• Velocidad de procesamiento: El análisis de Big Data a menudo implica procesamiento en tiempo real o casi en tiempo real, a diferencia del procesamiento por lotes tradicional.

• Tecnología: Big Data requiere herramientas y plataformas especializadas como Hadoop, Spark o bases de datos NoSQL, mientras que el análisis tradicional podría usar bases de datos relacionales y herramientas de inteligencia empresarial.

• Enfoque: Big Data a menudo utiliza técnicas de aprendizaje automático e IA para encontrar patrones e ideas, mientras que el análisis tradicional podría depender más de las pruebas de hipótesis y los métodos estadísticos.

Busque candidatos que puedan explicar estas diferencias claramente y proporcionar ejemplos de cuándo el análisis de Big Data podría ser preferido sobre los métodos tradicionales. Los candidatos fuertes también podrían discutir el concepto de ingeniería de datos y su papel en la preparación de datos para el análisis.

5. ¿Cuál es el papel del aprendizaje automático en Big Data?

El aprendizaje automático desempeña un papel crucial en el análisis de Big Data. Los candidatos deben ser capaces de explicar que los algoritmos de aprendizaje automático pueden identificar patrones automáticamente y hacer predicciones o tomar decisiones basadas en grandes volúmenes de datos. Algunos puntos clave que podrían mencionar incluyen:

• Análisis predictivo: los modelos de aprendizaje automático pueden pronosticar tendencias futuras basadas en Big Data histórico.

• Detección de anomalías: los algoritmos de ML pueden identificar patrones inusuales que podrían indicar fraude o fallas del sistema.

• Personalización: ML puede analizar datos de comportamiento del usuario para proporcionar recomendaciones o experiencias personalizadas.

• Procesamiento del lenguaje natural: ML permite el análisis de datos de texto no estructurados, lo que permite el análisis de sentimiento, la clasificación de texto y más.

• Análisis de imágenes y video: los algoritmos de ML pueden procesar y extraer información de Big Data visual.

Los candidatos fuertes podrán proporcionar ejemplos específicos de cómo se aplica el aprendizaje automático en escenarios de Big Data. También podrían discutir los desafíos de implementar ML en entornos de Big Data, como la necesidad de computación distribuida y la importancia de la ingeniería de características.

6. ¿Cómo abordaría los problemas de calidad de los datos en un entorno de Big Data?

Los candidatos deben esbozar un enfoque sistemático para abordar los problemas de calidad de los datos en Big Data:

-

Perfilado de datos: Analizar los datos para comprender su estructura, contenido y calidad.

-

Definir métricas de calidad: Establecer criterios claros para lo que constituye datos 'buenos'.

-

Implementar la validación de datos: Utilizar reglas y algoritmos para verificar los datos con los estándares de calidad.

-

Limpieza de datos: Aplicar técnicas para corregir o eliminar registros inexactos.

-

Monitoreo continuo: Configurar sistemas para verificar continuamente la calidad de los datos a medida que fluyen nuevos datos.

-

Análisis de la causa raíz: Investigar las fuentes de los problemas de calidad de los datos para evitar futuras ocurrencias.

-

Gobernanza de datos: Establecer políticas y procedimientos para mantener la calidad de los datos en toda la organización.

Busque candidatos que enfaticen la importancia de un enfoque proactivo para la calidad de los datos y entiendan que es un proceso continuo, no una solución única. Los candidatos fuertes también podrían discutir herramientas o tecnologías específicas que hayan utilizado para la gestión de la calidad de los datos en entornos de Big Data.

7. ¿Puede explicar el concepto de lagos de datos y en qué se diferencian de los almacenes de datos?

Los candidatos deben ser capaces de explicar que un lago de datos es un repositorio de almacenamiento que contiene una gran cantidad de datos sin procesar en su formato nativo hasta que se necesitan. Los puntos clave a cubrir incluyen:

• Estructura: Los lagos de datos almacenan datos en su forma bruta, mientras que los almacenes de datos almacenan datos estructurados y procesados.

• Tipos de datos: Los lagos de datos pueden almacenar datos estructurados, semiestructurados y no estructurados, mientras que los almacenes de datos normalmente solo manejan datos estructurados.

• Esquema: Los lagos de datos utilizan un enfoque de esquema en lectura, mientras que los almacenes de datos utilizan un esquema en escritura.

• Casos de uso: Los lagos de datos son ideales para el análisis de big data, el aprendizaje automático y el descubrimiento de datos. Los almacenes de datos son mejores para la generación de informes operativos y la inteligencia empresarial.

• Flexibilidad: Los lagos de datos ofrecen más flexibilidad en términos de almacenamiento y análisis de datos, mientras que los almacenes de datos son más rígidos pero ofrecen un rendimiento de consulta más rápido para casos de uso específicos.

Busque candidatos que puedan articular claramente estas diferencias y discutir escenarios en los que uno podría ser preferible sobre el otro. Los candidatos fuertes también podrían mencionar desafíos asociados con los lagos de datos, como los posibles pantanos de datos y la necesidad de una gestión efectiva de metadatos.

8. ¿Cómo se mantiene actualizado con las últimas tendencias y desarrollos en Big Data?

Esta pregunta evalúa el compromiso del candidato con el aprendizaje continuo y su participación en la comunidad de Big Data. Las respuestas sólidas podrían incluir:

• Seguir blogs de la industria y sitios de noticias (por ejemplo, KDnuggets, Data Science Central)

• Asistir a conferencias y seminarios web

• Participar en cursos en línea u obtener certificaciones

• Participar en proyectos de código abierto o hackathons

• Leer artículos académicos e informes de la industria

• Seguir a líderes de opinión en plataformas de redes sociales

• Experimentar con nuevas herramientas y tecnologías en proyectos personales

Busque candidatos que demuestren un entusiasmo genuino por el campo y un enfoque proactivo del aprendizaje. Los mejores candidatos podrán discutir las tendencias o desarrollos recientes que hayan llamado su atención y explicar cómo podrían aplicar este conocimiento en su trabajo.

20 preguntas de entrevista de Big Data para hacer a analistas junior

Para ayudarle a evaluar los conocimientos fundamentales y el potencial de los analistas junior en Big Data, considere estas preguntas de entrevista cuidadosamente seleccionadas. Utilice esta guía para identificar a los candidatos que pueden crecer en roles más avanzados y contribuir significativamente a sus iniciativas de Big Data.

- ¿Puedes guiarme a través de tu experiencia con la limpieza y el preprocesamiento de datos?

- ¿Cómo manejas los datos faltantes o inconsistentes en un conjunto de datos?

- ¿Qué herramientas o lenguajes de programación has utilizado para el análisis de Big Data?

- ¿Puedes explicar la diferencia entre datos estructurados y no estructurados?

- Describe un proyecto en el que tuviste que analizar un gran conjunto de datos. ¿Qué desafíos enfrentaste y cómo los superaste?

- ¿Cómo aseguras la seguridad y la privacidad de los datos cuando trabajas con Big Data?

- ¿Cuál es tu comprensión de Hadoop y has tenido alguna experiencia práctica con él?

- ¿Puedes explicar qué es MapReduce y su papel en el procesamiento de Big Data?

- ¿Cómo validas la fiabilidad de los datos que analizas?

- ¿Cuáles son algunas formas en que puedes optimizar las consultas en un entorno de Big Data?

- ¿Cómo visualizarías los resultados de Big Data para que sean comprensibles para una audiencia no técnica?

- Explica cualquier experiencia que tengas con plataformas de Big Data basadas en la nube como AWS, Azure o Google Cloud.

- ¿Qué medidas tomas para mantener la integridad de los datos durante los procesos de transformación de datos?

- ¿Cómo priorizas las tareas y administras el tiempo cuando trabajas en múltiples proyectos de datos?

- ¿Puedes describir una situación en la que tuviste que colaborar con un equipo para lograr un objetivo de proyecto de Big Data?

- ¿Cuál es tu experiencia con el procesamiento de datos en tiempo real y el análisis de streaming?

- ¿Cómo eliges las herramientas y tecnologías de Big Data adecuadas para un proyecto específico?

- ¿Puedes hablar sobre cualquier experiencia que tengas con bases de datos NoSQL?

- ¿Cómo abordas el aprendizaje y la adopción de nuevas tecnologías de Big Data?

- ¿Cuál es tu proceso para depurar y probar aplicaciones de Big Data?

10 preguntas y respuestas intermedias de entrevista sobre Big Data para hacer a analistas de nivel medio

Para evaluar la competencia de los analistas de nivel medio en Big Data, estas preguntas intermedias le ayudarán a medir sus conocimientos y habilidades para la resolución de problemas. Utilice esta lista durante las entrevistas para asegurarse de que los candidatos están bien versados en los desafíos y soluciones de Big Data del mundo real.

1. ¿Puede explicar la importancia de la gobernanza de datos en un entorno de Big Data?

La gobernanza de datos es crucial para mantener la calidad, la seguridad y el cumplimiento de los datos dentro de un entorno de Big Data. Implica establecer políticas y procedimientos para gestionar la integridad, accesibilidad y usabilidad de los datos en toda la organización.

La gobernanza de datos efectiva ayuda a minimizar riesgos como las filtraciones de datos y asegura que los datos sean confiables y precisos. También ayuda en el cumplimiento normativo, asegurando que la organización se adhiere a las leyes y estándares.

Las respuestas ideales deben resaltar la experiencia de un candidato con marcos de gobernanza de datos, su papel en el mantenimiento de la calidad de los datos y cualquier herramienta o tecnología relevante que haya utilizado.

2. ¿Qué estrategias utilizaría para manejar el procesamiento de datos a gran escala de manera eficiente?

El manejo eficiente del procesamiento de datos a gran escala requiere una combinación de algoritmos optimizados, computación distribuida y soluciones de almacenamiento de datos apropiadas. Por ejemplo, el uso de marcos de procesamiento paralelo como Apache Hadoop o Apache Spark puede acelerar significativamente las tareas de procesamiento de datos.

Otra estrategia es la partición de datos, que implica dividir los datos en fragmentos más pequeños y manejables que se pueden procesar simultáneamente. Esto ayuda a reducir el tiempo de procesamiento y mejorar el rendimiento.

Busque candidatos que puedan discutir herramientas y técnicas específicas que hayan utilizado para administrar grandes conjuntos de datos, así como su comprensión de las compensaciones involucradas en diferentes enfoques.

3. ¿Cómo garantiza la precisión y la consistencia de los datos en un proyecto de Big Data?

Garantizar la precisión y consistencia de los datos a menudo implica implementar técnicas sólidas de validación de datos, como la validación de esquemas, la creación de perfiles de datos y las comprobaciones de integridad. Estos métodos ayudan a identificar y rectificar errores o inconsistencias en los datos.

Las auditorías y el seguimiento periódicos también son esenciales para mantener la calidad de los datos a lo largo del tiempo. Se pueden emplear herramientas automatizadas para verificar continuamente las anomalías de los datos y garantizar el cumplimiento de los estándares predefinidos.

Los candidatos fuertes podrán discutir su experiencia con diversas herramientas y técnicas de validación de datos, y cómo han implementado estas prácticas en proyectos anteriores para garantizar la calidad de los datos.

4. Describa su experiencia con la integración de datos en un entorno de Big Data.

La integración de datos en un entorno de Big Data implica la combinación de datos de diversas fuentes para proporcionar una vista unificada. Este proceso puede ser complejo, especialmente cuando se trata de formatos y estructuras de datos diversos.

Técnicas como ETL (Extract, Transform, Load), el almacenamiento de datos y el uso de plataformas de integración pueden ayudar a agilizar este proceso. La integración de datos efectiva garantiza que los datos sean consistentes, precisos y estén disponibles para su análisis.

Un candidato ideal debería discutir las herramientas de integración específicas que ha utilizado, los desafíos a los que se enfrentó durante la integración de datos y cómo abordó esos desafíos para garantizar un flujo de datos fluido.

5. ¿Qué métodos utiliza para optimizar el almacenamiento de datos en proyectos de Big Data?

La optimización del almacenamiento de datos implica elegir las soluciones y los formatos de almacenamiento adecuados según las necesidades específicas del proyecto. Técnicas como la compresión de datos, la partición y la indexación pueden reducir significativamente los costos de almacenamiento y mejorar los tiempos de recuperación.

Utilizar soluciones de almacenamiento basadas en la nube como AWS S3, Google Cloud Storage o Azure Blob Storage puede ofrecer escalabilidad y rentabilidad. Además, seleccionar el formato de archivo adecuado (por ejemplo, Parquet, ORC) puede mejorar el rendimiento de las consultas.

Los candidatos deben demostrar su comprensión de diversas técnicas de optimización de almacenamiento y su experiencia con diferentes soluciones de almacenamiento, destacando cómo estas elecciones impactaron en el rendimiento y el costo general de sus proyectos.

6. ¿Cómo gestiona la privacidad y seguridad de los datos en proyectos de Big Data?

La gestión de la privacidad y seguridad de los datos implica la implementación de un cifrado robusto, controles de acceso y técnicas de enmascaramiento de datos para proteger la información sensible. Garantizar el cumplimiento de regulaciones como GDPR o CCPA también es crucial.

Las auditorías y el monitoreo de seguridad regulares pueden ayudar a identificar vulnerabilidades y prevenir filtraciones de datos. El uso de protocolos seguros de transmisión de datos y el mantenimiento de políticas estrictas de acceso de usuarios también son prácticas esenciales.

Busque candidatos que puedan discutir medidas de seguridad específicas que hayan implementado en proyectos anteriores, su comprensión de los requisitos regulatorios y cómo se mantienen actualizados con las últimas tendencias y tecnologías de seguridad.

7. ¿Puede discutir su enfoque para el análisis de datos en tiempo real y sus desafíos?

El análisis de datos en tiempo real implica procesar datos a medida que se generan para proporcionar información inmediata. Esto requiere marcos de ingesta y procesamiento de datos altamente eficientes como Apache Kafka y Apache Flink.

Los desafíos incluyen la gestión de la alta velocidad de los datos, garantizar el procesamiento de baja latencia y mantener la precisión de los datos. Abordar estos desafíos a menudo requiere una combinación de infraestructura robusta, algoritmos optimizados y soluciones escalables.

Los candidatos ideales deben proporcionar ejemplos de proyectos de análisis en tiempo real en los que hayan trabajado, las herramientas y técnicas específicas que emplearon y cómo abordaron los desafíos comunes para ofrecer información oportuna y precisa.

8. Explique la importancia de la escalabilidad en las soluciones de Big Data y cómo la logra.

La escalabilidad es fundamental en las soluciones de Big Data para manejar el aumento de los volúmenes de datos y las demandas de los usuarios sin comprometer el rendimiento. Lograr la escalabilidad a menudo implica el uso de marcos de computación distribuida y soluciones de almacenamiento escalables.

Estrategias como el escalado horizontal (agregar más nodos a un sistema) y el escalado vertical (mejorar la capacidad de los nodos existentes) pueden ayudar a gestionar el crecimiento de los datos y las necesidades de procesamiento. Las soluciones basadas en la nube también ofrecen opciones de escalado flexibles.

Busque candidatos que puedan discutir su experiencia con arquitecturas escalables, los desafíos que enfrentaron al escalar sistemas de Big Data y las herramientas o estrategias que utilizaron para garantizar una escalabilidad perfecta.

9. ¿Qué papel juega la visualización de datos en Big Data y qué herramientas prefiere?

La visualización de datos es esencial en Big Data, ya que ayuda a transformar conjuntos de datos complejos en información comprensible y procesable. La visualización efectiva puede revelar patrones, tendencias y correlaciones que podrían pasarse por alto en los datos brutos.

Las herramientas populares para la visualización de datos incluyen Tableau, Power BI y D3.js. Estas herramientas ofrecen funciones potentes para crear visualizaciones interactivas y dinámicas, lo que hace que el análisis de datos sea más intuitivo y accesible.

Los candidatos deben discutir su experiencia con diferentes herramientas de visualización, los tipos de visualizaciones que han creado y cómo estas visualizaciones ayudaron a las partes interesadas a tomar decisiones informadas.

10. ¿Cómo aborda el ajuste del rendimiento en un entorno de Big Data?

El ajuste del rendimiento en un entorno de Big Data implica optimizar consultas, ajustar las configuraciones del sistema y garantizar una utilización eficiente de los recursos. Técnicas como la indexación, la partición y la optimización de consultas pueden mejorar significativamente el rendimiento.

La monitorización y el perfilado regulares pueden ayudar a identificar cuellos de botella de rendimiento y áreas de mejora. Herramientas como las métricas de rendimiento integradas de Apache Spark o soluciones de terceros pueden ayudar en este proceso.

Los candidatos ideales deben compartir ejemplos específicos de ajuste del rendimiento que han realizado, las herramientas y técnicas que utilizaron y las mejoras tangibles que lograron en el rendimiento del sistema.

15 preguntas avanzadas de entrevista de Big Data para hacer a analistas senior

Al entrevistar para roles de analista senior de Big Data, es crucial hacer las preguntas correctas para evaluar su experiencia y habilidades prácticas. Esta lista de preguntas avanzadas de entrevista de Big Data garantiza que evalúe a los candidatos de manera efectiva, ayudándole a identificar el mejor talento para descripciones de puestos de ingeniero de datos o roles similares.

- ¿Puede describir su experiencia con frameworks de computación distribuida como Apache Spark?

- ¿Cómo gestiona y optimiza la asignación de recursos en un clúster Hadoop?

- ¿Cuáles son las consideraciones clave al diseñar una tubería de datos para la ingestión de datos a gran escala?

- ¿Cómo aborda la implementación de modelos de aprendizaje automático a escala en un entorno de Big Data?

- ¿Puede hablar de su experiencia con formatos de serialización de datos como Avro, Parquet u ORC?

- ¿Cómo gestiona la evolución del esquema en un entorno de data lake?

- ¿Qué estrategias emplea para indexar y particionar grandes conjuntos de datos para mejorar el rendimiento de las consultas?

- ¿Puede detallar su experiencia con frameworks de procesamiento de flujo como Apache Kafka o Flink?

- ¿Qué métodos utiliza para garantizar la tolerancia a fallos y la alta disponibilidad en sistemas de Big Data?

- ¿Cómo aborda la integración de diferentes fuentes de datos en una plataforma de datos unificada?

- ¿Puede explicar su enfoque para implementar el linaje de datos y la auditabilidad en sus proyectos de Big Data?

- ¿Qué papel juega la gestión de metadatos en su arquitectura de Big Data y cómo la gestiona?

- ¿Cómo aborda el desafío del versionado y la reversión de datos en un entorno dinámico de Big Data?

- ¿Puede discutir cómo implementa soluciones de análisis en tiempo real garantizando una baja latencia?

- ¿Qué técnicas utiliza para equilibrar la carga y evitar cuellos de botella en un sistema de procesamiento de datos distribuido?

9 preguntas y respuestas para entrevistas sobre Big Data relacionadas con el procesamiento de datos

Para ayudarle a identificar al candidato adecuado para manejar tareas de procesamiento de datos, utilice estas preguntas en sus entrevistas sobre Big Data. Le ayudarán a evaluar la comprensión del candidato de los principios, metodologías y su aplicación práctica del procesamiento de datos.

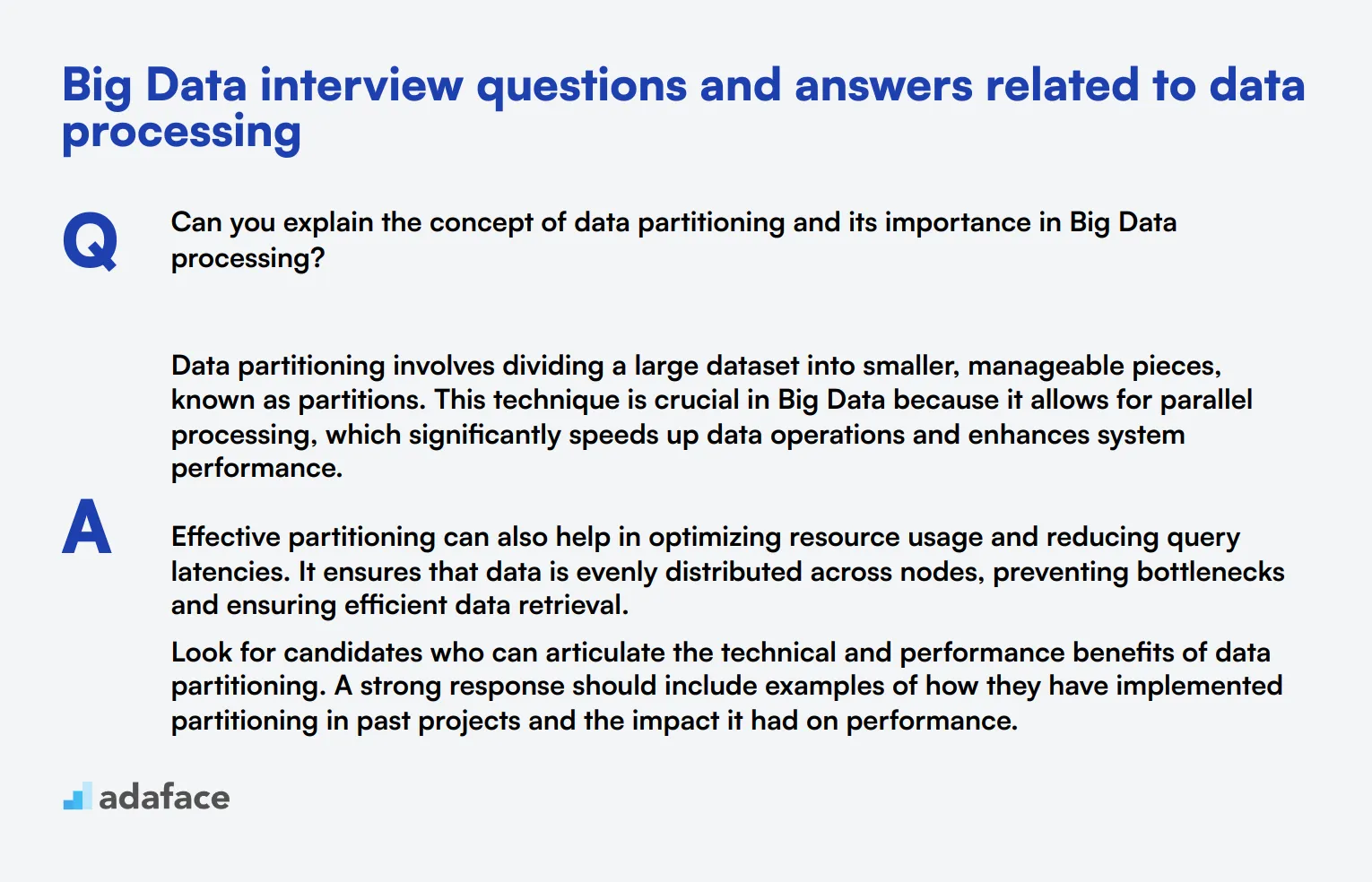

1. ¿Puede explicar el concepto de partición de datos y su importancia en el procesamiento de Big Data?

La partición de datos implica dividir un conjunto de datos grande en piezas más pequeñas y manejables, conocidas como particiones. Esta técnica es crucial en Big Data porque permite el procesamiento paralelo, lo que acelera significativamente las operaciones de datos y mejora el rendimiento del sistema.

La partición efectiva también puede ayudar a optimizar el uso de recursos y reducir las latencias de las consultas. Asegura que los datos se distribuyan uniformemente entre los nodos, lo que evita cuellos de botella y garantiza una recuperación eficiente de los datos.

Busque candidatos que puedan articular los beneficios técnicos y de rendimiento de la partición de datos. Una respuesta sólida debe incluir ejemplos de cómo han implementado la partición en proyectos anteriores y el impacto que tuvo en el rendimiento.

2. ¿Cuál es su enfoque para manejar transformaciones de datos a gran escala?

El manejo de transformaciones de datos a gran escala generalmente implica el uso de procesos ETL (Extract, Transform, Load). Los candidatos pueden mencionar herramientas como Apache Spark o Apache Flink, que están diseñadas para manejar conjuntos de datos masivos de manera eficiente.

Un buen enfoque incluye la definición de flujos de trabajo claros, la garantía de la calidad de los datos durante las transformaciones y la optimización del rendimiento de los procesos de transformación. Esto a menudo implica escribir una lógica de transformación eficiente y aprovechar el procesamiento paralelo.

El candidato ideal debe demostrar una sólida comprensión de las herramientas y técnicas ETL, y proporcionar ejemplos de cómo ha gestionado las transformaciones de datos en roles anteriores.

3. ¿Cómo aborda la optimización del almacenamiento de datos en proyectos de Big Data?

Optimizar el almacenamiento de datos en proyectos de Big Data implica varias estrategias, como la compresión de datos, la elección del formato de almacenamiento adecuado (por ejemplo, ORC, Parquet) y la partición eficiente de datos.

Los candidatos también deben mencionar la importancia de eliminar datos redundantes y archivar datos antiguos para reducir los costos de almacenamiento. El uso de formatos de almacenamiento en columnas también puede mejorar el rendimiento de las consultas y reducir las operaciones de entrada/salida (I/O) en disco.

Busque candidatos que estén familiarizados con diferentes formatos y técnicas de almacenamiento. Deben proporcionar ejemplos específicos de cómo se aplicaron estas estrategias en proyectos anteriores para optimizar el almacenamiento y mejorar el rendimiento.

4. ¿Cómo garantiza la privacidad y seguridad de los datos en el procesamiento de Big Data?

Garantizar la privacidad y seguridad de los datos en Big Data implica implementar métodos de cifrado robustos, mecanismos de control de acceso y auditorías regulares. Los candidatos deben mencionar el uso del cifrado tanto en reposo como en tránsito para proteger datos confidenciales.

Además, deben discutir la importancia del control de acceso basado en roles (RBAC) para restringir el acceso a los datos en función de los roles de los usuarios, y mantener registros de auditoría detallados para rastrear el acceso y las modificaciones de los datos.

Un candidato ideal demostrará una comprensión integral de las prácticas de seguridad de datos y proporcionará ejemplos de cómo ha aplicado estas medidas en proyectos anteriores para mantener la privacidad y la seguridad de los datos.

5. ¿Cuáles son las consideraciones clave al diseñar una tubería de ingesta de datos?

Al diseñar una tubería de ingesta de datos, es crucial considerar la escalabilidad, la calidad de los datos y la tolerancia a fallos. La tubería debe ser capaz de manejar volúmenes de datos variables y asegurar que los datos que se ingieren sean precisos y limpios.

Los candidatos también deben mencionar la importancia de elegir las herramientas y marcos de ingesta correctos, como Apache Kafka o AWS Kinesis, que admiten el procesamiento de datos en tiempo real y garantizan una alta disponibilidad.

Busque candidatos que puedan discutir su experiencia con diferentes herramientas de ingesta y proporcionar ejemplos de cómo diseñaron e implementaron tuberías de ingesta que cumplieron con los requisitos de escalabilidad y fiabilidad de sus proyectos.

6. ¿Puede discutir el papel de la gobernanza de datos en el procesamiento de Big Data?

La gobernanza de datos implica establecer políticas y procedimientos para gestionar la calidad, la seguridad y la privacidad de los datos. En el procesamiento de Big Data, asegura que los datos sean precisos, consistentes y utilizados de manera responsable.

Los candidatos deben destacar la importancia de los marcos de gobernanza de datos, como el cumplimiento del RGPD, y los roles de administración de datos que supervisan las prácticas de gestión de datos. Una gobernanza adecuada ayuda a mantener la integridad de los datos y reduce el riesgo de filtraciones de datos.

Un candidato ideal demostrará una sólida comprensión de los principios de gobernanza de datos y proporcionará ejemplos de cómo ha implementado prácticas de gobernanza en sus roles anteriores para garantizar la calidad y el cumplimiento de los datos.

7. ¿Cómo maneja la deduplicación de datos en un entorno de Big Data?

La deduplicación de datos implica identificar y eliminar registros duplicados de los conjuntos de datos para garantizar la calidad de los datos y reducir los costos de almacenamiento. Los candidatos pueden usar técnicas como hashing, enlace de registros o algoritmos de aprendizaje automático para la deduplicación.

También deben mencionar el uso de herramientas como Apache Spark o Hadoop MapReduce, que proporcionan funciones integradas para la deduplicación. Los procesos regulares de deduplicación pueden ayudar a mantener la integridad del conjunto de datos a lo largo del tiempo.

Busque candidatos que puedan explicar diferentes métodos de deduplicación y proporcionar ejemplos de cómo han implementado con éxito estos métodos en proyectos anteriores para mejorar la calidad y eficiencia de los datos.

8. ¿Qué estrategias utiliza para gestionar y supervisar los flujos de trabajo de procesamiento de datos?

La gestión y supervisión de los flujos de trabajo de procesamiento de datos implica el uso de herramientas de programación y orquestación como Apache Airflow, Oozie o NiFi. Estas herramientas ayudan a automatizar los flujos de trabajo, gestionar las dependencias y proporcionar visibilidad de las tuberías de procesamiento.

Los candidatos deben hablar sobre la configuración de sistemas de alerta y supervisión para detectar y solucionar problemas con prontitud. Pueden utilizar herramientas como Prometheus o Grafana para la supervisión y el registro en tiempo real.

Un candidato ideal demostrará familiaridad con las herramientas de orquestación de flujo de trabajo y los sistemas de supervisión. Deben proporcionar ejemplos de cómo han gestionado y supervisado los flujos de trabajo de procesamiento de datos para garantizar operaciones fluidas y eficientes.

9. ¿Cómo aborda la validación y los controles de calidad de los datos en el procesamiento de Big Data?

La validación de datos y los controles de calidad son esenciales para garantizar la exactitud y fiabilidad de los datos que se procesan. Los candidatos deben mencionar técnicas como la validación de esquemas, la creación de perfiles de datos y la configuración de reglas de calidad de datos.

También pueden utilizar herramientas como Apache Griffin o Deequ para automatizar los controles de calidad de los datos. Los procesos de validación regulares ayudan a identificar y rectificar los problemas de los datos antes de que afecten a las aplicaciones posteriores.

Busque candidatos que puedan hablar de su experiencia con herramientas y técnicas de validación de datos. Deben proporcionar ejemplos de cómo han implementado controles de calidad de datos para mantener altos estándares de datos en sus proyectos.

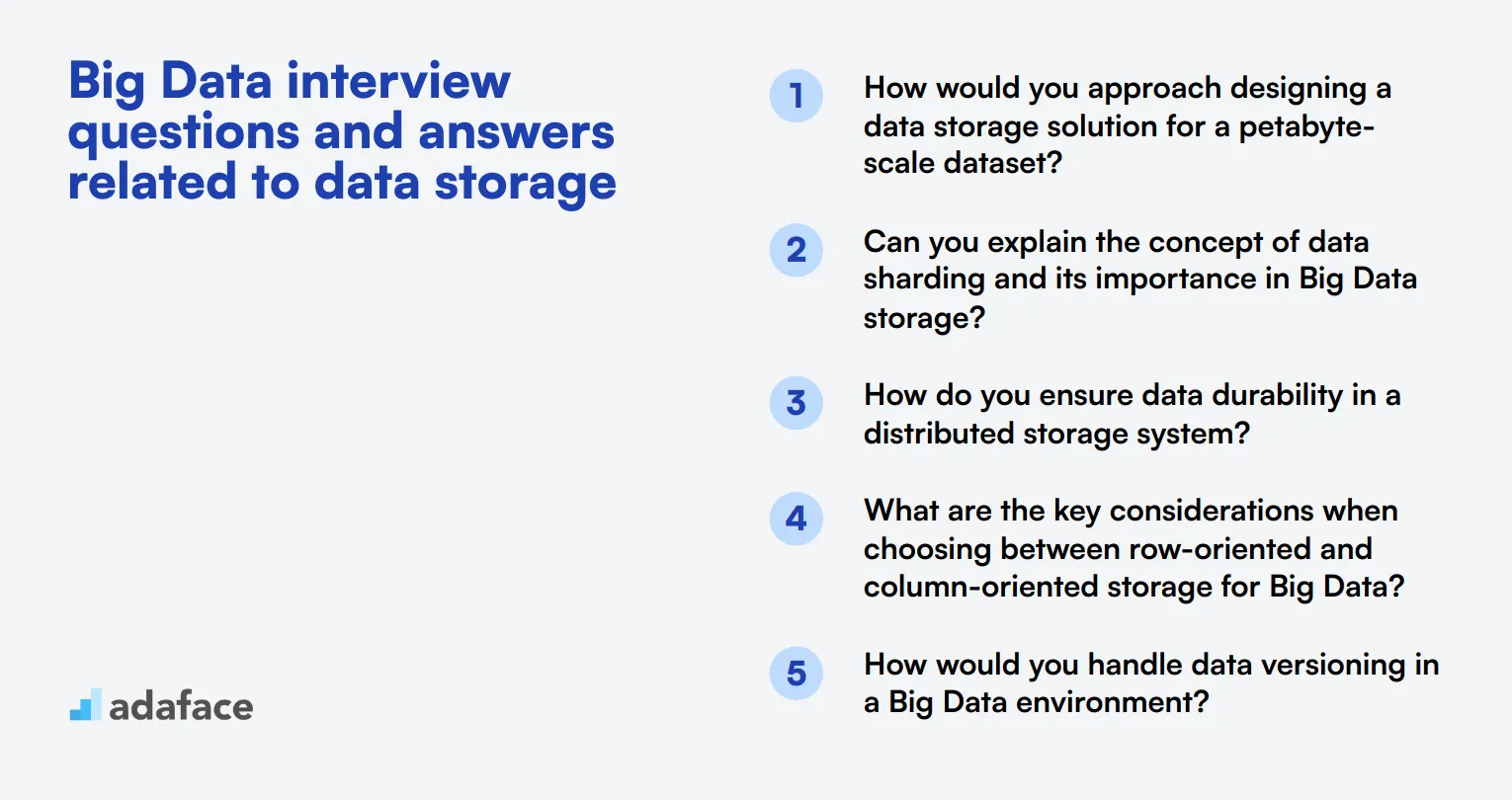

6 preguntas y respuestas de entrevistas sobre Big Data relacionadas con el almacenamiento de datos

Al entrevistar para puestos de Big Data, es crucial evaluar la comprensión de los candidatos sobre los conceptos de almacenamiento de datos. Estas preguntas le ayudarán a evaluar el conocimiento de los solicitantes sobre técnicas eficientes de gestión de datos y su capacidad para manejar desafíos de almacenamiento a gran escala. Utilice esta lista para evaluar a los candidatos para puestos que requieran experiencia en soluciones de almacenamiento de Big Data.

1. ¿Cómo abordaría el diseño de una solución de almacenamiento de datos para un conjunto de datos a escala de petabytes?

Un candidato fuerte debe esbozar un enfoque estructurado para diseñar una solución de almacenamiento de datos a escala de petabytes. Podrían mencionar los siguientes puntos clave:

- Evaluar la naturaleza de los datos (estructurados, semiestructurados o no estructurados)

- Considerar los patrones de acceso a los datos y la frecuencia

- Evaluar los requisitos de escalabilidad

- Elegir entre soluciones locales, en la nube o híbridas

- Seleccionar las tecnologías de almacenamiento adecuadas (por ejemplo, sistemas de archivos distribuidos, almacenamiento de objetos)

- Implementar estrategias de partición y fragmentación de datos

- Planificar la replicación y copia de seguridad de datos

Busque respuestas que demuestren una comprensión holística de los desafíos del almacenamiento de datos a gran escala. El candidato ideal también debería mencionar la importancia de la rentabilidad, la optimización del rendimiento y la escalabilidad futura en su enfoque de diseño.

2. ¿Puede explicar el concepto de partición de datos (sharding) y su importancia en el almacenamiento de Big Data?

La partición de datos es una técnica utilizada para distribuir grandes conjuntos de datos en múltiples servidores o nodos. Implica dividir una base de datos grande en piezas más pequeñas y manejables llamadas "shards" (fragmentos o particiones). Cada shard se almacena en un servidor separado, lo que permite el procesamiento en paralelo y una mejor rendimiento.

La importancia de la partición de datos en el almacenamiento de Big Data incluye:

- Escalabilidad mejorada: agregue fácilmente más servidores para manejar el creciente volumen de datos.

- Rendimiento mejorado: procesamiento paralelo de consultas en múltiples shards.

- Mejor disponibilidad: si un shard falla, los demás permanecen accesibles.

- Equilibrio de carga: distribuye datos y consultas de manera uniforme entre los servidores.

Un candidato fuerte debería ser capaz de explicar cómo se implementa la partición, incluidas las estrategias para elegir claves de partición y manejar consultas entre particiones. Busque respuestas que también aborden los desafíos potenciales, como mantener la consistencia de los datos entre las particiones y la complejidad de administrar un sistema particionado.

3. ¿Cómo garantiza la durabilidad de los datos en un sistema de almacenamiento distribuido?

Asegurar la durabilidad de los datos en un sistema de almacenamiento distribuido implica implementar múltiples estrategias para proteger contra la pérdida de datos. Un candidato con conocimientos podría mencionar los siguientes enfoques:

- Replicación: Almacenamiento de múltiples copias de datos en diferentes nodos o centros de datos

- Codificación de borrado: Uso de algoritmos para reconstruir datos perdidos a partir de fragmentos restantes

- Copias de seguridad regulares: Creación de instantáneas periódicas de todo el conjunto de datos

- Comprobaciones de consistencia: Implementación de mecanismos para verificar la integridad de los datos

- Hardware tolerante a fallos: Uso de componentes redundantes para minimizar fallas de hardware

- Almacenamiento geográficamente distribuido: Almacenamiento de datos en múltiples ubicaciones físicas

Busque respuestas que demuestren una comprensión de las compensaciones entre durabilidad, rendimiento y costo. El candidato ideal también debe mencionar la importancia de las pruebas periódicas y la planificación de la recuperación ante desastres para garantizar la efectividad de las medidas de durabilidad.

4. ¿Cuáles son las consideraciones clave al elegir entre el almacenamiento orientado a filas y el orientado a columnas para Big Data?

Al elegir entre el almacenamiento orientado a filas y el orientado a columnas para Big Data, entran en juego varios factores clave. Un candidato fuerte debe ser capaz de articular las siguientes consideraciones:

- Patrones de consulta: La orientación por filas es mejor para recuperar registros completos, mientras que la orientación por columnas sobresale en agregaciones y análisis en columnas específicas.

- Compresión de datos: El almacenamiento orientado a columnas a menudo logra mejores tasas de compresión.

- Rendimiento de escritura: El almacenamiento orientado a filas normalmente ofrece operaciones de escritura más rápidas.

- Escalabilidad: El almacenamiento orientado a columnas a menudo escala mejor para conjuntos de datos grandes.

- Variedad de datos: La orientación por filas es más flexible para datos heterogéneos, mientras que la orientación por columnas funciona bien con datos uniformes.

Busque respuestas que demuestren una comprensión de las compensaciones entre los dos enfoques. El candidato ideal debería ser capaz de proporcionar ejemplos de casos de uso donde cada tipo de almacenamiento sería más apropiado, como sistemas transaccionales para orientación por filas y cargas de trabajo analíticas para almacenamiento orientado a columnas.

5. ¿Cómo manejaría el versionado de datos en un entorno de Big Data?

El versionado de datos en un entorno de Big Data es crucial para mantener el linaje de datos, permitir reversiones y respaldar los requisitos de cumplimiento. Un candidato conocedor podría discutir los siguientes enfoques:

- Almacenamiento de datos inmutable: Mantener todas las versiones de los datos y nunca sobrescribir los datos existentes

- Capacidades de viaje en el tiempo: Habilitar consultas sobre los datos tal como existían en un momento específico en el tiempo

- Delta Lake o tecnologías similares: Usar frameworks de código abierto que proporcionan transacciones ACID y versionado

- Gestión de metadatos: Mantener metadatos detallados sobre cada versión de los datos

- Versionado basado en instantáneas: Crear instantáneas periódicas de todo el conjunto de datos

- Sistemas de control de versiones: Adaptar conceptos de control de versiones tipo Git al versionado de datos

Busque respuestas que aborden los desafíos de implementar el versionado a escala, como la eficiencia del almacenamiento y el rendimiento de las consultas. El candidato ideal también debe mencionar la importancia de políticas de versionado claras y procesos de limpieza automatizados para gestionar los costos de almacenamiento.

6. Explique el concepto de estratificación de datos en el almacenamiento de Big Data y sus beneficios.

La estratificación de datos en el almacenamiento de Big Data implica categorizar los datos en función de su importancia, frecuencia de acceso y requisitos de rendimiento, y luego almacenarlos en medios de almacenamiento apropiados. Este concepto permite a las organizaciones optimizar los costos de almacenamiento mientras mantienen el rendimiento de los datos a los que se accede con frecuencia.

Los beneficios de la estratificación de datos incluyen:

- Optimización de costos: Almacenamiento de datos de acceso menos frecuente en medios de almacenamiento más económicos

- Rendimiento mejorado: Mantener los datos "calientes" en almacenamiento de alto rendimiento para un acceso rápido

- Utilización eficiente de recursos: Equilibrar los datos en diferentes tipos de almacenamiento según las necesidades

- Escalabilidad: Gestión más fácil de conjuntos de datos crecientes moviendo datos más antiguos a niveles inferiores

- Cumplimiento: Capacidad para cumplir con los requisitos de retención de datos mientras se gestionan los costos

Un candidato fuerte debería ser capaz de explicar diferentes estrategias de niveles, como el nivelado automatizado basado en patrones de acceso o el nivelado basado en políticas. Busque respuestas que también aborden los desafíos de implementar el nivelado, como la sobrecarga de movimiento de datos y el mantenimiento de la consistencia de los datos en todos los niveles.

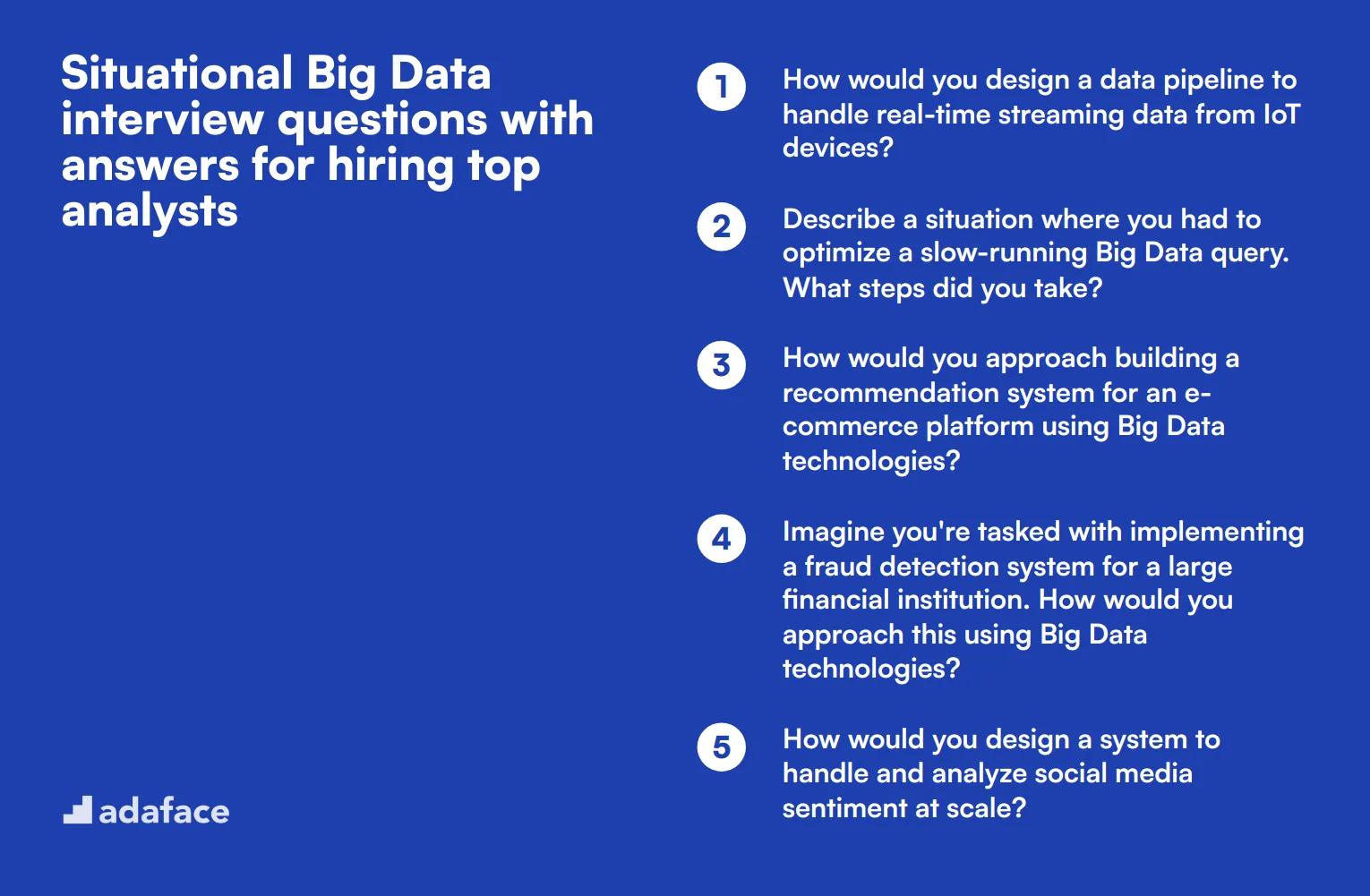

5 preguntas situacionales de entrevista sobre Big Data con respuestas para contratar a los mejores analistas

¿Listo para encontrar a su próxima superestrella de Big Data? Estas preguntas de entrevista situacionales le ayudarán a descubrir cómo los candidatos piensan sobre la marcha y aplican sus conocimientos a escenarios del mundo real. Use estas preguntas para evaluar las habilidades de resolución de problemas, el pensamiento analítico y la capacidad de los candidatos para manejar desafíos complejos de datos en un contexto práctico.

1. ¿Cómo diseñaría una tubería de datos para manejar datos de transmisión en tiempo real desde dispositivos IoT?

Un candidato fuerte debería esbozar un enfoque robusto y escalable para manejar datos de transmisión en tiempo real desde dispositivos IoT. Podrían describir una tubería que incluya:

- Ingesta de datos utilizando una plataforma de transmisión como Apache Kafka o Amazon Kinesis

- Procesamiento de flujo con herramientas como Apache Flink o Spark Streaming

- Almacenamiento de datos en una base de datos o lago de datos escalable

- Capa de análisis y visualización en tiempo real

- Manejo de errores y comprobaciones de calidad de datos en toda la tubería

Busque candidatos que enfaticen la importancia del procesamiento de baja latencia, la tolerancia a fallos y la escalabilidad en su diseño. También deben mencionar consideraciones para la seguridad y la privacidad de los datos, especialmente cuando se trata de datos de IoT potencialmente sensibles.

2. Describa una situación en la que tuvo que optimizar una consulta de Big Data de ejecución lenta. ¿Qué pasos tomó?

Una respuesta ideal debe demostrar las habilidades de resolución de problemas del candidato y la familiaridad con las técnicas de optimización de consultas. Podrían describir pasos como:

- Analizar el plan de ejecución de la consulta para identificar cuellos de botella

- Optimizar la partición de datos o las estrategias de indexación

- Reescribir la consulta para mejorar la eficiencia

- Considerar la desnormalización de datos o la pre-agregación

- Aprovechar los mecanismos de almacenamiento en caché

- Ajustar los recursos del clúster o escalar la infraestructura

Preste atención a los candidatos que enfatizan la importancia de la evaluación comparativa antes y después de la optimización, así como a aquellos que consideran las compensaciones entre el rendimiento de la consulta y la utilización de los recursos. Una respuesta sólida también abordará la naturaleza iterativa de la optimización y la importancia de monitorear el rendimiento de la consulta a lo largo del tiempo.

3. ¿Cómo abordaría la construcción de un sistema de recomendación para una plataforma de comercio electrónico utilizando tecnologías de Big Data?

Una respuesta completa debe cubrir los componentes clave de la construcción de un sistema de recomendación utilizando tecnologías de Big Data. El candidato podría esbozar un enfoque que incluya:

- Recopilación de datos: Recopilación de datos de comportamiento del usuario, historial de compras, atributos de productos y posiblemente fuentes de datos externas

- Procesamiento de datos: Limpieza y transformación de los datos utilizando herramientas como Apache Spark o Hadoop

- Ingeniería de características: Creación de características relevantes para el modelo de recomendación

- Selección de modelos: Elección de algoritmos apropiados (por ejemplo, filtrado colaborativo, filtrado basado en contenido o enfoques híbridos)

- Entrenamiento y evaluación del modelo: Uso de frameworks como MLlib o TensorFlow en sistemas distribuidos

- Implementación: Implementación del modelo en una infraestructura de servicio escalable y en tiempo real

- Bucle de retroalimentación: Actualización continua del modelo basada en nuevos datos e interacciones del usuario

Busque candidatos que discutan los desafíos de manejar datos a gran escala, la importancia de la personalización y las estrategias para abordar el problema del arranque en frío. Una respuesta sólida también abordará consideraciones éticas, como evitar el sesgo en las recomendaciones y proteger la privacidad del usuario.

4. Imagine que se le encarga la implementación de un sistema de detección de fraude para una gran institución financiera. ¿Cómo abordaría esto utilizando tecnologías de Big Data?

Una respuesta sólida debe demostrar la comprensión tanto de los principios de detección de fraude como de las tecnologías de Big Data. El candidato podría describir un enfoque que incluya:

- Ingesta de datos: Recopilación de datos transaccionales, información de cuentas y fuentes de datos externas en tiempo real

- Procesamiento de datos: Uso de tecnologías de procesamiento de flujo como Apache Flink o Kafka Streams para análisis en tiempo real

- Ingeniería de características: Creación de características relevantes que indiquen un posible fraude

- Desarrollo de modelos: Implementación de modelos de aprendizaje automático (por ejemplo, detección de anomalías, árboles de decisión o aprendizaje profundo) utilizando marcos distribuidos

- Puntuación en tiempo real: Implementación de modelos para puntuar transacciones en tiempo real

- Sistema de alerta: Desarrollo de un sistema para señalar actividades sospechosas para una investigación adicional

- Aprendizaje continuo: Implementación de un ciclo de retroalimentación para actualizar los modelos basados en casos de fraude confirmados

Busque candidatos que enfaticen la importancia de equilibrar los falsos positivos y los falsos negativos, así como aquellos que mencionen la necesidad de IA explicable en el sector financiero. Una respuesta completa también abordará las preocupaciones sobre la privacidad de los datos y el cumplimiento normativo en el manejo de datos financieros sensibles.

5. ¿Cómo diseñaría un sistema para manejar y analizar el sentimiento en las redes sociales a escala?

Una respuesta eficaz debe esbozar un enfoque integral para manejar grandes volúmenes de datos de redes sociales y realizar análisis de sentimiento. El candidato podría describir un sistema que incluya:

- Recopilación de datos: Uso de APIs de redes sociales o servicios de transmisión de datos para recopilar publicaciones y comentarios

- Procesamiento de datos: Implementación de procesamiento distribuido con herramientas como Apache Spark o Flink para preprocesamiento de texto y extracción de características

- Análisis de sentimiento: Aplicación de técnicas de procesamiento del lenguaje natural (PNL) y modelos de aprendizaje automático para la clasificación de sentimientos

- Almacenamiento de datos: Utilización de una base de datos escalable o una solución de data lake para almacenar datos brutos y procesados

- Análisis en tiempo real: Implementación de una tubería de procesamiento de flujo para obtener información inmediata

- Procesamiento por lotes: Ejecución de análisis más profundos sobre datos históricos

- Visualización: Creación de paneles e informes para presentar tendencias de sentimiento e información

Busque candidatos que discutan desafíos como el manejo de múltiples idiomas, el manejo del sarcasmo y el contexto, y la gestión de la alta velocidad de los datos de las redes sociales. Una respuesta sólida también abordará consideraciones éticas, como las preocupaciones de privacidad y los posibles sesgos en los modelos de análisis de sentimientos.

¿Qué habilidades de Big Data debe evaluar durante la fase de entrevista?

En el mundo de ritmo rápido de Big Data, evaluar las habilidades de un candidato en una sola entrevista puede ser un desafío. Sin embargo, ciertas competencias básicas son esenciales para garantizar que el candidato pueda prosperar en entornos intensivos en datos. Centrarse en estas habilidades clave ayudará a los entrevistadores a tomar decisiones informadas.

Análisis de datos

Para filtrar eficazmente a los candidatos, considere usar una prueba de evaluación que incluya preguntas de opción múltiple relevantes relacionadas con el análisis de datos. Nuestra Prueba en línea de análisis de datos ofrece preguntas personalizadas para evaluar esta habilidad.

Además, puede hacer preguntas de entrevista específicas para evaluar aún más las habilidades de análisis de datos de un candidato. Una de esas preguntas es:

¿Puede describir un proyecto complejo de análisis de datos en el que trabajó y las herramientas que utilizó?

Al hacer esta pregunta, busque claridad en su explicación, la relevancia de las herramientas mencionadas y cómo abordaron la resolución de problemas. Un candidato fuerte demostrará un proceso de pensamiento estructurado y experiencia práctica.

Tecnologías de Big Data

Evalúe esta habilidad a través de una prueba de evaluación con preguntas de opción múltiple sobre tecnologías de Big Data. Si bien no tenemos una prueba específica en nuestra biblioteca, puede adaptar las evaluaciones tecnológicas generales para centrarse en esta área.

También es posible que desee hacer a los candidatos preguntas específicas sobre su experiencia con estas tecnologías. Por ejemplo:

¿Cuáles son las diferencias clave entre Hadoop y Spark, y cuándo usaría uno sobre el otro?

Preste atención a su capacidad para articular las diferencias claramente y a sus experiencias prácticas utilizando estas tecnologías en escenarios del mundo real.

Visualización de datos

Considere el uso de una prueba de evaluación que incluya preguntas sobre técnicas y herramientas de visualización de datos. Si es necesario, puede crear evaluaciones personalizadas para satisfacer sus requisitos específicos de visualización de datos.

Para evaluar esta habilidad más a fondo, podría preguntar a los candidatos:

¿Con qué herramientas de visualización de datos ha trabajado y puede proporcionar un ejemplo de una visualización que haya creado?

Al evaluar las respuestas, busque familiaridad con varias herramientas y la capacidad de explicar por qué eligieron visualizaciones específicas basadas en los datos.

Consejos para Entrevistas Efectivas de Big Data

Antes de poner en práctica sus nuevos conocimientos, considere estos consejos para que sus entrevistas de Big Data sean más efectivas e informativas.

1. Comience con una Evaluación de Habilidades

Comience su proceso de contratación con una evaluación de habilidades para filtrar a los candidatos de manera eficiente. Este enfoque ahorra tiempo y garantiza que esté entrevistando a candidatos con las habilidades técnicas adecuadas.

Para puestos de Big Data, considere usar pruebas que evalúen las habilidades de Hadoop, Data Science y Data Mining. Estas evaluaciones ayudan a identificar candidatos con bases sólidas en tecnologías y metodologías clave de Big Data.

Al usar pruebas de habilidades, puede enfocar sus entrevistas en discusiones técnicas más profundas y escenarios de resolución de problemas. Esta estrategia le permite aprovechar al máximo el tiempo de su entrevista y evaluar a los candidatos de manera más exhaustiva.

2. Prepare un conjunto equilibrado de preguntas de entrevista

Compile una mezcla de preguntas técnicas y situacionales para evaluar tanto habilidades duras como blandas. Con un tiempo de entrevista limitado, elegir las preguntas correctas es crucial para evaluar a los candidatos de manera integral.

Incluya preguntas sobre tecnologías relacionadas como Spark o Machine Learning. Este enfoque ayuda a medir el conocimiento más amplio de un candidato sobre el ecosistema de Big Data.

No olvides evaluar las habilidades interpersonales, como la comunicación y la resolución de problemas. Estas cualidades son esenciales para el éxito en roles de Big Data, especialmente cuando se trabaja en equipos o se explican conceptos complejos a personas no técnicas.

3. Haz preguntas de seguimiento reflexivas

Prepárate para hacer preguntas de seguimiento para profundizar en el conocimiento y la experiencia de un candidato. Esta técnica te ayuda a distinguir entre candidatos que han memorizado respuestas y aquellos con una comprensión genuina y habilidades para resolver problemas.

Por ejemplo, después de preguntar sobre Hadoop, podrías seguir con una pregunta sobre cómo han optimizado los trabajos de Hadoop en roles anteriores. Busca respuestas detalladas basadas en la experiencia que demuestren conocimientos prácticos y pensamiento crítico.

Utiliza preguntas de entrevista de Big Data y pruebas de habilidades para contratar analistas talentosos

Si está buscando contratar a alguien con habilidades en Big Data, debe asegurarse de que tenga esas habilidades con precisión. La mejor manera de hacerlo es utilizar pruebas de habilidades. Considere usar nuestra Prueba en línea de Hadoop o la Prueba de ciencia de datos para evaluar a los candidatos.

Una vez que use estas pruebas, puede preseleccionar a los mejores solicitantes e invitarlos a entrevistas. Para obtener más detalles, visite nuestra plataforma de evaluación en línea o regístrese para comenzar.

Prueba en línea de Hadoop

30 minutos | 15 MCQs

La prueba en línea de Hadoop utiliza preguntas MCQ basadas en escenarios para evaluar la capacidad de los candidatos para instalar clústeres de Hadoop en la nube, ejecutar trabajos MapReduce optimizados en clústeres de Hadoop y escribir instrucciones Pig y consultas Hive eficientes para realizar análisis de datos en conjuntos de datos complejos. La prueba evalúa los conocimientos básicos del marco de trabajo de Hadoop que los gerentes de contratación buscan en los desarrolladores y administradores de Hadoop.

[

Probar la prueba en línea de Hadoop

](https://www.adaface.com/assessment-test/hadoop-online-test)

Descargue la plantilla de preguntas de la entrevista de Big Data en múltiples formatos

Adaptar las preguntas al nivel de experiencia del candidato le ayuda a evaluar mejor sus capacidades y garantiza una evaluación más precisa.

Concéntrese en preguntas de conocimiento general, procesamiento de datos, almacenamiento de datos y situaciones para obtener una visión completa de las habilidades del candidato.

Seleccione preguntas que coincidan con el puesto de trabajo y el nivel de experiencia del candidato. Mezcle preguntas generales, técnicas y situacionales para una entrevista equilibrada.

Busque explicaciones claras, habilidades para la resolución de problemas y familiaridad con las herramientas y conceptos de Big Data. Evalúe su capacidad para aplicar el conocimiento de forma práctica.

Se incluyen ejemplos de respuestas para algunas preguntas para guiarle, pero deberá evaluar las respuestas de los candidatos en función de sus requisitos específicos.

Sí, estas preguntas se pueden utilizar tanto en entrevistas presenciales como remotas. Asegúrese de tener una forma fiable de evaluar las habilidades técnicas si entrevista de forma remota.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento