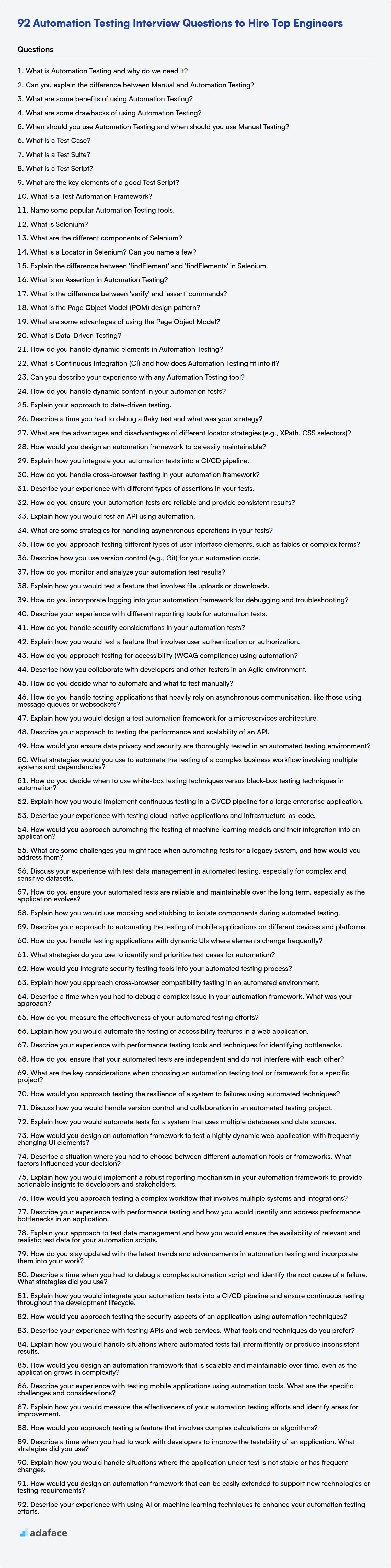

92 Preguntas de la entrevista de pruebas de automatización para contratar a los mejores ingenieros

En el vertiginoso panorama actual del desarrollo de software, las pruebas de automatización son una parte integral para garantizar la calidad del software. Los reclutadores y los gerentes de contratación a menudo luchan por evaluar a los candidatos, necesitando un enfoque estructurado para medir su competencia en este campo especializado, como se puede ver en nuestra publicación sobre las habilidades requeridas para un ingeniero de pruebas.

Esta publicación proporciona una lista seleccionada de preguntas de entrevista sobre pruebas de automatización, categorizadas por nivel de habilidad, incluyendo niveles básico, intermedio, avanzado y experto, junto con preguntas de opción múltiple. Esta guía le ayuda a hacer las preguntas correctas e identificar a los candidatos con las habilidades y el conocimiento para sobresalir en roles de pruebas de automatización.

Al usar estas preguntas, puede refinar su proceso de entrevista y tomar decisiones de contratación basadas en datos. Antes de la entrevista, considere usar evaluaciones en línea de Adaface para evaluar a los candidatos en habilidades prácticas y ahorrar un valioso tiempo de entrevista.

Tabla de contenidos

Preguntas de entrevista básicas sobre pruebas de automatización

Preguntas de entrevista intermedias sobre pruebas de automatización

Preguntas de entrevista avanzadas sobre pruebas de automatización

Preguntas de entrevista expertas sobre pruebas de automatización

Pruebas de automatización MCQ

¿Qué habilidades de pruebas de automatización debe evaluar durante la fase de entrevista?

3 Consejos para Maximizar las Preguntas de la Entrevista de Pruebas de Automatización

Evalúe a los Candidatos con Precisión con Pruebas de Habilidades de Pruebas de Automatización

Descargue la plantilla de preguntas de la entrevista de pruebas de automatización en múltiples formatos

1. ¿Qué son las pruebas de automatización y por qué las necesitamos?

Las pruebas de automatización utilizan software para controlar la ejecución de pruebas, comparar los resultados reales con los resultados predichos e informar sobre los resultados de las pruebas. Automatiza tareas repetitivas como pruebas de regresión, pruebas de rendimiento y entrada de datos, lo que consumiría mucho tiempo y sería propenso a errores si se hiciera manualmente.

Necesitamos pruebas de automatización para mejorar la calidad del software, aumentar la cobertura de las pruebas, acelerar el proceso de pruebas y reducir costos. Permite la ejecución de pruebas frecuente y consistente, la detección temprana de defectos y una retroalimentación más rápida a los desarrolladores. Esto conduce a un software más confiable y robusto.

2. ¿Puede explicar la diferencia entre las pruebas manuales y las pruebas de automatización?

Las pruebas manuales implican que los evaluadores ejecuten casos de prueba sin herramientas de automatización. Verifican manualmente el software contra los requisitos, documentando los hallazgos e informando los errores. Esto se basa en gran medida en la observación y el juicio humanos.

Las pruebas de automatización utilizan scripts y herramientas para ejecutar casos de prueba predefinidos automáticamente. Es especialmente útil para las pruebas de regresión, pruebas de rendimiento y tareas repetitivas. La automatización tiene como objetivo mejorar la eficiencia, la velocidad y la repetibilidad, pero a menudo requiere una inversión inicial en el desarrollo y mantenimiento de scripts. También proporciona una retroalimentación más rápida para los desarrolladores, lo que permite la corrección rápida de errores.

3. ¿Cuáles son algunos beneficios de usar pruebas de automatización?

Las pruebas de automatización ofrecen varios beneficios clave. Principalmente, reduce el tiempo y el costo asociados con las tareas de prueba repetitivas. Las pruebas automatizadas se pueden ejecutar mucho más rápido que las pruebas manuales, y pueden ejecutarse sin supervisión, liberando a los evaluadores humanos para que se concentren en pruebas más complejas o exploratorias. Esto conduce a ciclos de retroalimentación más rápidos y una identificación más rápida de errores, lo que en última instancia acelera el proceso de desarrollo.

Además, la automatización mejora la cobertura y consistencia de las pruebas. Las pruebas automatizadas pueden diseñarse para cubrir una gama más amplia de escenarios y casos extremos que las pruebas manuales, lo que garantiza pruebas más exhaustivas. Debido a que las pruebas automatizadas se ejecutan de manera consistente cada vez, eliminan el riesgo de error humano y aseguran que las pruebas se realicen de la misma manera en múltiples ejecuciones. Esta consistencia contribuye a mejorar la calidad y fiabilidad del software. El uso de herramientas como Selenium, JUnit o Cypress mejora aún más la eficiencia.

4. ¿Cuáles son algunos inconvenientes del uso de pruebas de automatización?

Las pruebas de automatización, aunque beneficiosas, tienen inconvenientes. La configuración inicial puede ser costosa debido a la adquisición de herramientas, la capacitación y el desarrollo de scripts. También requiere experiencia para diseñar y mantener conjuntos de pruebas automatizadas de manera efectiva.

Además, la automatización no es un reemplazo de las pruebas manuales. Es menos adaptable a los cambios inesperados de la interfaz de usuario y tiene dificultades con las pruebas exploratorias o las evaluaciones de usabilidad. Algunas pruebas son simplemente más adecuadas para la observación humana, y confiar únicamente en la automatización puede pasar por alto problemas sutiles o casos extremos que un evaluador humano detectaría.

5. ¿Cuándo debería usar pruebas de automatización y cuándo debería usar pruebas manuales?

Las pruebas de automatización son más adecuadas para tareas repetitivas, pruebas de regresión, pruebas de rendimiento y pruebas de carga. Destaca al probar conjuntos de datos grandes, escenarios complejos y funcionalidades críticas que requieren validación frecuente. Use la automatización donde la consistencia y la velocidad son primordiales. Las pruebas automatizadas se usan a menudo para pruebas de API y pruebas de elementos de la interfaz de usuario que no cambian.

Las pruebas manuales son preferibles para pruebas exploratorias, pruebas de usabilidad y pruebas ad hoc. Es vital al evaluar la experiencia del usuario, la estética y las áreas donde el juicio subjetivo es crucial. Las pruebas manuales también brillan en las primeras etapas del desarrollo, durante la prueba de concepto, o cuando la aplicación cambia con frecuencia y los scripts de automatización requerirían actualizaciones constantes. Considere las pruebas manuales cuando trate con nuevas características o casos límite complejos que son difíciles de automatizar.

6. ¿Qué es un caso de prueba?

Un caso de prueba es un conjunto específico de acciones realizadas en un sistema o software para verificar una característica o funcionalidad en particular. Incluye condiciones previas, datos de entrada, pasos de ejecución y resultados esperados.

Esencialmente, es un procedimiento documentado para determinar si una aplicación funciona correctamente en ciertas condiciones. Un caso de prueba bien definido ayuda a los evaluadores a garantizar que el software cumpla con los requisitos e identificar cualquier defecto o desviación del comportamiento esperado.

7. ¿Qué es un conjunto de pruebas?

Un conjunto de pruebas es una colección de casos de prueba que están diseñados para ejecutarse juntos para probar un programa de software con el fin de verificar que cumple con los estándares requeridos. Un conjunto de pruebas a menudo contiene:

- Un conjunto de casos de prueba o scripts de prueba, cada uno diseñado para verificar un aspecto específico del software.

- Procedimientos de configuración, como la configuración del entorno de prueba.

- Procedimientos de ejecución, que definen el orden en que se deben ejecutar las pruebas.

- Procedimientos de validación, que especifican cómo determinar si una prueba ha pasado o fallado.

Los conjuntos de pruebas están diseñados para mejorar la eficiencia de las pruebas mediante la organización y automatización de la ejecución de las pruebas. Por ejemplo, en Python, podría usar unittest o pytest para crear y ejecutar conjuntos de pruebas. Ayudan a garantizar pruebas completas y repetibles de una aplicación o componente de software.

8. ¿Qué es un script de prueba?

Un script de prueba es un conjunto de instrucciones que se ejecutan para verificar que una aplicación o sistema de software funciona como se espera. Es esencialmente un procedimiento detallado diseñado para validar funcionalidades o requisitos específicos. Los scripts de prueba pueden ser manuales (ejecutados por un evaluador humano) o automatizados (ejecutados por una herramienta de software).

Los elementos clave que se incluyen a menudo en un script de prueba son: ID del caso de prueba, nombre del caso de prueba, precondiciones (pasos a seguir antes de la prueba), pasos de prueba (acciones detalladas a realizar), resultados esperados y resultados reales. Los scripts de prueba automatizados a menudo se escriben en lenguajes de programación como Python, Java o JavaScript y utilizan marcos de prueba como Selenium o JUnit.

9. ¿Cuáles son los elementos clave de un buen script de prueba?

Un buen script de prueba debe ser confiable, repetible y mantenible. Los elementos clave incluyen una descripción clara y concisa del propósito de la prueba, precondiciones y postcondiciones bien definidas, y pasos detallados con los resultados esperados. El uso de nombres de variables y conjuntos de datos significativos hace que el script sea legible y más fácil de depurar.

Además, debe estar diseñado para un diagnóstico de fallos fácil, lo que significa que proporciona información suficiente para identificar la causa raíz de cualquier fallo. La modularidad y el manejo adecuado de errores también son importantes. Por ejemplo, en un script de Python, considere usar bloques try...except para manejar las posibles excepciones con elegancia.

10. ¿Qué es un marco de automatización de pruebas?

Un marco de automatización de pruebas es un enfoque estructurado para las pruebas automatizadas. Es un conjunto de pautas, mejores prácticas y herramientas que, cuando se siguen, conducen a pruebas automatizadas más eficientes, mantenibles y confiables. Piense en ello como la arquitectura de sus esfuerzos de prueba automatizada.

Un buen marco de trabajo típicamente incluye:

- Librerías/Módulos de Prueba: Código reutilizable para tareas comunes.

- Gestión de Datos de Prueba: Cómo se manejan los datos de prueba.

- Mecanismos de Informes: Cómo se presentan los resultados de las pruebas.

- Gestión de Configuración: Gestión de diferentes entornos.

- Motor de Ejecución: El componente que ejecuta las pruebas.

Por ejemplo, si está automatizando pruebas web usando Selenium, un framework podría definir cómo localizar elementos (por ejemplo, usando el Modelo de Objetos de Página), gestionar la configuración del navegador y generar informes.

11. Nombra algunas herramientas populares de pruebas de automatización.

Algunas herramientas populares de pruebas de automatización incluyen:

- Selenium: Un framework de código abierto ampliamente utilizado para pruebas de aplicaciones web.

- Cypress: Una herramienta moderna de pruebas front-end diseñada para la web.

- Playwright: Un framework para pruebas de extremo a extremo confiables para aplicaciones web.

- Appium: Una herramienta de código abierto para automatizar aplicaciones nativas, web móviles e híbridas.

- JUnit/TestNG: Frameworks de pruebas Java populares, a menudo utilizados para pruebas unitarias e integración.

- Robot Framework: Un framework de automatización de código abierto genérico.

12. ¿Qué es Selenium?

Selenium es un potente framework de código abierto utilizado para automatizar navegadores web. Principalmente prueba aplicaciones web, verificando que se comporten como se espera. Selenium es compatible con múltiples navegadores (Chrome, Firefox, Safari, etc.) y sistemas operativos (Windows, macOS, Linux).

Consta de varios componentes:

- Selenium IDE: Una herramienta de grabación y reproducción.

- Selenium WebDriver: Permite controlar un navegador a través de código, utilizando varios enlaces de lenguaje como Java, Python, C# y más.

- Selenium Grid: Permite la ejecución de pruebas en paralelo en diferentes navegadores y máquinas, lo que acelera el proceso de prueba.

13. ¿Cuáles son los diferentes componentes de Selenium?

Selenium es un conjunto de herramientas para automatizar navegadores web. Sus componentes principales incluyen:

- Selenium IDE: Una herramienta de grabación y reproducción para crear scripts de automatización simples. Es una extensión del navegador.

- Selenium WebDriver: Una colección de enlaces específicos del lenguaje para controlar navegadores web. Utiliza controladores específicos del navegador para comunicarse con el navegador. Soporta múltiples lenguajes como Java, Python, C#, etc.

- Selenium Grid: Permite ejecutar pruebas en paralelo en múltiples máquinas y navegadores, lo que ayuda a reducir el tiempo de ejecución de las pruebas. Implica un hub (punto central) y nodos (entornos de ejecución de pruebas).

14. ¿Qué es un localizador en Selenium? ¿Puede nombrar algunos?

En Selenium, un localizador es una forma de identificar de forma única un elemento web en una página web. Es crucial para interactuar con elementos, como hacer clic en botones, ingresar texto o recuperar datos. Sin localizadores, Selenium no sabría sobre qué elemento actuar.

Algunos tipos comunes de localizadores incluyen:

ID: Localiza elementos basados en su atributoid.Name: Localiza elementos basados en su atributoname.ClassName: Localiza elementos basados en su atributoclass.TagName: Localiza elementos basados en su nombre de etiqueta HTML (por ejemplo,button,input).LinkText: Localiza elementos de anclaje (enlaces) basados en su texto de enlace exacto.PartialLinkText: Localiza elementos de anclaje basados en una coincidencia parcial de su texto de enlace.Selector CSS: Localiza elementos basados en selectores CSS, ofreciendo una orientación flexible y potente.XPath: Localiza elementos basados en su ruta XML, lo que permite la navegación a través de la estructura HTML.

15. Explique la diferencia entre 'findElement' y 'findElements' en Selenium.

En Selenium, findElement y findElements se utilizan para localizar elementos web en una página web, pero difieren en su comportamiento cuando el elemento se encuentra o no se encuentra.

findElement devuelve el primer elemento coincidente basado en el localizador proporcionado. Si no se encuentra ningún elemento que coincida con el localizador, arroja una NoSuchElementException. findElements devuelve una lista de todos los elementos coincidentes. Si no se encuentra ningún elemento, devuelve una lista vacía, no arrojando una excepción. Esto hace que findElements sea más seguro cuando no está seguro de si un elemento existe. El uso de findElement requiere que maneje excepciones, mientras que findElements permite verificar el tamaño de la lista devuelta.

16. ¿Qué es una afirmación (Assertion) en las pruebas de automatización?

En las pruebas de automatización, una afirmación (assertion) es una declaración que verifica si una condición específica o un resultado esperado es verdadero en un punto particular durante la ejecución de un script de prueba. Es un mecanismo crucial para validar que el sistema bajo prueba se comporta como se espera. Si la afirmación evalúa como verdadera, la prueba continúa; si evalúa como falsa, la prueba falla, indicando un posible defecto.

Por ejemplo, en Selenium con Java, una afirmación podría verse así:

import org.junit.jupiter.api.Assertions; String expectedTitle = "Ejemplo de Sitio Web"; String actualTitle = driver.getTitle(); Assertions.assertEquals(expectedTitle, actualTitle, "¡Título no coincide!");

En este ejemplo, Assertions.assertEquals verifica si el actualTitle coincide con el expectedTitle. Si no coinciden, la prueba fallará y se mostrará el mensaje "¡Título no coincide!". Las afirmaciones son fundamentales para determinar el éxito o el fracaso de las pruebas automatizadas.

17. ¿Cuál es la diferencia entre los comandos 'verify' y 'assert'?

Tanto verify como assert se utilizan para la validación en las pruebas, pero difieren en su comportamiento ante un fallo. Los comandos Assert detienen la ejecución de la prueba inmediatamente cuando se produce un fallo. Esto significa que si una declaración assert se evalúa como falsa, el caso de prueba se termina y no se ejecutan pasos adicionales. Por el contrario, los comandos verify no detienen la ejecución de la prueba. Si una declaración verify falla, el fallo se registra, pero la prueba continúa ejecutándose, ejecutando los pasos siguientes.

La diferencia clave radica en si la prueba debe continuar después de un fallo. Use assert cuando un fallo indica un error crítico que invalida el resto de la prueba. Use verify cuando desee comprobar múltiples condiciones y registrar todos los fallos dentro de una única ejecución de prueba, incluso si algunas condiciones no se cumplen.

18. ¿Qué es el patrón de diseño Page Object Model (POM)?

El Page Object Model (POM) es un patrón de diseño comúnmente utilizado en la automatización de pruebas para crear un repositorio de elementos web. Cada página dentro de la aplicación bajo prueba tiene su correspondiente objeto de página. Este objeto contiene todos los elementos web presentes en esa página específica y métodos para interactuar con esos elementos.

Los beneficios clave de POM incluyen una mejor mantenibilidad, reutilización y legibilidad del código. Al encapsular los elementos de la página y sus interacciones, los cambios en la interfaz de usuario solo requieren actualizaciones en el objeto de la página correspondiente, en lugar de en toda la suite de pruebas. Esto reduce los costos de mantenimiento de las pruebas y mejora la fiabilidad general de las pruebas. La duplicación de código también se minimiza, ya que las acciones comunes se pueden definir una vez dentro de un objeto de página y reutilizarse en múltiples pruebas. Por ejemplo, si el id de un botón de inicio de sesión cambia, solo actualiza el localizador en el objeto LoginPage, no en cada prueba que utiliza la funcionalidad de inicio de sesión.

19. ¿Cuáles son algunas ventajas de usar el Modelo de Objetos de Página?

El Modelo de Objetos de Página (POM) ofrece varias ventajas en la automatización de pruebas. En primer lugar, mejora la mantenibilidad del código al encapsular los elementos de la página y las interacciones dentro de clases de objetos de página dedicadas. Esta separación de preocupaciones significa que los cambios en la interfaz de usuario solo requieren actualizaciones en el objeto de la página correspondiente, en lugar de modificaciones dispersas en múltiples casos de prueba. En segundo lugar, POM promueve la reutilización del código. Los flujos de trabajo o componentes de la interfaz de usuario comunes se pueden representar como métodos dentro de un objeto de página, y estos métodos pueden ser llamados por diferentes pruebas, lo que reduce la duplicación de código. Esto también hace que el código de prueba sea más legible y fácil de entender. Otra ventaja es el aumento de la estabilidad de las pruebas. Es menos probable que los cambios en la interfaz de usuario interrumpan las pruebas, ya que los objetos de página actúan como un escudo entre la interfaz de usuario y la prueba. Por último, el uso de POM mejora la colaboración dentro del equipo. Diferentes miembros del equipo pueden trabajar en diferentes objetos de página o casos de prueba simultáneamente sin interferir con el trabajo de los demás.

20. ¿Qué es la prueba basada en datos?

La prueba basada en datos (DDT) es una metodología de prueba donde la entrada de la prueba y el resultado esperado se leen de fuentes de datos (como CSV, Excel, bases de datos) en lugar de estar codificados en el script de prueba. Esto permite ejecutar la misma lógica de prueba con múltiples conjuntos de datos, aumentando la cobertura de la prueba y reduciendo la duplicación de código.

En lugar de escribir pruebas separadas para cada valor de entrada, un único script de prueba lee los datos, los alimenta a la aplicación y verifica el resultado. Los beneficios clave incluyen una mayor capacidad de mantenimiento, una mejor cobertura de la prueba y una parametrización más fácil de las pruebas.

21. ¿Cómo manejas los elementos dinámicos en las pruebas de automatización?

Manejar elementos dinámicos en las pruebas de automatización requiere localizadores robustos y estrategias flexibles. En lugar de depender de atributos fijos, utiliza localizadores relativos (ejes XPath como following-sibling, ancestor), coincidencias de atributos parciales (contains(), starts-with(), ends-with()) o selectores CSS que se dirigen a partes estables de la estructura del elemento.

Además, incorpore mecanismos de espera (esperas explícitas o implícitas) para permitir que los elementos se carguen antes de interactuar con ellos, evitando fallos falsos debidos a problemas de sincronización. Considere el uso de pruebas basadas en datos para iterar a través de diferentes variaciones de elementos, si corresponde. Al utilizar una combinación de estas técnicas, puede crear scripts de automatización más resistentes y adaptables.

22. ¿Qué es la Integración Continua (CI) y cómo encaja la Prueba de Automatización en ella?

La Integración Continua (CI) es una práctica de desarrollo donde los desarrolladores fusionan regularmente sus cambios de código en un repositorio central, después de lo cual se ejecutan compilaciones y pruebas automatizadas. El objetivo principal de CI es detectar errores de integración lo más rápido posible, lo que permite una retroalimentación más rápida y evita que los problemas de integración se acumulen.

La prueba de automatización es un componente crítico de CI. Al automatizar las pruebas (unitarias, de integración y de extremo a extremo), el sistema de CI puede verificar de forma rápida y fiable que los nuevos cambios de código no hayan introducido regresiones o hayan roto la funcionalidad existente. Sin las pruebas automatizadas, el proceso de CI sería significativamente más lento y menos efectivo, ya que las pruebas manuales consumen mucho tiempo y son propensas a errores humanos. Así es como encaja:

- El código se envía al repositorio central.

- El servidor CI detecta el cambio.

- El servidor CI construye y prueba automáticamente el código, ejecutando la suite de pruebas automatizadas.

- Se proporciona retroalimentación a los desarrolladores sobre los resultados de la compilación y las pruebas. Una prueba fallida indica un problema que debe abordarse.

23. ¿Puede describir su experiencia con alguna herramienta de Prueba de Automatización?

Tengo experiencia con Selenium WebDriver para automatizar pruebas de aplicaciones web. Lo he usado con Java para crear scripts de prueba que interactúan con elementos web, verifican la funcionalidad y generan informes. Mi experiencia incluye escribir localizadores robustos (usando IDs, XPath, selectores CSS), implementar esperas explícitas e implícitas y manejar diferentes configuraciones de navegador. También tengo familiaridad con el uso de frameworks de pruebas como JUnit y TestNG para estructurar y ejecutar pruebas, e integrar pruebas de Selenium en pipelines de CI/CD.

Además, he trabajado con Postman para pruebas de API. He creado suites de pruebas para validar endpoints de API, esquemas de solicitud/respuesta y manejo de errores. Esto incluyó parametrizar solicitudes, configurar scripts previos a la solicitud y escribir afirmaciones para verificar la corrección de las respuestas de la API. También entiendo cómo crear pruebas de API que se pueden automatizar como parte de una estrategia de pruebas de integración más amplia.

Preguntas de entrevista de pruebas de automatización intermedias

1. ¿Cómo manejas el contenido dinámico en tus pruebas de automatización?

Manejar contenido dinámico en pruebas de automatización implica estrategias para identificar y validar elementos que cambian con frecuencia. Un enfoque común es evitar depender de coincidencias de texto exactas, especialmente para cosas como fechas o marcas de tiempo. En cambio, concéntrese en atributos estables como id o nombres de clase siempre que sea posible. Si estos no están disponibles, use expresiones XPath relativas para ubicar elementos en función de su proximidad a elementos más estables.

Al tratar con texto dinámico, puede usar expresiones regulares para coincidir con patrones en lugar de valores exactos. Por ejemplo, element.text.matches("Order ID: \d+") podría validar una ID de pedido. Otra técnica eficaz es extraer el valor dinámico y luego usarlo en pasos posteriores. Por ejemplo, podría extraer una ID generada dinámicamente y usarla para hacer clic en un enlace o botón asociado con esa ID.

2. Explique su enfoque para las pruebas basadas en datos.

Mi enfoque para las pruebas basadas en datos (DDT) implica la creación de casos de prueba que utilizan fuentes de datos externas, como archivos CSV, hojas de cálculo de Excel o bases de datos, para impulsar el proceso de prueba. En lugar de codificar datos de prueba directamente en los scripts de prueba, parametrizo las pruebas y suministro los datos de entrada de estas fuentes externas. Esto me permite ejecutar la misma lógica de prueba con varios conjuntos de datos sin modificar el script de prueba en sí.

Los pasos clave incluyen:

- Identificación de parámetros de prueba: Determine qué aspectos de la prueba deben variar.

- Creación de la fuente de datos: Construya la fuente de datos externa con los conjuntos de datos requeridos.

- Parametrización de los scripts de prueba: Modifique los scripts de prueba para leer datos de la fuente de datos.

- Ejecución de pruebas: Ejecute las pruebas, que iterarán a través de los conjuntos de datos.

- Análisis de resultados: Revise los resultados de las pruebas para cada conjunto de datos. Por ejemplo, una prueba parametrizada para validar la funcionalidad de inicio de sesión leería nombres de usuario y contraseñas de la fuente de datos externa.

3. Describe un momento en el que tuviste que depurar una prueba inestable y cuál fue tu estrategia?

Una prueba inestable que encontré involucraba fallas intermitentes en una prueba de extremo a extremo para un flujo de registro de usuario. Mi estrategia implicó primero intentar reproducir la falla de manera consistente. Esto fue difícil debido a la inestabilidad, pero usé un bucle para ejecutar la prueba repetidamente. Una vez que pude reproducirlo de manera más confiable, comencé examinando los registros de la prueba y cualquier mensaje de error disponible, buscando patrones o pistas sobre la causa raíz.

Mi proceso de depuración involucró varias técnicas: agregué más registros alrededor de los pasos fallidos para capturar el estado de la aplicación. También introduje retrasos/reintentos en áreas donde el tiempo parecía ser un factor, específicamente en operaciones asíncronas como las escrituras en la base de datos. A través de esto, descubrí que la creación del índice de la base de datos después del registro del usuario no siempre se completaba antes de las consultas posteriores, lo que conducía a las fallas intermitentes. La solución fue agregar una verificación explícita de la existencia del índice antes de continuar. Esto eliminó la inestabilidad e hizo que la prueba fuera confiable.

4. ¿Cuáles son las ventajas y desventajas de las diferentes estrategias de localización (por ejemplo, XPath, selectores CSS)?

XPath y los selectores CSS son estrategias comunes de localización en la automatización web. XPath destaca en el recorrido del DOM, lo que permite localizar elementos basándose en relaciones (padre, hijo, hermano) y atributos. Sus ventajas incluyen flexibilidad y la capacidad de localizar elementos incluso sin IDs o clases únicos. Las desventajas incluyen un rendimiento potencialmente más lento en comparación con los selectores CSS y una mayor complejidad, lo que lleva a localizadores frágiles si no se diseñan cuidadosamente.

Los selectores CSS, por otro lado, son generalmente más rápidos y legibles. Son muy adecuados para localizar elementos basándose en IDs, clases y atributos. Las ventajas incluyen la facilidad de uso y un mejor rendimiento. Sin embargo, los selectores CSS tienen limitaciones para recorrer el DOM hacia arriba (hacia los elementos padre) y pueden no ser tan potentes como XPath en escenarios complejos. Elegir la estrategia correcta depende del elemento específico y de la estabilidad del localizador. Por ejemplo, usar id o class es preferible a un XPath complejo, siempre que los desarrolladores los nombren de forma única y consistente.

5. ¿Cómo diseñaría un framework de automatización para que sea fácilmente mantenible?

Para diseñar un framework de automatización fácilmente mantenible, me centraría en la modularidad, la abstracción y los informes. Dividiría los casos de prueba en componentes o módulos más pequeños y reutilizables. De esta manera, los cambios en un área no se propagan por todo el framework. Implementaría capas de abstracción para ocultar los detalles de implementación complejos, como el uso de un Modelo de Objetos de Página para las pruebas de UI.

Las consideraciones clave incluyen el uso de convenciones de nomenclatura descriptivas, la implementación de registros e informes completos y la adherencia a los estándares de codificación. Además, la utilización de archivos de configuración para gestionar los datos de prueba y la configuración del entorno promueve el mantenimiento. Asimismo, la incorporación de un sistema de control de versiones como Git es esencial para rastrear los cambios y facilitar la colaboración. Por ejemplo:

def suma(x, y): return x + y # En un módulo de prueba separado assert suma(2, 3) == 5

6. Explique cómo integra sus pruebas de automatización en un pipeline CI/CD.

Integro las pruebas de automatización en un pipeline CI/CD para garantizar la calidad del código y evitar regresiones. El proceso generalmente implica los siguientes pasos:

Primero, configuro la herramienta CI/CD (por ejemplo, Jenkins, GitLab CI, Azure DevOps) para activar las pruebas de automatización ante eventos específicos, como confirmaciones de código o solicitudes de extracción. El pipeline luego ejecuta las pruebas utilizando un marco de pruebas como Selenium, Cypress o Playwright, a menudo dentro de un entorno en contenedores (por ejemplo, Docker) para garantizar la consistencia. La generación de informes es crucial, por lo que integro herramientas para generar informes (por ejemplo, JUnit, Allure) y publicarlos en un panel centralizado, haciendo que los resultados de las pruebas sean fácilmente accesibles. Finalmente, basándose en los resultados de las pruebas, el pipeline puede continuar a la siguiente etapa (por ejemplo, despliegue) o detenerse, evitando que el código defectuoso llegue a producción. La compilación puede fallar si las pruebas fallan y se deberá investigar la revisión manual de los resultados de las pruebas y la nueva confirmación. Ejemplo: if (resultadosPruebas.fallidos) { pipeline.fallar(); }

7. ¿Cómo gestiona las pruebas entre diferentes navegadores en su marco de automatización?

Gestiono las pruebas entre diferentes navegadores en mi marco de automatización utilizando herramientas como Selenium Grid o plataformas de pruebas basadas en la nube como BrowserStack o Sauce Labs. Estas herramientas me permiten ejecutar los mismos scripts de prueba en múltiples navegadores y sistemas operativos simultáneamente. Mi marco está diseñado con configuraciones específicas para cada navegador (por ejemplo, configuración del controlador, opciones del navegador) que se pueden cambiar fácilmente en función del navegador de destino.

Para garantizar una cobertura exhaustiva, defino una matriz de navegadores y versiones compatibles basada en análisis y datos demográficos de los usuarios. Los scripts de prueba se escriben para que sean lo más independientes del navegador posible, utilizando las API estándar de WebDriver. Cuando se encuentra un comportamiento específico del navegador, se implementa lógica condicional o localizadores específicos del navegador. Los informes incluyen resultados específicos del navegador para facilitar la identificación de problemas. También incorporamos pruebas visuales para comparar instantáneas en diferentes navegadores y garantizar la coherencia.

8. Describa su experiencia con diferentes tipos de aserciones en sus pruebas.

He usado varios tipos de aserciones para validar los resultados esperados en mis pruebas. Principalmente, utilizo aserciones de igualdad (por ejemplo, assertEqual, assertEquals, ===) para verificar que los valores reales coincidan con los valores esperados. Para las comparaciones numéricas, empleo aserciones como assertGreater, assertLess o assertAlmostEqual para manejar posibles problemas de precisión de punto flotante. También utilizo aserciones booleanas (assertTrue, assertFalse, assertIsNone, assertIsNotNone) para verificar la veracidad o falsedad de las condiciones, y aserciones de tipo (assertInstanceOf, assertIsInstance) para asegurar que los objetos sean del tipo esperado.

Además de las comparaciones básicas, he trabajado con aserciones más específicas. Por ejemplo, assertIn y assertNotIn para verificar la pertenencia a colecciones, assertRaises o construcciones similares para confirmar que el código genera excepciones esperadas, y aserciones de expresiones regulares (assertRegex, assertNotRegex) para validar patrones de cadenas. La elección de la aserción depende del requisito específico de la prueba y del nivel de detalle necesario para confirmar la corrección. Ejemplos de código:

self.assertEqual(result, expected_result) #verificar igualdad self.assertTrue(isinstance(obj, MyClass)) self.assertRaises(ValueError, my_func, arg) #verificar excepción lanzada

9. ¿Cómo se asegura de que sus pruebas de automatización sean confiables y proporcionen resultados consistentes?

Para asegurar que las pruebas de automatización sean confiables y consistentes, me concentro en varias áreas clave. Primero, la aislamiento de las pruebas es crucial; cada prueba debe ser independiente y no depender del estado de las pruebas anteriores. Esto se puede lograr limpiando datos o recursos después de cada ejecución de la prueba. Segundo, el manejo robusto de errores es esencial. Las pruebas deben manejar con gracia los errores inesperados, registrarlos apropiadamente y evitar fallos en cascada.

Además, usar localizadores estables en las pruebas de la interfaz de usuario es vital (por ejemplo, IDs, atributos de datos en lugar de XPaths dinámicos). Emplear mecanismos de reintento para pruebas inestables (comunes en entornos asincrónicos) y parametrizar las pruebas con enfoques basados en datos para cubrir varios escenarios mejora la fiabilidad. Finalmente, la implementación de un sistema confiable de informes y registro de pruebas ayuda a identificar y abordar las inconsistencias rápidamente.

10. Explique cómo probaría una API usando la automatización.

Para automatizar las pruebas de API, usaría herramientas como Postman, Rest Assured (Java) o PyTest con Requests (Python). El proceso generalmente implica crear casos de prueba que cubran diferentes escenarios, como verificar códigos de estado, tiempos de respuesta y precisión de los datos. Las pruebas enviarían varias solicitudes (GET, POST, PUT, DELETE) con diferentes cargas útiles y encabezados, luego afirmarían que las respuestas coinciden con los valores esperados. Estas pruebas se pueden integrar en una canalización de CI/CD para pruebas continuas.

Los pasos clave incluyen:

- Configuración: Configure el entorno de prueba e importe las bibliotecas necesarias.

- Construcción de la solicitud: Defina los puntos finales de la API, los métodos de solicitud, las cabeceras y los cuerpos de solicitud (JSON, XML, etc.).

- Ejecución: Envíe las solicitudes de la API utilizando la herramienta/biblioteca de pruebas elegida.

- Validación: Las aserciones verifican el código de estado de la respuesta (por ejemplo, 200, 400), las cabeceras de la respuesta y los datos en el cuerpo de la respuesta. Los ejemplos incluyen comprobar que existen campos específicos y que tienen el tipo de datos correcto o verificar que una lista contiene un cierto número de elementos.

- Informes: Genere informes que muestren los resultados de las pruebas (aprobado/fallido) y cualquier error encontrado. Los registros de errores deben ser lo suficientemente descriptivos para identificar los problemas rápidamente.

11. ¿Cuáles son algunas estrategias para manejar operaciones asíncronas en sus pruebas?

Al probar operaciones asíncronas, varias estrategias pueden garantizar que las pruebas sean confiables y precisas.

- Promesas/Async/Await: Utilice

async/awaitpara simplificar el manejo de Promesas. Espere la resolución de la promesa antes de hacer aserciones. Por ejemplo:

it('should fetch data', async () => { const data = await fetchData(); expect(data).toBeDefined(); });

-

Callbacks: Si se trata de funciones asíncronas basadas en callbacks, use técnicas como

done()en Mocha o mecanismos similares en otros frameworks de pruebas para señalar la finalización de la operación asíncrona. Asegúrese de que el callbackdone()se invoque dentro del callback de la operación asíncrona. -

Mocking y Stubbing: Mockee las dependencias asíncronas (por ejemplo, llamadas a la API) para controlar su comportamiento y respuestas. Esto le permite probar diferentes escenarios (éxito, fallo, timeouts) sin depender de servicios externos.

-

Timeouts: Ajuste los timeouts de las pruebas apropiadamente para las operaciones asíncronas más lentas. Sin embargo, evite los timeouts excesivamente largos, ya que pueden enmascarar problemas de rendimiento. Prefiera usar métodos más precisos como esperar promesas en lugar de depender únicamente de timeouts.

12. ¿Cómo aborda la prueba de diferentes tipos de elementos de la interfaz de usuario, como tablas o formularios complejos?

Al probar elementos de la interfaz de usuario (UI) como tablas y formularios complejos, me concentro en la funcionalidad, la integridad de los datos y la experiencia del usuario. Para las tablas, verifico la correcta visualización de los datos, la ordenación, el filtrado, la paginación y que las acciones (por ejemplo, edición, eliminación) funcionen como se espera. Utilizo una combinación de pruebas manuales y pruebas automatizadas de la interfaz de usuario (por ejemplo, utilizando Selenium o Cypress) para asegurar que todos los escenarios estén cubiertos. Verifico las condiciones límite (tablas vacías, grandes conjuntos de datos) y la accesibilidad. Específicamente para las tablas, el aspecto visual debe probarse en varias resoluciones de pantalla, así como la capacidad de respuesta. También me aseguro de que cualquier modificación realizada a través de la tabla se conserve correctamente.

Para los formularios complejos, valido los campos de entrada, los tipos de datos, los campos obligatorios y los mensajes de error. Verifico que el envío del formulario funcione correctamente y que los datos se guarden y recuperen con precisión. Presto mucha atención al flujo de trabajo del usuario y me aseguro de que el formulario sea fácil de navegar. Para los formularios, me aseguro de que la validación del formulario funcione como se espera para todos los tipos de entrada, incluidos los validadores personalizados, como correo electrónico, número o expresiones regulares. Las pruebas también comprueban cómo cambian los datos en el backend con los valores ingresados en el formulario. Si el formulario utiliza lógica condicional (por ejemplo, mostrar/ocultar campos), esas condiciones también deben probarse.

13. Describe cómo usas el control de versiones (por ejemplo, Git) para tu código de automatización.

Uso Git para el control de versiones de mi código de automatización, siguiendo un flujo de trabajo estándar. Normalmente, creo una nueva rama para cada característica o corrección de errores, asegurando que la rama main o develop se mantenga estable. Esto me permite trabajar en cambios aislados sin afectar el proyecto en general. Cuando los cambios están completos, creo una solicitud de extracción (pull request) para su revisión y, después de la aprobación, la fusiono en la rama principal.

Específicamente, utilizo comandos como git clone, git pull, git checkout -b <nombre_de_la_rama>, git add, git commit -m "<mensaje_de_commit>", git push origin <nombre_de_la_rama>, git merge y git rebase. También aprovecho los archivos .gitignore para excluir archivos innecesarios como archivos temporales o credenciales del repositorio. Además, utilizo estrategias de ramificación, como Gitflow, y sigo convenciones de mensajes de commit para una mejor mantenibilidad y colaboración del código.

14. ¿Cómo monitoreas y analizas los resultados de tus pruebas de automatización?

Monitoreo y analizo los resultados de las pruebas de automatización utilizando una combinación de herramientas y técnicas. Primero, el propio marco de automatización generalmente genera informes, a menudo en formatos como HTML, XML o JUnit. Estos informes proporcionan un resumen de las ejecuciones de pruebas, incluido el número de pruebas aprobadas, fallidas y omitidas. También configuro el marco para que genere registros detallados que ayudan a identificar la causa raíz de cualquier fallo.

Para analizar más a fondo los resultados, a menudo integro el marco de automatización con una tubería CI/CD. Esto permite la ejecución y el informe automatizados de pruebas con herramientas como Jenkins, Azure DevOps o GitLab CI. Estas herramientas proporcionan visualizaciones y paneles que muestran las tendencias de las pruebas y ayudan a rastrear la estabilidad de la aplicación a lo largo del tiempo. Además, enviaría los resultados a herramientas de gestión de pruebas o informes basadas en la nube como TestRail, Xray o Allure. Estas herramientas ofrecen funciones como filtrado avanzado, agrupación y análisis histórico.

15. Explique cómo probaría una función que implica la carga o descarga de archivos.

Probar la carga y descarga de archivos implica verificar la funcionalidad, la seguridad y el rendimiento. Para las cargas, verificaría diferentes tipos de archivos (permitidos y no permitidos), tamaños de archivo (archivos límite y grandes) y nombres de archivo (incluidos caracteres especiales). También probaría el manejo de errores para escenarios como tipos de archivos incorrectos o exceder los límites de tamaño. Las pruebas de seguridad implicarían verificar vulnerabilidades como cargas de malware y el recorrido de rutas.

Para las descargas, verificaría la integridad del archivo descargado (usando sumas de verificación), probaría las velocidades de descarga y aseguraría el manejo adecuado de las descargas interrumpidas. Además, verificaría si el archivo descargado se abre correctamente y si se aplican los controles de acceso, evitando descargas no autorizadas. Probar diferentes navegadores y sistemas operativos es importante para garantizar la compatibilidad multiplataforma tanto para cargas como para descargas.

16. ¿Cómo incorpora el registro en su marco de automatización para la depuración y la solución de problemas?

El registro (logging) es crucial para la depuración y la resolución de problemas de los frameworks de automatización. Normalmente, integro una biblioteca de registro (como el módulo logging de Python) para registrar eventos en diferentes niveles de severidad (DEBUG, INFO, WARNING, ERROR, CRITICAL). Estos registros capturan detalles sobre la ejecución de pruebas, los valores de las variables y cualquier excepción encontrada. Esto permite un análisis detallado de los fallos de las pruebas o del comportamiento inesperado sin necesidad de volver a ejecutar las pruebas en modo de depuración.

Específicamente, incorporo el registro en puntos clave dentro del framework: al inicio y al final de las pruebas, antes y después de acciones críticas (por ejemplo, hacer clic en un botón, enviar un formulario) y dentro de los bloques de manejo de excepciones. También configuro el registro para que la salida se dirija tanto a la consola como a un archivo para obtener registros persistentes. Además, incluiría información contextual en los registros, como el ID del caso de prueba, la marca de tiempo y los datos relevantes, lo que ayuda a identificar la causa raíz de los problemas más rápidamente.

17. Describe su experiencia con diferentes herramientas de informes para pruebas de automatización.

Tengo experiencia con varias herramientas de informes comúnmente utilizadas en pruebas de automatización. Estas incluyen herramientas que generan informes HTML, como Allure Report, y aquellas integradas con marcos de prueba como pytest-html para Python y TestNG para Java. También he utilizado plataformas de informes basadas en la nube como TestRail y Zephyr, que proporcionan capacidades centralizadas de gestión de pruebas e informes.

Mi flujo de trabajo típico implica configurar la herramienta de informes para recopilar los resultados de las pruebas durante la ejecución. Después de que las pruebas se completan, analizo los informes generados para identificar fallos, cuellos de botella en el rendimiento y la cobertura general de las pruebas. Utilizo los informes para comunicar los resultados de las pruebas a las partes interesadas y para realizar un seguimiento del progreso a lo largo del tiempo. En los casos en que se necesita una generación de informes personalizada, he utilizado bibliotecas como reportlab en Python para generar informes PDF a partir de datos de prueba sin procesar. También puedo crear informes para integrarlos con herramientas como Slack para informar a las partes interesadas sobre el estado de la compilación y los resultados de la ejecución de las pruebas.

18. ¿Cómo gestiona las consideraciones de seguridad en sus pruebas de automatización?

La seguridad en las pruebas de automatización es crucial. La abordo evitando la codificación fija de credenciales, utilizando la gestión segura de credenciales (por ejemplo, variables de entorno, herramientas de gestión de secretos) y asegurando que los datos de prueba estén saneados y no expongan información sensible. Se automatiza la prueba de validación de entrada para buscar vulnerabilidades como la inyección SQL y el scripting entre sitios (XSS).

Específicamente, las pruebas están diseñadas para verificar los mecanismos de autorización y autenticación. Por ejemplo, las pruebas de API verifican que los usuarios sin los roles adecuados no puedan acceder a los puntos finales restringidos. La actualización regular de las dependencias y el uso de herramientas de análisis estático en el código de prueba ayudan a prevenir vulnerabilidades de seguridad en el propio marco de prueba. Las técnicas de fuzzing también se pueden integrar para identificar vulnerabilidades inesperadas.

19. Explique cómo probaría una función que implica autenticación o autorización de usuarios.

Probar la autenticación/autorización del usuario implica varias capas. Primero, verificaría el inicio de sesión exitoso con credenciales válidas. Luego, probaría escenarios de fallo: nombre de usuario inválido, contraseña incorrecta, cuentas bloqueadas y protección contra fuerza bruta. Probar la funcionalidad de restablecimiento de contraseña (verificación por correo electrónico, caducidad del token) es crucial. Para la autorización, comprobaría que los usuarios solo pueden acceder a los recursos/funciones permitidos por sus roles o permisos. También se debe probar la ausencia de acceso, es decir, verificar explícitamente que un usuario no puede acceder a algo a lo que no se supone que debe acceder.

Específicamente, algunas pruebas incluyen verificar la gestión de la sesión (tiempo de espera, invalidación), la autenticación multifactor (si corresponde) y el control de acceso basado en roles (RBAC). Para RBAC, asegurar que los usuarios con roles específicos pueden realizar acciones y los usuarios sin esos roles no pueden. Considere usar herramientas como Postman o curl para enviar solicitudes con diferentes tokens/cookies de usuario y verificar la respuesta del servidor (por ejemplo, 403 Prohibido, 200 OK).

20. ¿Cómo aborda las pruebas de accesibilidad (cumplimiento de WCAG) utilizando la automatización?

Las pruebas automatizadas de accesibilidad se centran en detectar violaciones comunes de WCAG al principio del ciclo de desarrollo. Normalmente utilizo herramientas como axe-core, Lighthouse o Pa11y integradas en mi pipeline de CI/CD. Estas herramientas escanean el HTML renderizado e informan automáticamente sobre las violaciones de las directrices de accesibilidad.

Mi enfoque implica:

- Integrar las pruebas de accesibilidad en las pruebas automatizadas existentes: Por ejemplo, agregar comprobaciones de axe a las pruebas de Cypress o Selenium.

- Ejecutar auditorías automatizadas como parte del proceso de compilación: Esto señala cualquier problema nuevo o regresiones en la accesibilidad.

- Configurar las reglas: A menudo configuro el conjunto de reglas para que solo verifique el cumplimiento de WCAG 2.1 AA. Además, si es necesario, deshabilito selectivamente algunas reglas para reducir los falsos positivos y centrarme en los problemas de accesibilidad fundamentales.

axe.configure({ rules: [{ id: '...' , enabled: false }] }) - Usar reglas personalizadas: Si hay problemas de accesibilidad específicos del sitio web, es posible definir reglas personalizadas. Si bien la automatización es útil, es crucial recordar que solo cubre una parte de las pruebas de accesibilidad. Las pruebas manuales con tecnologías de asistencia como lectores de pantalla también son necesarias para un cumplimiento exhaustivo de WCAG.

21. Describa cómo colabora con los desarrolladores y otros evaluadores en un entorno Agile.

En un entorno Agile, la colaboración es clave. Participo activamente en las reuniones diarias para mantenerme informado sobre el progreso y los obstáculos. Trabajo en estrecha colaboración con los desarrolladores proporcionando comentarios rápidos sobre los informes de errores y los resultados de las pruebas, utilizando herramientas como Jira para una comunicación clara y el seguimiento de problemas. Participo en discusiones sobre el desarrollo basado en pruebas (TDD) o el desarrollo basado en el comportamiento (BDD) con los desarrolladores para garantizar la capacidad de prueba desde el principio y asegurar la claridad y reducir los errores. Además, realizo pruebas en pareja con los desarrolladores para trabajar en problemas complejos y mejorar la cobertura de las pruebas de manera eficiente.

Con otros probadores, colaboro en la creación de planes de prueba, la revisión de casos de prueba y el intercambio de conocimientos. Trabajamos juntos para garantizar una cobertura de pruebas exhaustiva y evitar la duplicación de esfuerzos. Las discusiones y sesiones de lluvia de ideas regulares nos ayudan a identificar riesgos potenciales y mejorar la calidad general del software. Comparto herramientas de prueba, scripts y marcos de automatización para maximizar la eficiencia en todo el equipo. Participo en reuniones retrospectivas para discutir los sprints completados y mejorar los procesos para los sprints futuros.

22. ¿Cómo decides qué automatizar y qué probar manualmente?

Decido qué automatizar en función del riesgo, la repetición y la estabilidad. Las áreas de alto riesgo, las pruebas ejecutadas con frecuencia y las características que es poco probable que cambien son los principales candidatos para la automatización. Las pruebas de regresión casi siempre se automatizan, al igual que las pruebas que verifican la funcionalidad principal. Cualquier cosa que se ejecute varias veces se beneficia de la automatización.

Las pruebas manuales se priorizan para las pruebas exploratorias, las pruebas de usabilidad y los casos extremos que son difíciles de definir programáticamente. Las nuevas características en desarrollo o las funcionalidades que experimentan cambios frecuentes a menudo se prueban manualmente inicialmente para permitir una retroalimentación y ajustes más rápidos. Cualquier prueba que requiera intuición humana y evaluación subjetiva también entra en las pruebas manuales.

Preguntas de entrevista sobre pruebas de automatización avanzadas

1. ¿Cómo maneja la prueba de aplicaciones que dependen en gran medida de la comunicación asíncrona, como las que utilizan colas de mensajes o websockets?

La prueba de aplicaciones asíncronas requiere un enfoque estratégico. La clave es aislar los componentes y simular eventos asíncronos. Para las colas de mensajes, me centraría en verificar la producción de mensajes (formato correcto, claves de enrutamiento), el consumo de mensajes (lógica de procesamiento, efectos secundarios) y el manejo de errores (mecanismos de reintento, colas de mensajes fallidos). Herramientas como el plugin shovel de RabbitMQ o MirrorMaker de Kafka son útiles para probar la replicación de datos.

Para Websockets, simularía conexiones de cliente y mensajes. Las pruebas incluyen verificar el intercambio correcto de mensajes, manejar diferentes estados de conexión (abierto, cerrado, error) y validar las actualizaciones en tiempo real. Podemos usar bibliotecas como Socket.IO o ws en los scripts de prueba para enviar y recibir mensajes, y herramientas como Postman o Insomnia también soportan pruebas de WebSocket. Los mocks y stubs son útiles para aislar la aplicación de servicios externos y controlar el comportamiento asíncrono. También usamos pruebas de integración para verificar la interacción entre componentes.

2. Explique cómo diseñaría un marco de automatización de pruebas para una arquitectura de microservicios.

Diseñar un marco de automatización de pruebas para una arquitectura de microservicios requiere un enfoque estratégico. Los aspectos clave incluyen: Pruebas de API: Dado que los microservicios se comunican a través de APIs, las pruebas de API robustas son cruciales. Se pueden usar herramientas como Postman, Rest-Assured o Pytest con Requests. Necesitamos cubrir pruebas de contrato (usando herramientas como Pact) para asegurar que los servicios se adhieran a los esquemas acordados. Pruebas de componentes: Las pruebas unitarias se centran en la lógica de servicio individual. Las pruebas de integración verifican las interacciones entre servicios relacionados, posiblemente utilizando virtualización de servicios o mocks para aislar las dependencias. Pruebas de extremo a extremo: Validar los flujos de negocio críticos que abarcan múltiples servicios. Se pueden emplear herramientas como Selenium o Cypress, pero minimizando la dependencia debido a la sobrecarga de mantenimiento. Integración de la tubería de despliegue: La automatización debe integrarse en la tubería de CI/CD para asegurar que las pruebas se ejecuten en cada compilación y despliegue.

Además, el monitoreo y registro efectivos son esenciales para diagnosticar fallas en un entorno distribuido. Considere herramientas como Prometheus y Grafana para monitorear la ejecución de pruebas y la salud del servicio. Utilice un sistema de registro centralizado para agregar registros de todos los microservicios y componentes de prueba, simplificando la depuración. También necesitamos buenos informes y paneles para mostrar los resultados de las ejecuciones de pruebas. Finalmente, considere el uso de la contenerización (por ejemplo, Docker) para crear entornos de prueba consistentes que reflejen la producción.

3. Describa su enfoque para probar el rendimiento y la escalabilidad de una API.

Mi enfoque para probar el rendimiento y la escalabilidad de la API implica varios pasos clave. Primero, defino objetivos de rendimiento claros, como umbrales de tiempo de respuesta, expectativas de rendimiento (solicitudes por segundo) y límites de utilización de recursos (CPU, memoria). Luego, creo escenarios de prueba realistas que imitan el comportamiento esperado del usuario, incluida la carga máxima, la carga sostenida y las pruebas de estrés.

Utilizo herramientas como k6, Gatling o JMeter para simular usuarios concurrentes y medir métricas clave. Durante las pruebas, monitoreo las métricas del lado del servidor (CPU, memoria, rendimiento de la base de datos) para identificar cuellos de botella. Analizo los resultados de las pruebas para identificar áreas de optimización, como consultas de base de datos ineficientes, algoritmos lentos o limitaciones de recursos. Basado en los resultados, proporciono recomendaciones para mejorar el rendimiento y la escalabilidad, lo que podría incluir la optimización del código, el escalado de la infraestructura, estrategias de almacenamiento en caché o el equilibrio de carga.

4. ¿Cómo se aseguraría de que la privacidad y la seguridad de los datos se prueben a fondo en un entorno de pruebas automatizado?

Para asegurar que la privacidad y la seguridad de los datos se prueben a fondo en un entorno automatizado, me centraría en varias áreas clave. En primer lugar, se deben implementar técnicas de enmascaramiento y anonimización de datos para utilizar datos realistas pero no confidenciales en las pruebas. En segundo lugar, integraría herramientas de pruebas de seguridad como análisis estático (SAST) y análisis dinámico (DAST) en el pipeline CI/CD para detectar automáticamente vulnerabilidades. En tercer lugar, implementaría pruebas automatizadas de control de acceso para verificar que solo los usuarios autorizados puedan acceder a datos o funcionalidades específicas.

Además, se deben implementar pruebas de registro de auditoría automatizadas para garantizar que todos los accesos y modificaciones de datos se registren y supervisen adecuadamente. Las pruebas de penetración automatizadas periódicas contra entornos de prueba son cruciales. Finalmente, la generación de informes debe estar implementada, por ejemplo, marcando automáticamente los casos de prueba fallidos relacionados con la seguridad, como comprobaciones de código de estado HTTP o detalles de excepciones dentro de los resultados de la prueba. Ejemplo de código en pytest:

import pytest import requests def test_sensitive_data_not_exposed(): response = requests.get("your_api_endpoint") assert response.status_code == 200 assert "sensitive_field" not in response.text

5. ¿Qué estrategias utilizaría para automatizar la prueba de un flujo de trabajo empresarial complejo que involucra múltiples sistemas y dependencias?

Para automatizar las pruebas de un flujo de trabajo empresarial complejo, usaría una combinación de estrategias. Primero, definiría casos de prueba claros basados en historias de usuario y requisitos del negocio, centrándome en escenarios de extremo a extremo. Aprovecharía frameworks de automatización de pruebas como Selenium o Cypress para pruebas de interfaz de usuario (UI), y herramientas de pruebas de API como Postman o RestAssured para validar el flujo de datos e integraciones entre sistemas. Consideraría usar un enfoque de Desarrollo Dirigido por el Comportamiento (BDD) con herramientas como Cucumber para crear scripts de prueba legibles para humanos y fáciles de mantener.

Segundo, para sistemas con colas de mensajes o procesamiento asíncrono, implementaría técnicas de interceptación y validación de mensajes. Esto incluye herramientas y scripts para verificar el contenido y el orden de los mensajes. También implementaría la virtualización de servicios utilizando herramientas como WireMock o Mockito para simular dependencias y aislar los sistemas bajo prueba. Las tuberías de Integración Continua/Despliegue Continuo (CI/CD) son cruciales para la ejecución automatizada de estas pruebas en cada cambio de código. Finalmente, el registro y la monitorización robustos ayudarán a depurar fallos e identificar cuellos de botella en el rendimiento.

6. ¿Cómo decide cuándo usar técnicas de prueba de caja blanca versus técnicas de prueba de caja negra en la automatización?

La decisión de utilizar pruebas de caja blanca o caja negra en la automatización depende de los objetivos de las pruebas, el conocimiento del sistema por parte del evaluador y la etapa de las pruebas. Las pruebas de caja negra suelen ser preferibles al probar desde la perspectiva del usuario sin conocimiento de la estructura interna del código. Es útil para pruebas funcionales, pruebas de integración y pruebas del sistema. Ejemplos incluyen probar flujos de trabajo del usuario o puntos finales de la API proporcionando entradas y verificando las salidas contra los resultados esperados. La automatización a menudo se centra en verificar los requisitos especificados o las historias de usuario. Estas pruebas generalmente involucran pruebas de interfaz de usuario o pruebas de API.

Las pruebas de caja blanca se aplican cuando el evaluador tiene acceso al código y necesita verificar rutas de código específicas, lógica y estructuras internas. Es adecuado para pruebas unitarias, análisis de cobertura de código y pruebas de rendimiento. Por ejemplo, uno podría escribir pruebas unitarias que invocan directamente funciones o métodos dentro de una clase específica para asegurar su comportamiento bajo varias condiciones. Las pruebas de caja blanca ayudan a detectar casos extremos o a verificar el manejo de errores que podrían pasar desapercibidos en las pruebas de caja negra. A menudo requiere instrumentación de código o el uso de frameworks de pruebas especializadas como JUnit o pytest para Python.

7. Explique cómo implementaría pruebas continuas en una tubería de CI/CD para una aplicación empresarial grande.

Las pruebas continuas en una tubería de CI/CD para una aplicación empresarial grande implican la automatización de pruebas en varias etapas para proporcionar retroalimentación rápida sobre los cambios de código. Integraría diferentes tipos de pruebas: unitarias, de integración, API, de rendimiento y de seguridad, en la tubería utilizando herramientas como JUnit, Selenium, JMeter y SonarQube.

Para implementarlo eficazmente, me aseguraría de que:

- Las pruebas unitarias se ejecuten en la etapa de commit,

- Las pruebas de integración y API se activen después del despliegue en un entorno de prueba.

- Las pruebas de rendimiento y seguridad deben ejecutarse en un entorno de preparación antes del despliegue en producción. Los resultados de las pruebas se agregan y se muestran en un panel centralizado, como Xray o TestRail, proporcionando visibilidad a todo el equipo. Las puertas automatizadas evitarían la promoción de compilaciones que fallan las pruebas críticas. Utilizaría un framework como Jenkins, GitLab CI o Azure DevOps para orquestar este proceso.

8. Describa su experiencia con la prueba de aplicaciones nativas de la nube e infraestructura como código.

Tengo experiencia en la prueba de aplicaciones nativas de la nube, centrándome en los microservicios desplegados en Kubernetes utilizando herramientas de Infraestructura como Código (IaC) como Terraform y CloudFormation. Mi estrategia de prueba incluye pruebas unitarias, pruebas de integración y pruebas de extremo a extremo, a menudo automatizadas dentro de las tuberías de CI/CD utilizando herramientas como Jenkins o GitLab CI. También utilizo herramientas como kubectl para la interacción directa con el clúster de Kubernetes para verificar despliegues y recursos.

Para IaC, me concentro en validar que la infraestructura desplegada coincida con la configuración definida, utilizando herramientas como tfsec para el escaneo de seguridad del código Terraform. También escribo pruebas automatizadas utilizando Python y bibliotecas como boto3 o el SDK de Terraform para verificar las propiedades de los recursos después del despliegue. Además, uso herramientas como k6 para realizar pruebas de carga en la aplicación nativa de la nube para asegurar la escalabilidad y el rendimiento en diversas condiciones. Me aseguro de validar el despliegue utilizando herramientas como helm.

9. ¿Cómo abordaría la automatización de las pruebas de modelos de aprendizaje automático y su integración en una aplicación?

La automatización de las pruebas de modelos de ML implica varios aspectos clave. Primero, la validación de datos es crucial. Esto asegura que los datos entrantes coincidan con el esquema y la distribución esperados, utilizando herramientas como Great Expectations o scripts personalizados. Luego, la prueba del rendimiento del modelo debe ser automatizada. Esto incluye el cálculo de métricas relevantes (por ejemplo, exactitud, precisión, recall) en conjuntos de datos reservados y comparándolas con umbrales predefinidos. Podemos utilizar herramientas como MLflow para rastrear estas métricas en diferentes versiones de modelos. Ejemplo de código para el cálculo de una métrica:

from sklearn.metrics import accuracy_score y_verdadero = [0, 1, 1, 0] y_predicho = [0, 1, 0, 0] exactitud = accuracy_score(y_verdadero, y_predicho) print(f"Exactitud: {exactitud}")

Finalmente, para las pruebas de integración, concéntrese en verificar el comportamiento de extremo a extremo del modelo dentro de la aplicación. Esto podría implicar la configuración de una tubería CI/CD que implemente automáticamente el modelo en un entorno de prueba, la ejecución de pruebas automatizadas contra los puntos finales de la API de la aplicación que utilizan el modelo y la reversión de la implementación si alguna prueba falla.

10. ¿Cuáles son algunos desafíos que podría enfrentar al automatizar pruebas para un sistema heredado y cómo los abordaría?

La automatización de pruebas para sistemas heredados a menudo presenta desafíos únicos. Un problema común es la falta de documentación y el código mal entendido, lo que dificulta determinar el comportamiento esperado y escribir pruebas efectivas. Abordar esto implica dedicar tiempo a la ingeniería inversa, explorar manualmente el sistema y colaborar con los desarrolladores que tienen conocimientos históricos. Otro desafío son las pruebas frágiles debido al código estrechamente acoplado y la falta de una clara separación de preocupaciones. La refactorización puede ser necesaria, pero a menudo no es factible debido a limitaciones de tiempo o presupuesto. Priorizaría probar las funcionalidades críticas primero y usaría técnicas como pruebas de caracterización para establecer una línea de base del comportamiento existente antes de realizar cualquier cambio. Además, los marcos o bibliotecas antiguos pueden dificultar la integración de herramientas de prueba modernas.

Otro problema importante es la configuración de datos, que a menudo implica esquemas de bases de datos complejos o procesos de entrada de datos manuales. Mi objetivo sería crear scripts automatizados de configuración de datos utilizando herramientas como scripts SQL o APIs (si están disponibles). Si no hay APIs disponibles, exploraría la creación de mis propias APIs simples que interactúen con la base de datos para que la configuración de datos sea más programática. Ejemplo: Usando Python con la biblioteca pyodbc

11. Discuta su experiencia con la gestión de datos de prueba en pruebas automatizadas, especialmente para conjuntos de datos complejos y sensibles.

En las pruebas automatizadas, he gestionado los datos de prueba utilizando varias técnicas. Para conjuntos de datos más sencillos, he empleado herramientas de generación de datos o utilizado estructuras de datos en memoria. Sin embargo, para conjuntos de datos complejos y sensibles, priorizo la seguridad y el realismo. He trabajado con técnicas de enmascaramiento y anonimización de datos para proteger la información confidencial, manteniendo al mismo tiempo la integridad estructural de los datos. He utilizado herramientas como Faker y scripts personalizados para generar datos realistas que imitan los datos de producción sin exponer información real del usuario. Un aspecto clave ha sido el control de versiones para los datos de prueba, tratándolos como código para garantizar la reproducibilidad y gestionar los cambios de forma eficaz.

Por ejemplo, al probar aplicaciones bancarias, he creado pipelines para extraer datos de bases de datos de producción, anonimizarlos y luego cargarlos en entornos de prueba. Seguimos políticas estrictas de gobierno de datos durante este proceso. También he utilizado la subconjuntación de bases de datos para crear conjuntos de datos de prueba más pequeños y manejables que representen los escenarios necesarios, optimizando el tiempo y los recursos de prueba. Garantizar el cumplimiento de los datos y prevenir las filtraciones de datos es primordial al manejar conjuntos de datos confidenciales.

12. ¿Cómo se asegura de que sus pruebas automatizadas sean confiables y mantenibles a largo plazo, especialmente a medida que la aplicación evoluciona?

Para garantizar que las pruebas automatizadas sean confiables y mantenibles, me centro en varios principios clave. Primero, priorizo escribir pruebas atómicas que prueben solo una funcionalidad específica, lo que facilita la identificación de la causa raíz de las fallas. También sigo el principio DRY (Don't Repeat Yourself) creando componentes de prueba reutilizables y funciones auxiliares. La gestión de datos de prueba y la configuración del entorno bien definidas son cruciales. Por ejemplo, usar fábricas o fixtures para generar datos de prueba de manera consistente. Ejemplo de código: fixture.create_user().

Además, mi objetivo es lograr una alta cobertura de pruebas, enfocándome en las funcionalidades y APIs más críticas. Reviso y refactorizo regularmente las pruebas para mantenerlas alineadas con los cambios en la aplicación. Utilizar el Modelo de Objetos de Página (POM), o patrones de diseño similares, ayuda a abstraer los elementos de la interfaz de usuario, por lo que los cambios en la interfaz de usuario requieren modificaciones mínimas en el conjunto de pruebas. Adicionalmente, la integración de las pruebas en las tuberías CI/CD proporciona retroalimentación continua y asegura la detección temprana de problemas. Actualizar regularmente las dependencias y abordar las pruebas inestables también contribuye a la fiabilidad a largo plazo.

13. Explique cómo usaría mocking y stubbing para aislar componentes durante las pruebas automatizadas.

Mocking y stubbing son técnicas utilizadas para aislar unidades de código durante las pruebas automatizadas. Los stubs proporcionan reemplazos controlados y simples para las dependencias. Por ejemplo, al probar una función que depende de una conexión a la base de datos, un stub podría devolver un conjunto de resultados codificados en lugar de consultar realmente la base de datos. Esto asegura que la prueba sea rápida y no dependa de factores externos.

Por otro lado, los mocks se utilizan para verificar las interacciones. Un objeto mock no solo reemplaza una dependencia, sino que también permite afirmar que métodos específicos fueron llamados con argumentos específicos un cierto número de veces. Esto permite confirmar que la unidad bajo prueba está interactuando con sus dependencias correctamente. El uso de mocks y stubs permite a los desarrolladores probar la funcionalidad sin necesidad de que todo el sistema esté en funcionamiento, lo que les permite tener más confianza y acelerar el desarrollo.

14. Describa su enfoque para automatizar las pruebas de aplicaciones móviles en diferentes dispositivos y plataformas.

Mi enfoque para automatizar las pruebas de aplicaciones móviles implica la utilización de una combinación de herramientas y estrategias para garantizar una cobertura integral en diferentes dispositivos y plataformas. Normalmente, comienzo por identificar las funcionalidades y los flujos de usuario críticos que necesitan ser probados. Para la automatización de pruebas, elegiría Appium junto con un lenguaje de programación como Python o Java para escribir scripts de prueba. Estos scripts interactuarían con la aplicación bajo prueba en varios emuladores, simuladores y dispositivos reales, cubriendo una gama de sistemas operativos (iOS y Android) y tamaños de pantalla.

Para gestionar la diversidad de dispositivos, utilizaría una granja de dispositivos basada en la nube como BrowserStack o Sauce Labs para un acceso escalable y bajo demanda a una amplia gama de dispositivos reales. Además, priorizo la integración de pruebas automatizadas en la tubería CI/CD, utilizando herramientas como Jenkins o GitLab CI, para permitir pruebas continuas y ciclos de retroalimentación más rápidos. Esto incluye pruebas de UI para la funcionalidad y la validación visual, pruebas de API para garantizar la integración del backend y pruebas de rendimiento para evaluar la capacidad de respuesta de la aplicación y el uso de recursos.

15. ¿Cómo maneja las pruebas de aplicaciones con interfaces de usuario dinámicas donde los elementos cambian con frecuencia?

Probar aplicaciones con interfaces de usuario dinámicas requiere un enfoque robusto y adaptable. Las estrategias incluyen el uso de esperas explícitas en lugar de esperas implícitas para manejar la carga de elementos, la implementación de pruebas basadas en datos para administrar los datos cambiantes y el empleo de localizadores más resistentes, como los ejes XPath o localizadores relativos, que son menos propensos a romperse cuando los elementos de la interfaz de usuario cambian.

Además, la adopción de herramientas de validación visual puede ayudar a detectar cambios inesperados en la interfaz de usuario. Considere el uso de capas de abstracción como el Page Object Model (POM) para encapsular las interacciones de los elementos de la interfaz de usuario. Esto hace que las pruebas sean más fáciles de mantener. Además, incorpore el mantenimiento y la refactorización regulares de las pruebas para mantener las pruebas alineadas con la evolución de la interfaz de usuario. El uso de técnicas como los bloques try-catch con mecanismos de reintento para las interacciones de los elementos podría ser útil para manejar los cambios transitorios de la interfaz de usuario durante la ejecución de la prueba.

16. ¿Qué estrategias utiliza para identificar y priorizar los casos de prueba para la automatización?

Identifico los casos de prueba para la automatización centrándome en escenarios de alto riesgo, repetitivos y que consumen mucho tiempo. Los factores clave incluyen la frecuencia de ejecución, la criticidad del negocio y la estabilidad de la característica. Priorizo los casos de prueba que cubren la funcionalidad principal, los flujos de trabajo críticos y las áreas propensas a errores de regresión.

Específicamente, busco casos de prueba que son:

- Alto riesgo: Cubre funcionalidades críticas donde el fallo tendría un impacto significativo.

- Repetitivo: Se ejecuta frecuentemente, como pruebas de regresión.

- Estable: Prueba funcionalidades con cambios mínimos para evitar sobrecarga de mantenimiento.

- Basado en datos: Fácilmente parametrizado con diferentes entradas.

- Pruebas de integración: Validando las interacciones entre componentes.

También considero la complejidad del caso de prueba y el esfuerzo requerido para automatizarlo. Es crucial equilibrar los beneficios de la automatización con los costos asociados.

17. ¿Cómo integraría herramientas de pruebas de seguridad en su proceso de pruebas automatizado?

Integrar herramientas de pruebas de seguridad en un proceso de pruebas automatizado implica varios pasos clave. Primero, identifique las herramientas apropiadas basándose en la pila tecnológica de la aplicación y las vulnerabilidades potenciales, como herramientas de pruebas de seguridad de análisis estático (SAST) como SonarQube o herramientas de pruebas de seguridad de análisis dinámico (DAST) como OWASP ZAP. Integre estas herramientas en el pipeline de CI/CD. Por ejemplo, use plugins para activar escaneos de seguridad después de cada compilación o despliegue.

La configuración es crucial. Ajuste las reglas y los umbrales de las herramientas de seguridad para minimizar los falsos positivos y centrarse en las vulnerabilidades críticas. Además, incorpore pruebas de seguridad en varias etapas, como pruebas unitarias, pruebas de integración y pruebas de extremo a extremo. Los resultados de los análisis de seguridad deben ser reportados y rastreados automáticamente, utilizando herramientas como Jira, para asegurar la corrección oportuna de los problemas identificados. Por ejemplo:

Ejemplo usando OWASP ZAP en un pipeline

zaproxy -cmd -quickurl "http://example.com" -quickprogress

18. Explique cómo aborda las pruebas de compatibilidad entre navegadores en un entorno automatizado.

Mi enfoque para las pruebas de compatibilidad entre navegadores en un entorno automatizado implica varios pasos clave. Primero, defino una matriz de navegadores y versiones de destino basada en la cuota de mercado y los análisis de usuarios. Luego, utilizo un marco como Selenium Grid o plataformas de pruebas basadas en la nube (por ejemplo, BrowserStack, Sauce Labs) para ejecutar mis pruebas automatizadas en esta matriz. Escribo pruebas utilizando herramientas como Selenium WebDriver o Cypress que abstraen los detalles específicos del navegador, pero también incorporo aserciones específicas del navegador cuando es necesario para validar las diferencias de renderizado o comportamiento.

Específicamente, aprovecho las variables de entorno o los archivos de configuración para parametrizar la ejecución de mis pruebas, lo que me permite cambiar fácilmente entre diferentes navegadores y versiones. También uso herramientas de pruebas visuales como Applitools Eyes o Percy para detectar diferencias sutiles de renderizado entre navegadores. Los informes son cruciales; configuro mi marco de pruebas para generar informes detallados que resalten cualquier problema de compatibilidad junto con capturas de pantalla y vídeos. Integro estos informes en las tuberías de CI/CD para proporcionar retroalimentación rápida a los desarrolladores.

19. Describe una vez cuando tuviste que depurar un problema complejo en tu marco de automatización. ¿Cuál fue tu enfoque?