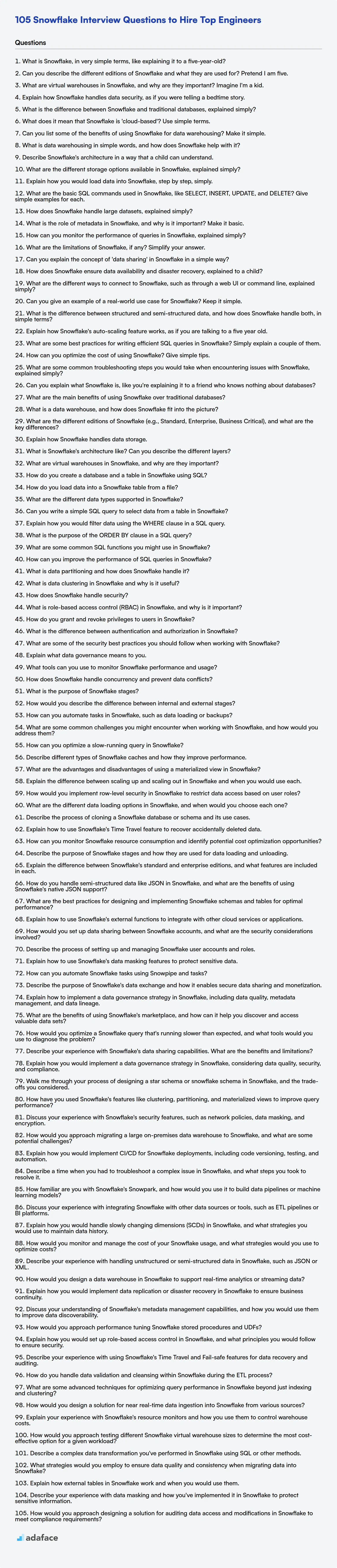

105 Preguntas de Entrevista de Snowflake para Contratar a los Mejores Ingenieros

Contratar profesionales de Snowflake requiere una profunda comprensión de sus habilidades en almacenamiento de datos, lagos de datos y computación en la nube. Los reclutadores y gerentes de contratación necesitan un conjunto de preguntas bien preparado para evaluar a los candidatos a fondo y evaluar su idoneidad para el puesto.

Esta publicación de blog proporciona una compilación detallada de preguntas de entrevista de Snowflake categorizadas por nivel de experiencia, que van desde recién graduados hasta profesionales experimentados, incluidas preguntas de opción múltiple. Su objetivo es proporcionarle las preguntas adecuadas para medir eficazmente el conocimiento y las habilidades prácticas de un candidato, lo que le ayudará a identificar el mejor talento.

Al usar estas preguntas, puede agilizar su proceso de entrevista y tomar decisiones de contratación informadas. Mejore la selección de sus candidatos con nuestra evaluación en línea de Snowflake para asegurarse de que está seleccionando a las personas más calificadas.

Tabla de contenidos

Preguntas de entrevista de Snowflake para recién graduados

Preguntas de entrevista de Snowflake para juniors

Preguntas de entrevista intermedias de Snowflake

Preguntas de entrevista de Snowflake para experimentados

Snowflake MCQ

¿Qué habilidades de Snowflake debería evaluar durante la fase de entrevista?

3 Consejos para usar preguntas de entrevista de Snowflake

Contrate al mejor talento de Snowflake con evaluaciones de habilidades

Descargue la plantilla de preguntas de entrevista de Snowflake en múltiples formatos

Preguntas de entrevista de Snowflake para recién graduados

1. ¿Qué es Snowflake, en términos muy sencillos, como explicárselo a un niño de cinco años?

Imagina que tienes muchos, muchos juguetes, como LEGO, muñecas y coches. Snowflake es como una sala de juegos gigante y súper organizada en la nube donde puedes guardar todos esos juguetes.

Te ayuda a mantenerlos seguros, te permite jugar con ellos cuando quieras, e incluso permite que tus amigos jueguen con ellos también, ¡sin estropear tu propia colección! Es como magia, pero es solo una forma realmente inteligente de almacenar y usar información.

2. ¿Puedes describir las diferentes ediciones de Snowflake y para qué se utilizan? Haz de cuenta que tengo cinco años.

¡Imagina que Snowflake es como diferentes sabores de helado! Algunos sabores son simples y baratos, y otros son elegantes y cuestan más. Cada sabor te permite hacer cosas diferentes con tus datos.

Hay un sabor básico llamado Estándar. Es bueno para empezar y realizar tareas de datos simples. Luego, está Enterprise, ¡que es como agregar chispas y una cereza encima! Tiene más funciones para empresas más grandes. Business Critical es el sabor súper-duper, con protección adicional para mantener tus datos seguros y protegidos, como un guardaespaldas. Y finalmente, Virtual Private Snowflake (VPS), que es el más seguro de todos, es como tener tu propio congelador cerrado solo para tu helado, manteniéndolo aislado y seguro de todos los demás. Cada una de estas ediciones proporciona diferentes niveles de seguridad, rendimiento y funciones, ¡así que eliges la que mejor se adapte a lo que necesitas hacer con tus datos!

3. ¿Qué son los almacenes virtuales en Snowflake y por qué son importantes? Imagina que soy un niño.

Imagina que Snowflake es como un gran parque infantil con muchos juguetes (¡datos!). Un almacén virtual es como un grupo de niños que puedes contratar para jugar con esos juguetes. Les dices lo que quieres que hagan (como contar cuántos bloques rojos hay), y ellos lo hacen por ti. Puedes tener diferentes grupos de niños (almacenes), algunos grandes y rápidos, otros pequeños y lentos, dependiendo de cuánto trabajo necesites hacer.

¡Son importantes porque sin ellos, nadie puede jugar con los juguetes! Proporcionan la potencia de cálculo necesaria para hacer preguntas y obtener respuestas de todos esos datos. Además, solo pagas por el tiempo que los niños realmente están jugando, por lo que es como alquilarlos solo cuando los necesitas, lo que ahorra dinero.

4. Explica cómo Snowflake maneja la seguridad de los datos, como si estuvieras contando un cuento para dormir.

Érase una vez, en la tierra de Data Cloud, vivía Snowflake, un castillo de hielo mágico que protegía datos valiosos. Snowflake se aseguraba de que solo los usuarios autorizados pudieran acceder a los datos utilizando claves seguras (autenticación). Cada clave tenía permisos específicos (control de acceso basado en roles), como permitir que un príncipe leyera solo los anuncios reales, pero no los cambiara. Los datos se protegían aún más cifrándolos utilizando códigos secretos (cifrado en reposo y en tránsito) mientras dormían en el castillo de hielo y cuando viajaban a tierras lejanas (como cuando se accede a ellos desde tu ordenador). Snowflake también vigila de cerca quién hace qué (auditoría), por lo que si algún duende travieso intenta colarse, puede ser atrapado y detenido.

Para asegurarse de que nadie robe secretos, Snowflake tiene capas adicionales de protección. Algunos secretos se ocultan utilizando técnicas como el enmascaramiento de datos, por lo que las partes importantes no se pueden ver sin permiso. Snowflake utiliza políticas de red como un muro mágico para controlar la entrada de datos. ¡Es como si Snowflake mantuviera los datos sanos y salvos, durante toda la noche y el día!

5. ¿Cuál es la diferencia entre Snowflake y las bases de datos tradicionales, explicado de forma sencilla?

Snowflake se diferencia de las bases de datos tradicionales en algunas formas clave. Las bases de datos tradicionales a menudo requieren que administres la infraestructura, incluyendo servidores, almacenamiento y copias de seguridad. Snowflake es un servicio totalmente gestionado, lo que significa que Snowflake se encarga de todos los aspectos de la infraestructura. Esto permite a los usuarios concentrarse en los datos y el análisis en lugar de la administración de la base de datos.

Otra diferencia importante es la arquitectura de Snowflake. Las bases de datos tradicionales suelen utilizar una arquitectura de disco compartido o sin recursos compartidos, lo que puede limitar la escalabilidad y la concurrencia. Snowflake utiliza una arquitectura única de datos compartidos multi-clúster, lo que permite el escalado independiente de la computación y el almacenamiento. Esta separación permite un mejor rendimiento y optimización de costos, ya que se pueden escalar los recursos de computación hacia arriba o hacia abajo según la demanda sin afectar los costos o el rendimiento del almacenamiento.

6. ¿Qué significa que Snowflake sea 'basado en la nube'? En términos sencillos.

Que Snowflake sea 'basado en la nube' simplemente significa que se ejecuta en Internet utilizando las computadoras (servidores) de otra persona en lugar de las suyas propias. Es como alquilar potencia de cálculo y almacenamiento a un proveedor como Amazon Web Services (AWS), Microsoft Azure o Google Cloud Platform (GCP).

En lugar de comprar y administrar servidores usted mismo, Snowflake se encarga de todo eso. Solo paga por lo que usa. Esto ofrece beneficios como escalabilidad (manejar fácilmente más datos o usuarios), costos reducidos (no es necesario comprar hardware costoso) y accesibilidad (acceder a sus datos desde cualquier lugar con conexión a Internet).

7. ¿Puede enumerar algunos de los beneficios de usar Snowflake para el almacenamiento de datos? Simplifíquelo.

Snowflake ofrece varios beneficios clave para el almacenamiento de datos que incluyen:

- Escalabilidad y Elasticidad: La computación y el almacenamiento se escalan de forma independiente, lo que le permite ajustar los recursos según las demandas de la carga de trabajo sin tiempo de inactividad.

- Rendimiento: La arquitectura de Snowflake y el motor de consulta optimizado ofrecen un rendimiento rápido de las consultas.

- Facilidad de uso: La carga y gestión de datos simplificadas y una interfaz fácil de usar reducen la sobrecarga administrativa.

- Rentabilidad: El modelo de precios de pago por uso y la utilización eficiente de los recursos pueden generar ahorros de costos.

- Compartir datos: Comparta datos de forma segura con usuarios internos y externos sin mover los datos.

- Soporte para varios tipos de datos: Snowflake maneja datos estructurados, semiestructurados y no estructurados.

8. ¿Qué es el almacenamiento de datos en palabras sencillas y cómo ayuda Snowflake?

El almacenamiento de datos es como crear un área de almacenamiento especial donde recopilas y organizas información de diferentes partes de tu negocio (como ventas, marketing y servicio al cliente). Esto te ayuda a analizar los datos para detectar tendencias, tomar mejores decisiones y mejorar el rendimiento de tu negocio. Piensa en ello como tomar todos los ingredientes de diferentes refrigeradores y despensas en un restaurante, y organizarlos cuidadosamente en un refrigerador central de fácil acceso, para que el chef pueda encontrarlos y usarlos fácilmente para cocinar.

Snowflake ayuda con el almacenamiento de datos al proporcionar una plataforma basada en la nube para almacenar, procesar y analizar grandes cantidades de datos. Es escalable, lo que significa que puedes aumentar o disminuir fácilmente los recursos según sea necesario. Los beneficios clave son:

- Escalabilidad: Maneja grandes conjuntos de datos sin problemas de rendimiento.

- Concurrencia: Múltiples usuarios pueden consultar datos al mismo tiempo.

- Rentable: Paga solo por los recursos que usas.

- Seguridad: Funciones de seguridad integradas para proteger tus datos.

- Fácil de usar: Snowflake tiene una interfaz de usuario simple en comparación con otras soluciones de almacenamiento de datos más antiguas.

9. Describe la arquitectura de Snowflake de una manera que un niño pueda entender.

Imagina que Snowflake es como una gran plataforma de construcción de Lego en línea. Todos los ladrillos de Lego (tus datos) se almacenan en un almacén especial y súper seguro (almacenamiento en la nube). Cuando quieres construir algo (ejecutar una consulta), pides prestados algunos constructores robot (almacenes virtuales). Estos robots no tocan los ladrillos de Lego originales; solo hacen copias para construir, por lo que tus datos originales siempre están seguros. Una vez que los robots terminan de construir, desaparecen, ¡y solo pagas por el tiempo que estuvieron trabajando! Puedes tener muchos grupos diferentes de robots trabajando en diferentes proyectos al mismo tiempo, todos usando los mismos ladrillos de Lego del almacén. Esto facilita que todos compartan y usen los datos sin estropearlos.

Así que, tiene tres partes principales: El almacén de Lego seguro, los constructores robot inteligentes y un centro de control que se asegura de que todos jueguen bien juntos. Esto te permite analizar tus datos de forma rápida y sencilla, sin tener que preocuparte por administrar todas las computadoras tú mismo.

10. ¿Cuáles son las diferentes opciones de almacenamiento disponibles en Snowflake, expliado de forma sencilla?

Snowflake abstrae la complejidad de elegir tipos de almacenamiento específicos. Todos los datos en Snowflake se almacenan en un formato columnar, comprimido y encriptado. Snowflake utiliza el almacenamiento en la nube (ya sea AWS S3, Azure Blob Storage o Google Cloud Storage) para almacenar físicamente los datos.

Esencialmente, no gestionas directamente las configuraciones de almacenamiento como lo harías con las bases de datos tradicionales. Snowflake se encarga de la optimización del almacenamiento, la disponibilidad y los aspectos de durabilidad por ti en segundo plano. Simplemente te enfocas en cargar y consultar tus datos.

11. Explica cómo cargarías datos en Snowflake, paso a paso, de forma sencilla.

Cargar datos en Snowflake implica algunos pasos clave. Primero, almacene sus datos en una ubicación a la que Snowflake pueda acceder, como AWS S3, Azure Blob Storage o Google Cloud Storage. Snowflake también proporciona etapas internas. Segundo, cree un objeto de formato de archivo en Snowflake que describa la estructura de sus archivos de datos (por ejemplo, CSV, JSON, Parquet). Defina el tipo de archivo, el delimitador de campo, la compresión y otras propiedades relevantes utilizando CREATE FILE FORMAT. Tercero, use el comando COPY INTO para cargar los datos desde la etapa a una tabla de Snowflake. Especifique la tabla, la ubicación de la etapa y el formato de archivo a utilizar. Por ejemplo, COPY INTO mytable FROM @mystage FILE_FORMAT = (FORMAT_NAME = my_file_format);.

Alternativamente, para conjuntos de datos más pequeños o la ingestión en tiempo real, puede usar Snowpipe. Snowpipe es el servicio de ingestión continua de datos de Snowflake. Configure un objeto de tubería que escuche los nuevos archivos en una etapa. Cuando llegan nuevos archivos, Snowpipe carga automáticamente los datos en la tabla especificada. Esto requiere la creación de un objeto de tubería y la configuración de un mecanismo de notificación para alertar a Snowpipe cuando se almacenan nuevos archivos.

12. ¿Cuáles son los comandos SQL básicos utilizados en Snowflake, como SELECT, INSERT, UPDATE y DELETE? Dé ejemplos sencillos para cada uno.

Los comandos SQL básicos en Snowflake se utilizan para manipular datos. SELECT recupera datos, INSERT agrega nuevos datos, UPDATE modifica los datos existentes y DELETE elimina datos.

Ejemplos:

SELECT:SELECT * FROM empleados;INSERT:INSERT INTO empleados (nombre, salario) VALUES ('John Doe', 60000);UPDATE:UPDATE empleados SET salario = 65000 WHERE nombre = 'John Doe';DELETE:DELETE FROM empleados WHERE nombre = 'John Doe';

13. ¿Cómo maneja Snowflake los conjuntos de datos grandes, explicado de forma sencilla?

Snowflake maneja conjuntos de datos grandes utilizando una arquitectura de procesamiento masivamente paralelo (MPP). Esencialmente, los datos se dividen en micro-particiones (pequeñas unidades de almacenamiento contiguas) y se distribuyen entre muchos nodos de cómputo. Cuando ejecuta una consulta, Snowflake distribuye automáticamente la carga de trabajo entre estos nodos, lo que les permite procesar datos simultáneamente, acelerando drásticamente la ejecución de la consulta.

Esta separación del almacenamiento y el cómputo permite a Snowflake escalar los recursos de cómputo hacia arriba o hacia abajo de forma independiente según la carga de trabajo. También utiliza el almacenamiento en columnas, que almacena los datos por columnas en lugar de por filas, lo que mejora el rendimiento de las consultas para las cargas de trabajo analíticas al leer solo las columnas necesarias para una consulta determinada. Esta arquitectura permite a Snowflake manejar conjuntos de datos muy grandes de manera eficiente y rentable.

14. ¿Cuál es el papel de los metadatos en Snowflake y por qué es importante? Explícalo de forma básica.

Los metadatos en Snowflake son esencialmente datos sobre datos. Describe varios aspectos de su entorno Snowflake, como: tablas, columnas, usuarios, almacenes de datos, consultas y linaje de datos. Piense en ello como un catálogo de biblioteca; le indica qué libros (datos) están disponibles y dónde encontrarlos.

Es importante porque impulsa casi todo lo que hace Snowflake. Permite el procesamiento eficiente de consultas, la seguridad, la gobernanza de datos y la gestión general del sistema. Sin metadatos precisos, Snowflake no sabría cómo acceder o gestionar sus datos de forma eficaz. Por ejemplo, cuando ejecuta una consulta, Snowflake utiliza metadatos para determinar el plan de ejecución óptimo. Los metadatos también permiten a Snowflake realizar un seguimiento del linaje de datos, mostrando cómo fluyen los datos a través del sistema.

15. ¿Cómo se puede supervisar el rendimiento de las consultas en Snowflake, explicado de forma sencilla?

Puede supervisar el rendimiento de las consultas de Snowflake utilizando la interfaz web, SQL o herramientas de socios.

Usando la interfaz web de Snowflake, puedes ver el historial de consultas y examinar los perfiles de consultas para obtener detalles como el tiempo de ejecución, la cantidad de datos escaneados y cualquier cuello de botella. Las funciones y vistas SQL (por ejemplo, QUERY_HISTORY, QUERY_HISTORY_BY_*) te permiten recuperar métricas de rendimiento de forma programática. Para una monitorización más avanzada, las herramientas ofrecidas por los socios de Snowflake suelen proporcionar visualizaciones y capacidades de alerta más completas. Las métricas clave a observar incluyen el tiempo de ejecución, la utilización del tamaño del almacén de datos, los bytes escaneados y el tiempo de compilación de la consulta.

16. ¿Cuáles son las limitaciones de Snowflake, si las hay? Simplifica tu respuesta.

Snowflake, aunque potente, tiene algunas limitaciones. Una clave es el costo. Su precio basado en el consumo puede ser caro si no se controla y optimiza cuidadosamente, especialmente con grandes conjuntos de datos y consultas complejas. Además, aunque Snowflake maneja datos estructurados y semiestructurados muy bien, no es ideal para datos no estructurados como imágenes o videos sin una transformación significativa.

Además, a pesar de las mejoras continuas, la gestión de metadatos de Snowflake puede ser un cuello de botella en implementaciones muy grandes. Si bien tiene soporte para muchos lenguajes a través de funciones externas, no es compatible de forma nativa con lenguajes procedimentales como PL/SQL a los que algunas organizaciones están acostumbradas. Esto podría requerir la reescritura de la lógica existente.

17. ¿Puede explicar el concepto de 'compartición de datos' en Snowflake de forma sencilla?

La compartición de datos en Snowflake le permite compartir datos de forma segura entre cuentas de Snowflake sin mover ni copiar realmente los datos. Piense en ello como conceder acceso a una tabla virtual (o conjunto de tablas, vistas, etc.) que reside en su cuenta a otra cuenta. La otra cuenta puede consultar estos datos 'compartidos' como si fueran propios, pero los datos permanecen almacenados y gestionados físicamente en su cuenta. No se necesita ETL ni replicación de datos.

Esto se logra a través de la arquitectura de compartición de datos segura de Snowflake. Usted, como proveedor de datos, crea un 'compartir', que es un puntero a los datos que desea compartir y luego otorga acceso a una cuenta específica de Snowflake. El consumidor (la cuenta que recibe los datos compartidos) crea una base de datos a partir de ese compartir, y esa base de datos actúa como un reflejo de solo lectura de los datos compartidos.

18. ¿Cómo asegura Snowflake la disponibilidad de datos y la recuperación ante desastres, explicado a un niño?

Imagina que Snowflake tiene una hucha mágica donde guarda tus datos. Para asegurarte de que siempre tienes tus datos incluso si algo malo sucede, como que la hucha se caiga y se rompa, Snowflake hace algunas cosas inteligentes. Primero, hace muchas copias de tus datos y las extiende en diferentes lugares muy lejos. ¡Piensa en ello como tener huchas adicionales escondidas en diferentes casas! Si una casa tiene un problema (¡como un incendio!), todavía puedes obtener tu dinero (datos) de las otras casas.

En segundo lugar, Snowflake realiza copias de seguridad constantes de tus datos. Esto significa que regularmente toma instantáneas de tu alcancía, por lo que si algo se borra o cambia accidentalmente, puedes volver a una instantánea anterior y recuperar los datos correctos. Por lo tanto, incluso si rompes accidentalmente tu juguete (datos), ¡Snowflake tiene una foto para volver a armarlo!

19. ¿Cuáles son las diferentes formas de conectarse a Snowflake, como a través de una interfaz de usuario web o línea de comandos, explicadas de forma sencilla?

Snowflake ofrece varias formas de conectarse. La más común es a través de la interfaz de usuario web de Snowsight, que es una interfaz basada en navegador para escribir consultas SQL, administrar usuarios y monitorear el rendimiento. Se accede directamente a través de tu cuenta de Snowflake.

Otra forma es a través del cliente de línea de comandos SnowSQL. Esto requiere instalación en tu máquina local. Luego, puedes ejecutar comandos y scripts SQL directamente desde tu terminal. También hay conectores disponibles para varios lenguajes de programación como Python (usando el conector de Snowflake para Python), lo que te permite interactuar con Snowflake programáticamente.

20. ¿Puedes dar un ejemplo de un caso de uso del mundo real para Snowflake? Mantenlo simple.

Un gran minorista en línea usa Snowflake para consolidar todos sus datos de ventas de varias fuentes (tienda en línea, tiendas físicas, aplicación móvil) en un único almacén de datos unificado. Esto les permite realizar análisis de ventas completos, como:

- Identificar los productos más vendidos en todos los canales.

- Comprender los patrones de comportamiento de compra de los clientes.

- Optimizar los niveles de inventario en función de los pronósticos de demanda.

Debido a que Snowflake puede manejar grandes volúmenes de datos y consultas complejas de manera eficiente, el minorista puede obtener información valiosa sobre el rendimiento de sus ventas y tomar decisiones basadas en datos para mejorar la rentabilidad y la satisfacción del cliente.

21. ¿Cuál es la diferencia entre datos estructurados y semiestructurados, y cómo maneja Snowflake ambos, en términos simples?

Los datos estructurados tienen un esquema predefinido, como una tabla en una base de datos relacional con columnas y filas (piense en archivos CSV o bases de datos SQL). Los datos semiestructurados no tienen un esquema estricto pero utilizan etiquetas o marcadores para delimitar elementos, como JSON o XML. Ofrece flexibilidad pero aún tiene algo de organización.

Snowflake puede manejar ambos. Para datos estructurados, Snowflake funciona como una base de datos SQL estándar, lo que le permite definir tablas y cargar datos en ellas. Para datos semiestructurados, Snowflake ofrece soporte nativo utilizando el tipo de datos VARIANT. Esto le permite cargar JSON o XML directamente y luego consultarlo usando SQL con funciones para analizar y extraer elementos específicos. Snowflake infiere automáticamente el esquema al leer datos semiestructurados almacenados en columnas VARIANT.

22. Explica cómo funciona la función de escalado automático de Snowflake, como si estuvieras hablando con un niño de cinco años.

Imagina que Snowflake es como un parque infantil con toboganes. Cuando solo juegan unos pocos niños, solo necesitamos un tobogán abierto. ¡Eso es como un Snowflake pequeño! Pero cuando muchos, muchos niños vienen a jugar, un tobogán no es suficiente, así que abrimos más toboganes automáticamente para que todos puedan divertirse más rápido. Snowflake hace lo mismo con las computadoras. Cuando no hay mucho trabajo, usa solo unas pocas computadoras, pero cuando hay mucho trabajo por hacer, agrega más computadoras automáticamente para que las cosas se hagan rápidamente, ¡como abrir más toboganes en el parque infantil!

23. ¿Cuáles son algunas de las mejores prácticas para escribir consultas SQL eficientes en Snowflake? Explica simplemente un par de ellas.

Al escribir consultas SQL eficientes en Snowflake, considera estas mejores prácticas:

- Usa el filtro de la cláusula WHERE: Siempre filtra los datos lo antes posible en la consulta usando la cláusula

WHERE. Esto reduce la cantidad de datos que Snowflake necesita escanear y procesar. Evita filtrar después de las uniones, a menos que sea inevitable. Por ejemplo, prefiereSELECT * FROM table WHERE column = 'value'sobre seleccionar todos los datos y luego filtrar. - Aprovecha la agrupación (Clustering): La agrupación (Clustering) de Snowflake puede mejorar significativamente el rendimiento de las consultas. Elige una clave de agrupación basada en columnas filtradas o unidas con frecuencia. Al filtrar consultas, usa columnas agrupadas con la cláusula

WHEREadecuada.

24. ¿Cómo se puede optimizar el costo de usar Snowflake? Dé consejos sencillos.

Para optimizar los costos de Snowflake, concéntrese en prácticas eficientes de almacenamiento de datos. Reduzca los costos de cómputo dimensionando correctamente los almacenes de datos virtuales, suspendiendo automáticamente aquellos que estén inactivos y escalando hacia arriba/abajo en función de la carga de trabajo. Mejore el rendimiento de las consultas mediante la agrupación adecuada de datos, el uso de tipos de datos apropiados y evitando SELECT *. Minimice los costos de almacenamiento aprovechando la compresión de datos, la partición de tablas grandes e implementando políticas de retención de datos para eliminar datos innecesarios. Las vistas materializadas son excelentes para el rendimiento de consultas repetidas y el ahorro de costos.

Además, supervise el uso de Snowflake a través de la interfaz web o mediante programación para identificar los factores que impulsan los costos y las áreas de mejora. Considere el uso de funciones de Snowflake como Monitores de Recursos para limitar el consumo de créditos y aproveche los descuentos como los precios por capacidad si sus necesidades son predecibles. Asegúrese de analizar sus consultas.

25. ¿Cuáles son algunos pasos comunes de solución de problemas que tomaría al encontrar problemas con Snowflake, explicados de manera simple?

Cuando se solucionan problemas de Snowflake, generalmente empiezo con lo básico. Primero, verifico mi conexión y credenciales para asegurarme de que realmente puedo conectarme al entorno de Snowflake. Un buen primer paso es intentar una consulta simple SELECT 1; para verificar la conectividad y la funcionalidad básica. Luego, examino el historial de consultas para ver si alguna consulta reciente falló y reviso sus mensajes de error. El perfil de consulta de Snowflake es invaluable para identificar cuellos de botella en el rendimiento, como uniones de bajo rendimiento o escaneos completos de tablas. También verifico la página de estado de Snowflake para ver si hay alguna interrupción del servicio informada que pueda estar afectando el rendimiento o la disponibilidad.

Luego, investigo el mensaje de error específico o el comportamiento inesperado. Si se trata de un problema de datos, examinaría los datos en sí, verificando valores nulos, tipos de datos incorrectos o inconsistencias. Para problemas de rendimiento, observaría los planes de ejecución de consultas para identificar áreas de optimización, como agregar o ajustar claves de agrupación o usar tamaños de almacén apropiados. Finalmente, a menudo consulto la documentación de Snowflake y los foros de la comunidad para obtener soluciones a problemas comunes, especialmente si el mensaje de error no es inmediatamente claro. Siempre trato de aislar el problema simplificando la consulta o el proceso para identificar la causa raíz.

Preguntas de entrevista de Snowflake para juniors

1. ¿Puedes explicar qué es Snowflake, como si se lo estuvieras explicando a un amigo que no sabe nada de bases de datos?

Imagina que tienes toneladas de datos, como todos los registros de ventas de tu tienda o los registros de tu sitio web, y quieres entender patrones o tendencias a partir de ellos. Snowflake es como una hoja de cálculo gigante y superpotenciada en la nube que puede manejar todos esos datos. Es realmente bueno porque es rápido, fácil de usar y se escala automáticamente, lo que significa que no tienes que preocuparte de que se caiga cuando cargas demasiados datos.

Piénsalo así: Normalmente, necesitarías configurar servidores de bases de datos complicados, configurar el almacenamiento y preocuparte por las copias de seguridad. Snowflake se encarga de todo eso por ti. Simplemente subes tus datos y luego puedes empezar a hacer preguntas y obtener respuestas. También funciona bien con otras herramientas como el software de visualización de datos (Tableau) y los lenguajes de programación para realizar análisis de datos más avanzados.

2. ¿Cuáles son los principales beneficios de usar Snowflake en comparación con las bases de datos tradicionales?

Snowflake ofrece varias ventajas sobre las bases de datos tradicionales, principalmente centradas en su arquitectura nativa de la nube. Estos beneficios incluyen: Escalabilidad y Rendimiento: Snowflake puede escalar de forma independiente los recursos de cómputo y almacenamiento, lo que permite una rápida adaptación a las cargas de trabajo cambiantes. Esto generalmente conduce a un rendimiento de consulta más rápido en comparación con las bases de datos tradicionales, donde el escalado puede ser más complejo y consumir más tiempo. Rentabilidad: El modelo de pago por uso le permite pagar solo por los recursos que consume. Además, la capacidad de escalar el cómputo de forma independiente significa que puede aumentar el cómputo solo cuando sea necesario y reducirlo cuando no lo sea. Compartir Datos: La arquitectura de Snowflake facilita el intercambio de datos seguro y fácil entre equipos internos, socios y clientes sin la necesidad de replicación de datos o procesos ETL complejos.

Además, Snowflake proporciona Gestión Simplificada: Snowflake es un servicio totalmente gestionado, lo que reduce la sobrecarga operativa asociada con las tareas de administración de bases de datos tradicionales, como la aplicación de parches, las copias de seguridad y la optimización del rendimiento. Soporte para Datos Semiestructurados: Snowflake admite de forma nativa formatos de datos semiestructurados como JSON y XML, lo que simplifica la ingestión y el análisis de datos sin requerir transformaciones complejas por adelantado.

3. ¿Qué es un almacén de datos y cómo encaja Snowflake en la imagen?

Un almacén de datos es un repositorio central para almacenar datos integrados de una o más fuentes dispares. Está diseñado para la generación de informes y el análisis de datos, y es un componente central de la inteligencia empresarial. Las características clave incluyen datos orientados a temas, integrados, variantes en el tiempo y no volátiles.

Snowflake es una plataforma de almacenamiento de datos basada en la nube que se ofrece como Software como Servicio (SaaS). Proporciona un servicio totalmente gestionado, lo que significa que los usuarios no tienen que preocuparse por la infraestructura, la configuración o el mantenimiento. Snowflake ofrece características como: * Escalado separado de cómputo y almacenamiento. * Soporte para datos semiestructurados. * Fuertes características de seguridad. * Precios de pago por uso. Snowflake se utiliza para almacenar y analizar grandes cantidades de datos estructurados y semiestructurados, lo que permite a las organizaciones obtener información y tomar decisiones basadas en datos.

4. ¿Cuáles son las diferentes ediciones de Snowflake (por ejemplo, Standard, Enterprise, Business Critical) y cuáles son las principales diferencias?

Snowflake ofrece varias ediciones adaptadas a diferentes necesidades y presupuestos. Las ediciones principales son Standard, Enterprise, Business Critical (anteriormente Enterprise for Sensitive Data) y Virtual Private Snowflake (VPS). Las principales diferencias residen en las características, la seguridad, el cumplimiento y el rendimiento.

Edición Estándar es la opción de nivel de entrada, que proporciona funcionalidades básicas de almacenamiento de datos. Edición Enterprise agrega características avanzadas como viaje en el tiempo, vistas materializadas y seguridad mejorada. Edición Business Critical proporciona el más alto nivel de protección y disponibilidad de datos, incluido el cumplimiento de HIPAA y el cifrado mejorado. Virtual Private Snowflake (VPS), es un entorno físicamente aislado para organizaciones con estrictas necesidades de seguridad y cumplimiento. Cada nivel superior se basa en las características de los niveles inferiores, ofreciendo niveles crecientes de rendimiento, seguridad y gobernanza.

5. Explique cómo Snowflake maneja el almacenamiento de datos.

Snowflake emplea una arquitectura híbrida para el almacenamiento de datos, separando el cómputo y el almacenamiento. Los datos se almacenan en un formato columnar, optimizado para análisis, dentro del sistema de almacenamiento interno de Snowflake, que suele ser almacenamiento de objetos en la nube (como AWS S3, Azure Blob Storage o Google Cloud Storage). Snowflake comprime y encripta estos datos. Snowflake gestiona la organización, el tamaño de los archivos, la estructura, los metadatos y la compresión. No tiene acceso directo al almacenamiento de objetos subyacente.

El almacenamiento de Snowflake es virtualmente ilimitado y se escala elásticamente. Cuando carga datos, Snowflake los reorganiza automáticamente en su formato columnar optimizado. Los datos también se particionan y micro-particionan automáticamente. Las micro-particiones son unidades de almacenamiento contiguas, típicamente de 50 a 500 MB de datos sin comprimir, organizados de forma columnar. Snowflake utiliza metadatos sobre estas micro-particiones para la optimización de consultas.

6. ¿Cómo es la arquitectura de Snowflake? ¿Puede describir las diferentes capas?

La arquitectura de Snowflake es un híbrido de arquitecturas de disco compartido y sin nada compartido. Utiliza un repositorio de datos central al que pueden acceder todos los nodos de cómputo, pero cada nodo de cómputo tiene sus propios recursos de cómputo independientes. Snowflake tiene tres capas principales:

- Capa de Servicios en la Nube: Esta capa gestiona todo el sistema, incluyendo la autenticación, el control de acceso, la gestión de la infraestructura, la gestión de metadatos, el análisis y la optimización de consultas.

- Capa de Cómputo: Esta capa consta de almacenes virtuales, que son clústeres de recursos de cómputo (CPU, memoria y almacenamiento temporal) utilizados para ejecutar consultas. Cada almacén virtual es independiente y no comparte recursos de cómputo.

- Capa de Almacenamiento: Esta capa almacena todos los datos en un formato columnar, optimizado para consultas analíticas. Snowflake gestiona el almacenamiento y la compresión de los datos. Los usuarios no necesitan preocuparse por la distribución o gestión de datos; Snowflake se encarga de todo eso.

7. ¿Qué son los almacenes virtuales en Snowflake y por qué son importantes?

Los almacenes virtuales en Snowflake son motores de cómputo que se utilizan para ejecutar consultas y realizar otras operaciones de manipulación de datos. Son esencialmente clústeres de recursos de cómputo (CPU, memoria y almacenamiento temporal) que se pueden aprovisionar y escalar dinámicamente de forma independiente del almacenamiento.

Son importantes porque proporcionan varios beneficios clave:

- Aislamiento de recursos de cómputo: Se pueden ejecutar diferentes cargas de trabajo en almacenes separados, lo que evita la contención de recursos y mejora el rendimiento.

- Escalabilidad: Puede cambiar fácilmente el tamaño de los almacenes para manejar diversas cargas de trabajo. Por ejemplo, escalar verticalmente para cargas de datos grandes y escalar horizontalmente durante las horas de menor actividad.

- Concurrencia: Snowflake gestiona automáticamente la concurrencia dentro de un almacén, lo que permite que varios usuarios o aplicaciones ejecuten consultas simultáneamente.

- Optimización de costos: Solo paga por los recursos de cómputo que utiliza, y los almacenes se pueden suspender automáticamente cuando están inactivos, lo que reduce los costos.

- Flexibilidad: Hay diferentes tamaños de almacén disponibles para adaptarse a diferentes requisitos de carga de trabajo.

8. ¿Cómo se crea una base de datos y una tabla en Snowflake usando SQL?

Para crear una base de datos en Snowflake, use el comando CREATE DATABASE seguido del nombre de la base de datos.

CREATE DATABASE my_database;

Para crear una tabla dentro de esa base de datos, primero asegúrese de que está utilizando la base de datos con USE DATABASE my_database;. Luego, use el comando CREATE TABLE, especificando el nombre de la tabla y las definiciones de columna (nombre, tipo de datos, restricciones).

CREATE TABLE my_table ( id INT, name VARCHAR(255), created_at TIMESTAMP );

9. ¿Cómo se cargan datos en una tabla Snowflake desde un archivo?

Para cargar datos en una tabla Snowflake desde un archivo, normalmente se usa el comando COPY INTO <table>. Primero, almacene su archivo de datos (por ejemplo, CSV, JSON, Parquet) en una ubicación a la que Snowflake pueda acceder, como una etapa interna (administrada por Snowflake) o una etapa externa (por ejemplo, AWS S3, Azure Blob Storage, Google Cloud Storage). Luego, ejecute el comando COPY INTO, especificando el nombre de la tabla, la ubicación de la etapa y las opciones de formato de archivo para que coincidan con su archivo de datos.

COPY INTO mi_tabla FROM @mi_stage/data.csv FILE_FORMAT = (TYPE = CSV FIELD_DELIMITER = ',' SKIP_HEADER = 1);

10. ¿Cuáles son los diferentes tipos de datos soportados en Snowflake?

Snowflake soporta una variedad de tipos de datos, que pueden ser ampliamente categorizados en:

- Numérico:

NUMBER,DECIMAL,INT,INTEGER,BIGINT,SMALLINT,TINYINT,BYTEINT,FLOAT,FLOAT8,DOUBLE,DOUBLE PRECISION,REAL - Cadena:

VARCHAR,STRING,TEXT - Binario:

BINARY - Fecha y Hora:

DATE,TIME,DATETIME,TIMESTAMP(y sus variantes comoTIMESTAMP_LTZ,TIMESTAMP_NTZ,TIMESTAMP_TZ) - Booleano:

BOOLEAN - Datos semiestructurados:

VARIANT,OBJECT,ARRAY

VARIANT es particularmente importante ya que permite almacenar datos semiestructurados como JSON, Avro, ORC, Parquet o XML sin requerir un esquema predefinido.

11. ¿Puede escribir una consulta SQL simple para seleccionar datos de una tabla en Snowflake?

Para seleccionar todas las columnas de una tabla llamada empleados en Snowflake, usaría la siguiente consulta SQL:

SELECT * FROM empleados;

Si solo desea seleccionar columnas específicas, por ejemplo, nombre y apellido, modificaría la consulta así:

SELECT nombre, apellido FROM empleados;

12. Explique cómo filtraría datos usando la cláusula WHERE en una consulta SQL.

La cláusula WHERE en SQL se usa para filtrar filas de una tabla en función de una condición especificada. Aparece después de la cláusula FROM y le permite seleccionar solo aquellas filas que cumplen con sus criterios. La condición en la cláusula WHERE puede usar varios operadores como =, !=, >, <, >=, <=, LIKE, BETWEEN, IN y NOT. Por ejemplo:

SELECT * FROM empleados WHERE salario > 50000;

Esta consulta recuperaría todas las columnas (*) de la tabla empleados, pero solo para aquellos empleados cuyo salario sea superior a 50000.

13. ¿Cuál es el propósito de la cláusula ORDER BY en una consulta SQL?

La cláusula ORDER BY en una consulta SQL se utiliza para ordenar el conjunto de resultados de la consulta. Especifica una o más columnas que deben utilizarse como base para ordenar las filas.

Por defecto, ORDER BY ordena en orden ascendente (A-Z, 0-9). Puede especificar explícitamente el orden ascendente utilizando ASC o el orden descendente utilizando DESC. Por ejemplo: ORDER BY nombre_columna DESC ordenaría los resultados por nombre_columna en orden descendente. Se pueden especificar varias columnas para la ordenación, creando una ordenación jerárquica.

14. ¿Cuáles son algunas funciones SQL comunes que podría usar en Snowflake?

Snowflake admite una amplia gama de funciones SQL. Algunas comunes que he usado incluyen:

- Funciones de cadena:

UPPER(),LOWER(),TRIM(),SUBSTRING(),LENGTH(),CONCAT()para manipular datos de texto. - Funciones de fecha/hora:

CURRENT_DATE(),CURRENT_TIMESTAMP(),DATE(),TIME(),DATEADD(),DATEDIFF(),EXTRACT()para trabajar con valores de fecha y hora. - Funciones numéricas:

ROUND(),TRUNC(),ABS(),MOD(),SQRT()para realizar operaciones matemáticas. - Funciones condicionales:

CASE WHEN ... THEN ... ELSE ... END,IFNULL(),NVL()para manejar la lógica condicional. - Funciones agregadas:

COUNT(),SUM(),AVG(),MIN(),MAX()para resumir datos. - Funciones de ventana:

ROW_NUMBER(),RANK(),LAG(),LEAD(),SUM() OVER(),AVG() OVER()para realizar cálculos en un conjunto de filas. - Funciones de variante:

PARSE_JSON(),TO_JSON(),GET()yGET_PATH()para manejar datos JSON semiestructurados.

Aquí tienes un ejemplo usando CASE WHEN y UPPER():

SELECT CASE WHEN estado = 'activo' THEN UPPER(nombre) ELSE nombre END AS nombre_procesado FROM usuarios;

15. ¿Cómo se puede mejorar el rendimiento de las consultas SQL en Snowflake?

Para mejorar el rendimiento de las consultas SQL en Snowflake, considere estos puntos: Optimizar la estructura de la consulta. Use EXPLAIN para comprender los planes de consulta e identificar cuellos de botella. Filtre los datos temprano utilizando las cláusulas WHERE, especialmente en las columnas agrupadas. Aprovechar las funciones de Snowflake. Utilice claves de agrupación para organizar físicamente los datos para una recuperación más rápida. Use vistas materializadas para precalcular datos a los que se accede con frecuencia. Optimizar la carga y el almacenamiento de datos. Asegúrese de que los datos se carguen correctamente utilizando las mejores prácticas para el tamaño y el formato de los archivos (Parquet generalmente es el preferido). Analice regularmente los metadatos de la tabla para identificar oportunidades de reagrupación u optimización. Utilice los tipos de datos adecuados. Asegúrese de que se utilicen los tipos de datos correctos para reducir las conversiones de datos innecesarias.

Consideraciones de hardware: Aunque Snowflake maneja automáticamente los aspectos de la infraestructura, elija el tamaño de almacén de datos adecuado para la carga de trabajo. Considere escalar el almacén de datos para aumentar el rendimiento a corto plazo o escalar horizontalmente para la concurrencia. Almacenamiento en caché: Snowflake utiliza capas de almacenamiento en caché para acelerar la recuperación de datos. Asegúrese de que el almacén de datos virtual no se suspenda con frecuencia para mantener la validez de la caché.

16. ¿Qué es la partición de datos y cómo la maneja Snowflake?

La partición de datos es el proceso de dividir una tabla grande en partes más pequeñas y manejables. Esto mejora el rendimiento de la consulta al permitir que la base de datos escanee solo las particiones relevantes, en lugar de toda la tabla. Snowflake maneja automáticamente la partición de datos a través de su función de micro-partición.

Snowflake divide todos los datos de una tabla en micro-particiones, que son unidades de almacenamiento contiguas que suelen oscilar entre 50 y 500 MB (antes de la compresión). Los datos dentro de cada micro-partición se ordenan automáticamente utilizando una combinación de técnicas (incluidas las claves de agrupación si se definen), lo que proporciona un rendimiento eficiente de las consultas. El optimizador de consultas de Snowflake aprovecha los metadatos de las micro-particiones para podar particiones innecesarias durante la ejecución de la consulta, optimizando aún más el rendimiento. El usuario no gestiona las particiones directamente, por lo que simplifica la gestión de datos.

17. ¿Qué es la agrupación de datos en Snowflake y por qué es útil?

La agrupación de datos en Snowflake se refiere al proceso de organizar los datos dentro de una tabla basándose en una o más columnas, conocidas como claves de agrupación. Snowflake reorganiza físicamente los datos en el disco para mejorar el rendimiento de las consultas. Cuando las consultas filtran u ordenan por las claves de agrupación, Snowflake puede podar eficientemente grandes porciones de la tabla que no contienen datos relevantes, reduciendo así la cantidad de datos escaneados.

La utilidad de la agrupación de datos reside en su capacidad para acelerar significativamente la ejecución de consultas y reducir los costos. Al minimizar la cantidad de datos escaneados, las consultas se completan más rápido, lo que lleva a una mejor experiencia del usuario. Además, la reducción del escaneo de datos se traduce en una menor cantidad de créditos de Snowflake consumidos, lo que genera ahorros de costos. La efectividad de la agrupación depende de qué tan bien las claves de agrupación se alinean con los patrones de consulta comunes. La información de agrupación está disponible a través de la función SYSTEM$CLUSTERING_INFORMATION.

18. ¿Cómo maneja Snowflake la seguridad?

Snowflake emplea un enfoque de seguridad de múltiples capas, que abarca la seguridad de la red, la infraestructura, los datos y la cuenta. Las características clave incluyen: aislamiento de la red mediante el uso de nubes privadas virtuales (VPC), cifrado de datos en reposo y en tránsito (cifrado AES de 256 bits), soporte para autenticación federada y inicio de sesión único (SSO), autenticación multifactor (MFA), control de acceso basado en roles (RBAC) y capacidades de auditoría integrales. Snowflake también cumple con varios estándares de la industria como SOC 2 Tipo II, HIPAA y PCI DSS.

La gobernanza de datos se logra a través de características como el enmascaramiento de datos (dinámico y estático), la seguridad a nivel de fila y la seguridad a nivel de columna, lo que permite un control preciso sobre el acceso a los datos. Se realizan evaluaciones de seguridad y pruebas de penetración periódicas para identificar y abordar las posibles vulnerabilidades, y Snowflake proporciona documentación de seguridad detallada y las mejores prácticas para los clientes.

19. ¿Qué es el control de acceso basado en roles (RBAC) en Snowflake y por qué es importante?

El Control de Acceso Basado en Roles (RBAC) en Snowflake es un método para gestionar los derechos de acceso basados en los roles asignados a los usuarios. En lugar de otorgar permisos directamente a usuarios individuales, los permisos se asocian con roles, y luego los usuarios se asignan a estos roles. Esto simplifica la gestión del acceso. Por ejemplo, podría tener roles como data_engineer (ingeniero_de_datos), analyst (analista) o manager (gerente), cada uno con permisos específicos para acceder a ciertos datos o realizar acciones específicas.

RBAC es importante porque mejora la seguridad, simplifica la administración y mejora la auditabilidad. Reduce el riesgo de otorgar permisos excesivos, facilitando la gestión del acceso de los usuarios y garantizando el cumplimiento de las políticas de seguridad. Al centralizar los permisos dentro de los roles, los administradores pueden otorgar o revocar fácilmente los derechos de acceso para grupos de usuarios, haciendo que la gestión de usuarios sea más eficiente y menos propensa a errores. También ayuda a rastrear quién tiene acceso a qué, facilitando la auditoría.

20. ¿Cómo se otorgan y revocan los privilegios a los usuarios en Snowflake?

En Snowflake, los privilegios se otorgan y se revocan utilizando los comandos GRANT y REVOKE, respectivamente. La sintaxis general es la siguiente:

GRANT <privilegio> ON <tipo_de_objeto> <nombre_del_objeto> TO ROLE <nombre_del_rol>; REVOKE <privilegio> ON <tipo_de_objeto> <nombre_del_objeto> FROM ROLE <nombre_del_rol>;

Reemplace <privilegio> con el privilegio específico (por ejemplo, SELECT, INSERT, USAGE, OWNERSHIP), <tipo_de_objeto> con el tipo de objeto (por ejemplo, DATABASE, TABLE, WAREHOUSE), <nombre_del_objeto> con el nombre del objeto y <nombre_del_rol> con el rol al que está otorgando o revocando privilegios. Luego, otorga el rol al usuario.

OTORGAR ROL <nombre_rol> A USUARIO <nombre_usuario>;

Los tipos de objetos típicos incluyen: DATABASE (BASE DE DATOS), SCHEMA (ESQUEMA), TABLE (TABLA), VIEW (VISTA), WAREHOUSE (ALMACÉN DE DATOS), etc. Los roles son fundamentales para gestionar los permisos. Se otorgan privilegios a los roles y luego se asignan roles a los usuarios.

21. ¿Cuál es la diferencia entre autenticación y autorización en Snowflake?

La autenticación verifica quién eres, mientras que la autorización determina qué se te permite hacer. La autenticación confirma tu identidad, normalmente a través de nombre de usuario/contraseña u otras credenciales. Snowflake admite varios métodos de autenticación como nombre de usuario/contraseña, MFA (autenticación multifactor), OAuth y autenticación de par de claves.

La autorización, por otro lado, ocurre después de una autenticación correcta. Rige tus derechos de acceso dentro de Snowflake. Por ejemplo, incluso después de haber iniciado sesión (autenticado), es posible que solo estés autorizado a leer datos de ciertas tablas, pero no de otras. Los roles y los privilegios son fundamentales para la autorización en Snowflake; los roles reciben privilegios y los usuarios se asignan a roles. Esto determina qué acciones pueden realizar los usuarios en los objetos de Snowflake.

22. ¿Cuáles son algunas de las mejores prácticas de seguridad que debes seguir cuando trabajas con Snowflake?

Al trabajar con Snowflake, las mejores prácticas de seguridad giran en torno al control de acceso, la protección de datos y la seguridad de la red. Las prácticas clave incluyen: el uso de autenticación multifactor (MFA) para todas las cuentas de usuario, la rotación regular de claves y secretos, y la implementación de políticas de contraseñas seguras. Utilice políticas de red para restringir el acceso a Snowflake según la dirección IP, y aproveche funciones como el enmascaramiento de datos y el cifrado (tanto en reposo como en tránsito) para proteger la información confidencial.

Además, aplique el control de acceso basado en roles (RBAC) para otorgar a los usuarios solo los permisos necesarios, supervise la actividad de los usuarios y los registros de auditoría en busca de comportamientos sospechosos, y mantenga el software cliente de Snowflake actualizado con los últimos parches de seguridad. Asegure los procesos de carga de datos, valide las entradas de datos y tenga en cuenta las posibles vulnerabilidades de inyección SQL al construir consultas. Revise y actualice periódicamente las configuraciones de seguridad para adaptarse a las amenazas en evolución y a las mejores prácticas de seguridad.

23. Explique qué significa la gobernanza de datos para usted.

La gobernanza de datos, para mí, es la gestión general de la disponibilidad, usabilidad, integridad y seguridad de los datos de una organización. Define quién puede realizar qué acción, sobre qué datos, en qué situaciones. Se trata de establecer políticas y procedimientos para garantizar que los datos sean precisos, consistentes, confiables y protegidos a lo largo de su ciclo de vida.

El objetivo de la gobernanza de datos es permitir una mejor toma de decisiones, mejorar la eficiencia operativa, reducir los riesgos y cumplir con los requisitos reglamentarios. Los aspectos clave incluyen la definición de la propiedad de los datos, el establecimiento de estándares de calidad de datos, el establecimiento de protocolos de seguridad de datos y la implementación de controles de acceso a datos. En última instancia, una buena gobernanza de datos garantiza que los datos sean un activo valioso y no una responsabilidad.

24. ¿Qué herramientas puede utilizar para monitorear el rendimiento y el uso de Snowflake?

Snowflake proporciona varias herramientas para monitorear el rendimiento y el uso. La herramienta principal es la interfaz web de Snowflake, que ofrece una interfaz fácil de usar para ver el historial de consultas, la utilización de recursos y la actividad del almacén de datos. También puede utilizar comandos SQL para consultar los metadatos y las tablas del sistema de Snowflake para obtener información detallada sobre el rendimiento de las consultas, el uso del almacenamiento y los costos de transferencia de datos.

Otras opciones incluyen el uso de la API REST de Snowflake para recuperar programáticamente datos de monitoreo para la integración con sistemas de monitoreo externos como Datadog, New Relic o Splunk. Estas herramientas de terceros a menudo proporcionan capacidades de visualización y alerta más avanzadas.

25. ¿Cómo maneja Snowflake la concurrencia y evita conflictos de datos?

Snowflake maneja la concurrencia utilizando su arquitectura de control de concurrencia de múltiples versiones (MVCC). Cada consulta ve una instantánea consistente de los datos a partir de la hora de inicio de la consulta. Esto elimina la necesidad de bloqueos de lectura, lo que permite que múltiples consultas lean los mismos datos de forma concurrente sin bloquearse entre sí ni experimentar conflictos de datos.

Las actualizaciones y eliminaciones en Snowflake se manejan a través de un mecanismo de copia al escribir. Cuando se modifican los datos, Snowflake crea nuevas micro-particiones con los datos actualizados, dejando las micro-particiones originales sin cambios. Luego, los metadatos se actualizan para apuntar a las nuevas micro-particiones para consultas posteriores. Esto garantiza que las consultas concurrentes continúen viendo la instantánea consistente desde que comenzaron, evitando conflictos de datos y manteniendo la integridad de los datos.

26. ¿Cuál es el propósito de los stages de Snowflake?

Los stages de Snowflake se utilizan para almacenar y gestionar archivos de datos que desea cargar o descargar desde Snowflake. Actúan como un puntero a una ubicación donde residen sus archivos de datos, ya sea una ubicación interna de Snowflake o un servicio de almacenamiento en la nube externo como AWS S3, Azure Blob Storage o Google Cloud Storage.

Esencialmente, los stages simplifican el proceso de carga y descarga masiva de datos al proporcionar una forma centralizada y segura de acceder a sus archivos. Ofrecen características como el cifrado automático de datos, la definición del formato de archivo y la compresión de datos, que agilizan el proceso de transferencia de datos y mejoran la eficiencia. Puede pensar en los stages como un sistema de archivos virtual al que Snowflake accede para la ingestión y extracción de datos.

27. ¿Cómo describiría la diferencia entre los stages internos y externos?

Los stages internos en Snowflake almacenan datos dentro del almacenamiento administrado de Snowflake, ofreciendo simplicidad y rendimiento. Los datos almacenados aquí se cifran y gestionan automáticamente por Snowflake. Los stages externos, por otro lado, apuntan a datos almacenados en servicios de almacenamiento en la nube externos como AWS S3, Azure Blob Storage o Google Cloud Storage.

La diferencia clave radica en la propiedad y gestión de los datos. Con los stages internos, Snowflake se encarga de todo. Con los stages externos, usted gestiona el almacenamiento y los permisos de acceso en su cuenta de almacenamiento en la nube, mientras que Snowflake accede a los datos en función de las credenciales que proporciona. Los stages externos son útiles para aprovechar el almacenamiento en la nube existente y compartir datos con sistemas fuera de Snowflake.

28. ¿Cómo puede automatizar tareas en Snowflake, como la carga de datos o las copias de seguridad?

Snowflake proporciona varias opciones para automatizar tareas como la carga de datos y las copias de seguridad. Estas incluyen:

- Tareas de Snowflake: Son sentencias SQL programadas que pueden automatizar la carga de datos, la transformación y otras operaciones DML. Puede definir dependencias entre tareas para crear flujos de trabajo complejos.

- Snowpipe: Para la ingesta continua de datos desde el almacenamiento en la nube, Snowpipe carga automáticamente los datos tan pronto como están disponibles en la etapa definida.

- Herramientas de orquestación externas: Herramientas como Airflow, dbt u otras herramientas ETL pueden conectarse a Snowflake y orquestar pipelines de datos complejos, incluyendo la carga, la transformación y las copias de seguridad. También puede usar servicios de proveedores de la nube como AWS Step Functions o Azure Data Factory para la orquestación del flujo de trabajo.

29. ¿Cuáles son algunos de los desafíos comunes que podría encontrar al trabajar con Snowflake y cómo los abordaría?

Algunos desafíos comunes encontrados con Snowflake incluyen la gestión de costos, la optimización del rendimiento de las consultas y el manejo de la gobernanza/seguridad de los datos. Para abordar la gestión de costos, monitorearía proactivamente la utilización de recursos utilizando las herramientas integradas de Snowflake, implementaría estrategias apropiadas de dimensionamiento y escalado de almacenes y aprovecharía funciones como la suspensión automática y la reanudación automática. Para el rendimiento de las consultas, analizaría los planes de ejecución de las consultas utilizando EXPLICAR, optimizaría las estructuras de las tablas utilizando claves de agrupación y garantizaría la indexación adecuada cuando corresponda. Con respecto a la gobernanza de los datos, implementaría controles de acceso sólidos utilizando roles y permisos, aplicaría políticas de enmascaramiento y cifrado de datos y utilizaría las funciones de linaje de datos de Snowflake para rastrear la procedencia de los datos. La documentación adecuada es clave para garantizar que todos sigan estas mejores prácticas. Otros desafíos comunes incluyen la comprensión de las capacidades de datos semiestructurados de Snowflake. SELECT $1:nombre_campo FROM tabla; es un ejemplo de consulta útil para extraer datos de las columnas VARIANT y requiere una cuidadosa consideración.

Preguntas de entrevista intermedias de Snowflake

1. ¿Cómo se puede optimizar una consulta de ejecución lenta en Snowflake?

Para optimizar una consulta de ejecución lenta en Snowflake, se pueden emplear varias estrategias. Primero, analice el perfil de la consulta en la interfaz web de Snowflake para identificar cuellos de botella (por ejemplo, escaneos completos de tablas, vertido excesivo al disco). Luego, considere lo siguiente:

- Optimizar la estructura de la tabla: Asegúrese de que se definan claves de clúster apropiadas para las columnas consultadas con frecuencia. Considere el uso de vistas materializadas para el cálculo previo de agregaciones o uniones complejas.

- Optimizar la estructura de la consulta: Reescriba la consulta para aprovechar las uniones en lugar de las subconsultas

INcuando sea posible. UseEXISTSen lugar deCOUNT(*)si solo necesita verificar la existencia de filas. Limite la cantidad de datos que se escanean, posiblemente utilizando particiones o técnicas de poda de datos. Use la cláusulaQUALIFYpara filtrar los resultados basándose en los cálculos de la función de ventana en lugar de hacerlo con subconsultas. - Aumentar el tamaño del almacén de datos: Aumentar temporalmente el tamaño del almacén de datos virtual puede proporcionar más recursos de cómputo para ejecutar la consulta más rápido, especialmente para conjuntos de datos grandes. Sin embargo, esto debe considerarse después de optimizar la consulta en sí. Además, asegúrese de que el tamaño adecuado del almacén de datos esté configurado para que sea óptimo en cuanto a costos y rendimiento.

2. Describa los diferentes tipos de cachés de Snowflake y cómo mejoran el rendimiento.

Snowflake utiliza varias capas de almacenamiento en caché para optimizar el rendimiento de las consultas. Estas cachés reducen significativamente la necesidad de obtener datos directamente del almacenamiento en la nube subyacente, lo que mejora la velocidad y reduce los costos.

Los diferentes tipos de cachés de Snowflake incluyen:

- Caché de metadatos: Esta caché almacena metadatos sobre tablas y micro-particiones (metadatos de archivos, estadísticas, etc.). Es crucial para la optimización de consultas porque Snowflake usa los metadatos para determinar qué micro-particiones deben escanearse para una consulta dada.

- Caché de resultados de consultas: Snowflake almacena en caché automáticamente los resultados de las consultas. Si la misma consulta se ejecuta de nuevo, y los datos subyacentes no han cambiado, Snowflake puede devolver los resultados directamente desde la caché, proporcionando tiempos de respuesta extremadamente rápidos. Esta caché está disponible en todos los almacenes de datos virtuales. Es importante tener en cuenta que incluso un pequeño cambio no activará un acierto de la caché de resultados.

- Caché de disco local del almacén de datos virtual: Cada almacén de datos virtual tiene una caché de disco local que almacena datos recuperados del almacenamiento en la nube. Esta caché reside en los propios nodos de cómputo. Si se necesitan datos para una consulta, Snowflake primero verifica la caché de disco local. Si los datos están presentes (un acierto de caché), se pueden recuperar mucho más rápido que leerlos desde el almacenamiento en la nube.

3. ¿Cuáles son las ventajas y desventajas de usar una vista materializada en Snowflake?

Las vistas materializadas en Snowflake ofrecen ventajas significativas, principalmente una mejora en el rendimiento de las consultas. Precalculan y almacenan los resultados de una consulta, por lo que las consultas idénticas posteriores pueden recuperar datos directamente de la vista materializada en lugar de volver a ejecutar la consulta original. Esto puede conducir a ganancias sustanciales en el rendimiento, especialmente para agregaciones o uniones complejas. Otras ventajas incluyen una lógica de consulta simplificada para los usuarios finales y un posible ahorro de costos al reducir el uso de recursos de cómputo.

Sin embargo, las vistas materializadas también tienen desventajas. Consumen espacio de almacenamiento, ya que almacenan una copia de los datos. Requieren mantenimiento; Snowflake las actualiza automáticamente cuando cambian los datos subyacentes, lo que consume recursos de cómputo y puede generar costos. La frecuencia de actualización puede afectar la obsolescencia de los datos, lo que significa que los datos en la vista materializada no siempre pueden estar perfectamente actualizados. Además, existen limitaciones en los tipos de consultas que se pueden usar para definir vistas materializadas (por ejemplo, sin la cláusula QUALIFY).

4. Explique la diferencia entre escalar verticalmente y escalar horizontalmente en Snowflake y cuándo usaría cada una.

Escalar verticalmente (escalado vertical) en Snowflake significa aumentar el tamaño de su almacén virtual. Usted elige un tamaño de almacén más grande (por ejemplo, de X-Small a Small, Medium, Large, etc.). Esto proporciona más recursos de cómputo (CPU, memoria) a una única unidad de procesamiento. Usaría el escalado vertical cuando necesite mejorar el rendimiento de consultas individuales, especialmente aquellas complejas que están limitadas por restricciones de recursos. Es adecuado cuando necesita resultados más rápidos y puede tolerar una breve interrupción para cambiar el tamaño del almacén. Sin embargo, tiene un límite en cuán grande puede escalar un solo almacén.

Escalar horizontalmente (escalado horizontal) en Snowflake implica agregar más almacenes virtuales. En lugar de un almacén grande, tiene múltiples almacenes más pequeños o de tamaño mediano que se ejecutan simultáneamente. Esto se logra a menudo a través de almacenes multi-cluster. El escalado horizontal es ideal cuando tiene un alto volumen de consultas concurrentes, cada una de las cuales puede no ser particularmente intensiva en recursos por sí sola. Le permite manejar más usuarios y cargas de trabajo sin afectar significativamente el rendimiento de las consultas individuales. Proporciona concurrencia y maneja mejor los picos de demanda. Considere el escalado horizontal cuando desee mejorar el rendimiento general del sistema y reducir la cola de espera para los usuarios, o cuando necesite aislar las cargas de trabajo asignando almacenes dedicados a diferentes usuarios o procesos. El escalado horizontal evita los límites de un solo punto de contención que se encuentran con el escalado vertical.

5. ¿Cómo implementaría la seguridad a nivel de fila en Snowflake para restringir el acceso a los datos en función de los roles de usuario?

La seguridad a nivel de fila (RLS) en Snowflake se puede implementar utilizando políticas de seguridad y mapeo de roles de usuario. Primero, se define una política de seguridad que contiene una expresión booleana que determina qué filas puede ver un usuario. Esta expresión típicamente usa la función CURRENT_ROLE() o CURRENT_USER() para comparar el rol o nombre de usuario del usuario con una columna en la tabla (a menudo una identificación de usuario o identificación de departamento).

Luego, aplica la política de seguridad a la tabla usando el comando ALTER TABLE. Cuando un usuario consulta la tabla, Snowflake aplica automáticamente la política de seguridad, filtrando los resultados en función del rol del usuario y la expresión de la política. Por ejemplo:

CREATE OR REPLACE SECURITY POLICY my_policy AS ( department VARCHAR ) RETURNS BOOLEAN -> CURRENT_ROLE() = 'ACCOUNTADMIN' OR CURRENT_ROLE() = department; ALTER TABLE my_table ADD ROW ACCESS POLICY my_policy ON (department);

6. ¿Cuáles son las diferentes opciones de carga de datos en Snowflake y cuándo elegiría cada una?

- **COPIAR EN [**Esta es la opción más común y versátil. Carga datos de archivos en stages (internos o externos) en tablas de Snowflake. Ideal para la carga por lotes, la transformación durante la carga y el manejo de varios formatos de archivo (CSV, JSON, Parquet, etc.). Elija esto cuando tenga datos en archivos y necesite un proceso de carga confiable y configurable.

- Snowpipe: Para la ingestión continua de datos, Snowpipe automatiza el proceso de carga tan pronto como nuevos archivos de datos están disponibles en un stage. Lo mejor para la carga casi en tiempo real, como la transmisión de datos o archivos actualizados con frecuencia. Utiliza notificaciones de eventos (por ejemplo, del almacenamiento en la nube) para activar la carga de datos.

- Carga de datos usando conectores/controladores (JDBC/ODBC/Snowflake Connector para Python): Estos permiten cargar datos directamente desde aplicaciones o scripts. Útil para la carga programática, la integración con herramientas ETL o cargas de datos más pequeñas.

- Interfaz de usuario web: La interfaz web de Snowflake ofrece una capacidad limitada de carga de datos adecuada para la carga desde un solo archivo. Útil para la carga ad-hoc o para experimentar con conjuntos de datos pequeños.

7. Describa el proceso de clonación de una base de datos o esquema de Snowflake y sus casos de uso.

La clonación en Snowflake crea una réplica sin copia de una base de datos, esquema o tabla en un momento específico en el tiempo. Es una operación de metadatos, por lo que es rápida y no consume almacenamiento adicional hasta que se realizan cambios en el clon. La sintaxis básica es CREATE {DATABASE | SCHEMA | TABLE} <nombre_objeto> CLONE <nombre_objeto_fuente>;.

Los casos de uso incluyen: crear entornos de desarrollo/prueba a partir de datos de producción sin afectar el rendimiento o los costos de almacenamiento; hacer copias de seguridad de datos en un punto específico en el tiempo para la recuperación ante desastres; habilitar el intercambio de datos sin copiar; y facilitar la experimentación al permitir modificaciones en un conjunto de datos clonado sin afectar el original.

8. Explique cómo usar la función Time Travel de Snowflake para recuperar datos eliminados accidentalmente.

Time Travel de Snowflake te permite acceder a datos históricos en cualquier momento dentro de un período definido. Para recuperar datos eliminados accidentalmente, puedes usar el comando UNDROP si la tabla fue eliminada. Por ejemplo, UNDROP TABLE my_table; restauraría la tabla si está dentro del período de retención de Time Travel (el valor predeterminado es 1 día, puede ser hasta 90 días para la Edición Enterprise). Si los datos dentro de la tabla fueron eliminados, puedes crear un clon de la tabla en un momento anterior a la eliminación usando las cláusulas AT o BEFORE en una declaración CREATE TABLE ... CLONE. Por ejemplo: CREATE TABLE my_table_restore CLONE my_table AT(timestamp => 'AAAA-MM-DD HH24:MI:SS'); Luego inserta los datos recuperados de nuevo en la tabla original.

9. ¿Cómo puedes monitorear el consumo de recursos de Snowflake e identificar oportunidades de optimización de costos?

Snowflake proporciona varias formas de monitorear el consumo de recursos e identificar oportunidades de optimización de costos. Las herramientas principales incluyen la interfaz web de Snowflake (Snowsight), consultas SQL contra las tablas de metadatos de Snowflake (ACCOUNT_USAGE y ORGANIZATION_USAGE) y soluciones de monitoreo de socios.

Para monitorizar el uso de recursos, puede utilizar los paneles de Snowsight para visualizar los costos de cómputo y almacenamiento a lo largo del tiempo, desglosados por almacén, base de datos, usuario y otras dimensiones. Las consultas SQL contra las vistas WAREHOUSE_METERING_HISTORY, DATABASE_STORAGE_USAGE_HISTORY y otras vistas ACCOUNT_USAGE permiten un análisis más granular. También puede identificar consultas ineficientes utilizando la vista QUERY_HISTORY. Las estrategias de optimización de costos implican el dimensionamiento adecuado de los almacenes, la optimización del rendimiento de las consultas (reducción del tiempo de ejecución de las consultas), el aprovechamiento del almacenamiento en caché, el establecimiento de períodos de retención de datos apropiados y la automatización de la suspensión/reanudación del almacén. El uso inteligente de funciones como las vistas materializadas y el servicio de optimización de búsqueda también puede contribuir al ahorro de costos.

10. Describa el propósito de las etapas de Snowflake y cómo se utilizan para la carga y descarga de datos.

Las etapas de Snowflake son ubicaciones de almacenamiento donde se almacenan los archivos de datos para cargarlos en o descargarlos de las tablas de Snowflake. Actúan como áreas intermedias para la transferencia de datos. Hay dos tipos principales de etapas: etapas internas (gestionadas por Snowflake) y etapas externas (vinculadas a almacenamiento en la nube externo como AWS S3, Azure Blob Storage o Google Cloud Storage).

Las etapas se utilizan para agilizar los procesos de carga y descarga de datos. Para la carga, los archivos de datos se cargan primero en una etapa, y luego se utiliza el comando COPY INTO para cargar los datos de la etapa en una tabla de Snowflake. Para la descarga, el comando COPY INTO se utiliza para descargar datos de una tabla de Snowflake en archivos de datos en una etapa. A partir de ahí, los archivos se pueden descargar.

11. Explique la diferencia entre las ediciones estándar y enterprise de Snowflake, y qué características se incluyen en cada una.

Snowflake ofrece varias ediciones con diferentes características y precios. La edición Estándar proporciona funciones principales como almacenamiento de datos, seguridad estándar y optimización básica del rendimiento. La edición Enterprise se basa en la Estándar agregando funciones de seguridad avanzadas (por ejemplo, cumplimiento de HIPAA, gestión de claves), capacidades de rendimiento mejoradas (por ejemplo, vistas materializadas) y un soporte más completo. Funciones como Time Travel (para la recuperación de datos) tienen períodos de retención más largos en Enterprise.

En esencia, la edición Estándar es adecuada para necesidades básicas de almacenamiento de datos, mientras que Enterprise se adapta a organizaciones que requieren mayor seguridad, rendimiento y capacidades de gobernanza.

12. ¿Cómo se gestionan los datos semiestructurados como JSON en Snowflake y cuáles son los beneficios de usar el soporte nativo de JSON de Snowflake?

Snowflake gestiona datos semiestructurados como JSON utilizando el tipo de datos VARIANT. Puede cargar datos JSON directamente en una columna VARIANT. Snowflake ofrece funciones para analizar y consultar JSON, como GET, GET_PATH y FLATTEN. Estas funciones le permiten extraer elementos específicos de la estructura JSON. Por ejemplo, SELECT GET(json_column, 'name') from table_name. Snowflake analiza automáticamente los datos JSON durante la ejecución de la consulta, sin requerir un esquema predefinido. Esta capacidad de esquema en lectura es un beneficio clave.

Los beneficios del soporte nativo de JSON de Snowflake incluyen flexibilidad en el manejo de estructuras de datos en evolución, carga de datos simplificada sin transformación previa y potentes capacidades de consulta con funciones específicas de JSON. También permite el almacenamiento y la recuperación eficientes de datos JSON dentro del data warehouse de Snowflake, aprovechando el rendimiento y la escalabilidad de Snowflake.

13. ¿Cuáles son las mejores prácticas para diseñar e implementar esquemas y tablas de Snowflake para un rendimiento óptimo?

Al diseñar esquemas y tablas de Snowflake para un rendimiento óptimo, concéntrese en la organización de datos y la eficiencia de las consultas. Las mejores prácticas clave incluyen el uso de tipos de datos apropiados, el aprovechamiento de claves de clúster para columnas filtradas con frecuencia y el empleo de estrategias de partición para tablas grandes (aunque la micro-partición de Snowflake maneja gran parte de esto automáticamente). Optimice para esquemas de estrella o copo de nieve cuando sea apropiado, usando tablas de dimensiones para atributos descriptivos y tablas de hechos para datos transaccionales.

Además, considere el uso de tipos de tabla apropiados (transitorios o temporales) en función de los requisitos de retención de datos. Analice periódicamente el rendimiento de las consultas utilizando las herramientas de perfilado de consultas de Snowflake e identifique las operaciones costosas. Optimice las consultas SQL minimizando la cantidad de datos escaneados (usando cláusulas WHERE y evitando SELECT *), aprovechando las vistas materializadas para agregaciones complejas y considerando sugerencias de consulta cuando sea necesario. Mantenga estadísticas regularmente para las tablas y considere técnicas de compresión de datos para mejorar la eficiencia del almacenamiento y el rendimiento de las consultas.

14. Explique cómo utilizar las funciones externas de Snowflake para integrarse con otros servicios o aplicaciones en la nube.

Las funciones externas de Snowflake le permiten llamar a código que se ejecuta fuera de Snowflake, como en AWS Lambda, Azure Functions o Google Cloud Functions, integrándose efectivamente con otros servicios o aplicaciones en la nube. Define una función externa en Snowflake que apunta al servicio remoto. Cuando la función externa se llama dentro de una declaración SQL, Snowflake envía los datos al servicio remoto, que los procesa y devuelve el resultado a Snowflake.

Por ejemplo, digamos que desea utilizar una API de análisis de sentimientos. Crearía una función externa en Snowflake que especifique el punto final de la API. Luego, llamaría a esta función en una consulta, pasando el texto para el análisis como entrada. La API devolvería la puntuación del sentimiento, que Snowflake luego incluiría en los resultados de la consulta. CREATE EXTERNAL FUNCTION my_sentiment_analysis(text VARCHAR) RETURNS VARCHAR LANGUAGE PYTHON AS $$ <handler_code> $$ API_INTEGRATION = my_api_integration;

15. ¿Cómo configuraría el intercambio de datos entre cuentas de Snowflake y cuáles son las consideraciones de seguridad involucradas?

Para configurar el intercambio de datos entre cuentas de Snowflake, utilizaría la función de intercambio de datos seguro de Snowflake. Una cuenta proveedora crea un "share" (compartición), otorga acceso a objetos de base de datos específicos (tablas, vistas, etc.) y luego otorga privilegios de uso sobre el "share" a una o más cuentas consumidoras. Las cuentas consumidoras pueden entonces crear una base de datos a partir del "share", que actúa como una referencia de solo lectura a los datos del proveedor. No se copia ni se mueve ningún dato, lo que garantiza un acceso casi en tiempo real.

Las consideraciones de seguridad incluyen: control de acceso (otorgando los privilegios mínimos necesarios), enmascaramiento de datos (protegiendo la información confidencial), seguridad a nivel de fila (limitando la visibilidad de los datos en función de los roles de usuario) y monitoreo (auditando los patrones de acceso). Es crucial asegurarse de que los datos compartidos no violen ninguna regulación de cumplimiento (por ejemplo, GDPR, HIPAA). La cuenta proveedora es responsable de la seguridad de los datos subyacentes, mientras que la cuenta consumidora es responsable de asegurar el acceso a la base de datos compartida.

16. Describe el proceso de configuración y gestión de cuentas de usuario y roles de Snowflake.

La configuración y gestión de cuentas de usuario y roles de Snowflake implica varios pasos. Primero, cree cuentas de usuario utilizando el comando CREATE USER, especificando propiedades como nombre de usuario, contraseña y rol predeterminado. Por ejemplo: CREATE USER <nombre_de_usuario> PASSWORD='<contraseña>' DEFAULT_ROLE = <nombre_de_rol>;. Luego, defina roles usando el comando CREATE ROLE para agrupar privilegios. Conceda privilegios a los roles usando GRANT <privilegio> ON <objeto> TO ROLE <nombre_de_rol>; que define qué acciones pueden realizar los roles en los objetos de la base de datos.

Para administrar usuarios, puede otorgar roles a los usuarios usando el comando GRANT ROLE <nombre_de_rol> TO USER <nombre_de_usuario>;. Los usuarios heredan los privilegios asociados con los roles que se les otorgan. También puede usar SHOW USERS y SHOW ROLES para ver los usuarios y roles existentes, respectivamente. La revocación de privilegios o roles se puede hacer usando comandos REVOKE similares a la sintaxis GRANT, asegurando la seguridad y el control de acceso. La gestión de usuarios también se puede automatizar a través de scripts y tuberías de CI/CD para Infraestructura como Código (IaC).

17. Explique cómo usar las funciones de enmascaramiento de datos de Snowflake para proteger datos confidenciales.