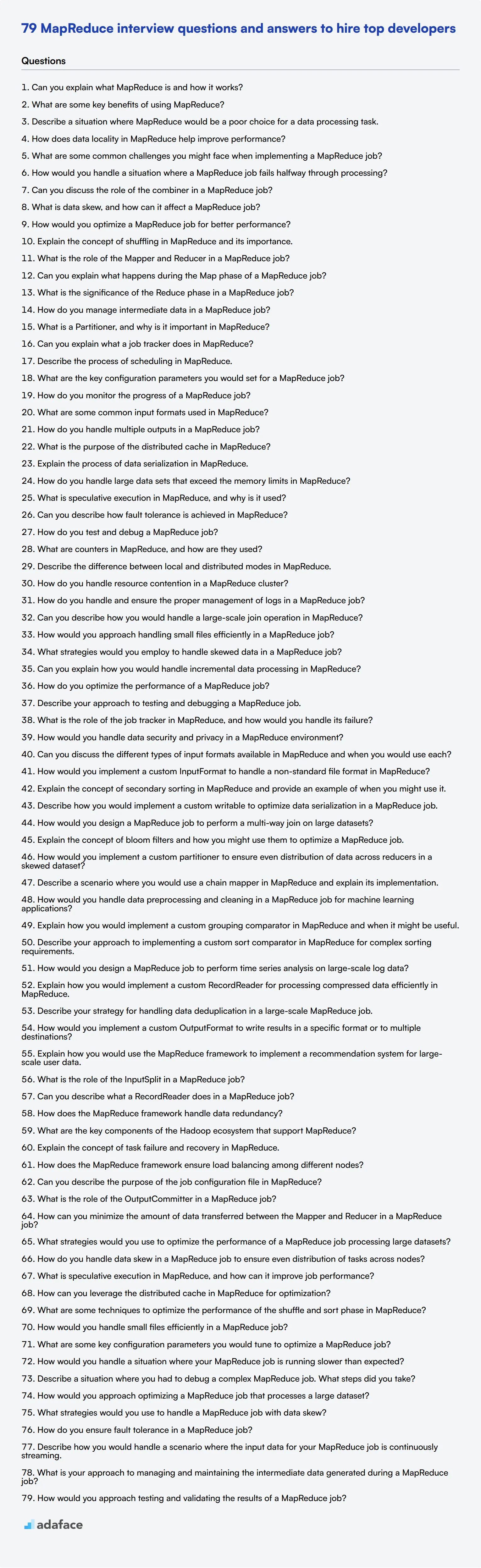

79 preguntas y respuestas de la entrevista de MapReduce para contratar a los mejores desarrolladores

Contratar a desarrolladores expertos en MapReduce es crucial para las organizaciones que se ocupan del procesamiento y análisis de big data. Las entrevistas efectivas ayudan a identificar a los candidatos que poseen no solo conocimientos teóricos, sino también experiencia práctica en la implementación de paradigmas de MapReduce.

Esta publicación de blog proporciona una lista completa de preguntas de entrevista sobre MapReduce, que van desde niveles básicos hasta avanzados. Hemos categorizado las preguntas para ayudarle a evaluar a los candidatos en diferentes niveles de experiencia, cubriendo definiciones técnicas, técnicas de optimización y escenarios del mundo real.

Al usar estas preguntas, puede evaluar eficazmente la experiencia y las habilidades de resolución de problemas de MapReduce de un candidato. Considere complementar su proceso de entrevista con una prueba de habilidades de MapReduce para obtener una evaluación completa de los posibles empleados.

Tabla de contenidos

10 preguntas y respuestas básicas de la entrevista de MapReduce para evaluar a los solicitantes

20 preguntas de la entrevista de MapReduce para hacer a los desarrolladores junior

10 preguntas y respuestas intermedias de la entrevista de MapReduce para hacer a los desarrolladores de nivel medio

15 preguntas avanzadas de la entrevista de MapReduce para hacer a los desarrolladores senior

8 preguntas y respuestas de la entrevista de MapReduce relacionadas con definiciones técnicas

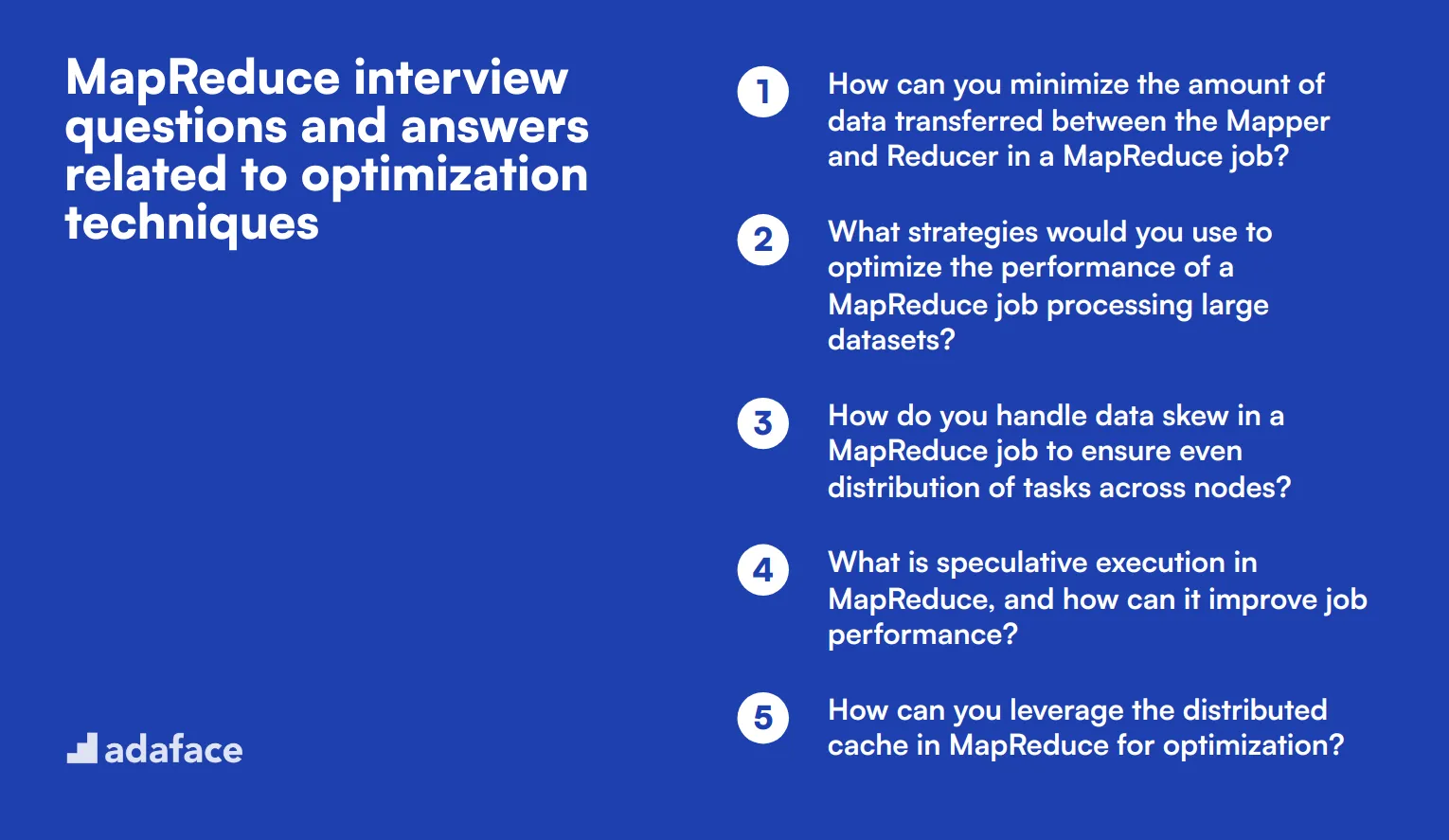

8 preguntas y respuestas de la entrevista de MapReduce relacionadas con técnicas de optimización

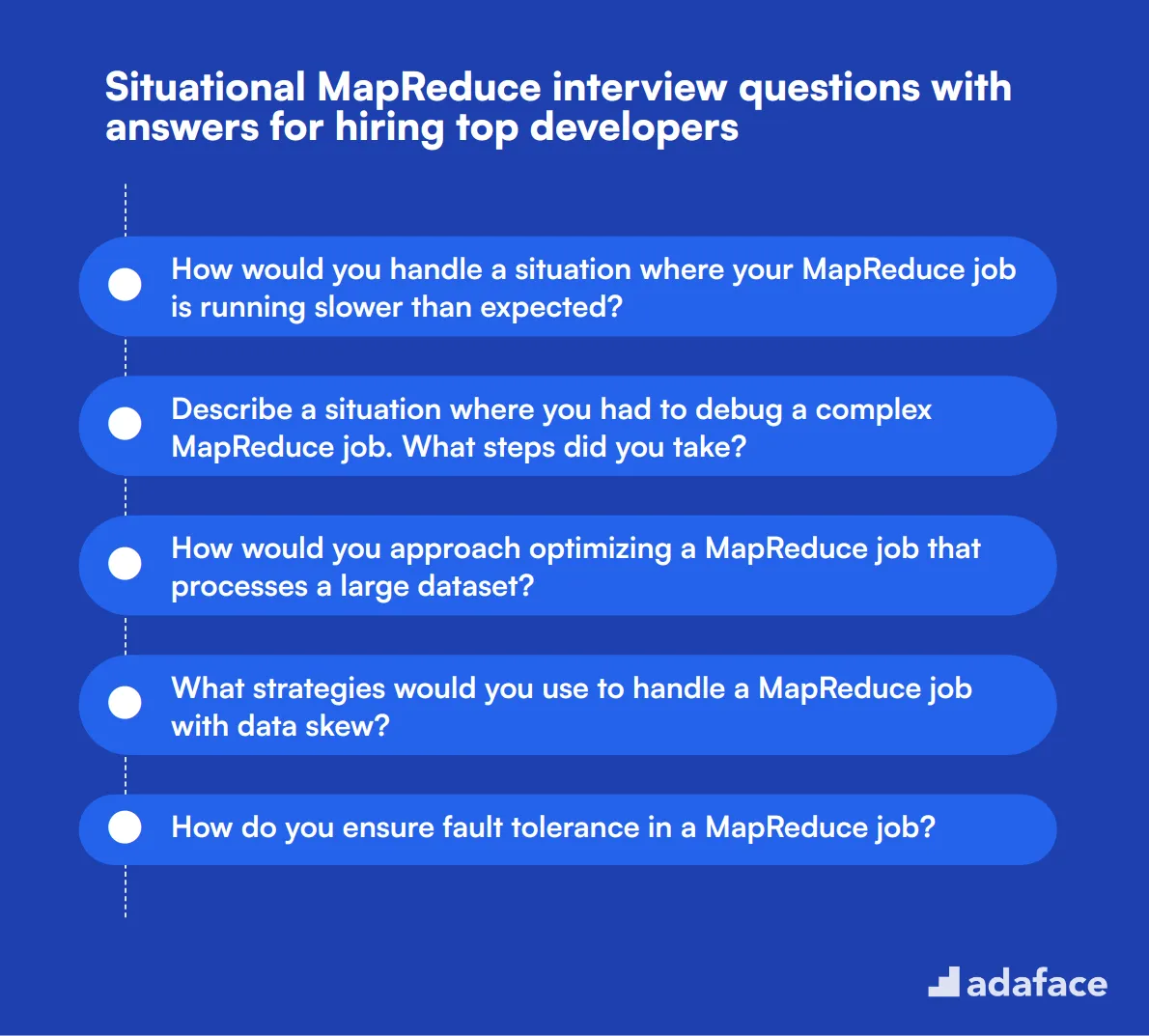

8 preguntas situacionales de la entrevista de MapReduce con respuestas para contratar a los mejores desarrolladores

¿Qué habilidades de MapReduce debe evaluar durante la fase de la entrevista?

3 consejos para usar eficazmente las preguntas de la entrevista de MapReduce

Use las preguntas de la entrevista de MapReduce y las pruebas de habilidades para contratar a desarrolladores talentosos

Descargue la plantilla de preguntas de la entrevista de MapReduce en múltiples formatos

10 preguntas y respuestas básicas de la entrevista de MapReduce para evaluar a los solicitantes

Para determinar si tus solicitantes tienen una sólida comprensión de los conceptos de MapReduce, utiliza estas 10 preguntas esenciales para la entrevista. Te ayudarán a evaluar si los candidatos entienden los principios clave y pueden aplicarlos a escenarios del mundo real.

1. ¿Puedes explicar qué es MapReduce y cómo funciona?

MapReduce es un modelo de programación utilizado para procesar grandes conjuntos de datos con un algoritmo distribuido en un clúster. Simplifica el procesamiento de datos dividiéndolo en dos funciones principales: la función Map, que procesa y filtra datos, y la función Reduce, que agrega los resultados.

Un candidato ideal debería ser capaz de explicar el flujo de datos a través de las etapas Map y Reduce, incluyendo la división de datos en fragmentos, la asignación de tareas a estos fragmentos, la mezcla y clasificación, y finalmente la reducción de la salida. Busca claridad en su explicación y su capacidad para relacionarla con aplicaciones prácticas.

2. ¿Cuáles son algunos beneficios clave de usar MapReduce?

MapReduce es altamente escalable y puede procesar petabytes de datos de manera eficiente. Distribuye la carga computacional entre muchas máquinas, haciéndolo tolerante a fallos y confiable. Además, abstrae la complejidad de la programación paralela, permitiendo a los desarrolladores centrarse en la lógica real de procesamiento de datos.

Los candidatos deben mencionar beneficios como escalabilidad, tolerancia a fallos y abstracción de procesos complejos. También deben ser capaces de proporcionar ejemplos de escenarios donde MapReduce es particularmente ventajoso, como el análisis de registros o la minería de datos a gran escala.

3. Describa una situación en la que MapReduce sería una mala elección para una tarea de procesamiento de datos.

MapReduce no es ideal para tareas de procesamiento de datos en tiempo real y de baja latencia o tareas que requieren un procesamiento iterativo extenso, como los algoritmos de aprendizaje automático. Su naturaleza de procesamiento por lotes puede introducir retrasos significativos.

Busque respuestas que destaquen las limitaciones de MapReduce, como su falta de idoneidad para el análisis en tiempo real, los cálculos iterativos o las tareas que requieren una comunicación compleja entre tareas. Una respuesta ideal también debe sugerir tecnologías alternativas, como Apache Spark, para estos escenarios.

4. ¿Cómo ayuda la localidad de datos en MapReduce a mejorar el rendimiento?

La localidad de datos se refiere al concepto de mover la computación más cerca de donde residen los datos, en lugar de transferir grandes volúmenes de datos a través de la red. Esto minimiza la congestión de la red y reduce el tiempo necesario para procesar los datos.

Los candidatos deben explicar que MapReduce optimiza el rendimiento ejecutando tareas de mapeo en los mismos nodos donde se almacenan los datos. Esto reduce la sobrecarga de la transferencia de datos y conduce a tiempos de procesamiento más rápidos. Las respuestas sólidas incluirán ejemplos de cómo la localidad de datos ha impactado positivamente el rendimiento en proyectos anteriores.

5. ¿Cuáles son algunos desafíos comunes que podría enfrentar al implementar un trabajo de MapReduce?

Los desafíos comunes incluyen la asimetría de datos, donde algunos nodos terminan procesando significativamente más datos que otros, lo que genera ineficiencias. La depuración de trabajos distribuidos también puede ser compleja, y la gestión de la sobrecarga de la mezcla y la clasificación de datos entre las etapas de mapeo y reducción puede ser intensiva en recursos.

Los candidatos deben mencionar estos desafíos y sugerir posibles soluciones, como la partición efectiva de los datos, el uso de combinadores para reducir la cantidad de datos mezclados y el empleo de herramientas de monitoreo para identificar cuellos de botella. Deben demostrar un enfoque de resolución de problemas y experiencia en la superación de estos obstáculos.

6. ¿Cómo manejaría una situación en la que un trabajo de MapReduce falla a la mitad del procesamiento?

Primero, revisaría los registros para identificar la causa raíz del fallo. Los problemas comunes pueden incluir fallas en los nodos de datos, memoria insuficiente o errores de codificación. Basado en el diagnóstico, tomaría las acciones apropiadas, como reasignar recursos, corregir problemas de código o reiniciar el trabajo desde el último punto de control.

El candidato debe explicar su proceso de depuración y mencionar cualquier herramienta o práctica que utilice para el monitoreo y la gestión de errores. Busque un enfoque estructurado para la resolución de problemas y su capacidad para aprender de los fallos para evitar futuros problemas.

7. ¿Puede discutir el papel del combinador en un trabajo de MapReduce?

Un combinador actúa como un mini-reductor que realiza una reducción local en el nodo de mapa antes de que los datos se envíen al reductor. Esto ayuda a minimizar el volumen de datos transferidos a través de la red, mejorando la eficiencia y el rendimiento general.

Los candidatos deben explicar cómo los combinadores reducen la transferencia de datos y proporcionar ejemplos de cuándo y cómo usarlos eficazmente. Busque una comprensión de las limitaciones y los escenarios correctos para aplicar los combinadores.

8. ¿Qué es la asimetría de datos y cómo puede afectar a un trabajo de MapReduce?

La asimetría de datos ocurre cuando la distribución de datos entre los nodos es desigual, lo que hace que algunos nodos manejen significativamente más datos que otros. Esto puede conducir a ineficiencias y tiempos de procesamiento más largos, ya que los nodos sobrecargados se convierten en cuellos de botella.

Los candidatos deben comprender el impacto de la asimetría de datos y sugerir estrategias para mitigarla, como el uso de particionadores personalizados, la optimización de la distribución de datos o el preprocesamiento de los datos para equilibrar la carga. Busque experiencia práctica en el manejo de la asimetría de datos y la capacidad de implementar soluciones efectivas.

9. ¿Cómo optimizaría un trabajo MapReduce para un mejor rendimiento?

Para optimizar un trabajo MapReduce, me centraría en la localidad de los datos, la partición eficiente de los datos y la minimización de la transferencia de datos. El uso de combinadores, la sintonización del número de tareas de mapa y reducción y el aprovechamiento de formatos de archivo apropiados (como Parquet o Avro) también pueden mejorar el rendimiento.

Los candidatos deben discutir varias técnicas de optimización y proporcionar ejemplos de cómo las han aplicado en proyectos anteriores. Busque una comprensión integral de los cuellos de botella de rendimiento y un enfoque proactivo de la optimización.

10. Explique el concepto de shuffling en MapReduce y su importancia.

Shuffling es el proceso de transferir datos de las tareas de mapa a las tareas de reducción en función de las claves intermedias. Es una fase crítica que implica ordenar y fusionar datos para garantizar que cada reductor reciba el conjunto correcto de datos intermedios.

Los candidatos deben explicar la importancia del shuffling en la agregación y clasificación de datos para la fase de reducción. Busque una comprensión de cómo el shuffling afecta el rendimiento y cómo gestionar su sobrecarga de manera efectiva. La experiencia con problemas relacionados con el shuffling y sus soluciones es una ventaja.

20 preguntas de entrevista de MapReduce para hacer a desarrolladores junior

Para identificar si los candidatos tienen el conocimiento fundamental adecuado en MapReduce, utilice estas preguntas de entrevista específicamente diseñadas para desarrolladores junior. Estas preguntas le ayudarán a evaluar sus habilidades técnicas y capacidades de resolución de problemas, asegurando que estén listos para roles como Desarrollador Hadoop.

- ¿Cuál es el papel del Mapper y del Reducer en un trabajo de MapReduce?

- ¿Puede explicar qué sucede durante la fase Map de un trabajo de MapReduce?

- ¿Cuál es la importancia de la fase Reduce en un trabajo de MapReduce?

- ¿Cómo se gestionan los datos intermedios en un trabajo de MapReduce?

- ¿Qué es un Particionador y por qué es importante en MapReduce?

- ¿Puede explicar qué hace un rastreador de trabajos en MapReduce?

- Describa el proceso de programación en MapReduce.

- ¿Cuáles son los parámetros de configuración clave que establecería para un trabajo de MapReduce?

- ¿Cómo se supervisa el progreso de un trabajo de MapReduce?

- ¿Cuáles son algunos formatos de entrada comunes utilizados en MapReduce?

- ¿Cómo se manejan múltiples salidas en un trabajo de MapReduce?

- ¿Cuál es el propósito de la caché distribuida en MapReduce?

- Explique el proceso de serialización de datos en MapReduce.

- ¿Cómo se manejan grandes conjuntos de datos que exceden los límites de memoria en MapReduce?

- ¿Qué es la ejecución especulativa en MapReduce y por qué se utiliza?

- ¿Puede describir cómo se logra la tolerancia a fallos en MapReduce?

- ¿Cómo se prueba y depura un trabajo de MapReduce?

- ¿Qué son los contadores en MapReduce y cómo se utilizan?

- Describa la diferencia entre los modos local y distribuido en MapReduce.

- ¿Cómo se gestiona la contención de recursos en un clúster MapReduce?

10 preguntas y respuestas intermedias sobre MapReduce para entrevistar a desarrolladores de nivel medio

Para determinar si sus candidatos tienen las habilidades adecuadas para abordar tareas intermedias de MapReduce, hágales algunas de estas preguntas. Esta lista está diseñada para ayudarle a evaluar la profundidad de su comprensión y su capacidad para superar los desafíos comunes que podrían enfrentar en un escenario del mundo real.

1. ¿Cómo gestiona y asegura la gestión adecuada de los registros en un trabajo MapReduce?

La gestión de registros en un trabajo MapReduce es crucial para la depuración y el monitoreo del rendimiento. Típicamente, los registros se almacenan en el sistema de archivos local de los nodos y se puede acceder a ellos utilizando la interfaz de usuario web de Hadoop o directamente desde los nodos.

Un candidato ideal debería explicar la importancia de interpretar tanto los registros de errores como los registros de tareas para identificar problemas. También podrían hablar sobre el uso de funciones de agregación de registros o herramientas de terceros para optimizar la gestión de registros.

Qué buscar: Busque candidatos que entiendan la importancia práctica de los registros y puedan sugerir formas eficientes de gestionarlos e interpretarlos.

2. ¿Puede describir cómo manejaría una operación de unión a gran escala en MapReduce?

Una operación de unión a gran escala en MapReduce se puede gestionar utilizando diferentes estrategias, como la unión en el lado de reducción (Reduce-side join), la unión en el lado de mapa (Map-side join) o la unión de difusión (Broadcast join), más eficiente, dependiendo del tamaño y la distribución de los datos.

Los candidatos deben explicar los pros y los contras de cada método. Por ejemplo, una unión en el lado de reducción es más flexible pero menos eficiente debido al reordenamiento de los datos, mientras que una unión en el lado de mapa es más rápida pero requiere que un conjunto de datos sea lo suficientemente pequeño como para caber en la memoria.

Qué buscar: Busque una comprensión detallada de las técnicas de unión y los escenarios en los que cada una sería aplicable. Haga un seguimiento de su experiencia con casos de uso específicos.

3. ¿Cómo abordaría el manejo eficiente de archivos pequeños en un trabajo de MapReduce?

Los archivos pequeños pueden causar ineficiencias en un trabajo de MapReduce debido a la sobrecarga de la gestión de muchas tareas pequeñas. Un enfoque común es utilizar una herramienta como Hadoop Archive (HAR) o archivos de secuencia para combinar archivos pequeños en archivos más grandes.

Los candidatos también podrían mencionar el uso de un InputFormat personalizado para consolidar archivos pequeños durante la fase de Map o el aprovechamiento de herramientas como Apache HBase o Hive para una mejor gestión de archivos pequeños.

Qué buscar: Busque soluciones prácticas y una comprensión de las implicaciones de los archivos pequeños en el rendimiento. Los candidatos deben mostrar un enfoque proactivo para superar este problema común.

4. ¿Qué estrategias emplearía para manejar datos sesgados en un trabajo de MapReduce?

Manejar datos sesgados implica identificar el sesgo y luego aplicar estrategias para equilibrar la carga. Las técnicas incluyen la pre-división de los datos, el uso de particionadores personalizados o el reequilibrio de los datos entre nodos.

Los candidatos deben discutir cómo identificarían el sesgo de datos utilizando métricas y registros, y detallar su enfoque para mitigarlo, como el uso de un combinador o la modificación de la lógica de partición.

Qué buscar: Busque una comprensión integral de los problemas de sesgo de datos y estrategias prácticas para abordarlos. Deben demostrar familiaridad con las herramientas y métricas de monitoreo.

5. ¿Puede explicar cómo manejaría el procesamiento incremental de datos en MapReduce?

El procesamiento incremental de datos implica procesar solo los datos nuevos o actualizados desde la última ejecución del trabajo. Las técnicas incluyen el uso de marcas de tiempo, datos de versionamiento o el aprovechamiento de frameworks como Apache HBase para el procesamiento en tiempo real.

Un candidato ideal debe discutir la importancia del almacenamiento y la recuperación eficientes de datos para garantizar que solo se procesen los datos necesarios. También podrían mencionar el uso de herramientas como Apache Flume o Kafka para la ingestión de datos.

Qué buscar: Busque una comprensión de la importancia del procesamiento incremental en entornos de big data y enfoques prácticos para implementarlo.

6. ¿Cómo optimiza el rendimiento de un trabajo MapReduce?

Optimizar un trabajo MapReduce implica varias estrategias, como ajustar los parámetros de configuración (por ejemplo, asignación de memoria, número de reducers), usar combinadores y garantizar la localidad de los datos.

Los candidatos también deben hablar sobre la optimización de las propias funciones de map y reduce, posiblemente a través de la refactorización del código o el uso de estructuras de datos más eficientes. También podrían mencionar el uso de las herramientas de perfilado integradas de Hadoop.

Qué buscar: Busque un enfoque metódico para la optimización del rendimiento y experiencia con herramientas y técnicas específicas. Haga un seguimiento de su experiencia con cuellos de botella de rendimiento del mundo real.

7. Describa su enfoque para probar y depurar un trabajo MapReduce.

Probar y depurar un trabajo MapReduce generalmente implica pruebas unitarias de las funciones de map y reduce individuales, el uso de ejecutores de trabajo locales para pruebas a pequeña escala y el monitoreo de registros en busca de errores durante la ejecución del trabajo.

Los candidatos también deben discutir el uso de herramientas como Apache MRUnit para las pruebas y la interfaz de usuario web de Hadoop para monitorear el progreso del trabajo y la depuración. Podrían mencionar el uso de técnicas de muestreo para probar con subconjuntos de datos.

Qué buscar: Busque un enfoque sistemático de las pruebas y la depuración, y familiaridad con las herramientas que ayudan en estos procesos. Los candidatos deben enfatizar la importancia de las pruebas exhaustivas para garantizar la fiabilidad.

8. ¿Cuál es la función del rastreador de trabajos en MapReduce y cómo abordaría su fallo?

El rastreador de trabajos es responsable de administrar los recursos, programar los trabajos y monitorear su progreso en un clúster de MapReduce. Coordina entre el cliente, el nodo de nombre y los rastreadores de tareas.

Si el rastreador de trabajos falla, puede interrumpir todo el procesamiento del trabajo. Los candidatos deben discutir soluciones de alta disponibilidad, como el uso de un rastreador de trabajos secundario o el cambio a YARN, que separa la gestión de recursos y la programación de trabajos.

Qué buscar: Busque una comprensión clara de la función del rastreador de trabajos y soluciones prácticas para manejar su fallo. La experiencia con configuraciones de alta disponibilidad en Hadoop sería una ventaja.

9. ¿Cómo manejaría la seguridad y la privacidad de los datos en un entorno MapReduce?

La seguridad y la privacidad de los datos se pueden gestionar mediante el cifrado, el control de acceso y la auditoría. El cifrado de datos tanto en reposo como en tránsito, y el uso de Kerberos para la autenticación son prácticas comunes.

Los candidatos también deben mencionar la implementación de un control de acceso detallado utilizando Apache Ranger o Sentry, y el monitoreo del acceso y uso de datos a través de herramientas de auditoría.

Qué buscar: Busque un enfoque holístico de la seguridad que cubra el cifrado, la autenticación y la auditoría. La experiencia práctica con herramientas de seguridad en el ecosistema de Hadoop es deseable.

10. ¿Puede discutir los diferentes tipos de formatos de entrada disponibles en MapReduce y cuándo usaría cada uno?

MapReduce admite varios formatos de entrada como TextInputFormat, KeyValueTextInputFormat, SequenceFileInputFormat y otros. La elección depende de la fuente y la estructura de los datos.

Por ejemplo, TextInputFormat es adecuado para archivos de texto plano, mientras que SequenceFileInputFormat es ideal para datos binarios. KeyValueTextInputFormat se puede usar cuando tanto la clave como el valor deben analizarse del archivo de entrada.

Qué buscar: Busque una comprensión de los diferentes formatos de entrada y sus casos de uso apropiados. Los candidatos deben demostrar experiencia en la selección e implementación del formato de entrada más eficiente para tipos de datos dados.

15 preguntas avanzadas de entrevista de MapReduce para hacer a desarrolladores senior

Para evaluar las habilidades avanzadas de MapReduce de los desarrolladores senior, utilice estas 15 preguntas en profundidad. Están diseñadas para sondear un profundo conocimiento técnico y habilidades de resolución de problemas en escenarios complejos de MapReduce. Úselas para identificar a los candidatos de primer nivel que pueden abordar proyectos de big data desafiantes.

- ¿Cómo implementaría un InputFormat personalizado para manejar un formato de archivo no estándar en MapReduce?

- Explique el concepto de ordenamiento secundario en MapReduce y proporcione un ejemplo de cuándo podría usarlo.

- Describa cómo implementaría un writable personalizado para optimizar la serialización de datos en un trabajo de MapReduce.

- ¿Cómo diseñaría un trabajo de MapReduce para realizar una unión múltiple en conjuntos de datos grandes?

- Explique el concepto de filtros bloom y cómo podría usarlos para optimizar un trabajo de MapReduce.

- ¿Cómo implementaría un particionador personalizado para garantizar una distribución uniforme de los datos entre los reducers en un conjunto de datos sesgado?

- Describa un escenario donde usaría un mapeador encadenado en MapReduce y explique su implementación.

- ¿Cómo manejaría el preprocesamiento y la limpieza de datos en un trabajo de MapReduce para aplicaciones de aprendizaje automático?

- Explique cómo implementaría un comparador de agrupación personalizado en MapReduce y cuándo podría ser útil.

- Describa su enfoque para implementar un comparador de ordenamiento personalizado en MapReduce para requisitos de ordenamiento complejos.

- ¿Cómo diseñaría un trabajo de MapReduce para realizar análisis de series temporales en datos de registro a gran escala?

- Explique cómo implementaría un RecordReader personalizado para procesar datos comprimidos de manera eficiente en MapReduce.

- Describa su estrategia para manejar la deduplicación de datos en un trabajo de MapReduce a gran escala.

- ¿Cómo implementaría un OutputFormat personalizado para escribir resultados en un formato específico o en múltiples destinos?

- Explique cómo usaría el marco MapReduce para implementar un sistema de recomendación para datos de usuario a gran escala.

8 preguntas y respuestas de entrevistas sobre MapReduce relacionadas con definiciones técnicas

Para evaluar si sus candidatos comprenden las definiciones técnicas críticas para MapReduce, hágales algunas de estas preguntas de entrevista. Esta lista le ayudará a identificar a los candidatos que no solo entienden los conceptos básicos, sino que también pueden aplicarlos eficazmente durante escenarios del mundo real.

1. ¿Cuál es el papel del InputSplit en un trabajo de MapReduce?

El InputSplit en un trabajo de MapReduce define los fragmentos de datos que un solo Mapper procesará. Es una representación lógica de los datos que deben procesarse en paralelo.

Un candidato ideal debería ser capaz de explicar cómo los InputSplits contribuyen al procesamiento paralelo y cómo ayudan a optimizar el rendimiento general de un trabajo de MapReduce. Busque candidatos que entiendan el equilibrio entre el número de InputSplits y la eficiencia del procesamiento de datos.

2. ¿Puede describir qué hace un RecordReader en un trabajo de MapReduce?

Un RecordReader en un trabajo de MapReduce convierte los datos en un InputSplit en pares clave-valor que el Mapper puede procesar. Toma datos sin procesar como entrada y los desglosa en un formato adecuado para su procesamiento.

Los candidatos deben mencionar que el RecordReader es responsable de la serialización de datos y puede afectar el rendimiento del Mapper. Busque respuestas que muestren una comprensión de cómo se pueden usar diferentes tipos de RecordReaders para varios formatos de datos.

3. ¿Cómo maneja el marco MapReduce la redundancia de datos?

El marco MapReduce maneja la redundancia de datos a través de la replicación. Los datos se replican típicamente en múltiples nodos para garantizar la tolerancia a fallos. Si un nodo falla, aún se puede acceder a los datos desde otro nodo.

Busque candidatos que comprendan la importancia de la redundancia para garantizar la disponibilidad y confiabilidad de los datos. Deben ser conscientes de cómo las estrategias de replicación impactan el rendimiento general y la tolerancia a fallos del sistema.

4. ¿Cuáles son los componentes clave del ecosistema Hadoop que admiten MapReduce?

Los componentes clave del ecosistema Hadoop que soportan MapReduce incluyen HDFS (Hadoop Distributed File System) para almacenamiento, YARN (Yet Another Resource Negotiator) para la gestión de recursos, y el propio motor MapReduce para el procesamiento. Los candidatos deben ser capaces de describir cómo estos componentes trabajan juntos para facilitar el procesamiento de datos a gran escala. Busque una comprensión exhaustiva del papel de cada componente y cómo se integran para soportar flujos de trabajo de procesamiento de datos eficientes.

5. Explique el concepto de fallo y recuperación de tareas en MapReduce.

En MapReduce, el fallo de una tarea puede ocurrir debido a varias razones, como fallos de hardware, errores de software o problemas de red. El framework reintenta automáticamente la tarea fallida un cierto número de veces antes de declararla como fallida.

Los candidatos deben ser capaces de explicar cómo MapReduce gestiona la recuperación de tareas reasignando la tarea fallida a otro nodo. Busque una comprensión clara del mecanismo de reintento y su importancia para asegurar la finalización del trabajo.

6. ¿Cómo asegura el framework MapReduce el equilibrio de carga entre los diferentes nodos?

El framework MapReduce asegura el equilibrio de carga a través de la distribución de los InputSplits entre los diferentes nodos. Intenta asignar tareas basándose en la localidad de los datos para minimizar la transferencia de datos y optimizar el rendimiento.

Busque candidatos que entiendan la importancia del equilibrio de carga para prevenir cuellos de botella y asegurar una utilización eficiente de los recursos. Deben ser capaces de explicar cómo el framework ajusta dinámicamente las asignaciones de tareas para mantener cargas de trabajo equilibradas.

7. ¿Puede describir el propósito del archivo de configuración del trabajo en MapReduce?

El archivo de configuración del trabajo en MapReduce contiene todos los ajustes y parámetros necesarios para ejecutar un trabajo MapReduce, incluyendo las rutas de entrada y salida, las clases mapper y reducer, y varios parámetros específicos del trabajo.

Los candidatos deben mencionar que el archivo de configuración es crucial para personalizar el comportamiento de un trabajo MapReduce. Busque una comprensión de cómo se pueden ajustar diferentes parámetros para optimizar el rendimiento del trabajo y cumplir con requisitos específicos.

8. ¿Cuál es el papel del OutputCommitter en un trabajo MapReduce?

El OutputCommitter en un trabajo MapReduce es responsable de gestionar la salida de la tarea. Asegura que la salida de la tarea se confirme una vez que la tarea se completa con éxito y gestiona la limpieza en caso de fallo de la tarea.

Los candidatos ideales deben explicar cómo el OutputCommitter contribuye a la integridad de los datos y a la tolerancia a fallos. Busque una clara comprensión de cómo ayuda a gestionar la salida final y a garantizar que solo las tareas totalmente exitosas contribuyan a la salida.

8 preguntas y respuestas de entrevistas de MapReduce relacionadas con las técnicas de optimización

Para determinar si sus solicitantes tienen las habilidades adecuadas para optimizar los trabajos de MapReduce, hágales algunas de estas preguntas de entrevista de MapReduce sobre técnicas de optimización. Esto le ayudará a identificar a los candidatos que pueden asegurar un procesamiento de datos eficiente y la utilización de recursos.

1. ¿Cómo puede minimizar la cantidad de datos transferidos entre el Mapper y el Reducer en un trabajo de MapReduce?

Minimizar la transferencia de datos entre el Mapper y el Reducer se puede lograr mediante el uso de combinadores. Los combinadores realizan una tarea de 'reducción' local antes de la fase de reducción real, resumiendo los datos para reducir la cantidad de datos que se mezclan a través de la red.

Otro enfoque es diseñar su lógica de MapReduce para emitir menos pares clave-valor intermedios. Reducir el tamaño del conjunto de datos intermedio puede disminuir significativamente la sobrecarga de la red.

Las respuestas ideales deben mencionar el uso de combinadores y la generación eficiente de pares clave-valor. Busque candidatos que puedan explicar los beneficios prácticos y las posibles compensaciones de estas técnicas.

2. ¿Qué estrategias utilizaría para optimizar el rendimiento de un trabajo de MapReduce que procesa conjuntos de datos grandes?

Para optimizar el rendimiento de un trabajo de MapReduce, puede aumentar el número de reductores para distribuir mejor la carga de trabajo. Esto ayuda a equilibrar la carga y reduce el tiempo de ejecución.

Otra estrategia efectiva es aprovechar la localidad de los datos asegurando que los datos se procesen en el nodo donde residen. Esto minimiza la latencia de la red y mejora el rendimiento del trabajo.

Los candidatos también deben mencionar los parámetros de configuración de ajuste, como la configuración de la memoria y los tamaños de división. Busque respuestas que proporcionen una estrategia clara para equilibrar los recursos y minimizar los cuellos de botella.

3. ¿Cómo se gestiona la asimetría de datos en un trabajo MapReduce para garantizar una distribución uniforme de las tareas entre los nodos?

La gestión de la asimetría de datos implica el uso de un particionador personalizado. Un particionador personalizado puede distribuir los datos de manera más uniforme entre los reducers asignando particiones en función de las características de los datos, en lugar de la partición hash predeterminada.

Otro enfoque es preprocesar los datos para dividir los registros más grandes y asimétricos en fragmentos más pequeños. Esto asegura que ningún reducer individual se sobrecargue con una cantidad excesiva de datos.

Busque candidatos que puedan explicar la importancia de la distribución uniforme de los datos y cómo los particionadores personalizados o el preprocesamiento pueden mitigar la asimetría de los datos. También deben discutir los impactos potenciales de la asimetría de los datos en el rendimiento del trabajo.

4. ¿Qué es la ejecución especulativa en MapReduce y cómo puede mejorar el rendimiento del trabajo?

La ejecución especulativa es una característica de MapReduce que ejecuta instancias duplicadas de las tareas más lentas en diferentes nodos. La tarea que finaliza primero se acepta y las otras se eliminan. Esto ayuda a completar el trabajo más rápido al mitigar el impacto de los nodos lentos o fallidos.

Puede mejorar significativamente el rendimiento del trabajo, especialmente en clústeres heterogéneos donde algunos nodos pueden ser más lentos que otros. Actúa como una salvaguardia contra los problemas impredecibles de rendimiento de los nodos.

Las respuestas ideales deben destacar el concepto de ejecución especulativa y sus beneficios para mejorar la fiabilidad y el rendimiento de los trabajos. Los candidatos también deben discutir escenarios donde esta función es particularmente útil.

5. ¿Cómo puede aprovechar la caché distribuida en MapReduce para la optimización?

La caché distribuida en MapReduce le permite almacenar en caché archivos pequeños a medianos y distribuirlos a todos los nodos. Esto es útil para compartir datos de solo lectura, como tablas de búsqueda que se necesitan en múltiples nodos.

Al usar la caché distribuida, puede evitar operaciones de E/S redundantes y transferencias de red, mejorando así la eficiencia de su trabajo de MapReduce.

Los candidatos deben explicar cómo se puede usar la caché distribuida para optimizar el trabajo al reducir la E/S y la sobrecarga de la red. Busque ejemplos donde hayan usado con éxito esta función para mejorar el rendimiento.

6. ¿Cuáles son algunas técnicas para optimizar el rendimiento de la fase de mezcla y clasificación en MapReduce?

Para optimizar la fase de mezcla y clasificación, puede aumentar el número de tareas de reducción para distribuir mejor la carga de clasificación en todo el clúster. Esto acelera el proceso de clasificación al aprovechar el paralelismo.

Otra técnica es ajustar los tamaños de los búferes y las configuraciones de memoria para garantizar que se asignen suficientes recursos para las operaciones de mezcla y ordenación. Los candidatos fuertes deben mencionar la importancia de optimizar la fase de mezcla y ordenación y discutir técnicas prácticas de ajuste. También deben destacar el papel de la gestión de búferes y la optimización de la memoria en la mejora del rendimiento. ### 7. ¿Cómo manejaría archivos pequeños de manera eficiente en un trabajo MapReduce? El manejo eficiente de archivos pequeños se puede lograr agregándolos en archivos más grandes usando herramientas como Hadoop Archive o SequenceFile. Esto reduce la sobrecarga asociada con el procesamiento individual de una gran cantidad de archivos pequeños. Otro enfoque es usar CombineFileInputFormat, que trata múltiples archivos pequeños como una sola división de entrada, minimizando así la carga en NameNode y mejorando el rendimiento del trabajo. Los candidatos deben ser capaces de explicar ambas técnicas y sus beneficios. Busque respuestas que demuestren una comprensión de los desafíos que plantean los archivos pequeños y soluciones prácticas para abordarlos. ### 8. ¿Cuáles son algunos parámetros de configuración clave que ajustaría para optimizar un trabajo MapReduce?

Los parámetros clave de configuración incluyen el número de mappers y reducers, la configuración de la asignación de memoria y los tamaños de división de entrada. Ajustar estos parámetros puede ayudar a equilibrar la carga de trabajo y garantizar una utilización eficiente de los recursos.

Por ejemplo, aumentar el número de reducers puede mejorar la distribución de la carga, mientras que ajustar la configuración de memoria puede evitar problemas de falta de memoria. Establecer tamaños de división de entrada apropiados también puede ayudar a optimizar la ejecución del trabajo.

Los candidatos deben mencionar parámetros específicos y su impacto en el rendimiento del trabajo. Busque respuestas que proporcionen una justificación clara para ajustar estos parámetros y ejemplos de cómo lo han hecho en el pasado.

8 preguntas situacionales de MapReduce para entrevistas con respuestas para contratar a los mejores desarrolladores

Para descubrir si los candidatos pueden manejar desafíos del mundo real usando MapReduce, considere estas 8 preguntas situacionales de entrevista sobre MapReduce. Estas preguntas le ayudarán a evaluar sus conocimientos prácticos y habilidades para resolver problemas, asegurando que contrate a la persona más adecuada para su equipo.

1. ¿Cómo manejaría una situación en la que su trabajo de MapReduce se está ejecutando más lento de lo esperado?

Cuando un trabajo de MapReduce se ejecuta más lento de lo esperado, el primer paso es identificar el cuello de botella. Esto podría deberse a la sesgo de los datos, configuraciones incorrectas o algoritmos ineficientes.

Los candidatos deben mencionar herramientas y técnicas de monitoreo para diagnosticar problemas de rendimiento, como verificar el rastreador de trabajos, mirar los registros y usar analizadores de rendimiento para comprender dónde se está gastando el tiempo.

Un candidato ideal no solo identificará la causa raíz, sino que también sugerirá soluciones como optimizar el algoritmo, ajustar los parámetros de configuración o distribuir los datos de manera más uniforme.

2. Describa una situación en la que tuvo que depurar un trabajo complejo de MapReduce. ¿Qué pasos tomó?

Los candidatos deben explicar el uso de contadores para rastrear el progreso del trabajo e identificar cualquier anomalía en los datos intermedios. También podrían discutir la ejecución de subconjuntos de datos más pequeños para aislar el problema.

Busque respuestas que demuestren un enfoque sistemático, incluido el uso de herramientas y marcos de depuración, así como la colaboración con los miembros del equipo para resolver problemas complejos.

3. ¿Cómo abordaría la optimización de un trabajo de MapReduce que procesa un conjunto de datos grande?

Optimizar un trabajo de MapReduce para conjuntos de datos grandes implica múltiples estrategias. Primero, asegúrese de que la localidad de los datos se maximice para que las tareas se ejecuten en los nodos donde residen los datos.

Los candidatos deben mencionar técnicas como el uso de combinadores para reducir la cantidad de datos barajados entre los mapeadores y los reductores, y la optimización de los parámetros de configuración, como el número de mapeadores y reductores.

Un candidato ideal también discutirá la importancia de monitorear y perfilar el trabajo para identificar cuellos de botella, y refinar iterativamente la lógica y la configuración del trabajo para un mejor rendimiento.

4. ¿Qué estrategias utilizaría para manejar un trabajo de MapReduce con sesgo de datos?

Manejar el sesgo de datos implica garantizar una distribución uniforme de los datos en todos los reductores. Los candidatos podrían sugerir el uso de un particionador personalizado para distribuir los datos de manera más uniforme.

Otro enfoque es preprocesar los datos para equilibrar la carga, como dividir registros grandes en fragmentos más pequeños o fusionar registros pequeños en otros más grandes antes de que se ejecute el trabajo MapReduce.

Busque candidatos que demuestren una comprensión del impacto de la asimetría de los datos y puedan sugerir soluciones prácticas para mantener cargas de trabajo equilibradas en todo el clúster.

5. ¿Cómo asegura la tolerancia a fallos en un trabajo MapReduce?

La tolerancia a fallos en MapReduce se logra a través de mecanismos como la re-ejecución de tareas fallidas. El framework reinicia automáticamente cualquier tarea fallida en diferentes nodos para garantizar la finalización del trabajo.

Los candidatos deben mencionar la importancia de los puntos de control (checkpoints) y el mantenimiento de datos intermedios para recuperarse de fallos parciales. También podrían discutir el papel de la replicación para asegurar la disponibilidad de los datos.

Una respuesta ideal destacará la comprensión del candidato de las características integradas de tolerancia a fallos de MapReduce y cómo se pueden configurar y monitorear para asegurar la fiabilidad del trabajo.

6. Describe cómo manejarías un escenario donde los datos de entrada para tu trabajo MapReduce se transmiten continuamente.

Manejar flujos de datos continuos en MapReduce normalmente implica usar un marco como Apache Kafka para almacenar en búfer los datos entrantes y alimentarlos en trabajos MapReduce en fragmentos manejables.

Los candidatos podrían discutir la configuración de trabajos por lotes periódicos que procesan datos dentro de ventanas de tiempo específicas, asegurando que los datos se procesen eficientemente sin abrumar el sistema.

Busca candidatos que comprendan los desafíos de la transmisión de datos y puedan sugerir soluciones prácticas, como la integración de herramientas de big data que complementan MapReduce para el procesamiento en tiempo real.

7. ¿Cuál es tu enfoque para gestionar y mantener los datos intermedios generados durante un trabajo MapReduce?

La gestión de datos intermedios implica asegurar que se almacenen eficientemente y que los reductores puedan acceder a ellos rápidamente. Los candidatos deben mencionar el uso de discos locales para almacenamiento temporal y la importancia de la compresión de datos.

También podrían discutir técnicas como el uso de combinadores para reducir el volumen de datos intermedios y configurar los tamaños de búfer correctos para optimizar el rendimiento.

Un candidato ideal demostrará una comprensión de varias estrategias para gestionar eficientemente los datos intermedios, asegurando la ejecución sin problemas del trabajo MapReduce.

8. ¿Cómo abordarías las pruebas y la validación de los resultados de un trabajo MapReduce?

Probar un trabajo de MapReduce implica crear casos de prueba con entrada y salida conocidas para asegurar que el trabajo produzca los resultados esperados. Los candidatos deben mencionar las pruebas unitarias para las funciones individuales de mapa y reducción.

También podrían discutir la importancia de ejecutar el trabajo en un conjunto de datos de muestra antes de escalar al conjunto de datos completo, así como usar marcos de prueba de extremo a extremo para validar toda la tubería del trabajo.

Busque candidatos que enfaticen la importancia de pruebas y validación exhaustivas para detectar errores temprano y asegurar la fiabilidad del trabajo de MapReduce.

¿Qué habilidades de MapReduce debe evaluar durante la fase de entrevista?

Si bien una sola entrevista puede no descubrir todas las facetas de las habilidades de un candidato, centrarse en las habilidades clave de MapReduce puede generar información significativa sobre su experiencia y su potencial ajuste para el puesto. En el contexto de MapReduce, ciertas habilidades son fundamentales y sirven como indicadores confiables de la capacidad de un candidato para manejar desafíos de procesamiento de datos del mundo real.

Comprensión del ecosistema Hadoop

Una sólida comprensión del ecosistema Hadoop, que incluye MapReduce, es fundamental para los desarrolladores que trabajan en el procesamiento de datos. MapReduce a menudo opera dentro de Hadoop, y el conocimiento del ecosistema más amplio puede mejorar en gran medida la capacidad de un desarrollador para diseñar e implementar soluciones eficientes de procesamiento de datos.

Para evaluar esta habilidad de manera efectiva, considere usar una serie de preguntas de opción múltiple (MCQ) que cubran varios componentes del ecosistema Hadoop. Para una prueba completa, pruebe el examen en línea de MapReduce de nuestra biblioteca.

Una pregunta de entrevista específica también puede proporcionar información sobre el conocimiento práctico del candidato sobre el ecosistema Hadoop. Aquí hay una pregunta que podría considerar:

¿Puede describir cómo MapReduce encaja en el ecosistema Hadoop y nombrar al menos otros dos componentes que interactúan con MapReduce?

Busque respuestas que mencionen HDFS para el almacenamiento de datos y YARN para la programación de trabajos, lo que demuestra la comprensión holística del candidato de cómo estos componentes trabajan junto con MapReduce.

Técnicas de optimización

En la programación MapReduce, comprender las técnicas de optimización es clave para mejorar el rendimiento y reducir los costos. Los candidatos deben estar familiarizados con conceptos como las funciones Combiner, los Partitioners y la clasificación y mezcla eficiente de datos.

Para explorar la competencia del candidato en optimización, plantee la siguiente pregunta de la entrevista:

¿Cuáles son algunas estrategias de optimización efectivas para un trabajo MapReduce que procesa grandes conjuntos de datos?

Busque estrategias detalladas, como el uso de Combiners para reducir la cantidad de datos transferidos a través de la red, la optimización del número de reducers y las técnicas de partición para garantizar una distribución uniforme de los datos.

Manejo de errores y depuración

La competencia en el manejo de errores y la depuración es esencial para los desarrolladores de MapReduce, ya que garantiza la confiabilidad y precisión de los trabajos de procesamiento de datos. La capacidad de un desarrollador para identificar y rectificar rápidamente los errores en los trabajos de MapReduce puede afectar significativamente la eficiencia y la estabilidad de las tareas de procesamiento de datos.

Considere hacer esta pregunta para evaluar la experiencia en el manejo de errores y la depuración en MapReduce:

Explique cómo identificaría y resolvería un cuello de botella de rendimiento en un trabajo MapReduce.

Las respuestas efectivas deben incluir métodos como la revisión de la configuración, el análisis de los archivos de registro o el uso de herramientas específicas de Hadoop como JobTracker y TaskTracker para identificar y resolver problemas.

3 Consejos para usar eficazmente las preguntas de la entrevista de MapReduce

Antes de comenzar a aplicar lo que ha aprendido, aquí hay algunos consejos para mejorar su proceso de entrevista.

1. Implemente pruebas de habilidades antes de las entrevistas

Usar pruebas de habilidades antes de las entrevistas es una forma inteligente de filtrar a los candidatos de manera efectiva. Estas pruebas le permiten evaluar las habilidades prácticas relevantes para el trabajo, proporcionando una imagen más clara de las capacidades de un candidato.

Para evaluar las habilidades de MapReduce, considere usar nuestra prueba en línea de MapReduce o pruebas en áreas relacionadas como Hadoop y Spark. La implementación de estas pruebas puede reducir significativamente el tiempo dedicado a candidatos no cualificados y agilizar el proceso de selección.

Este enfoque ayuda a garantizar que solo los candidatos más competentes pasen a las entrevistas, lo que le permite concentrarse en la evaluación de los aspectos más relevantes de su experiencia y habilidades.

2. Seleccione sabiamente las preguntas de la entrevista

En las entrevistas, el tiempo suele ser limitado, por lo que es esencial seleccionar las preguntas correctas que aborden los aspectos más críticos del conjunto de habilidades del candidato. Centrarse en un número manejable de preguntas bien seleccionadas maximizará el éxito de su evaluación.

Considere incluir preguntas sobre habilidades relacionadas o habilidades blandas como la comunicación y el trabajo en equipo. Por ejemplo, puede consultar las preguntas de nuestras categorías de ciencia de datos o Java para obtener contexto adicional.

Esta estrategia le permite cubrir áreas importantes sin abrumar al candidato ni a usted mismo, lo que conduce a una entrevista más productiva.

3. Haga preguntas de seguimiento relevantes

Simplemente hacer preguntas de entrevista no es suficiente para evaluar la verdadera profundidad de un candidato. Las preguntas de seguimiento son esenciales para explorar la comprensión real de un candidato y la aplicación práctica de sus conocimientos, lo que ayuda a revelar cualquier posible discrepancia.

Por ejemplo, si un candidato explica cómo usó MapReduce para procesar grandes conjuntos de datos, una buena pregunta de seguimiento sería: '¿Puede describir un desafío específico al que se enfrentó y cómo lo superó?' Esto no solo evalúa sus habilidades para resolver problemas, sino que también proporciona información sobre su experiencia y proceso de pensamiento.

Utilice preguntas de entrevista de MapReduce y pruebas de habilidades para contratar desarrolladores talentosos

Si busca contratar a alguien con habilidades de MapReduce, es importante asegurarse de que posea estas habilidades con precisión. La mejor manera de lograrlo es mediante la utilización de pruebas de habilidades, como la prueba en línea de MapReduce.

Después de realizar esta prueba, puede preseleccionar eficazmente a los mejores candidatos para las entrevistas. Para comenzar, visite nuestra biblioteca de pruebas de evaluación o regístrese aquí para comenzar su proceso de contratación.

Prueba en línea de MapReduce

30 minutos | 15 MCQ

El examen en línea de MapReduce utiliza preguntas de opción múltiple basadas en escenarios para evaluar a los candidatos sobre su conocimiento del marco de MapReduce, incluida su competencia en el trabajo con Hadoop, HDFS y YARN. La prueba también evalúa la familiaridad del candidato con Pig y Hive para el análisis de datos y su capacidad para trabajar con tecnologías de Big Data. El examen tiene como objetivo evaluar la capacidad del candidato para diseñar y desarrollar aplicaciones utilizando el marco de MapReduce y tecnologías relacionadas de manera efectiva.

[

Pruebe el examen en línea de MapReduce

](https://www.adaface.com/assessment-test/map-reduce-online-test)

Descargue la plantilla de preguntas de la entrevista de MapReduce en múltiples formatos

Las preguntas de la entrevista de MapReduce están diseñadas para evaluar el conocimiento y las habilidades de un candidato en MapReduce, un modelo de programación utilizado para procesar grandes conjuntos de datos.

Usar las preguntas de MapReduce le ayuda a evaluar la competencia de un candidato en el manejo de tareas de procesamiento de datos a gran escala, lo cual es crucial para los roles en big data y análisis.

Para los desarrolladores junior, concéntrese en preguntas básicas y de definición técnica. Para los desarrolladores senior, incluya preguntas avanzadas y técnicas de optimización.

Busque claridad, habilidades para la resolución de problemas, comprensión de conceptos de MapReduce como map, reduce y técnicas de optimización, y experiencia práctica.

Sí, estas preguntas se pueden utilizar eficazmente tanto en entrevistas presenciales como remotas para evaluar las habilidades de MapReduce de un candidato.

Si bien estas preguntas son generalmente aplicables, son particularmente útiles para las industrias que se ocupan de big data, análisis de datos y procesamiento de datos a gran escala.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento