Habilidades requeridas para un desarrollador de Hadoop y cómo evaluarlas

Los desarrolladores de Hadoop adecuados son fundamentales para la gestión de entornos de big data. Ellos salvan la distancia entre conjuntos de datos masivos y conocimientos prácticos, asegurando que los datos sean accesibles y utilizables para las empresas.

Las habilidades de desarrollo de Hadoop abarcan una comprensión profunda del ecosistema Hadoop, incluyendo componentes como HDFS, YARN y MapReduce, así como habilidades de programación en Java, Scala o Python.

Los candidatos pueden escribir estas habilidades en sus currículums, pero no se pueden verificar sin pruebas de habilidades de desarrollador de Hadoop en el trabajo.

En esta publicación, exploraremos 9 habilidades esenciales de desarrollador de Hadoop, 11 habilidades secundarias y cómo evaluarlas para que pueda tomar decisiones de contratación informadas.

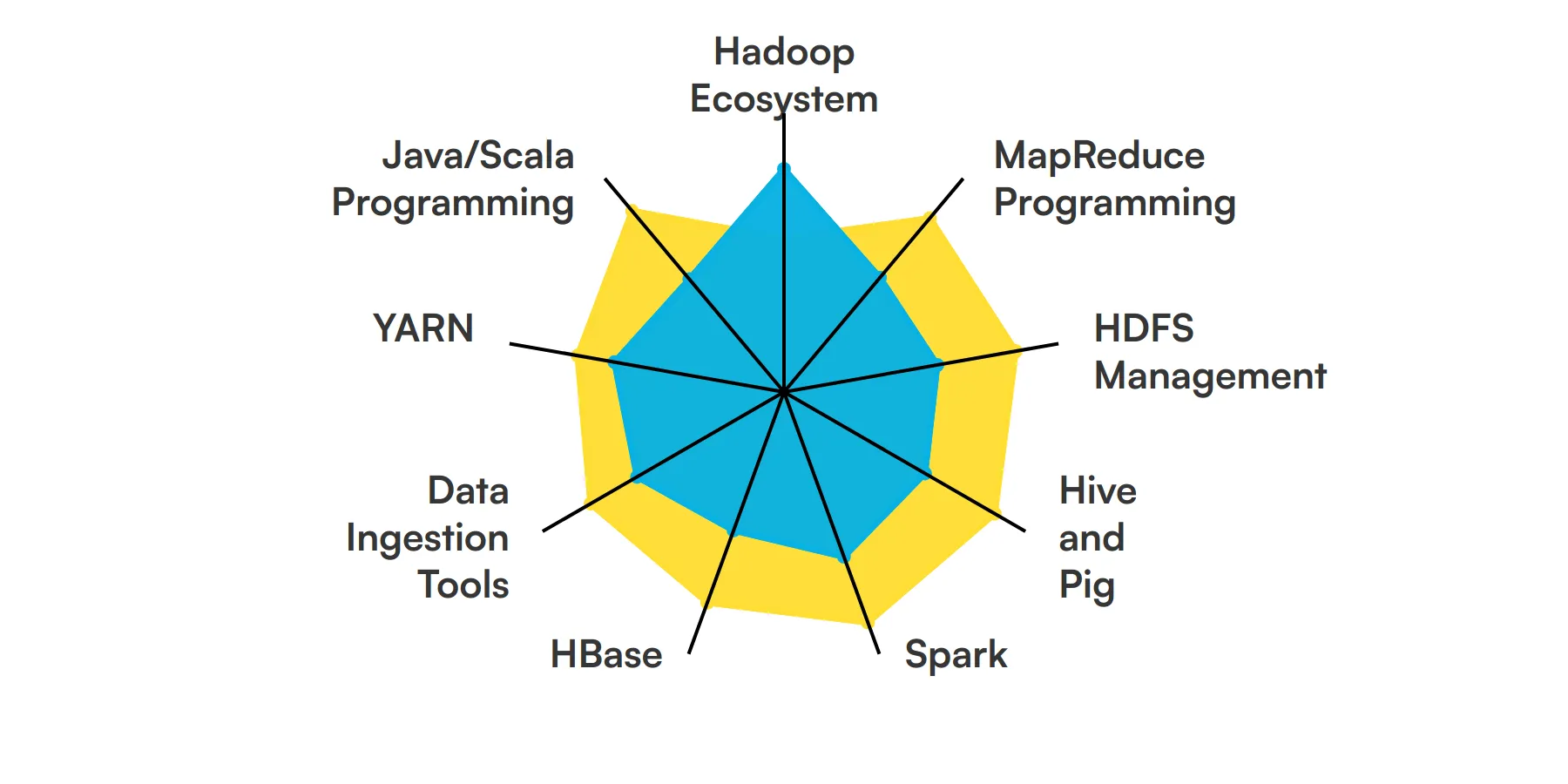

9 habilidades y rasgos fundamentales del desarrollador de Hadoop

11 habilidades y rasgos secundarios del desarrollador de Hadoop

Cómo evaluar las habilidades y rasgos del desarrollador de Hadoop

Resumen: Las 9 habilidades clave del desarrollador de Hadoop y cómo probarlas

Evalúe y contrate a los mejores desarrolladores de Hadoop con Adaface

Preguntas frecuentes sobre las habilidades del desarrollador de Hadoop

9 habilidades y rasgos fundamentales del desarrollador de Hadoop

Las mejores habilidades para los desarrolladores de Hadoop incluyen Ecosistema Hadoop, Programación MapReduce, Gestión de HDFS, Hive y Pig, Spark, HBase, Herramientas de Ingesta de Datos, YARN y Programación Java/Scala.

Profundicemos en los detalles examinando las 9 habilidades esenciales de un desarrollador de Hadoop.

Ecosistema Hadoop

Un desarrollador de Hadoop debe estar bien versado en el ecosistema de Hadoop, incluyendo HDFS, MapReduce, YARN y otras herramientas relacionadas. Este conocimiento es crucial para la gestión y el procesamiento eficiente de grandes conjuntos de datos.

Para obtener más información, consulta nuestra guía para escribir una Descripción del puesto de desarrollador de Hadoop.

Programación MapReduce

Comprender MapReduce es fundamental para un desarrollador de Hadoop. Este modelo de programación permite el procesamiento de grandes conjuntos de datos con un algoritmo distribuido en un clúster de Hadoop, lo que lo hace esencial para las tareas de análisis de datos.

Gestión de HDFS

Hadoop Distributed File System (HDFS) es la unidad de almacenamiento de Hadoop. Un desarrollador necesita saber cómo gestionar y manipular datos dentro de HDFS, asegurando que los datos se almacenan de forma fiable y se puede acceder a ellos rápidamente.

Hive y Pig

Hive y Pig son herramientas de procesamiento de datos de alto nivel en el ecosistema de Hadoop. Hive utiliza consultas similares a SQL, mientras que Pig utiliza un lenguaje de scripting. Ambos son esenciales para simplificar las transformaciones y análisis de datos complejos.

Consulta nuestra guía para obtener una lista completa de preguntas de entrevista.

Spark

Apache Spark es un potente motor de procesamiento de datos que funciona bien con Hadoop. Un desarrollador de Hadoop debe saber cómo usar Spark para un procesamiento de datos más rápido y análisis en tiempo real.

HBase

HBase es una base de datos distribuida no relacional que se ejecuta sobre HDFS. El conocimiento de HBase es importante para el acceso de lectura/escritura en tiempo real a grandes conjuntos de datos, lo cual se requiere a menudo en proyectos de Hadoop.

Herramientas de ingesta de datos

Herramientas como Flume y Sqoop se utilizan para la ingesta de datos en Hadoop. Un desarrollador debe saber cómo usar estas herramientas para importar y exportar datos entre Hadoop y otros sistemas.

YARN

Yet Another Resource Negotiator (YARN) es la capa de gestión de recursos de Hadoop. Comprender YARN es crucial para gestionar y programar recursos en un clúster de Hadoop.

Programación Java/Scala

Java y Scala son lenguajes comúnmente utilizados para escribir aplicaciones Hadoop. La competencia en estos lenguajes es necesaria para desarrollar soluciones Hadoop eficientes y escalables.

Para obtener más información, consulta nuestra guía para redactar una descripción de puesto de trabajo de desarrollador de Scala.

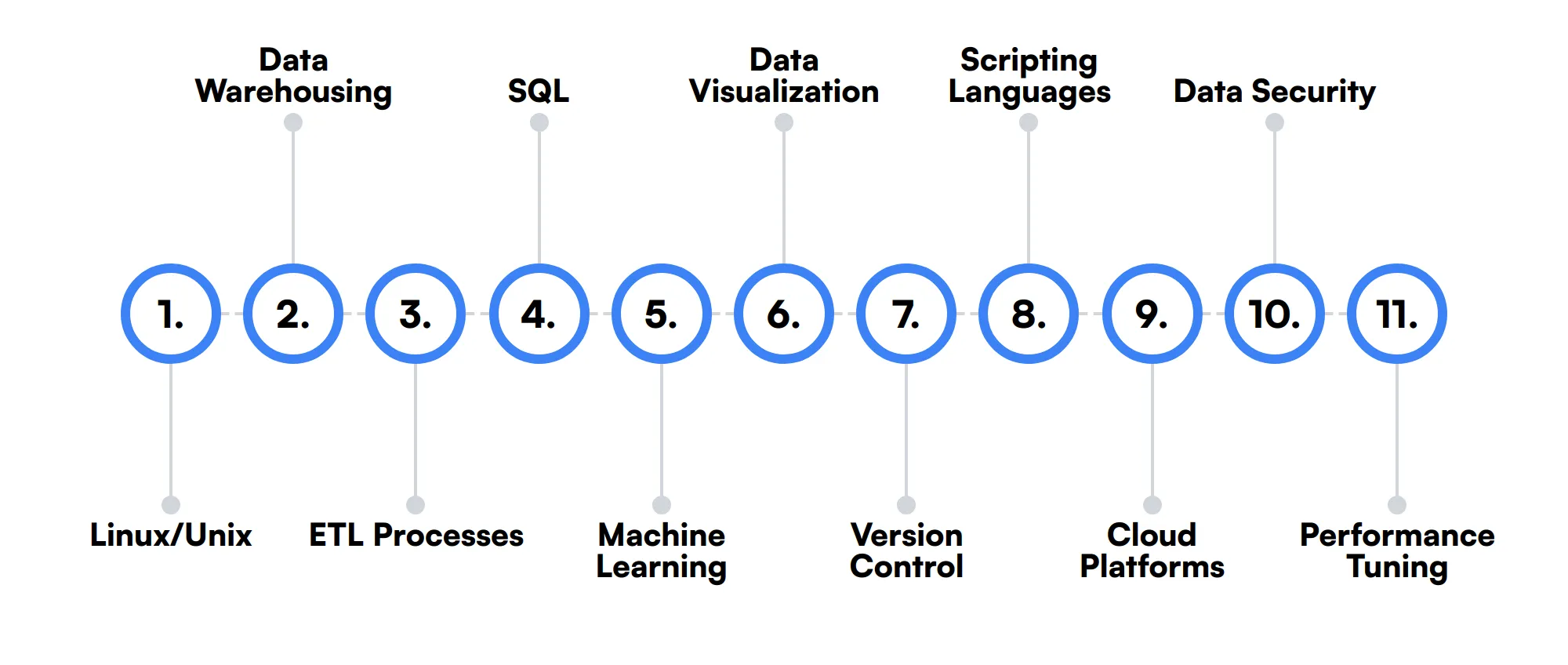

11 habilidades y rasgos secundarios de los desarrolladores de Hadoop

Las mejores habilidades para los desarrolladores de Hadoop incluyen Linux/Unix, almacenamiento de datos, procesos ETL, SQL, aprendizaje automático, visualización de datos, control de versiones, lenguajes de scripting, plataformas en la nube, seguridad de datos y ajuste del rendimiento.

Profundicemos en los detalles examinando las 11 habilidades secundarias de un desarrollador de Hadoop.

Linux/Unix

Hadoop se ejecuta en sistemas Linux/Unix, por lo que la familiaridad con estos sistemas operativos es beneficiosa para administrar y solucionar problemas en los clústeres de Hadoop.

Almacenamiento de datos

Comprender los conceptos de almacenamiento de datos puede ayudar a un desarrollador de Hadoop a diseñar mejores soluciones de almacenamiento de datos y optimizar los procesos de recuperación de datos.

Procesos ETL

El conocimiento de los procesos de Extracción, Transformación y Carga (ETL) es útil para mover y transformar datos dentro del ecosistema de Hadoop.

SQL

SQL se usa a menudo junto con herramientas de Hadoop como Hive. Saber SQL puede facilitar la consulta y manipulación de datos almacenados en Hadoop.

Aprendizaje automático

La familiaridad con los marcos de aprendizaje automático como Mahout o Spark MLlib puede ser ventajosa para implementar análisis de datos avanzados y modelos predictivos.

Visualización de datos

Las habilidades en herramientas de visualización de datos como Tableau o D3.js pueden ayudar a un desarrollador de Hadoop a presentar información de datos en un formato más comprensible y útil.

Control de versiones

Usar sistemas de control de versiones como Git es importante para administrar los cambios de código y colaborar con otros desarrolladores en proyectos de Hadoop.

Lenguajes de scripting

El conocimiento de lenguajes de scripting como Python o Perl puede ser útil para automatizar tareas y escribir scripts personalizados para el procesamiento de datos.

Plataformas en la nube

La experiencia con plataformas en la nube como AWS, Azure o Google Cloud puede ser beneficiosa para implementar y administrar clústeres de Hadoop en un entorno en la nube.

Seguridad de datos

Comprender las prácticas de seguridad de datos es importante para proteger los datos confidenciales dentro de un ecosistema de Hadoop, especialmente en industrias con estrictos requisitos de cumplimiento.

Ajuste del rendimiento

Las habilidades en el ajuste del rendimiento pueden ayudar a un desarrollador de Hadoop a optimizar el rendimiento de los trabajos de Hadoop y asegurar el uso eficiente de los recursos.

Cómo evaluar las habilidades y rasgos de un desarrollador de Hadoop

Evaluar las habilidades y rasgos de un desarrollador de Hadoop puede ser una tarea desafiante, dada la amplia gama de experiencia requerida. Desde la comprensión del ecosistema Hadoop y la programación MapReduce hasta la gestión de HDFS y el trabajo con herramientas como Hive, Pig y Spark, un desarrollador de Hadoop competente debe estar bien versado en varios dominios.

Los currículums y las certificaciones pueden proporcionar una instantánea de los antecedentes de un candidato, pero no revelan la profundidad de sus conocimientos ni su capacidad para aplicarlos en escenarios del mundo real. Las evaluaciones basadas en habilidades son la forma más fiable de evaluar las verdaderas capacidades de un candidato.

Por ejemplo, las pruebas de habilidades en el trabajo de Adaface pueden ayudarle a crear evaluaciones personalizadas que se centren en las habilidades específicas que necesita, como HBase, herramientas de ingestión de datos, YARN y programación Java/Scala. Este enfoque no solo mejora la calidad de las contrataciones en 2 veces, sino que también reduce el tiempo de selección en un 85%.

Veamos cómo evaluar las habilidades de los desarrolladores de Hadoop con estas 6 evaluaciones de talento.

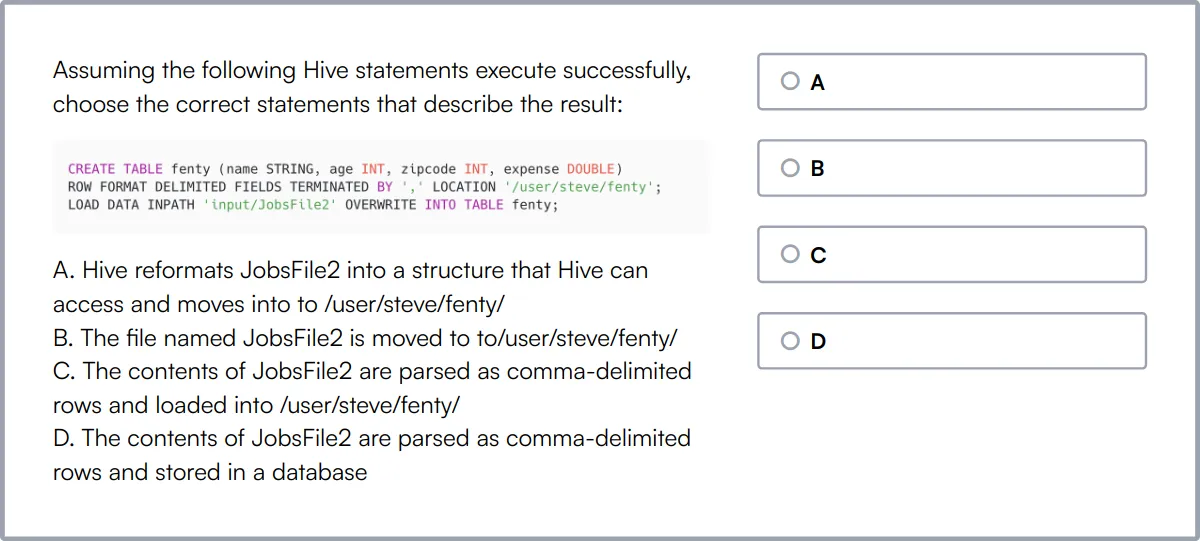

Prueba en línea de Hadoop

Nuestra Prueba en línea de Hadoop evalúa a los candidatos en su capacidad para administrar y analizar big data utilizando Hadoop. La prueba se centra en habilidades prácticas como la instalación de clústeres Hadoop, la configuración de la arquitectura central de Hadoop y la escritura de consultas eficientes de Hive y Pig.

La prueba evalúa la competencia de los candidatos en el manejo de datos de transmisión, el trabajo con varios formatos de archivo y la solución de problemas y el monitoreo de clústeres Hadoop.

Los candidatos exitosos demuestran un fuerte dominio de la publicación de datos en clústeres y la optimización de trabajos MapReduce, lo cual es esencial para roles en entornos intensivos en datos.

Prueba en línea de MapReduce

Nuestro Examen en línea de MapReduce desafía a los candidatos sobre sus conocimientos del framework MapReduce, un componente clave de Hadoop utilizado para procesar grandes conjuntos de datos con un algoritmo distribuido.

Este examen evalúa la capacidad del candidato para diseñar y desarrollar aplicaciones utilizando MapReduce, incluyendo la agregación de datos, la transformación y la optimización del rendimiento.

Los candidatos proficientes en MapReduce también mostrarán sólidas habilidades en computación paralela y computación distribuida, cruciales para el desarrollo de soluciones eficientes de procesamiento de big data.

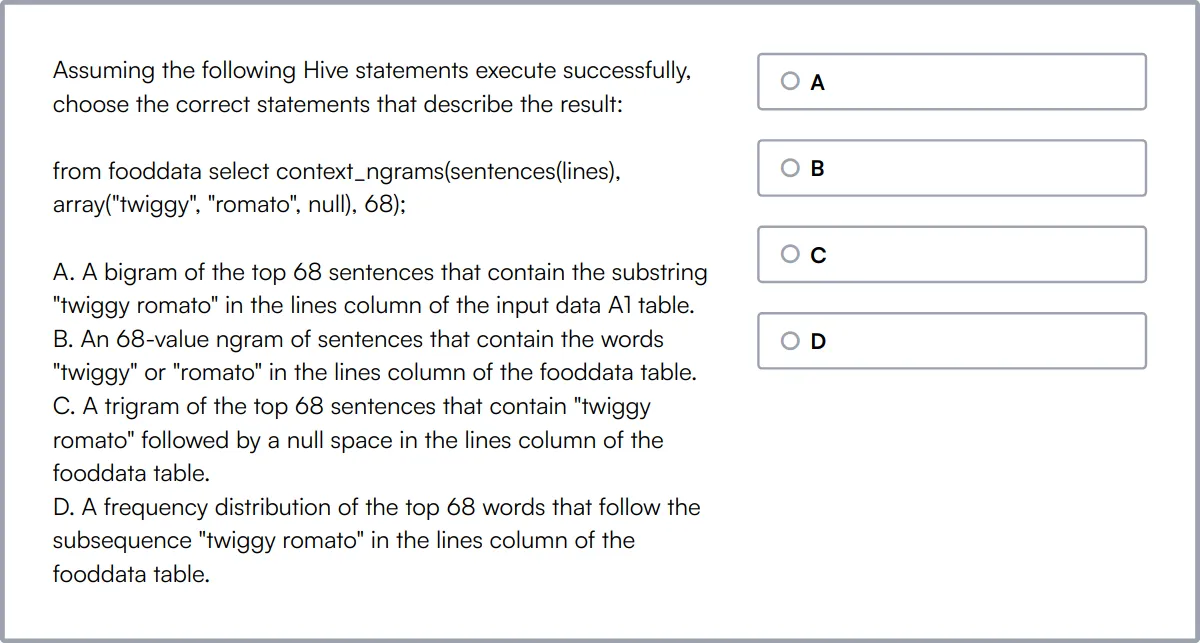

Examen en línea de Hive

Nuestro Examen en línea de Hive evalúa a los candidatos sobre su experiencia en Hive, centrándose en áreas como la arquitectura de Hive, el modelado de datos y la optimización de consultas.

El examen desafía a los candidatos a demostrar su capacidad para crear y administrar bases de datos y tablas de Hive, escribir consultas eficientes y usar las funciones de Hive de manera efectiva.

Los candidatos con altas puntuaciones son expertos en la resolución de problemas y la optimización de consultas de Hive, lo que garantiza un alto rendimiento y escalabilidad en las tareas de procesamiento de datos.

Examen en línea de Spark

Nuestro Examen en línea de Spark evalúa a los candidatos sobre su capacidad para desarrollar y ejecutar aplicaciones utilizando Apache Spark, un motor rápido y general para el procesamiento de datos a gran escala.

El examen cubre los fundamentos de Spark Core, el procesamiento de datos con Spark SQL y la construcción de pipelines de datos en tiempo real utilizando Spark Streaming.

Los candidatos que sobresalen en esta prueba son competentes en la ejecución de Spark en clústeres, la implementación de algoritmos de múltiples etapas y la optimización de trabajos de Spark, habilidades clave para manejar tareas complejas de procesamiento de datos.

Prueba en línea de Sqoop

Nuestra Prueba en línea de Sqoop evalúa a los candidatos en su capacidad para transferir datos entre Hadoop y bases de datos relacionales usando Sqoop, centrándose en los comandos de ingestión y exportación de datos.

Esta prueba evalúa la competencia en la gestión de la transformación, validación e integración de datos utilizando conectores basados en Sqoop y el manejo eficiente de la entrada/salida (I/O) de disco y red.

Los candidatos con experiencia en Sqoop demuestran sólidas capacidades en los procesos ETL y la integración de datos, esenciales para roles que involucran migraciones y transformaciones de datos a gran escala.

Prueba en línea de Scala

Nuestra Prueba en línea de Scala mide la competencia de los candidatos en Scala, un lenguaje de programación potente que admite paradigmas de programación orientada a objetos y funcional.

La prueba desafía a los candidatos en su comprensión de las características principales de Scala, incluida la inferencia de tipos, la concurrencia y las colecciones, así como su capacidad para aplicar principios de programación funcional y manejar errores de manera efectiva.

Los candidatos competentes demostrarán sólidas habilidades para la resolución de problemas y la capacidad de desarrollar aplicaciones escalables utilizando Scala, lo que refleja su profunda comprensión de las capacidades y las mejores prácticas del lenguaje.

Resumen: Las 9 habilidades clave de los desarrolladores de Hadoop y cómo evaluarlas

| Habilidad de Desarrollador Hadoop | Cómo evaluarlos |

|---|---|

| 1. Ecosistema Hadoop | Evaluar la comprensión de varios componentes de Hadoop y su integración. |

| 2. Programación MapReduce | Evaluar la capacidad de escribir y optimizar trabajos MapReduce. |

| 3. Gestión de HDFS | Verificar las habilidades en la gestión y mantenimiento del Sistema de Archivos Distribuidos Hadoop. |

| 4. Hive y Pig | Medir la competencia en el uso de Hive y Pig para la consulta de datos. |

| 5. Spark | Determinar la experiencia en el uso de Apache Spark para el procesamiento de big data. |

| 6. HBase | Evaluar el conocimiento de HBase para el acceso de lectura/escritura en tiempo real a los datos. |

| 7. Herramientas de Ingestión de Datos | Evaluar la experiencia con herramientas como Flume y Sqoop para la ingesta de datos. |

| 8. YARN | Verificar la comprensión de YARN para la gestión de recursos en Hadoop. |

| 9. Programación Java/Scala | Evaluar las habilidades de programación en Java o Scala para aplicaciones Hadoop. |

Prueba en Línea de Hadoop

30 minutos | 15 MCQs

La Prueba en Línea de Hadoop utiliza preguntas MCQ basadas en escenarios para evaluar la capacidad de los candidatos para instalar clústeres Hadoop en la nube, ejecutar trabajos MapReduce optimizados en clústeres Hadoop y escribir instrucciones Pig y consultas Hive eficientes para realizar análisis de datos en conjuntos de datos complejos. La prueba evalúa los conocimientos básicos del marco de trabajo Hadoop que los gerentes de contratación buscan en los desarrolladores y administradores de Hadoop.

Intenta la Prueba en Línea de Hadoop

Preguntas frecuentes sobre las habilidades de los desarrolladores de Hadoop

¿Qué es el Ecosistema Hadoop y por qué es importante para un Desarrollador Hadoop?

El ecosistema de Hadoop incluye herramientas como HDFS, MapReduce, Hive, Pig y más. Comprender estas herramientas ayuda a los desarrolladores a gestionar y procesar grandes conjuntos de datos de manera efectiva.

¿Cómo puedo evaluar la competencia de un candidato en la programación de MapReduce?

Solicite a los candidatos que expliquen el proceso de MapReduce y resuelvan un problema simple utilizando MapReduce. Busque su comprensión de conceptos clave como mappers, reducers y flujo de datos.

¿Qué habilidades son necesarias para la gestión de HDFS?

Los candidatos deben saber cómo almacenar, gestionar y recuperar datos en HDFS. Evalúe su capacidad para realizar tareas como la replicación de datos, la tolerancia a fallos y las operaciones del sistema de archivos.

¿Por qué es importante el conocimiento de Hive y Pig para un desarrollador de Hadoop?

Hive y Pig simplifican la consulta y el análisis de grandes conjuntos de datos. Evalúe a los candidatos en su capacidad para escribir consultas HiveQL y scripts Pig para procesar datos.

¿Cómo evalúa la experiencia de un candidato con Spark?

Pídales que describan la arquitectura de Spark y resuelvan un problema usando Spark. Busque su comprensión de RDDs, DataFrames y el modelo de ejecución de Spark.

¿Qué debo buscar en la experiencia de un candidato con HBase?

Verifique su conocimiento de la arquitectura de HBase, el modelado de datos y las operaciones CRUD. La experiencia práctica con la API de HBase y la optimización del rendimiento es una ventaja.

¿Cómo puedo evaluar las habilidades de un candidato en herramientas de ingestión de datos?

Evalúe su experiencia con herramientas como Flume, Sqoop y Kafka. Pídales que describan los flujos de trabajo de ingestión de datos y cómo manejan los datos de varias fuentes.

¿Qué papel juega YARN en Hadoop y cómo puedo evaluar el conocimiento de un candidato sobre él?

YARN gestiona los recursos en un clúster de Hadoop. Pídales a los candidatos que expliquen la arquitectura de YARN y cómo programa y supervisa los trabajos.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento