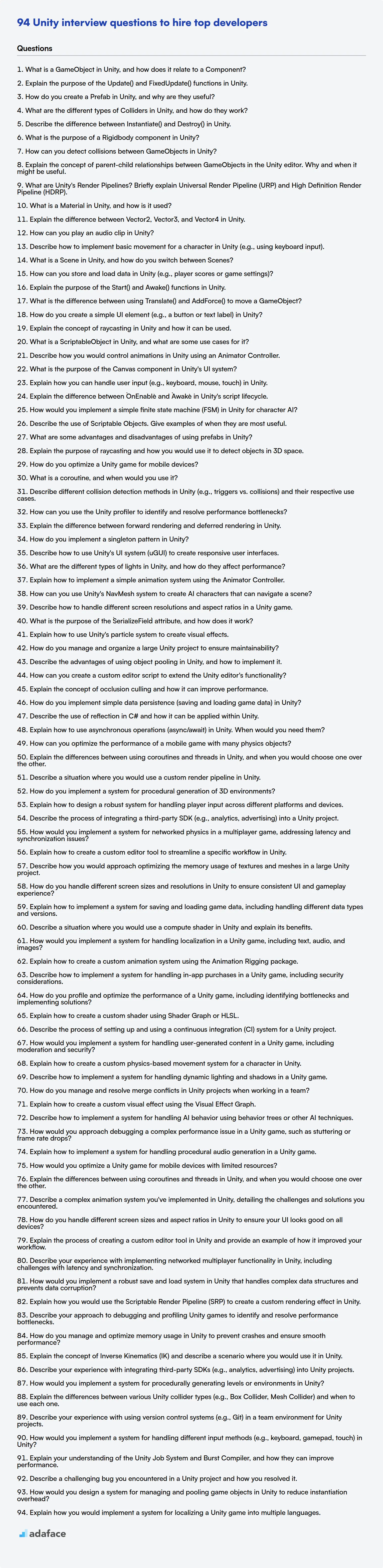

94 preguntas de entrevista de Unity para contratar a los mejores desarrolladores

Contratar a un desarrollador de Unity requiere comprender sus habilidades técnicas y su experiencia con el motor. Necesitas saber si pueden construir tu próximo juego o simulación de alta calificación, por lo que es importante hacer las preguntas correctas, y es más que solo conocer las habilidades requeridas para un programador de juegos.

Esta entrada de blog proporciona una compilación categorizada de preguntas de entrevista de Unity, que van desde niveles básicos hasta expertos, incluidas preguntas de opción múltiple específicas de Unity. Estas preguntas están diseñadas para ayudar a los reclutadores y gerentes de contratación a evaluar a los candidatos de manera efectiva.

Al usar estas preguntas, puedes evaluar mejor la competencia y el ajuste de un candidato para tu equipo y considerar usar una prueba de Unity antes de la entrevista para optimizar tu proceso de contratación.

Tabla de contenido

Preguntas básicas de entrevista de Unity

Preguntas intermedias de entrevista de Unity

Preguntas avanzadas de entrevista de Unity

Preguntas de entrevista de expertos de Unity

Unity MCQ

¿Qué habilidades de Unity debes evaluar durante la fase de entrevista?

Contrata a desarrolladores de Unity cualificados con las herramientas adecuadas

Descarga la plantilla de preguntas de entrevista de Unity en múltiples formatos

1. ¿Qué es un GameObject en Unity y cómo se relaciona con un Componente?

Un GameObject en Unity es el componente fundamental de cualquier escena. Es un contenedor que puede albergar varios componentes, que definen su comportamiento y apariencia. Piense en ello como una caja vacía que llena de funcionalidades.

Un Componente, por otro lado, es una pieza de código modular que añade una funcionalidad específica a un GameObject. Por ejemplo, un componente Transform controla la posición, rotación y escala del GameObject. Un componente Rigidbody añade comportamiento físico, y un script personalizado (como un archivo .cs) puede definir lógica de juego única. Un GameObject debe tener un componente Transform, pero puede tener cero o muchos otros componentes adjuntos.

2. Explica el propósito de las funciones Update() y FixedUpdate() en Unity.

La función Update() en Unity se llama cada frame. Esto la hace adecuada para la mayoría de la lógica del juego, animaciones y manejo de entradas que no requieren una sincronización precisa. La frecuencia de Update() depende de la tasa de fotogramas del juego, que puede variar.

FixedUpdate() se llama a un intervalo de tiempo fijo. Esto es crucial para los cálculos de física. Debido a que se ejecuta a una velocidad constante, independientemente de la tasa de fotogramas, asegura un comportamiento físico predecible en diferentes hardware. Usa FixedUpdate() para aplicar fuerzas, torques o manipular directamente los componentes Rigidbody. Por ejemplo, cualquier código que use Rigidbody.AddForce debería estar en FixedUpdate().

3. ¿Cómo se crea un Prefab en Unity, y por qué son útiles?

Para crear un Prefab en Unity, simplemente arrastra un GameObject desde tu Scene Hierarchy a la ventana Project. Esto crea un recurso reutilizable de ese GameObject, incluyendo sus componentes, objetos hijos y ajustes.

Los Prefabs son útiles porque te permiten crear múltiples instancias del mismo objeto con propiedades consistentes. Si más tarde necesitas cambiar algo acerca de todas las instancias de ese objeto, simplemente puedes modificar el Prefab, y todas las instancias se actualizarán automáticamente. Esto promueve la reutilización del código, reduce errores y facilita mucho la gestión de la escena. Por ejemplo, imagina que tienes un prefab Enemigo. Cambiar el valor de salud del prefab base actualizará todas las instancias del Enemigo presentes en tu escena. Esto ahorra mucho tiempo y también ayuda a prevenir errores.

4. ¿Cuáles son los diferentes tipos de Colliders en Unity y cómo funcionan?

Los Colliders en Unity definen la forma de un objeto para propósitos de colisiones físicas. Unity proporciona varios tipos de colliders, cada uno adecuado para diferentes formas y consideraciones de rendimiento. Los tipos principales son:

- Box Collider: Un prisma rectangular simple. Eficiente para formas básicas como paredes o cajas.

- Sphere Collider: Una forma de esfera. Bueno para representar bolas u objetos con una forma aproximadamente esférica.

- Capsule Collider: Una forma de cápsula (cilindro con extremos hemisféricos). Útil para controladores de personajes.

- Mesh Collider: Usa la malla real del objeto para la colisión. Puede ser muy preciso, pero también el que más consume recursos de rendimiento. Puede ser Convexo o no. Los Mesh Colliders Convexos pueden colisionar con otros Mesh colliders. Los colliders no convexos solo pueden colisionar con colliders primitivos como Box, Sphere o Capsule.

- Terrain Collider: Diseñado específicamente para objetos Terrain de Unity, optimizado para paisajes grandes y complejos.

- Wheel Collider: Se utiliza para simular el comportamiento de las ruedas de los vehículos. Maneja la suspensión, la fricción y el par motor.

- Composite Collider 2D: Se utiliza con física 2D, fusionan múltiples colliders 2D en uno para optimización. Esto se usa a menudo con Tilemap Colliders.

Los colliders funcionan detectando cuándo sus formas se superponen con otros colliders en la escena. Cuando ocurre una colisión, Unity puede activar eventos como OnCollisionEnter, OnCollisionStay y OnCollisionExit, lo que permite que los scripts reaccionen a la colisión. Para la física 2D, existen métodos análogos que comienzan con OnTrigger y OnCollision respectivamente.

5. Describe la diferencia entre Instantiate() y Destroy() en Unity.

En Unity, Instantiate() y Destroy() son funciones fundamentales para administrar objetos en una escena.

Instantiate() crea una nueva instancia de un prefab u objeto existente. Esencialmente clona un objeto, lo que le permite crear dinámicamente nuevos objetos de juego durante el tiempo de ejecución. Por ejemplo: GameObject newObject = Instantiate(myPrefab, position, rotation);. Destroy(), por otro lado, elimina un objeto de la escena. Cuando se llama a Destroy(gameObject), el gameObject especificado se marca para su eliminación. La eliminación real ocurre al final del frame.

6. ¿Cuál es el propósito de un componente Rigidbody en Unity?

El componente Rigidbody en Unity permite que un GameObject sea controlado por el motor de física de Unity. Esencialmente, le da a un objeto masa, inercia y la capacidad de colisionar con otros objetos y responder a fuerzas como la gravedad. Sin un Rigidbody, un objeto es cinemático y debe moverse directamente a través de su componente Transform. Las interacciones de física de Rigidbody son las que crean movimiento y colisiones realistas.

Específicamente, agregar un Rigidbody hace lo siguiente:

- Permite que el objeto sea afectado por la gravedad.

- Permite que el objeto colisione con otros objetos que tienen colliders.

- Permite aplicar fuerzas y torques al objeto para controlar su movimiento y rotación utilizando métodos como

AddForce()yAddTorque().

7. ¿Cómo se pueden detectar colisiones entre GameObjects en Unity?

En Unity, puedes detectar colisiones entre GameObjects usando varios métodos. Los enfoques principales implican el uso del sistema de detección de colisiones integrado de Unity, que se basa en los componentes Collider y Rigidbody. Para detectar colisiones, al menos uno de los GameObjects que colisionan debe tener un componente Rigidbody adjunto. Hay métodos OnCollisionEnter, OnCollisionStay y OnCollisionExit para rastrear el evento de colisión. Estos se utilizan cuando se desean interacciones de colisión física como rebotar o aplicar fuerza.

Otro enfoque es usar trigger colliders. Los triggers permiten que los GameObjects se atraviesen entre sí mientras aún detectan el contacto. Puedes usar los métodos OnTriggerEnter, OnTriggerStay y OnTriggerExit para este tipo de interacciones. Estos métodos proporcionan un parámetro Collision o Collider que contiene información sobre el otro GameObject involucrado en la colisión. Ejemplo:

void OnCollisionEnter(Collision collision) { Debug.Log("Colisionó con: " + collision.gameObject.name); }

8. Explica el concepto de relaciones padre-hijo entre GameObjects en el editor de Unity. Por qué y cuándo podría ser útil.

En Unity, la relación padre-hijo entre GameObjects establece una jerarquía. El GameObject hijo hereda las transformaciones (posición, rotación, escala) de su padre. Mover, rotar o escalar el padre también afectará al hijo. Esto crea una dependencia donde el hijo se posiciona relativamente al padre.

Esta relación es útil por varias razones:

- Organización: Ayuda a estructurar la escena de manera lógica.

- Objetos complejos: Combinar múltiples GameObjects en una única unidad funcional. Por ejemplo, un coche puede ser un objeto padre y las ruedas pueden ser hijos. Mover el coche mueve las ruedas junto con él.

- Posicionamiento relativo: Mantener distancias y orientaciones relativas entre objetos. Si quieres que el arma de un personaje siempre se sujete en la misma posición relativa en su mano, haz que el arma sea un hijo del GameObject mano.

- Control simplificado: Permite el control de múltiples objetos a través de un solo objeto padre. Esto simplifica la escritura de scripts y la animación.

9. ¿Qué son los Render Pipelines de Unity? Explique brevemente el Universal Render Pipeline (URP) y el High Definition Render Pipeline (HDRP).

Los render pipelines de Unity son rutas de renderizado preconstruidas que definen cómo el motor renderiza los gráficos. Dictan la iluminación, el sombreado y otros efectos visuales. Los tres pipelines principales son el Built-in Render Pipeline (heredado), el Universal Render Pipeline (URP) y el High Definition Render Pipeline (HDRP).

URP es un render pipeline programable diseñado para la escalabilidad en una amplia gama de plataformas, desde móviles hasta PCs de gama alta. Proporciona gráficos optimizados y de alto rendimiento adecuados para proyectos dirigidos a múltiples plataformas. HDRP, por otro lado, es un render pipeline programable orientado a gráficos de alta fidelidad en hardware de gama alta. Ofrece características avanzadas como iluminación realista, efectos volumétricos y modelos de sombreado de materiales avanzados, ideal para PC, consolas y plataformas similares que priorizan la calidad visual.

10. ¿Qué es un Material en Unity y cómo se usa?

En Unity, un Material define cómo se debe renderizar una superficie. Esencialmente, es una receta que le dice al motor de renderizado de Unity cómo la luz debe interactuar con un objeto específico. Los Materiales contienen información sobre el color, la textura, el brillo del objeto, si debe ser opaco o transparente, y mucho más.

Los Materiales se utilizan asignándolos a componentes Renderer (como MeshRenderer o SkinnedMeshRenderer) adjuntos a GameObjects. Al cambiar el Material de un GameObject, puede alterar radicalmente su apariencia sin cambiar la malla subyacente. Puede ajustar las propiedades del material en el Inspector o mediante scripting. Por ejemplo, para cambiar el color de un material a través del código, podría usar:

GetComponent<Renderer>().material.color = Color.red;

11. Explique la diferencia entre Vector2, Vector3 y Vector4 en Unity.

En Unity, Vector2, Vector3 y Vector4 representan vectores de 2, 3 y 4 dimensiones, respectivamente. Vector2 se usa comúnmente para gráficos 2D e interfaz de usuario, almacenando componentes x e y que representan la posición o la dirección en un espacio 2D. Vector3 se usa de manera más amplia para posiciones, direcciones y fuerzas 3D, que contienen componentes x, y e z.

Vector4 se usa con menos frecuencia, pero puede representar un vector 4D, a menudo útil para almacenar datos de color (RGBA) donde x, y, z y w representan los canales rojo, verde, azul y alfa, respectivamente, o cuando se necesitan coordenadas homogéneas en gráficos 3D o cálculos especializados.

12. ¿Cómo puedes reproducir un clip de audio en Unity?

En Unity, puedes reproducir un clip de audio utilizando el componente AudioSource. Primero, necesitas un componente AudioSource adjunto a un GameObject. Luego, puedes asignar un AudioClip al AudioSource. Finalmente, puedes usar el método AudioSource.Play() para reproducir el clip. Aquí hay un código de ejemplo:

AudioSource audioSource = GetComponent<AudioSource>(); audioSource.clip = myAudioClip; audioSource.Play();

Alternativamente, para sonidos simples y únicos, puedes usar AudioSource.PlayClipAtPoint(). Esto crea un GameObject temporal con un AudioSource en una posición específica y reproduce el clip.

AudioSource.PlayClipAtPoint(myAudioClip, transform.position);

13. Describe cómo implementar el movimiento básico de un personaje en Unity (por ejemplo, usando la entrada del teclado).

Para implementar el movimiento básico de personajes en Unity usando la entrada del teclado, normalmente se utiliza el componente CharacterController o Rigidbody. Si se utiliza el CharacterController, en un script de C# adjunto al personaje, se utilizaría Input.GetAxis para obtener la entrada horizontal y vertical (por ejemplo, los ejes "Horizontal" y "Vertical" se asignan a las teclas A/D o flecha izquierda/derecha, y W/S o flecha arriba/abajo respectivamente). Luego, se crea un vector de movimiento multiplicando los valores de entrada con una variable de velocidad. Finalmente, se llama a CharacterController.Move(movementVector * Time.deltaTime) para mover al personaje. Time.deltaTime asegura que el movimiento sea independiente de la velocidad de fotogramas.

Si se utiliza Rigidbody, se usará AddForce para controlar el movimiento. La entrada del teclado es la misma que para el CharacterController, pero en lugar de llamar a Move, se usará rigidbody.AddForce(movementVector * speed). A continuación, se muestra un código de ejemplo que demuestra el movimiento con CharacterController.

using UnityEngine; public class PlayerMovement : MonoBehaviour { public CharacterController controller; public float speed = 5f; void Update() { float x = Input.GetAxis("Horizontal"); float z = Input.GetAxis("Vertical"); Vector3 move = transform.right * x + transform.forward * z; move = move.normalized * speed; controller.Move(move * Time.deltaTime); } }

14. ¿Qué es una escena en Unity y cómo se cambia entre escenas?

En Unity, una escena es un contenedor que contiene todos los objetos del juego, activos y scripts que componen una parte específica de tu juego, como un nivel, un menú o una escena cinemática. Piensa en ello como un solo mapa o ubicación en el mundo de tu juego.

Para cambiar entre escenas, normalmente usas el método SceneManager.LoadScene(). Puedes cargar una escena por su nombre (cadena) o por su índice en la configuración de compilación. Aquí tienes un ejemplo en C#:

using UnityEngine.SceneManagement; public class SceneSwitcher : MonoBehaviour { public void LoadNextScene(string sceneName) { SceneManager.LoadScene(sceneName); } }

Asegúrate de que las escenas a las que quieres cambiar se agreguen a la configuración de compilación (Archivo -> Configuración de compilación).

15. ¿Cómo puedes almacenar y cargar datos en Unity (por ejemplo, puntuaciones de jugadores o configuraciones del juego)?

En Unity, las puntuaciones de los jugadores o las configuraciones del juego se pueden almacenar y cargar utilizando varios métodos. PlayerPrefs es una opción sencilla para almacenar pequeñas cantidades de datos como puntuaciones, configuraciones o nombres de jugadores. Es fácil de usar, pero no es adecuado para datos grandes o complejos. Los datos se almacenan localmente en el dispositivo del usuario utilizando almacenamiento específico de la plataforma.

Para estructuras de datos más complejas o conjuntos de datos más grandes, considere usar la serialización. Esto implica convertir objetos de Unity a un formato que se pueda almacenar en un archivo (por ejemplo, JSON o XML). La clase JsonUtility o bibliotecas como Newtonsoft.Json pueden serializar y deserializar objetos de C# desde y hacia JSON. La serialización binaria es otra opción, sin embargo, menos legible por humanos y menos compatible. Después de serializar a una cadena (por ejemplo, JSON), puede escribirla en un archivo usando System.IO. La carga de los datos implica leer el archivo y deserializarlo de nuevo en objetos de Unity.

16. Explique el propósito de las funciones Start() y Awake() en Unity.

En Unity, tanto Awake() como Start() son funciones del ciclo de vida, pero sirven para propósitos distintos. Awake() se llama cuando se está cargando una instancia de script, independientemente de si el script está habilitado o deshabilitado. Se utiliza principalmente para tareas de inicialización que deben ocurrir antes de que comience el juego, como configurar referencias o inicializar variables. Es importante destacar que Awake() se llama solo una vez durante la vida útil de la instancia del script.

Start(), por otro lado, se llama solo una vez en la vida útil del script, pero después de Awake(). Start() solo se llama si la instancia del script está habilitada. A menudo se usa para la inicialización que se basa en que otros scripts se inicialicen o para tareas que deben retrasarse hasta que el juego realmente comience. Si necesita asegurar un orden de ejecución específico o si necesita interactuar con otros componentes que podrían no estar completamente inicializados durante Awake(), Start() es la mejor opción.

17. ¿Cuál es la diferencia entre usar Translate() y AddForce() para mover un GameObject?

Translate() manipula directamente la transform.position de un GameObject, moviéndolo instantáneamente sin considerar la física. Es ideal para movimientos simples, teletransportación o cuando se necesita un posicionamiento preciso, ignorando colisiones y fuerzas. No interactúa con el motor de física en absoluto.

AddForce(), por otro lado, aplica una fuerza al Rigidbody del GameObject, lo que hace que se acelere y se mueva en función de su masa, arrastre y otras propiedades físicas. Es adecuado para movimientos realistas influenciados por la física, como empujar, lanzar o simular la gravedad. AddForce() considera las colisiones y otras fuerzas en la escena.

18. ¿Cómo se crea un elemento de interfaz de usuario (UI) simple (por ejemplo, un botón o una etiqueta de texto) en Unity?

En Unity, puede crear elementos de interfaz de usuario utilizando el espacio de nombres UnityEngine.UI. Por ejemplo, para crear un botón, normalmente usaría el Editor de Unity. Vaya a GameObject > UI > Button. Esto crea automáticamente un Canvas y un EventSystem si aún no existen.

Alternativamente, puedes crear elementos de interfaz de usuario (UI) programáticamente. Primero, añade using UnityEngine.UI; a tu script. Luego, instancia un GameObject, añade un componente Button a él, y establece sus propiedades como la posición y el texto usando código. Ejemplo:

GameObject buttonObject = new GameObject("MyButton"); Button button = buttonObject.AddComponent<Button>(); // Establece el padre del botón al lienzo buttonObject.transform.SetParent(canvas.transform, false);

19. Explica el concepto de raycasting en Unity y cómo se puede usar.

El raycasting en Unity es una técnica usada para proyectar un rayo invisible desde un punto en una dirección especificada y detectar colisiones con objetos en su camino. Esto te permite determinar qué objetos están frente al emisor del rayo y a qué distancia se encuentran. La función Physics.Raycast() es la forma principal de implementar esto. Retorna true si el rayo golpea algo, y proporciona información sobre el impacto, como el colisionador, el punto de contacto, y la normal de la superficie.

El raycasting se usa para una amplia gama de propósitos. Los ejemplos incluyen:

- Detección en el suelo del controlador de personajes: Determinar si un personaje está de pie en el suelo lanzando un rayo hacia abajo.

- Selección de objetos: Hacer clic en objetos de la escena lanzando un rayo desde la cámara a través de la posición del cursor del ratón.

- Línea de visión de la IA: Comprobar si un agente de IA puede ver al jugador lanzando un rayo desde el agente al jugador.

- Rayos láser/Proyectiles: Simular rayos láser o proyectiles comprobando las colisiones a lo largo de su trayectoria. Por ejemplo:

if (Physics.Raycast(transform.position, transform.forward, out hit, 10f)) { Debug.Log("¡Algo golpeado!"); }

20. ¿Qué es un ScriptableObject en Unity y cuáles son algunos casos de uso?

Un ScriptableObject es un contenedor de datos en Unity que permite almacenar grandes cantidades de datos, independientemente de las instancias de clase. A diferencia de los MonoBehaviours, los ScriptableObjects no necesitan estar adjuntos a los GameObjects. Se almacenan como activos en tu proyecto.

Algunos casos de uso comunes incluyen:

- Almacenar datos de configuración del juego (por ejemplo, estadísticas de personajes, definiciones de elementos).

- Crear plantillas de datos reutilizables.

- Gestionar la lógica compleja del juego desacoplando los datos del código.

- Reducir el uso de memoria compartiendo datos entre múltiples objetos.

Ejemplo:

[CreateAssetMenu(fileName = "NuevoItem", menuName = "Inventario/Item")] public class ItemData : ScriptableObject { public string itemName; public string descripción; public Sprite icon; public int maxStackSize; }

21. Describe cómo controlarías las animaciones en Unity utilizando un controlador de Animator.

En Unity, controlaría las animaciones usando un Controlador de Animación. El Controlador de Animación actúa como una máquina de estados donde cada estado representa una animación o un árbol de mezcla de animación. Las transiciones entre estos estados se rigen por condiciones, típicamente basadas en parámetros (variables) definidos dentro del Animador. Estos parámetros pueden ser de varios tipos como float, int, bool o trigger, y se controlan mediante scripting para influir en qué animación se está reproduciendo en un momento dado.

Por ejemplo, para hacer la transición de un estado 'Idle' a un estado 'Walking', crearía una transición en el Controlador de Animación. Luego agregaría una condición a esta transición, como un parámetro booleano 'isWalking'. En el script, establecería animator.SetBool("isWalking", true) para iniciar la transición a la animación 'Walking'. Por el contrario, configurarlo en false volvería a la transición al estado 'Idle'. Los árboles de mezcla podrían usarse para comportamientos más complejos, como variar la velocidad de caminar según un parámetro float. Usar animator.Play("MyAnimation") permite forzar la reproducción de una determinada animación.

22. ¿Cuál es el propósito del componente Canvas en el sistema UI de Unity?

El componente Canvas en el sistema UI de Unity sirve como la base para todos los elementos de la interfaz de usuario. Es un contenedor que define el área donde se renderizan los elementos de la interfaz de usuario. Piense en él como la superficie de dibujo para su interfaz de usuario.

El Canvas gestiona cómo se escalan y renderizan los elementos de la interfaz de usuario basándose en el modo de renderizado elegido (Screen Space - Overlay, Screen Space - Camera, o World Space). También gestiona los eventos de entrada, asegurando que los elementos de la interfaz de usuario respondan a las interacciones del usuario como clics y toques.

23. Explique cómo puede manejar la entrada del usuario (por ejemplo, teclado, ratón, táctil) en Unity.

En Unity, el manejo de la entrada del usuario implica el uso de la clase Input. Para la entrada del teclado, puede usar métodos como Input.GetKey(), Input.GetKeyDown() e Input.GetKeyUp() para detectar pulsaciones de teclas. Para la entrada del ratón, métodos como Input.GetMouseButton(), Input.GetMouseButtonDown() e Input.GetMouseButtonUp() detectan eventos de los botones del ratón, e Input.mousePosition da las coordenadas de la pantalla del ratón. La entrada táctil se puede gestionar utilizando Input.touchCount para obtener el número de toques, e Input.GetTouch(index) para recuperar un objeto Touch específico, que contiene información como la posición, la fase (comenzó, movido, finalizado, etc.) y el número de toques.

Para esquemas de entrada más complejos, considere usar el Administrador de Entrada de Unity (Editar > Configuración del proyecto > Administrador de Entrada) o el nuevo paquete Sistema de Entrada. El Administrador de Entrada le permite definir ejes y acciones, asignándolos a varias fuentes de entrada. El nuevo Sistema de Entrada proporciona más flexibilidad con el soporte de dispositivos y los mapas de acciones de entrada, y usa eventos o callbacks de C# para responder a eventos de entrada. El uso de Input.GetAxis() y Input.GetAxisRaw() le permitirá configurar los ejes.

Preguntas de entrevista intermedias de Unity

1. Explique la diferencia entre `OnEnable` y `Awake` en el ciclo de vida del script de Unity.

Awake se llama solo una vez durante la vida útil del script, cuando se está cargando la instancia del script. Se usa para inicializar variables y configurar componentes antes de que comience el juego. OnEnable se llama cada vez que el script se habilita y se activa. Esto puede suceder varias veces durante la vida útil del script.

Piénselo de esta manera: Awake es para la inicialización única, mientras que OnEnable es para cuando el script se activa. OnEnable también se llama después de Awake cuando el objeto se instancia por primera vez. Los usos comunes de OnEnable incluyen el registro de eventos, la suscripción a delegados o la reinicialización de estados cuando un objeto se agrupa y se reactiva.

Considere el siguiente ejemplo:

using UnityEngine; public class ExampleScript : MonoBehaviour { void Awake() { Debug.Log("Awake llamado"); } void OnEnable() { Debug.Log("OnEnable llamado"); } }

2. ¿Cómo implementaría una máquina de estados finitos (FSM) simple en Unity para la IA de personajes?

Un FSM simple en Unity se puede implementar usando una enum para representar los estados y una declaración switch (o un diccionario) para manejar las transiciones y acciones entre estados. El script de IA del personaje tendría una variable para almacenar el estado actual. Cada estado dentro del enum correspondería a un comportamiento específico (por ejemplo, Inactivo, Patrulla, Perseguir). El método Update() contendría la declaración switch, ejecutando diferentes bloques de código basados en el estado actual. Estos bloques de código manejarían la lógica específica del estado y determinarían cuándo hacer la transición a un nuevo estado.

Por ejemplo:

enum AIState { Inactivo, Patrulla, Perseguir } AIState currentState = AIState.Inactivo; void Update() { switch (currentState) { case AIState.Inactivo: // Lógica de inactividad if (/condición para perseguir/) { currentState = AIState.Perseguir; } break; case AIState.Patrulla: // Lógica de patrulla break; case AIState.Perseguir: // Lógica de persecución break; } }

Para gestionar un comportamiento más complejo, considera usar un diccionario para mapear estados a funciones o acciones. Esto evita sentencias switch profundamente anidadas y promueve un código más limpio y fácil de mantener.

3. Describe el uso de los Scriptable Objects. Proporciona ejemplos de cuándo son más útiles.

Los Scriptable Objects son contenedores de datos que almacenan información independiente de las instancias de script. A diferencia de los scripts MonoBehaviour regulares adjuntos a GameObjects, los Scriptable Objects no están adjuntos a objetos de escena; en cambio, existen como activos en tu proyecto. Esto te permite almacenar datos y compartirlos entre múltiples objetos o escenas sin duplicar los datos en la memoria.

Son más útiles para:

- Datos de configuración: Almacenar la configuración del juego, las estadísticas de los personajes o las definiciones de los objetos. Por ejemplo, definir diferentes tipos de enemigos con valores de salud, daño y velocidad.

- Datos compartidos: Representar datos a los que necesitan acceder y modificar múltiples objetos. Por ejemplo, un gestor de recursos o un sistema de eventos global.

- Persistencia de datos: Almacenar datos que persisten entre sesiones de juego. Puedes guardar y cargar Scriptable Objects para almacenar el progreso del jugador o el estado del juego.

- Crear plantillas de datos reutilizables: Crear estadísticas base para objetos y personajes.

[CreateAssetMenu(fileName = "NewCharacterData", menuName = "Character Data")] public class CharacterData : ScriptableObject { public string characterName; public int health; public float speed; }

4. ¿Cuáles son algunas ventajas y desventajas de usar prefabs en Unity?

Los prefabs en Unity ofrecen varias ventajas. Promueven la reutilización al permitirte crear un objeto plantilla que se puede instanciar múltiples veces, asegurando la consistencia en toda tu escena. Esto acelera significativamente el desarrollo y reduce el riesgo de errores. Hacer cambios en el prefab actualiza automáticamente todas las instancias, ahorrando un tiempo considerable durante los ajustes.

Sin embargo, los prefabs también tienen desventajas. El uso excesivo puede llevar a estructuras rígidas, lo que dificulta la introducción de variaciones si muchas instancias necesitan modificaciones leves. Si bien existen variantes de prefab, la gestión de jerarquías complejas de variantes puede volverse engorrosa. Además, los prefabs profundamente anidados a veces pueden afectar el rendimiento debido a la mayor sobrecarga de la gestión de numerosos objetos interconectados.

5. Explica el propósito del raycasting y cómo lo usarías para detectar objetos en el espacio 3D.

El raycasting es una técnica utilizada para encontrar qué objetos están en la línea de visión de un rayo. Esencialmente, lanzas un rayo invisible desde un punto en una dirección específica y detectas el primer objeto con el que el rayo se cruza. Esto es muy útil para la detección de objetos, la detección de colisiones e incluso cosas como determinar si un personaje está mirando a un objeto específico en el espacio 3D.

Para detectar objetos, primero debes definir el punto de origen del rayo y la dirección en la que viaja. Luego, utilizando una función de raycasting proporcionada por un motor de juego o una implementación personalizada, verificarías las intersecciones con los objetos en la escena. La función normalmente devuelve información sobre el punto de intersección, la distancia al objeto y el objeto que fue golpeado. Luego puedes usar esta información para determinar qué objeto fue detectado y actuar en consecuencia; por ejemplo, activar un evento o realizar algún cálculo. Usarlo podría verse así:

Ray ray(origen, dirección); RaycastHit hitInfo; if (Physics.Raycast(ray, out hitInfo, maxDistance)) { GameObject hitObject = hitInfo.collider.gameObject; // Haz algo con el hitObject }

6. ¿Cómo se optimiza un juego de Unity para dispositivos móviles?

Optimizar un juego de Unity para dispositivos móviles involucra varias áreas clave. Primero, optimiza los activos: reduce los tamaños de las texturas, utiliza compresión de texturas (como ETC1/2, ASTC), minimiza el recuento de polígonos en los modelos y utiliza compresión de audio. Emplea nivel de detalle (LOD) para reducir el detalle de los objetos distantes. Optimiza los shaders utilizando versiones amigables para móviles y minimizando los cálculos complejos. Utiliza atlas de texturas y hojas de sprites para reducir las llamadas de dibujo.

Segundo, optimice el código y el rendimiento: use la agrupación de objetos para reducir la recolección de basura, evite usar funciones Find en exceso, use corrutinas de manera eficiente y perfile su juego con frecuencia usando el Profiler de Unity para identificar cuellos de botella en el rendimiento. Mantenga sus scripts livianos y evite cálculos innecesarios por cuadro. Al desarrollar, apunte a un perfil de hardware específico (dispositivos móviles de gama baja/media/alta).

7. ¿Qué es una corrutina y cuándo la usaría?

Una corrutina es una función que puede suspender su ejecución y reanudarla más tarde, permitiendo que se ejecute otro código mientras tanto. Es una forma de concurrencia, pero a diferencia de los hilos, las corrutinas normalmente se ejecutan dentro de un solo hilo y se administran en el espacio del usuario, lo que las hace livianas.

Use corrutinas cuando necesite realizar operaciones asíncronas o administrar tareas concurrentes sin la sobrecarga de los hilos tradicionales. Los casos de uso comunes incluyen:

- Tareas de E/S (Entrada/Salida): Manejo de solicitudes de red, operaciones de archivos o consultas de bases de datos sin bloquear el hilo principal.

- Concurrencia: Gestión de múltiples tareas concurrentemente, como en el desarrollo de juegos o la programación basada en eventos.

- Implementación de generadores: Creación de iteradores que producen valores a pedido, ahorrando memoria y mejorando el rendimiento.

- Programación asíncrona: Simplificación de la programación asíncrona con las palabras clave

async/await, haciendo que el código sea más legible y mantenible en comparación con las devoluciones de llamada (callbacks).

8. Describa diferentes métodos de detección de colisiones en Unity (por ejemplo, disparadores vs. colisiones) y sus casos de uso respectivos.

En Unity, la detección de colisiones utiliza principalmente dos métodos: Disparadores y Colisiones. Los disparadores se activan cuando un Collider entra en su espacio. Los objetos que pasan a través de un disparador no experimentan ninguna interacción física o respuesta de colisión. Son útiles para eventos como recolectar elementos, entrar en una nueva área o activar sensores. Típicamente usamos los métodos OnTriggerEnter, OnTriggerStay y OnTriggerExit para manejar eventos de disparador. Observe que la propiedad IsTrigger debe estar habilitada en el Collider.

Las colisiones, por otro lado, representan interacciones físicas entre objetos con componentes Collider y Rigidbody (al menos un objeto debe tener un Rigidbody no cinemático). Cuando los objetos colisionan, el motor de física de Unity calcula la respuesta basada en sus propiedades físicas. Las colisiones se gestionan mediante los métodos OnCollisionEnter, OnCollisionStay y OnCollisionExit. Estos se utilizan para interacciones físicas realistas como que los objetos reboten entre sí, detengan el movimiento o apliquen fuerzas. El componente Rigidbody es esencial para cualquier objeto que necesite ser afectado por el motor de física de Unity para que la colisión funcione.

Por ejemplo, si quisiéramos comprobar si un jugador entró en un área determinada, podemos usar un collider de activación de la siguiente manera:

void OnTriggerEnter(Collider other) { if (other.gameObject.CompareTag("Player")) { Debug.Log("Player entered the area."); } }

Si, sin embargo, quisiéramos crear una pelota que rebota, podemos adjuntarle componentes Rigidbody y Collider. Entonces, no necesitamos escribir ningún código para implementar el rebote, ya que será gestionado por el motor de física de Unity.

9. ¿Cómo se puede utilizar el profiler de Unity para identificar y resolver cuellos de botella de rendimiento?

El Profiler de Unity es una herramienta poderosa para identificar cuellos de botella de rendimiento. Para usarlo, primero habilite el Profiler (Ventana > Análisis > Profiler). Luego, ejecute su juego/aplicación y observe las diversas secciones: CPU, Memoria, Renderizado, Audio, etc. Busque picos o valores consistentemente altos en cualquiera de estas secciones. Específicamente, preste atención al Uso de CPU, observando qué funciones consumen más tiempo (Deep Profile puede ayudar). También analice Renderizado, por ejemplo, altos SetPass Calls o Batches podrían indicar problemas de shader o de llamadas de dibujo. Las altas asignaciones de memoria o eventos de recolección de basura (en Memoria) también pueden afectar significativamente el rendimiento. Una vez que se identifica un cuello de botella, puede abordarlo optimizando el código (por ejemplo, reduciendo cálculos complejos, almacenando en caché los resultados), reduciendo las llamadas de dibujo (por ejemplo, usando batching estático, instancing de GPU), optimizando el uso de memoria (por ejemplo, agrupación de objetos, evitando asignaciones innecesarias) o optimizando los activos (por ejemplo, comprimiendo texturas, reduciendo el recuento de polígonos).

10. Explique la diferencia entre el renderizado directo y el renderizado diferido en Unity.

El renderizado directo y el renderizado diferido son dos rutas de renderizado diferentes en Unity. En el renderizado directo, cada objeto en la escena se renderiza en una o más pasadas, y los cálculos de iluminación se realizan para cada objeto durante estas pasadas. Este enfoque es simple de implementar y admite funciones como la transparencia y MSAA (Anti-Aliasing de Muestreo Múltiple) fácilmente. Sin embargo, el costo de renderizado aumenta linealmente con el número de luces y objetos, ya que los cálculos de iluminación se repiten para cada objeto visible por luz.

En el renderizado diferido, el proceso de renderizado se divide en dos pases principales. En el primer pase, la geometría de la escena se renderiza en múltiples texturas llamadas G-buffer. Este buffer típicamente contiene información como color, normal y profundidad. En el segundo pase, los cálculos de iluminación se realizan utilizando los datos almacenados en el G-buffer. Este enfoque permite renderizar un gran número de luces de manera eficiente porque los cálculos de iluminación se realizan por píxel en lugar de por objeto. Sin embargo, tiene limitaciones como la dificultad para manejar la transparencia y la falta de soporte MSAA incorporado.

11. ¿Cómo implementas un patrón Singleton en Unity?

Para implementar el patrón Singleton en Unity, típicamente creas un script de C# que asegura que solo exista una instancia de una clase. Esto generalmente se logra usando una variable de instancia estática y un método GetInstance(). En el método Awake(), el script comprueba si ya existe una instancia; si es así, la instancia actual se destruye para evitar duplicados.

Aquí hay un ejemplo simple:

public class MiSingleton : MonoBehaviour { private static MiSingleton _instancia; public static MiSingleton Instance { get { if (_instancia == null) { _instancia = FindObjectOfType<MiSingleton>(); if (_instancia == null) { GameObject singleton = new GameObject("MiSingleton"); _instancia = singleton.AddComponent<MiSingleton>(); } } return _instancia; } } private void Awake() { if (_instancia != null && _instancia != this) { Destroy(this.gameObject); return; } _instancia = this; DontDestroyOnLoad(this.gameObject); // Opcional: Persistir a través de la carga de escenas } // La funcionalidad de tu singleton aquí }

12. Describe cómo usar el sistema de interfaz de usuario (UI) de Unity (uGUI) para crear interfaces de usuario responsivas.

Para crear interfaces de usuario responsivas en Unity usando uGUI, aprovecha los anclajes y los puntos de pivote. Los anclajes definen cómo un elemento de la interfaz de usuario se reposiciona y cambia de tamaño en relación con su padre. Usa los ajustes preestablecidos de anclaje para configurar rápidamente posiciones de anclaje comunes (por ejemplo, arriba-izquierda, abajo-derecha, estirar). El punto de pivote determina el origen de la escala y la rotación. Además, usa el componente Canvas Scaler, estableciendo su Modo de Escala UI en 'Escalar con el tamaño de la pantalla' es importante. Configura la resolución de referencia y el modo de coincidencia de pantalla para asegurar que la interfaz de usuario se escale apropiadamente en diferentes tamaños de pantalla.

Considera usar Layout Groups (Horizontal, Vertical, Grid) para organizar automáticamente los elementos de la interfaz de usuario. Esto simplifica los diseños dinámicos, especialmente cuando el contenido cambia. El componente Content Size Fitter se puede usar para cambiar el tamaño automáticamente de los elementos de la interfaz de usuario basándose en su contenido. Es crucial probar la interfaz de usuario en diferentes resoluciones y relaciones de aspecto para asegurar la capacidad de respuesta.

13. ¿Cuáles son los diferentes tipos de luces en Unity y cómo afectan al rendimiento?

Unity tiene varios tipos de luces, cada uno con diferentes características de rendimiento. Las luces direccionales simulan fuentes de luz distantes como el sol y generalmente son las más económicas, ya que solo requieren un único mapa de sombras. Las luces puntuales emiten luz desde un solo punto en todas las direcciones y son más caras, especialmente con sombras, porque potencialmente afectan a muchos objetos. Las luces de foco son similares a las luces puntuales pero emiten luz en un cono, lo que las hace más eficientes que las luces puntuales cuando solo se necesita luz en un área específica. Finalmente, las luces de área son las más caras, ya que calculan la luz desde un rectángulo o un cuadrilátero. Son útiles para la iluminación realista, particularmente para escenas de interiores, pero deben usarse con moderación debido a su alto costo de rendimiento.

Los principales factores que afectan el rendimiento de la luz son el número de luces, el tipo de luces, el casting de sombras y la ruta de renderizado utilizada. Las sombras en tiempo real son muy costosas, por lo que considere usar iluminación horneada siempre que sea posible, especialmente para objetos estáticos. Las rutas de renderizado de Unity (Forward vs. Deferred) también impactan en el rendimiento de la iluminación. El renderizado Deferred generalmente maneja mejor muchas luces, pero tiene su propia sobrecarga de rendimiento. Finalmente, el uso de mapas de luz puede mejorar dramáticamente el rendimiento al precalcular la iluminación para objetos estáticos.

14. Explique cómo implementar un sistema de animación simple usando el Controlador de Animación.

Para implementar un sistema de animación simple usando el Controlador de Animación de Unity, primero necesita crear un recurso de Controlador de Animación. Luego, defina los estados de animación dentro del controlador, cada uno representando un clip de animación diferente. Estos estados están conectados por transiciones, que determinan cuándo y cómo cambia la animación. Las transiciones se rigen por condiciones basadas en parámetros definidos en el Controlador de Animación, como float, int, bool y trigger.

15. ¿Cómo puedes usar el sistema NavMesh de Unity para crear personajes de IA que pueden navegar por una escena?

Para usar el sistema NavMesh de Unity para la navegación de IA, primero, hornea una NavMesh. Esto implica seleccionar objetos de juego estáticos que forman las superficies transitables y usar la ventana de Navegación para generar la NavMesh. Luego, agrega un componente NavMeshAgent a tu personaje de IA. El NavMeshAgent maneja la búsqueda de rutas y el movimiento. Luego, puedes controlar el movimiento de la IA estableciendo la propiedad destination del NavMeshAgent en un script, por ejemplo: GetComponent<NavMeshAgent>().destination = targetPosition;

Además, puedes usar la función NavMesh.CalculatePath para determinar la validez de una ruta antes de establecer un destino. Para escenarios más complejos, considera incorporar cosas como la evasión de obstáculos y los enlaces fuera de la malla para manejar saltos u otros recorridos no relacionados con la malla de navegación. Considera utilizar raycasting u otros mecanismos de detección para detectar el entorno. Utiliza NavMeshObstacle para obstáculos dinámicos.

16. Describe cómo manejar diferentes resoluciones de pantalla y relaciones de aspecto en un juego de Unity.

Para manejar diferentes resoluciones de pantalla y relaciones de aspecto en Unity, usa el componente Canvas Scaler en tu interfaz de usuario (UI). Establece el UI Scale Mode en Scale With Screen Size. Luego, especifica una Reference Resolution (por ejemplo, 1920x1080). La interfaz de usuario se escalará en consecuencia. También puedes usar anclajes y pivotes para asegurar que los elementos de la interfaz de usuario se posicionen correctamente en relación con los bordes de la pantalla.

Para los elementos de juego, ajusta el orthographicSize de la cámara (para 2D) o fieldOfView (para 3D) en función de la relación de aspecto. Considera usar diferentes configuraciones de cámara o ajustar el rectángulo de la ventana gráfica si la relación de aspecto cambia drásticamente, y asegúrate de que el mundo de tu juego esté diseñado para ser lo suficientemente flexible como para adaptarse a diferentes tamaños de pantalla sin recorte o espacio vacío excesivo. Usa código como este para obtener las dimensiones de la pantalla: Screen.width y Screen.height para ajustar el juego.

17. ¿Cuál es el propósito del atributo SerializeField y cómo funciona?

El atributo SerializeField en Unity se usa para hacer que un campo privado o protegido sea visible y accesible en la ventana Inspector del Editor de Unity. Por defecto, solo los campos públicos se serializan (guardan y cargan con la escena o el prefab). SerializeField te permite exponer campos privados específicos para su edición en el Inspector sin hacerlos públicamente accesibles a otros scripts, manteniendo así la encapsulación.

Cuando Unity encuentra SerializeField, instruye al sistema de serialización del motor para tratar ese campo como si fuera público a efectos de guardar y cargar su valor. Esto significa que el valor del campo se conservará cuando la escena se guarde, el componente se desactive y se reactive, o cuando el juego se cierre y se vuelva a abrir. Esencialmente, cierra la brecha entre los datos privados y las capacidades de edición visual del Editor de Unity.

18. Explica cómo usar el sistema de partículas de Unity para crear efectos visuales.

El sistema de partículas de Unity es una herramienta poderosa para crear efectos visuales. Para usarlo, normalmente creas un nuevo GameObject del Sistema de Partículas. Luego, en el Inspector, modificas varios módulos como Emisión, Forma, Velocidad a lo largo de la vida, Color a lo largo de la vida y Tamaño a lo largo de la vida para definir cómo se crean las partículas, cómo se mueven y cómo se ven. Puedes ajustar parámetros como el número de partículas emitidas, su velocidad inicial, su gradiente de color a lo largo del tiempo y la forma desde la cual se emiten.

Por ejemplo, para crear un efecto de fuego simple, podrías usar un emisor con forma de esfera, establecer la tasa de emisión en un valor alto y usar un gradiente de color que transicione de amarillo a naranja a rojo. También puedes usar texturas para las propias partículas y shaders para un control visual más avanzado. Puedes controlar el comportamiento de las partículas mediante scripts utilizando la API ParticleSystem en C#. Los métodos comunes incluyen Play(), Stop() y Emit() para el control directo sobre la generación de partículas.

19. ¿Cómo gestionas y organizas un proyecto grande de Unity para garantizar el mantenimiento?

Para gestionar un proyecto grande de Unity, me concentro en una organización clara y en la mantenibilidad. Utilizo un sistema de carpetas estructurado, separando los activos en categorías lógicas como _Project/Art, _Project/Scripts, _Project/Prefabs, y _Project/Scenes. Dentro de los scripts, sigo las convenciones de codificación (por ejemplo, nombres consistentes, comentarios) y utilizo espacios de nombres para evitar conflictos de nombres. El control de versiones (Git) es esencial. Refactorizar código regularmente, usar objetos scriptables para el almacenamiento de datos y emplear patrones de diseño (como el patrón Singleton o el patrón Observer) ayuda a reducir la complejidad.

Además, priorizo la modularidad. Descomponer escenas grandes y scripts complejos en componentes más pequeños y reutilizables es crucial. Utilizar prefabs de manera efectiva para evitar la duplicación también es clave. Herramientas como el Sistema de Activos Direccionables ayudan a gestionar la carga de activos y las dependencias. Para las pruebas, escribo pruebas unitarias usando el Unity Test Framework para asegurar que los componentes individuales funcionen como se espera y pruebas de integración para sistemas más grandes.

20. Describe las ventajas de usar object pooling en Unity, y cómo implementarlo.

La agrupación de objetos (Object pooling) en Unity ofrece importantes ventajas de rendimiento al reutilizar objetos existentes en lugar de instanciarlos y destruirlos constantemente. Esto es particularmente beneficioso para objetos que se crean y destruyen con frecuencia, como balas, efectos de partículas o enemigos. La instanciación y destrucción son operaciones costosas, y la agrupación de objetos reduce la sobrecarga de la recolección de basura (garbage collection), lo que conduce a una jugabilidad más fluida y un mejor rendimiento, especialmente en dispositivos móviles.

Para implementar la agrupación de objetos, normalmente se crea una colección (como una List o Queue) para almacenar objetos inactivos. Cuando se necesita un objeto, primero se comprueba si hay uno disponible en el grupo. Si es así, se reactiva (por ejemplo, configurando su SetActive(true) y reposicionándolo). Si el grupo está vacío, se instancia un nuevo objeto. Cuando ya no se necesita el objeto, se desactiva y se devuelve al grupo en lugar de destruirlo. Aquí hay un ejemplo simplificado:

public class ObjectPool : MonoBehaviour { public GameObject pooledObject; public int poolSize = 10; private List<GameObject> pool; void Start() { pool = new List<GameObject>(); for (int i = 0; i < poolSize; i++) { GameObject obj = Instantiate(pooledObject); obj.SetActive(false); pool.Add(obj); } } public GameObject GetPooledObject() { for (int i = 0; i < pool.Count; i++) { if (!pool[i].activeInHierarchy) { return pool[i]; } } return null; // Or instantiate a new one if needed } public void ReturnToPool(GameObject obj) { obj.SetActive(false); } }

21. ¿Cómo puedes crear un script de editor personalizado para extender la funcionalidad del editor de Unity?

Para crear un script de editor personalizado en Unity, creas un nuevo script de C# ubicado dentro de una carpeta Editor en el directorio Assets de tu proyecto (por ejemplo, Assets/Editor/MiEditorPersonalizado.cs). Este script hereda de UnityEditor.Editor o UnityEditor.EditorWindow. Utilizas el atributo [CustomEditor(typeof(TuScriptObjetivo))] para vincular el script del editor a un componente específico (TuScriptObjetivo).

Dentro del script, puedes anular el método OnInspectorGUI() para personalizar la ventana del Inspector para el componente objetivo. Puedes usar SerializedObject y SerializedProperty para interactuar con las propiedades del objeto objetivo, lo que permite la modificación y el guardado de valores. Las clases EditorGUILayout y EditorGUI proporcionan funciones para dibujar elementos de UI personalizados, como botones, campos y etiquetas. Por ejemplo:

using UnityEditor; using UnityEngine; [CustomEditor(typeof(MyScript))] public class MyScriptEditor : Editor { public override void OnInspectorGUI() { DrawDefaultInspector(); // Dibuja el inspector predeterminado MyScript myScript = (MyScript)target; if(GUILayout.Button("Haz Algo")) { myScript.DoSomething(); } } }

22. Explica el concepto de occlusion culling y cómo puede mejorar el rendimiento.

El occlusion culling es una técnica de optimización de renderizado que evita que la GPU dibuje objetos que están completamente ocultos de la vista de la cámara por otros objetos. Evita desperdiciar recursos en la renderización de píxeles que no serán visibles en la imagen final.

Al no dibujar objetos ocluidos, el occlusion culling reduce el número de llamadas de dibujo y la cantidad de procesamiento de píxeles (sombreado) que la GPU necesita realizar. Esto se traduce directamente en un rendimiento mejorado (mayores velocidades de fotogramas) y una menor consumo de energía, especialmente en escenas con alta densidad de objetos y superposición significativa. Esto se utiliza a menudo junto con otras técnicas de culling como el frustum culling.

23. ¿Cómo se implementa la persistencia de datos simple (guardar y cargar datos del juego) en Unity?

Para la persistencia de datos simple en Unity, normalmente uso PlayerPrefs. Es sencillo para guardar tipos de datos primitivos como enteros, flotantes y cadenas. Para guardar datos, uso métodos como PlayerPrefs.SetInt("puntuacion", valorPuntuacion), PlayerPrefs.SetFloat("volumen", valorVolumen), y PlayerPrefs.SetString("nombreJugador", nombreJugador). Para cargar datos, uso los métodos correspondientes PlayerPrefs.GetInt("puntuacion"), PlayerPrefs.GetFloat("volumen"), y PlayerPrefs.GetString("nombreJugador"). También verifico si existe una clave antes de cargar usando PlayerPrefs.HasKey("nombreClave") para proporcionar valores predeterminados si es necesario.

Alternativamente, podría serializar datos en un archivo JSON o binario para estructuras de datos más complejas. Para JSON, usaría JsonUtility.ToJson() para serializar un objeto y JsonUtility.FromJson() para deserializarlo. Para binario, usaría BinaryFormatter para serializar y deserializar los datos. Guardar en un archivo implica usar File.WriteAllText() o File.WriteAllBytes() y leer desde un archivo implica usar File.ReadAllText() o File.ReadAllBytes(), respectivamente. Esto se usa a menudo cuando se necesita almacenar datos de juego más complejos de forma persistente.

24. Describa el uso de la reflexión en C# y cómo se puede aplicar dentro de Unity.

La reflexión en C# le permite inspeccionar y manipular tipos, propiedades, métodos y eventos en tiempo de ejecución. Le permite descubrir información de tipo sin conocerla en tiempo de compilación. Dentro de Unity, la reflexión se puede aplicar a:

- Acceder a miembros privados: Modificar variables privadas o llamar a métodos privados de componentes (¡úsese con precaución!).

- Creación de editores genéricos: Generar dinámicamente interfaces de editor basadas en las propiedades del componente.

- Carga de activos dinámicamente: Encontrar y cargar activos basados en nombres de tipo en tiempo de ejecución. Por ejemplo:

Type assetType = Type.GetType("MyCustomAsset, Assembly-CSharp"); AssetDatabase.LoadAssetAtPath("Assets/MyAsset.asset", assetType);

- Implementación de sistemas basados en atributos: Descubrir clases o métodos marcados con atributos personalizados. Por ejemplo:

[MyCustomAttribute] public class MyClass {} //Reflexión para encontrar todas las clases con MyCustomAttribute

La reflexión ofrece gran flexibilidad pero puede impactar el rendimiento debido a la sobrecarga en tiempo de ejecución del descubrimiento de tipos. Úsala con prudencia, especialmente en secciones críticas para el rendimiento de tu juego de Unity.

25. Explica cómo usar operaciones asíncronas (async/await) en Unity. ¿Cuándo las necesitarías?

Las operaciones asíncronas en Unity (usando async/await) te permiten realizar tareas de larga duración sin congelar el hilo principal de Unity. Esto es crucial para tareas como solicitudes de red, E/S de archivos o cálculos complejos. Para usarlo, necesitas definir un método async que devuelva un Task o Task<T>, y usar await antes de las operaciones que podrían llevar tiempo.

Por ejemplo:

using System.Threading.Tasks; using UnityEngine; public class Example : MonoBehaviour { async Task LoadDataAsync() { string data = await LongRunningOperation(); Debug.Log(data); } Task<string> LongRunningOperation() { return Task.Run(() => { // Simula una operación larga System.Threading.Thread.Sleep(2000); return "Datos cargados"; }); } void Start() { _ = LoadDataAsync(); } }

Necesitarías operaciones asíncronas siempre que una tarea pueda bloquear el hilo principal durante un tiempo considerable, lo que provocaría una experiencia de usuario entrecortada o sin respuesta. Es especialmente útil cuando no quieres retrasar la renderización o el procesamiento de la entrada del usuario.

Preguntas avanzadas de entrevista de Unity

1. ¿Cómo puedes optimizar el rendimiento de un juego móvil con muchos objetos de física?

Optimizar un juego móvil con muchos objetos de física implica varias técnicas. Primero, reduce el número de objetos de física activos utilizando técnicas como el agrupamiento de objetos o la desactivación de objetos que están fuera de la pantalla o no interactúan activamente. Segundo, simplifica la representación física utilizando formas de colisión más simples (por ejemplo, círculos en lugar de polígonos complejos) y reduciendo el número de actualizaciones de física por segundo. Considera también el uso de técnicas para evitar realizar actualizaciones si el estado no ha cambiado.

Otras optimizaciones incluyen el uso de pasos de tiempo fijos para los cálculos de física, a fin de garantizar la coherencia en diferentes dispositivos y frecuencias de fotogramas, la creación de perfiles del motor de física para identificar cuellos de botella en el rendimiento y el uso de subprocesos múltiples para descargar los cálculos de física a un núcleo separado (¡pero tenga cuidado de abordar correctamente los problemas de sincronización de subprocesos!). Finalmente, si es posible, la integración de la física estática en los datos del nivel puede reducir la necesidad de cálculos continuos. Asegúrese de seleccionar un motor de física de alto rendimiento para el hardware de destino.

2. Explique las diferencias entre el uso de corrutinas y subprocesos en Unity, y cuándo elegiría uno sobre el otro.

Las corrutinas y los subprocesos le permiten realizar tareas simultáneamente, pero funcionan de manera diferente en Unity. Las corrutinas son 'pseudo-concurrentes', ya que se ejecutan en el subproceso principal y ceden la ejecución en puntos específicos (por ejemplo, yield return null, yield return new WaitForSeconds(1)). Esto significa que en realidad no se ejecutan en paralelo, sino que simulan la concurrencia dividiendo una tarea en partes más pequeñas. Los subprocesos, por otro lado, ofrecen un paralelismo real al ejecutar código en núcleos separados, liberando el subproceso principal.

Elige corrutinas para tareas que no requieren un procesamiento intensivo y que pueden dividirse en porciones más pequeñas y manejables, como animaciones, IA simple o eventos temporizados. Son más fáciles de gestionar ya que están vinculadas al hilo principal de Unity. Opta por hilos cuando necesites realizar tareas computacionalmente intensivas (por ejemplo, cálculos complejos, operaciones de E/S de archivos grandes, operaciones de red) que de otro modo congelarían el hilo principal. Ten en cuenta que los hilos requieren un manejo cuidadoso para evitar condiciones de carrera y problemas de sincronización. Es importante destacar que no puedes acceder directamente a objetos o API de Unity desde un hilo. Utiliza UnityMainThreadDispatcher o enfoques similares para enviar datos o acciones de vuelta al hilo principal para operaciones relacionadas con Unity.

3. Describe una situación en la que usarías una canalización de renderizado personalizada en Unity.

Una canalización de renderizado personalizada en Unity se vuelve esencial cuando las canalizaciones integradas (Estándar, URP, HDRP) no cumplen con los requisitos visuales específicos o las restricciones de rendimiento de un proyecto. Por ejemplo, si se está desarrollando un juego estilizado con un estilo de renderizado único, como un aspecto pintado a mano o un tipo específico de sombreado cel, la implementación de una canalización personalizada permite un control preciso sobre cada etapa de renderizado.

Otro escenario es la optimización para hardware de gama muy baja. Las canalizaciones integradas pueden ser demasiado ricas en funciones, lo que genera cuellos de botella en el rendimiento. Una canalización personalizada le permite eliminar las funciones innecesarias e implementar solo los pasos de renderizado esenciales, lo que mejora drásticamente el rendimiento. Puede escribir sombreadores y lógica de renderizado personalizados para controlar cada llamada de dibujo. Por ejemplo, puede realizar renderizado de sombras personalizado utilizando técnicas no compatibles con las canalizaciones integradas, o implementar rutas de renderizado diferido personalizadas con solo los pases que su juego necesita renderizar para obtener el máximo rendimiento en el hardware de destino.

4. ¿Cómo se implementa un sistema para la generación procedural de entornos 3D?

La generación procedural de entornos 3D generalmente implica dividir el entorno en componentes manejables y utilizar algoritmos para crear variaciones. Un enfoque común implica estos pasos:

- Definir bloques de construcción: Identificar elementos reutilizables como paredes, suelos, accesorios, etc. Estos pueden representarse como modelos 3D o primitivas basadas en código.

- Generación de números aleatorios: Utilizar un generador de números pseudoaleatorios (PRNG) con una semilla para garantizar la reproducibilidad. El valor de la semilla determina el entorno específico generado.

- Algoritmos de diseño: Emplear algoritmos para organizar los bloques de construcción. Los ejemplos incluyen:

- Mosaico: Organizar elementos en una cuadrícula u otro patrón.

- Sistemas L: Utilizar reglas gramaticales para generar estructuras complejas.

- Algoritmos de generación de mazmorras: Adaptar algoritmos como la partición binaria del espacio (BSP) o las caminatas aleatorias para crear espacios interconectados.

- Detallado: Agregar variaciones al entorno generado. Esto puede incluir cambiar texturas, agregar accesorios y modificar la geometría.

- Optimización: Optimizar el entorno generado para obtener rendimiento, lo que puede implicar técnicas como el nivel de detalle (LOD) y la oclusión de detección.

Por ejemplo, generar un bosque podría implicar dispersar árboles (definidos como modelos 3D) aleatoriamente con restricciones para evitar la superposición, o generar un nivel de mazmorra podría usar un algoritmo BSP para subdividir el nivel en habitaciones y pasillos. Luego, se puede poblar con trampas y tesoros.

5. Explique cómo diseñar un sistema robusto para manejar la entrada del jugador en diferentes plataformas y dispositivos.

Para diseñar un sistema robusto de entrada del jugador, abstraiga los eventos de entrada en un formato independiente de la plataforma. Use un administrador de entrada que mapee los controles físicos (teclado, gamepad, táctil) a acciones virtuales (saltar, avanzar, etc.). Esto permite una fácil reasignación y personalización.

Considere usar un enfoque en capas: 1) Controladores de entrada: código de bajo nivel específico de la plataforma. 2) Administrador de entrada: Traduce los eventos del controlador a acciones virtuales. 3) Lógica del juego: Reacciona a las acciones virtuales. Este enfoque le permite cambiar los métodos de entrada sin modificar la lógica del juego. Use técnicas como el almacenamiento en búfer de entrada para manejar la entrada perdida o el retraso. Asegúrese de que su código pueda admitir múltiples métodos de entrada a la vez, como teclado y gamepad.

6. Describa el proceso de integración de un SDK de terceros (por ejemplo, análisis, publicidad) en un proyecto de Unity.

La integración de un SDK de terceros en un proyecto de Unity normalmente implica estos pasos:

-

Descargue el SDK: Obtenga el paquete SDK (generalmente un archivo

.unitypackageo un.aar/.jarpara Android y.framework/.xcframeworkpara iOS) del sitio web o repositorio del proveedor del SDK. -

Importar el SDK: En el Editor de Unity, importa el paquete del SDK yendo a

Assets > Import Package > Custom Package...y seleccionando el archivo descargado. Esto añade los scripts, plugins y otros assets del SDK a tu proyecto. Si el SDK incluye plugins nativos (como.aar,.jar,.framework,.xcframework), asegúrate de que estén colocados en la estructura de carpetasPluginscorrecta (por ejemplo,Assets/Plugins/AndroidoAssets/Plugins/iOS). -

Configurar el SDK: Sigue la documentación del SDK para configurarlo correctamente. Esto podría implicar añadir componentes de script específicos a GameObjects, inicializar el SDK con tus claves API y configurar ajustes específicos de la plataforma (por ejemplo, en

Player Settingspara Android e iOS). -

Escribir Código: Usa la API del SDK en tus scripts de C# para activar eventos o acceder a sus funciones. Esto a menudo implica llamar a funciones proporcionadas por las clases y métodos del SDK. Por ejemplo:

using ThirdPartySDK; public class MyScript : MonoBehaviour { void Start() { ThirdPartySDK.Initialize("your_api_key"); ThirdPartySDK.TrackEvent("game_started"); } }

- Probar y Construir: Prueba a fondo la integración en el Editor de Unity y en los dispositivos objetivo (Android, iOS, etc.). Construye el proyecto para la plataforma deseada y verifica que el SDK funcione como se espera. Depura cualquier problema comprobando los registros y utilizando la documentación del SDK o los recursos de soporte.

7. ¿Cómo implementarías un sistema para física en red en un juego multijugador, abordando la latencia y los problemas de sincronización?

Para la física en red, usaría un enfoque de predicción en el lado del cliente y reconciliación en el servidor. Los clientes predicen su propia física localmente para minimizar la latencia. El servidor ejecuta la simulación de física autoritativa y envía actualizaciones periódicamente a los clientes. Los clientes luego reconcilian sus estados predichos con el estado autoritativo del servidor, corrigiendo cualquier discrepancia sin problemas, a menudo utilizando técnicas como interpolación o mezcla. Para mitigar el engaño, se puede implementar la validación en el lado del servidor para rechazar acciones de cliente muy divergentes.

Considere el uso de técnicas como la estimación por navegación o la gestión de interés para optimizar aún más el uso del ancho de banda. La estimación por navegación extrapola las posiciones de los objetos entre actualizaciones. La gestión de interés solo envía actualizaciones sobre los objetos relevantes para un cliente específico. Para tecnologías específicas, considere usar UDP por su velocidad (manejo de paquetes perdidos) y una biblioteca como ENet, o motores de juego como Unity o Unreal que tienen funciones de red integradas y a menudo proporcionan algunas herramientas de sincronización física.

8. Explique cómo crear una herramienta de editor personalizada para agilizar un flujo de trabajo específico en Unity.

Para crear una herramienta de editor personalizada en Unity, normalmente se comienza creando un script C# en la carpeta Editor. Este script contendrá la lógica para tu herramienta personalizada. Usa UnityEditor.Editor para crear un nuevo inspector o UnityEditor.EditorWindow para una ventana separada. Por ejemplo, usa [CustomEditor(typeof(YourComponent))] para extender el inspector de YourComponent. Dentro del script, usa OnInspectorGUI() (para inspectores personalizados) o OnGUI() (para ventanas de editor) para definir la interfaz de usuario usando el sistema IMGUI de Unity o UIElements para las versiones más recientes de Unity. Puedes agregar botones, campos y otros controles para manipular objetos de escena o propiedades de componentes.

Para optimizar un flujo de trabajo específico, identifica las tareas repetitivas o complejas. Luego, crea tu herramienta de editor personalizada para automatizar esos pasos. Digamos que quieres renombrar por lotes objetos de juego. Podrías crear una ventana de editor con un campo de texto para el prefijo, un campo numérico para el índice inicial y un botón que itere a través de los objetos de juego seleccionados y los renombre en consecuencia, haciendo el proceso más eficiente. Por ejemplo, aquí tienes un ejemplo de código sencillo:

using UnityEditor; using UnityEngine; public class RenameTool : EditorWindow { string prefijo = "NuevoObjeto"; int indiceInicial = 0; [MenuItem("Tools/Rename Tool")] public static void ShowWindow() { GetWindow<RenameTool>("Herramienta de Renombrado"); } void OnGUI() { GUILayout.Label("Configuración de Renombrado", EditorStyles.boldLabel); prefijo = EditorGUILayout.TextField("Prefijo", prefijo); indiceInicial = EditorGUILayout.IntField("Índice Inicial", indiceInicial); if (GUILayout.Button("Renombrar Seleccionados")) { RenameSelectedObjects(); } } void RenameSelectedObjects() { GameObject[] selectedObjects = Selection.gameObjects; for (int i = 0; i < selectedObjects.Length; i++) { selectedObjects[i].name = prefijo + (indiceInicial + i); } } }

9. Describe cómo abordaría la optimización del uso de memoria de texturas y mallas en un proyecto grande de Unity.

Para optimizar la memoria de las texturas, me centraría en varias técnicas. Primero, la compresión de texturas (por ejemplo, ASTC, ETC) es crucial para reducir el tamaño en la GPU. Usa mipmaps para reducir la resolución de las texturas según la distancia. Además, usa atlas de texturas para combinar múltiples texturas más pequeñas en una sola más grande para reducir las llamadas de dibujo y los cambios de estado. Considera reducir la resolución general de las texturas si la calidad visual lo permite.

Para las mallas, utiliza la compresión de malla para reducir el espacio de almacenamiento. Optimiza la topología de la malla eliminando vértices y triángulos innecesarios. Utiliza el nivel de detalle (LOD) más bajo aceptable para objetos más alejados de la cámara. Habilita la optimización de malla en la importación para consolidar vértices compartidos. Considera usar la generación procedural o técnicas de mosaicos para patrones repetitivos, reduciendo la necesidad de mallas grandes y únicas.

10. ¿Cómo manejas diferentes tamaños y resoluciones de pantalla en Unity para asegurar una experiencia de interfaz de usuario y juego consistente?

Para manejar diferentes tamaños y resoluciones de pantalla en Unity, utilizo principalmente el componente Canvas Scaler de Unity, configurándolo en 'Scale With Screen Size' (Escalar con el tamaño de la pantalla). Esto permite que la interfaz de usuario se ajuste dinámicamente según la resolución de la pantalla, manteniendo una apariencia consistente en todos los dispositivos. También me aseguro de que los elementos de la interfaz de usuario estén anclados y posicionados correctamente dentro del lienzo, utilizando anclajes para mantener las posiciones relativas.

Para el juego, diseño niveles con un enfoque independiente de la resolución. Esto podría implicar el uso de cámaras ortográficas y el ajuste del tamaño de la cámara en función de la relación de aspecto o el uso de una cámara de perspectiva con ajustes del campo de visión. Además, pruebo mi juego en varios dispositivos y emuladores para identificar y abordar cualquier problema de escalado o diseño específico de ciertos tamaños de pantalla. Asegurándome de usar Screen.width y Screen.height para ajustar programáticamente los elementos o la lógica del juego para diferentes relaciones de pantalla.

11. Explica cómo implementar un sistema para guardar y cargar datos del juego, incluyendo el manejo de diferentes tipos de datos y versiones.

Para implementar guardar y cargar, serializa los datos del juego (estado del juego, progreso del jugador) en un formato persistente como JSON o binario. Usa un objeto de guardado del juego que contenga todos los datos relevantes. La serialización convierte el objeto de guardado del juego en una cadena o flujo de bytes para el almacenamiento. La deserialización invierte esto, recreando el objeto de guardado del juego a partir de los datos guardados.

El manejo de tipos de datos requiere una cuidadosa consideración. Los tipos simples (int, float, string) se mapean directamente a representaciones JSON o binarias. Para objetos complejos, implemente lógica personalizada de serialización/deserialización. El versionado es crucial. Incluya un número de versión en los datos guardados. Al cargar, verifique la versión; si está desactualizada, realice una migración de datos para actualizar los datos a la versión actual utilizando lógica condicional para actualizar los campos apropiadamente. Esto garantiza la compatibilidad entre diferentes versiones del juego. Por ejemplo:

struct GameSave { int version = 2; //Versión actual int playerHealth; float playerPositionX; float playerPositionY; }; //Ejemplo de migración de datos: if (loadedSave.version < 2) { loadedSave.playerMana = 100; //Agrega la variable playerMana }

12. Describa una situación en la que usaría un compute shader en Unity y explique sus beneficios.

Una buena situación para usar un compute shader en Unity es para simulaciones de partículas. En lugar de actualizar las posiciones y velocidades de las partículas en la CPU cada fotograma, lo que puede convertirse en un cuello de botella con una gran cantidad de partículas, podemos descargar ese cálculo a la GPU utilizando un compute shader.

Los beneficios son importantes ganancias de rendimiento, especialmente cuando se trata de miles o millones de partículas. La GPU está altamente paralelizada, lo que la hace mucho más rápida para realizar la misma operación en muchos puntos de datos simultáneamente. Esto libera a la CPU para otras tareas, lo que resulta en un juego más fluido y receptivo. Por ejemplo, el código del compute shader podría verse así:

#pragma kernel CSMain struct Particle { float3 position; float3 velocidad; }; RWStructuredBuffer<Particle> particles; float deltaTime; [numthreads(64,1,1)] void CSMain (uint id : SV_DispatchThreadID) { Particle p = particles[id]; p.position += p.velocity * deltaTime; particles[id] = p; }

13. ¿Cómo implementaría un sistema para manejar la localización en un juego de Unity, incluyendo texto, audio e imágenes?

Para la localización en Unity, usaría ScriptableObjects para almacenar datos localizados. Para el texto, cada ScriptableObject contendría un diccionario que mapea claves de idioma (por ejemplo, 'en', 'fr') a cadenas. Un script de administrador de localización se encargaría de cambiar de idioma y recuperar el texto correcto. Para audio e imágenes, ScriptableObjects similares almacenarían activos específicos del idioma.

Para agilizar el flujo de trabajo, integraría un plugin de localización o un paquete de la tienda de activos como 'Localization Package' (la solución oficial de Unity) o I2 Localization. Estos paquetes proporcionan herramientas para importar/exportar datos de localización (por ejemplo, archivos CSV), administrar traducciones y previsualizar contenido localizado en el editor. La función de importación y exportación de datos simplifica el proceso de localización para los desarrolladores y traductores. La opción de previsualización facilita la prueba y mejora de la localización en el juego.

14. Explique cómo crear un sistema de animación personalizado utilizando el paquete Animation Rigging.

Para crear un sistema de animación personalizado con Animation Rigging, defines restricciones que modifican la transformación de GameObjects basándose en el estado de otros GameObjects o variables. Primero, crea un script IRigConstraint personalizado que define la lógica para el efecto de tu animación. Este script normalmente tiene propiedades que controlan la intensidad del efecto y los objetos objetivo. Luego, en el método Process de tu script de restricción personalizado, calcula la modificación de transformación deseada basándote en tu lógica y aplícala al objeto restringido. Después, agrega un GameObject vacío a la jerarquía de tu personaje para que actúe como un 'rig' para tus restricciones personalizadas. Finalmente, agrega tu script de restricción al rig, estableciendo sus propiedades y conectándolo a los GameObjects apropiados. Esto hace que la animación se vea afectada dinámicamente por el contexto del juego u otras animaciones.

15. Describe cómo implementar un sistema para manejar compras dentro de la aplicación en un juego de Unity, incluyendo consideraciones de seguridad.

Implementar compras dentro de la aplicación (IAP) en Unity implica usar el servicio Unity IAP. Primero, importa el paquete IAP a través del Package Manager. Luego, configura tus productos (consumibles, no consumibles, suscripciones) en el catálogo de Unity IAP, especificando IDs de productos que coincidan con los de las tiendas de aplicaciones (por ejemplo, Google Play, Apple App Store). Usa la API UnityPurchasing para inicializar IAP, registrar tus productos y manejar eventos de compra. Los pasos clave son Initialize, ProcessPurchase, OnInitialized, OnInitializeFailed, OnPurchaseFailed. Implementa elementos de la interfaz de usuario para mostrar productos e iniciar compras usando PurchaseProcessingResult.Complete() para finalizar la transacción. Por ejemplo:

public class IAPManager : MonoBehaviour, IStoreListener { private static IStoreController m_StoreController; private static IExtensionProvider m_StoreExtensionProvider; void Start() { // Begin initializing the purchasing system as soon as the C# scripting // is running. InitializePurchasing(); } public void InitializePurchasing() { // If we have already connected to Purchasing ... if (IsInitialized()) { // ... we are done here. return; } } public PurchaseProcessingResult ProcessPurchase(PurchaseEventArgs args) { // A consumable product has been purchased by this user. if (String.Equals(args.purchasedProduct.definition.id, kProductIDConsumable, StringComparison.Ordinal)) { Debug.Log(string.Format("ProcessPurchase: PASS. Product: '{0}'", args.purchasedProduct.definition.id)); // The consumable item has been successfully purchased, add 100 coins to the user's in-game score. GiveCoins(100); // Or maybe by using UnityEngine.SceneManagement.SceneManager.LoadScene() // Return a flag indicating whether this product has completely been received, or if the application needs // to be reminded of this purchase at next app launch. return PurchaseProcessingResult.Complete; } else { Debug.Log(string.Format("ProcessPurchase: FAIL. Unrecognized product: '{0}'", args.purchasedProduct.definition.id)); // Return a flag indicating whether this product has completely been received, or if the application needs // to be reminded of this purchase at next app launch. return PurchaseProcessingResult.Pending; } } }