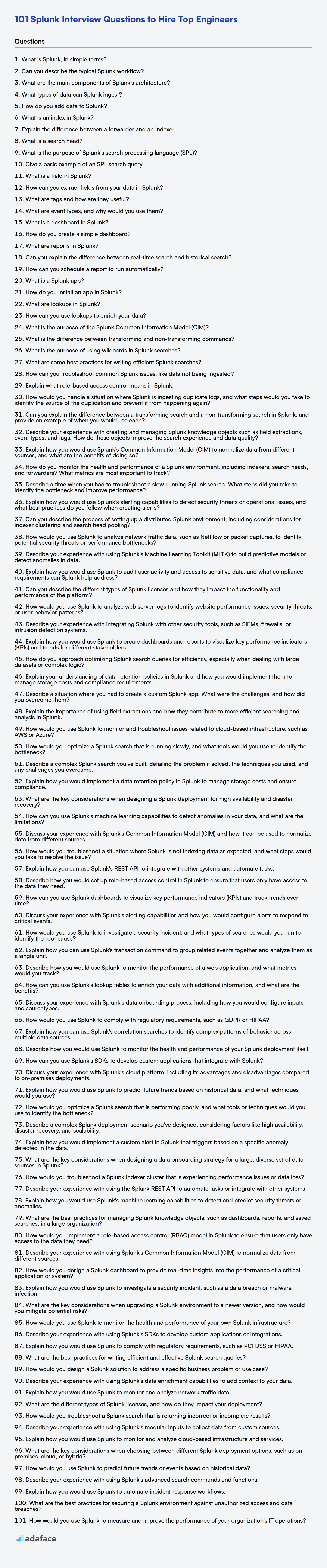

101 Preguntas de Entrevista de Splunk para Contratar a los Mejores Ingenieros

Evaluar a los candidatos para puestos de Splunk puede ser difícil, ya que requiere una combinación de experiencia técnica y aplicación práctica. Los reclutadores pueden tener dificultades para evaluar la verdadera competencia de un candidato sin preguntas de entrevista estructuradas.

Esta publicación de blog proporciona una lista seleccionada de preguntas de entrevista de Splunk, categorizadas por nivel de experiencia, desde básico hasta experto, incluyendo un conjunto de preguntas de opción múltiple (MCQ) de Splunk. Estas preguntas cubren un espectro de temas, asegurando una revisión de las habilidades de un candidato.

Al usar estas preguntas, los entrevistadores pueden identificar a los candidatos que realmente entienden Splunk y sus aplicaciones. Para asegurarse de que un candidato es verdaderamente hábil, use nuestra prueba en línea de Splunk antes de la entrevista para filtrar a los candidatos no aptos.

Tabla de contenidos

Preguntas básicas de la entrevista de Splunk

Preguntas intermedias de la entrevista de Splunk

Preguntas avanzadas de la entrevista de Splunk

Preguntas de la entrevista de experto en Splunk

Splunk MCQ

¿Qué habilidades de Splunk debe evaluar durante la fase de entrevista?

Contrate a expertos en Splunk con evaluaciones de habilidades específicas

Descargue la plantilla de preguntas de la entrevista de Splunk en múltiples formatos

1. ¿Qué es Splunk, en términos simples?

Splunk es como un potente motor de búsqueda para datos de máquinas. Piense en él como Google, pero en lugar de buscar en Internet, busca en registros (logs), métricas y otros datos producidos por computadoras, aplicaciones y dispositivos. Estos datos suelen ser desordenados y no estructurados, pero Splunk ayuda a darles sentido, lo que le permite monitorear sistemas, solucionar problemas, detectar amenazas de seguridad y obtener información empresarial.

Esencialmente, toma datos de máquina en bruto, los indexa y proporciona una interfaz de usuario para buscar, analizar y visualizar esos datos. Ayuda a convertir los datos de las máquinas en información procesable.

2. ¿Puede describir el flujo de trabajo típico de Splunk?

El flujo de trabajo típico de Splunk implica varias etapas clave: Primero, los datos se introducen en Splunk, ya sea a través de conexiones directas a fuentes de datos, cargas de archivos o reenviadores. Luego, Splunk indexa estos datos, analizándolos en eventos y extrayendo campos para la búsqueda. Este proceso de indexación crea un repositorio de búsqueda. Los usuarios luego buscan y analizan los datos indexados utilizando el Lenguaje de Procesamiento de Búsqueda (SPL) de Splunk para identificar tendencias, patrones y anomalías. Finalmente, los usuarios pueden crear informes, paneles y alertas basados en los resultados de sus búsquedas para visualizar datos, monitorear eventos críticos y responder de manera proactiva a los problemas.

En resumen:

- Entrada de Datos: Recopilar datos de varias fuentes.

- Indexación: Analizar y almacenar datos en un formato de búsqueda.

- Búsqueda y Análisis: Usar SPL para consultar y examinar datos.

- Informes y Alertas: Visualizar información y configurar notificaciones.

3. ¿Cuáles son los componentes principales de la arquitectura de Splunk?

- Forwarders de Splunk: Estos agentes recopilan datos de diversas fuentes y los reenvían a los indexadores de Splunk. Hay diferentes tipos de forwarders como Universal Forwarder (UF) y Heavy Forwarder (HF).

- Indexadores de Splunk: Procesan, analizan e indexan los datos recibidos de los forwarders. Los datos indexados se almacenan para la búsqueda y el análisis.

- Search Heads de Splunk: Estos proporcionan la interfaz de usuario para buscar, analizar y visualizar los datos indexados. Distribuyen las solicitudes de búsqueda a los indexadores y consolidan los resultados.

- Servidor de Implementación: Esta instancia central gestiona y distribuye configuraciones, aplicaciones y actualizaciones a los forwarders en el entorno de Splunk.

- Maestro de Licencias: Gestiona las licencias de Splunk.

4. ¿Qué tipos de datos puede ingerir Splunk?

Splunk puede ingerir una amplia variedad de tipos de datos. Esencialmente, maneja cualquier dato que pueda representarse como un evento con marca de tiempo. Esto incluye datos estructurados como archivos CSV y bases de datos, datos semiestructurados como JSON y XML, y datos no estructurados como registros de aplicaciones y tráfico de red. Esencialmente, si puede obtener los datos en un archivo, o transmitirlos, Splunk probablemente pueda ingerirlos.

Ejemplos específicos incluyen registros de servidor, registros de aplicaciones, paquetes de red (a través de herramientas como Wireshark o tcpdump), eventos de seguridad, métricas del sistema, datos de sensores y archivos de configuración. Splunk logra esto a través de varios métodos de entrada como la monitorización de archivos, puertos de red (TCP/UDP), APIs y scripts.

5. ¿Cómo se añaden datos a Splunk?

Los datos se pueden agregar a Splunk utilizando varios métodos. Una forma común es a través de forwarders (reenviadores), que son agentes ligeros instalados en los sistemas que recopilan datos y los reenvían a los indexadores de Splunk. Alternativamente, los datos se pueden ingerir directamente utilizando el punto final HTTP Event Collector (HEC), a menudo utilizado para registros de aplicaciones o la ingesta programática de datos. También puede cargar archivos directamente a través de la interfaz web de Splunk o usar entradas con scripts para extraer datos de varias fuentes.

Específicamente, aquí hay algunos métodos:

- Forwarders (Reenviadores): Instale un reenviador de Splunk en la máquina que genera los datos.

- HTTP Event Collector (HEC): Envíe datos a través de solicitudes HTTP a un punto final específico.

- Interfaz web de Splunk: Cargue archivos directamente a través de la interfaz de usuario web.

- Entradas con scripts: Use scripts para recopilar datos y canalizarlos a Splunk.

- Puertos de red: Configure Splunk para escuchar en puertos de red específicos (por ejemplo, syslog).

6. ¿Qué es un índice en Splunk?

En Splunk, un índice es un repositorio para almacenar y administrar datos. Es donde Splunk almacena los eventos indexados de sus fuentes de datos. Piense en ello como una base de datos optimizada para la búsqueda y el análisis rápidos de datos de máquinas.

Los aspectos clave de un índice de Splunk incluyen: Los datos se almacenan en depósitos basados en el tiempo, lo que ayuda a la búsqueda eficiente dentro de rangos de tiempo específicos. Splunk puede tener múltiples índices, lo que le permite segregar datos según la fuente, el tipo o los requisitos de retención. Esta separación puede ser muy útil al aplicar el control de acceso basado en roles (RBAC) también.

7. Explique la diferencia entre un reenviador y un indexador.

Un forwarder en Splunk es responsable de recopilar datos de diversas fuentes y enviarlos a un indexador. Su trabajo principal es la adquisición y el enrutamiento de datos. Puede realizar un análisis y filtrado mínimos, pero su propósito principal es llevar los datos al indexador de manera eficiente. Hay diferentes tipos de forwarders como el forwarder universal (UF), el forwarder pesado (HF) y el forwarder ligero (LF).

Un indexador, por otro lado, recibe los datos de los forwarders, los analiza, los transforma y luego los indexa. La indexación hace que los datos sean buscables. El indexador también gestiona el almacenamiento de datos y las políticas de retención. Esencialmente, el indexador es donde ocurre el trabajo pesado de procesamiento y organización de datos.

8. ¿Qué es un search head?

Un search head es un componente de Splunk Enterprise que gestiona la administración de búsquedas y la generación de informes. Sirve como el punto central para que los usuarios interactúen con Splunk, proporcionando una interfaz para ejecutar búsquedas, crear informes, paneles y alertas en todos los datos indexados.

En esencia, el search head distribuye las solicitudes de búsqueda a los indexadores, consolida los resultados y los presenta al usuario. No almacena datos indexados en sí mismo; en cambio, se basa en los indexadores para realizar la recuperación real de datos. Los search heads también gestionan la autenticación, la autorización y los objetos de conocimiento en tiempo de búsqueda, como las búsquedas de referencia, las búsquedas guardadas y los tipos de eventos. Se pueden implementar clústeres de search head para alta disponibilidad y escalabilidad.

9. ¿Cuál es el propósito del lenguaje de procesamiento de búsqueda (SPL) de Splunk?

El propósito del lenguaje de procesamiento de búsqueda (SPL) de Splunk es permitir a los usuarios buscar, analizar y visualizar datos generados por máquinas. Actúa como la interfaz principal para interactuar con las capacidades de indexación y recuperación de datos de Splunk. SPL permite a los usuarios extraer información significativa de los datos en bruto, identificar patrones y generar informes.

Esencialmente, SPL proporciona una forma potente y flexible de transformar datos en bruto en información procesable. Utiliza un enfoque basado en tuberías, donde cada comando procesa la salida del comando anterior. Esto permite realizar operaciones complejas encadenando una serie de comandos.

10. Dé un ejemplo básico de una consulta de búsqueda SPL.

Una consulta de búsqueda SPL básica busca eventos que contienen una palabra clave específica. Por ejemplo:

index=_internal error

Esta consulta busca en el índice _internal eventos que contengan la palabra error. La parte index=_internal especifica el índice a buscar, y error es el término de búsqueda. Las consultas más complejas pueden encadenar comandos utilizando el carácter de tubería | para filtrar, transformar e informar sobre los resultados.

11. ¿Qué es un campo en Splunk?

En Splunk, un campo es un par nombre-valor que representa una pieza específica de información extraída de sus datos. Los campos son cruciales para buscar, informar y analizar datos dentro de Splunk. Splunk extrae automáticamente campos predeterminados como host, source y sourcetype, pero también puede definir campos personalizados para capturar puntos de datos específicos relevantes para sus registros o eventos.

Los campos son lo que le permite filtrar los resultados de su búsqueda, realizar cálculos estadísticos y crear paneles. Esencialmente, proporcionan la estructura para dar sentido a los datos sin procesar y no estructurados que Splunk ingiere.

12. ¿Cómo puede extraer campos de sus datos en Splunk?

Splunk ofrece varias formas de extraer campos de datos durante el tiempo de búsqueda o de indexación. Los métodos comunes incluyen el uso del comando rex con expresiones regulares, el comando extract para extracciones de campos basadas en delimitadores, y extracciones de campos a través de Splunk Web utilizando el extractor de campos interactivo (IFX). Las extracciones de campos en tiempo de indexación implican configurar props.conf y transforms.conf para definir cómo se extraen los campos durante el proceso de indexación, optimizando el rendimiento de la búsqueda.

Por ejemplo:

- comando rex:

| rex field=_raw "(?<mifield>\d+)" - comando extract:

| extract pairdelim="," kvdelim="=" limit=10 - IFX: Usando el extractor de campos interactivo de Splunk Web, puede seleccionar visualmente los datos y definir los nombres de los campos.

13. ¿Qué son las etiquetas y cómo son útiles?

Las etiquetas son etiquetas o palabras clave asignadas a los recursos (por ejemplo, archivos, imágenes, recursos en la nube, registros de bases de datos) para categorizarlos y organizarlos. Son metadatos que proporcionan contexto adicional y facilitan la búsqueda, gestión y automatización de acciones en estos recursos.

Las etiquetas son útiles por varias razones:

- Organización: Agrupar recursos relacionados, independientemente de su ubicación o tipo.

- Búsqueda y Filtrado: Localizar rápidamente recursos específicos basados en sus etiquetas.

- Automatización: Activar acciones basadas en etiquetas (por ejemplo, respaldar automáticamente recursos con una etiqueta específica).

- Gestión de costos: Rastrear los costos asociados con proyectos o departamentos específicos mediante la etiqueta de recursos relacionados. Por ejemplo, en AWS, podrías etiquetar instancias EC2:

"Proyecto":"MiProyecto" - Control de acceso: Controlar el acceso a los recursos basados en sus etiquetas.

14. ¿Qué son los tipos de eventos y por qué los usarías?

Los tipos de eventos son clasificaciones o categorías de eventos que ocurren dentro de un sistema o aplicación. Proporcionan una forma de diferenciar entre varias acciones, ocurrencias o cambios de estado, lo que permite que se activen respuestas específicas en función del tipo de evento que ocurrió. Los ejemplos incluyen eventos de clic, eventos de mouseover, eventos de data_received o eventos personalizados definidos específicamente para el dominio de una aplicación. El uso de tipos de eventos es crucial para construir sistemas receptivos y desacoplados.

Usarías tipos de eventos para:

- Desacoplar componentes: Diferentes partes del sistema pueden reaccionar a eventos sin necesidad de conocer los detalles del origen del evento.

- Implementar comportamiento asíncrono: Permite procesar eventos a medida que ocurren, en lugar de una manera rígida y secuencial.

- Crear arquitecturas modulares y extensibles: Se pueden agregar nuevos manejadores de eventos sin modificar el código existente.

- Mejorar la mantenibilidad del código: Los diseños basados en eventos a menudo conducen a un código más organizado y fácil de entender.

- Ejemplo:

Definir un tipo de evento

event_type = "user_logged_in"

# Despachar un evento de ese tipo

dispatch_event(event_type, user_data)

# Función del manejador

def handle_user_login(user_data):

print(f"Usuario conectado: {user_data}")

# Registrar el manejador para el tipo de evento

register_handler(event_type, handle_user_login)

15. ¿Qué es un panel de control (dashboard) en Splunk?

Un panel de control de Splunk es una representación visual de datos, que se utiliza típicamente para monitorear indicadores clave de rendimiento (KPI) y obtener información sobre el comportamiento del sistema. Se compone de paneles, cada uno de los cuales muestra datos en un formato específico, como gráficos, tablas o valores únicos.

Los paneles de control proporcionan una vista centralizada de la información crítica, lo que permite a los usuarios identificar rápidamente tendencias, anomalías y posibles problemas. Son configurables y se pueden adaptar para satisfacer las necesidades específicas de diferentes usuarios o equipos.

16. ¿Cómo se crea un panel de control simple?

La creación de un panel de control simple implica varios pasos clave. Primero, definir el propósito y la audiencia para determinar qué métricas son más relevantes. Luego, recopilar los datos necesarios de sus fuentes de datos. Esto a menudo implica consultar bases de datos o APIs. Luego, elegir una herramienta de visualización (por ejemplo, Google Sheets, Tableau Public, Grafana para paneles técnicos).

Con la herramienta seleccionada, diseñe el diseño centrándose en la claridad y la facilidad de comprensión. Utilice tipos de gráficos apropiados (por ejemplo, gráficos de líneas para tendencias, gráficos de barras para comparaciones). Finalmente, actualice los datos regularmente para mantener el panel actual y relevante.

17. ¿Qué son los informes en Splunk?

Los informes en Splunk son búsquedas guardadas que proporcionan una instantánea de los datos en un momento específico. Ayudan a los usuarios a monitorear tendencias, identificar anomalías y obtener información de sus datos sin ejecutar repetidamente las mismas búsquedas.

Los informes se pueden programar para que se ejecuten automáticamente, y sus resultados se pueden mostrar en paneles, enviar por correo electrónico a los usuarios o utilizar para activar alertas. Esencialmente, agilizan el análisis de datos mediante la automatización de la ejecución de la búsqueda y la presentación de resultados.

18. ¿Puede explicar la diferencia entre la búsqueda en tiempo real y la búsqueda histórica?

La búsqueda en tiempo real se centra en proporcionar resultados sobre eventos actuales o información que cambia rápidamente. El índice se actualiza constantemente para reflejar los últimos datos, y los resultados pretenden ser casi instantáneos. Piense en buscar temas de noticias de tendencia o precios de acciones en vivo. La búsqueda histórica, por otro lado, se ocupa de recuperar información de un conjunto de datos estático o actualizado con menos frecuencia. Se utiliza para encontrar eventos pasados, documentos archivados o datos que no cambian rápidamente. Piense en buscar en registros históricos o documentos de investigación. La diferencia clave es la frescura y la volatilidad de los datos que se están buscando.

19. ¿Cómo se puede programar un informe para que se ejecute automáticamente?

El método para programar un informe para que se ejecute automáticamente depende de la herramienta de informes que se esté utilizando. Los enfoques comunes incluyen el uso de las funciones de programación integradas del propio software de informes, o el aprovechamiento de un programador externo como cron (en sistemas Linux/Unix) o el Programador de tareas de Windows.

Por ejemplo, herramientas como Tableau, Power BI y SSRS (SQL Server Reporting Services) tienen funcionalidades de programación integradas. Puede definir el informe, la frecuencia deseada (diaria, semanal, mensual) y la hora de ejecución directamente en la configuración del informe. El sistema luego genera y distribuye automáticamente el informe de acuerdo con la programación especificada.

20. ¿Qué es una aplicación Splunk?

Una aplicación Splunk es una colección preempaquetada de configuraciones, paneles, informes, alertas y otros objetos de conocimiento que extiende la funcionalidad de Splunk para un caso de uso o fuente de datos específico. Piense en ello como un plugin que proporciona una experiencia a medida para analizar y visualizar un tipo particular de datos.

Las aplicaciones simplifican el proceso de incorporación y análisis de nuevas fuentes de datos al proporcionar herramientas y configuraciones preconstruidas. Reducen la necesidad de que los usuarios creen manualmente paneles, informes y alertas desde cero, lo que ahorra tiempo y esfuerzo. Las aplicaciones pueden centrarse en tecnologías específicas (por ejemplo, seguridad de Cisco), industrias (por ejemplo, análisis minorista) o casos de uso (por ejemplo, operaciones de TI).

21. ¿Cómo se instala una aplicación en Splunk?

Para instalar una aplicación en Splunk, el método más común es a través de la interfaz web de Splunk. Navegue a la sección 'Apps', que generalmente se encuentra en la barra de navegación izquierda. Luego, haga clic en 'Instalar aplicación desde archivo' o 'Buscar más aplicaciones'. Si tiene el paquete de la aplicación (un archivo .spl), use la opción 'Instalar aplicación desde archivo' y cargue el archivo. Para las aplicaciones disponibles en Splunkbase, use la opción 'Buscar más aplicaciones', busque la aplicación deseada y haga clic en 'Instalar'. Es posible que se le soliciten sus credenciales de Splunk.com para continuar.

Alternativamente, puede instalar una aplicación manualmente. Extraiga el contenido del archivo .spl en el directorio $SPLUNK_HOME/etc/apps. Después de extraer, Splunk necesita ser reiniciado para que la aplicación sea reconocida. Tenga en cuenta que la instalación manual puede requerir el ajuste de los permisos de los archivos para garantizar que Splunk pueda acceder a los archivos de la aplicación.

22. ¿Qué son las búsquedas (lookups) en Splunk?

Las búsquedas en Splunk son una forma de enriquecer los datos de sus eventos con información externa. Esencialmente, mapean campos en sus eventos a campos en una fuente externa, agregando nuevos campos a sus eventos durante el proceso de búsqueda. Esto le permite correlacionar sus datos con contexto adicional como atributos de usuario, ubicaciones geográficas o datos de inteligencia de amenazas.

Hay varios tipos de búsquedas:

- Búsquedas CSV: Utilizan archivos CSV para mapear valores.

- Búsquedas externas: Utilizan scripts o ejecutables para realizar la búsqueda.

- Búsquedas de KV Store: Utilizan el Key Value Store de Splunk para búsquedas.

- Búsquedas geográficas: Mapean direcciones IP a ubicaciones geográficas.

| lookup <tabla_de_búsqueda> <campo_de_búsqueda> AS <campo_de_evento> OUTPUT <nuevo_campo> es la sintaxis básica para usar el comando de búsqueda en Splunk.

23. ¿Cómo se pueden usar las búsquedas para enriquecer sus datos?

Las búsquedas enriquecen los datos agregando contexto relevante de fuentes externas, mejorando el análisis y la toma de decisiones. Por ejemplo, podría usar una tabla de búsqueda para agregar información demográfica del cliente (edad, ubicación) basada en los ID de los clientes en sus datos de transacciones. Esto le permite analizar las tendencias de ventas por grupos demográficos.

Específicamente, considere las direcciones IP. Un servicio de búsqueda puede proporcionar la ubicación geográfica (país, ciudad) y posiblemente la organización asociada con esa IP. Si tiene registros del servidor web con direcciones IP, el uso de una búsqueda enriquece dramáticamente esos datos. En Python, esto podría hacerse con:

import geoip2.database def enrich_ip(ip_address): reader = geoip2.database.Reader('GeoLite2-City.mmdb') try: response = reader.city(ip_address) return { 'city': response.city.name, 'country': response.country.name } except Exception as e: return None

24. ¿Cuál es el propósito del Modelo de Información Común (CIM) de Splunk?

El Modelo de Información Común (CIM) de Splunk sirve como un modelo semántico compartido enfocado en extraer valor de los datos. Su propósito principal es normalizar los datos de diferentes fuentes en una estructura común, permitiendo a los usuarios analizar y correlacionar eventos a través de diversos conjuntos de datos más fácilmente. Esta abstracción simplifica la búsqueda, la generación de informes y la creación de paneles porque se pueden utilizar las mismas consultas independientemente de la fuente de datos original. Asegura la consistencia, permitiendo una investigación más rápida y una mejor comprensión.

El CIM logra esto al definir un conjunto de campos y etiquetas para varios tipos de eventos (por ejemplo, autenticación, tráfico de red, malware). Cuando los datos se ajustan al CIM, los analistas pueden aprovechar paneles, informes y búsquedas de correlación predefinidos. El CIM también proporciona un marco para desarrollar nuevo contenido que funcione en todos los conjuntos de datos compatibles con el CIM.

25. ¿Cuál es la diferencia entre los comandos transformadores y los no transformadores?

Los comandos transformadores modifican la fuente de datos original, mientras que los comandos no transformadores no lo hacen. Por ejemplo, en Linux, mv (mover) es un comando transformador porque mueve físicamente el archivo, alterando el sistema de archivos. cp (copiar) no es transformador, ya que crea un nuevo archivo dejando el original intacto.

En el contexto del procesamiento de datos (como con Spark o Pandas), las operaciones de transformación crean un nuevo conjunto de datos basado en el original, dejando el conjunto de datos original sin cambios. Las operaciones no transformadoras generalmente implican acciones como leer datos, mostrar resúmenes (por ejemplo, describe() en Pandas) o escribir datos en un destino, sin alterar los datos de origen. Entender esta diferencia es crucial para la integridad de los datos y la depuración de las canalizaciones.

26. ¿Cuál es el propósito de usar comodines en las búsquedas de Splunk?

Los comodines en las búsquedas de Splunk sirven como marcadores de posición, lo que le permite coincidir con múltiples términos sin especificar cada uno exactamente. Son útiles cuando no conoce el término exacto que está buscando, o cuando desea ampliar su búsqueda para incluir variaciones de un término. Los comodines principales son * (coincide con cero o más caracteres) y ? (coincide con un solo carácter).

27. ¿Cuáles son algunas de las mejores prácticas para escribir búsquedas eficientes en Splunk?

Al escribir búsquedas en Splunk, concéntrese en filtrar datos lo antes posible en el pipeline de búsqueda. Use índices específicos y cláusulas where para reducir la cantidad de datos que los comandos subsiguientes necesitan procesar. Aproveche las extracciones de campos en el momento de la indexación para evitar extracciones en tiempo de ejecución. Usar el comando fields para seleccionar solo los campos necesarios mejora el rendimiento.

Evite usar caracteres comodín al principio de sus términos de búsqueda, ya que pueden ralentizar significativamente la búsqueda. En lugar de usar *error*, considere error. Use tstats para resúmenes estadísticos, ya que usa datos indexados, mejorando la velocidad, en lugar del comando stats que busca en los eventos. timechart puede ser más eficiente para la visualización de datos de series temporales. Tenga cuidado al usar los comandos eval y regex, ya que pueden consumir muchos recursos; explore métodos alternativos como case o campos pre-extraídos cuando sea posible. Use dedup para eliminar eventos redundantes, pero asegúrese de colocarlo en el lugar apropiado en la búsqueda para limitar el conjunto de datos.

28. ¿Cómo puede solucionar problemas comunes de Splunk, como que no se ingieran datos?

Para solucionar problemas de ingestión de datos en Splunk, comience por verificar los registros de Splunk (splunkd.log) en busca de errores relacionados con la configuración de la entrada o problemas de conectividad. Verifique que la entrada esté configurada correctamente, que el reenviador se esté ejecutando y que esté configurado correctamente para reenviar datos a los indexadores de Splunk o a los reenviadores pesados. La conectividad de red entre la fuente de datos, el reenviador y el indexador debe probarse utilizando herramientas como ping o telnet. Asegúrese de que las reglas del firewall no estén bloqueando el tráfico en el puerto configurado.

Una investigación más profunda implica examinar el archivo de configuración de entrada (por ejemplo, inputs.conf) en busca de errores de sintaxis, tipos de fuente incorrectos o campos obligatorios faltantes. Confirme que el indexador se esté ejecutando y tenga recursos suficientes, y que el índice exista y esté configurado correctamente. Consulte la consola de monitoreo en Splunk para ver si hay alertas de estado relacionadas con los reenviadores o indexadores y asegúrese de que la fuente de datos realmente esté produciendo datos. Por ejemplo, si está monitoreando registros, verifique la aplicación de destino para ver si el archivo de registro se está actualizando.

29. Explique qué significa el control de acceso basado en roles en Splunk.

El Control de Acceso Basado en Roles (RBAC) en Splunk es un mecanismo de seguridad que restringe el acceso al sistema a usuarios autorizados en función de sus roles dentro de una organización. Permite a los administradores definir roles con permisos específicos, determinando qué acciones pueden realizar los usuarios asignados a esos roles dentro de Splunk. Esto controla el acceso a datos, capacidades y configuraciones.

RBAC en Splunk funciona asignando capacidades (permisos específicos) a los roles. Luego, los usuarios se asignan a uno o más roles. Cuando un usuario inicia sesión, Splunk evalúa los roles que se le asignaron y les otorga el conjunto combinado de permisos asociados con esos roles. Esto permite un enfoque de mínimo privilegio, donde los usuarios solo tienen acceso a los recursos y acciones necesarios para sus funciones laborales, mejorando la seguridad y el cumplimiento.

Preguntas de entrevista intermedias de Splunk

1. ¿Cómo manejaría una situación en la que Splunk está ingiriendo registros duplicados, y qué pasos tomaría para identificar la fuente de la duplicación y evitar que vuelva a ocurrir?

Para manejar registros duplicados en Splunk, primero identificaría el alcance del problema usando una búsqueda como index=* | stats count by _raw | where count > 1. Esto ayuda a determinar el alcance y la frecuencia de la duplicación. Luego, investigaría las posibles fuentes:

- Configuración del Forwarder: Verifique si los forwarders están mal configurados y envían los mismos registros varias veces. Busque entradas superpuestas o filtros configurados incorrectamente en

inputs.conf. Además, investigue si el forwarder está configurado para enviar datos a múltiples indexadores de Splunk sin intención. - Configuración de entrada: Examine la configuración de entrada en los indexadores de Splunk. Varias entradas podrían configurarse inadvertidamente para monitorear los mismos archivos de registro.

- Problemas de red: Los problemas de red transitorios a veces pueden causar que los forwarders reenvíen datos. Revise los registros del forwarder en busca de errores de conexión o tiempos de espera.

- Clustering de Splunk: En un entorno agrupado, asegúrese de que los datos no se estén indexando varias veces debido a problemas de replicación.

Para evitar la recurrencia, implementaría técnicas de deduplicación, como el uso del comando dedup en las búsquedas para la generación de informes, o configuraría el atributo crcSalt en inputs.conf para evitar que los mismos datos se indexen varias veces. Monitorear los registros del forwarder y del indexador regularmente también es clave.

2. ¿Puede explicar la diferencia entre una búsqueda transformadora y una búsqueda no transformadora en Splunk, y proporcionar un ejemplo de cuándo usaría cada una?

Una búsqueda transformadora en Splunk cambia la estructura de datos subyacente, típicamente para crear estadísticas o visualizaciones. Utiliza comandos como stats, chart, timechart y top. Estos comandos agregan o manipulan los eventos, alterando los datos sin procesar a un formato tabular adecuado para el análisis. Por ejemplo, index=web | stats count by status_code transforma los registros de un servidor web sin procesar a una tabla que muestra el conteo de cada código de estado HTTP. Usaría esto para generar un panel de tablero que muestre el estado del sitio web a lo largo del tiempo.

Una búsqueda no transformadora, por otro lado, recupera eventos que coinciden con criterios específicos sin cambiar su estructura básica. Los comandos como search, where, head, tail, sort y regex se utilizan típicamente. Por ejemplo, index=web error devuelve todos los eventos del servidor web que contienen la palabra "error" sin cambiar los datos. Esto es útil para identificar errores específicos en sus registros. Usaría esto para investigaciones de incidentes o depuración de problemas.

3. Describa su experiencia con la creación y gestión de objetos de conocimiento de Splunk, como extracciones de campos, tipos de eventos y etiquetas. ¿Cómo mejoran estos objetos la experiencia de búsqueda y la calidad de los datos?

Tengo amplia experiencia en la creación y gestión de objetos de conocimiento de Splunk. He definido extracciones de campos utilizando tanto la interfaz web de Splunk como archivos de configuración (props.conf, transforms.conf), utilizando expresiones regulares para analizar con precisión datos clave de diversas fuentes de registro. También he creado tipos de eventos para categorizar eventos basados en características comunes, lo que permite una búsqueda y generación de informes más específicas. Además, he implementado estrategias de etiquetado para clasificar eventos basados en atributos o contextos específicos, mejorando la capacidad de búsqueda y correlación entre diferentes fuentes de datos.

Estos objetos de conocimiento mejoran significativamente la experiencia de búsqueda al simplificar consultas complejas. Los usuarios pueden buscar utilizando tipos de eventos y etiquetas en lugar de un lenguaje de procesamiento de búsqueda (SPL) intrincado. También mejoran la calidad de los datos al garantizar la denominación consistente de campos y la categorización de datos, lo que a su vez permite una generación de informes y análisis más precisos. Las extracciones de campos aseguran que los datos se analicen e indexen correctamente, haciéndolos buscables y accionables. La aplicación consistente de estos objetos asegura que los datos sean uniformes y buscables.

4. Explique cómo usaría el Modelo de Información Común (CIM) de Splunk para normalizar datos de diferentes fuentes, y cuáles son los beneficios de hacerlo?

El Modelo de Información Común (CIM) de Splunk se utiliza para normalizar datos de diversas fuentes mapeando campos de varios registros a un conjunto común de campos y etiquetas. Esto se hace instalando y configurando los complementos CIM apropiados para las fuentes de datos. Estos complementos contienen los objetos de conocimiento (extracciones de campos, tipos de eventos, etiquetas, etc.) necesarios para normalizar los datos al CIM. Los datos de diferentes fuentes se mapean a los campos predefinidos del CIM (por ejemplo, src_ip, dest_ip, usuario) utilizando estos objetos de conocimiento.

Los beneficios incluyen: búsqueda e informes simplificados en diferentes fuentes de datos, correlación mejorada de eventos, paneles e alertas estandarizados que funcionan en diferentes tipos de datos y un intercambio de conocimientos más fácil dentro de una organización. Esencialmente, el CIM le permite tratar los datos de diferentes proveedores (por ejemplo, Cisco, CrowdStrike, Okta) de manera consistente, lo que hace que el análisis y las operaciones de seguridad sean más eficientes y efectivos. Esto simplifica la gestión de datos, mejora la postura de seguridad y acelera la respuesta a incidentes.

5. ¿Cómo se monitorea la salud y el rendimiento de un entorno Splunk, incluyendo indexadores, cabezas de búsqueda y forwarders? ¿Qué métricas son más importantes de rastrear?

Monitorear la salud y el rendimiento de Splunk implica rastrear métricas clave en indexadores, cabezas de búsqueda y forwarders. Las métricas importantes incluyen: Tasa de indexación (eventos/segundo), concurrencia de búsqueda, utilización de CPU, uso de memoria, entrada/salida de disco, latencia de red y uso de licencia. Para los forwarders, se debe monitorear el estado de la conexión, el rendimiento de datos y las tasas de error.

Herramientas como Splunk Monitoring Console, Distributed Management Console (DMC) y paneles personalizados se pueden usar para visualizar estas métricas. Configurar alertas para umbrales críticos es crucial para la detección proactiva de problemas. Los archivos de registro (splunkd.log) también son vitales para la solución de problemas y el análisis más profundo. Para una utilización óptima de los recursos, se debe monitorear proactivamente la concurrencia de búsqueda, el volumen de indexación y la capacidad del hardware del entorno Splunk.

6. Describe una vez que tuviste que solucionar un problema de búsqueda lenta en Splunk. ¿Qué pasos seguiste para identificar el cuello de botella y mejorar el rendimiento?

Durante un proyecto reciente, los usuarios informaron un rendimiento lento con una búsqueda de Splunk utilizada para monitorear errores de aplicaciones. Inicialmente, examiné la propia consulta de búsqueda utilizando el Inspector de Trabajo de Búsqueda de Splunk. Esto ayudó a identificar que la búsqueda estaba escaneando un gran volumen de datos innecesariamente. Luego me concentré en optimizar la consulta.

Mi enfoque involucró varios pasos:

- Refiné el rango de tiempo: Reduje la búsqueda solo a la ventana de tiempo relevante cuando se informó el problema.

- Optimicé los índices: Me aseguré de que la búsqueda estuviera utilizando solo los índices relevantes y que los índices estuvieran configurados correctamente para los datos específicos que se estaban buscando.

- Usé filtrado temprano: Trasladé los criterios de filtrado (usando los comandos

whereosearch) al comienzo de la tubería de búsqueda para reducir la cantidad de datos procesados aguas abajo. - Aproveché las extracciones de campos: Aseguré que las extracciones de campos fueran eficientes y utilicé alias de campos donde fuera apropiado para evitar el análisis repetido de cadenas.

- Resumen: Para las búsquedas recurrentes, creé índices de resumen. Las búsquedas programadas poblaron estos índices con agregados precalculados, acelerando dramáticamente los informes.

7. Explique cómo usaría las capacidades de alerta de Splunk para detectar amenazas de seguridad o problemas operativos, y qué mejores prácticas sigue al crear alertas?

Para detectar amenazas de seguridad o problemas operativos utilizando las alertas de Splunk, definiría búsquedas que busquen eventos o patrones específicos que indiquen un problema. Por ejemplo, podría crear una alerta que se active cuando haya múltiples intentos fallidos de inicio de sesión desde una única dirección IP en un corto período de tiempo, lo que indica un posible ataque de fuerza bruta, o alertar si el uso de CPU de un servidor excede un umbral. Las alertas en tiempo real de Splunk me permiten tomar medidas inmediatas cuando ocurren estos eventos.

Las mejores prácticas incluyen: hacer que las alertas sean específicas para reducir los falsos positivos, usar los niveles de severidad apropiados, definir condiciones de activación claras, usar la limitación para evitar tormentas de alertas e incluir runbooks con alertas para que los respondedores sepan qué acción tomar. Por ejemplo, me aseguraría de que la búsqueda esté optimizada para la velocidad y la eficiencia utilizando la indexación y los filtros adecuados. También siempre documento el propósito de la alerta, las condiciones de activación y las acciones recomendadas.

8. ¿Puede describir el proceso de configuración de un entorno Splunk distribuido, incluyendo consideraciones para la agrupación de indexadores y la agrupación de cabezales de búsqueda?

Configurar un entorno Splunk distribuido implica varios pasos clave. Primero, necesita planificar su implementación en función de su volumen de datos y requisitos de búsqueda. Esto incluye decidir el número de indexadores y cabezas de búsqueda. Para la agrupación de indexadores, designará un indexador como nodo maestro y otros como nodos pares. El nodo maestro gestiona la configuración del clúster y la replicación. Para configurar esto, modificará el archivo server.conf en cada nodo, especificando los detalles del nodo maestro y configurando los factores de replicación. Esta configuración garantiza la redundancia y disponibilidad de los datos. La agrupación de cabezas de búsqueda implica configurar múltiples cabezas de búsqueda para compartir la carga de trabajo de búsqueda. Esto se logra designando un implementador, que envía configuraciones a las cabezas de búsqueda. Configurarás las cabezas de búsqueda para que apunten al clúster de indexadores. La configuración de la agrupación de cabezas de búsqueda también va en server.conf.

Las consideraciones clave incluyen el ancho de banda de la red, la capacidad de almacenamiento y la seguridad. Asegúrese de que haya suficiente ancho de banda entre los indexadores para la replicación. Utilice almacenamiento rápido para los indexadores para optimizar el rendimiento. Implemente mecanismos de autenticación y autorización apropiados para proteger su entorno Splunk. Monitorear la salud y el rendimiento de cada componente también es crucial para mantener una configuración Splunk distribuida estable y eficiente.

9. ¿Cómo usaría Splunk para analizar datos de tráfico de red, como NetFlow o capturas de paquetes, para identificar posibles amenazas a la seguridad o cuellos de botella en el rendimiento?

Para analizar el tráfico de red con Splunk, primero ingeriría datos de NetFlow o captura de paquetes usando un reenviador de Splunk o un complemento tecnológico adaptado a la fuente de datos específica. Luego, usaría el lenguaje de procesamiento de búsqueda (SPL) de Splunk para extraer campos relevantes como IP de origen/destino, puertos, protocolos y volumen de tráfico. Para identificar amenazas a la seguridad, correlacionaría el tráfico de red con fuentes de inteligencia de amenazas, buscando comunicación con IPs o dominios maliciosos conocidos. También buscaría patrones de tráfico anómalos, como el uso inusual de puertos, picos en el volumen de tráfico o conexiones a ubicaciones geográficas desconocidas.

Para los cuellos de botella de rendimiento, analizaría la latencia de la red, la pérdida de paquetes y la utilización del ancho de banda. Crearía paneles e visualizaciones para monitorear los indicadores clave de rendimiento (KPI) como el tiempo de ida y vuelta (RTT) y el rendimiento. Al analizar estas métricas, puedo identificar áreas donde el rendimiento de la red se degrada y tomar medidas correctivas. Las capacidades de alerta de Splunk se pueden configurar para notificar a los administradores cuando se exceden ciertos umbrales, lo que permite la identificación y resolución proactiva de problemas de red.

10. Describa su experiencia con el uso del Machine Learning Toolkit (MLTK) de Splunk para construir modelos predictivos o detectar anomalías en los datos.

Tengo experiencia usando el Machine Learning Toolkit (MLTK) de Splunk tanto para modelado predictivo como para detección de anomalías. En un rol anterior, utilicé MLTK para predecir el tiempo de inactividad del servidor basándome en métricas de rendimiento históricas. Esto involucró el uso de algoritmos como la regresión lineal y modelos de pronóstico de series temporales disponibles dentro de MLTK. Utilicé el asistente de Smart Forecasting y personalicé las consultas SPL subyacentes para necesidades comerciales específicas. También experimenté con diferentes algoritmos e ingeniería de características para mejorar la precisión del modelo.

Además, he aprovechado MLTK para la detección de anomalías en los datos de tráfico de la red. Empleé algoritmos de clustering, específicamente k-means, para identificar patrones inusuales y desviaciones del comportamiento normal. Las anomalías detectadas se utilizaron luego para activar alertas e iniciar investigaciones. El proceso implicó el uso de SPL para preprocesar los datos, seleccionar características relevantes, entrenar el modelo y luego usar el comando apply para puntuar nuevos eventos y marcarlos como posibles anomalías. También he utilizado modelos de detección de valores atípicos dentro de MLTK como DensityFunction y Quantile para identificar eventos raros.

11. Explique cómo usaría Splunk para auditar la actividad del usuario y el acceso a datos confidenciales, y qué requisitos de cumplimiento puede ayudar a abordar Splunk?

Para auditar la actividad del usuario y el acceso a datos confidenciales utilizando Splunk, primero configuraría Splunk para ingerir registros de varias fuentes como sistemas operativos (Registros de eventos de Windows, registros de autenticación de Linux), bases de datos (registros de auditoría), aplicaciones y dispositivos de red. Luego, crearía búsquedas y paneles específicos centrados en eventos de autenticación de usuarios (inicios de sesión, cierres de sesión, intentos fallidos), patrones de acceso a datos (operaciones de lectura/escritura en archivos o bases de datos confidenciales) y actividad de usuarios privilegiados (comandos sudo, cambios en las listas de control de acceso). Estas búsquedas podrían activar alertas cuando se detecte actividad anómala o sospechosa, como ubicaciones de inicio de sesión inusuales, acceso no autorizado a datos o intentos de escalada de privilegios. Las extracciones de campos y las búsquedas se pueden usar para normalizar y enriquecer los datos para que sea más fácil correlacionar eventos e identificar patrones.

Splunk puede ayudar a abordar diversos requisitos de cumplimiento como HIPAA (mediante la supervisión del acceso a la información de salud protegida), PCI DSS (mediante el seguimiento del acceso a los datos del titular de la tarjeta), GDPR (mediante la auditoría del acceso y la modificación de datos) y SOX (mediante la supervisión de la actividad del sistema financiero). Al proporcionar una plataforma centralizada para la gestión de registros, la supervisión de la seguridad y la elaboración de informes, Splunk permite a las organizaciones demostrar el cumplimiento a los auditores y a los organismos reguladores. Las aplicaciones y los paneles de cumplimiento preconstruidos en Splunk Enterprise Security pueden agilizar aún más el proceso de cumplimiento al proporcionar plantillas e informes adaptados a normativas específicas.

12. ¿Puede describir los diferentes tipos de licencias de Splunk y cómo impactan en la funcionalidad y el rendimiento de la plataforma?

Las licencias de Splunk rigen la cantidad de datos que puede indexar por día. Existen varios tipos, cada uno de los cuales afecta a la funcionalidad de forma diferente. Los principales son: Licencia Enterprise (funcionalidad completa, límites de datos obligatorios), Licencia Free (funciones limitadas, límite diario de datos muy pequeño, a menudo 500 MB), Licencia Forwarder (permite a los forwarders enviar datos sin consumir la licencia de indexación), Licencia Developer (para desarrollo/pruebas, uso restringido). Superar el volumen diario con licencia suele provocar que se supriman los resultados de la búsqueda o que se muestren advertencias. En cuanto a la funcionalidad, la licencia gratuita carece de autenticación de usuario, alertas y capacidades de búsqueda distribuida, lo que repercute en la usabilidad general de la plataforma para implementaciones mayores. El rendimiento se ve afectado principalmente por el volumen de datos, pero una asignación incorrecta de la licencia también podría provocar una limitación y una menor velocidad de búsqueda.

13. ¿Cómo utilizaría Splunk para analizar los registros del servidor web con el fin de identificar problemas de rendimiento del sitio web, amenazas de seguridad o patrones de comportamiento de los usuarios?

Para analizar los registros del servidor web utilizando Splunk, primero ingestaría los registros en Splunk. Luego, usaría el lenguaje de procesamiento de búsqueda (SPL) de Splunk para extraer campos relevantes como la marca de tiempo, la dirección IP del cliente, el código de estado HTTP, la URI, el agente de usuario y el tiempo de respuesta. Para problemas de rendimiento, me centraría en tiempos de respuesta lentos, altas tasas de error (códigos de estado 5xx) y la utilización de recursos (por ejemplo, solicitudes por segundo). Crearía visualizaciones como gráficos de tiempo y paneles para monitorear estas métricas. Para las amenazas de seguridad, buscaría actividad inusual, como múltiples intentos fallidos de inicio de sesión desde una sola dirección IP, solicitudes de URL sospechosas o grandes cantidades de datos descargados. Crearía alertas para notificarme sobre posibles amenazas. Para comprender el comportamiento del usuario, analizaría las vistas de página, la duración de la sesión, las rutas de navegación y las ubicaciones geográficas. Usando el comando stats de Splunk, puedo agregar datos para identificar páginas populares, flujos de usuarios comunes y áreas donde los usuarios abandonan.

Ejemplos específicos que utilizan SPL podrían incluir index=servidorweb status=500 | stats count by uri para identificar URLs propensas a errores, o index=servidorweb action=login failed | stats count by src_ip | where count > 10 para señalar posibles ataques de fuerza bruta. También usaría las extracciones de campos y búsquedas de Splunk para enriquecer los datos de registro con información adicional, como datos demográficos de usuarios o datos de inteligencia de amenazas.

14. Describa su experiencia con la integración de Splunk con otras herramientas de seguridad, como SIEMs, firewalls o sistemas de detección de intrusiones.

Tengo experiencia en la integración de Splunk con varias herramientas de seguridad para mejorar la detección de amenazas y las capacidades de respuesta a incidentes. Específicamente, he integrado Splunk con plataformas SIEM como QRadar y ArcSight para reenviar registros y alertas, lo que permite la monitorización y el análisis centralizados. Esto implicó la configuración de reenviadores para recopilar datos del SIEM y transformarlos en un formato compatible con Splunk mediante configuraciones como props.conf y transforms.conf.

Además, he integrado Splunk con firewalls (por ejemplo, Palo Alto Networks, Cisco ASA) y sistemas de detección de intrusiones (IDS) como Suricata y Snort. Estas integraciones implicaron configurar los firewalls y los IDS para enviar datos syslog a los forwarders de Splunk, luego analizar y normalizar los datos dentro de Splunk para crear paneles e alertas significativos. También aproveché la API de Splunk para crear acciones de respuesta automatizadas, como bloquear direcciones IP maliciosas basadas en alertas de IDS, fortaleciendo efectivamente la postura de seguridad.

15. Explique cómo usaría Splunk para crear paneles e informes para visualizar los indicadores clave de rendimiento (KPI) y las tendencias para diferentes partes interesadas.

Para crear paneles e informes en Splunk para visualizar KPIs y tendencias, comenzaría por identificar los KPIs específicos relevantes para cada grupo de partes interesadas. Luego, crearía consultas de Splunk usando SPL (Search Processing Language) para extraer los datos necesarios de las fuentes de registro relevantes o eventos indexados. Estas consultas realizarían cálculos y agregaciones para derivar los valores de los KPI. Finalmente, usaría las funciones de panel e informes de Splunk para presentar los datos visualmente. Los paneles contendrían gráficos, tablas y medidores, cada uno visualizando un KPI específico. Los informes podrían programarse para generar y distribuir automáticamente visualizaciones de tendencias a lo largo del tiempo a partes interesadas específicas por correo electrónico u otros medios. Por ejemplo, un panel de KPI de Ventas realizaría un seguimiento del crecimiento de los ingresos, las tasas de cierre de acuerdos y el valor de la cartera de pedidos. Un panel de KPI de Seguridad mostraría incidentes de seguridad, vulnerabilidades y el estado de cumplimiento.

16. ¿Cómo aborda la optimización de las consultas de búsqueda de Splunk para la eficiencia, especialmente cuando se trata de grandes conjuntos de datos o lógica compleja?

Al optimizar las consultas de búsqueda de Splunk, especialmente con grandes conjuntos de datos, me concentro en varias áreas clave. Primero, trato de reducir la cantidad de datos que Splunk necesita procesar al principio de la canalización de búsqueda mediante el uso de índices y rangos de tiempo específicos. Por ejemplo, index=web sourcetype=access_* earliest=-1h es mejor que buscar en todo el tiempo en todos los índices. Luego, aprovecho los comandos de filtrado como where y search de manera eficiente. Por ejemplo, usar search status_code=200 es generalmente más rápido que usar where status_code==200. Además, priorizo el uso del comando fields para extraer solo los campos necesarios lo antes posible, lo que reduce el uso de memoria. Finalmente, usaría el comando stats de manera efectiva para las agregaciones y usaría el comando summarize cuando sea posible, evitando comandos ineficientes como dedup cuando otros comandos son suficientes.

La optimización adicional implica comprender el orden de procesamiento de búsqueda de Splunk. Para una lógica compleja, dividir la búsqueda en sub-búsquedas más pequeñas y manejables puede mejorar el rendimiento. Es crucial evitar el uso de append o appendcols si se puede usar un comando join en su lugar, ya que estos comandos pueden ser muy ineficientes. Además, es bueno optimizar los objetos de conocimiento (como búsquedas guardadas, modelos de datos, etc.) que podrían tener beneficios posteriores.

17. Explique su comprensión de las políticas de retención de datos en Splunk y cómo las implementaría para gestionar los costos de almacenamiento y los requisitos de cumplimiento.

Las políticas de retención de datos en Splunk son cruciales para gestionar los costos de almacenamiento y cumplir con los requisitos de cumplimiento. Definen cuánto tiempo Splunk mantiene los datos indexados antes de archivarlos o eliminarlos. La implementación de estas políticas típicamente implica la configuración de indexes.conf con configuraciones como frozenTimePeriodInSecs que determina cuánto tiempo se conservan los datos en los buckets hot/warm antes de ser movidos a los buckets cold/frozen. También podemos usar el parámetro maxTotalDataSizeMB para definir el tamaño máximo de un índice, activando la eliminación o el archivo de datos una vez que se alcanza el límite.

Para implementar la retención de datos, primero analizaría los patrones de uso de datos y las necesidades de cumplimiento para determinar los períodos de retención apropiados para diferentes tipos de datos. Luego, configuraría indexes.conf en consecuencia, estableciendo períodos de retención basados en el índice. Por ejemplo, podría retener los registros de seguridad durante un período más largo que los registros de aplicaciones. También usaría las capacidades de archivado integradas de Splunk para mover datos más antiguos a un almacenamiento más económico, como Amazon S3 o Glacier, sin dejar de mantener la capacidad de buscarlo si fuera necesario. Monitorear regularmente los tamaños de los índices y la configuración de retención es esencial para garantizar el cumplimiento y optimizar los costos de almacenamiento.

18. Describa una situación en la que tuvo que crear una aplicación Splunk personalizada. ¿Cuáles fueron los desafíos y cómo los superó?

En un rol anterior, necesitaba crear una aplicación Splunk personalizada para monitorear el rendimiento de una aplicación heredada, ya que ninguna aplicación existente abordaba adecuadamente su formato de datos y requisitos específicos. El mayor desafío fue analizar la estructura de registro inusual de la aplicación. Lo superé utilizando las capacidades de regex de Splunk para crear extracciones de campos personalizadas.

Específicamente, utilicé el comando rex y creé varias extracciones de campos en tiempo de búsqueda en props.conf para estructurar correctamente los datos. También construí paneles y alertas personalizados dentro de la aplicación utilizando el XML simple de Splunk para visualizar los indicadores clave de rendimiento de la aplicación. También escribí algunos scripts de Python para algunas búsquedas personalizadas. Esta aplicación le dio al equipo una visibilidad mucho mejor del estado de la aplicación heredada.

19. Explique la importancia de usar extracciones de campos y cómo contribuyen a una búsqueda y análisis más eficientes en Splunk.

Las extracciones de campos en Splunk son cruciales porque transforman datos no estructurados en información estructurada y buscable. Al analizar eventos sin formato y asignar nombres significativos a puntos de datos específicos, mejoran drásticamente la eficiencia de la búsqueda. Sin extracciones de campos, tendría que depender de búsquedas por palabras clave menos eficientes dentro de todos los datos de eventos sin formato, lo que ralentiza las consultas y hace que el análisis sea engorroso.

Las extracciones de campos le permiten apuntar directamente a campos específicos en sus consultas de búsqueda. Esto significa tiempos de búsqueda más rápidos, ya que Splunk puede indexar y recuperar datos de manera más eficiente. Además, los campos extraídos le permiten utilizar las funciones analíticas más potentes de Splunk, como cálculos estadísticos, informes y visualizaciones, que son difíciles o imposibles de realizar eficazmente en datos no estructurados. Por ejemplo, en lugar de buscar "código de error 500", puede extraer un campo llamado error_code y luego buscar error_code=500 que es mucho más rápido y preciso.

20. ¿Cómo usaría Splunk para monitorear y solucionar problemas relacionados con la infraestructura basada en la nube, como AWS o Azure?

Para monitorear y solucionar problemas de la infraestructura en la nube con Splunk, comenzaría por ingerir fuentes de datos relevantes utilizando Splunk Connect para AWS/Azure o similar. Esto incluye registros de servicios como EC2, Lambda, S3 (AWS), o Máquinas Virtuales, Azure Functions, Blob Storage (Azure), así como métricas de CloudWatch o Azure Monitor. Se crearían paneles para visualizar indicadores clave de rendimiento (KPI) como la utilización de la CPU, el uso de la memoria, el tráfico de red y las tasas de error.

Para la solución de problemas, usaría el lenguaje de procesamiento de búsqueda (SPL) de Splunk para correlacionar eventos en diferentes servicios, identificar las causas raíz de los problemas y configurar alertas para anomalías o eventos críticos. Por ejemplo, crearía alertas que se activen cuando la utilización de la CPU exceda un cierto umbral o cuando las tasas de error aumenten repentinamente. Las capacidades de aprendizaje automático de Splunk podrían utilizarse para detectar patrones inusuales y predecir problemas potenciales antes de que impacten en el sistema. También configuraría el rastreo distribuido utilizando herramientas como Jaeger o Zipkin, e integraría esos datos en Splunk para obtener visibilidad de extremo a extremo en los microservicios.

Preguntas de entrevista avanzadas de Splunk

1. ¿Cómo optimizaría una búsqueda de Splunk que se ejecuta lentamente y qué herramientas utilizaría para identificar el cuello de botella?

Para optimizar una búsqueda lenta de Splunk, primero identificaría el cuello de botella utilizando herramientas como el Inspector de trabajos. El Inspector de trabajos proporciona métricas de rendimiento detalladas sobre cada etapa de la búsqueda, destacando las áreas que consumen la mayor cantidad de recursos (CPU, memoria, E/S). Buscaría eventos escaneados, la utilización de la CPU y la duración de las diferentes fases de búsqueda.

Según el cuello de botella, aplicaría técnicas de optimización como:

- Usar índices de manera efectiva: Asegúrese de que la búsqueda use el índice más relevante. Use

index=para especificar los índices. - Filtrado temprano: Filtre los eventos irrelevantes lo antes posible en la búsqueda utilizando los comandos

whereosearchcon criterios específicos. - Optimización de sub-búsquedas: Evalúe la eficiencia de cualquier sub-búsqueda. A veces, reescribirlas como uniones o búsquedas puede mejorar el rendimiento.

- Usar extracciones de campo en el momento de la indexación: Si es posible, extraiga campos en el momento de la indexación en lugar del momento de la búsqueda.

- Resumen: Considere el uso de índices de resumen para precalcular agregados para búsquedas comunes.

- Limitar el conjunto de resultados: Use head y tail, o un rango de tiempo para limitar la cantidad de datos que se devuelven en la búsqueda.

- Usando tstats: Para crear informes estadísticos,

tstatsutiliza almacenes de datos acelerados y ofrece un rendimiento mucho más rápido.

2. Describe una búsqueda compleja de Splunk que hayas construido, detallando el problema que resolvió, las técnicas que usaste y cualquier desafío que superaste.

Una vez construí una búsqueda compleja de Splunk para identificar un comportamiento anómalo del usuario que indicara posibles intentos de exfiltración de datos. El problema era que las alertas de umbral simples basadas en los recuentos de inicio de sesión o los volúmenes de acceso a datos generaban demasiados falsos positivos. Necesitaba correlacionar varios factores para pintar una imagen más precisa. Mi búsqueda correlacionó los tiempos de inicio de sesión, los tipos de archivos accedidos, las ubicaciones geográficas y el volumen de tráfico de red para cada usuario durante un período de tiempo específico. Utilicé varias técnicas avanzadas, incluyendo transaction para agrupar eventos relacionados, geostats para visualizar las ubicaciones de inicio de sesión y funciones estadísticas como stdev y avg para identificar desviaciones del comportamiento normal.

El principal desafío fue el rendimiento. Las búsquedas iniciales eran lentas debido al gran volumen de datos. Optimicé la búsqueda utilizando extracciones de campos en el momento de la indexación, limitando el rango de tiempo solo a lo necesario y usando summarize para reducir la cantidad de datos procesados en etapas posteriores. También creé tablas de consulta para almacenar los patrones de acceso típicos de los usuarios, lo que redujo drásticamente el tiempo de búsqueda. La búsqueda final redujo significativamente los falsos positivos y proporcionó una lista priorizada de usuarios para la investigación.

3. Explique cómo implementaría una política de retención de datos en Splunk para administrar los costos de almacenamiento y garantizar el cumplimiento.

Para implementar una política de retención de datos en Splunk, usaría principalmente los índices y sus configuraciones asociadas. Splunk permite establecer una antigüedad máxima para los eventos almacenados en cada índice utilizando el atributo maxDataAge en indexes.conf. Cuando los datos exceden esta antigüedad, Splunk los archiva o borra automáticamente, lo que ayuda a administrar los costos de almacenamiento. También consideraría usar políticas de rotación de datos donde los buckets calientes rotan a tibios, luego a fríos y, finalmente, se archivan/borran. Para el cumplimiento, me aseguraría de que el período de retención se ajuste a los requisitos reglamentarios e implementaría el registro de auditoría para rastrear las actividades de eliminación de datos, proporcionando un registro claro de los esfuerzos de cumplimiento.

Además, aprovecharía las funciones de gestión del ciclo de vida de los buckets de Splunk. Podemos definir los tamaños de los buckets hot, warm y cold. Cuando un bucket alcanza un cierto tamaño o umbral de antigüedad, pasa a la siguiente etapa. Los buckets cold pueden archivarse en un almacenamiento más económico o eliminarse según la configuración de frozenTimePeriodInSecs. El monitoreo regular de los tamaños de los índices y la efectividad de la política de retención es crucial para abordar de forma proactiva los posibles problemas de almacenamiento y mantener el cumplimiento.

4. ¿Cuáles son las consideraciones clave al diseñar una implementación de Splunk para alta disponibilidad y recuperación ante desastres?

Al diseñar una implementación de Splunk para alta disponibilidad (HA) y recuperación ante desastres (DR), entran en juego varias consideraciones clave. Para HA, concéntrese en eliminar los puntos únicos de falla a través de la redundancia. Esto incluye el uso de clústeres de cabezas de búsqueda para la búsqueda distribuida y el acceso a la interfaz de usuario, clústeres de indexadores para la replicación y gestión de datos (asegurando múltiples copias de datos en diferentes indexadores) y la implementación de balanceadores de carga para distribuir el tráfico entre las cabezas de búsqueda y los indexadores. Una solución de monitoreo también es fundamental para la detección proactiva de fallas.

Para DR, el objetivo es mantener la continuidad del negocio en caso de una interrupción completa del sitio. Esto implica la replicación de datos a un sitio DR secundario, normalmente utilizando un mecanismo como la replicación de almacenamiento o las funciones integradas de Splunk para la recuperación del sitio. Defina un Objetivo de Punto de Recuperación (RPO) y un Objetivo de Tiempo de Recuperación (RTO) claros para guiar el diseño y la implementación. Pruebe regularmente el plan de DR para asegurarse de que funciona como se espera e identificar posibles problemas. Esto incluye automatizar los procesos de conmutación por error y conmutación por recuperación en la medida de lo posible para minimizar el tiempo de inactividad. Además, considere el ancho de banda de la red y la latencia entre los sitios primario y DR, ya que pueden afectar el rendimiento de la replicación y el tiempo de recuperación.

5. ¿Cómo puede utilizar las capacidades de aprendizaje automático de Splunk para detectar anomalías en sus datos y cuáles son las limitaciones?

El Machine Learning Toolkit (MLTK) de Splunk y las aplicaciones asociadas ofrecen varias formas de detectar anomalías. Puede usar algoritmos predefinidos como AnomalyDetection que modelan datos históricos e identifican desviaciones de la norma. Otros métodos incluyen algoritmos de agrupación para agrupar eventos similares y señalar valores atípicos, o usar pronósticos para predecir valores futuros y compararlos con los valores reales. Las búsquedas personalizadas que aprovechan comandos estadísticos como stdev, mean y relative_deviation también pueden identificar picos o caídas inusuales. Estos métodos requieren datos formateados e indexados correctamente, y a menudo necesitan ajustes finos de los umbrales o los parámetros del modelo para evitar falsos positivos o negativos.

Las limitaciones incluyen la necesidad de datos históricos suficientes para entrenar modelos de manera efectiva; los modelos son tan buenos como los datos con los que se entrenan. Además, los algoritmos pueden tener dificultades con la estacionalidad o las tendencias, lo que requiere un manejo específico o la ingeniería de características. Las anomalías complejas o las que dependen de múltiples variables pueden ser difíciles de capturar con métodos más simples, lo que podría requerir modelos de aprendizaje automático más avanzados o personalizados. Finalmente, explicar las detecciones de anomalías a las partes interesadas no técnicas a veces puede resultar difícil.

6. Discuta su experiencia con el Modelo de Información Común (CIM) de Splunk y cómo se puede usar para normalizar datos de diferentes fuentes.

Tengo experiencia en el uso del Modelo de Información Común (CIM) de Splunk para normalizar datos de diversas fuentes. El CIM proporciona un esquema estandarizado para representar datos, lo que permite búsquedas, informes y correlaciones consistentes en diferentes tipos de datos. Mi experiencia implica mapear campos de varias fuentes de datos (por ejemplo, registros de firewall, registros de servidores web, datos de endpoints) a los campos CIM correspondientes. Esto me permite usar búsquedas y paneles compatibles con CIM para analizar datos de manera uniforme, independientemente de su fuente original. Esto facilita la identificación de tendencias, la investigación de incidentes de seguridad y la generación de informes en toda la infraestructura de TI.

Específicamente, he trabajado con la aceleración CIM y objetos de conocimiento como etiquetas y alias para garantizar un rendimiento de búsqueda eficiente. Esto implica validar que los datos se ajusten al esquema CIM mediante el uso del panel de validación CIM y las extracciones de campos, así como el aprovechamiento de aplicaciones y complementos compatibles con CIM para acelerar el análisis y mejorar la usabilidad general de los datos dentro de Splunk. Mis flujos de trabajo de incorporación de datos invariablemente incluyen pasos para garantizar que los datos se alineen con CIM.

7. ¿Cómo solucionaría un problema en el que Splunk no indexa datos como se esperaba, y qué pasos tomaría para resolver el problema?

Cuando Splunk no está indexando datos, comenzaría por verificar lo básico: ¿La instancia de Splunk se está ejecutando? ¿El reenviador está configurado correctamente y enviando datos a los indexadores correctos? Luego, examinaría los registros internos de Splunk (index=_internal) en busca de errores relacionados con la ingestión de datos, violaciones de licencias o problemas de conectividad con los reenviadores. También verificaría que las entradas estén configuradas correctamente (por ejemplo, rutas de archivo correctas, tipos de origen) y que no haya problemas con las transformaciones (props.conf, transforms.conf) que impidan la indexación.

8. Explique cómo puede usar la API REST de Splunk para integrarse con otros sistemas y automatizar tareas.

La API REST de Splunk permite la integración con otros sistemas y la automatización de tareas al proporcionar acceso programático a las funcionalidades de Splunk. Puede usarla para realizar búsquedas, recuperar datos, administrar configuraciones y activar alertas externamente. Por ejemplo, puede usar curl o un lenguaje de programación como Python para interactuar con la API. Al usarla, uno puede automatizar tareas como:

- Ingesta de datos: Reenvía automáticamente datos de fuentes externas a Splunk.

- Gestión de la configuración: Actualiza programáticamente las configuraciones de Splunk, como agregar nuevas entradas o modificar las existentes.

- Alertas y notificaciones: Integra las alertas de Splunk con otros sistemas, como sistemas de tickets o plataformas de notificación. Por ejemplo, cuando se activa una alerta de Splunk, se puede utilizar la API REST para crear automáticamente un ticket en ServiceNow.

- Generación de informes: Programa y automatiza la generación de informes y paneles.

9. Describe cómo configuraría el control de acceso basado en roles en Splunk para garantizar que los usuarios solo tengan acceso a los datos que necesitan.

Para implementar el control de acceso basado en roles (RBAC) en Splunk, primero definiría roles basados en las funciones laborales y los datos que requieren. Por ejemplo, un rol de analista de seguridad podría necesitar acceso a los registros de seguridad, mientras que un rol de analista de marketing necesita acceso a los registros del servidor web relacionados con las campañas de marketing. Luego, crearía estos roles en Splunk, especificando las capacidades que poseen, como la capacidad de buscar en índices específicos o usar comandos particulares. Después, asignaría usuarios a los roles apropiados. Específicamente:

- Cree roles de Splunk (por ejemplo, security_analyst, marketing_analyst).

- Defina capacidades para cada rol (acceso al índice, comandos permitidos).

- Asigne usuarios a roles. Esto asegura que los usuarios solo tengan acceso a los datos y funcionalidades relevantes para sus roles, mejorando la seguridad y el cumplimiento. Puedo usar la interfaz de usuario de Splunk o la interfaz de línea de comandos (CLI) para gestionar roles y usuarios. Por ejemplo,

splunk add role <nombre_del_rol> -capability <nombre_de_la_capacidad>para agregar capacidades a un rol.

10. ¿Cómo puede usar los paneles de Splunk para visualizar los indicadores clave de rendimiento (KPI) y realizar un seguimiento de las tendencias a lo largo del tiempo?

Los paneles de Splunk son potentes para visualizar los KPI y realizar un seguimiento de las tendencias. Puede crear paneles que muestren métricas clave utilizando consultas de búsqueda. Estas consultas pueden agregar datos, calcular tasas, promedios u otros indicadores de rendimiento relevantes. Splunk ofrece varios tipos de gráficos (línea, barra, circular, etc.) para representar los datos de manera efectiva. Para el análisis de tendencias, utilice gráficos basados en el tiempo que muestren los KPI durante períodos específicos.

Para rastrear tendencias, configure el selector de rango de tiempo para permitir a los usuarios ajustar dinámicamente el marco de tiempo mostrado. Use el comando timechart en sus consultas SPL para visualizaciones de series temporales. Las alertas también se pueden configurar en función de los umbrales de KPI para identificar proactivamente las desviaciones de las tendencias esperadas. Por ejemplo, index=myindex sourcetype=mysourcetype | timechart count by category generará un gráfico de series temporales que muestra el recuento de eventos por categoría a lo largo del tiempo. Además, puede usar drilldowns para navegar desde los KPI de resumen a paneles más detallados para un análisis más profundo.

11. Discuta su experiencia con las capacidades de alerta de Splunk y cómo configuraría alertas para responder a eventos críticos.

Tengo experiencia en la configuración de alertas de Splunk para varios eventos críticos. He usado búsquedas programadas y alertas en tiempo real, dependiendo de la inmediatez requerida. Mi flujo de trabajo típico implica definir una consulta de búsqueda que identifique el evento crítico, establecer un umbral para activar la alerta y configurar las acciones apropiadas. Las acciones pueden incluir el envío de notificaciones por correo electrónico, la creación de tickets en un sistema de tickets a través de scripts o la activación de webhooks para iniciar procesos de remediación automatizados.

Para configurar alertas para eventos críticos, priorizo alertas claras y procesables. Esto incluye la creación de líneas de asunto y cuerpos de mensaje significativos que proporcionen contexto sobre el evento y su impacto potencial. También configuro niveles de gravedad apropiados (por ejemplo, crítico, alto, medio) para priorizar las respuestas. Además, considero técnicas de supresión de alertas, como el uso de configuraciones de "estrangulamiento" o búsquedas de correlación, para evitar la fatiga de alertas por eventos recurrentes. Por ejemplo, para monitorear registros de errores, podría configurar una alerta para que se active si el recuento de mensajes 'ERROR' excede un cierto umbral dentro de un período de tiempo específico.

12. ¿Cómo usaría Splunk para investigar un incidente de seguridad y qué tipos de búsquedas ejecutaría para identificar la causa raíz?

Para investigar un incidente de seguridad usando Splunk, comenzaría por identificar los sistemas y usuarios afectados, y el período de tiempo del incidente. Correlacionaría los registros de diversas fuentes como firewalls, sistemas de detección de intrusiones, herramientas de seguridad de endpoints y servidores de aplicaciones utilizando el lenguaje de procesamiento de búsqueda (SPL) de Splunk. Comenzaría normalizando los datos para evitar cualquier suposición/correlación incorrecta.

Las búsquedas específicas podrían incluir la búsqueda de patrones de tráfico de red inusuales (por ejemplo, grandes transferencias de datos a IPs desconocidas), intentos de inicio de sesión fallidos seguidos de inicios de sesión exitosos, ejecuciones de procesos sospechosos en endpoints o cambios en archivos críticos del sistema. Ejemplos de búsquedas SPL serían: index=firewall src_ip=* dst_ip=* bytes_out>1000000 | stats sum(bytes_out) by src_ip, dst_ip | sort - sum(bytes_out) para encontrar grandes transferencias de datos. Otro ejemplo index=windows EventCode=4625 | stats count by Account_Name | sort -count | head 10 para encontrar las cuentas con la mayoría de los intentos de inicio de sesión fallidos. El objetivo es identificar el punto de entrada inicial, el movimiento lateral y el alcance de la intrusión para determinar la causa raíz, que podría ser una vulnerabilidad, una configuración incorrecta o credenciales comprometidas.

13. Explique cómo puede usar el comando transaction de Splunk para agrupar eventos relacionados y analizarlos como una sola unidad.

El comando transaction en Splunk agrupa eventos basándose en criterios como un campo común (por ejemplo, ID de usuario, ID de sesión) y restricciones de tiempo. Permite tratar una serie de eventos relacionados como una única transacción para el análisis. Esto es útil para identificar patrones, calcular duraciones y comprender secuencias de eventos.

Por ejemplo, si tiene registros del servidor web con IDs de usuario, podría usar transaction user_id maxspan=10m para agrupar todos los eventos de un usuario específico dentro de una ventana de 10 minutos en una sola transacción. Luego, puede usar funciones como duration (para encontrar la duración total de la sesión) o eventcount para contar eventos dentro de la transacción. Se capturan los tiempos de inicio y fin. También puede especificar eventos de inicio y fin. Sin un parámetro startswith o endswith, cualquier evento puede comenzar o finalizar una transacción.

14. Describa cómo usaría Splunk para monitorear el rendimiento de una aplicación web y qué métricas rastrearía.

Para monitorear el rendimiento de una aplicación web usando Splunk, primero configuraría los servidores de aplicaciones y cualquier infraestructura relevante (bases de datos, equilibradores de carga, etc.) para reenviar sus registros a Splunk. Luego crearía paneles y alertas basados en métricas específicas extraídas de estos registros.

Las métricas clave para rastrear incluyen: códigos de respuesta HTTP (por ejemplo, 200, 400, 500), tiempos de respuesta para diferentes URL/puntos de conexión, tasas de solicitud (solicitudes por segundo), tasas de error, utilización de la CPU en los servidores, uso de memoria, rendimiento de consultas de la base de datos y latencia de la red. También monitorearía los registros específicos de la aplicación en busca de excepciones o errores. Usando el lenguaje de procesamiento de búsqueda de Splunk, crearía consultas para calcular estas métricas, visualizarlas en paneles y configurar alertas para notificarme de cualquier anomalía o degradación del rendimiento. Por ejemplo, una consulta como index="web_logs" status_code>=500 | stats count by status_code puede resaltar errores del servidor. Además, se podría aprovechar el kit de herramientas de Machine Learning de Splunk para establecer el rendimiento de referencia y detectar desviaciones.

15. ¿Cómo puede utilizar las tablas de búsqueda de Splunk para enriquecer sus datos con información adicional y cuáles son los beneficios?

Las tablas de búsqueda de Splunk enriquecen los datos agregando campos de fuentes externas basándose en valores coincidentes en sus datos indexados. Define una búsqueda que mapea un campo en sus eventos a un campo en la tabla de búsqueda. Cuando Splunk procesa un evento, comprueba en la tabla de búsqueda si hay un valor coincidente y añade los campos correspondientes al evento.

Los beneficios incluyen: * Enriquecimiento de datos: Añadir contexto como ubicaciones geográficas o roles de usuario. * Normalización de datos: Estandarizar formatos de datos (por ejemplo, convertir códigos de país a nombres completos). * Mejora de la búsqueda y los informes: Facilitar búsquedas más específicas y crear informes más informativos mediante el uso de los campos añadidos. * Consultas simplificadas: Reducir la necesidad de comandos de búsqueda complejos pre-uniendo datos.

16. Discuta su experiencia con el proceso de incorporación de datos de Splunk, incluyendo cómo configuraría las entradas y los tipos de origen.