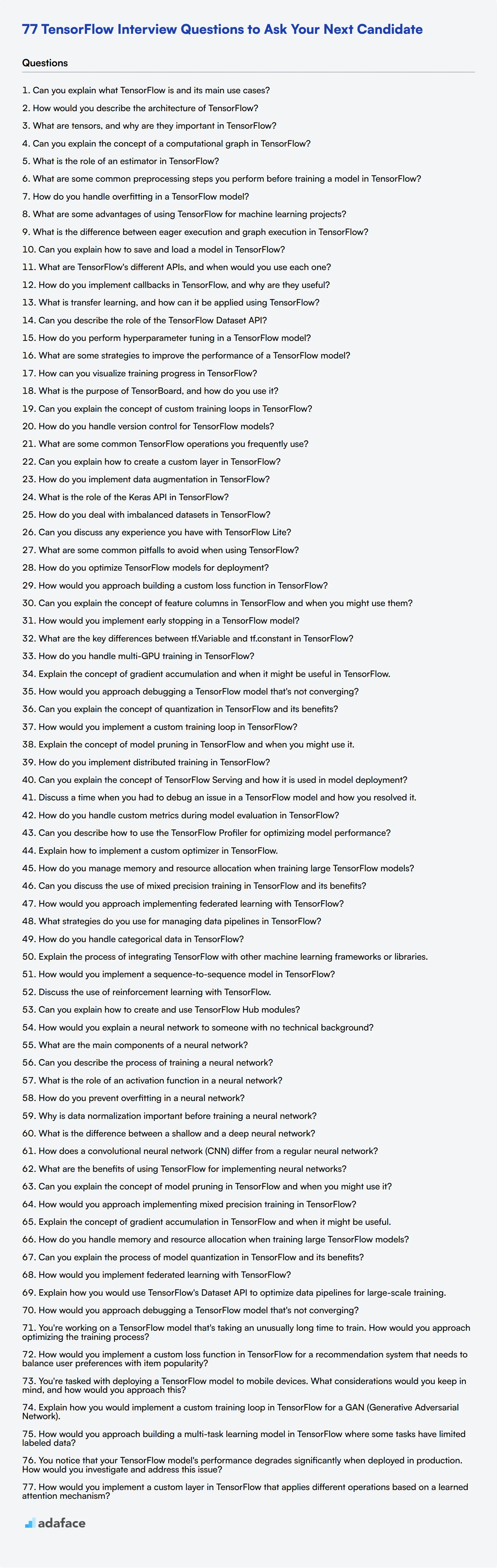

77 Preguntas de Entrevista de TensorFlow para Preguntar a tu Próximo Candidato

Contratar al desarrollador de TensorFlow adecuado es fundamental, ya que garantiza que sus proyectos de aprendizaje automático se construyan sobre una base sólida. Hacer preguntas perspicaces en la entrevista puede ayudarlo a identificar a los mejores candidatos que poseen tanto las habilidades técnicas como la capacidad de resolución de problemas necesarias para el puesto.

Esta publicación de blog cubre una lista completa de preguntas de entrevista de TensorFlow diseñadas para varios niveles de experiencia, desde desarrolladores junior hasta senior. También incluye preguntas relacionadas con las redes neuronales, la optimización de modelos y los desafíos situacionales para ayudarlo a evaluar la profundidad de conocimiento de un candidato.

Al usar estas preguntas, puede optimizar su proceso de entrevista y tomar decisiones de contratación informadas. Además, considere complementar estas preguntas con nuestra prueba en línea de aprendizaje automático para evaluar aún más las habilidades del candidato antes de la etapa de la entrevista.

Tabla de contenido

8 preguntas y respuestas generales de la entrevista de TensorFlow

20 preguntas de la entrevista de TensorFlow para hacer a los desarrolladores junior

10 preguntas y respuestas de la entrevista de TensorFlow intermedias para hacer a los desarrolladores de nivel medio

15 preguntas avanzadas de la entrevista de TensorFlow para hacer a los desarrolladores senior

9 preguntas y respuestas de la entrevista de TensorFlow relacionadas con las redes neuronales

8 preguntas y respuestas de la entrevista de TensorFlow relacionadas con la optimización del modelo

7 preguntas situacionales de la entrevista de TensorFlow con respuestas para contratar a los mejores desarrolladores

¿Qué habilidades de TensorFlow debe evaluar durante la fase de la entrevista?

Contrata a los mejores talentos con pruebas de habilidades de TensorFlow y las preguntas de entrevista adecuadas

Descarga la plantilla de preguntas de entrevista de TensorFlow en múltiples formatos

8 preguntas y respuestas generales sobre entrevistas de TensorFlow

Para determinar si tus candidatos tienen la comprensión y las habilidades adecuadas para usar TensorFlow de manera efectiva, hazles algunas de estas 8 preguntas generales de entrevista de TensorFlow. Esta lista te ayudará a evaluar sus conocimientos prácticos y sus habilidades para resolver problemas, asegurando que contrates a la persona más adecuada para tu equipo.

1. ¿Puedes explicar qué es TensorFlow y sus principales casos de uso?

TensorFlow es un marco de aprendizaje automático de código abierto desarrollado por Google. Permite a los desarrolladores crear gráficos de flujo de datos, estructuras que describen cómo los datos se mueven a través de una serie de nodos de procesamiento. Cada nodo representa una operación matemática, y cada conexión o arista es una matriz de datos multidimensional (tensor).

Los principales casos de uso de TensorFlow incluyen la construcción de modelos de aprendizaje automático y aprendizaje profundo, el procesamiento del lenguaje natural, el reconocimiento de imágenes y video, y más. Es versátil y se puede utilizar en varias industrias como la atención médica, las finanzas y la automoción para tareas como el análisis predictivo y la conducción autónoma.

Busque candidatos que puedan articular claramente qué es TensorFlow y proporcionar ejemplos específicos de sus aplicaciones. Esto indica una sólida comprensión fundamental.

2. ¿Cómo describiría la arquitectura de TensorFlow?

La arquitectura de TensorFlow consta de tres partes principales: el preprocesamiento de datos, la creación del modelo y el entrenamiento y la estimación del modelo.

-

Preprocesamiento: Esto implica preparar los datos para el entrenamiento del modelo. Es un paso crucial para asegurar que los datos estén en el formato correcto.

-

Creación del modelo: Usando las capas y operaciones de TensorFlow, puede crear un grafo computacional que representa su modelo.

-

Entrenamiento y estimación: Esta parte implica alimentar los datos preparados al modelo y ajustar los parámetros del modelo para minimizar el error en las predicciones.

Los candidatos deben ser capaces de explicar estos pasos con claridad y podrían describir cómo han aplicado esta arquitectura en proyectos anteriores. Su explicación debe reflejar una comprensión práctica del flujo de trabajo de TensorFlow.

3. ¿Qué son los tensores y por qué son importantes en TensorFlow?

Los tensores son las estructuras de datos centrales en TensorFlow. Son arreglos multidimensionales que se utilizan para representar los datos que el modelo está procesando. Los tensores pueden variar desde escalares simples (números individuales) hasta arreglos multidimensionales complejos (como matrices o arreglos de mayor dimensión).

Los tensores son fundamentales porque permiten que TensorFlow maneje cálculos a gran escala de manera eficiente. Permiten la flexibilidad y escalabilidad necesarias para construir modelos de aprendizaje automático complejos. Por ejemplo, en el reconocimiento de imágenes, un tensor puede representar una imagen como una matriz 3D de valores de píxeles.

Busque candidatos que puedan describir los tensores en términos sencillos y explicar su importancia en el manejo y procesamiento de datos dentro de TensorFlow. Esto demuestra que comprenden profundamente los conceptos fundamentales.

4. ¿Puede explicar el concepto de un gráfico computacional en TensorFlow?

Un gráfico computacional en TensorFlow es una representación visual de las operaciones matemáticas y el flujo de datos en un modelo de aprendizaje automático. Consiste en nodos (operaciones) y aristas (tensores). Cada nodo realiza una operación específica, como suma o multiplicación, y las aristas transportan los datos entre estas operaciones.

El gráfico computacional permite a TensorFlow optimizar los cálculos mediante la paralelización de operaciones y la gestión eficiente de la memoria. Esto hace posible manejar conjuntos de datos grandes y modelos complejos de manera más efectiva.

Los candidatos deben ser capaces de explicar la estructura y el propósito de los gráficos computacionales. Su comprensión de cómo estos gráficos optimizan y paralelizan las operaciones puede indicar su dominio de TensorFlow.

5. ¿Cuál es el papel de un estimador en TensorFlow?

En TensorFlow, un estimador es una API de alto nivel que simplifica el proceso de creación, entrenamiento y evaluación de modelos de aprendizaje automático. Los estimadores encapsulan todo el modelo, incluida la lógica de entrenamiento y evaluación, lo que facilita la implementación de modelos complejos con menos código.

Los estimadores proporcionan bucles de entrenamiento incorporados, métricas de evaluación y sirven como puente entre sus datos y el modelo. Se encargan de las complejidades del entrenamiento del modelo, lo que permite a los desarrolladores concentrarse más en el diseño del modelo y menos en el código repetitivo.

Busque candidatos que puedan articular los beneficios de usar estimadores, como la facilidad de uso y la eficiencia. Su respuesta debe resaltar su familiaridad con las API de alto nivel de TensorFlow.

6. ¿Cuáles son algunos pasos comunes de preprocesamiento que realiza antes de entrenar un modelo en TensorFlow?

Los pasos comunes de preprocesamiento en TensorFlow incluyen la limpieza de datos, la normalización y la ampliación. La limpieza de datos implica el manejo de valores faltantes, la eliminación de duplicados y la corrección de errores. La normalización escala los datos a un rango estándar, lo que ayuda a acelerar el proceso de entrenamiento y a mejorar la precisión del modelo.

La aumentación de datos es particularmente útil en el procesamiento de imágenes e involucra técnicas como la rotación, el volteo y el recorte para generar más ejemplos de entrenamiento a partir de los datos existentes. Esto ayuda a que el modelo sea más robusto y generalizable.

Los candidatos deben discutir las técnicas de preprocesamiento específicas que han utilizado y explicar por qué estos pasos son importantes. Esto demostrará su experiencia práctica y atención al detalle.

7. ¿Cómo se maneja el sobreajuste en un modelo TensorFlow?

El sobreajuste ocurre cuando un modelo funciona bien con los datos de entrenamiento, pero mal con los datos de prueba no vistos. Para manejar el sobreajuste, se pueden utilizar técnicas como la regularización, el abandono (dropout) y la aumentación de datos. La regularización agrega una penalización por coeficientes más grandes en el modelo, lo que desalienta la complejidad. El abandono elimina aleatoriamente neuronas durante el entrenamiento, evitando que el modelo dependa demasiado de caminos específicos.

Otro método efectivo es usar la validación cruzada, donde los datos de entrenamiento se dividen en múltiples subconjuntos, y el modelo se entrena y evalúa en estos subconjuntos para asegurar la robustez. La detención anticipada, donde el entrenamiento se detiene una vez que el rendimiento en un conjunto de validación comienza a disminuir, también puede ser útil.

Los candidatos deben mencionar múltiples estrategias y proporcionar ejemplos de cómo han aplicado estas técnicas en sus proyectos. Esto demuestra que comprenden las implicaciones prácticas del sobreajuste y saben cómo mitigarlo.

8. ¿Cuáles son algunas ventajas de usar TensorFlow para proyectos de aprendizaje automático?

TensorFlow ofrece varias ventajas para los proyectos de aprendizaje automático, incluyendo flexibilidad, escalabilidad y un rico ecosistema. Su flexibilidad permite a los desarrolladores construir y experimentar con modelos complejos, mientras que su escalabilidad asegura que estos modelos puedan ser implementados en varias plataformas, desde dispositivos móviles hasta entornos de computación distribuida.

El ecosistema de TensorFlow incluye una plétora de herramientas y bibliotecas como TensorFlow Lite para dispositivos móviles e integrados, y TensorFlow Extended (TFX) para tuberías de aprendizaje automático de extremo a extremo. El extenso soporte de la comunidad y la documentación completa también facilitan la resolución de problemas y la innovación.

Busque candidatos que puedan destacar ventajas específicas y relacionarlas con sus proyectos anteriores. Su capacidad para conectar estos beneficios con casos de uso prácticos indica una sólida comprensión de las fortalezas de TensorFlow.

20 preguntas de entrevista de TensorFlow para hacer a desarrolladores junior

Para identificar si los candidatos tienen las habilidades fundamentales necesarias en TensorFlow, considere hacer estas 20 preguntas de entrevista diseñadas para desarrolladores junior. Esta lista le ayudará a evaluar su comprensión y conocimiento práctico, asegurando que encajen bien en su equipo. Para obtener información adicional sobre las cualificaciones de los candidatos, consulte nuestra descripción del puesto de ingeniero de aprendizaje automático.

- ¿Cuál es la diferencia entre la ejecución eager y la ejecución de gráficos en TensorFlow?

- ¿Puede explicar cómo guardar y cargar un modelo en TensorFlow?

- ¿Cuáles son las diferentes API de TensorFlow y cuándo usaría cada una?

- ¿Cómo implementa callbacks en TensorFlow y por qué son útiles?

- ¿Qué es el aprendizaje por transferencia y cómo se puede aplicar usando TensorFlow?

- ¿Puede describir el papel de la API de conjuntos de datos de TensorFlow?

- ¿Cómo realiza el ajuste de hiperparámetros en un modelo de TensorFlow?

- ¿Cuáles son algunas estrategias para mejorar el rendimiento de un modelo de TensorFlow?

- ¿Cómo puede visualizar el progreso del entrenamiento en TensorFlow?

- ¿Cuál es el propósito de TensorBoard y cómo lo usa?

- ¿Puede explicar el concepto de bucles de entrenamiento personalizados en TensorFlow?

- ¿Cómo maneja el control de versiones para modelos de TensorFlow?

- ¿Cuáles son algunas operaciones comunes de TensorFlow que usa con frecuencia?

- ¿Puede explicar cómo crear una capa personalizada en TensorFlow?

- ¿Cómo implementa la aumento de datos en TensorFlow?

- ¿Cuál es el papel de la API Keras en TensorFlow?

- ¿Cómo se enfrenta a conjuntos de datos desequilibrados en TensorFlow?

- ¿Puede discutir alguna experiencia que tenga con TensorFlow Lite?

- ¿Cuáles son algunos escollos comunes a evitar al usar TensorFlow?

- ¿Cómo optimiza los modelos de TensorFlow para su implementación?

10 preguntas y respuestas intermedias de TensorFlow para hacer a desarrolladores de nivel medio

¿Listo para mejorar tus entrevistas de TensorFlow? Estas 10 preguntas intermedias son perfectas para evaluar a desarrolladores de nivel medio. Te ayudarán a medir el conocimiento práctico y las habilidades de resolución de problemas de un candidato sin profundizar demasiado en los tecnicismos. Usa estas preguntas para iniciar discusiones perspicaces y descubrir el verdadero potencial de tus candidatos de TensorFlow.

1. ¿Cómo abordaría la construcción de una función de pérdida personalizada en TensorFlow?

Construir una función de pérdida personalizada en TensorFlow implica subclasear la clase tf.keras.losses.Loss e implementar el método call. Este método debe tomar las etiquetas verdaderas y los valores predichos como entradas y devolver la pérdida calculada.

Un candidato sólido debe explicar que la función de pérdida personalizada debe ser compatible con la diferenciación automática para la retropropagación. También podrían mencionar la importancia de considerar la escala de la pérdida y asegurar que sea diferenciable con respecto a los parámetros del modelo.

Busque candidatos que puedan proporcionar un ejemplo simple, como crear una versión ponderada de una función de pérdida existente o combinar múltiples términos de pérdida. Su respuesta debe demostrar una comprensión de cómo las funciones de pérdida guían el proceso de aprendizaje del modelo.

2. ¿Puede explicar el concepto de columnas de características en TensorFlow y cuándo podría usarlas?

Las columnas de características en TensorFlow son una forma de cerrar la brecha entre los datos sin procesar y el formato esperado por los modelos de aprendizaje automático. Actúan como una abstracción que le permite transformar y preprocesar los datos antes de introducirlos en su modelo.

Los candidatos deben mencionar que las columnas de características son particularmente útiles cuando se trabaja con datos estructurados, como datos de bases de datos o archivos CSV. Ayudan a manejar varios tipos de datos (numéricos, categóricos, etc.) y a realizar tareas comunes de preprocesamiento como la normalización, la codificación one-hot o el bucketizing.

Busque respuestas que destaquen la flexibilidad de las columnas de características al crear interacciones complejas de características o capas de incrustación para variables categóricas. Un buen candidato también podría discutir cómo se pueden usar las columnas de características con la API tf.data para pipelines de datos eficientes.

3. ¿Cómo implementaría la detención anticipada en un modelo TensorFlow?

La implementación de la detención anticipada en TensorFlow implica el uso del callback EarlyStopping durante el entrenamiento del modelo. Este callback monitorea una métrica especificada (generalmente la pérdida de validación) y detiene el entrenamiento cuando la métrica deja de mejorar.

Una buena respuesta debe incluir los siguientes pasos:

-

Importar el callback EarlyStopping desde tf.keras.callbacks

-

Crear una instancia de EarlyStopping, especificando parámetros como 'monitor' (la métrica a observar), 'patience' (número de épocas sin mejora antes de detenerse) y 'restore_best_weights' (para mantener los mejores pesos del modelo)

-

Incluir la instancia EarlyStopping en la lista de callbacks al llamar a model.fit()

Busque candidatos que entiendan el propósito de la detención anticipada para prevenir el sobreajuste y reducir el tiempo de entrenamiento. También deberían ser capaces de discutir cómo elegir valores apropiados para la paciencia y la métrica monitoreada en función del problema y el conjunto de datos específicos.

4. ¿Cuáles son las diferencias clave entre tf.Variable y tf.constant en TensorFlow?

tf.Variable y tf.constant se utilizan para representar tensores en TensorFlow, pero tienen diferencias cruciales:

-

Mutabilidad: tf.Variable es mutable y se puede actualizar durante el entrenamiento del modelo, mientras que tf.constant es inmutable.

-

Asignación de memoria: Las variables se almacenan en un área de memoria separada que persiste a través de múltiples ejecuciones de un grafo, mientras que las constantes se incrustan en el propio grafo.

-

Inicialización: Las variables requieren inicialización explícita, mientras que las constantes se inicializan cuando se definen.

-

Casos de uso: Las variables se utilizan típicamente para los parámetros del modelo que necesitan ser actualizados durante el entrenamiento, mientras que las constantes se utilizan para valores fijos o hiperparámetros.

Un candidato fuerte debería ser capaz de explicar estas diferencias y proporcionar ejemplos de cuándo usar cada uno. También podrían mencionar que el uso de variables permite un uso más eficiente de la memoria en modelos grandes, ya que las constantes se copian para cada operación que las utiliza.

5. ¿Cómo se gestiona el entrenamiento con múltiples GPU en TensorFlow?

La gestión del entrenamiento con múltiples GPU en TensorFlow implica el uso de la API tf.distribute.Strategy. Esta API proporciona una interfaz de alto nivel para distribuir el entrenamiento entre múltiples GPU o incluso múltiples máquinas.

Una buena respuesta debe esbozar los siguientes pasos:

-

Elija una estrategia de distribución adecuada (por ejemplo, MirroredStrategy para el entrenamiento con múltiples GPU en una sola máquina)

-

Cree el objeto de estrategia

-

Utilice el alcance de la estrategia para crear y compilar el modelo

-

Escale el tamaño del lote de acuerdo con el número de GPU

-

Utilice el método run de la estrategia o ajuste el modelo como de costumbre

Busque candidatos que comprendan los beneficios del entrenamiento multi-GPU, como la reducción del tiempo de entrenamiento y la capacidad de manejar modelos o conjuntos de datos más grandes. También deben ser conscientes de los posibles desafíos, como el aumento del uso de memoria y la necesidad de un ajuste cuidadoso del tamaño del lote.

6. Explique el concepto de acumulación de gradientes y cuándo podría ser útil en TensorFlow.

La acumulación de gradientes es una técnica donde los gradientes se calculan y acumulan en múltiples lotes pequeños antes de realizar una actualización de peso. Esto permite aumentar eficazmente el tamaño del lote sin aumentar el uso de memoria.

Los candidatos deben explicar que la acumulación de gradientes es particularmente útil cuando:

-

Se trabaja con modelos grandes que no caben en la memoria de la GPU con el tamaño de lote deseado

-

Entrenamiento en máquinas con memoria limitada

-

Intentar simular tamaños de lote más grandes para una mejor convergencia

Una respuesta sólida incluiría cómo implementar la acumulación de gradientes en TensorFlow, normalmente usando bucles de entrenamiento personalizados y tf.GradientTape. Busque candidatos que comprendan las compensaciones, como un tiempo de entrenamiento potencialmente más lento debido a una sincronización más frecuente CPU-GPU, pero una mejor eficiencia de la memoria.

7. ¿Cómo abordaría la depuración de un modelo TensorFlow que no converge?

La depuración de un modelo TensorFlow no convergente requiere un enfoque sistemático. Un candidato fuerte debe esbozar un proceso que incluya:

-

Comprobando la tasa de aprendizaje: Asegúrese de que no sea demasiado alta ni demasiado baja

-

Inspeccionando la función de pérdida: Verifique que sea apropiada para el problema y esté implementada correctamente

-

Examinando los datos: Busque problemas como normalización incorrecta o fuga de datos

-

Monitoreando los gradientes: Use tf.summary para rastrear las magnitudes de los gradientes y verificar la desaparición o explosión de gradientes

-

Simplificando el modelo: Comience con una arquitectura más simple y aumente gradualmente la complejidad

-

Visualizando las activaciones intermedias: Use TensorBoard para inspeccionar las salidas de las capas

-

Verificando el optimizador: Asegúrese de que sea adecuado para el problema y esté configurado correctamente

Busque candidatos que enfaticen la importancia de la experimentación sistemática y el registro adecuado. También deben mencionar herramientas como TensorBoard para la visualización y tf.debugging para las comprobaciones en tiempo de ejecución. Una respuesta completa podría incluir la discusión de errores comunes como el preprocesamiento de datos incorrecto o hiperparámetros inadecuados.

8. ¿Puede explicar el concepto de cuantización en TensorFlow y sus beneficios?

La cuantización en TensorFlow es el proceso de reducir la precisión de los números utilizados para representar los parámetros de un modelo. Esto típicamente implica convertir números de punto flotante de 32 bits a enteros de 8 bits.

Los principales beneficios de la cuantización incluyen:

-

Tamaño de modelo reducido: Los modelos más pequeños son más fáciles de implementar, especialmente en dispositivos móviles o de borde.

-

Inferencia más rápida: Las operaciones de enteros son generalmente más rápidas que las operaciones de punto flotante.

-

Menor consumo de energía: Particularmente importante para dispositivos móviles e IoT.

-

Potencial para la aceleración de hardware especializado: Algunos hardware están optimizados para cálculos de baja precisión.

Un candidato sólido debería ser capaz de discutir las diferentes técnicas de cuantización disponibles en TensorFlow, como la cuantización posterior al entrenamiento y el entrenamiento consciente de la cuantización. También debe ser consciente de las posibles compensaciones, como una posible ligera disminución en la precisión del modelo, y cómo mitigar estos problemas.

9. ¿Cómo implementaría un bucle de entrenamiento personalizado en TensorFlow?

Implementar un bucle de entrenamiento personalizado en TensorFlow le da un control preciso sobre el proceso de entrenamiento. Una buena respuesta debería describir los siguientes pasos:

-

Definir la arquitectura del modelo

-

Elegir un optimizador y una función de pérdida

-

Preparar los datos de entrenamiento utilizando tf.data.Dataset

-

Definir la función del paso de entrenamiento, típicamente usando @tf.function para un mejor rendimiento

-

Dentro del paso de entrenamiento, usar tf.GradientTape para registrar las operaciones para la diferenciación automática

-

Calcular la pérdida y los gradientes

-

Aplicar los gradientes a las variables entrenables del modelo usando el optimizador

-

Implementar el bucle principal de entrenamiento, iterando sobre épocas y lotes

Buscar candidatos que entiendan los beneficios de los bucles de entrenamiento personalizados, como implementar esquemas de entrenamiento complejos o ajustar el proceso de optimización. También deben estar conscientes de las consideraciones de rendimiento, como usar tf.function para el modo de ejecución de gráficos.

10. Explicar el concepto de poda de modelos en TensorFlow y cuándo podría usarlo.

La poda de modelos en TensorFlow es una técnica utilizada para reducir el tamaño y la complejidad de las redes neuronales al eliminar pesos o conexiones innecesarias. Este proceso típicamente implica establecer pesos pequeños o insignificantes en cero, eliminándolos efectivamente del modelo.

Los candidatos deben mencionar que la poda es útil cuando:

-

Se implementan modelos en entornos con recursos limitados, como dispositivos móviles

-

Se reduce el tiempo de inferencia y el consumo de energía

-

Se disminuye el riesgo de sobreajuste al reducir la complejidad del modelo

Una respuesta sólida incluiría una explicación de diferentes técnicas de poda, como la poda basada en la magnitud o la poda estructurada. Busque candidatos que entiendan que la poda a menudo requiere un ajuste fino del modelo después de eliminar los pesos para mantener el rendimiento. También podrían mencionar el kit de herramientas de optimización de modelos de TensorFlow, que proporciona herramientas para la poda.

15 preguntas avanzadas de entrevista de TensorFlow para hacer a desarrolladores senior

Para evaluar eficazmente la idoneidad de los desarrolladores senior para su equipo, es importante hacer preguntas avanzadas de entrevista de TensorFlow. Esta lista ofrece preguntas específicas que le ayudan a evaluar su comprensión profunda y su experiencia práctica con TensorFlow, lo que garantiza que elija el talento adecuado para sus proyectos.

- ¿Cómo implementas el entrenamiento distribuido en TensorFlow?

- ¿Puedes explicar el concepto de TensorFlow Serving y cómo se utiliza en el despliegue de modelos?

- Discute una vez que tuviste que depurar un problema en un modelo de TensorFlow y cómo lo resolviste.

- ¿Cómo manejas las métricas personalizadas durante la evaluación del modelo en TensorFlow?

- ¿Puedes describir cómo usar el TensorFlow Profiler para optimizar el rendimiento del modelo?

- Explica cómo implementar un optimizador personalizado en TensorFlow.

- ¿Cómo gestionas la memoria y la asignación de recursos al entrenar modelos grandes de TensorFlow?

- ¿Puedes discutir el uso del entrenamiento de precisión mixta en TensorFlow y sus beneficios?

- ¿Cómo abordarías la implementación del aprendizaje federado con TensorFlow?

- ¿Qué estrategias utilizas para gestionar las tuberías de datos en TensorFlow?

- ¿Cómo manejas los datos categóricos en TensorFlow?

- Explica el proceso de integración de TensorFlow con otros marcos o bibliotecas de aprendizaje automático.

- ¿Cómo implementarías un modelo de secuencia a secuencia en TensorFlow?

- Discute el uso del aprendizaje por refuerzo con TensorFlow.

- ¿Puedes explicar cómo crear y usar módulos de TensorFlow Hub?

9 preguntas y respuestas de entrevista de TensorFlow relacionadas con las redes neuronales

¿Tiene una próxima entrevista para un puesto de aprendizaje automático? Utilice estas preguntas sobre redes neuronales de TensorFlow para profundizar en la comprensión y experiencia de un candidato. Perfecto para evaluar qué tan bien entienden las complejidades de las redes neuronales dentro del marco de TensorFlow.

1. ¿Cómo explicaría una red neuronal a alguien sin conocimientos técnicos?

Una red neuronal es como una red de nodos interconectados, similar a las neuronas del cerebro humano. Cada nodo es responsable de una pieza específica de información y trabaja en conjunto para resolver problemas complejos.

Un candidato ideal debería simplificar el concepto sin jerga, indicando su capacidad para comunicar ideas complejas con claridad. Busque analogías y explicaciones sencillas que lo hagan accesible a audiencias no técnicas.

2. ¿Cuáles son los componentes principales de una red neuronal?

Los componentes principales de una red neuronal son neuronas (o nodos), capas, pesos, sesgos y funciones de activación. Las neuronas se organizan en capas: entrada, ocultas y de salida. Los pesos y los sesgos ajustan los datos de entrada, mientras que las funciones de activación determinan la salida de cada neurona.

Los candidatos deben ser capaces de explicar cada componente claramente, mostrando su comprensión de cómo estos elementos trabajan juntos para formar una red neuronal. Haga un seguimiento pidiendo ejemplos para evaluar su profundidad de conocimiento.

3. ¿Puede describir el proceso de entrenamiento de una red neuronal?

El entrenamiento de una red neuronal implica alimentarla con datos, hacer predicciones, comparar esas predicciones con los resultados reales y ajustar los pesos y los sesgos para minimizar los errores. Este proceso se repite durante múltiples iteraciones hasta que el rendimiento de la red se estabiliza.

Busque candidatos que mencionen pasos clave como la propagación hacia adelante, el cálculo de la función de pérdida, la retropropagación y la optimización. También deben resaltar la importancia de la calidad de los datos y el número de iteraciones de entrenamiento.

4. ¿Cuál es el papel de una función de activación en una red neuronal?

Una función de activación determina la salida de una neurona en función de su entrada. Introduce no linealidad en la red, lo que le permite aprender y modelar patrones de datos complejos. Las funciones de activación comunes incluyen ReLU, Sigmoid y Tanh.

Los candidatos deben ser capaces de explicar por qué la no linealidad es crucial para las redes neuronales y discutir los diferentes tipos de funciones de activación y sus casos de uso. Una respuesta ideal también abordaría posibles problemas como la desaparición de gradientes.

5. ¿Cómo se evita el sobreajuste en una red neuronal?

Prevenir el sobreajuste implica técnicas como la validación cruzada, la regularización (L1, L2), el dropout y la aumento de datos. El sobreajuste ocurre cuando un modelo funciona bien con los datos de entrenamiento pero mal con los datos no vistos, lo que indica que ha aprendido ruido en lugar de señal.

Los candidatos fuertes deben discutir varias estrategias y por qué son efectivas. También podrían mencionar el monitoreo de la pérdida de validación y el ajuste de la complejidad del modelo. Busque ejemplos prácticos de sus experiencias pasadas.

6. ¿Por qué es importante la normalización de datos antes de entrenar una red neuronal?

La normalización de datos escala las características de entrada a un rango común, mejorando la estabilidad del entrenamiento y la velocidad de convergencia. Ayuda a evitar problemas donde algunas características dominan a otras debido a su escala, lo que lleva a un mejor rendimiento del modelo.

Los candidatos deben explicar el impacto de los datos no normalizados en el entrenamiento y cómo se pueden aplicar técnicas de normalización como el escalado min-max o la estandarización z-score. Busque su comprensión de cómo la normalización afecta a los algoritmos de optimización.

7. ¿Cuál es la diferencia entre una red neuronal superficial y una red neuronal profunda?

Una red neuronal superficial tiene una o muy pocas capas ocultas, mientras que una red neuronal profunda tiene múltiples capas ocultas. Las redes profundas pueden capturar patrones más complejos, pero también requieren más datos y potencia computacional para entrenar eficazmente.

Los candidatos deben articular las compensaciones entre redes superficiales y profundas, como la complejidad, el tiempo de entrenamiento y el riesgo de sobreajuste. También deben discutir escenarios donde una podría ser preferida sobre la otra.

8. ¿En qué se diferencia una red neuronal convolucional (CNN) de una red neuronal regular?

Una CNN está específicamente diseñada para procesar datos en forma de cuadrícula, como imágenes. Utiliza capas convolucionales para aprender automática e jerárquicamente jerarquías espaciales en los datos, lo que la hace muy eficaz para tareas como el reconocimiento de imágenes.

Busque candidatos que puedan explicar los componentes únicos de las CNN, como las capas convolucionales, las capas de pooling y las capas totalmente conectadas. También deben discutir las ventajas de las CNN sobre las redes neuronales tradicionales para tareas relacionadas con imágenes.

9. ¿Cuáles son los beneficios de usar TensorFlow para implementar redes neuronales?

TensorFlow proporciona un marco robusto para construir y entrenar redes neuronales con amplias bibliotecas y herramientas. Admite la programación de alto y bajo nivel, ofrece escalabilidad y se integra bien con otras herramientas de aprendizaje automático y big data.

Los candidatos deben enfatizar la flexibilidad de TensorFlow, las características de optimización del rendimiento y el soporte de la comunidad. Una respuesta sólida también podría resaltar los casos de uso y las experiencias personales con TensorFlow, mostrando su familiaridad práctica con el marco.

8 preguntas y respuestas de entrevistas de TensorFlow relacionadas con la optimización del modelo

Al optimizar los modelos de TensorFlow, es crucial hacer las preguntas correctas para medir la experiencia de un candidato. Estas 8 preguntas de entrevista de TensorFlow se centran en las técnicas de optimización de modelos, lo que le ayuda a identificar a los candidatos que pueden crear modelos eficientes y de alto rendimiento de aprendizaje automático. Use estas preguntas para evaluar la comprensión de un candidato sobre las capacidades de optimización de TensorFlow y su capacidad para aplicarlas de manera efectiva.

1. ¿Puedes explicar el concepto de poda de modelos en TensorFlow y cuándo podrías usarla?

La poda de modelos en TensorFlow es una técnica utilizada para reducir el tamaño y la complejidad de las redes neuronales al eliminar pesos o conexiones innecesarias. Se basa en la observación de que muchos pesos en una red entrenada están cerca de cero y no contribuyen significativamente a la salida del modelo.

La poda se utiliza típicamente cuando:

-

Necesitas implementar modelos en dispositivos con recursos limitados.

-

Deseas reducir la huella de memoria del modelo.

-

Tu objetivo es mejorar la velocidad de inferencia sin una pérdida significativa de precisión.

-

Buscas reducir el sobreajuste en modelos grandes.

Busca candidatos que puedan explicar las compensaciones entre el tamaño del modelo y la precisión, y que entiendan la naturaleza iterativa de la poda (podar, reentrenar, repetir). También deben conocer las API de poda integradas de TensorFlow y cómo usarlas de manera efectiva.

2. ¿Cómo abordarías la implementación del entrenamiento de precisión mixta en TensorFlow?

El entrenamiento de precisión mixta en TensorFlow implica el uso de una combinación de tipos de punto flotante de 16 bits y 32 bits para acelerar el entrenamiento y reducir el uso de memoria. Los pasos clave para implementar el entrenamiento de precisión mixta son:

-

Importa el módulo de precisión mixta de TensorFlow

-

Establece la política global en precisión mixta

-

Envuelve el optimizador con un optimizador de escalado de pérdida

-

Asegúrate de que la última capa del modelo use float32 para la estabilidad

Los candidatos deben mencionar que la precisión mixta es particularmente beneficiosa para modelos con una gran huella de memoria o al entrenar en GPU que admiten operaciones de 16 bits. También deben ser conscientes de los posibles problemas de estabilidad numérica y cómo abordarlos.

Busca respuestas que demuestren una comprensión de los beneficios de rendimiento y los posibles inconvenientes del entrenamiento de precisión mixta. Los candidatos fuertes también mencionarán la necesidad de evaluar y comparar los resultados con el entrenamiento de precisión completa para garantizar que se mantenga la precisión.

3. Explica el concepto de acumulación de gradientes en TensorFlow y cuándo podría ser útil.

La acumulación de gradientes es una técnica utilizada para simular tamaños de lote más grandes al entrenar modelos de aprendizaje profundo. Implica acumular gradientes durante varios mini-lotes antes de actualizar los pesos del modelo. Este enfoque es particularmente útil cuando:

-

Se trabaja con memoria GPU limitada que no puede acomodar tamaños de lote grandes

-

Se entrenan modelos muy grandes donde el aumento del tamaño del lote mejora la convergencia

-

Se trata de conjuntos de datos donde los tamaños de muestra varían significativamente

Para implementar la acumulación de gradientes en TensorFlow, normalmente:

-

Calcula los gradientes para cada mini-lote sin aplicarlos

-

Acumula estos gradientes durante un número determinado de pasos

-

Promedia los gradientes acumulados

-

Aplica los gradientes promediados para actualizar los pesos del modelo

Busque candidatos que puedan explicar cómo la acumulación de gradientes afecta el proceso de entrenamiento y los algoritmos de optimización. También deben ser capaces de discutir las compensaciones entre el uso de la acumulación de gradientes y la simple reducción del tamaño del lote o el uso de estrategias de entrenamiento distribuido.

4. ¿Cómo gestiona la asignación de memoria y recursos al entrenar modelos grandes de TensorFlow?

La gestión de la asignación de memoria y recursos para modelos grandes de TensorFlow implica varias estrategias:

-

Usar tf.data para tuberías de datos eficientes y reducir el uso de memoria

-

Implementar el checkpointing de gradientes para intercambiar computación por memoria

-

Utilizar el entrenamiento de precisión mixta para reducir la huella de memoria

-

Emplear el paralelismo de modelos para distribuir el modelo en múltiples dispositivos

-

Implementar tamaños de lote eficientes y, potencialmente, usar la acumulación de gradientes

-

Usar optimizadores eficientes en memoria como Adam con precisión reducida

Los candidatos también deben mencionar la importancia de las herramientas de perfilado como TensorFlow Profiler para identificar los cuellos de botella de memoria y optimizar el uso de recursos. Podrían discutir estrategias como la poda o la cuantización para reducir el tamaño del modelo.

Busque respuestas que demuestren una comprensión integral de las consideraciones de software y hardware. Los candidatos fuertes discutirán las compensaciones entre diferentes enfoques y cómo elegir la estrategia correcta en función del modelo específico y las limitaciones de hardware.

5. ¿Puede explicar el proceso de cuantización de modelos en TensorFlow y sus beneficios?

La cuantización de modelos en TensorFlow es el proceso de convertir los pesos y activaciones de un modelo de formatos de punto flotante a formatos de menor precisión, como enteros de 8 bits. Los pasos principales del proceso de cuantización son:

-

Entrenamiento o ajuste fino del modelo con conocimiento de cuantización

-

Convertir el modelo a un formato cuantizado

-

Opcionalmente, calibrar el modelo utilizando datos representativos

Los beneficios de la cuantización incluyen:

-

Tamaño de modelo reducido, lo que facilita su implementación en dispositivos edge

-

Tiempos de inferencia más rápidos, especialmente en hardware con operaciones int8 dedicadas

-

Menor consumo de energía, lo cual es crucial para dispositivos móviles e IoT

-

Potencial para una mejor utilización de la caché debido a una menor huella de memoria

Busque candidatos que comprendan los diferentes tipos de cuantización (post-entrenamiento, entrenamiento con conocimiento de cuantización) y sus compensaciones. Deben ser capaces de discutir los desafíos potenciales como la degradación de la precisión y cómo mitigarlos. Los candidatos fuertes también mencionarán las API y herramientas de cuantización integradas de TensorFlow para evaluar modelos cuantizados.

6. ¿Cómo implementaría el aprendizaje federado con TensorFlow?

El aprendizaje federado en TensorFlow permite entrenar modelos en datos descentralizados sin compartir los datos sin procesar. Los pasos clave para implementar el aprendizaje federado son:

-

Definir una arquitectura de modelo adecuada para el aprendizaje federado

-

Implementar un algoritmo de promediación federada para agregar actualizaciones del modelo

-

Configurar un servidor central para coordinar el proceso de entrenamiento

-

Desarrollar código del lado del cliente para entrenar con datos locales y enviar actualizaciones

-

Implementar protocolos de agregación segura para proteger la privacidad

Los candidatos deben mencionar TensorFlow Federated (TFF), un marco de trabajo diseñado específicamente para el aprendizaje federado. Deben ser capaces de discutir los desafíos del aprendizaje federado, como lidiar con datos no-IID, la eficiencia de la comunicación y las preocupaciones de privacidad.

Busque respuestas que demuestren una comprensión de las compensaciones entre el aprendizaje centralizado y el federado. Los candidatos fuertes discutirán cómo evaluar modelos federados, manejar rezagados (clientes lentos) e implementar técnicas de privacidad diferencial para mejorar la seguridad.

7. Explique cómo usaría la API Dataset de TensorFlow para optimizar las tuberías de datos para el entrenamiento a gran escala.

La API Dataset de TensorFlow es crucial para crear tuberías de datos eficientes, especialmente para el entrenamiento a gran escala. Las estrategias de optimización clave incluyen:

-

Usar

tf.data.Dataset.from_generatorotf.data.TFRecordDatasetpara una carga de datos eficiente. -

Implementar

prefetchpara superponer el preprocesamiento de datos y la ejecución del modelo. -

Utilizando

cachepara conjuntos de datos pequeños que caben en memoria -

Aplicando

mapconnum_parallel_callspara el preprocesamiento de datos en paralelo -

Usando

batchcon tamaños de lote apropiados para una utilización eficiente de la GPU -

Implementando

shufflecon un buffer suficientemente grande para la aleatorización

Los candidatos también deben mencionar la importancia de usar tf.data.experimental.AUTOTUNE para el ajuste automático de las llamadas paralelas y los tamaños de buffer. Podrían discutir estrategias para manejar secuencias de longitud variable o implementar funciones de análisis personalizadas.

Busque respuestas que demuestren una comprensión de cómo la tubería de datos puede convertirse en un cuello de botella en el entrenamiento. Los candidatos fuertes discutirán cómo perfilar y evaluar las tuberías de datos, y cómo equilibrar la utilización de la CPU y la GPU para un rendimiento óptimo.

8. ¿Cómo abordaría la depuración de un modelo de TensorFlow que no converge?

La depuración de un modelo de TensorFlow que no converge requiere un enfoque sistemático:

-

Verifique la función de pérdida y asegúrese de que sea apropiada para la tarea

-

Verifique la tubería de datos para detectar la corrección y posibles problemas como la fuga de datos

-

Inspeccione la tasa de aprendizaje y considere implementar programaciones de tasa de aprendizaje

-

Analice el flujo de gradiente utilizando

tf.GradientTapeo la función de histograma de TensorBoard -

Implemente el recorte de gradientes para evitar la explosión de gradientes

-

Use TensorBoard para visualizar las métricas de entrenamiento y la arquitectura del modelo

-

Comienza con un modelo más sencillo y aumenta gradualmente la complejidad

-

Verifica el desequilibrio de clases y considera ajustar los pesos de las muestras

Los candidatos también deben mencionar la importancia de la inicialización adecuada, las técnicas de regularización y, posiblemente, el uso de un modelo preentrenado como punto de partida.

Busca respuestas que demuestren un enfoque metódico para la depuración. Los candidatos fuertes discutirán el uso de las herramientas de depuración de TensorFlow como el módulo tf.debugging, y mencionarán estrategias para aislar el problema, como probar en un pequeño subconjunto de datos o usar datos sintéticos.

7 preguntas situacionales de entrevista de TensorFlow con respuestas para contratar a los mejores desarrolladores

¿Listo para sumergirte en el mundo de las entrevistas de TensorFlow? Estas preguntas situacionales te ayudarán a evaluar el conocimiento práctico y las habilidades de resolución de problemas de los candidatos. Úsalas para descubrir cómo los posibles empleados aplican los conceptos de TensorFlow en escenarios del mundo real y obtén una mejor idea de su experiencia práctica.

1. Estás trabajando en un modelo de TensorFlow que tarda un tiempo inusualmente largo en entrenarse. ¿Cómo abordarías la optimización del proceso de entrenamiento?

Al optimizar el proceso de entrenamiento de un modelo de TensorFlow, consideraría varios enfoques:

• Analizar el flujo de entrada: Asegúrese de que la carga de datos no sea un cuello de botella utilizando tf.data para una carga y preprocesamiento de datos eficientes. • Usar entrenamiento de precisión mixta: Implementar cálculos de punto flotante de 16 bits cuando sea posible para acelerar el entrenamiento en hardware compatible. • Optimizar la arquitectura del modelo: Simplificar el modelo si es posible, o usar tipos de capas más eficientes. • Aprovechar el entrenamiento distribuido: Utilizar múltiples GPU o TPUs si están disponibles. • Perfilar el modelo: Usar TensorFlow Profiler para identificar los cuellos de botella de rendimiento.

Busque candidatos que demuestren un enfoque sistemático de la optimización y familiaridad con las funciones de mejora del rendimiento de TensorFlow. Las respuestas sólidas priorizarán la eficiencia del flujo de datos y la utilización del hardware antes de considerar los cambios en la arquitectura del modelo.

2. ¿Cómo implementaría una función de pérdida personalizada en TensorFlow para un sistema de recomendación que necesita equilibrar las preferencias del usuario con la popularidad del artículo?

Para implementar una función de pérdida personalizada para este escenario, yo:

• Definiría una clase que herede de tf.keras.losses.Loss • Anularía el método call para calcular la pérdida • Incorporaría tanto el error de preferencia del usuario como el sesgo de popularidad del artículo • Usaría operaciones de TensorFlow para asegurar que la función sea diferenciable • Añadiría pesos para equilibrar la importancia de las preferencias frente a la popularidad

Una respuesta ideal debería demostrar comprensión de la implementación de pérdidas personalizadas de TensorFlow y la capacidad de traducir requisitos comerciales en formulaciones matemáticas. Busque candidatos que discutan la importancia de mantener la función diferenciable y mencionen los desafíos potenciales al equilibrar diferentes aspectos de la pérdida.

3. Se le encarga implementar un modelo TensorFlow en dispositivos móviles. ¿Qué consideraciones tendría en cuenta y cómo abordaría esto?

Al implementar un modelo TensorFlow en dispositivos móviles, las consideraciones clave incluyen:

• Tamaño del modelo: Optimice el modelo para móviles mediante la poda, la cuantificación y, potencialmente, el uso de TensorFlow Lite. • Velocidad de inferencia: Asegúrese de que el modelo pueda ejecutarse eficientemente en procesadores móviles. • Compatibilidad de la plataforma: Considere el uso de TensorFlow Lite para implementaciones en Android e iOS. • Uso de memoria: Minimice los requisitos de RAM durante la inferencia. • Consumo de energía: Optimice para reducir el consumo de batería durante la ejecución del modelo.

Busque candidatos que mencionen TensorFlow Lite y demuestren conocimiento de los desafíos específicos de los dispositivos móviles. Las respuestas sólidas también podrían abordar el uso potencial del entrenamiento en el dispositivo o el aprendizaje por transferencia para personalizar los modelos en los dispositivos de los usuarios.

4. Explique cómo implementaría un bucle de entrenamiento personalizado en TensorFlow para una GAN (Red Generativa Adversaria).

Implementar un bucle de entrenamiento personalizado para una GAN en TensorFlow implica varios pasos:

• Definir modelos de generador y discriminador separados • Crear optimizadores para ambos modelos • Implementar el paso de entrenamiento utilizando tf.GradientTape • Alternar entre el entrenamiento del discriminador y el generador • Usar métricas personalizadas para rastrear el progreso • Implementar un bucle de entrenamiento que llama al paso de entrenamiento y registra los resultados

Una respuesta ideal debe demostrar comprensión de las GAN y las API de bajo nivel de TensorFlow. Busque candidatos que mencionen la importancia de equilibrar el entrenamiento del generador y el discriminador, y que puedan explicar cómo usar tf.function para la optimización del rendimiento.

5. ¿Cómo abordaría la construcción de un modelo de aprendizaje de múltiples tareas en TensorFlow donde algunas tareas tienen datos etiquetados limitados?

La construcción de un modelo de aprendizaje de múltiples tareas con datos etiquetados limitados para algunas tareas requiere una cuidadosa consideración:

• Use una red base compartida con capas de salida específicas de la tarea • Implemente la aumento de datos para tareas con datos limitados • Utilice el aprendizaje por transferencia pre-entrenando en tareas relacionadas • Emplee técnicas de regularización como la regularización dropout o L1/L2 • Implemente una función de pérdida personalizada que equilibre la importancia de cada tarea • Considere enfoques de aprendizaje semisupervisado para tareas con etiquetas limitadas

Busque candidatos que demuestren comprensión de las arquitecturas de aprendizaje multi-tarea y estrategias para lidiar con la disponibilidad desequilibrada de datos entre tareas. Las respuestas sólidas también podrían discutir los posibles beneficios del aprendizaje multi-tarea para mejorar la generalización del modelo.

6. Observa que el rendimiento de tu modelo TensorFlow se degrada significativamente cuando se implementa en producción. ¿Cómo investigarías y abordarías este problema?

Para investigar y abordar la degradación del rendimiento en producción, seguiría estos pasos:

• Comparar las distribuciones de datos de entrenamiento y producción • Verificar la deriva de datos o la deriva de concepto • Analizar las entradas y salidas del modelo en producción • Implementar el monitoreo de las métricas de rendimiento del modelo • Investigar posibles problemas con la canalización de preprocesamiento de datos • Considerar volver a entrenar el modelo con datos de producción • Evaluar si la arquitectura del modelo es adecuada para las restricciones de producción

Busque candidatos que demuestren un enfoque sistemático para la depuración y mencionen la importancia del monitoreo en entornos de producción. Las respuestas sólidas también podrían discutir estrategias para el aprendizaje continuo o la actualización del modelo para adaptarse a los patrones cambiantes de datos.

7. ¿Cómo implementaría una capa personalizada en TensorFlow que aplica diferentes operaciones basadas en un mecanismo de atención aprendido?

• Subclase tf.keras.layers.Layer • Implementar el método build para definir pesos aprendibles para la atención • Crear el método call para aplicar la atención y diferentes operaciones • Usar operaciones tf.math para asegurar la diferenciabilidad • Implementar get_config y from_config para la serialización

¿Qué habilidades de TensorFlow deberías evaluar durante la fase de entrevista?

Si bien es imposible evaluar todos los aspectos del dominio de TensorFlow de un candidato en una sola entrevista, enfocarse en habilidades clave puede proporcionar información valiosa. Las siguientes competencias básicas son particularmente importantes al evaluar la experiencia en TensorFlow.

Python

Python es el lenguaje principal para el desarrollo de TensorFlow. Una base sólida en Python es esencial para usar eficazmente las API de TensorFlow y construir modelos complejos.

Para evaluar las habilidades de Python, considera usar una prueba en línea de Python con preguntas de opción múltiple relevantes. Esto puede ayudar a filtrar a los candidatos en función de su dominio de Python.

Durante la entrevista, haz preguntas específicas para evaluar el conocimiento de Python en el contexto de TensorFlow. Aquí hay un ejemplo:

¿Puedes explicar cómo usarías las listas por comprensión de Python para preprocesar un conjunto de datos para un modelo de TensorFlow?

Busque respuestas que demuestren comprensión tanto de las listas por comprensión de Python como de los conceptos de preprocesamiento de datos. Una buena respuesta debe incluir ejemplos de cómo transformar o filtrar datos de manera eficiente utilizando listas por comprensión.

Fundamentos del aprendizaje automático

Una sólida comprensión de los conceptos de aprendizaje automático es crucial para el uso eficaz de TensorFlow. Esto incluye la comprensión de varios algoritmos, arquitecturas de modelos y métricas de evaluación.

Para evaluar los conocimientos de aprendizaje automático, puede utilizar una prueba en línea de aprendizaje automático que cubre conceptos fundamentales y sus aplicaciones.

Durante la entrevista, haga preguntas que revelen la comprensión del candidato de los principios del aprendizaje automático en relación con TensorFlow. Por ejemplo:

¿Cómo abordaría la construcción de un modelo de clasificación utilizando TensorFlow y qué consideraciones tendría en cuenta para la evaluación del modelo?

Busque respuestas que discutan la selección de la arquitectura del modelo, el preprocesamiento de datos, el proceso de entrenamiento y métricas de evaluación como la precisión, la precisión y el recall. Una buena respuesta también debe mencionar técnicas como la validación cruzada y el manejo del desequilibrio de clases.

API y ecosistema de TensorFlow

La familiaridad con la API y el ecosistema de TensorFlow es clave para un desarrollo eficiente. Esto incluye el conocimiento de los módulos principales, las API de alto nivel como Keras y las herramientas para la implementación y optimización del modelo.

Para evaluar el conocimiento específico de TensorFlow, considere hacer preguntas sobre sus características y mejores prácticas. Aquí hay un ejemplo:

¿Puede explicar la diferencia entre la ejecución ansiosa y la ejecución de gráficos en TensorFlow y cuándo usaría cada una?

Busque respuestas que demuestren comprensión de los modelos de ejecución de TensorFlow. Una buena respuesta debe explicar que la ejecución ansiosa es más intuitiva y fácil para la depuración, mientras que la ejecución de gráficos es más eficiente para implementaciones a gran escala y ofrece una mejor optimización del rendimiento.

Contrate al mejor talento con pruebas de habilidades de TensorFlow y las preguntas de entrevista adecuadas

Al buscar contratar candidatos con habilidades de TensorFlow, es importante verificar que posean la experiencia necesaria. Esto garantiza que esté incorporando a personas que puedan contribuir eficazmente a sus proyectos.

Una de las formas más precisas de evaluar estas habilidades es mediante el uso de pruebas de habilidades. Considere usar nuestra Prueba en línea de aprendizaje profundo o la Prueba de redes neuronales para evaluaciones precisas.

Después de administrar estas pruebas, puede preseleccionar eficientemente a los mejores solicitantes e invitarlos a entrevistas. Este enfoque específico ayuda a optimizar su proceso de contratación.

Para comenzar, regístrese en nuestra plataforma de evaluación y explore más pruebas personalizadas de nuestra biblioteca de pruebas. Esto garantizará que encuentre a los expertos en TensorFlow adecuados para su equipo.

Prueba de evaluación de aprendizaje automático

30 minutos | 12 MCQs

La prueba de evaluación de aprendizaje automático previa al empleo evalúa la comprensión de un candidato sobre los fundamentos del aprendizaje automático, como la ingeniería de características, la regresión, la varianza, la probabilidad condicional, el clustering, los árboles de decisión, los vecinos más cercanos, el Naive Bayes, el sesgo y el sobreajuste. La prueba también evalúa su capacidad para recopilar y preparar el conjunto de datos, entrenar un modelo, evaluar el modelo e iterativamente mejorar el rendimiento del modelo.

[

Prueba de evaluación de aprendizaje automático

](https://www.adaface.com/assessment-test/machine-learning-online-test)

Descargue la plantilla de preguntas de entrevista de TensorFlow en múltiples formatos

Las preguntas generales incluyen temas sobre la arquitectura de TensorFlow, operaciones básicas y sus aplicaciones en el aprendizaje automático.

Concéntrese en conceptos fundamentales como los conceptos básicos de TensorFlow, el preprocesamiento de datos y la construcción de modelos simples.

Pregunte sobre temas intermedios como el entrenamiento de modelos personalizados, las técnicas de optimización y las herramientas del ecosistema de TensorFlow.

Desafíelos con preguntas avanzadas sobre la implementación de modelos, el entrenamiento distribuido y TensorFlow Extended (TFX).

Las preguntas situacionales ayudan a comprender cómo los candidatos abordan la resolución de problemas y los escenarios del mundo real utilizando TensorFlow.

Estas preguntas evalúan la capacidad de un candidato para mejorar el rendimiento y la eficiencia del modelo.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento