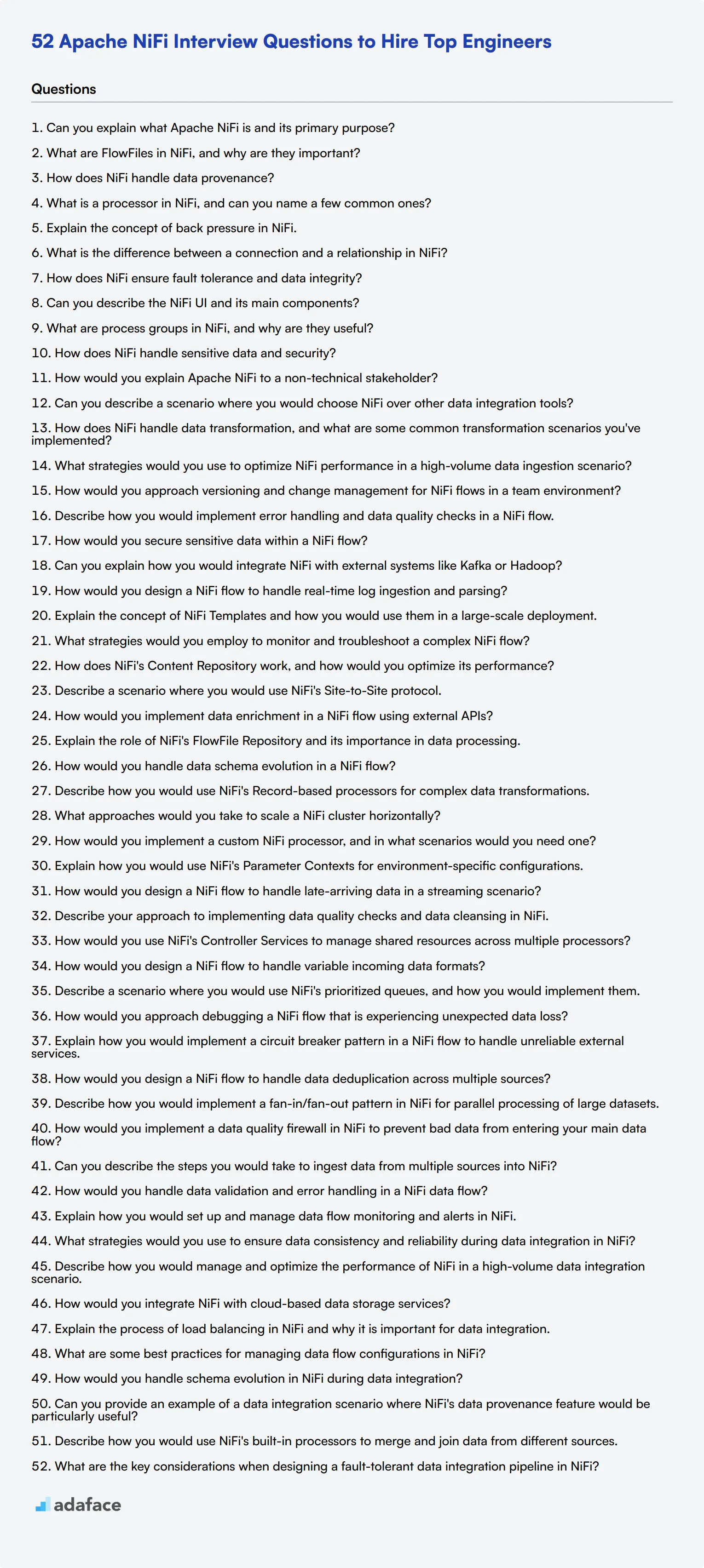

52 Preguntas de Entrevista de Apache NiFi para Contratar a los Mejores Ingenieros

Contratar al ingeniero de Apache NiFi adecuado puede impactar significativamente la gestión y los procesos de integración de su flujo de datos. Realizar entrevistas efectivas con preguntas bien preparadas garantiza que pueda identificar candidatos que tengan la destreza técnica y las habilidades de resolución de problemas adecuadas.

Esta publicación de blog proporciona una lista completa de preguntas de entrevista de Apache NiFi, segmentadas para que coincidan con diferentes niveles de ingeniería y áreas de habilidades. Encontrará preguntas que van desde la evaluación inicial hasta la gestión avanzada del flujo de datos y los procesos de integración.

Usando estas preguntas, puede optimizar su proceso de entrevista y tomar decisiones de contratación informadas. Mejore aún más su estrategia de contratación con nuestro test online de Apache NiFi para preseleccionar a los candidatos antes de la entrevista.

Tabla de contenidos

10 preguntas de entrevista de Apache NiFi para iniciar la entrevista

8 preguntas y respuestas de entrevista de Apache NiFi para evaluar a los ingenieros de datos junior

15 preguntas y respuestas intermedias de entrevista de Apache NiFi para preguntar a ingenieros de datos de nivel medio

7 preguntas y respuestas de entrevista de Apache NiFi relacionadas con la gestión del flujo de datos

12 preguntas de Apache NiFi relacionadas con los procesos de integración de datos

¿Qué habilidades de Apache NiFi deberías evaluar durante la fase de entrevista?

Contrata a los mejores talentos con pruebas de habilidades de Apache NiFi y las preguntas de entrevista correctas

Descarga la plantilla de preguntas de entrevista de Apache NiFi en múltiples formatos

10 preguntas de entrevista de Apache NiFi para iniciar la entrevista

Para iniciar tu proceso de entrevista y evaluar el conocimiento fundamental de un candidato sobre Apache NiFi, considera usar estas 10 preguntas introductorias. Estas consultas están diseñadas para ayudarte a evaluar rápidamente la comprensión de un ingeniero de datos sobre los conceptos y la funcionalidad centrales de NiFi.

- ¿Puedes explicar qué es Apache NiFi y su propósito principal?

- ¿Qué son los FlowFiles en NiFi y por qué son importantes?

- ¿Cómo maneja NiFi la procedencia de los datos?

- ¿Qué es un procesador en NiFi y puedes nombrar algunos comunes?

- Explica el concepto de contrapresión en NiFi.

- ¿Cuál es la diferencia entre una conexión y una relación en NiFi?

- ¿Cómo asegura NiFi la tolerancia a fallos y la integridad de los datos?

- ¿Puedes describir la interfaz de usuario de NiFi y sus componentes principales?

- ¿Qué son los grupos de procesos en NiFi y por qué son útiles?

- ¿Cómo maneja NiFi los datos sensibles y la seguridad?

8 preguntas y respuestas de entrevista sobre Apache NiFi para evaluar a ingenieros de datos junior

¿Listo para evaluar a ingenieros de datos junior en su dominio de Apache NiFi? Estas 8 preguntas de entrevista te ayudarán a medir la comprensión de los candidatos sobre los conceptos centrales y las aplicaciones prácticas de NiFi. Úsalas para identificar talento prometedor que pueda comenzar a trabajar rápidamente con tus proyectos de flujo de datos.

1. ¿Cómo explicarías Apache NiFi a un interesado no técnico?

Un candidato fuerte debería ser capaz de simplificar el concepto de NiFi sin usar jerga técnica. Podrían explicarlo de la siguiente manera:

Apache NiFi es como un sistema de cintas transportadoras inteligente para datos. Ayuda a mover información de un lugar a otro, asegurando que llegue a su destino de manera rápida y segura. Al igual que una cinta transportadora en una fábrica podría clasificar paquetes y enviarlos a diferentes destinos, NiFi hace esto con datos. Puede recopilar información de diversas fuentes, procesarla si es necesario y entregarla al lugar correcto, todo mientras realiza un seguimiento de lo que sucedió en el camino.

Busque candidatos que utilicen analogías relacionables y se centren en los beneficios de NiFi, como la mejora del flujo de datos, el aumento de la eficiencia y una mejor gestión de datos. Haga un seguimiento preguntando cómo explicarían el valor de NiFi al negocio en términos de ahorro de costes o mejora de las capacidades de toma de decisiones.

2. ¿Puede describir un escenario en el que elegiría NiFi sobre otras herramientas de integración de datos?

Una respuesta ideal debe demostrar la comprensión del candidato sobre las fortalezas y los casos de uso de NiFi. Podrían describir un escenario como este:

Elegiría NiFi para un proyecto que requiera la ingesta de datos en tiempo real de múltiples fuentes diversas con diferentes formatos de datos. Por ejemplo,, en una iniciativa de ciudad inteligente donde necesitamos recopilar y procesar datos de sensores de tráfico, estaciones meteorológicas y fuentes de redes sociales simultáneamente. NiFi sobresale en este escenario porque:

- Ofrece una amplia gama de procesadores listos para usar para diferentes fuentes y formatos de datos.

- Su interfaz de arrastrar y soltar permite ajustes rápidos a los flujos de datos.

- Proporciona una excelente escalabilidad para manejar grandes volúmenes de datos de streaming.

- Su función de procedencia de datos garantiza la transparencia y la trazabilidad en la tubería de datos.

Busque candidatos que puedan articular las ventajas únicas de NiFi y relacionarlas con necesidades comerciales específicas. Las respuestas sólidas también tocarán la capacidad de NiFi para manejar datos tanto por lotes como en streaming, su robusto manejo de errores y su soporte para procesadores personalizados cuando sea necesario.

3. ¿Cómo gestiona NiFi la transformación de datos y cuáles son algunos escenarios comunes de transformación que ha implementado?

Un candidato con conocimientos debería ser capaz de explicar las capacidades de transformación de datos de NiFi y proporcionar ejemplos. Podrían responder:

NiFi gestiona la transformación de datos a través de varios procesadores y técnicas. Algunos escenarios de transformación comunes que he implementado incluyen:

- Conversión de formato: Usando procesadores como ConvertRecord para cambiar datos de CSV a JSON o de XML a Avro

- Manipulación de campos: Empleando UpdateRecord o JoltTransformJSON para agregar, eliminar o modificar campos en datos estructurados

- Enriquecimiento de datos: Utilizando LookupRecord para agregar información adicional de fuentes externas

- Filtrado de datos: Usando QueryRecord o RouteOnAttribute para filtrar datos no deseados basados en criterios específicos

- Agregación: Implementando MergeRecord o MergeContent para combinar múltiples FlowFiles en una única salida

Preste atención a los candidatos que puedan explicar la lógica detrás de la elección de procesadores específicos para diferentes tareas de transformación. Las respuestas sólidas también mencionarán la importancia de mantener el linaje de datos y cómo la función de procedencia de NiFi ayuda a rastrear las transformaciones.

4. ¿Qué estrategias utilizaría para optimizar el rendimiento de NiFi en un escenario de ingesta de datos de alto volumen?

Un candidato con experiencia debería ser capaz de sugerir múltiples estrategias para optimizar el rendimiento de NiFi. Una respuesta completa podría incluir:

- Aumentar la concurrencia: Ajustar el número de tareas concurrentes para procesadores que manejan cargas de trabajo pesadas

- Usar contrapresión: Configurar los umbrales del objeto de contrapresión para evitar abrumar a los componentes descendentes

- Implementar procesamiento por lotes: Usar procesadores de procesamiento por lotes para reducir el número de archivos FlowFile individuales y minimizar las operaciones de E/S

- Optimizar la configuración del procesador: Ajustar las propiedades del procesador, como el programa de ejecución y el tamaño del lote, para un rendimiento óptimo

- Aprovechar el sitio a sitio: Usar la comunicación de sitio a sitio para la transferencia eficiente de datos entre instancias de NiFi

- Escalar horizontalmente: Agregar más nodos de NiFi a un clúster para distribuir la carga de trabajo

- Usar formatos de datos apropiados: Elegir formatos de datos eficientes como Avro o Parquet para conjuntos de datos grandes

- Implementar almacenamiento en caché: Usar el almacenamiento en caché cuando sea apropiado para reducir los cálculos o búsquedas repetidas

Busque candidatos que demuestren una comprensión de la arquitectura de NiFi y que puedan explicar cómo estas optimizaciones impactan el rendimiento. Las respuestas sólidas también mencionarán la importancia del monitoreo y la mejora iterativa en la optimización del rendimiento.

5. ¿Cómo abordaría el versionado y la gestión de cambios para los flujos de NiFi en un entorno de equipo?

Una respuesta reflexiva debe cubrir tanto los aspectos técnicos como los orientados a procesos del control de versiones y la gestión de cambios. Una buena respuesta podría incluir:

- Utilizar NiFi Registry: Implementar NiFi Registry para el control de versiones de las definiciones de flujo y gestionar diferentes versiones de los flujos

- Implementar estrategia de ramificación: Adoptar una estrategia de ramificación similar a Git para diferentes entornos (desarrollo, pruebas, producción)

- Establecer un proceso de revisión: Configurar un proceso de revisión por pares para los cambios en los flujos antes de fusionarlos en las ramas principales

- Documentar los cambios: Mantener una documentación clara para cada versión, incluyendo el propósito de los cambios y cualquier actualización de configuración

- Usar plantillas: Crear y controlar versiones de plantillas de flujo reutilizables para patrones comunes

- Implementar CI/CD: Configurar tuberías automatizadas de pruebas y despliegue para los flujos de NiFi

- Control de acceso: Utilizar las funciones de autenticación y autorización de usuarios de NiFi para gestionar quién puede realizar cambios

- Copias de seguridad regulares: Asegurar copias de seguridad regulares de las configuraciones de flujo y los datos de NiFi Registry

Evaluar a los candidatos en función de su capacidad para equilibrar las soluciones técnicas con los procesos colaborativos. Las respuestas sólidas enfatizarán la importancia de mantener la consistencia del flujo en todos los entornos y minimizar las interrupciones durante las actualizaciones.

6. Describa cómo implementaría el manejo de errores y las comprobaciones de calidad de los datos en un flujo de NiFi.

Una respuesta completa debe cubrir tanto el manejo de errores como los aspectos de calidad de los datos. Un candidato sólido podría responder:

Para el manejo de errores:

- Utilice RouteOnAttribute para separar los FlowFiles válidos e inválidos

- Implemente procesadores personalizados para escenarios de error específicos

- Utilice PutEmail u otros procesadores de notificación para errores críticos

- Configure mecanismos de reintento usando RetryFlowFile para fallas transitorias

- Use UpdateAttribute para agregar detalles de error para la solución de problemas

Para las comprobaciones de calidad de los datos:

- Implemente procesadores ValidateRecord o ValidateCsv para la validación del esquema

- Utilice QueryRecord o ExecuteGroovyScript para la lógica de validación personalizada

- Aproveche LookupRecord para las comprobaciones de integridad referencial

- Implemente el monitoreo utilizando la API de Tareas de informes de NiFi

- Configure el muestreo de datos utilizando SampleRecord para comprobaciones intensivas en rendimiento

Busque candidatos que enfaticen la importancia del manejo centralizado de errores y el registro. Las respuestas sólidas también mencionarán la necesidad de equilibrar las comprobaciones de la calidad de los datos con las consideraciones de rendimiento y sugerirán estrategias para manejar diferentes tipos de problemas de calidad de datos.

7. ¿Cómo aseguraría los datos confidenciales dentro de un flujo de NiFi?

Un candidato consciente de la seguridad debe proporcionar un enfoque de múltiples capas para asegurar los datos confidenciales. Una respuesta completa podría incluir:

- Cifrado en reposo: Utilice el cifrado incorporado de NiFi para el repositorio de archivos de flujo y el repositorio de contenido

- Cifrado en tránsito: Implemente SSL/TLS para todas las comunicaciones, incluido el sitio a sitio

- Enmascaramiento de datos: Use UpdateRecord o procesadores personalizados para enmascarar o tokenizar campos confidenciales

- Control de acceso: Utilice la autorización detallada de NiFi para restringir el acceso a procesadores y datos confidenciales

- Configuraciones seguras: Use propiedades confidenciales para almacenar credenciales y claves API

- Registro de auditoría: Habilite el registro de auditoría completo para rastrear todas las acciones sobre datos confidenciales

- Gestión segura de claves: Implemente una solución robusta de gestión de claves para las claves de cifrado

- Clasificación de datos: Implemente un sistema para clasificar y etiquetar los flujos de datos confidenciales

Evalúe a los candidatos en función de su comprensión de los principios de seguridad de datos y las características de seguridad específicas de NiFi. Las respuestas sólidas también mencionarán la importancia de las auditorías de seguridad periódicas y mantenerse al día con las últimas prácticas recomendadas de seguridad para NiFi.

8. ¿Puede explicar cómo integraría NiFi con sistemas externos como Kafka o Hadoop?

Un candidato con experiencia debería poder describir el proceso de integración y las consideraciones para diferentes sistemas externos. Una buena respuesta podría incluir:

Para la integración con Kafka:

- Utilice los procesadores ConsumeKafka y PublishKafka para leer y escribir en temas de Kafka.

- Implemente el manejo de errores y los mecanismos de reintento adecuados para los problemas de conectividad de Kafka.

- Considere el uso del registro de esquema de Kafka para mantener la consistencia de los datos.

- Optimice los tamaños de lote y la configuración de compresión para el rendimiento.

Para la integración con Hadoop:

- Utilizar los procesadores PutHDFS y FetchHDFS para leer y escribir datos en HDFS

- Implementar la autenticación Kerberos para clústeres Hadoop seguros

- Usar MergeContent para optimizar la preferencia de Hadoop por archivos más pequeños y numerosos

- Considerar usar la compatibilidad HDFS de NiFi para aprovechar las capacidades de procesamiento de datos de Hadoop

Busque candidatos que puedan discutir los desafíos y las mejores prácticas para cada integración. Las respuestas sólidas también mencionarán la importancia de monitorear estas integraciones y las estrategias para manejar la evolución del esquema y la consistencia de los datos en todos los sistemas.

15 preguntas y respuestas de entrevista intermedias de Apache NiFi para hacer a los ingenieros de datos de nivel medio

Para evaluar las habilidades de nivel intermedio de ingenieros de datos en Apache NiFi, utilice estas 15 preguntas de entrevista. Estas preguntas están diseñadas para evaluar el conocimiento práctico y las habilidades de resolución de problemas de un candidato en escenarios de NiFi del mundo real.

- ¿Cómo diseñaría un flujo de NiFi para manejar la ingestión y el análisis de registros en tiempo real?

- Explique el concepto de Plantillas de NiFi y cómo las usaría en una implementación a gran escala.

- ¿Qué estrategias emplearía para monitorear y solucionar problemas de un flujo de NiFi complejo?

- ¿Cómo funciona el Repositorio de Contenido de NiFi y cómo optimizaría su rendimiento?

- Describa un escenario en el que utilizaría el protocolo Site-to-Site de NiFi.

- ¿Cómo implementaría el enriquecimiento de datos en un flujo de NiFi utilizando APIs externas?

- Explique el papel del Repositorio de FlowFile de NiFi y su importancia en el procesamiento de datos.

- ¿Cómo manejaría la evolución del esquema de datos en un flujo de NiFi?

- Describa cómo usaría los procesadores basados en registros de NiFi para transformaciones de datos complejas.

- ¿Qué enfoques tomaría para escalar un clúster de NiFi horizontalmente?

- ¿Cómo implementaría un procesador NiFi personalizado y en qué escenarios necesitaría uno?

- Explique cómo usaría los Contextos de Parámetros de NiFi para configuraciones específicas del entorno.

- ¿Cómo diseñaría un flujo de NiFi para manejar datos que llegan tarde en un escenario de transmisión?

- Describa su enfoque para implementar comprobaciones de calidad de datos y limpieza de datos en NiFi.

- ¿Cómo usaría los Servicios de Controlador de NiFi para administrar recursos compartidos en múltiples procesadores?

7 preguntas y respuestas de entrevista de Apache NiFi relacionadas con la gestión del flujo de datos

Al entrevistar a candidatos para puestos de Apache NiFi, es crucial evaluar su comprensión de la gestión del flujo de datos. Estas siete preguntas te ayudarán a medir el conocimiento práctico y las habilidades de resolución de problemas de un candidato en entornos NiFi. Úsalas para iniciar debates y descubrir cómo los solicitantes abordan los desafíos del mundo real del flujo de datos.

1. ¿Cómo diseñarías un flujo NiFi para manejar formatos de datos entrantes variables?

Un candidato fuerte debe discutir un enfoque flexible para manejar formatos de datos variables. Podrían mencionar:

- Usar el procesador UpdateAttribute para agregar atributos específicos del formato

- Implementar un procesador RouteOnAttribute para dirigir datos a ramas de procesamiento específicas del formato

- Utilizar procesadores ConvertRecord con diferentes esquemas para cada formato

- Emplear EvaluateJsonPath u otros procesadores de análisis para diferentes estructuras de datos

Busca respuestas que demuestren adaptabilidad y una comprensión de las capacidades de NiFi para el manejo dinámico de datos. Los candidatos fuertes también mencionarán la importancia del manejo adecuado de errores y el registro de formatos inesperados.

2. Describe un escenario en el que usarías las colas priorizadas de NiFi y cómo las implementarías.

- Escenario: Priorizar datos críticos en un flujo mixto, como priorizar entradas de registro de alta severidad u órdenes urgentes en un sistema de comercio electrónico

- Implementación:

- Usar UpdateAttribute para agregar un atributo de prioridad basado en el contenido

- Configurar una conexión con múltiples relaciones (por ejemplo, alta, media, baja)

- Configurar priorizadores en la conexión (por ejemplo, PriorityAttributePrioritizer)

- Ajustar el umbral del objeto de contrapresión para cada nivel de prioridad

Busque candidatos que entiendan el concepto de priorización de colas y puedan explicar cómo impacta el comportamiento del flujo. También deben mencionar posibles compensaciones, como el riesgo de inanición para los elementos de menor prioridad.

3. ¿Cómo abordaría la depuración de un flujo de NiFi que está experimentando pérdida de datos inesperada?

Una respuesta exhaustiva debe describir un enfoque sistemático para la solución de problemas:

- Habilitar los boletines y configurar el registro para los procesadores relevantes

- Usar la función Data Provenance para rastrear el linaje de los FlowFiles

- Implementar procesadores basados en conteo (por ejemplo, UpdateCounter) en puntos clave del flujo

- Verificar conexiones o relaciones configuradas incorrectamente

- Verificar que la configuración de contrapresión sea apropiada para el volumen de datos

- Examinar cualquier procesador o script personalizado en busca de posibles problemas

- Usar el Lenguaje de Expresión de NiFi para agregar atributos de depuración en varias etapas

Evalúe la metodología de resolución de problemas del candidato y su familiaridad con las herramientas de resolución de problemas integradas de NiFi. Los candidatos fuertes también mencionarán la importancia de crear un entorno de prueba para reproducir el problema de forma segura.

4. Explique cómo implementaría un patrón de interruptor de circuito en un flujo de NiFi para manejar servicios externos no confiables.

Una buena respuesta debe describir el patrón de interruptor de circuito y su implementación en NiFi:

- Use una combinación de procesadores RouteOnAttribute y Wait para implementar los estados (cerrado, abierto, semiabierto)

- Emplee el servicio de controlador DistributedMapCache para almacenar el estado del circuito en todo el clúster NiFi

- Configure procesadores como InvokeHTTP con la configuración adecuada de tiempo de espera y reintentos

- Use UpdateAttribute para realizar un seguimiento de los recuentos de fallos y las marcas de tiempo

- Implemente un procesador o script personalizado para gestionar las transiciones de estado basadas en los umbrales de fallos y los periodos de enfriamiento

Busque candidatos que entiendan el propósito del patrón de circuito en la prevención de fallos en cascada. También deben discutir cómo este patrón puede adaptarse a diferentes tipos de servicios externos y escenarios de fallo en los flujos de NiFi.

5. ¿Cómo diseñaría un flujo de NiFi para manejar la deduplicación de datos a través de múltiples fuentes?

Una respuesta efectiva debe describir una estrategia para identificar y manejar datos duplicados:

- Utilizar los procesadores HashContent o IdentifyDuplicates para generar identificadores únicos para los datos entrantes

- Implementar un DistributedMapCache o DistributedCacheServer para almacenar identificadores vistos

- Utilizar los procesadores LookupAttribute o LookupRecord para buscar entradas existentes

- Enrutar los duplicados a una ruta separada para el registro o el descarte

- Considerar la expiración basada en el tiempo de las entradas de la caché para flujos de larga duración

- Implementar la limpieza periódica de la caché para gestionar el uso de la memoria

Evalúe la comprensión del candidato sobre el procesamiento con estado en NiFi y su capacidad para equilibrar la eficiencia con la precisión. Los candidatos fuertes también podrían discutir estrategias para manejar duplicados cercanos o coincidencias parciales, dependiendo del caso de uso.

6. Describa cómo implementaría un patrón fan-in/fan-out en NiFi para el procesamiento paralelo de grandes conjuntos de datos.

Una respuesta completa debe cubrir tanto los aspectos de fan-out como de fan-in del procesamiento paralelo:

Fan-out:

- Utilizar SplitRecord o SplitText para dividir grandes conjuntos de datos en trozos más pequeños

- Implementar DistributeLoad para distribuir el procesamiento entre múltiples nodos

- Configurar tareas concurrentes en los procesadores para la ejecución en paralelo

Fan-in:

- Utilizar MergeContent o MergeRecord para combinar los trozos procesados

- Implementar WaitForFlowFile para sincronizar los resultados de las ramas paralelas

- Utilizar AttributeAggregator para combinar metadatos de procesos paralelos

Busque candidatos que entiendan las implicaciones de rendimiento del procesamiento paralelo en NiFi. Deben discutir consideraciones como el equilibrio de carga, el ordenamiento de datos y los posibles cuellos de botella en la etapa de entrada (fan-in). Los candidatos fuertes también podrían mencionar el uso de Site-to-Site para la transferencia eficiente de datos en entornos en clúster.

7. ¿Cómo implementaría un firewall de calidad de datos en NiFi para evitar que los datos incorrectos entren en su flujo de datos principal?

Una respuesta sólida debe describir un enfoque de múltiples capas para la verificación de la calidad de los datos:

- Use los procesadores ValidateRecord o ValidateCsv para la validación del esquema.

- Implemente EvaluateJsonPath o ExtractText para la validación basada en el contenido.

- Use RouteOnAttribute para separar registros válidos e inválidos.

- Emplee LookupService para comprobaciones de datos de referencia.

- Implemente procesadores personalizados para la validación de reglas de negocio complejas.

- Use UpdateAttribute para señalar problemas de calidad de datos.

- Configure conexiones para enrutar datos inválidos a flujos de manejo de errores.

Evalúe la comprensión del candidato sobre los conceptos de calidad de datos y su capacidad para traducirlos en un flujo de NiFi. Busque menciones de estrategias de registro y monitoreo para datos rechazados, así como ideas para manejar casos extremos o coincidencias parciales. Los candidatos fuertes también podrían discutir cómo equilibrar las reglas estrictas de calidad de datos con la necesidad de completar los datos.

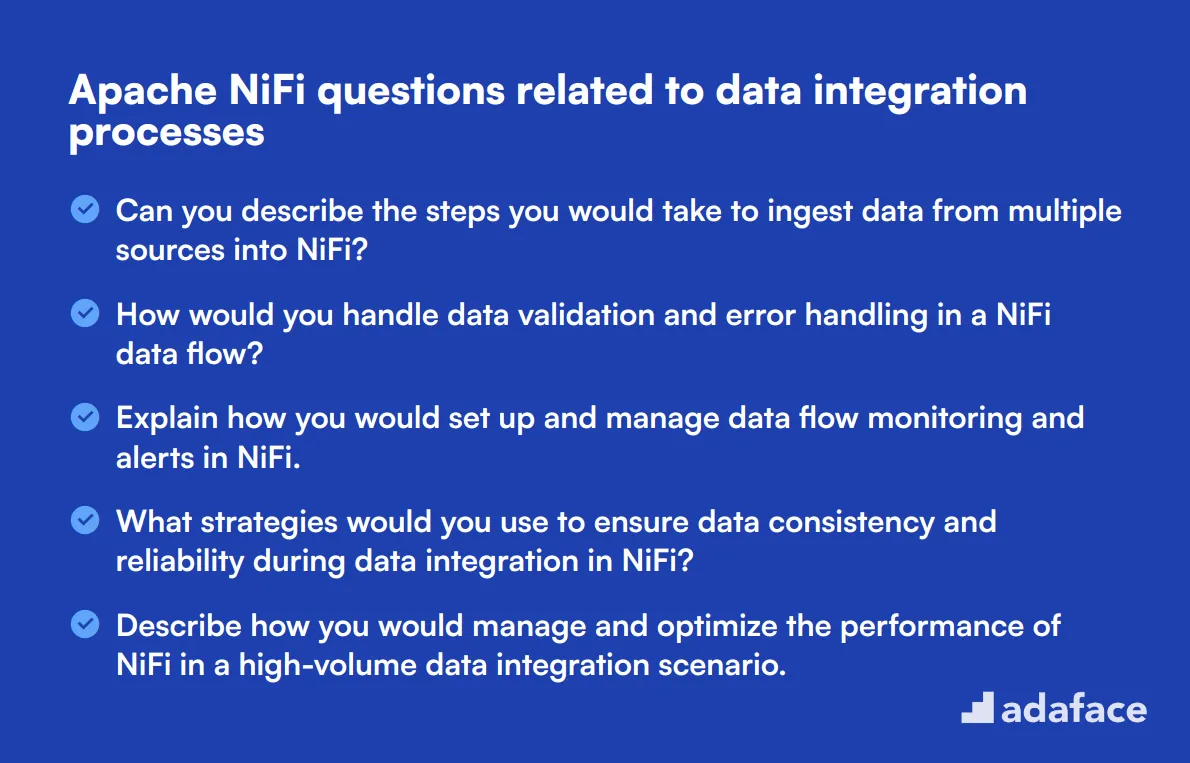

12 preguntas sobre Apache NiFi relacionadas con los procesos de integración de datos

Para determinar si sus candidatos poseen las habilidades necesarias para los procesos de integración de datos utilizando Apache NiFi, utilice estas preguntas de entrevista dirigidas. Esta lista personalizada le ayudará a evaluar su comprensión de los flujos de trabajo de datos complejos y su capacidad para gestionar los datos sin problemas.

- ¿Puede describir los pasos que tomaría para ingerir datos de múltiples fuentes en NiFi?

- ¿Cómo gestionaría la validación de datos y la gestión de errores en un flujo de datos de NiFi?

- Explique cómo configuraría y gestionaría la monitorización de flujos de datos y las alertas en NiFi.

- ¿Qué estrategias utilizaría para garantizar la consistencia y fiabilidad de los datos durante la integración de datos en NiFi?

- Describa cómo gestionaría y optimizaría el rendimiento de NiFi en un escenario de integración de datos de alto volumen.

- ¿Cómo integraría NiFi con los servicios de almacenamiento de datos basados en la nube?

- Explique el proceso de equilibrio de carga en NiFi y por qué es importante para la integración de datos.

- ¿Cuáles son algunas de las mejores prácticas para gestionar las configuraciones de flujo de datos en NiFi?

- ¿Cómo gestionaría la evolución del esquema en NiFi durante la integración de datos?

- ¿Puede proporcionar un ejemplo de un escenario de integración de datos en el que la función de procedencia de datos de NiFi sería particularmente útil?

- Describa cómo utilizaría los procesadores integrados de NiFi para fusionar y unir datos de diferentes fuentes.

- ¿Cuáles son las consideraciones clave al diseñar una tubería de integración de datos tolerante a fallos en NiFi?

¿Qué habilidades de Apache NiFi deberías evaluar durante la fase de entrevista?

Evaluar las habilidades de un candidato en una sola entrevista puede ser un desafío. Sin embargo, centrarse en las habilidades básicas críticas para Apache NiFi puede proporcionar información valiosa sobre sus capacidades y su idoneidad para el puesto.

Gestión del flujo de datos

Para filtrar la competencia de los candidatos en la gestión del flujo de datos, considere usar una prueba de evaluación con preguntas de opción múltiple relevantes. Puede consultar nuestra prueba en línea de Apache NiFi para evaluar esta habilidad.

Además, puede hacer preguntas específicas para medir su comprensión práctica de esta habilidad.

¿Puede explicar cómo diseñaría un flujo de datos en Apache NiFi para manejar la ingesta de datos en tiempo real?

Busque candidatos que puedan articular un proceso claro, incluyendo la elección de procesadores, las configuraciones de flujo y las consideraciones de rendimiento y confiabilidad.

Técnicas de integración de datos

Podría considerar administrar una evaluación de preguntas de opción múltiple (MCQ) para filtrar el conocimiento de los candidatos en esta área. Si está interesado, ofrecemos una prueba en línea de Apache NiFi que cubre tales habilidades.

Hacer preguntas específicas sobre técnicas de integración de datos también puede brindarle información sobre su experiencia.

¿Cuáles son las consideraciones clave al integrar datos de fuentes heterogéneas utilizando Apache NiFi?

Preste atención a las respuestas que destaquen los formatos de datos, las necesidades de transformación y cómo abordar las inconsistencias entre las fuentes de datos.

Manejo de errores y monitoreo

Usar una evaluación de MCQ puede ayudar a evaluar esta habilidad de manera efectiva. Si es necesario, considere nuestra prueba en línea de Apache NiFi para preguntas relevantes.

También puede evaluar su conocimiento práctico haciéndoles preguntas específicas relacionadas con el manejo de errores.

¿Cómo manejaría los errores en un flujo de datos que involucra múltiples procesadores en Apache NiFi?

Busque respuestas que mencionen estrategias como el uso de 'relaciones de fallo', registro y notificaciones para abordar y resolver errores.

Contrate a los mejores talentos con pruebas de habilidades de Apache NiFi y las preguntas de entrevista correctas

Al contratar para roles que requieren habilidades de Apache NiFi, es esencial asegurarse de que los candidatos posean la experiencia necesaria. Una sólida comprensión de la gestión del flujo de datos, los procesos de integración y las herramientas relevantes es clave para su éxito.

La forma más efectiva de verificar estas habilidades es a través de evaluaciones personalizadas. Considere usar nuestra prueba en línea de Apache NiFi para medir con precisión la competencia de un candidato.

Después de administrar la prueba, puede seleccionar fácilmente a los mejores solicitantes e invitarlos a entrevistas. Este enfoque simplificado ahorra tiempo y ayuda a identificar a los mejores talentos de manera eficiente.

Para empezar, visita nuestra biblioteca de pruebas y explora nuestra gama de evaluaciones. Regístrate hoy para asegurarte de tener las herramientas adecuadas para encontrar al candidato ideal.

Prueba online de Apache NiFi

30 minutos | 15 MCQs

La prueba de Apache NiFi utiliza preguntas de opción múltiple basadas en escenarios para evaluar el conocimiento y las habilidades de un candidato relacionadas con la arquitectura y los componentes de NiFi, el diseño y la gestión del flujo de datos, la transformación y el enriquecimiento de datos, el enrutamiento y la priorización de datos, los clústeres de NiFi y la alta disponibilidad, la seguridad y el control de acceso, y la integración con sistemas y tecnologías externas. La prueba tiene como objetivo evaluar la competencia del candidato en Apache NiFi y su capacidad para gestionar y procesar datos en una variedad de escenarios.

Probar la prueba online de Apache NiFi

Descargar plantilla de preguntas de entrevista de Apache NiFi en múltiples formatos

Apache NiFi se utiliza para automatizar y gestionar flujos de datos entre sistemas.

Hacer preguntas sobre NiFi ayuda a evaluar la capacidad de un candidato para manejar tareas de gestión e integración de flujo de datos.

Los roles como ingenieros de datos, especialistas en integración de datos y arquitectos de sistemas a menudo requieren habilidades en NiFi.

Sí, Apache NiFi es un proyecto de software de código abierto mantenido por la Apache Software Foundation.

Las características clave incluyen la procedencia de datos, la interfaz fácil de usar, la escalabilidad flexible y la transferencia segura de datos.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento