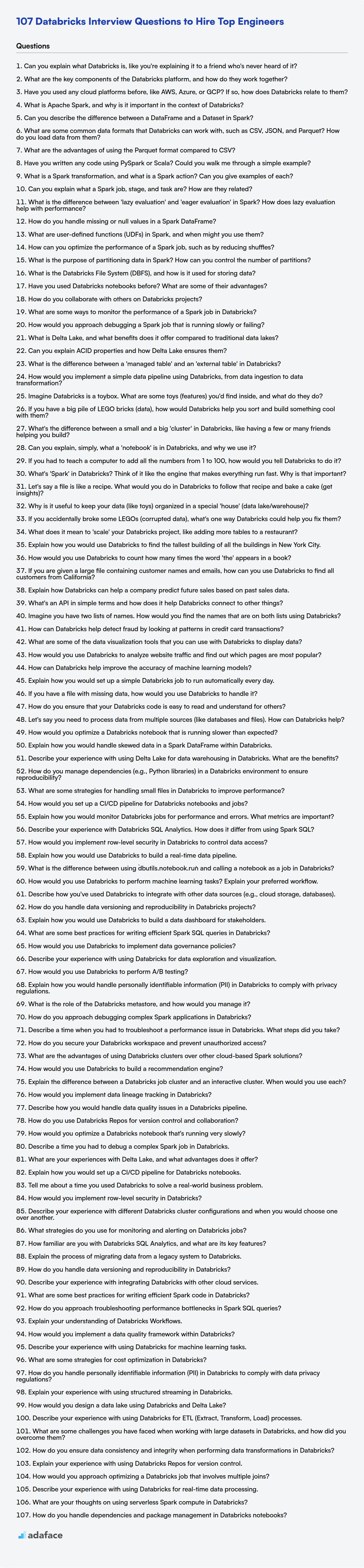

107 Preguntas de Entrevista de Databricks para Contratar a los Mejores Ingenieros

Contratar al profesional de Databricks adecuado es como encontrar una aguja en un pajar; necesitas hacer las preguntas correctas para filtrar el ruido. Como con la contratación de cualquier otro puesto especializado, como un científico de datos, el proceso de entrevista es un paso crítico.

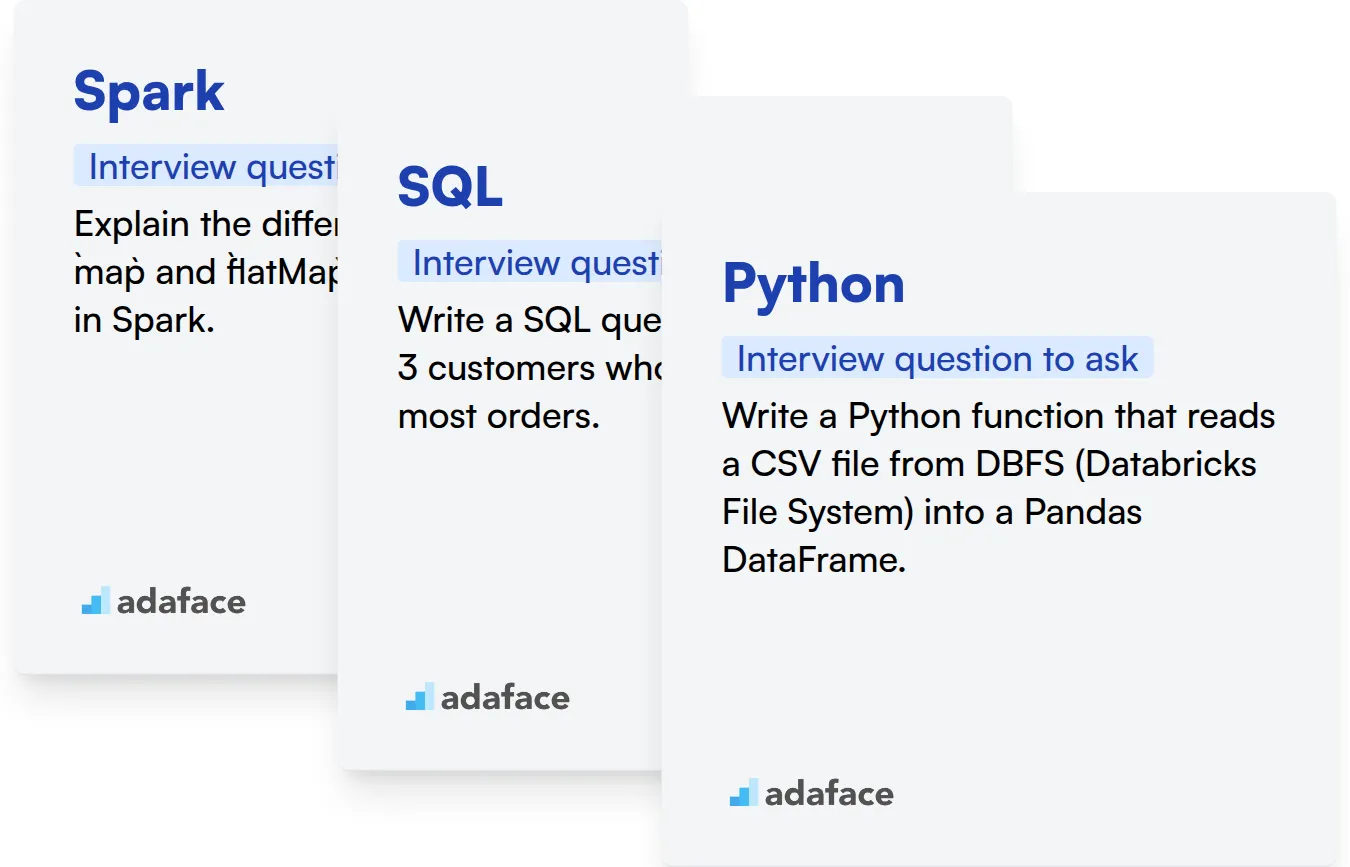

Esta publicación de blog tiene como objetivo equiparte con una lista completa de preguntas de entrevista de Databricks adaptadas para varios niveles de experiencia, desde recién graduados hasta profesionales experimentados. También incluiremos una sección de preguntas de opción múltiple para ayudarte a evaluar rápidamente el conocimiento de un candidato.

Al usar estas preguntas, podrás evaluar las habilidades y la experiencia de un candidato de manera efectiva, e incluso puedes usar nuestra prueba en línea de Spark para preseleccionar a los candidatos antes de la entrevista.

Tabla de contenido

Preguntas de entrevista de Databricks para recién graduados

Preguntas de entrevista de Databricks para juniors

Preguntas de entrevista intermedias de Databricks

Preguntas de entrevista de Databricks para experimentados

Preguntas de opción múltiple de Databricks

¿Qué habilidades de Databricks deberías evaluar durante la fase de entrevista?

Domina la contratación de Databricks con pruebas de habilidades y preguntas de entrevista específicas

Descarga la plantilla de preguntas de entrevista de Databricks en múltiples formatos

Preguntas de entrevista de Databricks para recién graduados

1. ¿Puedes explicar qué es Databricks, como si se lo estuvieras explicando a un amigo que nunca ha oído hablar de ello?

Imagina que tienes montones de datos y quieres analizarlos de forma rápida y sencilla, pero están dispersos por todas partes. Databricks es como un espacio de trabajo superpotenciado en la nube que te ayuda a hacer precisamente eso. Está construido sobre Apache Spark, que es un motor realmente rápido para procesar grandes cantidades de datos. Databricks facilita el uso de Spark y añade un montón de herramientas, como cuadernos colaborativos (donde puedes escribir código y ver los resultados al instante), bibliotecas de aprendizaje automático y formas de gestionar tus flujos de datos.

Piénsalo como un entorno colaborativo para científicos de datos, ingenieros y analistas. Todos pueden trabajar juntos con los mismos datos, utilizando herramientas como Python, SQL, Scala y R. Databricks se encarga de la infraestructura (como la configuración y gestión de servidores), para que puedas centrarte en analizar los datos y construir modelos en lugar de preocuparte por la tecnología subyacente. Además, se integra bien con el almacenamiento en la nube como AWS S3 o Azure Blob Storage para leer y escribir datos fácilmente.

2. ¿Cuáles son los componentes clave de la plataforma Databricks y cómo funcionan juntos?

Los componentes clave de la plataforma Databricks son:

- Apache Spark: El motor de procesamiento central para el procesamiento de datos a gran escala. Databricks proporciona una versión optimizada de Spark.

- Databricks Runtime: Un entorno preconfigurado con Spark optimizado, bibliotecas y mejoras de rendimiento.

- Delta Lake: Una capa de almacenamiento de código abierto que brinda confiabilidad a los lagos de datos, lo que permite transacciones ACID, manejo de metadatos escalable y procesamiento unificado de datos en streaming y por lotes. Permite construir una Lakehouse.

- MLflow: Una plataforma de código abierto para gestionar el ciclo de vida de ML, incluyendo el seguimiento de experimentos, el empaquetado de modelos y el despliegue.

- Databricks Workspace: Un entorno colaborativo para que los científicos de datos, ingenieros y analistas trabajen juntos. Proporciona cuadernos, paneles y otras herramientas para la exploración de datos, el desarrollo y el despliegue.

Estos componentes trabajan juntos aprovechando Spark para el procesamiento de datos, Delta Lake para el almacenamiento confiable, MLflow para la gestión del ciclo de vida de ML y Databricks Workspace para la colaboración y la productividad. Databricks Runtime proporciona un entorno optimizado para ejecutar todos estos componentes. Los usuarios pueden escribir y ejecutar código utilizando cuadernos, programar trabajos y desplegar modelos de aprendizaje automático, todo dentro de la plataforma Databricks.

3. ¿Ha utilizado alguna plataforma en la nube antes, como AWS, Azure o GCP? Si es así, ¿cómo se relaciona Databricks con ellas?

Sí, tengo experiencia con plataformas en la nube como AWS, Azure y GCP. Databricks se implementa típicamente sobre estas plataformas en la nube, aprovechando su infraestructura subyacente para la computación, el almacenamiento y la red. No es una plataforma en la nube en sí misma, sino una plataforma de análisis de datos y aprendizaje automático optimizada para ejecutarse dentro de esos entornos.

Específicamente, Databricks se integra profundamente. Por ejemplo, en AWS, Databricks utiliza servicios como S3 para almacenamiento y EC2 para cómputo. De manera similar, en Azure, aprovecha Azure Blob Storage y Azure VMs, y en GCP utiliza Google Cloud Storage y Compute Engine. Esto permite a Databricks enfocarse en proporcionar una plataforma de análisis unificada, al tiempo que confía en los proveedores de la nube para la gestión de la infraestructura y la escalabilidad.

4. ¿Qué es Apache Spark y por qué es importante en el contexto de Databricks?

Apache Spark es un potente sistema de procesamiento distribuido de código abierto diseñado para el procesamiento y análisis de big data. Proporciona APIs de alto nivel en Java, Scala, Python y R, y un motor optimizado que admite gráficos de cómputo generales para el análisis de datos. Spark es crucial en Databricks porque Databricks está construido sobre Spark; mejora las capacidades de Spark al proporcionar un entorno de notebook colaborativo, gestión automatizada de clústeres y rendimiento optimizado.

Específicamente, Databricks utiliza Spark para diversas tareas de ingeniería de datos y ciencia de datos, incluyendo la ingestión de datos, la transformación, el aprendizaje automático y la transmisión de datos en tiempo real. Databricks simplifica el uso de Spark con características como clústeres de escalado automático, Delta Lake incorporado para el almacenamiento de datos confiable y MLflow para la gestión de flujos de trabajo de aprendizaje automático. Por lo tanto, Spark es el motor fundamental que impulsa la plataforma Databricks, haciéndolo esencial para procesar grandes conjuntos de datos de manera eficiente y efectiva.

5. ¿Puedes describir la diferencia entre un DataFrame y un Dataset en Spark?

En Spark, tanto DataFrames como Datasets son colecciones distribuidas de datos. La principal diferencia radica en el nivel de abstracción y la seguridad de tipos. Un DataFrame es como una tabla con columnas, similar a una tabla de base de datos relacional o una hoja de cálculo. Proporciona una vista de esquema de los datos, pero sin seguridad de tipos en tiempo de compilación. Esto significa que no sabrás si estás utilizando el tipo de datos incorrecto hasta el tiempo de ejecución.

Un Dataset, por otro lado, proporciona seguridad de tipos en tiempo de compilación. Es esencialmente un DataFrame con tipado fuerte. Define la estructura de sus datos utilizando una clase Scala o Java, y Spark asegura que los datos se ajusten a esa estructura en tiempo de compilación. Los conjuntos de datos están disponibles en Scala y Java. Con Datasets, puede realizar operaciones directamente en objetos (por ejemplo, dataset.map(x => x.atributo) en lugar de usar nombres de columna de cadena), lo que hace que el código sea más limpio y menos propenso a errores. Los conjuntos de datos aprovechan los codificadores para convertir entre objetos JVM y el formato binario interno de Spark para almacenamiento y procesamiento.

6. ¿Cuáles son algunos formatos de datos comunes con los que puede trabajar Databricks, como CSV, JSON y Parquet? ¿Cómo se cargan los datos desde ellos?

Databricks puede trabajar con una variedad de formatos de datos que incluyen: CSV, JSON, Parquet, ORC, Avro y archivos de texto sin formato. También admite el trabajo con datos almacenados en bases de datos relacionales a través de conexiones JDBC.

Para cargar datos, normalmente usa la API spark.read de Spark. Por ejemplo, para cargar un archivo CSV:

df = spark.read.csv("/ruta/a/tu/archivo.csv", header=True, inferSchema=True) df.show()

De manera similar, para JSON, usaría spark.read.json(), y para Parquet, spark.read.parquet(). La opción header=True en el ejemplo CSV indica que la primera fila contiene los nombres de las columnas, e inferSchema=True intenta determinar automáticamente el tipo de datos de cada columna. Hay diferentes opciones disponibles para cada formato para controlar cómo se analizan y cargan los datos.

7. ¿Cuáles son las ventajas de usar el formato Parquet en comparación con CSV?

Parquet ofrece ventajas significativas sobre CSV, principalmente debido a su formato de almacenamiento columnar. Esto permite una compresión y codificación de datos eficientes, lo que resulta en tamaños de archivo más pequeños y menores costos de almacenamiento. El almacenamiento columnar también permite un rendimiento de consulta más rápido, ya que solo se leen las columnas necesarias, omitiendo los datos irrelevantes.

En contraste, CSV almacena los datos en formato basado en filas, lo que conlleva tamaños de archivo más grandes y un rendimiento de consulta más lento, especialmente cuando se trata de grandes conjuntos de datos. Parquet también admite la evolución del esquema y un mejor manejo de los tipos de datos, que a menudo faltan o son engorrosos en los archivos CSV.

8. ¿Has escrito algún código usando PySpark o Scala? ¿Podrías guiarme a través de un ejemplo sencillo?

Sí, tengo experiencia con PySpark. Aquí tienes un ejemplo sencillo:

Digamos que tenemos un archivo de texto data.txt con algunas líneas de texto. Queremos contar las ocurrencias de cada palabra usando PySpark. Aquí está el código:

from pyspark import SparkContext

sc = SparkContext("local", "Word Count")

# Carga el archivo de texto en un RDD

rdd = sc.textFile("data.txt")

# Divide cada línea en palabras, aplana el RDD, convierte a minúsculas y añade un conteo de 1 a cada palabra

word_counts = rdd.flatMap(lambda line: line.split())

.map(lambda word: word.lower())

.map(lambda word: (word, 1))

# Reduce por clave para sumar los conteos para cada palabra

word_counts = word_counts.reduceByKey(lambda a, b: a + b)

# Imprime los conteos de palabras

for word, count in word_counts.collect():

print(f"{word}: {count}")

sc.stop()

Este código primero crea un SparkContext. Luego, lee el archivo de texto, divide cada línea en palabras y las convierte a minúsculas. Finalmente, cuenta las ocurrencias de cada palabra e imprime los resultados. La función flatMap aplica la función lambda a cada elemento, devolviendo un nuevo RDD y luego aplanando el resultado. La función reduceByKey agrega los valores basados en la clave utilizando la función lambda.

9. ¿Qué es una transformación Spark, y qué es una acción Spark? ¿Puedes dar ejemplos de cada una?

Las transformaciones Spark son operaciones perezosas que crean un nuevo RDD (Conjunto de Datos Distribuido Resiliente) a partir de uno existente. No se ejecutan inmediatamente; en cambio, Spark construye un Grafo Acíclico Dirigido (DAG) de transformaciones. Los ejemplos incluyen map(), filter(), flatMap(), groupByKey() y reduceByKey().

Las acciones Spark, por otro lado, desencadenan la ejecución del DAG y devuelven un valor al programa controlador o escriben datos en almacenamiento externo. Las acciones obligan a Spark a realizar los cálculos definidos por las transformaciones. Los ejemplos incluyen collect(), count(), first(), take(), reduce() y saveAsTextFile().

10. ¿Puedes explicar qué son un trabajo, una etapa y una tarea de Spark? ¿Cómo se relacionan?

En Spark, un trabajo es la unidad de ejecución de más alto nivel. Representa una aplicación completa o un flujo de trabajo que Spark ejecuta. Un trabajo se activa cuando se llama a una acción en un RDD (Conjunto de Datos Distribuido Resiliente) o DataFrame, como count(), collect() o saveAsTextFile(). El controlador de Spark divide el trabajo en unidades más pequeñas llamadas etapas.

Una etapa es un conjunto de tareas independientes que se pueden ejecutar en paralelo. Las etapas se crean en función de las dependencias de mezcla, que ocurren cuando los datos necesitan ser redistribuidos entre particiones (por ejemplo, durante una operación groupByKey() o reduceByKey()). Cada etapa consta de tareas, que son las unidades de trabajo más pequeñas en Spark. Una tarea es una sola unidad de ejecución que opera en una partición de datos. Cada tarea realiza la misma operación en su respectiva partición. Por lo tanto, un trabajo se compone de múltiples etapas, y cada etapa se compone de múltiples tareas.

11. ¿Cuál es la diferencia entre 'evaluación perezosa' y 'evaluación ansiosa' en Spark? ¿Cómo ayuda la evaluación perezosa con el rendimiento?

En Spark, la evaluación ansiosa ejecuta una transformación tan pronto como se llama. En contraste, la evaluación perezosa (utilizada por Spark) retrasa la ejecución hasta que se activa una acción. Las transformaciones se registran en un Grafo Acíclico Dirigido (DAG), y solo cuando se llama a una acción como count() o saveAsTextFile() Spark realmente procesa las transformaciones.

La evaluación perezosa ayuda con el rendimiento de un par de maneras clave:

- Optimización: Spark puede optimizar todo el DAG antes de la ejecución. Podría reordenar transformaciones, combinarlas o elegir la estrategia de ejecución más eficiente.

- Evitar cálculos innecesarios: Si solo se necesita un subconjunto de los datos, Spark podría calcular solo las transformaciones necesarias para ese subconjunto, evitando el procesamiento de todo el conjunto de datos.

- Ejemplo:

val data = sc.textFile("mydata.txt") val filteredData = data.filter(_.contains("error")) //Transformación - evaluada perezosamente filteredData.count() // Acción - desencadena la evaluación

12. ¿Cómo se manejan los valores faltantes o nulos en un DataFrame de Spark?

Spark proporciona varias formas de manejar valores faltantes o nulos en los DataFrames. Los enfoques comunes incluyen:

- Filtrado: Eliminar filas con valores nulos usando

df.na.drop()odf.filter(col("nombre_columna").isNull()). El métododrop()ofrece opciones comohow='any'(eliminar si cualquier valor en la fila es nulo) ohow='all'(eliminar solo si todos los valores en la fila son nulos). - Imputación: Reemplazar los valores nulos con un valor específico. Esto se puede hacer usando

df.na.fill(valor, subset=["nombre_columna"]). Las estrategias de imputación comunes incluyen el uso de la media, la mediana o un valor constante. Por ejemplo,df.na.fill(df.stat.mean("nombre_columna"), subset=["nombre_columna"])para reemplazar los valores faltantes con la media de la columna. También puede usar la funciónfillna. Ejemplo:df.fillna({'nombre_columna': 0}) - Usando

coalesce: La funcióncoalescedevuelve el primer valor no nulo de una lista de columnas. Esto es útil cuando tiene varias columnas que podrían contener los datos deseados. Ejemplo:df.withColumn("nueva_columna", coalesce(col("columna1"), col("columna2")))

13. ¿Qué son las funciones definidas por el usuario (UDF) en Spark y cuándo podrías usarlas?

Las funciones definidas por el usuario (UDF) en Spark son funciones personalizadas que extienden la funcionalidad incorporada de Spark. Defines estas funciones usando lenguajes como Python, Scala, Java o R, y luego las registras con Spark para usarlas dentro de las expresiones SQL de Spark y DataFrames/Datasets. Esencialmente, te permiten aplicar lógica personalizada a tus datos durante las transformaciones.

Podrías usar UDFs cuando:

- Necesitas realizar cálculos o transformaciones complejas que no están disponibles en las funciones incorporadas de Spark.

- Necesitas integrarte con bibliotecas o sistemas externos dentro de tus trabajos de Spark. Por ejemplo:

spark.udf.register("mi_udf", mi_funcion_python)

14. ¿Cómo puedes optimizar el rendimiento de un trabajo de Spark, como reduciendo los shuffles?

Optimizar un trabajo de Spark implica varias estrategias para minimizar la reorganización de datos y el consumo de recursos. Un enfoque clave es reducir los shuffles, que son operaciones costosas que implican la redistribución de datos a través del clúster. Esto se puede lograr mediante técnicas como:

- Usando variables

broadcast: Transmite pequeños conjuntos de datos a todos los nodos de trabajo, evitando la necesidad de mezclar una tabla más grande para las uniones. Ejemplo:val broadcastState = sc.broadcast(statesMap). Luego, en una operación de mapa o unión, usabroadcastState.value. - Filtrando temprano: Aplica filtros lo antes posible en la tubería de procesamiento de datos para reducir la cantidad de datos que necesitan ser mezclados.

- Usando particiones apropiadas: Elige el número correcto de particiones según el tamaño de los datos y los recursos del clúster. Demasiadas pocas particiones pueden llevar a la subutilización, mientras que demasiadas pueden aumentar la sobrecarga. Considera usar repartition o coalesce estratégicamente.

- Evitando

groupByKeyinnecesario: PrefierereduceByKeyoaggregateByKeycuando sea posible, ya que realizan pre-agregación en el lado del mapeador antes de mezclar.groupByKeymezcla todos los datos. - Optimizando las operaciones de unión: Considera técnicas como el bucketing o el uso de sugerencias

skew joinsi hay una asimetría significativa de datos. Además, asegura un orden de unión adecuado para minimizar la transferencia de datos.

15. ¿Cuál es el propósito de la partición de datos en Spark? ¿Cómo puedes controlar el número de particiones?

La partición en Spark es crucial para el procesamiento paralelo. Divide los datos en fragmentos lógicos más pequeños que pueden ser procesados independientemente por diferentes ejecutores en todo el clúster. Esto mejora significativamente el rendimiento y la escalabilidad, especialmente para conjuntos de datos grandes, ya que permite una verdadera computación paralela.

Puedes controlar el número de particiones de varias maneras:

- Durante la carga de datos: Muchos métodos

SparkSession.readte permiten especificar el número de particiones (por ejemplo,spark.read.text("archivo.txt").repartition(10)). - Usando

repartition()ocoalesce():repartition()crea un nuevo RDD/DataFrame con el número especificado de particiones, barajando los datos.coalesce()intenta reducir el número de particiones de manera más eficiente, evitando una mezcla completa si es posible. Usa repartition al aumentar las particiones o cuando una mezcla completa es aceptable/deseada. Usa coalesce al disminuir el número de particiones para evitar una mezcla completa. - Configuración de Spark: La propiedad

spark.default.parallelismafecta el número predeterminado de particiones para los RDD creados a partir de fuentes de datos como archivos o colecciones. Sin embargo, a menudo es preferible establecer explícitamente el número de particiones conrepartition()o durante la carga de datos para un mejor control.

16. ¿Qué es el sistema de archivos de Databricks (DBFS) y cómo se utiliza para almacenar datos?

El sistema de archivos de Databricks (DBFS) es un sistema de archivos distribuido montado en un espacio de trabajo de Databricks, disponible en los clústeres de Databricks. Es una capa de abstracción sobre el almacenamiento en la nube (como AWS S3, Azure Blob Storage o Google Cloud Storage), lo que permite a los usuarios interactuar con el almacenamiento en la nube como si fuera un sistema de archivos local.

DBFS se utiliza para diversos fines: almacenar datos para su procesamiento con Spark, almacenar bibliotecas, archivos de configuración y resultados de experimentos. Los usuarios pueden interactuar con DBFS a través de la CLI de DBFS, la interfaz de usuario de Databricks, la API REST de Databricks y las API de Spark. Esto facilita la carga de datos en DataFrames y conjuntos de datos de Spark. Por ejemplo, podría usar spark.read.csv("dbfs:/FileStore/mydata.csv") para leer un archivo CSV de DBFS.

17. ¿Ha utilizado cuadernos de Databricks antes? ¿Cuáles son algunas de sus ventajas?

Sí, he utilizado cuadernos de Databricks extensamente. Algunas ventajas incluyen:

- Colaboración: Múltiples usuarios pueden trabajar simultáneamente en el mismo cuaderno, fomentando el trabajo en equipo. Se admite la coautoría en tiempo real.

- Entorno Integrado: Proporciona un entorno unificado para la ingeniería de datos, la ciencia de datos y las tareas de aprendizaje automático. Integra Spark, Python, Scala, R y SQL.

- Control de Versiones: La integración con Git permite el seguimiento de los cambios y la colaboración en el código de forma eficaz.

- Computación Interactiva: Permite la exploración y visualización interactiva de datos, lo que facilita la comprensión y el análisis de los datos. Visualización en línea de gráficos y tablas.

- Escalabilidad: Aprovecha el poder de Apache Spark para procesar grandes conjuntos de datos.

- Implementación Simplificada: Los cuadernos se pueden implementar fácilmente como trabajos de producción. Puede programar trabajos directamente desde la interfaz de usuario de Databricks.

- Reproducibilidad: Fácil de recrear entornos con dependencias definidas.

Por ejemplo, el uso de %pip install <nombre_del_paquete> permite instalar paquetes específicos para la sesión actual del notebook, garantizando la consistencia del entorno.

18. ¿Cómo colabora con otros en proyectos de Databricks?

La colaboración en Databricks implica varias prácticas clave. Aprovecho Databricks Repos para el control de versiones utilizando Git, lo que permite que múltiples desarrolladores trabajen en los mismos notebooks o archivos de código simultáneamente y gestionen los cambios de manera efectiva a través de ramificaciones, fusiones y solicitudes de extracción. También utilizo las funciones de comentarios integradas de Databricks dentro de los notebooks para discutir el código, compartir ideas y proporcionar contexto para los cambios, lo que mejora la comunicación y la comprensión.

Además, utilizo espacios de trabajo y clústeres de Databricks compartidos para facilitar el trabajo en equipo. Por ejemplo, al desarrollar una tubería de datos, los miembros del equipo pueden trabajar en diferentes etapas (por ejemplo, ingestión de datos, transformación, carga) en notebooks separados dentro del mismo repositorio, y luego usar un notebook central para orquestar toda la tubería. El uso de clústeres compartidos garantiza entornos consistentes y simplifica la gestión de dependencias, evitando el problema de 'funciona en mi máquina'. Además, participo activamente en revisiones de código, proporcionando comentarios constructivos para asegurar la calidad del código y el cumplimiento de los estándares de codificación. Finalmente, la comunicación clara es clave, y utilizo herramientas como Slack o Teams para discusiones rápidas y actualizaciones sobre el progreso del proyecto.

19. ¿Cuáles son algunas formas de monitorear el rendimiento de un trabajo de Spark en Databricks?

Puede monitorear el rendimiento del trabajo de Spark en Databricks a través de varios métodos. La Interfaz de usuario de Spark (Spark UI) es una herramienta principal, que ofrece información sobre la ejecución del trabajo, las etapas, las tareas y el uso de recursos. Acceda a ella directamente desde la interfaz de usuario de Databricks o a través del Servidor de Historial de Spark para trabajos completados. También puede usar la Interfaz de usuario de Monitoreo de Databricks (Databricks Monitoring UI), disponible en la interfaz de usuario de Databricks.

Además, los Repositorios de Databricks (Databricks Repos) y las soluciones de registro integradas como Azure Monitor o AWS CloudWatch (dependiendo del proveedor de la nube) pueden capturar registros y métricas para su análisis. Considere usar spark.sparkContext.addSparkListener() para rastrear y recopilar métricas programáticamente y enviarlas a sistemas de monitoreo externos. Por ejemplo, se puede usar esto para enviar datos a herramientas de monitoreo como Prometheus o Grafana.

20. ¿Cómo abordaría la depuración de un trabajo de Spark que se ejecuta lentamente o falla?

Al depurar trabajos de Spark lentos o fallidos, comenzaría por examinar la interfaz de usuario de Spark en busca de cuellos de botella, centrándome en las etapas con duraciones largas o lectura/escritura de mezcla (shuffle) alta. Verificaría la asimetría de los datos (data skew), lo que puede causar una distribución desigual de las tareas y un rendimiento lento. Revisar los registros del ejecutor y los registros del controlador es crucial para identificar errores, excepciones o problemas de recursos como errores de memoria (OOM).

Luego, miraría el código para asegurar que los datos se estén procesando de manera eficiente. Esto incluye evitar mezclas innecesarias (por ejemplo, usar uniones broadcast para conjuntos de datos pequeños), optimizar la serialización de datos (usando Kryo) y asegurar que los datos se filtren lo antes posible en la tubería para reducir la cantidad de datos que se procesan. También podría considerar aumentar el paralelismo del trabajo ajustando el número de particiones.

21. ¿Qué es Delta Lake y qué beneficios ofrece en comparación con los lagos de datos tradicionales?

Delta Lake es una capa de almacenamiento de código abierto que aporta fiabilidad a los lagos de datos. Proporciona transacciones ACID (Atomicidad, Consistencia, Aislamiento, Durabilidad), manejo de metadatos escalable y unifica el procesamiento de datos en streaming y por lotes. Esencialmente, es una capa sobre el almacenamiento de objetos existente como AWS S3, Azure Data Lake Storage o Google Cloud Storage, que proporciona funciones mejoradas para la gestión de datos.

En comparación con los lagos de datos tradicionales, Delta Lake ofrece varios beneficios: Asegura la fiabilidad de los datos a través de transacciones ACID, previniendo la corrupción de los datos. Permite la aplicación y evolución de esquemas, manteniendo la calidad de los datos a lo largo del tiempo. Proporciona capacidades de versionado y viaje en el tiempo, lo que le permite auditar y revertir a estados de datos anteriores. Los lagos de datos tradicionales a menudo carecen de estas características, lo que lleva a problemas de calidad de los datos y dificultades en la gestión de datos a gran escala.

22. ¿Puede explicar las propiedades ACID y cómo Delta Lake las asegura?

Las propiedades ACID (Atomicidad, Consistencia, Aislamiento, Durabilidad) son cruciales para las transacciones de datos fiables. Delta Lake asegura las propiedades ACID en su lago de datos utilizando un registro de transacciones.

- Atomicidad: Las transacciones son todo o nada. Delta Lake utiliza un protocolo de confirmación para garantizar que se apliquen todos los cambios en una transacción, o ninguno. El registro de transacciones de Delta sirve como fuente de verdad, garantizando que nunca se expongan escrituras parciales.

- Consistencia: Las transacciones mueven los datos de un estado válido a otro. Delta Lake aplica la validación y las restricciones del esquema, evitando que se escriban datos incorrectos. Asegura que solo se agreguen a la tabla datos válidos, que se ajusten al esquema definido.

- Aislamiento: Las transacciones concurrentes están aisladas entre sí. Delta Lake utiliza el control de concurrencia optimista con aislamiento serializable, lo que significa que múltiples transacciones pueden ejecutarse concurrentemente, pero parecerá que se ejecutaron en serie. Los conflictos se detectan y resuelven, y las transacciones se reintentarán automáticamente.

- Durabilidad: Una vez que se confirma una transacción, es permanente. Delta Lake almacena el registro de transacciones en almacenamiento confiable (por ejemplo, almacenamiento de objetos en la nube como S3 o Azure Blob Storage), lo que hace que los cambios confirmados sean duraderos incluso ante fallas. La creación de puntos de control del registro de transacciones mejora el rendimiento de lectura.

23. ¿Cuál es la diferencia entre una 'tabla gestionada' y una 'tabla externa' en Databricks?

En Databricks, el ciclo de vida de una tabla gestionada está totalmente controlado por Databricks. Cuando se elimina una tabla gestionada, se borran tanto los metadatos como los datos subyacentes. Los datos se almacenan en la ubicación de almacenamiento gestionada por Databricks, a menudo la raíz DBFS. Una tabla externa, por otro lado, solo tiene sus metadatos gestionados por Databricks. Los datos en sí residen en una ubicación de almacenamiento externa que usted especifica, como un almacenamiento de blobs de Azure o un bucket de AWS S3. Eliminar una tabla externa solo elimina los metadatos del metastore; los datos subyacentes permanecen intactos en su ubicación externa.

Las diferencias clave son:

- Ubicación de los datos: Las tablas gestionadas almacenan datos en el almacenamiento controlado por Databricks; las tablas externas almacenan datos en ubicaciones definidas por el usuario.

- Eliminación de datos: Eliminar una tabla gestionada borra tanto los metadatos como los datos; eliminar una tabla externa solo borra los metadatos.

- Acceso a los datos: Las tablas externas son útiles cuando los datos necesitan ser accedidos por otras herramientas o procesos fuera de Databricks porque residen en almacenamiento externo, mientras que las tablas gestionadas se utilizan principalmente dentro de Databricks.

24. ¿Cómo implementaría una tubería de datos simple utilizando Databricks, desde la ingestión de datos hasta la transformación de datos?

Una tubería de datos simple de Databricks implica ingerir datos de una fuente, transformarlos y luego almacenarlos. Primero, use cuadernos de Databricks o Delta Live Tables (DLT) para leer datos de varias fuentes (por ejemplo, almacenamiento en la nube como AWS S3, Azure Blob Storage o bases de datos). Esto se puede hacer utilizando la funcionalidad spark.read de Spark con las opciones de formato apropiadas (por ejemplo, csv, json, parquet).

A continuación, los datos se transforman utilizando Spark SQL o PySpark DataFrames. Esto implica limpiar, filtrar, agregar y unir conjuntos de datos. Por ejemplo, puede usar funciones como filter(), groupBy(), agg() y join(). Luego, los datos transformados se escriben en una ubicación de almacenamiento de destino, típicamente una tabla de Delta Lake para mejorar la fiabilidad y el rendimiento. Esto se logra utilizando df.write.format("delta").save("/ruta/a/la/tabla/delta"). La programación se puede lograr utilizando Databricks Jobs o DLT pipelines para la ejecución automatizada.

Preguntas de entrevista de Databricks para juniors

1. Imagina que Databricks es un cofre de juguetes. ¿Cuáles son algunos juguetes (características) que encontrarías dentro y qué hacen?

¡Imagina Databricks como un cofre de juguetes! Aquí tienes algunos juguetes que encontrarías:

- Spark: El motor principal. Es como un conjunto de bloques de construcción para el procesamiento distribuido de datos, lo que te permite construir pipelines de datos complejos y ejecutarlos rápidamente en un clúster.

- Delta Lake: Piénsalo como una herramienta organizativa mágica para tu data lake. Agrega fiabilidad y estructura (transacciones ACID, aplicación de esquema) a los datos almacenados en el almacenamiento de objetos en la nube, garantizando la calidad de los datos.

- MLflow: Esta es una caja de herramientas para proyectos de aprendizaje automático. Te ayuda a rastrear experimentos, gestionar modelos y desplegarlos fácilmente. Es como un sistema para mantener organizados todos tus proyectos de construcción de ML.

- SQL Analytics (Databricks SQL): Una lupa, que da a los usuarios de negocio la capacidad de explorar los datos almacenados en el lakehouse utilizando consultas SQL estándar. Ideal para dashboards e informes.

- Notebooks: Entornos de codificación interactivos. Utiliza lenguajes como Python, Scala, R y SQL para interactuar con los datos. Puedes escribir código útil, como

print('¡Hola Mundo!')ospark.read.format('delta').load('/ruta/a/delta').show().

2. Si tienes una gran pila de ladrillos LEGO (datos), ¿cómo te ayudaría Databricks a ordenar y construir algo genial con ellos?

Databricks proporciona una plataforma poderosa para procesar y transformar grandes conjuntos de datos, similar a ordenar y construir con una gran pila de ladrillos LEGO. Aquí te explicamos cómo:

El motor Spark de Databricks permite el procesamiento paralelo de datos, lo que te permite ordenar, filtrar y transformar eficientemente tus 'ladrillos LEGO' (datos) a escala. Las características clave incluyen:

- Escalabilidad: Maneja fácilmente grandes conjuntos de datos con computación distribuida.

- Ingeniería de datos: Usa herramientas como Delta Lake para el almacenamiento y versionado de datos confiables.

- Ciencia de datos y aprendizaje automático: Aprovecha MLflow integrado para la creación e implementación de modelos.

- Análisis SQL: Ejecuta consultas SQL para explorar y analizar tus datos de 'ladrillos LEGO'.

Esencialmente, Databricks te da las herramientas para organizar, manipular y combinar tus datos (ladrillos LEGO) para construir estructuras complejas y valiosas (información, modelos, aplicaciones).

3. ¿Cuál es la diferencia entre un 'clúster' pequeño y uno grande en Databricks, como tener pocos o muchos amigos que te ayuden a construir?

En Databricks, un clúster pequeño es como tener unos pocos amigos que te ayudan a construir algo: es más barato y rápido para empezar, bueno para tareas más pequeñas o pruebas. Tiene recursos de cómputo limitados, por lo que las tareas tardan más si requieren muchos datos o son computacionalmente complejas. Un clúster grande es como tener muchos amigos: es más caro, pero puede manejar tareas más grandes y complejas mucho más rápido porque tiene más poder de cómputo (más núcleos y memoria).

Elegir el tamaño correcto depende de tu carga de trabajo. Los clústeres pequeños son ideales para el desarrollo, las pruebas y conjuntos de datos pequeños. Los clústeres grandes brillan cuando necesitas procesar grandes conjuntos de datos o ejecutar cálculos complejos rápidamente. Considera la compensación entre costo y rendimiento al decidir.

4. ¿Puedes explicar, de forma sencilla, qué es un 'notebook' en Databricks y por qué lo usamos?

En Databricks, un notebook es una interfaz web para crear y ejecutar código, visualizaciones y documentación de forma colaborativa. Piénsalo como un cuaderno digital e interactivo donde puedes combinar código, su salida y texto explicativo en un solo documento.

Usamos notebooks por varias razones:

- Colaboración: Múltiples usuarios pueden trabajar en el mismo notebook simultáneamente.

- Desarrollo interactivo: Escribe y ejecuta código en celdas, ve los resultados inmediatamente e itera rápidamente.

- Exploración y visualización de datos: Explora fácilmente datos, crea visualizaciones y documenta hallazgos.

- Orquestación del flujo de trabajo: Encadena múltiples pasos en una tubería de datos.

- Soporte para múltiples lenguajes: Los notebooks de Databricks soportan lenguajes como Python, SQL, Scala y R. Por ejemplo, puedes usar los comandos mágicos

%python,%sql,%scalao%rpara especificar el lenguaje de una celda en particular. Esto permite una mezcla de lenguajes dentro de un mismo notebook.

5. Si tuvieras que enseñar a una computadora a sumar todos los números del 1 al 100, ¿cómo le dirías a Databricks que lo hiciera?

Le diría a Databricks que sumara los números del 1 al 100 usando un bucle o una fórmula matemática dentro de un trabajo de Spark. Usando Scala en Databricks, podría implementarlo así:

val sum = spark.range(1, 101).sum() println(sum) // Output: 5050.0

Alternativamente, podría usar la fórmula para la suma de una serie aritmética: n * (n + 1) / 2. Esto se implementaría como: val n = 100; val sum = n * (n + 1) / 2; println(sum). Este enfoque evita la iteración y es más eficiente para rangos grandes.

6. ¿Qué es 'Spark' en Databricks? Piénsalo como el motor que hace que todo funcione rápido. ¿Por qué es importante?

En Databricks, Spark es el motor de análisis unificado utilizado para el procesamiento de datos a gran escala. Piense en él como el núcleo potente que permite a Databricks manejar conjuntos de datos masivos y cálculos complejos de manera eficiente. Es importante porque permite a los usuarios realizar tareas como la limpieza de datos, la transformación, el aprendizaje automático y el análisis en tiempo real a velocidades significativamente más rápidas que los marcos de procesamiento de datos tradicionales.

Spark logra esta velocidad a través de varias características clave:

- Procesamiento en memoria: Spark almacena datos en la memoria RAM, lo que reduce la necesidad de leer del disco.

- Computación distribuida: Spark distribuye la carga de trabajo a través de un clúster de máquinas, lo que permite el procesamiento paralelo.

- Evaluación perezosa: Spark optimiza el plan de ejecución computando los resultados solo cuando es necesario.

Sin Spark, Databricks no podría cumplir su promesa de análisis de datos rápido y escalable.

7. Digamos que un archivo es como una receta. ¿Qué haría en Databricks para seguir esa receta y hornear un pastel (obtener información)?

Si un archivo es como una receta (instrucciones para el procesamiento de datos), en Databricks, seguiría estos pasos para 'hornear un pastel' (derivar información):

Primero, subiría el archivo de la 'receta' a Databricks, probablemente a DBFS o a una ubicación de almacenamiento montada. Luego, crearía un notebook de Databricks (Python, Scala, SQL o R) para orquestar el procesamiento de datos. Dentro del notebook, haría lo siguiente:

- Leer el archivo de la 'receta': Usar código para leer y analizar el archivo, por ejemplo:

with open("/dbfs/mnt/my_data/recipe.txt", "r") as f: recipe = f.read()

- Implementar la ingesta de datos: Usar Spark para cargar los datos ('ingredientes') desde la fuente especificada (por ejemplo, archivos, bases de datos) en DataFrames. Por ejemplo:

df = spark.read.csv("/dbfs/mnt/my_data/ingredients.csv", header=True)

-

Aplicar transformaciones de datos: Realizar las transformaciones de datos ('pasos') descritas en la receta utilizando operaciones de Spark DataFrame (filtrado, agregación, unión, etc.).

-

Analizar los resultados: Utilizar Spark para realizar análisis y obtener información, posiblemente visualizando los datos utilizando las herramientas de visualización integradas de Databricks o bibliotecas como Matplotlib y Seaborn.

-

Almacenar/presentar el 'pastel': Guardar la información obtenida ('pastel horneado') en una tabla, visualización o panel para que sea accesible. O, si la receta contiene instrucciones para generar un informe, crearía ese informe.

8. ¿Por qué es útil mantener los datos (como los juguetes) organizados en una 'casa' especial (lago/almacén de datos)?

Mantener los datos organizados en un repositorio central como un lago o almacén de datos facilita enormemente su búsqueda y uso. Imagínese buscando un juguete específico en una habitación desbordante de desorden frente a encontrarlo cuidadosamente guardado en su caja designada dentro de una casa de juguetes. Los lagos/almacenes de datos centralizan la información, lo que la hace accesible para el análisis, la generación de informes y el aprendizaje automático. Esto mejora la eficiencia y reduce el tiempo necesario para extraer información valiosa.

Además, los datos organizados permiten una mejor consistencia y calidad. Limpiar y transformar los datos se vuelve más simple cuando se gestionan de forma centralizada. Esto nos permite utilizar los datos de forma más fiable para la toma de decisiones y asegura que diferentes equipos trabajen con la misma información fiable. Piense en ello como etiquetar todas las cajas de juguetes, para que sepa exactamente lo que hay dentro, evitando confusiones y asegurando que todos jueguen con los juguetes correctos.

9. Si accidentalmente rompiste algunos LEGO (datos corruptos), ¿de qué manera Databricks podría ayudarte a arreglarlos?

Databricks puede ayudar a arreglar datos corruptos (como LEGO rotos) principalmente a través de sus capacidades de ingeniería de datos centradas en Delta Lake. Delta Lake proporciona transacciones ACID sobre lagos de datos, lo que permite funciones como el versionado y el viaje en el tiempo. Si los datos están corruptos, puedes usar la función de viaje en el tiempo de Delta Lake para revertir a una versión anterior y conocida de los datos. Por ejemplo:

%sql RESTORE TABLE my_table TO VERSION AS OF 2;

Este comando restauraría my_table al estado en el que se encontraba en la versión 2, deshaciendo efectivamente el daño causado por los "LEGO rotos". Además, el motor Spark de Databricks te permite realizar operaciones de limpieza y transformación de datos a escala. Los registros corruptos podrían ser identificados, filtrados y corregidos, antes de reescribir una versión limpia del conjunto de datos. Delta Lake proporciona el marco y Spark proporciona las herramientas para arreglarlo.

10. ¿Qué significa "escalar" tu proyecto Databricks, como agregar más mesas a un restaurante?

Escalar un proyecto Databricks, como agregar mesas a un restaurante, significa aumentar su capacidad y recursos para manejar cargas de trabajo más grandes y más datos. En lugar de mesas literales, piensa en tablas en tu lago de datos o almacén de datos. Esto podría implicar procesar conjuntos de datos más grandes, admitir más usuarios concurrentes o realizar análisis más complejos.

En términos prácticos, el escalado implica varios aspectos clave: aumentar la potencia de cálculo (por ejemplo, usando clústeres Databricks más grandes o más clústeres), optimizar el código para el rendimiento (por ejemplo, usando transformaciones Spark eficientes), gestionar el almacenamiento de datos de manera efectiva (por ejemplo, particionando datos) y potencialmente mejorar la arquitectura general para manejar las crecientes demandas. Podría optimizar las configuraciones de Spark, como spark.sql.shuffle.partitions, y también aumentar el tamaño del clúster.

11. Explique cómo usaría Databricks para encontrar el edificio más alto de todos los edificios de la ciudad de Nueva York.

Usaría Databricks con Spark para procesar un conjunto de datos que contenga información sobre los edificios de la ciudad de Nueva York. Primero, cargaría el conjunto de datos (por ejemplo, un archivo CSV o Parquet) en un DataFrame de Spark. Esto podría implicar leer los datos del almacenamiento en la nube como AWS S3 o Azure Blob Storage utilizando la API de fuente de datos de Spark. A continuación, seleccionaría las columnas relevantes para la altura del edificio (por ejemplo, 'nombre_del_edificio', 'altura_pies'). Finalmente, usaría las funciones de agregación de Spark para encontrar la altura máxima. Específicamente, usaría la función orderBy en la columna de altura y luego tomaría el nombre del edificio a través de first() o head(1).

Por ejemplo, en PySpark:

df = spark.read.csv("nyc_buildings.csv", header=True, inferSchema=True) tallest_building = df.orderBy(desc("height_feet")).select("building_name", "height_feet").first() print(tallest_building)

Este código lee el CSV, ordena por altura descendente, selecciona el nombre y la altura, e imprime el nombre del edificio con la altura más alta.

12. ¿Cómo usaría Databricks para contar cuántas veces aparece la palabra 'the' en un libro?

Primero, cargue el texto del libro en un DataFrame de Databricks. Puede leer el archivo de texto usando spark.read.text().

Luego, use los siguientes pasos:

- Divida el texto en palabras: Use la función

split()para dividir cada línea en una matriz de palabras. - Explote la matriz: Use la función

explode()para crear una nueva fila para cada palabra. - Filtre por 'the': Filtre el DataFrame para mantener solo las filas donde la palabra es 'the' (se recomienda una comparación que no distinga entre mayúsculas y minúsculas: función

lower()). - Cuente las ocurrencias: Use la función

count()para contar el número de filas en el DataFrame filtrado.

from pyspark.sql.functions import split, explode, lower book_df = spark.read.text("path/to/your/book.txt") word_df = book_df.select(explode(split(book_df.value, "\s+")).alias("word")) the_count = word_df.filter(lower(word_df["word"]) == "the").count() print(f"The word 'the' appears {the_count} times.")

13. Si se le da un archivo grande que contiene nombres y correos electrónicos de clientes, ¿cómo puede usar Databricks para encontrar todos los clientes de California?

Suponiendo que el archivo grande es accesible en Databricks (por ejemplo, en DBFS o un almacenamiento en la nube externo como S3), puede usar Spark SQL o PySpark para leer el archivo, aplicar la lógica de filtrado y extraer los datos de clientes requeridos. Primero, cargue los datos en un DataFrame de Spark. Luego, suponiendo que hay una columna 'estado', filtre el DataFrame para incluir solo las filas donde el 'estado' es 'California'. Finalmente, puede mostrar los resultados o guardarlos en un nuevo archivo.

Por ejemplo, en PySpark:

from pyspark.sql.functions import col df = spark.read.csv("/path/to/your/file.csv", header=True, inferSchema=True) # Carga el archivo CSV en un DataFrame california_customers = df.filter(col("state") == "California") # Filtra para los clientes de California california_customers.show() # Muestra los clientes de California #california_customers.write.csv("/path/to/california_customers.csv", header=True) # Guarda en un nuevo archivo CSV

14. Explique cómo Databricks puede ayudar a una empresa a predecir ventas futuras basándose en datos de ventas pasadas.

Databricks permite a las empresas predecir ventas futuras al aprovechar su plataforma unificada para la ingeniería de datos, la ciencia de datos y el aprendizaje automático. Primero, los datos históricos de ventas de diversas fuentes (CRM, ERP, sistemas de punto de venta) se ingieren y procesan utilizando las capacidades de ingeniería de datos de Databricks con Spark, lo que permite una limpieza, transformación y agregación eficientes de los datos. Estos datos limpios se utilizan luego para entrenar modelos de aprendizaje automático utilizando MLlib u otras bibliotecas como scikit-learn dentro del entorno Databricks, construyendo modelos predictivos como modelos de regresión o de series temporales, que podrían ser producidos fácilmente con MLflow o Databricks Model Serving.

Databricks simplifica todo el proceso de previsión de ventas, desde la preparación de datos hasta la implementación del modelo. El espacio de trabajo colaborativo permite a los científicos de datos e ingenieros trabajar juntos sin problemas. La infraestructura Spark escalable garantiza el procesamiento eficiente de grandes conjuntos de datos, y la plataforma MLflow integrada agiliza la gestión, el seguimiento y la implementación de modelos. Además, Databricks Delta Lake ofrece almacenamiento de datos y control de versiones confiables, lo que garantiza la integridad de los datos y la reproducibilidad de los resultados, mejorando la confianza en las cifras de ventas pronosticadas y permitiendo la toma de decisiones proactiva.

15. ¿Qué es una API en términos sencillos y cómo ayuda a Databricks a conectarse a otras cosas?

Una API (Interfaz de Programación de Aplicaciones) es como un camarero en un restaurante. El camarero toma tu pedido (solicitud) a la cocina (aplicación/sistema), y luego te trae la comida (respuesta). En el contexto de Databricks, una API es un conjunto de reglas y especificaciones que permiten que diferentes aplicaciones de software se comuniquen entre sí.

Las API permiten que Databricks se conecte a diversas fuentes de datos, herramientas y servicios. Por ejemplo, Databricks usa las API para:

- Leer datos del almacenamiento en la nube como AWS S3 o Azure Blob Storage.

- Escribir datos en bases de datos como MySQL o PostgreSQL.

- Integrarse con otros servicios como Tableau para la visualización o Airflow para la orquestación. Las llamadas subyacentes generalmente ocurren utilizando solicitudes HTTP que contienen la solicitud y la respuesta en un formato estándar (por ejemplo, JSON).

curl https://someapi.com/dataes un ejemplo de tal llamada a la API. Databricks puede procesar los datos obtenidos a través de la API.

16. Imagina que tienes dos listas de nombres. ¿Cómo encontrarías los nombres que están en ambas listas usando Databricks?

Para encontrar nombres presentes en ambas listas usando Databricks, puedes aprovechar el poder de Apache Spark y su API DataFrame. Asumiendo que tus listas se almacenan como DataFrames (por ejemplo, df1 y df2), puedes usar una operación de inner join. Primero crea dos dataframes para la lista de nombres y carga los datos en ellos. Para que el join funcione, necesitarás una columna común, lo cual se puede hacer especificando la columna usando .join después de especificar los dataframes.

Aquí hay un ejemplo usando PySpark:

from pyspark.sql.functions import col # Asumiendo que df1 y df2 son tus DataFrames con una columna llamada 'name' nombres_comunes = df1.join(df2, df1["name"] == df2["name"], "inner") # Selecciona solo la columna 'name' para obtener la lista de nombres comunes (opcional) nombres_comunes = nombres_comunes.select(col("df1.name")) nombres_comunes.show()

El DataFrame nombres_comunes resultante contendrá los nombres que aparecen en ambos DataFrames de entrada. Este enfoque es eficiente para conjuntos de datos grandes porque Spark distribuye la operación de join a través del clúster. Ten en cuenta que también puedes escribir código en Scala.

17. ¿Cómo puede Databricks ayudar a detectar fraudes analizando patrones en las transacciones con tarjetas de crédito?

Databricks, aprovechando Apache Spark, puede procesar y analizar eficientemente grandes volúmenes de datos de transacciones con tarjetas de crédito para detectar patrones fraudulentos. Permite a los ingenieros de datos y a los científicos de datos construir sistemas robustos de detección de fraudes al:

- Ingesta y preprocesamiento de datos: Conexión a diversas fuentes de datos (bases de datos, flujos), limpieza, transformación y agregación de datos de transacciones utilizando Spark DataFrames y SQL.

- Ingeniería de características: Creación de características indicativas de fraude, como la frecuencia de transacciones, el importe, anomalías de ubicación, patrones de gasto en comparación con datos históricos, etc., todo mediante trabajos escalables de Spark.

- Entrenamiento e implementación de modelos: Entrenamiento de modelos de aprendizaje automático (por ejemplo, Regresión Logística, Bosques Aleatorios, Árboles Aumentados por Gradiente) utilizando MLlib u otras bibliotecas de ML en Databricks. MLflow de Databricks puede rastrear experimentos, gestionar modelos e implementar el modelo con mejor rendimiento en producción para la puntuación de fraude en tiempo real o por lotes.

- Monitoreo en tiempo real: Implementación de tuberías de datos de transmisión con Spark Streaming o Structured Streaming para analizar transacciones en tiempo real y activar alertas cuando se detectan actividades sospechosas. Databricks Delta Lake permite un almacenamiento de datos confiable y de alto rendimiento tanto para el análisis histórico como para la ingesta en tiempo real.

- Colaboración: Proporciona cuadernos colaborativos para que los científicos de datos e ingenieros trabajen juntos en la construcción, prueba e implementación de soluciones de detección de fraude.

18. ¿Cuáles son algunas de las herramientas de visualización de datos que puede usar con Databricks para mostrar datos?

Databricks ofrece varias opciones para la visualización de datos. La función integrada display() es una forma rápida y fácil de generar gráficos y tablas directamente desde DataFrames dentro de los cuadernos. Esto funciona bien para el análisis exploratorio de datos. Además, puede usar bibliotecas populares de Python como Matplotlib, Seaborn y Plotly dentro de los cuadernos de Databricks. Estas bibliotecas ofrecen una amplia gama de opciones de personalización para crear visualizaciones sofisticadas. Para paneles interactivos, Databricks SQL (anteriormente conocido como Databricks Workspace SQL) proporciona una plataforma para crear y compartir paneles usando consultas SQL.

También puede conectar Databricks a herramientas de BI externas como Tableau, Power BI y Looker usando los controladores JDBC/ODBC para aprovechar sus capacidades avanzadas de visualización e integrar los datos de Databricks en los flujos de trabajo de informes existentes. Por ejemplo, con Plotly, puede renderizar gráficos interactivos usando plotly.offline.iplot().

19. ¿Cómo usaría Databricks para analizar el tráfico del sitio web y averiguar qué páginas son las más populares?

Usaría Databricks con Spark SQL o Python (PySpark) para analizar los registros de tráfico del sitio web, típicamente almacenados en un formato como los registros de acceso de Apache. Primero, ingeriría los datos del registro en una tabla Delta de Databricks. Luego, usando Spark SQL, consultaría la tabla para extraer las URL de las páginas y agregar el número de visitas para cada página. Finalmente, ordenaría los resultados en orden descendente para identificar las páginas más populares. El código se vería así: SELECT page_url, COUNT(*) AS visit_count FROM logs_table GROUP BY page_url ORDER BY visit_count DESC.

Alternativamente, en PySpark, cargaría los registros, extraería las URL y luego usaría las funciones groupBy y count para lograr el mismo resultado. Después de obtener los resultados, los visualizaría usando las herramientas de gráficos integradas de Databricks u otras bibliotecas como Matplotlib para identificar fácilmente las páginas y tendencias más populares.

20. ¿Cómo puede Databricks ayudar a mejorar la precisión de los modelos de aprendizaje automático?

Databricks mejora la precisión de los modelos de aprendizaje automático a través de varias capacidades clave. Su plataforma unificada agiliza todo el ciclo de vida del ML, facilitando la ingeniería de datos, la ingeniería de características, el entrenamiento de modelos y la implementación, lo que lleva a resultados más consistentes y confiables. Específicamente, características como Delta Lake aseguran la calidad y confiabilidad de los datos, cruciales para el entrenamiento preciso de modelos, y MLflow permite el seguimiento de experimentos, el versionado y la reproducibilidad, lo que permite a los científicos de datos mejorar los modelos iterativamente mientras mantienen un claro registro de auditoría.

Además, Databricks admite el entrenamiento distribuido utilizando Apache Spark, lo que permite un entrenamiento de modelos más rápido en conjuntos de datos grandes. Esto es vital para modelos complejos que requieren datos sustanciales para un rendimiento óptimo. El entorno colaborativo de la plataforma promueve el intercambio de conocimientos y la reutilización de código dentro de los equipos de ciencia de datos. Las capacidades de AutoML automatizan la selección de modelos y el ajuste de hiperparámetros para mejorar la eficiencia.

21. Explique cómo configuraría un trabajo simple de Databricks para que se ejecute automáticamente todos los días.

Para configurar un trabajo diario de Databricks, usaría la interfaz de usuario de Trabajos de Databricks o la API REST de Databricks. Dentro de la interfaz de usuario, crearía un nuevo trabajo, configuraría una tarea para ejecutar un cuaderno o JAR específico y luego definiría un disparador de programación. Esta programación se configuraría para ejecutarse diariamente a la hora deseada. Por ejemplo, podría seleccionar una recurrencia diaria y establecer los campos 'Hora' y 'Minuto' para definir la hora exacta del día.

Alternativamente, usando la API REST, crearía una carga útil JSON que especifica los detalles de la tarea (ruta del cuaderno, parámetros si los hay) y la programación (usando la sintaxis cron para definir la ejecución diaria). Una carga útil de ejemplo podría incluir:

{ "name": "MiTrabajoDiario", "tasks": [ { "task_key": "mitarea", "notebook_task": { "notebook_path": "/Usuarios/me@example.com/MiCuaderno" }, "new_cluster": { "spark_version": "12.2.x-scala2.12", "node_type_id": "Standard_DS3_v2", "num_workers": 2 } } ], "schedule": { "quartz_cron_expression": "0 0 0 * * ?", "timezone": "UTC" } }

Luego, usaría curl o una herramienta similar para publicar esta carga útil en el punto final de la API de Trabajos de Databricks.

22. Si tiene un archivo con datos faltantes, ¿cómo usaría Databricks para manejarlo?

Para manejar datos faltantes en Databricks, primero cargaría los datos en un DataFrame de Spark. Luego, exploraría los patrones de datos faltantes usando funciones como isNull(), isnan(), count() y groupBy() para comprender la extensión y distribución de los valores faltantes. A continuación, elegiría una estrategia de imputación adecuada.

Las estrategias comunes incluyen:

- Eliminación de filas/columnas: Usa

dropna()para eliminar filas o columnas con valores faltantes (apropiado si los datos faltantes son mínimos). - Imputación:

- Imputación con la media/mediana/moda: Reemplaza los valores faltantes con la media, la mediana o la moda de la columna (usando

fillna()con la estadística calculada). - Imputación con valor constante: Reemplaza los valores faltantes con un valor constante específico (también usando

fillna()). - Técnicas más avanzadas: Para escenarios más complejos, podría considerar usar técnicas de imputación más avanzadas como la imputación de k-vecinos más cercanos (usando bibliotecas como

sklearn.imputea través de UDFs de Spark) o la imputación basada en modelos (entrenando un modelo para predecir los valores faltantes). Finalmente, evaluaría el impacto de la estrategia elegida en el análisis posterior.

- Imputación con la media/mediana/moda: Reemplaza los valores faltantes con la media, la mediana o la moda de la columna (usando

23. ¿Cómo se asegura de que su código de Databricks sea fácil de leer y comprender para los demás?

Para asegurar la legibilidad y comprensión de mi código de Databricks, priorizo las prácticas de codificación limpia. Esto incluye el uso de nombres descriptivos para variables y funciones, agregar comentarios para explicar la lógica compleja y adherirme a un formato de código consistente (por ejemplo, sangría consistente, saltos de línea). También trato de mantener las funciones pequeñas y enfocadas, con parámetros de entrada y salida claros. El código debe dividirse en partes más pequeñas y manejables utilizando funciones. Evito bloques de código largos o profundamente anidados. Uso celdas de markdown en los cuadernos de Databricks para explicar el propósito de las secciones de código.

También estructuro mis cuadernos de Databricks de manera lógica, agrupando las celdas de código relacionadas y usando encabezados de markdown para proporcionar contexto. Usar títulos de celda significativos es importante. Cuando es posible, sigo guías de estilo como PEP 8 para Python y guías de estilo SQL generales al escribir consultas SQL. Si una transformación es particularmente complicada, una pequeña muestra de los datos que entran en la transformación y los datos de salida esperados ayuda a explicarla. Considere usar las funciones de documentación incorporadas de Databricks. Por ejemplo:

def calcular_promedio(datos: list[int]) -> float: """Calcula el promedio de una lista de enteros. Args: datos: Una lista de enteros. Returns: El promedio de los enteros en la lista. Raises: TypeError: Si la entrada no es una lista de enteros. ValueError: Si la lista de entrada está vacía. """ if not isinstance(datos, list): raise TypeError("La entrada debe ser una lista.") if not all(isinstance(x, int) for x in datos): raise TypeError("La lista debe contener solo enteros.") if not datos: raise ValueError("La lista de entrada no puede estar vacía.") return sum(datos) / len(datos)

24. Digamos que necesita procesar datos de múltiples fuentes (como bases de datos y archivos). ¿Cómo puede ayudar Databricks?

Databricks ofrece varias funciones para ayudar a procesar datos de múltiples fuentes de manera eficiente. Primero, proporciona conectores a varias fuentes de datos como bases de datos (por ejemplo, MySQL, PostgreSQL), almacenamiento en la nube (por ejemplo, AWS S3, Azure Blob Storage) y formatos de archivo (por ejemplo, CSV, JSON, Parquet). Estos conectores le permiten leer datos fácilmente en Databricks utilizando la API DataFrame de Spark. Por ejemplo, puede cargar un archivo CSV de la siguiente manera:

df = spark.read.csv("ruta/a/tu/archivo.csv", header=True, inferSchema=True)

En segundo lugar, la plataforma de análisis unificado de Databricks le permite realizar transformaciones y análisis de datos de estas fuentes dispares utilizando un único entorno consistente. Puede utilizar SQL, Python, Scala o R para consultar y procesar los datos. Al aprovechar las capacidades de procesamiento distribuido de Spark, Databricks puede manejar grandes volúmenes de datos de múltiples fuentes con alto rendimiento. Además, Databricks Delta Lake agrega una capa de almacenamiento encima del almacenamiento en la nube para la fiabilidad y las transacciones ACID.

Preguntas de entrevista intermedias de Databricks

1. ¿Cómo optimizaría un cuaderno de Databricks que se está ejecutando más lento de lo esperado?

Para optimizar un cuaderno de Databricks lento, primero identifique los cuellos de botella utilizando la interfaz de usuario de Spark o las herramientas de perfilado de Databricks para identificar las etapas u operaciones que consumen la mayor cantidad de recursos. Luego considere estas optimizaciones:

- Particionamiento de datos: Asegúrese de que los datos se particionen correctamente utilizando

repartition()ocoalesce()según la carga de trabajo para minimizar la reorganización de datos (shuffling). - Almacenamiento en caché: Almacene en caché DataFrames/Datasets a los que se accede con frecuencia utilizando

cache()opersist(). - Formatos de datos eficientes: Utilice formatos eficientes como Parquet o Delta, aprovechando características como la "propagación de predicados" (predicate pushdown).

- Variables de difusión (Broadcast Variables): Utilice variables de difusión para conjuntos de datos más pequeños para evitar la reorganización de datos durante las uniones (joins).

- Optimización de uniones (Joins): Elija la estrategia de unión adecuada según los tamaños de los conjuntos de datos (por ejemplo, unión hash de difusión para uniones pequeño-grande).

- Optimización del código: Revise el código de Spark en busca de ineficiencias; utilice UDFs vectorizadas siempre que sea posible y evite los bucles.

- Asignación de recursos: Ajuste los parámetros de configuración de Spark (por ejemplo,

spark.executor.memory,spark.executor.cores,spark.driver.memory) para proporcionar suficientes recursos. - Sesgo de datos (Data Skew): Maneje el sesgo de datos salando las claves o utilizando técnicas como la partición por rangos.

- Evite la reorganización de datos (shuffles) innecesaria: Refactorice el código para evitar transformaciones amplias que requieran reorganización de datos.

- Optimice las lecturas de archivos: Asegúrese de que el número de archivos leídos sea óptimo. Demasiados archivos pequeños pueden causar lecturas lentas.

- Optimice las escrituras: Asegúrese de que el número de archivos de salida sea óptimo ajustando el número de particiones.

- Use comandos de optimización de Delta Lake: Ejecute los comandos

OPTIMIZEyVACUUMen las tablas Delta.

2. Explique cómo manejaría datos sesgados en un DataFrame de Spark dentro de Databricks.

Para manejar datos sesgados en un DataFrame de Spark dentro de Databricks, consideraría estrategias como "salting" (agregar sal), "bucketing" (agrupación) y el uso de "broadcast joins" (uniones de transmisión). "Salting" implica agregar un prefijo o sufijo aleatorio a la clave sesgada para distribuirla en múltiples particiones. "Bucketing" es útil al unir en claves sesgadas dividiendo los datos en cubos. Para tablas de dimensiones pequeñas unidas con tablas de hechos grandes que exhiben sesgo, las "broadcast joins" pueden ser muy efectivas.

Específicamente, para "salting", el código podría parecerse a esto:

import org.apache.spark.sql.functions._ def addSalt(key: String, numBuckets: Int): String = { val rand = new scala.util.Random key + "_" + rand.nextInt(numBuckets).toString } val addSaltUDF = udf(addSalt _ , StringType) df.withColumn("salted_key", addSaltUDF(col("skewed_key"), lit(10)))

Después de "salting"/"bucketing", podemos realizar uniones en la nueva columna 'salted_key', reduciendo así el sesgo y mejorando el rendimiento. La Ejecución de Consultas Adaptativas (AQE) en Spark también es útil, ya que optimiza dinámicamente los planes de ejecución de consultas en tiempo de ejecución basándose en las estadísticas de los datos, lo que puede mitigar los efectos del sesgo. AQE puede fusionar particiones pequeñas, dividir particiones sesgadas y optimizar las estrategias de unión.

3. Describa su experiencia con el uso de Delta Lake para el almacenamiento de datos en Databricks. ¿Cuáles son los beneficios?

Tengo experiencia utilizando Delta Lake en Databricks para construir almacenes de datos confiables y escalables. Mi trabajo implicó la creación de tuberías de datos que ingerían datos de diversas fuentes, realizaban transformaciones y almacenaban los resultados en tablas Delta. Aproveché las características de Delta Lake, como las transacciones ACID, para garantizar la consistencia de los datos, especialmente durante las operaciones de escritura y actualizaciones concurrentes. También se utilizó el viaje en el tiempo para auditar los cambios de datos y revertir a versiones anteriores cuando fue necesario.

Los beneficios de utilizar Delta Lake incluyen una mayor confiabilidad de los datos debido a las propiedades ACID, una mejor gobernanza de los datos a través de la aplicación y evolución del esquema, y un aumento en el rendimiento de las consultas con características como el salto de datos y el Z-ordering. Además, su integración perfecta con Spark hizo que el procesamiento y la manipulación de datos fueran eficientes, lo que me permitió construir y mantener soluciones robustas de almacenamiento de datos.

4. ¿Cómo gestiona las dependencias (por ejemplo, bibliotecas de Python) en un entorno Databricks para garantizar la reproducibilidad?

Para gestionar las dependencias en Databricks para la reproducibilidad, utilizo principalmente pip y scripts de inicialización de Databricks junto con Databricks Repos.

requirements.txt: Creo un archivorequirements.txtque enumera todos los paquetes de Python necesarios y sus versiones. Este archivo se usa luego en un script de inicialización que se ejecuta cuando se inicia el clúster de Databricks. El script de inicialización ejecutapip install -r requirements.txt, lo que garantiza versiones de paquetes consistentes en todos los nodos.- Repositorios de Databricks: El código, incluidos los scripts de inicialización y

requirements.txt, se almacena en un repositorio de Databricks, con control de versiones (por ejemplo, usando Git). Esto permite una fácil reversión y garantiza que se use la versión correcta del código y las dependencias. - Bibliotecas del clúster: Otro enfoque es instalar directamente bibliotecas en un clúster. Sin embargo,

requirements.txty los scripts de inicialización son preferibles para una mayor reproducibilidad. Las bibliotecas se instalan en el clúster utilizando la interfaz de usuario o la CLI de Databricks. - Archivos Wheel: Para dependencias complejas o privadas, creo archivos wheel y los almaceno, instalándolos mediante

pip install /path/to/wheel_file.whlen el script de inicialización.

5. ¿Cuáles son algunas estrategias para manejar archivos pequeños en Databricks para mejorar el rendimiento?

Los archivos pequeños en Databricks pueden generar problemas de rendimiento debido al aumento de la sobrecarga en la gestión de numerosos archivos. Varias estrategias pueden mitigar esto:

- Reparticionamiento: Aumente el tamaño de la partición usando los métodos

repartition(numPartitions)ocoalesce(numPartitions)para reducir el número de particiones y crear archivos más grandes.repartition()mezcla los datos por completo en el clúster, creando una distribución equitativa, mientras quecoalesce()intenta minimizar el movimiento de datos (use coalesce si sabe que los datos ya están particionados razonablemente bien). Sin embargo,coalesce()puede resultar en tamaños de particiones desiguales. - Escribir datos con particionamiento optimizado: Al escribir datos en el almacenamiento, puede asegurar un particionamiento eficiente especificando el número de particiones. Por ejemplo, al escribir un DataFrame:

df.write.option("maxRecordsPerFile", 1000000).parquet("path/to/output")

Esto limita el tamaño de los archivos. Adapte el valor maxRecordsPerFile según sus datos y clúster.

- Compactación: Compacte periódicamente archivos pequeños en archivos más grandes. Esto implica leer archivos pequeños, concatenarlos y escribir el resultado de nuevo en el almacenamiento. Esto se puede automatizar con trabajos programados.

- Usando Delta Lake: Delta Lake proporciona compactación automática (optimización automática) y omisión de datos que ayudan a administrar archivos pequeños y mejorar el rendimiento de las consultas.

6. ¿Cómo configuraría una tubería CI/CD para cuadernos y trabajos de Databricks?

Una tubería CI/CD para cuadernos y trabajos de Databricks se puede configurar utilizando herramientas como Azure DevOps, GitHub Actions o GitLab CI/CD. Los pasos básicos implican el control de versiones de sus cuadernos de Databricks (típicamente como archivos .ipynb o archivos .py exportados de cuadernos) en un repositorio Git. Luego, la tubería CI/CD se activaría al realizar commits de código en el repositorio. La tubería luego realizaría pasos como linting, pruebas unitarias (si corresponde) e implementar los cuadernos y trabajos en un espacio de trabajo de Databricks. Para la implementación, se puede usar la CLI de Databricks o la API REST de Databricks para importar cuadernos, crear o actualizar trabajos basados en el código más reciente en el repositorio. Considere usar la función databricks bundle para administrar los artefactos de implementación como parte de CI/CD.

Por ejemplo, una tubería simple podría:

- Extraer código: Obtener el código más reciente del repositorio Git.

- Lint & Test: Ejecutar linters (por ejemplo,

flake8,pylint) y pruebas unitarias. - Desplegar en Databricks: Usar la CLI de Databricks (

databricks bundles deploy) para desplegar los cuadernos y trabajos en un espacio de trabajo Databricks especificado. Esto podría implicar:databricks bundles validate: validar el desplieguedatabricks bundles deploy -t <target>: desplegar los paquetes

- Ejecutar pruebas en Databricks: Activar un trabajo de Databricks para ejecutar pruebas de integración o aceptación contra el código desplegado.

- Reportar resultados: Publicar los resultados de las pruebas y el estado del despliegue.

7. Explique cómo monitorizaría los trabajos de Databricks para detectar el rendimiento y los errores. ¿Qué métricas son importantes?

Para monitorizar los trabajos de Databricks, aprovecharía varias herramientas y métricas. Principalmente, usaría la interfaz de usuario de Databricks para monitorizar las ejecuciones de trabajos, prestando mucha atención a la interfaz de usuario de Spark para obtener información detallada sobre las etapas, las tareas y los ejecutores. Las métricas importantes incluyen la duración del trabajo, la duración de la tarea, los tamaños de lectura/escritura de shuffle y el uso de memoria del ejecutor. Esto puede ayudar a identificar cuellos de botella.

Para la monitorización y alerta proactiva, configuraría la monitorización de Databricks utilizando herramientas como Azure Monitor, Prometheus o Datadog para rastrear estas métricas clave. Configuraría alertas basadas en umbrales para fallos de trabajos, tareas de larga duración o consumo excesivo de recursos. Además, implementaría el registro dentro de los propios trabajos de Databricks utilizando log4j o similar, para capturar errores y advertencias específicas de la aplicación, que luego se pueden enrutar a un sistema de registro central para su análisis.

8. Describe tu experiencia con Databricks SQL Analytics. ¿En qué se diferencia de usar Spark SQL?

Mi experiencia con Databricks SQL Analytics implica usarlo para consultas interactivas y creación de paneles en lagos de datos. Lo he usado para construir paneles para usuarios de negocio, realizar análisis ad-hoc y crear informes. Es un almacén de SQL sin servidor muy eficiente, especialmente al consultar datos en formato Delta Lake.

Databricks SQL y Spark SQL son similares pero tienen diferencias clave. Spark SQL es un motor SQL distribuido de propósito general dentro del marco más amplio de Apache Spark, adecuado para el procesamiento de datos a gran escala y tuberías ETL. Databricks SQL, por otro lado, está optimizado para consultas SQL de baja latencia para cargas de trabajo de BI y análisis. Databricks SQL ofrece características como un motor de consulta optimizado para SQL, historial de consultas, paneles y alertas que no están disponibles fácilmente en Spark SQL. Piénsalo de esta manera: Spark SQL es para construir los datos, mientras que Databricks SQL es para analizar el producto terminado.

9. ¿Cómo implementaría la seguridad a nivel de fila en Databricks para controlar el acceso a los datos?

La seguridad a nivel de fila en Databricks se puede implementar utilizando varias técnicas. Un enfoque común es aprovechar las Vistas Dinámicas. Esto implica crear una vista que filtre los datos en función de la identidad de un usuario o la pertenencia a un grupo utilizando CURRENT_USER() o una función personalizada que recupere la información del grupo. La definición de la vista incluye una cláusula WHERE que restringe el acceso a las filas en función del contexto del usuario. Por ejemplo:

CREATE VIEW secured_table AS SELECT * FROM original_table WHERE user_id = CURRENT_USER();

Otro enfoque, especialmente útil con Delta Lake, implica el uso de las funciones de control de acceso a tablas de Delta Lake en conjunción con funciones definidas por el usuario (UDF) para definir políticas de acceso detalladas. Las UDF pueden encapsular una lógica de autorización compleja. Estas funciones, cuando se combinan, garantizan que los usuarios solo vean los datos que están autorizados a ver en función de las políticas o roles predefinidos dentro del entorno de Databricks.

10. Explique cómo usaría Databricks para construir una tubería de datos en tiempo real.

Para construir una canalización de datos en tiempo real en Databricks, aprovecharía Structured Streaming. Primero, configuraría una fuente de transmisión, como Kafka o Azure Event Hubs, para ingerir los datos entrantes. Luego, utilizando Spark Structured Streaming, realizaría transformaciones como filtrado, agregación y enriquecimiento en los datos. Finalmente, escribiría los datos procesados en un sumidero en tiempo real como una tabla Delta Lake configurada para lecturas de transmisión, una base de datos NoSQL o una solución de panel en tiempo real.

Las consideraciones clave incluyen elegir el intervalo de activación apropiado (por ejemplo, micro-lotes o continuo), manejar los datos que llegan tarde usando marcas de agua y asegurar la tolerancia a fallos con puntos de control. Monitorear el rendimiento de la canalización, incluyendo la latencia y el rendimiento, es crucial para mantener su estabilidad y eficiencia. Utilizaría las capacidades integradas de monitoreo de Databricks, la interfaz de usuario de Spark y las capacidades de registro para lograr esto.

11. ¿Cuál es la diferencia entre usar `dbutils.notebook.run` y llamar a un cuaderno como un trabajo en Databricks?

`dbutils.notebook.run` ejecuta un cuaderno dentro del contexto del cuaderno que lo llama. Esto significa que se ejecuta en línea, espera a que el cuaderno llamado se complete, y cualquier variable o configuración establecida en el cuaderno llamado puede ser directamente accedida o afectar el estado del cuaderno que llama, sujeto al alcance. Además, los errores en el cuaderno llamado detienen el cuaderno que llama.

Llamar a un cuaderno como un trabajo de Databricks, por otro lado, ejecuta el cuaderno en un contexto separado y aislado. No bloquea el proceso que llama; es asíncrono. Los cambios o errores en el cuaderno de trabajo no afectan directamente la ejecución del cuaderno del llamante. Los datos se pasan a través de métodos de entrada y salida bien definidos (por ejemplo, parámetros y devolver un valor usando `dbutils.notebook.exit()`), asegurando una separación adecuada. Los trabajos generalmente se activan en un horario o evento, y son más adecuados para cargas de trabajo de producción que requieren un manejo robusto de errores y aislamiento.

12. ¿Cómo usaría Databricks para realizar tareas de aprendizaje automático? Explique su flujo de trabajo preferido.

Usaría Databricks para realizar tareas de aprendizaje automático aprovechando su espacio de trabajo colaborativo, computación escalable y seguimiento integrado de MLflow. Mi flujo de trabajo preferido implica varios pasos: