Cómo contratar a un desarrollador de Spark: una guía paso a paso para reclutadores

Contratar a un Desarrollador Spark puede ser un cambio radical para las empresas que buscan aprovechar el poder del análisis de big data. Sin embargo, muchos reclutadores tropiezan a la hora de identificar el talento adecuado. La clave está en entender que los Desarrolladores Spark no son solo codificadores, sino arquitectos de datos que pueden transformar la información bruta en información procesable. No se trata solo de encontrar a alguien que conozca la tecnología; se trata de encontrar a un solucionador de problemas que pueda impulsar su estrategia de datos.

Esta guía completa le guiará a través del proceso de contratación de un Desarrollador Spark de primera categoría. Cubriremos todo, desde la redacción de una descripción de trabajo eficaz hasta la realización de entrevistas técnicas. Para profundizar en las habilidades específicas que debe buscar, consulte nuestro análisis detallado de las habilidades de los Desarrolladores Spark.

Tabla de contenidos

¿Qué hace un desarrollador de Spark?

Proceso de contratación de desarrolladores de Spark

Habilidades y calificaciones clave para contratar a un desarrollador de Spark

Cómo redactar una descripción de trabajo eficaz para un desarrollador de Spark

Las mejores plataformas para contratar desarrolladores de Spark

¿Cómo examinar los currículums de los desarrolladores de Spark?

Pruebas de habilidades recomendadas para evaluar a los desarrolladores de Spark

Asignaciones de estudios de caso para contratar desarrolladores de Spark

Estructuración de entrevistas técnicas para desarrolladores de Spark

¿Cuál es la diferencia entre un desarrollador de Spark y un ingeniero de datos de Spark?

¿Cuáles son los rangos de los desarrolladores de Spark?

Contrata a los mejores desarrolladores de Spark

¿Qué hace un desarrollador de Spark?

Un desarrollador de Spark es responsable de desarrollar aplicaciones de procesamiento de datos a gran escala utilizando Apache Spark. Transforman grandes volúmenes de datos en información útil, lo que ayuda a las empresas a tomar decisiones informadas.

A diario, un desarrollador de Spark trabaja en varias tareas:

- Diseñar e implementar pipelines de datos utilizando Apache Spark

- Escribir consultas complejas de Spark SQL para manipular datos

- Optimizar trabajos de Spark para rendimiento y escalabilidad

- Colaborar con ingenieros de datos y científicos de datos para integrar aplicaciones de Spark

- Garantizar la calidad de los datos y solucionar cualquier problema en los entornos de Spark

Para una mirada exhaustiva a las habilidades requeridas para un desarrollador de Spark, consulte nuestro blog.

Proceso de contratación de desarrolladores de Spark

Contratar a un desarrollador de Spark puede ser un proceso optimizado si sigue los pasos correctos. Típicamente, todo el proceso tarda alrededor de 1-2 meses.

-

Redacte una descripción clara del puesto: Asegúrese de que la descripción del puesto destaque las habilidades y la experiencia necesarias para un desarrollador de Spark. Publíquela en plataformas donde el talento tecnológico visite con frecuencia.

-

Selección de currículums: Recopile currículums en la primera semana. Busque candidatos con experiencia en Spark, Scala y tecnologías de big data.

-

Evaluación de habilidades: Utilice herramientas de selección técnica para evaluar las habilidades relacionadas con Spark del candidato. Esto ayuda a reducir la lista a los candidatos más competentes.

-

Etapa de entrevista: Realice entrevistas a los candidatos preseleccionados. Concéntrese tanto en la competencia técnica como en la adaptación cultural dentro de su equipo.

-

Selección final y oferta: Elija al mejor candidato en función de su rendimiento en las evaluaciones y entrevistas. Proceda con la carta de oferta y el proceso de incorporación.

Este proceso garantiza que contrate a un desarrollador de Spark de primer nivel que se alinee con sus demandas técnicas y expectativas culturales. Embárcate en cada paso con más detalle para optimizar tu estrategia de reclutamiento.

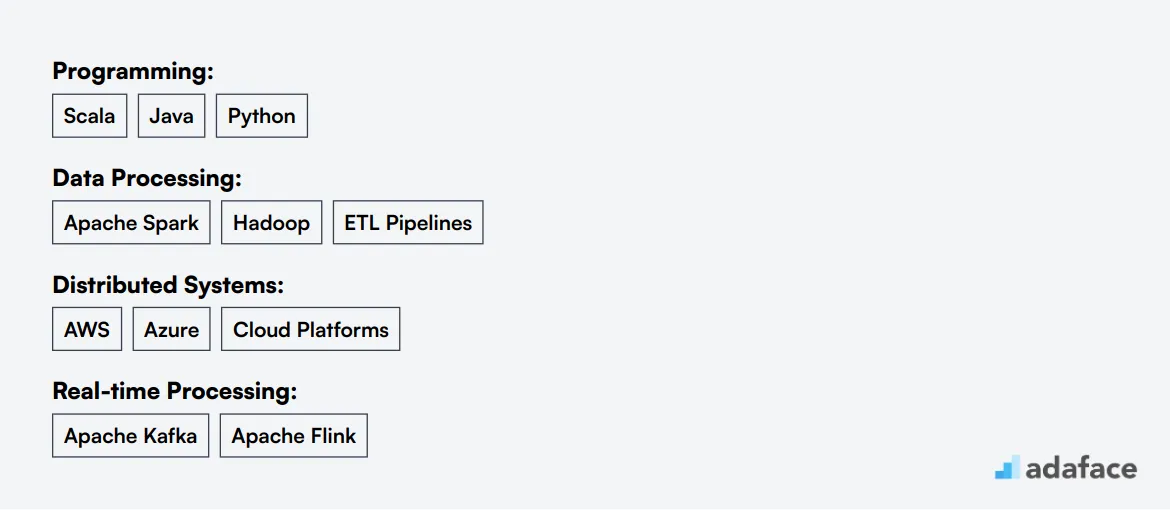

Habilidades y cualificaciones clave para contratar a un desarrollador de Spark

Al contratar a un desarrollador de Spark, la elaboración del perfil ideal del candidato puede ser un desafío. Lo que puede parecer crucial para una organización podría ser solo opcional para otra. Es importante diferenciar claramente entre las calificaciones requeridas y preferidas para encontrar la mejor opción para su equipo.

Aquí hay algunas habilidades y calificaciones comunes a considerar al evaluar a los candidatos para este puesto:

-

Habilidades requeridas:

-

Experiencia comprobada en el desarrollo con Apache Spark y el ecosistema Hadoop

-

Comprensión profunda de la arquitectura de Spark y la optimización del rendimiento

-

Fuertes habilidades de programación en Scala, Java o Python

-

Experiencia con el procesamiento de datos y el diseño de tuberías ETL

-

Conocimiento de sistemas distribuidos y plataformas en la nube como AWS o Azure

-

Habilidades preferidas:

-

Experiencia con el procesamiento de datos en tiempo real utilizando Apache Kafka o Flink

-

Familiaridad con soluciones de almacenamiento de datos como Snowflake o Redshift

-

Experiencia con bibliotecas y marcos de aprendizaje automático

-

Comprensión de los procesos y herramientas de CI/CD

-

Fuertes habilidades de comunicación para la colaboración con equipos multifuncionales

| Habilidades y calificaciones requeridas | Habilidades y calificaciones preferidas |

|---|---|

| Experiencia comprobada en desarrollo con Apache Spark y el ecosistema Hadoop | Experiencia con procesamiento de datos en tiempo real usando Apache Kafka o Flink |

| Comprensión profunda de la arquitectura de Spark y el ajuste del rendimiento | Familiaridad con soluciones de almacenamiento de datos como Snowflake o Redshift |

| Fuertes habilidades de programación en Scala, Java o Python | Experiencia con bibliotecas y frameworks de aprendizaje automático |

| Experiencia con el diseño de pipelines de procesamiento de datos y ETL | Comprensión de los procesos y herramientas de CI/CD |

| Conocimiento de sistemas distribuidos y plataformas en la nube como AWS o Azure | Fuertes habilidades de comunicación para la colaboración con equipos multifuncionales |

Cómo escribir una descripción de trabajo efectiva para un desarrollador de Spark

Una vez que haya identificado el perfil de candidato ideal para su puesto de Desarrollador de Spark, el siguiente paso es redactar una descripción de trabajo convincente para atraer a los mejores talentos. Aquí hay algunos consejos clave para que su descripción de trabajo de Desarrollador de Spark se destaque:

- Resalte responsabilidades específicas: Describa claramente las tareas y proyectos diarios que el Desarrollador de Spark manejará, como el desarrollo de pipelines de procesamiento de datos o la optimización de flujos de trabajo de big data.

- Equilibre los requisitos técnicos: Enumere las habilidades imprescindibles, como el dominio de Scala o Java, la experiencia con el ecosistema Spark y la familiaridad con los conceptos de computación distribuida.

- Enfatice las habilidades blandas: Incluya cualidades como habilidades para la resolución de problemas, trabajo en equipo y habilidades de comunicación para encontrar candidatos integrales.

- Muestre el atractivo de su empresa: Mencione proyectos únicos, oportunidades de aprendizaje o la cultura de la empresa para atraer a desarrolladores de Spark apasionados.

Principales plataformas para contratar desarrolladores de Spark

Una vez que tenga lista la descripción de su trabajo, es hora de buscar candidatos. Publicar su puesto de desarrollador de Spark en varias plataformas de empleo le ayudará a llegar a un público más amplio y atraer al talento adecuado.

LinkedIn es ideal para publicar puestos de desarrollador de Spark a tiempo completo debido a su vasta red profesional y herramientas de contratación.

Indeed

Indeed es popular para publicar ofertas de trabajo a tiempo completo en diversas industrias, incluida la tecnología, con un amplio alcance de candidatos.

Upwork

Upwork es una plataforma líder para contratar desarrolladores de Spark freelance para proyectos específicos o trabajos a corto plazo.

Algunas de las mejores plataformas a considerar incluyen LinkedIn por su red profesional, e Indeed, que es popular en todas las industrias. Además, Upwork y Toptal son excelentes opciones para buscar desarrolladores de Spark freelance, brindando flexibilidad para el trabajo basado en proyectos. Para las empresas interesadas en la cultura empresarial, Glassdoor ofrece información junto con ofertas de trabajo, y Hired lo conecta con candidatos de tecnología verificados que buscan activamente oportunidades.

¿Cómo evaluar los currículums de los desarrolladores de Spark?

En el mundo de la contratación tecnológica, el cribado de currículums es un paso clave para reducir una vasta cantidad de candidatos y encontrar al desarrollador de Spark ideal. Esta evaluación inicial ayuda a identificar los currículums que se ajustan a los requisitos de su trabajo, ahorrando tiempo y esfuerzo en el proceso de entrevista.

La evaluación manual de currículums implica detectar palabras clave específicas relacionadas con el desarrollo de Spark. Busque menciones de Apache Spark, el ecosistema Hadoop, Scala, Java o Python. Otras palabras clave importantes podrían incluir el diseño de tuberías ETL, sistemas distribuidos y plataformas en la nube como AWS o Azure. Estas habilidades son fundamentales para evaluar la idoneidad de un candidato para el puesto.

Aproveche los LLM de IA para automatizar y mejorar el proceso de selección. Herramientas como Claude o ChatGPT pueden ayudar a escanear los currículums en busca de palabras clave coincidentes y resaltar a los candidatos potenciales. Este enfoque ofrece una forma objetiva de examinar numerosas solicitudes de forma rápida y eficaz.

Aquí hay un ejemplo de prompt que puede usar para optimizar su proceso:

TAREA: Los currículums de la pantalla coinciden con la descripción del puesto para el puesto de desarrollador de Spark ENTRADA: Currículums SALIDA: Para cada currículum, proporcione la siguiente información: - ID de correo electrónico - Nombre - Palabras clave coincidentes - Puntuación (de 10 según las palabras clave coincidentes) - Recomendación (recomendación detallada sobre si preseleccionar o no a este candidato) - Preselección (Sí, No o Quizás) REGLAS: - Si no está seguro de la idoneidad de un candidato, ponga al candidato como Quizás en lugar de No - Mantenga la recomendación concisa y directa. DATOS DE PALABRAS CLAVE: - Apache Spark, ecosistema Hadoop - Programación (Scala, Java, Python) - Sistemas distribuidos (AWS, Azure)

Pruebas de habilidades recomendadas para evaluar a los desarrolladores de Spark

Las pruebas de habilidades son una excelente manera de evaluar a los desarrolladores de Spark objetivamente. Le ayudan a evaluar las habilidades prácticas de los candidatos más allá de lo que aparece en sus currículums. Veamos las mejores pruebas para usar al contratar desarrolladores de Spark.

Prueba en línea de Spark: Esta prueba de Spark evalúa la competencia de un candidato en los fundamentos de Apache Spark, las operaciones RDD y Spark SQL. Es ideal para evaluar las habilidades básicas de Spark necesarias para las tareas de procesamiento y análisis de datos.

Prueba PySpark: Para los roles que involucran Python con Spark, una evaluación de PySpark es valiosa. Comprueba la capacidad del candidato para usar PySpark para la manipulación de datos, el aprendizaje automático y las aplicaciones de transmisión.

Prueba en línea de Scala: Dado que Spark está escrito en Scala, una prueba de Scala puede ser útil. Evalúa la competencia de un desarrollador en la programación en Scala, que a menudo se utiliza para aplicaciones complejas de Spark.

Prueba en línea de Java: Muchas aplicaciones de Spark están escritas en Java. Una evaluación de Java ayuda a evaluar las habilidades de Java de un candidato, que a menudo son necesarias para el desarrollo y el mantenimiento de Spark.

Prueba de ingeniero de datos: Una evaluación de ingeniería de datos más amplia puede ser útil. Cubre varios aspectos del procesamiento de datos, incluido Spark, y ayuda a evaluar las capacidades generales de ingeniería de datos de un candidato.

Asignaciones de estudio de caso para contratar desarrolladores de Spark

Las asignaciones de estudio de caso pueden ser efectivas para evaluar a los desarrolladores de Spark, pero conllevan inconvenientes. A menudo consumen mucho tiempo, lo que lleva a tasas de finalización más bajas y potencialmente a perder buenos candidatos. A pesar de estos desafíos, los estudios de caso bien diseñados pueden proporcionar información valiosa sobre las habilidades de un candidato.

Optimización de la canalización de datos: Este estudio de caso pide a los candidatos que optimicen una canalización de datos de Spark para un mejor rendimiento. Es posible que necesiten identificar cuellos de botella, implementar estrategias de partición o usar las APIs de Spark apropiadas para mejorar la eficiencia. Esta tarea evalúa el conocimiento práctico de Spark y las habilidades de resolución de problemas.

Procesamiento de flujo en tiempo real: Los candidatos deben diseñar una aplicación de transmisión en tiempo real utilizando Spark Streaming. Deben proponer una arquitectura, manejar la ingestión de datos, implementar operaciones de ventana y garantizar la tolerancia a fallas. Este estudio de caso evalúa la comprensión de los conceptos de transmisión y las capacidades de transmisión de Spark.

Aprendizaje automático con Spark: Esta tarea implica la construcción de una canalización de aprendizaje automático utilizando Spark MLlib. Los candidatos pueden necesitar preprocesar datos, seleccionar características, entrenar un modelo y evaluar su rendimiento a escala. Evalúa tanto las habilidades de Spark como las de aprendizaje automático, que a menudo se requieren para los roles de desarrollador de Spark.

Estructuración de entrevistas técnicas para desarrolladores de Spark

Después de que los candidatos aprueban las pruebas iniciales de habilidades de desarrollador de Spark, es hora de las entrevistas técnicas. Estas entrevistas son cruciales para evaluar la comprensión profunda y la experiencia práctica de un candidato con Spark. Le permiten evaluar las habilidades de resolución de problemas y el conocimiento técnico en escenarios del mundo real.

Aquí hay algunas preguntas clave para hacer en las entrevistas de desarrolladores de Spark:

- ¿Cómo optimizaría un trabajo de Spark que se está ejecutando lentamente?

- ¿Puede explicar la diferencia entre RDD y DataFrame en Spark?

- ¿Cuál es su experiencia con Spark Streaming para el procesamiento de datos en tiempo real?

- ¿Cómo maneja la asimetría de datos en Spark?

- ¿Puede describir una canalización ETL compleja que haya construido utilizando Spark?

Estas preguntas ayudan a evaluar la experiencia práctica del candidato, sus habilidades para resolver problemas y su profundo entendimiento de los conceptos centrales y las mejores prácticas de Spark.

¿Cuál es la diferencia entre un Desarrollador de Spark y un Ingeniero de Datos de Spark?

Los roles de un Desarrollador de Spark y un Ingeniero de Datos de Spark a menudo pueden ser confundidos debido a sus áreas superpuestas en proyectos de big data. Sin embargo, el enfoque principal y las responsabilidades de estas dos posiciones son distintos.

Un Desarrollador de Spark se enfoca principalmente en el desarrollo de aplicaciones utilizando Apache Spark. Típicamente tienen habilidades en Spark, Scala y Java, y trabajan en proyectos que implican la creación de aplicaciones Spark y herramientas de análisis. Son responsables del procesamiento por lotes y en tiempo real, pero su conocimiento de las plataformas en la nube suele ser básico.

En contraste, un Ingeniero de Datos de Spark está más preocupado por la tubería de datos y la infraestructura. Sus habilidades principales incluyen Spark, Hadoop, SQL y NoSQL, que son esenciales para el procesamiento de datos a gran escala y las tareas de ETL (Extracción, Transformación, Carga). Poseen experiencia avanzada en plataformas en la nube como AWS, Azure y GCP, y se enfocan en la optimización de clústeres y trabajos, así como en habilidades avanzadas de modelado de datos.

| Desarrollador Spark | Ingeniero de Datos Spark | |

|---|---|---|

| Enfoque Principal | Desarrollo de aplicaciones | Tuberías e infraestructura de datos |

| Habilidades Principales | Spark, Scala, Java | Spark, Hadoop, SQL, NoSQL |

| Procesamiento de Datos | Procesamiento por lotes y en tiempo real | Procesamiento de datos a gran escala y ETL |

| Plataformas en la Nube | Conocimientos básicos | Experiencia avanzada (AWS, Azure, GCP) |

| Optimización del Rendimiento | Optimización a nivel de aplicación | Optimización de clústeres y trabajos |

| Modelado de Datos | Comprensión básica | Habilidades avanzadas de modelado de datos |

| Proyectos Típicos | Aplicaciones Spark, herramientas de análisis | Lagos de datos, almacenes, tuberías |

| Colaboración en Equipo | Trabaja con científicos de datos | Trabaja con arquitectos de datos, administradores de bases de datos |

¿Cuáles son los rangos de los Desarrolladores Spark?

Al contratar Desarrolladores Spark, es importante diferenciar entre varios rangos, ya que sus responsabilidades y experiencia pueden variar significativamente. Esto ayuda a alinear el talento adecuado con las necesidades específicas de su proyecto.

• Desarrollador Spark Junior: Un Desarrollador Spark Junior es típicamente un puesto de nivel inicial. Por lo general, tienen una comprensión fundamental de Spark y su ecosistema, pero necesitan orientación de desarrolladores más experimentados para completar tareas complejas.

• Desarrollador Spark: Un Desarrollador Spark de nivel medio posee una experiencia sustancial con Spark y puede manejar independientemente una variedad de proyectos. Se espera que escriban código eficiente, optimicen el rendimiento y colaboren con ingenieros de datos y científicos de datos.

• Desarrollador Spark Senior: Los Desarrolladores Spark Senior son profesionales altamente cualificados que lideran el desarrollo de soluciones complejas de procesamiento de datos. Son responsables de las decisiones arquitectónicas, la tutoría del personal junior y la garantía de las mejores prácticas en codificación y optimización del rendimiento.

• Desarrollador Spark Líder: El Desarrollador Spark Líder supervisa todo el equipo de desarrollo de Spark. No solo guía la dirección técnica, sino que también gestiona los plazos de los proyectos, coordina con otros equipos y se asegura de que las soluciones Spark se alineen con los objetivos empresariales.

Contrata a los Mejores Desarrolladores Spark

En esta publicación, cubrimos todo, desde la comprensión del papel de un Desarrollador Spark hasta la estructuración eficaz de las entrevistas técnicas. Exploramos las habilidades y cualificaciones clave necesarias, cómo redactar una descripción de trabajo convincente y dónde encontrar a los mejores talentos. Además, analizamos cómo seleccionar currículums y las diferencias entre los Desarrolladores Spark y los Ingenieros de Datos Spark.

Para asegurarte de contratar a los Desarrolladores Spark más adecuados, es fundamental centrarse en la elaboración de descripciones de trabajo precisas y la utilización de pruebas de habilidades relevantes. Considera la posibilidad de utilizar una Prueba Online de Spark para evaluar a los candidatos con precisión y tomar decisiones de contratación informadas. Recuerda que las herramientas y los procesos adecuados pueden mejorar significativamente la calidad de tu reclutamiento.

Prueba en línea de Spark

30 minutos | 15 preguntas de opción múltiple

La prueba en línea de Apache Spark evalúa la capacidad del candidato para transformar datos estructurados con la API RDD y SparkSQL (Datasets y DataFrames), convertir desafíos de big data en scripts iterativos/de múltiples etapas de Spark, optimizar trabajos de Spark existentes utilizando particiones/almacenamiento en caché y analizar estructuras de gráficos utilizando GraphX.

[

Probar la prueba en línea de Spark

](https://www.adaface.com/assessment-test/spark-online-test)

Preguntas frecuentes

Busque candidatos con una sólida formación en informática o campos relacionados, experiencia con tecnologías de big data, dominio de Scala o Java y familiaridad con los conceptos de computación distribuida. Las certificaciones en Apache Spark o tecnologías relacionadas pueden ser una ventaja.

Utilice una combinación de entrevistas técnicas, desafíos de codificación y evaluaciones de habilidades específicas de Spark. Pida a los candidatos que resuelvan problemas del mundo real utilizando Spark y evalúe su enfoque para el procesamiento y análisis de datos.

Busque desarrolladores de Spark en bolsas de trabajo especializadas, plataformas de redes sociales centradas en la tecnología, conferencias de ciencia de datos y a través de referencias de su equipo técnico actual. Las comunidades en línea centradas en big data y Apache Spark también pueden ser buenas fuentes.

Incluir las habilidades técnicas requeridas (Spark, Scala/Java, SQL), la experiencia deseada con tecnologías de big data, responsabilidades específicas y cualquier conocimiento específico de la industria. Resaltar proyectos o desafíos emocionantes en los que trabajarán. Puede encontrar una muestra de la descripción del puesto de trabajo de un desarrollador de Spark aquí.

Comenzar con preguntas sobre la arquitectura y los conceptos de Spark, pasar a escenarios de resolución de problemas que involucren grandes conjuntos de datos e incluir un ejercicio de codificación usando Spark. Preguntar sobre su experiencia con tuberías de datos e integración de Spark con otras tecnologías.

Los desarrolladores senior de Spark suelen tener más de 5 años de experiencia, pueden diseñar soluciones de datos complejas, optimizar trabajos de Spark para el rendimiento y liderar equipos. Los desarrolladores junior pueden tener entre 1 y 3 años de experiencia y se centran más en implementar diseños existentes y operaciones básicas de Spark.

El conocimiento de la computación en la nube es cada vez más importante, ya que muchas aplicaciones de Spark se ejecutan en plataformas en la nube. La familiaridad con servicios como AWS EMR, Azure HDInsight o Google Dataproc puede ser una ventaja significativa para un desarrollador de Spark.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento