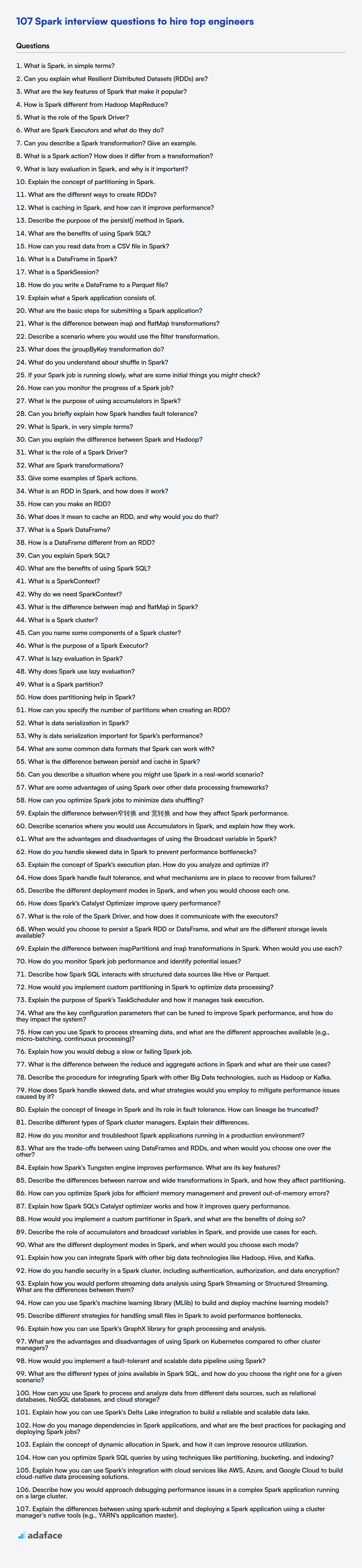

107 preguntas de entrevista de Spark para contratar a los mejores ingenieros

En el mundo del big data, Apache Spark destaca como un motor potente para el procesamiento y análisis de datos, por lo que los reclutadores necesitan encontrar personas que realmente conozcan Spark. A medida que las empresas compiten por aprovechar los datos para obtener información, identificar el mejor talento de Spark se vuelve súper importante.

Esta publicación te ofrece una lista seleccionada de preguntas de entrevista de Spark, adecuada para candidatos con diversos niveles de experiencia, desde recién graduados hasta profesionales experimentados, así como una selección de preguntas de opción múltiple (MCQ). Espera preguntas sobre la arquitectura de Spark, transformaciones de datos, ajuste del rendimiento y aplicaciones del mundo real.

Al usar estas preguntas, puedes evaluar mejor a los candidatos y asegurarte de que poseen las habilidades para impulsar tus iniciativas de datos y antes de invertir en entrevistas, considera usar la prueba en línea de Spark de Adaface para preseleccionar rápidamente a los candidatos.

Tabla de contenidos

Preguntas de entrevista de Spark para recién graduados

Preguntas de entrevista de Spark para juniors

Preguntas de entrevista intermedias de Spark

Preguntas de entrevista de Spark para experimentados

Spark MCQ

¿Qué habilidades de Spark deberías evaluar durante la fase de entrevista?

3 consejos para usar las preguntas de entrevista de Spark

Contrata al mejor talento de Spark con pruebas de habilidades y preguntas de entrevista específicas

Descarga la plantilla de preguntas de entrevista de Spark en múltiples formatos

Preguntas de entrevista sobre Spark para recién graduados

1. ¿Qué es Spark, en términos sencillos?

Spark es un motor de procesamiento distribuido rápido y de propósito general para grandes conjuntos de datos. Piense en él como un motor súper rápido en memoria que puede procesar cantidades masivas de datos mucho más rápido que los sistemas tradicionales basados en disco como Hadoop MapReduce.

Proporciona APIs de alto nivel en lenguajes como Java, Scala, Python y R, lo que facilita a los desarrolladores escribir cálculos paralelos. Spark también incluye bibliotecas para SQL, aprendizaje automático (MLlib), procesamiento de gráficos (GraphX) y procesamiento de flujos (Structured Streaming), lo que permite una amplia gama de tareas de análisis de datos.

2. ¿Puede explicar qué son los conjuntos de datos distribuidos resilientes (RDD)?

Los conjuntos de datos distribuidos resilientes (RDD) son la estructura de datos fundamental de Apache Spark. Son una colección de datos inmutable y distribuida que se particiona en un clúster de máquinas, lo que permite el procesamiento en paralelo. Los RDD son resilientes porque si se pierde una partición de datos, se puede volver a calcular a partir del grafo de linaje (la secuencia de transformaciones que creó el RDD).

Las características clave de los RDD incluyen:

- Inmutabilidad: Una vez creados, los RDD no se pueden cambiar. Los nuevos RDD se crean a través de transformaciones.

- Distribuidos: Los datos se distribuyen en múltiples nodos en un clúster.

- Resilientes: Tolerantes a fallos; la pérdida de datos se gestiona automáticamente.

- Soporte para varios tipos de datos y operaciones como

map,filteryreducepara el procesamiento de datos.

3. ¿Cuáles son las características clave de Spark que lo hacen popular?

La popularidad de Spark se deriva de varias características clave. Principalmente, su velocidad es un atractivo importante, que se logra a través del cálculo en memoria y los planes de ejecución optimizados. Es significativamente más rápido que MapReduce tradicional para muchas cargas de trabajo.

Además, Spark ofrece facilidad de uso, con APIs disponibles en Scala, Java, Python y R. Su motor unificado soporta diversas tareas de procesamiento de datos, incluyendo procesamiento por lotes, procesamiento de flujo, aprendizaje automático (MLlib) y procesamiento de grafos (GraphX). Spark también cuenta con tolerancia a fallos, recuperándose automáticamente de errores. Finalmente, se integra bien con diversas fuentes y formatos de datos (HDFS, AWS S3, Cassandra, etc.)

4. ¿En qué se diferencia Spark de Hadoop MapReduce?

Spark y Hadoop MapReduce son frameworks de procesamiento distribuido, pero difieren significativamente en cómo manejan el procesamiento de datos. MapReduce está basado en disco; lee datos del disco, los procesa y escribe la salida de vuelta al disco en cada etapa de un trabajo. Esto lo hace tolerante a fallos pero más lento.

Spark, por otro lado, es un motor de procesamiento en memoria. Intenta mantener los datos en memoria tanto como sea posible, reduciendo el número de operaciones de entrada/salida (I/O) de disco. Esto hace que Spark sea mucho más rápido que MapReduce para algoritmos iterativos y tareas de minería de datos. Spark también ofrece APIs más ricas para la manipulación de datos (por ejemplo, DataFrames, Datasets) y soporta procesamiento en tiempo real, algo que MapReduce no tiene de forma nativa. Aquí están las diferencias clave:

- Velocidad: Spark es generalmente más rápido debido al procesamiento en memoria.

- Almacenamiento de datos: MapReduce se basa en gran medida en la entrada/salida de disco; Spark minimiza la entrada/salida de disco.

- APIs: Spark proporciona APIs más ricas y fáciles de usar (Scala, Python, Java, R).

- Procesamiento en tiempo real: Spark soporta procesamiento en tiempo real; MapReduce es principalmente para procesamiento por lotes.

5. ¿Cuál es el papel del Spark Driver?

El Spark Driver es el coordinador central de una aplicación Spark. Sus roles principales incluyen:

- Mantener el estado de la aplicación: El proceso del driver realiza un seguimiento del estado de la aplicación Spark durante todo su ciclo de vida.

- Crear SparkContext: Crea el

SparkContext, que representa la conexión al clúster Spark. - Negociación de recursos: El driver negocia con el administrador del clúster (por ejemplo, YARN, Mesos, Standalone) para asignar recursos (ejecutores) para la aplicación.

- Programación de tareas: El driver divide la aplicación en tareas y las programa para que se ejecuten en los ejecutores. Analiza el DAG (Grafo Acíclico Dirigido) de las operaciones y optimiza el plan de ejecución.

- Monitoreo de tareas: Monitorea la ejecución de las tareas en los ejecutores y gestiona cualquier fallo o reintento.

- Comunicación con el ejecutor: El driver se comunica con los ejecutores para enviarles tareas y recibir los resultados.

- Ejecución del código del usuario: En última instancia, el proceso del driver ejecuta el código de la aplicación del usuario que define los trabajos de Spark.

6. ¿Qué son los ejecutores de Spark y qué hacen?

Los ejecutores de Spark son nodos de trabajo en un clúster de Spark que ejecutan las tareas que el controlador de Spark les asigna. Cada ejecutor se ejecuta en su propia Máquina Virtual Java (JVM). Los ejecutores son responsables de:

- Ejecutar tareas: Ejecutan el código real para un trabajo de Spark. Estas tareas son la unidad más pequeña de trabajo en Spark.

- Almacenamiento en caché de datos: Los ejecutores pueden almacenar datos en caché en la memoria o en el disco, lo que acelera las operaciones posteriores.

- Informar el estado: Los ejecutores informan el estado de las tareas al controlador de Spark.

- Almacenamiento de datos: Los ejecutores también pueden almacenar datos cuando se les indica que lo hagan a través de las operaciones

persist()ocache().

7. ¿Puede describir una transformación de Spark? Dé un ejemplo.

Una transformación de Spark es una función que crea un nuevo RDD a partir de un RDD existente. Las transformaciones son perezosas, lo que significa que no se ejecutan inmediatamente. En cambio, Spark realiza un seguimiento de las transformaciones aplicadas a un RDD y las ejecuta solo cuando se llama a una acción. Esto permite a Spark optimizar el plan de ejecución y evitar cálculos innecesarios.

Por ejemplo, map() es una transformación. Aplica una función a cada elemento de un RDD y devuelve un nuevo RDD que contiene los resultados. Aquí hay un ejemplo simple:

rdd = sc.parallelize([1, 2, 3, 4]) squared_rdd = rdd.map(lambda x: x * x) # squared_rdd contendrá [1, 4, 9, 16] pero la transformación no se ha aplicado hasta que se llama a una acción como collect().

8. ¿Qué es una acción de Spark? ¿En qué se diferencia de una transformación?

Una acción de Spark activa el cálculo en un RDD de Spark (conjunto de datos distribuido resiliente). Fuerza la ejecución de las transformaciones definidas anteriormente. Las acciones devuelven un valor al programa del controlador o escriben datos en el almacenamiento externo.

Las acciones se diferencian de las transformaciones en que las transformaciones son operaciones perezosas que crean un nuevo RDD a partir de uno existente pero no se ejecutan inmediatamente. Solo definen un plan de lo que se debe hacer. Las acciones, por otro lado, son el catalizador que inicia este plan. Ejemplos comunes de acciones incluyen collect(), count(), first(), take(), reduce() y saveAsTextFile().

9. ¿Qué es la evaluación perezosa en Spark y por qué es importante?

La evaluación perezosa en Spark significa que Spark retrasa la ejecución de las transformaciones hasta que se llama a una acción. En lugar de ejecutar las transformaciones inmediatamente, Spark construye un Grafo Acíclico Dirigido (DAG) de operaciones. Este DAG representa todo el flujo de trabajo. Las transformaciones solo se activan cuando una acción (como collect(), count(), saveAsTextFile()) requiere que Spark calcule un resultado.

Esto es importante porque permite a Spark optimizar todo el plan de ejecución. Spark puede reordenar las transformaciones, combinarlas o incluso omitir pasos innecesarios para mejorar la eficiencia. También permite a Spark evitar el procesamiento de datos hasta que sea absolutamente necesario, ahorrando recursos de cómputo. Por ejemplo, considere dos transformaciones: map() seguido de filter(). Con la evaluación perezosa, Spark podría combinarlas en un solo paso durante la ejecución real, en lugar de realizarlas por separado.

10. Explique el concepto de partición en Spark.

La partición en Spark es dividir los datos en un RDD (Resilient Distributed Dataset) lógicamente en fragmentos más pequeños. Cada partición reside en un nodo del clúster, lo que permite el procesamiento paralelo. Las operaciones de Spark se ejecutan en cada partición simultáneamente, mejorando el rendimiento y la escalabilidad.

Aspectos clave de la partición:

- Localidad de datos: Spark se esfuerza por colocar las particiones cerca de la fuente de datos para minimizar la transferencia de datos.

- Paralelismo: Permite realizar cálculos en diferentes particiones simultáneamente.

- Ajuste del rendimiento: La partición adecuada es crucial para optimizar el rendimiento de la aplicación Spark, incluida la repartición y la coalescencia.

- Los métodos

repartition()ycoalesce()se utilizan para la repartición.

11. ¿Cuáles son las diferentes formas de crear RDDs?

Los RDD (Resilient Distributed Datasets) se pueden crear en Spark utilizando varios métodos:

- De una colección existente: Puedes paralelizar una colección existente en tu programa controlador usando

sparkContext.parallelize(colección). Esto es útil para probar o crear RDDs pequeños. - De conjuntos de datos externos: Puedes crear RDDs a partir de datos almacenados en sistemas de almacenamiento externos como HDFS, S3, bases de datos u otros formatos de archivo.

sparkContext.textFile(path)se usa comúnmente para leer archivos de texto. Hay otros métodos específicos para otros tipos de archivo. - Transformando RDDs existentes: Usando transformaciones como

map,filter,reduceByKey, etc., puedes crear nuevos RDDs a partir de los existentes. Esta es la forma más común de construir tuberías de procesamiento de datos. Por ejemplo:

existing_rdd.map(lambda x: x * 2)

12. ¿Qué es el almacenamiento en caché en Spark y cómo puede mejorar el rendimiento?

El almacenamiento en caché en Spark es un mecanismo para almacenar datos intermedios (RDDs, DataFrames o Datasets) en memoria o en disco a través de las operaciones. Esto evita volver a calcular los mismos datos varias veces, lo que puede ser un cuello de botella significativo en algoritmos iterativos o cuando los datos se reutilizan en múltiples etapas de una aplicación Spark.

El almacenamiento en caché mejora el rendimiento al:

- Reducción del tiempo de cálculo: Los datos se recuperan de la caché en lugar de volver a calcularse.

- Reducción de la entrada/salida de disco: Los datos se pueden mantener en la memoria, evitando costosas lecturas de disco.

- Permitir algoritmos iterativos más rápidos: Algoritmos como los modelos de aprendizaje automático que refinan iterativamente sus parámetros se benefician enormemente de la caché de los datos de entrenamiento. Los datos se pueden almacenar en caché utilizando funciones como

.cache()o.persist(). Por ejemplo:val cachedData = someRDD.cache()

13. Describa el propósito del método persist() en Spark.

El método persist() en Spark se utiliza para almacenar en caché RDDs (Resilient Distributed Datasets) o DataFrames en la memoria o en el disco. Por defecto, Spark calcula los RDDs/DataFrames cada vez que se llama a una acción sobre ellos. Esto puede ser ineficiente si el mismo RDD/DataFrame se utiliza varias veces. persist() evita el recálculo almacenando el RDD/DataFrame después de su primer cálculo.

Llamar a persist() es una indicación a Spark de que planea reutilizar el RDD/DataFrame, por lo que Spark lo mantendrá en la memoria para un acceso más rápido durante las operaciones posteriores. Puede especificar un nivel de almacenamiento utilizando la clase StorageLevel (por ejemplo, MEMORY_ONLY, DISK_ONLY, MEMORY_AND_DISK). Si no hay suficiente memoria, Spark volcará los datos al disco según el nivel de almacenamiento elegido. unpersist() se puede utilizar para eliminar manualmente el RDD/DataFrame de la caché.

14. ¿Cuáles son los beneficios de usar Spark SQL?

Spark SQL ofrece varios beneficios, incluyendo:

- Acceso Unificado a Datos: Proporciona una única interfaz para consultar diversas fuentes de datos como Hive, Parquet, JSON y bases de datos JDBC. Esto simplifica la integración y el análisis de datos.

- Compatibilidad SQL: Permite a los usuarios familiarizados con SQL interactuar fácilmente con los datos de Spark utilizando la sintaxis SQL estándar o la API DataFrame. Esto reduce la curva de aprendizaje.

- Optimización del Rendimiento: Aprovecha las capacidades de procesamiento distribuido de Spark y el optimizador Catalyst para mejorar significativamente el rendimiento de las consultas en comparación con los sistemas de bases de datos tradicionales. Incluye características como la optimización basada en costos y la generación de código.

- Integración con el Ecosistema Spark: Se integra a la perfección con otros componentes de Spark como Spark Streaming y MLlib, lo que permite construir tuberías de datos integrales.

- Escalabilidad: Se escala fácilmente para manejar grandes conjuntos de datos y consultas complejas a través de un clúster de máquinas.

- API DataFrame: Ofrece una forma programática de interactuar con los datos, proporcionando seguridad de tipos y la capacidad de realizar transformaciones de datos complejas.

- Funciones Definidas por el Usuario (UDFs): Admite la creación de funciones personalizadas que se pueden usar en consultas SQL, extendiendo la funcionalidad de Spark SQL.

15. ¿Cómo se pueden leer datos de un archivo CSV en Spark?

En Spark, se pueden leer datos de un archivo CSV usando el método spark.read.csv(). Este método devuelve un DataFrame, que es una colección distribuida de datos organizada en columnas con nombre.

Para leer un archivo CSV, se puede usar el siguiente código:

from pyspark.sql import SparkSession # Crea una SparkSession spark = SparkSession.builder.appName("ReadCSV").getOrCreate() # Lee el archivo CSV en un DataFrame df = spark.read.csv("path/to/your/file.csv", header=True, inferSchema=True) # Muestra el DataFrame df.show()

path/to/your/file.csv: Reemplace esto con la ruta real a su archivo CSV. Puede ser una ruta local o una ruta en un sistema de archivos distribuido como HDFS.header=True: Especifica que la primera fila del archivo CSV contiene los nombres de las columnas.inferSchema=True: Permite a Spark inferir automáticamente los tipos de datos de las columnas basándose en los datos del archivo CSV. Si bien es conveniente, para cargas de trabajo de producción, es mejor definir el esquema explícitamente para el rendimiento y la consistencia. Puede definir un esquema así:

from pyspark.sql.types import StructType, StructField, StringType, IntegerType schema = StructType([ StructField("name", StringType(), True), StructField("age", IntegerType(), True) ]) df = spark.read.csv("path/to/your/file.csv", schema=schema)

16. ¿Qué es un DataFrame en Spark?

En Spark, un DataFrame es una colección distribuida de datos organizada en columnas con nombre. Es conceptualmente similar a una tabla en una base de datos relacional o un DataFrame en Pandas (Python) o R. Los DataFrames le permiten estructurar sus datos, lo que permite operaciones como filtrado, agrupación y unión utilizando el motor SQL de Spark.

Las características clave de los DataFrames de Spark incluyen: inferencia de esquema, optimización a través de Catalyst, y soporte para varias fuentes de datos como JSON, CSV, Parquet y más. Los DataFrames proporcionan una API de alto nivel que simplifica la manipulación y el análisis de datos en un entorno distribuido, soportando lenguajes como Scala, Java, Python y R.

17. ¿Qué es un SparkSession?

Un SparkSession es el punto de entrada a la funcionalidad de Spark. Es la interfaz unificada para interactuar con los diversos componentes de Spark. Proporciona una forma de crear DataFrames, registrar DataFrames como tablas, ejecutar consultas SQL, acceder a SparkContext e interactuar con varias fuentes de datos.

Piense en él como el objeto maestro que necesita para comenzar cualquier aplicación Spark. Esencialmente combina SparkContext, SQLContext y HiveContext (donde esté disponible) en un único objeto. Para crear un SparkSession, normalmente se utiliza la API SparkSession.builder.

18. ¿Cómo se escribe un DataFrame en un archivo Parquet?

Para escribir un DataFrame en un archivo Parquet, normalmente se utiliza un DataFrameWriter proporcionado por bibliotecas como Apache Spark o pandas (con extensiones como pyarrow). Aquí hay un ejemplo general usando Spark:

dataframe.write.parquet("ruta/al/archivo/parquet")

Este comando guarda el DataFrame en la ruta especificada en formato Parquet. También puede especificar opciones como códecs de compresión. Por ejemplo, dataframe.write.option("compression", "snappy").parquet("path/to/parquet/file") utilizará la compresión Snappy.

19. Explique en qué consiste una aplicación Spark.

Una aplicación Spark consiste en un programa controlador (Driver program) y un conjunto de procesos ejecutores (Executor processes). El programa controlador mantiene el SparkContext, que coordina la ejecución de la aplicación. Define las transformaciones y acciones sobre los datos. Los procesos ejecutores se ejecutan en nodos de trabajo en el clúster y son responsables de ejecutar las tareas asignadas por el controlador.

Específicamente, involucra estos componentes:

- SparkContext: El punto de entrada a la funcionalidad de Spark. Representa la conexión a un clúster Spark.

- RDDs (Conjuntos de datos distribuidos resilientes): Estructura de datos fundamental de Spark. Colección de datos inmutable y distribuida.

- Transformaciones: Operaciones que crean nuevos RDD a partir de los existentes (por ejemplo,

map,filter). Son perezosas (lazy). - Acciones: Operaciones que desencadenan el cálculo y devuelven un valor al programa controlador (por ejemplo,

count,collect). - Ejecutores: Agentes distribuidos que ejecutan tareas. Cada ejecutor se ejecuta en su propia JVM.

20. ¿Cuáles son los pasos básicos para enviar una aplicación Spark?

- Empaqueta tu aplicación: Agrupa tu código y dependencias en un archivo JAR (para Java/Scala) o un archivo

.py/zip (para Python). - Prepara el entorno Spark: Asegúrate de que Spark esté instalado y configurado correctamente en el clúster o la máquina local donde planeas ejecutar la aplicación.

- Usa

spark-submit: Esta es la herramienta principal para lanzar aplicaciones Spark. Especificarás varios parámetros como el archivo JAR/Python de la aplicación, la URL del maestro, el modo de despliegue (clúster o cliente), la memoria del ejecutor, el número de núcleos y cualquier argumento específico de la aplicación. - Monitoriza la aplicación: Después del envío, Spark proporciona interfaces de usuario web para monitorizar el progreso y el uso de recursos de tu aplicación. Revisa los registros para detectar errores o cuellos de botella en el rendimiento.

21. ¿Cuál es la diferencia entre las transformaciones `map` y `flatMap`?

Tanto map como flatMap son transformaciones utilizadas para aplicar una función a cada elemento de una colección. La diferencia clave radica en cómo manejan los resultados de la aplicación de la función.

map aplica una función a cada elemento y devuelve una nueva colección que contiene los resultados. Si la función devuelve una colección en sí misma, map resultará en una colección de colecciones. Por el contrario, flatMap aplana la colección resultante de colecciones en una sola colección. En esencia, flatMap aplica una función que devuelve una colección y luego concatena todas las colecciones resultantes en una. flatMap se usa comúnmente para evitar colecciones anidadas cuando se trabaja con transformaciones que producen múltiples valores para cada valor de entrada.

22. Describe un escenario donde usarías la transformación filter.

Usaría la transformación filter cuando necesito procesar selectivamente elementos de una colección basándome en una condición específica. Por ejemplo, imagina que tengo una lista de objetos de clientes y quiero crear una nueva lista que contenga solo los clientes que han realizado una compra en el último mes.

clientes = [{'nombre': 'Alicia', 'última_compra': '2024-01-15'}, {'nombre': 'Bob', 'última_compra': '2024-03-20'}, {'nombre': 'Carlos', 'última_compra': '2024-03-25'}] import datetime fecha_límite = datetime.date.today() - datetime.timedelta(days=30) clientes_recientes = filter(lambda c: datetime.datetime.strptime(c['última_compra'], '%Y-%m-%d').date() >= fecha_límite, clientes) lista_clientes_recientes = list(clientes_recientes) print(lista_clientes_recientes) # Output: [{'nombre': 'Carlos', 'última_compra': '2024-03-25'}]

En este escenario, filter me permite crear eficientemente un subconjunto de la lista original de clientes que cumple con mis criterios, sin modificar la lista original.

23. ¿Qué hace la transformación `groupByKey`?

La transformación groupByKey en Spark agrupa los elementos de un RDD en función de la clave. Toma un RDD de pares clave-valor (K, V) y devuelve un nuevo RDD de (K, Iterable). Esencialmente, mezcla todos los valores para cada clave en un solo reductor.

Consideraciones importantes:

groupByKeypuede ser costoso debido a la mezcla de todos los datos a través de la red.- Puede provocar errores de falta de memoria si una clave tiene una gran cantidad de valores.

- A menudo se prefieren alternativas como

reduceByKeyoaggregateByKeypara un mejor rendimiento, ya que realizan alguna agregación en el lado del mapeador antes de mezclar.

24. ¿Qué entiende sobre el shuffle en Spark?

Shuffle en Spark es un proceso de redistribución de datos entre particiones de forma distribuida. Esto ocurre cuando los datos de diferentes particiones de entrada deben combinarse o agregarse, como en operaciones como groupByKey, reduceByKey, join y repartition. La operación de shuffle implica la transferencia de datos a través de la red entre los nodos ejecutores, lo que la convierte en una de las operaciones más costosas en Spark en términos de rendimiento.

Durante una barajadura (shuffle), los datos se escriben primero en el disco en el lado del mapeador (la tarea que produce los datos). Luego, los ejecutores en el lado del reductor (la tarea que consume los datos) obtienen los datos necesarios de los mapeadores. Este proceso implica la serialización, la deserialización y la entrada/salida de red (I/O). Debido a su sobrecarga, es crucial optimizar las operaciones de barajadura minimizando la cantidad de datos barajados. Técnicas como el uso de mapPartitions y variables de difusión (broadcast) pueden ayudar a reducir o evitar las barajaduras cuando sea posible.

25. Si su trabajo de Spark se ejecuta lentamente, ¿qué son algunas de las cosas iniciales que podría verificar?

Si mi trabajo de Spark se ejecuta lentamente, algunas comprobaciones iniciales incluirían:

- Sesgo de datos: La distribución desigual de datos entre las particiones puede provocar que algunas tareas tarden significativamente más que otras. Compruebe el sesgo examinando las duraciones de las tareas en la interfaz de usuario de Spark. La repartición, la salazón o el uso de técnicas como

reduceByKeycon particionadores personalizados pueden ayudar a mitigar esto. - Recursos insuficientes: Asegúrese de que el clúster de Spark tenga suficientes recursos de CPU y memoria asignados para el trabajo. Supervise la utilización de recursos en la interfaz de usuario de Spark o en las herramientas de gestión del clúster (por ejemplo, YARN, Kubernetes) y ajuste el número de ejecutores, los núcleos por ejecutor y la memoria del ejecutor según sea necesario.

- Código ineficiente: Examine el código de la aplicación Spark para detectar posibles cuellos de botella de rendimiento. Busque reorganizaciones innecesarias, agregaciones grandes u operaciones que podrían optimizarse. Utilice

explain()para analizar el plan de ejecución de la consulta. El almacenamiento en caché de DataFrames/Datasets a los que se accede con frecuencia mediante.cache()o.persist()también puede mejorar el rendimiento. - Serialización: Compruebe el método de serialización que se está utilizando. La serialización Kryo suele ser más rápida y compacta que la serialización Java. Configure Spark para usar la serialización Kryo usando

spark.serializer=org.apache.spark.serializer.KryoSerializer. - Demasiados archivos pequeños: Si los datos de entrada consisten en una gran cantidad de archivos pequeños, puede generar una sobrecarga excesiva. Consolide los archivos pequeños en archivos más grandes antes de procesarlos.

- Configuración de Spark: Revise otros parámetros de configuración de Spark como

spark.default.parallelismpara asegurarse de que estén configurados adecuadamente para el tamaño del clúster y la carga de trabajo.

26. ¿Cómo puedes monitorear el progreso de un trabajo de Spark?

Puedes monitorear el progreso de un trabajo de Spark usando varios métodos:

- Spark UI: Esta interfaz web (normalmente accesible en el puerto 4040 del nodo del driver) proporciona información detallada sobre la ejecución del trabajo, incluyendo etapas, tareas, ejecutores, almacenamiento y entorno. Es la forma más común y completa de monitorear los trabajos de Spark.

- Spark History Server: Para trabajos completados, el Spark History Server proporciona una vista persistente de la Spark UI. Esto es útil para analizar el rendimiento de trabajos pasados.

- Sistema de métricas: Spark expone métricas que se pueden recopilar y monitorear utilizando sistemas de monitoreo externos como Prometheus, Graphite o Ganglia. Esto permite la monitorización y alerta en tiempo real.

- Logging: Spark registra información detallada sobre la ejecución del trabajo, lo cual puede ser útil para depurar y solucionar problemas. Puedes configurar el nivel de logging y el destino de salida utilizando

log4j.properties. - Monitoreo programático: Puedes usar la API de Spark para monitorear programáticamente el progreso del trabajo. Por ejemplo, puedes escuchar eventos como

SparkListenerJobStart,SparkListenerJobEnd,SparkListenerStageCompleted, etc., y luego mostrar información de progreso.

27. ¿Cuál es el propósito de usar acumuladores en Spark?

Los acumuladores en Spark se utilizan para proporcionar una variable de solo escritura que se puede actualizar eficientemente en paralelo en los nodos de trabajo. Están diseñados específicamente para acumular valores, como contadores o sumas, durante la ejecución de trabajos de Spark. Esto permite el seguimiento de estadísticas globales o la agregación de información que de otra manera sería difícil o ineficiente de recopilar. Solo el programa del controlador puede acceder al valor del acumulador.

Esencialmente, los acumuladores ayudan en la depuración y la comprensión del comportamiento de un cálculo distribuido al proporcionar información sobre cómo se procesan los datos en todo el clúster. Son particularmente útiles para implementar contadores (similares a los contadores de MapReduce) o para acumular sumas de valores distribuidos en los ejecutores en el clúster de Spark. Ejemplo de caso de uso: val myCounter = spark.sparkContext.longAccumulator("Mi Contador").

28. ¿Puede explicar brevemente cómo Spark maneja la tolerancia a fallos?

Spark logra la tolerancia a fallos principalmente a través de Conjuntos de Datos Distribuidos Resilientes (RDDs) y su linaje. Los RDDs rastrean la secuencia de transformaciones aplicadas para crearlos. Si se pierde una partición de un RDD (debido a una falla del nodo), Spark puede reconstruirla reproduciendo las transformaciones en el gráfico de linaje, comenzando con los datos originales. Este proceso se conoce como recompilación de datos. El checkpointing también se puede usar para truncar el gráfico de linaje guardando RDDs intermedios en almacenamiento estable, reduciendo el tiempo de recompilación.

Además, Spark utiliza técnicas como la replicación de datos (persistencia de copias de las particiones de RDD en múltiples nodos) para minimizar la pérdida de datos. El programa del controlador de Spark también admite modos de alta disponibilidad, lo que permite que el controlador se reinicie en caso de falla, asegurando aún más la resiliencia de las aplicaciones de Spark. El DAGScheduler ayuda con la recuperación de trabajos en caso de fallas durante la ejecución del trabajo.

Preguntas de entrevista de Spark para principiantes

1. ¿Qué es Spark, en términos muy simples?

Spark es un motor de procesamiento distribuido rápido y de propósito general para grandes conjuntos de datos. Piense en ello como una versión sobrealimentada de MapReduce. Le permite procesar enormes cantidades de datos mucho más rápido que los métodos tradicionales.

En lugar de escribir datos en el disco después de cada paso (como MapReduce), Spark mantiene los datos en la memoria, lo que lo hace mucho más rápido para algoritmos iterativos y transformaciones de datos complejas. Ofrece APIs en lenguajes como Python, Scala, Java y R, haciéndolo accesible a una amplia gama de desarrolladores. Spark se utiliza comúnmente para el procesamiento de big data, el aprendizaje automático y el análisis de datos en tiempo real.

2. ¿Puede explicar la diferencia entre Spark y Hadoop?

Spark y Hadoop son ambos frameworks de procesamiento de big data, pero difieren en su enfoque. Hadoop utiliza principalmente MapReduce, que implica escribir datos en el disco después de cada etapa de procesamiento, lo que lo hace adecuado para conjuntos de datos grandes y procesamiento por lotes. Spark, por otro lado, realiza el procesamiento de datos en memoria, lo que lleva a una ejecución significativamente más rápida, especialmente para algoritmos iterativos y análisis en tiempo real. Sin embargo, el procesamiento en memoria de Spark puede estar limitado por la RAM disponible.

Esencialmente, Hadoop es un sistema de almacenamiento (HDFS) y procesamiento (MapReduce) distribuido. Spark puede ejecutarse sobre Hadoop (usando YARN para la gestión de recursos y HDFS para el almacenamiento) o de forma independiente. Spark ofrece un conjunto más rico de herramientas que incluyen Spark SQL, Spark Streaming, MLlib (aprendizaje automático) y GraphX (procesamiento de grafos), mientras que el núcleo de Hadoop es MapReduce. Spark se prefiere a menudo por su velocidad y facilidad de uso, mientras que Hadoop es mejor para conjuntos de datos muy grandes donde la rentabilidad y la tolerancia a fallos son cruciales.

3. ¿Cuál es el papel de un controlador de Spark?

El controlador de Spark es el proceso principal en una aplicación Spark. Sus funciones principales incluyen:

- Coordinar y gestionar la ejecución de trabajos de Spark: Es responsable de traducir el código del usuario en tareas de Spark y distribuir estas tareas a los ejecutores de Spark. Se comunica con el gestor de clúster (por ejemplo, YARN, Mesos o el gestor de clúster independiente de Spark) para asignar recursos a los ejecutores.

- Mantener el estado de la aplicación: El controlador realiza un seguimiento del estado de la aplicación Spark, incluyendo el DAG (Grafo Acíclico Dirigido) de operaciones, la ubicación de las particiones de datos y el estado de los ejecutores.

- Proporcionar el SparkContext: El

SparkContextse crea en el controlador y proporciona el punto de entrada a toda la funcionalidad de Spark. Permite crear RDD (Conjuntos de Datos Distribuidos Resilientes), que son la abstracción de datos fundamental en Spark.

4. ¿Qué son las transformaciones de Spark?

Las transformaciones de Spark son operaciones en RDDs (Resilient Distributed Datasets) que crean nuevos RDDs. Las transformaciones son perezosas, lo que significa que no se ejecutan inmediatamente. En cambio, Spark recuerda la secuencia de transformaciones aplicadas a un RDD, y solo se ejecutan cuando se llama a una acción.

Algunas transformaciones comunes de Spark incluyen:

map(): Aplica una función a cada elemento del RDD.filter(): Devuelve un nuevo RDD que contiene solo los elementos que satisfacen una condición dada.flatMap(): Similar amap(), pero cada elemento de entrada puede asignarse a cero o más elementos de salida (mediante la devolución de una secuencia).groupByKey(): Agrupa los valores para cada clave en el RDD en una sola secuencia.reduceByKey(): Fusiona los valores para cada clave utilizando una función de reducción especificada.union(): Devuelve un nuevo RDD que contiene todos los elementos de ambos RDDs.join(): Realiza una unión interna entre dos RDDs.

rdd = sc.parallelize([1, 2, 3, 4, 5]) squared_rdd = rdd.map(lambda x: x * x) #transformación result = squared_rdd.collect() #acción print(result)

5. Dé ejemplos de acciones de Spark.

Las acciones de Spark activan la ejecución de un gráfico de linaje RDD (DAG) de Spark para devolver un valor al programa del controlador o escribir datos en almacenamiento externo. Algunos ejemplos comunes incluyen:

collect(): Devuelve todos los elementos del RDD como una matriz al programa del controlador. Úselo con precaución en conjuntos de datos grandes, ya que puede causar problemas de memoria en el controlador.count(): Devuelve el número de elementos en el RDD.first(): Devuelve el primer elemento del RDD.take(n): Devuelve los primeros n elementos del RDD.reduce(func): Agrega los elementos del RDD usando una función func (que toma dos argumentos y devuelve uno).saveAsTextFile(path): Guarda el RDD en un archivo de texto en un directorio dado.

6. ¿Qué es un RDD en Spark y cómo funciona?

Un RDD (Conjunto de Datos Distribuidos Resistente) es la estructura de datos fundamental de Spark. Es una colección de datos inmutable y distribuida que se particiona en múltiples nodos en un clúster, lo que permite el procesamiento paralelo. Los RDD admiten dos tipos de operaciones:

- Transformaciones: Estas operaciones crean nuevos RDDs a partir de los existentes (por ejemplo,

map,filter,reduceByKey). Las transformaciones son perezosas, lo que significa que no se ejecutan inmediatamente. En cambio, Spark construye un gráfico de linaje de transformaciones. - Acciones: Estas operaciones desencadenan el cálculo del RDD y devuelven un valor al programa controlador (por ejemplo,

count,collect,saveAsTextFile). Cuando se llama a una acción, Spark recorre el gráfico de linaje, optimiza el plan de ejecución y ejecuta las transformaciones necesarias en paralelo en todo el clúster.

7. ¿Cómo se puede crear un RDD?

Los RDDs (Conjuntos de Datos Distribuidos Resilientes) se pueden crear de varias maneras en Spark. Los dos métodos más comunes son:

- Desde una colección existente: Puede crear un RDD a partir de una colección (como una lista) ya presente en su programa controlador usando

sparkContext.parallelize(colección). Esto distribuye los datos en todo el clúster. - Desde un conjunto de datos externo: Puede crear un RDD a partir de datos almacenados en fuentes externas como un sistema de archivos (por ejemplo, HDFS, sistema de archivos local), una base de datos o una API.

sparkContext.textFile(path)lee un archivo de texto y crea un RDD donde cada línea es un elemento.

De una lista

data = [1, 2, 3, 4, 5]

rdd_from_list = sparkContext.parallelize(data)

# De un archivo de texto

rdd_from_file = sparkContext.textFile("path/to/your/file.txt")

8. ¿Qué significa "cachear" un RDD y por qué lo harías?

"Cachear" un RDD significa almacenarlo en memoria o en disco después de su cálculo inicial. Esto evita volver a calcular el RDD cada vez que se utiliza en operaciones posteriores. La evaluación perezosa de Spark significa que las transformaciones no se ejecutan hasta que se llama a una acción. Sin el almacenamiento en caché, el grafo de linaje de la fuente de datos original se reevaluaría para cada acción realizada en el RDD. Se cachea un RDD llamando a rdd.cache() o rdd.persist(StorageLevel.MEMORY_ONLY).

9. ¿Qué es un Spark DataFrame?

Un Spark DataFrame es una colección distribuida de datos organizada en columnas con nombre. Es conceptualmente similar a una tabla en una base de datos relacional o a un DataFrame en pandas de Python. Los DataFrames le permiten estructurar sus datos y luego realizar operaciones en ellos utilizando consultas tipo SQL o funciones de la API de DataFrame.

Las características clave incluyen: aplicación de esquema, lo que significa que cada columna tiene un tipo de datos especificado; procesamiento distribuido a través de un clúster; y optimización a través del optimizador Catalyst de Spark, que mejora automáticamente el rendimiento de las consultas. La capacidad de manejar conjuntos de datos estructurados y semiestructurados convierte a los DataFrames en una herramienta poderosa en Spark. Puede crear DataFrames a partir de varias fuentes, incluidos archivos de datos estructurados, tablas en Hive, bases de datos externas o RDD (Conjuntos de Datos Distribuidos Resistentes) existentes.

10. ¿En qué se diferencia un DataFrame de un RDD?

Los RDD (Resilient Distributed Datasets) son los bloques de construcción fundamentales de Spark, que representan una colección de datos distribuida e inmutable. Ofrecen control y flexibilidad detallados, particularmente para transformaciones de datos complejas.

Los DataFrames, por otro lado, se construyen sobre los RDD y proporcionan una abstracción de nivel superior, similar a las tablas en las bases de datos relacionales. Las diferencias clave incluyen:

- Schema (Esquema): Los DataFrames tienen un esquema, que proporciona estructura y permite la ejecución optimizada de consultas a través del optimizador Catalyst de Spark.

- Optimización: Los DataFrames se benefician de la optimización automática de consultas, lo que lleva a mejoras significativas en el rendimiento en muchas tareas comunes de procesamiento de datos.

- Tipos de datos: Los DataFrames manejan datos estructurados y semiestructurados de manera más eficiente, ofreciendo un mejor soporte para varios tipos de datos y funciones integradas.

- API: Los DataFrames ofrecen una API fácil de usar con sintaxis similar a SQL, lo que facilita su uso para el análisis y la manipulación de datos.

11. ¿Puede explicar Spark SQL?

Spark SQL es un módulo de Spark para el procesamiento de datos estructurados. Proporciona una interfaz de programación, llamada DataFrames, que son colecciones distribuidas de datos organizados en columnas con nombre. Spark SQL le permite consultar datos utilizando SQL o una API de DataFrame en Python, Java, Scala y R.

Las características clave incluyen:

- API de DataFrame: Le permite trabajar con datos de una manera más estructurada.

- Interfaz SQL: Le permite consultar datos utilizando sentencias SQL.

- Conectividad de fuente de datos: Admite la lectura y escritura de datos desde varias fuentes como Hive, bases de datos JDBC, Parquet, JSON y más.

- Ejecución optimizada: Utiliza el optimizador Catalyst de Spark para mejorar el rendimiento de las consultas.

- Integración con el ecosistema Spark: Se integra a la perfección con otros componentes de Spark como Spark Streaming y MLlib.

12. ¿Cuáles son los beneficios de usar Spark SQL?

Spark SQL ofrece varios beneficios clave. Proporciona una interfaz unificada para consultar datos de diversas fuentes como Parquet, JSON, Hive y bases de datos relacionales utilizando SQL o la API DataFrame. Esta abstracción simplifica el acceso e integración de datos. Spark SQL optimiza las consultas utilizando el optimizador Catalyst, lo que puede mejorar significativamente el rendimiento en comparación con los enfoques tradicionales de MapReduce.

Además, permite una integración fluida con otros componentes de Spark como Spark Streaming y MLlib, lo que permite construir tuberías de datos de extremo a extremo para análisis en tiempo real y aprendizaje automático. Su capacidad para procesar datos estructurados y semiestructurados de manera eficiente lo convierte en una herramienta versátil para el almacenamiento de datos, la ciencia de datos y las aplicaciones de inteligencia empresarial. El uso de una interfaz SQL común también reduce la barrera de entrada para los analistas de datos que ya están familiarizados con SQL.

13. ¿Qué es un SparkContext?

Un SparkContext es el punto de entrada a cualquier funcionalidad de Spark. Representa una conexión a un clúster de Spark y se puede usar para crear RDDs, acumuladores y variables de difusión. Piense en ello como el controlador del programa del controlador al clúster de Spark; coordina la ejecución de la aplicación.

Utiliza el objeto SparkConf para obtener los parámetros necesarios para enviar la aplicación Spark al clúster. Solo un SparkContext puede estar activo por JVM. Debe stop() el SparkContext activo antes de crear uno nuevo.

14. ¿Por qué necesitamos SparkContext?

SparkContext es el punto de entrada a cualquier funcionalidad de Spark. Representa la conexión a un clúster de Spark y puede usarse para crear RDDs, acumuladores y variables de difusión. Piense en ello como el controlador del programa del controlador al clúster de Spark.

Esencialmente, se necesita para:

- Conectarse al administrador del clúster de Spark (por ejemplo, Standalone, YARN, Mesos).

- Coordinar la ejecución de trabajos de Spark en el clúster.

- Proporcionar acceso a la API de Spark (por ejemplo,

sc.textFile(),sc.parallelize()).

15. ¿Cuál es la diferencia entre `map` y `flatMap` en Spark?

Tanto map como flatMap son transformaciones en Spark que aplican una función a cada elemento de un RDD. La diferencia clave reside en la salida de la función.

map aplica una función a cada elemento y devuelve un nuevo RDD con los resultados. La salida de la función corresponde directamente a un solo elemento en el nuevo RDD. Por el contrario, flatMap aplica una función a cada elemento, pero la función puede devolver una secuencia (por ejemplo, una lista o matriz) de cero, uno o múltiples elementos. flatMap luego aplana esta secuencia en un solo RDD. Esto es útil cuando desea transformar cada elemento de entrada en múltiples elementos de salida. Aquí hay un fragmento de código en pyspark:

rdd = sc.parallelize(["hola mundo", "cómo estás"]) map_rdd = rdd.map(lambda x: x.split()) # Resultado: [['hola', 'mundo'], ['cómo', 'estás']] flatmap_rdd = rdd.flatMap(lambda x: x.split()) # Resultado: ['hola', 'mundo', 'cómo', 'estás']

16. ¿Qué es un clúster Spark?

Un clúster Spark es un sistema de computación distribuida que permite procesar grandes conjuntos de datos en paralelo. Consiste en un nodo controlador (el maestro) que coordina las tareas y los nodos de trabajo que ejecutan esas tareas. Estos nodos de trabajo son los recursos de cómputo donde ocurre el procesamiento de datos real.

Los clústeres Spark se pueden implementar de varias maneras, incluyendo el modo independiente, YARN y Mesos. Cada opción de implementación tiene diferentes capacidades de gestión de recursos. El programa controlador divide la aplicación en etapas y tareas, y las programa en los nodos de trabajo para la ejecución en paralelo, lo que permite un procesamiento de datos más rápido que los enfoques de una sola máquina.

17. ¿Puedes nombrar algunos componentes de un clúster Spark?

Un clúster Spark comprende varios componentes clave que trabajan juntos para procesar datos en paralelo. Estos componentes incluyen:

- Programa del controlador: La aplicación principal que coordina la ejecución de trabajos Spark.

- Administrador de clúster: Asigna recursos a la aplicación Spark. Los administradores de clúster comunes son: Standalone, YARN y Mesos.

- Nodos de trabajo: Máquinas en el clúster que ejecutan las tareas asignadas por el controlador. Cada nodo de trabajo tiene ejecutores.

- Ejecutores: Procesos que se ejecutan en nodos de trabajo y ejecutan las tareas. Proporcionan almacenamiento en memoria para el almacenamiento en caché de datos.

- SparkContext: Representa la conexión a un clúster Spark y se puede usar para crear RDDs, acumuladores y variables de difusión en ese clúster.

- RDD (Conjunto de datos distribuidos resilientes): Estructura de datos fundamental de Spark; una colección distribuida inmutable de datos.

18. ¿Cuál es el propósito de un ejecutor de Spark?

Un ejecutor de Spark es un proceso de trabajo que ejecuta cálculos y almacena datos en un nodo del clúster. Su propósito principal es ejecutar tareas asignadas por el controlador de Spark. Piense en ello como el músculo de la aplicación Spark.

Específicamente, un ejecutor:

- Ejecuta tareas (unidades de trabajo) en particiones de datos.

- Almacena los resultados calculados en la memoria o en el disco (almacenamiento en caché).

- Proporciona almacenamiento de datos en memoria para RDDs o DataFrames (cuando el almacenamiento en caché está habilitado).

- Informa el estado de la tarea (éxito, fracaso) al controlador.

- Cada ejecutor se ejecuta en su propio proceso JVM.

19. ¿Qué es la evaluación perezosa en Spark?

La evaluación perezosa en Spark es una técnica de optimización donde Spark retrasa la ejecución de las transformaciones hasta que se llama a una acción. En lugar de ejecutar transformaciones inmediatamente, Spark crea un Gráfico Acíclico Dirigido (DAG) de transformaciones. Este DAG representa todo el flujo de trabajo.

El beneficio de la evaluación perezosa es que Spark puede optimizar todo el flujo de trabajo antes de la ejecución. Esto incluye combinar múltiples transformaciones en una sola etapa, filtrar datos al principio del proceso para reducir la cantidad de datos procesados y elegir el plan de ejecución más eficiente. Esencialmente, Spark solo calcula el resultado cuando es absolutamente necesario (cuando se activa una acción), lo que potencialmente ahorra una cantidad significativa de tiempo y recursos de procesamiento.

20. ¿Por qué Spark utiliza la evaluación perezosa?

Spark emplea la evaluación perezosa principalmente para la optimización. Al retrasar la ejecución de las transformaciones hasta que se llama a una acción, Spark puede analizar todo el gráfico de transformación y optimizarlo. Esto permite técnicas como la canalización de transformaciones (por ejemplo, la combinación de múltiples operaciones map) y la evitación del procesamiento innecesario de datos. Por ejemplo, si filtra un conjunto de datos y luego solo usa una pequeña porción, Spark no procesará todo el conjunto de datos antes de filtrar.

Específicamente, la evaluación perezosa permite:

- Optimización: Spark puede reordenar y combinar operaciones para mayor eficiencia.

- Cálculo reducido: Las operaciones solo se realizan cuando se necesitan sus resultados.

- Tolerancia a fallos: Permite el recálculo de particiones perdidas al rastrear el gráfico de linaje, lo que garantiza la recuperación de datos en caso de fallos.

21. ¿Qué es una partición de Spark?

Una partición de Spark es la unidad más pequeña de distribución de datos en Spark. Representa un fragmento de datos dentro de un RDD (Resilient Distributed Dataset) o DataFrame de Spark que reside en un solo nodo del clúster. Spark distribuye los datos en particiones para permitir el procesamiento en paralelo.

Cada partición es procesada por una sola tarea. Spark tiene como objetivo crear una partición para cada núcleo en el clúster, maximizando así el paralelismo. El número de particiones impacta en el nivel de paralelismo logrado durante los cálculos. Puede controlar el número de particiones utilizando métodos como repartition() o coalesce().

22. ¿Cómo ayuda la partición en Spark?

La partición en Spark es una técnica de optimización crucial. Implica dividir los datos en fragmentos más pequeños y manejables llamados particiones. Estas particiones se distribuyen luego entre diferentes nodos en el clúster de Spark, lo que permite el procesamiento en paralelo. Esto acelera drásticamente los cálculos, especialmente para conjuntos de datos grandes, ya que diferentes nodos pueden trabajar en diferentes particiones simultáneamente, evitando cuellos de botella de un solo punto.

Los beneficios incluyen:

- Paralelismo: Las tareas se ejecutan simultáneamente en diferentes particiones.

- Tolerancia a fallos: Si una partición falla, solo esa partición necesita ser recalculada, no todo el conjunto de datos.

- Rendimiento mejorado: Reduce la sobrecarga de transferencia de datos y permite un procesamiento de datos eficiente al procesar datos más cerca de donde se almacenan (localidad de datos).

23. ¿Cómo se puede especificar el número de particiones al crear un RDD?

Puede especificar el número de particiones al crear un RDD de varias maneras:

-

Al crear un RDD a partir de un archivo utilizando

textFile(),hadoopFile()o métodos similares, puede pasar un argumento opcionalminPartitionspara especificar el número mínimo de particiones. Spark puede crear más particiones de las especificadas, pero no creará menos. -

Al crear un RDD a partir de una colección existente utilizando

sc.parallelize(), puede pasar un segundo argumento que especifique el número de particiones. Por ejemplo:

data = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10] rdd = sc.parallelize(data, numSlices=4)

Aquí, numSlices determina el número de particiones.

- Puede reparticionar un RDD existente utilizando los métodos

repartition(numPartitions)ocoalesce(numPartitions).repartitionmezcla los datos, asegurando una distribución uniforme entre las particiones, mientras quecoalesceintenta minimizar el movimiento de datos y debe usarse cuando se reduce el número de particiones.

24. ¿Qué es la serialización de datos en Spark?

La serialización de datos en Spark es el proceso de convertir objetos de datos a un formato que se puede almacenar o transmitir fácilmente a través de una red. Esto es crucial porque Spark opera en un entorno distribuido donde los datos deben moverse entre diferentes nodos. La serialización asegura que los datos se puedan transferir y reconstruir eficientemente en el extremo receptor.

Spark utiliza la serialización para optimizar el almacenamiento y la transferencia de datos durante varias operaciones, como la mezcla de datos entre ejecutores, el almacenamiento en caché de RDD/DataFrames en memoria o en disco y la persistencia de datos en sistemas de almacenamiento. Elegir el método de serialización correcto puede impactar significativamente el rendimiento de las aplicaciones Spark. Las bibliotecas de serialización comunes utilizadas incluyen la serialización Java, la serialización Kryo y estrategias de serialización personalizadas. Kryo suele ser preferido a la serialización Java debido a su velocidad y eficiencia.

25. ¿Por qué es importante la serialización de datos para el rendimiento de Spark?

La serialización de datos es crucial para el rendimiento de Spark porque Spark opera con datos distribuidos en un clúster. La serialización es el proceso de convertir objetos de datos a un formato que se puede transmitir fácilmente a través de la red y almacenar en disco. Sin una serialización eficiente, Spark sufriría una sobrecarga significativa durante la mezcla y la persistencia de datos.

Específicamente, impacta estas áreas:

- Transferencia de red: La reducción del tamaño de los datos serializados minimiza el uso del ancho de banda de la red durante las mezclas (por ejemplo,

groupByKey,reduceByKey). - E/S de disco: Los datos serializados más pequeños resultan en operaciones de lectura/escritura más rápidas al persistir RDD en disco (por ejemplo, usando

cache()opersist(MEMORY_AND_DISK_SER)). - Uso de memoria: Los datos serializados compactos permiten que Spark quepa más datos en la memoria, lo que reduce la probabilidad de volcado en disco, lo cual es mucho más lento. Spark generalmente utiliza

serialización Javaoserialización Kryo:Kryoes más rápido y más compacto, pero requiere el registro de clases.

26. ¿Cuáles son algunos formatos de datos comunes con los que Spark puede trabajar?

Spark puede trabajar con una variedad de formatos de datos. Algunos comunes incluyen:

- Archivos de texto: Datos de texto plano, a menudo procesados línea por línea.

- JSON: Un formato ampliamente utilizado para datos estructurados.

- CSV: Valores separados por comas, un formato común para datos tabulares.

- Parquet: Un formato de almacenamiento columnar optimizado para consultar grandes conjuntos de datos.

- ORC: Otro formato de almacenamiento columnar, similar a Parquet, diseñado para Hadoop.

- Avro: Un sistema de serialización de datos orientado a filas.

- SequenceFile: Un formato de archivo binario específico de Hadoop.

- Bases de datos relacionales: Spark puede conectarse y leer datos de bases de datos como MySQL, PostgreSQL, etc., usando JDBC.

Spark proporciona soporte integrado para muchos de estos formatos, y puedes usar bibliotecas o conectores externos para trabajar con otros. Por ejemplo, leyendo un archivo CSV:

df = spark.read.csv("ruta/al/archivo.csv", header=True, inferSchema=True)

27. ¿Cuál es la diferencia entre `persist` y `cache` en Spark?

`cache()\ y \persist()\ en Spark se utilizan para almacenar RDDs, DataFrames o Datasets en memoria o en disco para acelerar los cálculos posteriores. \cache()\ es esencialmente una abreviatura de \persist(MEMORY_ONLY)`, lo que significa que almacena los datos solo en memoria. Si no hay suficiente memoria, Spark volverá a calcular las particiones según sea necesario.

persist() ofrece más control ya que permite especificar diferentes niveles de almacenamiento utilizando la clase StorageLevel. Esto incluye opciones como MEMORY_ONLY, DISK_ONLY, MEMORY_AND_DISK, con y sin serialización, y con diferentes factores de replicación. persist() brinda flexibilidad para elegir la estrategia de almacenamiento basada en el tamaño de los datos, las limitaciones de memoria y los requisitos de tolerancia a fallos.

28. ¿Puede describir una situación en la que podría usar Spark en un escenario del mundo real?

Imagine una gran empresa de comercio electrónico que quiere analizar los patrones de compra de los clientes para mejorar las recomendaciones y las campañas de marketing. Tienen terabytes de datos de transacciones almacenados en un sistema distribuido. Spark sería ideal para esto.

Podríamos usar Spark para procesar este conjunto de datos masivo en paralelo. Por ejemplo, podríamos calcular:

- Artículos comprados con frecuencia: Utilizando algoritmos de minería de reglas de asociación disponibles en la biblioteca MLlib de Spark.

- Segmentación de clientes: Agrupando a los clientes en función de su comportamiento de compra utilizando k-means u otros algoritmos de clustering.

- Análisis predictivo: Construyendo modelos para predecir compras futuras utilizando las capacidades de aprendizaje automático de Spark. Los datos analizados mejorarán la experiencia del cliente y proporcionarán datos para campañas de marketing dirigidas y gestión de inventario.

29. ¿Cuáles son algunas ventajas de usar Spark sobre otros frameworks de procesamiento de datos?

Spark ofrece varias ventajas sobre otros frameworks de procesamiento de datos. Principalmente, sus capacidades de procesamiento en memoria conducen a velocidades de ejecución significativamente más rápidas, especialmente para algoritmos iterativos y transformaciones complejas. También es compatible con múltiples lenguajes de programación como Python, Java, Scala y R, lo que proporciona flexibilidad para los desarrolladores con diferentes orígenes. El motor unificado de Spark maneja el procesamiento por lotes, el procesamiento de flujo, el aprendizaje automático y el procesamiento de gráficos, simplificando el desarrollo de tuberías de datos complejas.

Además, la capacidad de Spark para ejecutarse en varios administradores de clústeres como Hadoop YARN, Apache Mesos y Kubernetes lo hace fácilmente integrable en la infraestructura de datos existente. Su tolerancia a fallos, lograda a través de conjuntos de datos distribuidos resilientes (RDDs), garantiza la recuperación de datos en caso de fallos. Además, Spark SQL le permite consultar datos estructurados utilizando SQL o HiveQL, ampliando el acceso para los analistas de datos que se sienten cómodos con SQL.

Preguntas de entrevista intermedias sobre Spark

1. ¿Cómo se pueden optimizar los trabajos de Spark para minimizar la reorganización de datos (shuffling)?

Minimizar la reorganización de datos en los trabajos de Spark es crucial para el rendimiento. Se pueden emplear varias técnicas.

- Utilice variables de difusión: Difunda conjuntos de datos más pequeños a todos los nodos de trabajo para evitar enviar el conjunto de datos más grande a través de la red durante las uniones o transformaciones.

- Utilice la partición de forma eficaz: Asegúrese de que los datos estén particionados de forma adecuada en función de las claves utilizadas en las uniones o agregaciones. Use

repartition()ocoalesce()con cautela, entendiendo su impacto. Si los datos ya están particionados correctamente en la fuente, evite la repartición. Considere usarbucketBypara la pre-partición y la clasificación de datos en disco. - Utilice

mapPartitions(): En lugar demap(), que procesa los datos fila por fila,mapPartitions()le permite trabajar con una partición completa a la vez, lo que reduce el número de operaciones y potencialmente mejora la eficiencia. - Optimice las operaciones de unión: Si es posible, use

broadcastHashJoin(Spark podría hacer esto automáticamente para tablas pequeñas). Asegúrese de que las claves de unión sean del mismo tipo de datos. - Filtre temprano: Aplique filtros lo antes posible en la canalización de datos para reducir la cantidad de datos que deben ser barajados.

- Use acumuladores: Los acumuladores son útiles para actualizar valores de los ejecutores sin barajar.

- Almacenamiento en caché: Si se utilizan los mismos datos repetidamente, almacene en caché el RDD o DataFrame utilizando

cache()opersist(). Sin embargo, tenga en cuenta el uso de la memoria. - Evite

groupByKey()innecesario: PrefierareduceByKey()oaggregateByKey()ya que realizan la pre-agregación en cada partición antes de barajar los datos.

2. Explique la diferencia entre "narrow transformations" (transformaciones estrechas) y "wide transformations" (transformaciones anchas) y cómo afectan el rendimiento de Spark.

Las transformaciones estrechas en Spark son aquellas donde cada partición del RDD depende solo de una única partición del RDD padre. Ejemplos incluyen map, filter y union. Las transformaciones estrechas son muy eficientes porque permiten a Spark realizar una ejecución en tubería (pipelined execution), lo que significa que las transformaciones se pueden ejecutar en una sola etapa sin mezclar datos a través de la red. Esto también permite una tolerancia a fallos óptima, ya que una partición perdida se puede reconstruir a partir de una única partición padre.

Las transformaciones anchas, por otro lado, requieren datos de múltiples particiones del RDD padre para calcular las particiones del RDD hijo. groupByKey, reduceByKey y join son ejemplos. Estas transformaciones implican mezclar datos a través de la red, lo cual es una operación costosa en términos de tiempo y recursos. Además, las transformaciones anchas introducen dependencias de mezcla (shuffle dependencies), que crean etapas en el plan de ejecución de Spark. Si una etapa falla debido a fallos en los nodos, toda la etapa, incluido el proceso de mezcla, necesita ser recalculada, lo cual puede perjudicar significativamente el rendimiento.

3. Describe escenarios donde usarías acumuladores en Spark, y explica cómo funcionan.

Los acumuladores en Spark son útiles para agregar valores en todos los ejecutores y de vuelta al programa del controlador de forma tolerante a fallos. Los escenarios incluyen:

- Contadores: Rastrear el número de eventos, como errores, registros procesados o elementos omitidos durante el procesamiento de datos. Por ejemplo, contar registros mal formados al analizar un archivo de registro.

- Depuración: Observar el progreso de un trabajo de Spark incrementando un acumulador en varias etapas de una tubería de transformación. Esto permite rastrear cuántos registros pasan por cada etapa.

- Métricas personalizadas: Recopilar estadísticas personalizadas más allá de lo que Spark proporciona de forma predeterminada, como calcular la suma de valores específicos que cumplen ciertas condiciones durante el procesamiento.

Los acumuladores son de solo escritura desde los ejecutores; solo el controlador puede leer su valor final después de que el trabajo de Spark se completa. Los ejecutores realizan actualizaciones localmente, y Spark se encarga de agregar estas actualizaciones durante el trabajo. Ejemplo (Python):

sc = SparkContext.getOrCreate() error_count = sc.accumulator(0) def process_record(record): try: # Realizar lógica de procesamiento pass except Exception as e: error_count.add(1) rdd.foreach(process_record) print(f"Número de errores: {error_count.value}")

4. ¿Cuáles son las ventajas y desventajas de usar la variable Broadcast en Spark?

Las variables de transmisión en Spark ofrecen mejoras de rendimiento al permitir que las variables de solo lectura se almacenen en caché en cada máquina en lugar de enviarse con las tareas. Esto reduce el tráfico de red y los costos de serialización, especialmente para conjuntos de datos grandes que necesitan varias tareas. La principal ventaja es la reducción del tráfico de red y el uso de memoria en el nodo del controlador, lo que conduce a una ejecución más rápida del trabajo.

Sin embargo, existen desventajas. La creación de una variable de transmisión implica la serialización y la sobrecarga de distribución iniciales. Además, todos los ejecutores almacenan una copia de la variable de transmisión que puede consumir una cantidad significativa de memoria si la variable es grande, lo que podría provocar problemas de memoria o afectar el espacio disponible para el almacenamiento en caché de las particiones de datos. Además, dado que son de solo lectura, las actualizaciones requieren la creación de una nueva variable de transmisión, lo que puede ser ineficiente si los datos subyacentes cambian con frecuencia. Por lo tanto, el uso juicioso es importante, especialmente con grandes conjuntos de datos que se actualizan con poca frecuencia.

5. ¿Cómo se manejan los datos sesgados en Spark para evitar cuellos de botella de rendimiento?

Para manejar datos sesgados en Spark y evitar cuellos de botella de rendimiento, se pueden emplear varias estrategias. La salazón (Salting) es una técnica común. Agregamos un prefijo o sufijo aleatorio a la clave sesgada, lo que distribuye los datos de manera más uniforme entre las particiones. Esto evita que las particiones individuales se sobrecarguen durante las mezclas.

Otro método implica el uso de variables de transmisión para tablas de dimensiones más pequeñas. Esto evita la mezcla de grandes cantidades de datos al realizar uniones (joins). Además, el empleo de técnicas como el pre-filtrado y las agregaciones aproximadas puede reducir el volumen de datos antes de realizar operaciones costosas en los datos sesgados. Finalmente, considere el uso de la ejecución adaptativa de consultas (AQE), que Spark usa automáticamente para manejar particiones sesgadas. AQE puede detectar y dividir particiones sesgadas durante la ejecución de la consulta.

6. Explique el concepto del plan de ejecución de Spark. ¿Cómo lo analiza y optimiza?

El plan de ejecución de Spark, también conocido como el Grafo Acíclico Dirigido (DAG), representa la serie de transformaciones y acciones que Spark realizará para ejecutar un trabajo. Visualiza el flujo de datos y las operaciones involucradas, dividiendo el código de alto nivel en etapas y tareas. Analizar el plan de ejecución es crucial para la optimización del rendimiento. Puede verlo usando el método explain() en un DataFrame o RDD.

Para analizar y optimizar el plan de ejecución:

- Comprenda el DAG: Identifique las etapas, los shuffles (movimiento de datos) y el uso de recursos.

- Identifique los cuellos de botella: Busque etapas con una duración alta o una mezcla de datos excesiva.

- Optimice las transformaciones: Reordene las operaciones, use funciones más eficientes (por ejemplo,

reduceByKeyen lugar degroupBy) y evite los shuffles innecesarios. - Ajuste el particionamiento: Aumente o disminuya el número de particiones para optimizar el paralelismo.

- Almacene en caché los resultados intermedios: Use

cache()opersist()para evitar volver a calcular los datos. - Ajuste la configuración de Spark: Ajuste configuraciones como

spark.executor.memory,spark.executor.coresyspark.default.parallelism.

7. ¿Cómo maneja Spark la tolerancia a fallos y qué mecanismos existen para recuperarse de ellos?

Spark logra la tolerancia a fallos principalmente a través de los Conjuntos de Datos Distribuidos Resilientes (RDDs) y su linaje. Los RDDs rastrean las transformaciones aplicadas a ellos, formando un grafo de linaje. Si una partición de un RDD se pierde debido a una falla de un nodo, Spark puede reconstruir esa partición reproduciendo las transformaciones en el grafo de linaje a partir de los datos originales. Este proceso se llama recuperación basada en el linaje de datos.

Otros mecanismos incluyen:

- Checkpointing: Los RDDs se pueden persistir en el almacenamiento (por ejemplo, HDFS) para acortar los grafos de linaje y acelerar la recuperación, especialmente para algoritmos iterativos.

- Replicación de datos: Spark puede replicar datos en múltiples nodos para aumentar la disponibilidad de datos y reducir el impacto de las fallas de los nodos.

- Reintentos de tareas: Si una tarea falla, Spark la reintenta automáticamente en otro nodo.

- Redundancia del controlador: El programa del controlador, que coordina la aplicación Spark, puede hacerse tolerante a fallos utilizando un controlador en espera.

8. Describe los diferentes modos de implementación en Spark y cuándo elegirías cada uno.

- Modo local: Ejecuta Spark en una sola máquina, utilizando múltiples hilos para simular un clúster. Ideal para el desarrollo, pruebas y depuración, ya que no requiere una configuración de clúster. Sin embargo, no es adecuado para cargas de trabajo de producción.

- Modo autónomo: Un gestor de clústeres simple que viene incluido con Spark. Fácil de configurar y gestionar, es una buena opción para clústeres pequeños a medianos, o cuando no se necesitan las funciones avanzadas de gestores de clústeres más robustos.

- YARN (Yet Another Resource Negotiator): Aprovecha el gestor de recursos YARN de Hadoop. Esta es la opción más común en entornos Hadoop, ya que permite a Spark compartir recursos con otras aplicaciones YARN. Úselo cuando ya tiene un clúster Hadoop y quiere integrar Spark en él.

- Mesos: Otro gestor de clústeres que puede ejecutar Spark junto con otros frameworks como Hadoop MapReduce, MPI, etc. Ofrece un intercambio de recursos detallado y es adecuado para entornos multi-inquilino. Úselo cuando tenga un clúster Mesos y necesite ejecutar diversas cargas de trabajo.

- Kubernetes: Sistema de orquestación de contenedores que puede gestionar aplicaciones Spark. Esto se está volviendo cada vez más popular, especialmente en entornos en la nube, ofreciendo escalabilidad, aislamiento y facilidad de gestión a través de la contenerización. Úselo si está ejecutando Spark en Kubernetes o en un entorno en la nube que aprovecha Kubernetes.

9. ¿Cómo mejora el optimizador Catalyst de Spark el rendimiento de las consultas?

El optimizador Catalyst de Spark mejora significativamente el rendimiento de las consultas a través de una serie de optimizaciones basadas en reglas y en costos. Transforma un plan de consulta lógico en un plan de ejecución física más eficiente. Catalyst funciona en cuatro fases: Análisis, Optimización Lógica, Planificación Física y Generación de Código.

Algunas optimizaciones clave incluyen:

- Empuje de Predicados (Predicate Pushdown): Mover las condiciones de filtro más cerca de la fuente de datos para reducir la cantidad de datos procesados.

- Poda de Columnas (Column Pruning): Eliminar columnas innecesarias del plan de consulta para reducir el tamaño de los datos.

- Optimización Basada en Costos (CBO): Elegir el orden de unión más eficiente en función de las estadísticas de datos.

- Optimización Basada en Reglas (RBO): Aplicar un conjunto de reglas predefinidas para mejorar el plan de consulta, como la contracción de constantes o la simplificación de expresiones.

- Reordenamiento de Uniones (Join Reordering): Optimizar el orden en que se unen las tablas. Utiliza estadísticas para estimar el costo de diferentes órdenes de unión y selecciona el que tiene el costo más bajo.

- Por ejemplo, considere una consulta SQL:

SELECT * FROM tableA JOIN tableB ON tableA.id = tableB.id WHERE tableA.value > 10 - Catalyst podría aplicar primero el empuje de predicados, filtrando

tableAsolo a las filas dondevalue > 10antes de realizar la unión, reduciendo así la cantidad de datos que deben procesarse durante la unión.

- Por ejemplo, considere una consulta SQL:

10. ¿Cuál es el papel del Spark Driver y cómo se comunica con los ejecutores?

El Spark Driver es el corazón de una aplicación Spark. Es responsable de coordinar la ejecución de un trabajo de Spark. Sus roles principales incluyen:

- Gestión de trabajos: Convertir el código de la aplicación Spark en tareas y etapas, programando tareas para los ejecutores.

- Negociación de recursos: Comunicarse con el gestor de clúster (por ejemplo, YARN, Mesos o el gestor de clúster independiente de Spark) para solicitar recursos (CPU, memoria) para los ejecutores.

- Distribución de tareas: Enviar tareas a los ejecutores para su procesamiento.

- Recopilación de resultados: Recibir resultados de los ejecutores después de la finalización de la tarea.

- Mantenimiento del estado de la aplicación: Realizar un seguimiento del estado de la aplicación Spark, incluido el DAG (Gráfico acíclico dirigido) de operaciones y metadatos.

El Spark Driver se comunica con los ejecutores a través de un gestor de clúster. El driver negocia los recursos con el gestor de clúster, que luego lanza los ejecutores en los nodos de trabajo. El driver y los ejecutores se comunican a través de sockets TCP. El driver serializa las tareas y las envía a los ejecutores. Los ejecutores deserializan las tareas, las ejecutan y luego envían los resultados de vuelta al driver. La comunicación se realiza mediante protocolos como Akka.

11. ¿Cuándo elegirías persistir un RDD o DataFrame de Spark y cuáles son los diferentes niveles de almacenamiento disponibles?

Deberías persistir un RDD o DataFrame de Spark cuando planeas reutilizarlo varias veces en tu aplicación Spark. La persistencia evita la recomputación del RDD/DataFrame cada vez que se accede a él, lo que puede mejorar significativamente el rendimiento, especialmente para transformaciones costosas o algoritmos iterativos.

Los niveles de almacenamiento disponibles son:

MEMORY_ONLY: Almacena el RDD como objetos Java deserializados en la JVM. Si el RDD no cabe en la memoria, algunas particiones no se almacenarán en caché y se volverán a calcular sobre la marcha cada vez que se necesiten.MEMORY_AND_DISK: Almacena el RDD como objetos Java deserializados en la JVM. Si el RDD no cabe en la memoria, almacena las particiones en el disco y las lee del disco cuando se necesiten.DISK_ONLY: Almacena las particiones del RDD solo en el disco.MEMORY_ONLY_SER: Almacena el RDD como objetos Java serializados (un array de bytes por partición). Más eficiente en espacio queMEMORY_ONLY, pero más intensivo en CPU.MEMORY_AND_DISK_SER: Similar aMEMORY_ONLY_SER, pero vierte en el disco si el RDD no cabe en la memoria.OFF_HEAP: Similar aMEMORY_ONLY_SER, pero almacena los datos en memoria fuera del heap. La memoria está fuera de la JVM.MEMORY_ONLY_2,MEMORY_AND_DISK_2, etc.: Igual que los niveles anteriores, pero replica cada partición en dos nodos del clúster. Proporciona tolerancia a fallos.

12. Explica la diferencia entre las transformaciones `mapPartitions` y `map` en Spark. ¿Cuándo usarías cada una?

map y mapPartitions son transformaciones en Spark utilizadas para aplicar una función a los elementos del RDD. map aplica la función proporcionada a cada elemento del RDD individualmente, resultando en un nuevo RDD con los elementos transformados. Por el contrario, mapPartitions aplica la función a cada partición del RDD. La función recibe un iterador de los elementos dentro de la partición y devuelve un iterador de los elementos transformados.

Usarías mapPartitions cuando la transformación requiere realizar algunos pasos de configuración o inicialización que se pueden hacer una vez por partición en lugar de una vez por elemento, lo que lleva a optimizaciones de rendimiento. Ejemplos incluyen abrir una conexión a la base de datos o inicializar un modelo de aprendizaje automático. Si solo necesitas transformar elementos individuales sin ninguna configuración por partición, map es generalmente más apropiado y fácil de usar.

13. ¿Cómo supervisas el rendimiento de los trabajos de Spark e identificas posibles problemas?

Superviso el rendimiento de los trabajos de Spark utilizando varias herramientas y técnicas. La interfaz de usuario de Spark es mi principal recurso, proporcionando información detallada sobre etapas, tareas, ejecutores y utilización de recursos. Busco tareas de larga duración, distribuciones de datos sesgadas y shuffles ineficientes, que son cuellos de botella comunes en el rendimiento. También utilizo herramientas de monitoreo externas como Prometheus y Grafana para rastrear métricas a nivel de clúster, como CPU, memoria y uso de la red, para identificar restricciones de recursos que impactan los trabajos de Spark.

Para identificar posibles problemas, examino los registros de Spark en busca de errores y advertencias. Presto mucha atención al comportamiento de la recolección de basura, buscando pausas excesivas de GC que puedan afectar la latencia de los trabajos. También utilizo herramientas de perfilado para identificar puntos críticos en el código y optimizar el rendimiento. Además, configuro proactivamente alertas basadas en métricas clave para ser notificado de cualquier degradación del rendimiento o fallas en los trabajos. spark.eventLog.enabled y spark.history.fs.logDirectory son configuraciones clave para el registro y la depuración. Las herramientas de perfilado de código como Java Flight Recorder o Flame Graphs pueden ayudar.

14. Describa cómo Spark SQL interactúa con fuentes de datos estructurados como Hive o Parquet.

Spark SQL proporciona una interfaz unificada para interactuar con varias fuentes de datos estructurados, incluyendo Hive y Parquet. Para Hive, Spark SQL aprovecha el metastore de Hive para acceder a la información del esquema y los metadatos de la tabla. Utiliza el analizador de consultas y el optimizador de Hive para traducir las consultas SQL en trabajos de Spark. Spark puede entonces ejecutar estos trabajos, leyendo datos directamente del almacenamiento subyacente (como HDFS) donde residen las tablas de Hive.

Para Parquet, Spark SQL tiene soporte incorporado. Puede leer y escribir archivos Parquet directamente. Spark SQL utiliza la información del esquema y el formato de almacenamiento columnar de Parquet para un procesamiento de datos eficiente. Al consultar archivos Parquet, el optimizador de consultas de Spark puede aprovechar los metadatos de Parquet (como los valores min/máx. para las columnas) para realizar el pushdown de predicados, reduciendo la cantidad de datos que se deben leer.

15. ¿Cómo implementaría la partición personalizada en Spark para optimizar el procesamiento de datos?

Para implementar la partición personalizada en Spark, definiría una clase Partitioner personalizada que extiende org.apache.spark.Partitioner. Esta clase necesita anular dos métodos clave: numPartitions, que devuelve el número de particiones, y getPartition(key: Any), que determina el ID de la partición (un entero entre 0 y numPartitions - 1) para una clave determinada.