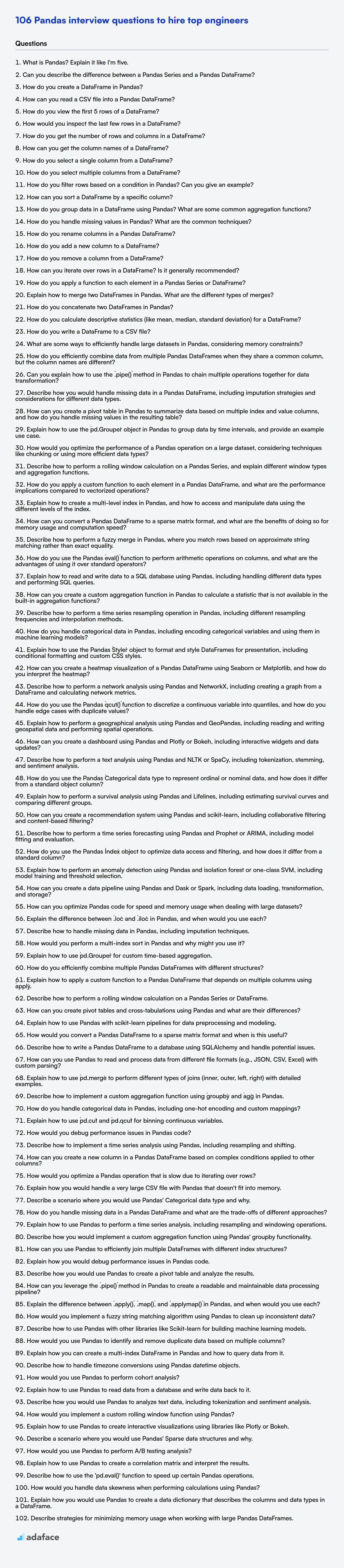

106 preguntas de entrevista sobre Pandas para contratar a los mejores ingenieros

Pandas es una biblioteca de análisis y manipulación de datos y se utiliza en varios roles laborales. Por lo tanto, identificar a los candidatos con las habilidades adecuadas en Pandas es fundamental para los reclutadores y gerentes de contratación que buscan formar equipos de datos competentes.

Esta publicación de blog proporciona una colección de preguntas de entrevista de Pandas categorizadas por nivel de dificultad, que van desde básico hasta experto, incluida una sección sobre preguntas de opción múltiple. Las preguntas están diseñadas para ayudarlo a evaluar la profundidad de conocimiento y las habilidades prácticas de un candidato en Pandas.

Al usar estas preguntas, puede asegurarse de que su próxima contratación tenga las habilidades para sobresalir; para la validación objetiva de habilidades, considere usar una prueba en línea de Python Pandas para evaluar a los candidatos antes de la entrevista.

Tabla de contenidos

Preguntas básicas de la entrevista de Pandas

Preguntas intermedias de la entrevista de Pandas

Preguntas avanzadas de la entrevista de Pandas

Preguntas de la entrevista de expertos de Pandas

Preguntas de opción múltiple de Pandas

¿Qué habilidades de Pandas debe evaluar durante la fase de la entrevista?

3 consejos para usar las preguntas de la entrevista de Pandas

Contrate a los mejores talentos de Pandas con pruebas de habilidades

Descarga la plantilla de preguntas de entrevista de Pandas en múltiples formatos

1. ¿Qué es Pandas? Explícalo como si tuviera cinco años.

Imagina que tienes una caja de juguetes llena de cosas diferentes, como coches, muñecas y bloques. Pandas es como una caja especial que te ayuda a organizar esos juguetes. Es como una hoja de cálculo, pero mucho más potente.

Pandas te ayuda a poner etiquetas a tus juguetes (columnas), como "Color" o "Tamaño", y a hacerles un seguimiento en filas. Es genial para contar cuántos coches rojos tienes o para encontrar el bloque más grande. Si los juguetes son datos, ¡Pandas es como magia para jugar con esos juguetes de una manera útil! Por ejemplo, digamos que tienes una lista de edades:

import pandas as pd ages = [5, 6, 5, 7, 6] age_series = pd.Series(ages) #Pandas al rescate print(age_series.mean())

Aquí pd.Series es un uso simple que convierte una lista básica de números en algo que Pandas puede usar. El .mean() calcula la edad promedio.

2. ¿Puedes describir la diferencia entre una Serie de Pandas y un DataFrame de Pandas?

Una Serie de Pandas es una matriz etiquetada unidimensional capaz de contener cualquier tipo de datos (enteros, cadenas, flotantes, objetos de Python, etc.). Piénsalo como una sola columna en una hoja de cálculo. Tiene un índice, que puede definirse explícitamente o, por defecto, es un índice numérico. Un DataFrame, por otro lado, es una estructura de datos etiquetada bidimensional con columnas de tipos potencialmente diferentes. Puedes pensarlo como una hoja de cálculo o una tabla SQL, o un dict de objetos Series. Tiene un índice de fila y de columna.

En esencia, un DataFrame es un contenedor de objetos Series. Cada columna en un DataFrame es una Serie. Por lo tanto, mientras que una Serie representa una sola columna de datos con un índice, un DataFrame representa una tabla de datos compuesta por múltiples Series que comparten el mismo índice.

3. ¿Cómo se crea un DataFrame en Pandas?

Puedes crear un DataFrame de Pandas de varias maneras:

- Desde un diccionario: Donde las claves se convierten en nombres de columnas y los valores (listas, arrays de NumPy, Series) se convierten en datos de columnas.

import pandas as pd data = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(data)

- Desde una lista de listas/tuplas: Especifica explícitamente los nombres de las columnas.

data = [[1, 3], [2, 4]] df = pd.DataFrame(data, columns=['col1', 'col2'])

-

Desde un array de NumPy: Similar a las listas de listas, especifica los nombres de las columnas.

-

Desde un archivo CSV: Usando

pd.read_csv() -

Desde otras fuentes: como bases de datos SQL, archivos JSON, etc.

4. ¿Cómo se puede leer un archivo CSV en un DataFrame de Pandas?

Puedes leer un archivo CSV en un DataFrame de Pandas utilizando la función pd.read_csv(). Esta función es parte de la biblioteca Pandas y está diseñada específicamente para analizar archivos CSV.

Para usarla, simplemente pasa la ruta del archivo (o un objeto similar a un archivo) a la función de la siguiente manera:

import pandas as pd df = pd.read_csv('your_file.csv') print(df)

Puedes especificar varios parámetros opcionales dentro de pd.read_csv() para manejar diferentes delimitadores, encabezados, codificaciones y otras características del archivo, como:

delimitador(osep): Especifica el carácter usado para separar los campos (por ejemplo,',','\t',';')encabezado: Indica el número de fila a usar como nombres de columna (por ejemplo,0para la primera fila,Nonesi no hay fila de encabezado).codificación: Especifica la codificación del archivo (por ejemplo,'utf-8','latin-1')index_col: Especifica qué columna usar como índice.

5. ¿Cómo se ven las primeras 5 filas de un DataFrame?

Para ver las primeras 5 filas de un DataFrame de Pandas, puedes usar el método .head(). Este método, por defecto, devuelve las primeras 5 filas.

df.head()

Si quieres ver un número diferente de filas, puedes pasar un argumento entero al método .head(), así:

df.head(10) # Ver las primeras 10 filas

6. ¿Cómo se inspeccionarían las últimas filas de un DataFrame?

Para inspeccionar las últimas filas de un DataFrame de Pandas, puedes usar el método .tail(). Por defecto, .tail() devuelve las últimas 5 filas. Puedes especificar el número de filas que quieres ver pasando un argumento entero al método.

Por ejemplo:

import pandas as pd # Asumiendo que 'df' es tu DataFrame last_10_rows = df.tail(10) print(last_10_rows)

7. ¿Cómo se obtiene el número de filas y columnas en un DataFrame?

Para obtener el número de filas y columnas en un DataFrame de Pandas, puedes usar el atributo .shape. Devuelve una tupla donde el primer elemento es el número de filas y el segundo elemento es el número de columnas.

Por ejemplo:

import pandas as pd datos = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(datos) filas, columnas = df.shape print(f"Filas: {filas}, Columnas: {columnas}")

8. ¿Cómo se pueden obtener los nombres de las columnas de un DataFrame?

Puede recuperar los nombres de las columnas de un DataFrame utilizando el atributo .columns. Este atributo devuelve un objeto Index que contiene los nombres de las columnas. Por ejemplo, en pandas, usaría df.columns para acceder a los nombres de las columnas del DataFrame df.

Para convertir los nombres de las columnas en una lista, puede usar df.columns.tolist(). Esto es útil si necesita iterar sobre los nombres de las columnas o realizar otras operaciones que requieran una estructura de datos de lista. La sintaxis se ve así:

nombres_columnas = df.columns.tolist() print(nombres_columnas)

9. ¿Cómo se selecciona una sola columna de un DataFrame?

Para seleccionar una sola columna de un DataFrame, puedes usar la notación de corchetes con el nombre de la columna como una cadena, así: df['nombre_columna']. Esto devuelve una Serie de pandas que contiene los datos de esa columna. Alternativamente, puedes usar la notación de punto si el nombre de la columna es un identificador de Python válido (es decir, sin espacios ni caracteres especiales), así: df.nombre_columna. Sin embargo, generalmente se prefiere usar la notación de corchetes, ya que funciona en todos los casos y es menos propensa a errores cuando los nombres de las columnas son complejos.

10. ¿Cómo se seleccionan múltiples columnas de un DataFrame?

Para seleccionar múltiples columnas de un DataFrame, puedes usar varios métodos. El enfoque más común es pasar una lista de nombres de columna dentro de corchetes [] al objeto DataFrame. Esto devolverá un nuevo DataFrame que contiene solo las columnas especificadas. Por ejemplo, si tienes un DataFrame llamado df y quieres seleccionar las columnas 'col1', 'col2' y 'col3', usarías df[['col1', 'col2', 'col3']].

Alternativamente, puedes usar el acceso .loc con una lista de nombres de columna. Por ejemplo: df.loc[:, ['col1', 'col2', 'col3']]. Los : indican que quieres seleccionar todas las filas. Este método es particularmente útil cuando necesitas combinar la selección de filas y columnas basada en etiquetas. Usar .iloc también es una opción si prefieres usar la posición del índice de las columnas: df.iloc[:, [0, 1, 2]].

11. ¿Cómo se filtran filas basadas en una condición en Pandas? ¿Puedes dar un ejemplo?

Para filtrar filas basadas en una condición en Pandas, puedes usar la indexación booleana. Esto implica crear una Serie booleana que tenga la misma longitud que el DataFrame, donde cada elemento indica si la fila correspondiente satisface la condición. Luego, usas esta Serie booleana para seleccionar las filas donde el valor es True.

Por ejemplo, si tiene un DataFrame df y desea seleccionar filas donde 'nombre_columna' es mayor que 10, haría lo siguiente:

filtered_df = df[df['nombre_columna'] > 10]

Esto crea un nuevo DataFrame, filtered_df, que contiene solo las filas que cumplen la condición especificada. Puede usar varios operadores de comparación (>, <, ==, !=, >=, <=) y operadores lógicos (&, |, ~) para crear condiciones más complejas.

12. ¿Cómo puede ordenar un DataFrame por una columna específica?

Puede ordenar un DataFrame por una columna específica usando el método sort_values() en pandas. Simplemente pase el nombre de la columna (o una lista de nombres de columna para la clasificación de varios niveles) al argumento by.

Por ejemplo:

df.sort_values(by='nombre_columna')

Esto ordena el DataFrame en orden ascendente basado en los valores de 'nombre_columna'. Para ordenar en orden descendente, establezca ascending=False:

df.sort_values(by='nombre_columna', ascending=False)

13. ¿Cómo se agrupan los datos en un DataFrame usando Pandas? ¿Cuáles son algunas funciones de agregación comunes?

En Pandas, puedes agrupar datos en un DataFrame usando el método groupby(). Este método divide el DataFrame en grupos basados en una o más columnas. Después de agrupar, puedes aplicar funciones de agregación a cada grupo.

Algunas funciones de agregación comunes incluyen:

sum(): Calcula la suma de los valores en cada grupo.mean(): Calcula la media de los valores en cada grupo.median(): Calcula la mediana de los valores en cada grupo.count(): Cuenta el número de valores en cada grupo.min(): Encuentra el valor mínimo en cada grupo.max(): Encuentra el valor máximo en cada grupo.std(): Calcula la desviación estándar de los valores en cada grupo.agg(): Te permite aplicar múltiples funciones de agregación a la vez, usando código como:

df.groupby('nombre_columna').agg(['sum', 'mean', 'count'])

14. ¿Cómo manejas los valores faltantes en Pandas? ¿Cuáles son las técnicas comunes?

Pandas ofrece varias formas de manejar los valores faltantes, típicamente representados como NaN (Not a Number - No es un Número). Las técnicas comunes incluyen:

- Identificación de Valores Faltantes:

isna()oisnull(): Detecta valores faltantes y devuelve una máscara booleana.notna()onotnull(): Inverso deisna()eisnull().

- Manejo de Valores Faltantes:

dropna(): Elimina filas o columnas que contienen valores faltantes. Puedes controlar el comportamiento con parámetros comoaxis(filas o columnas) yhow('any' o 'all').fillna(): Rellena los valores faltantes con un valor especificado (por ejemplo, media, mediana, constante) o utilizando métodos como relleno hacia adelante (ffill) o relleno hacia atrás (bfill).

- Imputación: Se pueden usar métodos más sofisticados para imputar valores faltantes, a menudo involucrando técnicas estadísticas o modelos de aprendizaje automático. Bibliotecas como

scikit-learnproporcionan herramientas para este propósito. Por ejemplo,SimpleImputerpuede reemplazar los valores faltantes con la media, la mediana o el valor más frecuente de la columna.

Por ejemplo:

df.dropna(axis=0) # Eliminar filas con cualquier valor NaN df['nombre_columna'].fillna(df['nombre_columna'].mean(), inplace=True) # Rellenar valores NaN en 'nombre_columna' con la media

15. ¿Cómo se renombran las columnas en un DataFrame de Pandas?

Puedes renombrar las columnas en un DataFrame de Pandas usando varios métodos:

df.rename(): Este es el método más versátil. Se pasa un diccionario donde las claves son los nombres de columna antiguos y los valores son los nombres de columna nuevos al argumentocolumns.df = df.rename(columns={'nombre_antiguo': 'nombre_nuevo', 'otro_nombre_antiguo': 'otro_nombre_nuevo'}). Para modificar el DataFrame en su lugar, usainplace=True.df.columns: Puedes asignar directamente una nueva lista de nombres de columna al atributodf.columns.df.columns = ['nueva_col1', 'nueva_col2', 'nueva_col3']. Este método requiere que proporciones una lista con la misma longitud que el número de columnas.df.set_axis(): Similar adf.columns, pero más general. Permite renombrar tanto filas como columnas usando el parámetroaxis. Para renombrar columnas:df = df.set_axis(['nueva_col1', 'nueva_col2'], axis='columns'). El parámetroinplacetambién se puede usar aquí.

16. ¿Cómo se agrega una nueva columna a un DataFrame?

Puedes agregar una nueva columna a un DataFrame de varias maneras. La más común es usando la notación de corchetes, similar a cómo agregarías una clave a un diccionario. Por ejemplo, en pandas, puedes asignar directamente una Serie (o un único valor) a un nuevo nombre de columna. Otra forma es usando el método assign(), que crea un nuevo DataFrame con la(s) columna(s) agregada(s) o modificada(s), dejando el DataFrame original intacto.

Por ejemplo, en pandas:

import pandas as pd # DataFrame de ejemplo data = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(data) # Agregar una nueva columna usando notación de corchetes df['new_col'] = [5, 6] # Agregar una nueva columna usando assign df = df.assign(another_col = [7,8])

17. ¿Cómo se elimina una columna de un DataFrame?

Puedes eliminar una columna de un DataFrame de Pandas de varias maneras. Los métodos principales son usar la palabra clave del, el método drop(), o reasignando el DataFrame sin la columna.

Aquí hay una breve descripción general:

- Palabra clave

del:del df['nombre_de_la_columna']- Esto modifica el DataFrame en su lugar. - Método

drop():df.drop('nombre_de_la_columna', axis=1)odf.drop(columns=['nombre_de_la_columna'])- Esto devuelve un nuevo DataFrame con la columna eliminada. Usainplace=Truepara modificar el DataFrame original. - Reasignación:

df = df.drop('nombre_de_la_columna', axis=1)- Asigna el resultado dedf.dropal dataframe original. Es lo mismo que arriba, excepto que sobrescribe de forma más explícita el dataframe inicial.

Ejemplo usando drop():

import pandas as pd data = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(data) df = df.drop('col1', axis=1) # o df.drop(columns=['col1']) print(df)

18. ¿Cómo se puede iterar sobre las filas en un DataFrame? ¿Es generalmente recomendable?

Puedes iterar sobre filas en un DataFrame de Pandas utilizando métodos como iterrows(), itertuples(), o accediendo directamente al array NumPy subyacente con .values. Sin embargo, iterar sobre las filas generalmente no se recomienda por razones de rendimiento, especialmente para DataFrames grandes.

Estos métodos son lentos en comparación con las operaciones vectorizadas usando funciones integradas de Pandas o NumPy. Para la mayoría de las tareas, debes tratar de usar operaciones vectorizadas, funciones apply, u otros métodos de Pandas/NumPy que operan en columnas o DataFrames completos a la vez. Por ejemplo:

- Operaciones vectorizadas:

df['nueva_columna'] = df['columna_a'] + df['columna_b'] - Función

apply():df['nueva_columna'] = df.apply(lambda fila: some_function(fila['columna_a'], fila['columna_b']), axis=1)

19. ¿Cómo se aplica una función a cada elemento de una Serie o DataFrame de Pandas?

Para aplicar una función a cada elemento de una Serie o DataFrame de Pandas, puedes usar los métodos apply() o map(). Para una Serie, map() está diseñado específicamente para transformaciones elemento por elemento usando una función o un objeto similar a un diccionario. apply() también se puede usar en Series y DataFrames para operaciones más complejas.

Para DataFrames, apply() se puede usar para aplicar una función a lo largo de un eje (filas o columnas). Para la aplicación elemento por elemento en un DataFrame, use applymap(). Aquí hay ejemplos:

- Series:

import pandas as pd s = pd.Series([1, 2, 3]) s_transformed = s.map(lambda x: x * 2) print(s_transformed)

- DataFrame:

import pandas as pd df = pd.DataFrame({'A': [1, 2], 'B': [3, 4]}) df_transformed = df.applymap(lambda x: x + 1) print(df_transformed)

20. Explique cómo fusionar dos DataFrames en Pandas. ¿Cuáles son los diferentes tipos de fusiones?

En Pandas, puede fusionar dos DataFrames usando la función pd.merge(). Combina DataFrames basándose en una columna o índice común, de forma similar a las uniones SQL. La sintaxis básica es pd.merge(left, right, how='inner', on='key'), donde left y right son los DataFrames, how especifica el tipo de fusión y on especifica la columna en la que fusionar. Si los nombres de las columnas son diferentes en los dos DataFrames, se pueden especificar left_on y right_on.

Los diferentes tipos de fusiones incluyen:

- Inner: (predeterminado) Devuelve solo las filas con claves coincidentes en ambos DataFrames.

- Outer: Devuelve todas las filas de ambos DataFrames, rellenando los valores faltantes con

NaN. - Left: Devuelve todas las filas del DataFrame izquierdo y las filas coincidentes del DataFrame derecho. Los valores faltantes del DataFrame derecho se rellenan con

NaN. - Right: Devuelve todas las filas del DataFrame derecho y las filas coincidentes del DataFrame izquierdo. Los valores faltantes del DataFrame izquierdo se rellenan con

NaN. - Cross: Realiza un producto cartesiano de las filas de ambos DataFrames, devolviendo todas las combinaciones. Ejemplo:

pd.merge(df1, df2, how='cross')

21. ¿Cómo se concatenan dos DataFrames en Pandas?

Se pueden concatenar dos DataFrames en Pandas usando la función pd.concat(). Esta función permite combinar DataFrames a lo largo de filas (verticalmente) o columnas (horizontalmente). La sintaxis básica es pd.concat([df1, df2]), que concatena df1 y df2 verticalmente.

Los parámetros clave incluyen:

objs: Una secuencia o mapeo de objetos Pandas como DataFrames o Series.axis: Especifica el eje a concatenar (0 para filas, 1 para columnas).join: Especifica cómo manejar los índices en otro eje (inner, outer).ignore_index: Si es verdadero, no use los valores de índice a lo largo del eje de concatenación. El eje resultante se etiquetará 0, ..., n - 1.

Por ejemplo:

import pandas as pd df1 = pd.DataFrame({'A': [1, 2], 'B': [3, 4]}) df2 = pd.DataFrame({'A': [5, 6], 'B': [7, 8]}) df_concatenated = pd.concat([df1, df2], ignore_index=True) print(df_concatenated)

22. ¿Cómo se calculan las estadísticas descriptivas (como la media, la mediana, la desviación estándar) para un DataFrame?

Para calcular las estadísticas descriptivas para un DataFrame (asumiendo que estamos usando pandas en Python), puedes usar varios métodos integrados. El más común es .describe(), que proporciona un resumen de las estadísticas para las columnas numéricas, incluyendo la cuenta, la media, la desviación estándar, el mínimo, el máximo y los cuartiles. Para estadísticas individuales:

- Media: Usa

.mean()en un DataFrame o Serie (columna).df['nombre_columna'].mean() - Mediana: Usa

.median().df['nombre_columna'].median() - Desviación Estándar: Usa

.std().df['nombre_columna'].std() - Otras funciones como

.min(),.max(),.count()y.quantile()también están disponibles para estadísticas específicas.

23. ¿Cómo se escribe un DataFrame en un archivo CSV?

Para escribir un DataFrame en un archivo CSV, normalmente usas un método proporcionado por la biblioteca DataFrame que estás utilizando (por ejemplo, Pandas en Python). Así es como lo harías con Pandas:

import pandas as pd data = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(data) df.to_csv('output.csv', index=False)

Puntos clave:

to_csv()es el método usado para escribir el DataFrame en un archivo CSV.- El primer argumento (por ejemplo,

'output.csv') especifica el nombre del archivo. index=Falseevita escribir el índice del DataFrame en el CSV.

24. ¿Cuáles son algunas formas de manejar eficientemente conjuntos de datos grandes en Pandas, considerando las limitaciones de memoria?

Para manejar eficientemente conjuntos de datos grandes en Pandas bajo restricciones de memoria, considere estas estrategias:

- Use

chunksizeal leer datos: Lea los datos en fragmentos más pequeños y manejables usando el parámetrochunksizeen funciones comopd.read_csv. Procese cada fragmento iterativamente, realizando agregaciones o transformaciones según sea necesario, y luego libere la memoria. Por ejemplo:

for chunk in pd.read_csv('archivo_grande.csv', chunksize=10000): # Procesa el fragmento procesar_fragmento(chunk)

-

Especifique

dtype: Defina explícitamente los tipos de datos para las columnas usando el parámetrodtypeenpd.read_csv. El uso de tipos de datos más pequeños (por ejemplo,int16en lugar deint64) puede reducir significativamente el uso de memoria. -

Seleccione solo las columnas necesarias: Lea solo las columnas necesarias para su análisis usando el parámetro

usecolsenpd.read_csv. -

Optimice los tipos de datos después de la lectura: Convierta las columnas a tipos de datos más eficientes en memoria utilizando funciones como

pd.to_numeric(downcast='integer')opd.to_datetime. También convierta los tipos de datosobjectacategorycuando sea apropiado para ahorrar espacio. -

Elimine datos innecesarios: Elimine los DataFrames o columnas intermedias que ya no son necesarios utilizando

deloDataFrame.drop()para liberar memoria. -

Use

inplace=True: Cuando sea posible, use el argumentoinplace=Trueen las operaciones de Pandas (por ejemplo,fillna,drop) para modificar el DataFrame directamente en lugar de crear una copia. -

Considerar bibliotecas alternativas: Para conjuntos de datos extremadamente grandes que exceden la memoria disponible, explore bibliotecas de computación fuera del núcleo como Dask o Vaex, que le permiten trabajar con datos que no caben completamente en la memoria.

Preguntas de entrevista intermedias de Pandas

1. ¿Cómo se combinan eficientemente los datos de múltiples DataFrames de Pandas cuando comparten una columna común, pero los nombres de las columnas son diferentes?

Para combinar eficientemente los datos de múltiples DataFrames de Pandas cuando comparten una columna común pero los nombres de las columnas son diferentes, primero debe renombrar las columnas comunes a un nombre consistente en todos los DataFrames. Puede lograr esto usando el método .rename() en Pandas. Después de renombrar, puede usar funciones como pd.concat(), pd.merge() o .join() para combinar los DataFrames. pd.concat() es útil para agregar DataFrames vertical u horizontalmente. pd.merge() se utiliza para uniones estilo base de datos basadas en la columna común. .join() es a menudo más rápido que pd.merge() al unir en índices o en una columna común.

Por ejemplo, si tienes df1 con la columna 'ID' y df2 con la columna 'CustomerID' que representan los mismos datos, harías df2 = df2.rename(columns={'CustomerID': 'ID'}) antes de fusionar. Luego, merged_df = pd.merge(df1, df2, on='ID', how='inner') para realizar una unión interna. El uso del argumento how apropiado asegura que solo se incluyan los registros requeridos en el resultado.

2. ¿Puedes explicar cómo usar el método `.pipe()` en Pandas para encadenar múltiples operaciones juntas para la transformación de datos?

El método .pipe() en Pandas te permite encadenar múltiples transformaciones de datos juntas de una manera más legible y organizada. En lugar de anidar múltiples llamadas a funciones o asignar resultados intermedios a variables, puedes pasar funciones (o objetos invocables) a .pipe() secuencialmente. Cada función recibe el DataFrame como entrada y devuelve un DataFrame transformado, que luego se pasa a la siguiente función en la cadena.

Por ejemplo, si tienes las funciones clean_data, feature_engineer y analyze_data, puedes encadenarlas usando .pipe() así: df.pipe(clean_data).pipe(feature_engineer).pipe(analyze_data). Esto mejora la legibilidad y el mantenimiento del código. También puedes reescribir las funciones como cadenas de métodos, lo que puede ser un mejor patrón para la reutilización. El código puede reescribirse como def clean_data(df): return df[...], donde la función clean_data ahora se puede aplicar al objeto dataframe a través de df.pipe(clean_data).

3. Describe cómo manejarías los datos faltantes en un DataFrame de Pandas, incluyendo estrategias de imputación y consideraciones para diferentes tipos de datos.

Manejar los datos faltantes en Pandas implica identificar y abordar los valores NaN. Primero, verificaría los datos faltantes usando df.isnull().sum() para entender la magnitud del problema. Consideraría eliminar filas o columnas con valores faltantes excesivos usando df.dropna(), teniendo en cuenta la posible pérdida de datos. Si los valores faltantes no son demasiados, consideraría estrategias de imputación que dependen del tipo de datos y el contexto.

Para datos numéricos, consideraría usar df.fillna(df.mean()) o df.fillna(df.median()) para la imputación de la media o la mediana, respectivamente. Para datos categóricos, df.fillna(df['columna'].mode()[0]) es apropiado para rellenar con el valor más frecuente. Técnicas de imputación más avanzadas, como el uso de sklearn.impute.SimpleImputer o modelos predictivos basados en otras columnas, podrían ser adecuadas en escenarios más complejos. Otra opción sería usar relleno hacia adelante o hacia atrás - df.fillna(method='ffill') o df.fillna(method='bfill'). Es esencial evaluar el impacto de la imputación en la distribución de los datos y cualquier análisis posterior.

4. ¿Cómo se puede crear una tabla dinámica en Pandas para resumir datos basados en múltiples columnas de índice y valor, y cómo se manejan los valores faltantes en la tabla resultante?

Puede crear una tabla dinámica en Pandas usando la función pivot_table(). Para resumir datos basados en múltiples columnas de índice, pase una lista de nombres de columna al parámetro index. De manera similar, para múltiples columnas de valor, pase una lista al parámetro values. Aquí hay un ejemplo:

import pandas as pd pivot_table = pd.pivot_table(data, values=['valor1', 'valor2'], index=['índice1', 'índice2'], aggfunc='sum')

Para manejar los valores faltantes en la tabla resultante, puedes usar el parámetro fill_value en pivot_table(). Esto reemplaza los valores NaN con un valor especificado (por ejemplo, 0). También puedes usar .fillna() en la tabla pivot resultante después de la creación para imputar valores faltantes usando varias estrategias (por ejemplo, media, mediana).

pivot_table = pd.pivot_table(data, values=['valor1', 'valor2'], index=['índice1', 'índice2'], aggfunc='sum', fill_value=0)

5. Explica cómo usar el objeto pd.Grouper en Pandas para agrupar datos por intervalos de tiempo, y proporciona un ejemplo de caso de uso.

El objeto pd.Grouper en Pandas proporciona una forma flexible de especificar la operación de agrupación, especialmente cuando se trata de datos de series temporales. Es particularmente útil cuando necesitas agrupar datos por intervalos de tiempo (por ejemplo, cada 5 minutos, diariamente, semanalmente). Normalmente lo usas dentro del método groupby() de un DataFrame o Serie de Pandas. Especificas la key (la columna por la que agrupar), la freq (la frecuencia de la agrupación), y opcionalmente axis (a lo largo de qué eje agrupar).

Por ejemplo, considera un DataFrame df con un DateTimeIndex. df.groupby(pd.Grouper(freq='D')).sum() agruparía los datos por día y calcularía la suma para cada grupo. freq puede ser cualquier cadena de frecuencia válida de Pandas (por ejemplo, 'D' para día, 'H' para hora, '5min' para 5 minutos, 'M' para mes). Alternativamente, puedes usar df.groupby(pd.Grouper(key='columna_fecha', freq='W')).mean() para agrupar por una columna de fecha específica llamada columna_fecha semanalmente.

6. ¿Cómo optimizarías el rendimiento de una operación de Pandas en un conjunto de datos grande, considerando técnicas como la división en fragmentos o el uso de tipos de datos más eficientes?

Para optimizar el rendimiento de Pandas en conjuntos de datos grandes, considere la segmentación. Lea los datos en piezas más pequeñas y manejables usando pd.read_csv(nombre_archivo, chunksize=...). Procese cada segmento de forma independiente y luego combine los resultados. Además, usar los tipos de datos correctos es crucial. Por ejemplo, convierta las cadenas a datos categóricos usando astype('category') si es apropiado, y use tipos enteros más pequeños como int16 o int8 en lugar de int64 cuando el rango de valores lo permita. Esto reduce el uso de memoria y acelera las operaciones. La vectorización es clave: evite los bucles y aplique operaciones en columnas/Series completas a la vez utilizando las funciones integradas de Pandas.

7. Describa cómo realizar un cálculo de ventana móvil en una Serie de Pandas y explique los diferentes tipos de ventana y funciones de agregación.

Para realizar un cálculo de ventana móvil en una Serie de Pandas, puede usar el método rolling(). Este método crea un objeto Rolling que le permite especificar el tamaño de la ventana. Después de crear el objeto Rolling, puede aplicar una función de agregación como mean(), sum(), min(), max() o std() para calcular la estadística móvil.

Los diferentes tipos de ventana incluyen:

- Ventana fija: Una ventana de tamaño constante que se desliza sobre los datos.

s.rolling(window=3).mean() - Ventana variable: Una ventana que cambia su tamaño según algún criterio, a menudo relacionado con el tiempo. Esto se puede lograr usando

groupbycon una función personalizada.

Las diferentes funciones de agregación incluyen:

mean(): Calcula la media de los valores dentro de la ventana.sum(): Calcula la suma de los valores dentro de la ventana.min(): Encuentra el valor mínimo dentro de la ventana.max(): Encuentra el valor máximo dentro de la ventana.std(): Calcula la desviación estándar de los valores dentro de la ventana.apply(func): Aplica una función personalizada a los valores dentro de la ventana. Por ejemplo:

import pandas as pd s = pd.Series([1, 2, 3, 4, 5, 6, 7, 8, 9, 10]) media_móvil = s.rolling(window=3).mean() print(media_móvil)

8. ¿Cómo se aplica una función personalizada a cada elemento en un DataFrame de Pandas y cuáles son las implicaciones de rendimiento en comparación con las operaciones vectorizadas?

Puedes aplicar una función personalizada a cada elemento en un DataFrame de Pandas usando el método .applymap(). Por ejemplo:

def funcion_personalizada(x): return x * 2 df.applymap(funcion_personalizada)

Si bien .applymap() es flexible, generalmente es más lento que las operaciones vectorizadas (por ejemplo, usar operadores como *, +, -, / directamente en las columnas/filas del DataFrame). Las operaciones vectorizadas están optimizadas para trabajar en matrices enteras a la vez, aprovechando los cálculos eficientes de NumPy. .applymap() itera elemento por elemento, lo que genera una sobrecarga. Para tareas críticas de rendimiento, favorece las operaciones vectorizadas cuando sea posible. Si tu función personalizada no se puede vectorizar (por ejemplo, implica una lógica condicional compleja o procesamiento de cadenas que NumPy no puede manejar directamente), applymap() es una opción viable, pero ten en cuenta la compensación de rendimiento.

9. Explica cómo crear un índice de varios niveles en Pandas y cómo acceder y manipular datos utilizando los diferentes niveles del índice.

Para crear un índice de varios niveles (también conocido como índice jerárquico) en Pandas, puedes usar los métodos pd.MultiIndex.from_tuples() o pd.MultiIndex.from_arrays(). También puedes establecer múltiples columnas como el índice usando df.set_index(['col1', 'col2']). Una vez creado, el acceso a los datos implica el uso de .loc[] con tuplas que representan los niveles. Por ejemplo, df.loc[('valor_nivel1', 'valor_nivel2')] accederá a los datos en valores de índice específicos. El slicing también se puede realizar dentro de los niveles usando slice(None) para seleccionar todo dentro de un nivel, por ejemplo, df.loc[(slice(None), 'valor_nivel2'), :].

Manipular datos en niveles específicos a menudo implica usar el método swaplevel() para cambiar el orden de los niveles, y luego ordenar con sort_index() si es necesario. Luego puede usar el accesorio .loc[] como antes para asignar nuevos valores a porciones, o realizar cálculos usando funciones agregadas como groupby(level='level_name').sum(). Por ejemplo:

import pandas as pd import numpy as np index = pd.MultiIndex.from_tuples([('A', 1), ('A', 2), ('B', 1), ('B', 2)], names=['Categoría', 'Valor']) df = pd.DataFrame({'Datos': np.random.randn(4)}, index=index) # Accediendo a datos print(df.loc[('A', 1)]) # Manipulando datos df = df.swaplevel(0, 1) df = df.sort_index() print(df.loc[(1, 'A')])

10. ¿Cómo puede convertir un DataFrame de Pandas a un formato de matriz dispersa, y cuáles son los beneficios de hacerlo para el uso de memoria y la velocidad de cálculo?

Puede convertir un DataFrame de Pandas a una matriz dispersa utilizando matrices scipy.sparse en conjunto con métodos de DataFrame como to_numpy(). Por ejemplo, podría usar scipy.sparse.csc_matrix(df.to_numpy()) para crear una matriz de Columna Dispersa Comprimida (CSC). Se pueden elegir diferentes formatos dispersos como CSR (Fila Dispersa Comprimida), CSC, COO (Lista de Coordenadas), etc., basándose en la estructura de los datos y las operaciones que se realizarán.

Los beneficios de usar matrices dispersas incluyen el uso reducido de memoria al tratar con dataframes que contienen una gran cantidad de valores cero o faltantes. Almacenar solo los elementos distintos de cero y sus índices puede disminuir significativamente la huella de memoria. Además, ciertos cálculos, especialmente aquellos que involucran álgebra lineal, se pueden realizar de manera más eficiente en matrices dispersas, ya que los algoritmos se pueden optimizar para evitar operaciones que involucran elementos cero, lo que lleva a velocidades de cálculo más rápidas.

11. Describe cómo realizar una fusión difusa en Pandas, donde se emparejan filas basadas en la coincidencia aproximada de cadenas en lugar de la igualdad exacta.

La fusión difusa en Pandas implica emparejar filas de dos DataFrames basadas en coincidencias aproximadas de cadenas en una o más columnas, en lugar de la igualdad exacta. Esto suele ser necesario cuando se trata de datos del mundo real donde los campos de cadena pueden contener ligeras variaciones, errores tipográficos o inconsistencias.

La biblioteca fuzzywuzzy, junto con Pandas, se usa comúnmente para lograr esto. Primero, calcularía una puntuación de similitud entre las cadenas en las columnas de fusión usando fuzzywuzzy.fuzz.ratio u otras funciones relevantes como partial_ratio, token_sort_ratio, etc. Luego, filtre las posibles coincidencias basadas en una puntuación de umbral definida. Finalmente, puede fusionar los DataFrames basándose en estos índices de coincidencia difusa o crear un nuevo DataFrame que contenga las mejores coincidencias para cada fila. Por ejemplo:

import pandas as pd from fuzzywuzzy import fuzz def fuzzy_merge(df_left, df_right, left_on, right_on, threshold=90): merged_rows = [] for i, row_left in df_left.iterrows(): best_match_index = None best_score = 0 for j, row_right in df_right.iterrows(): score = fuzz.ratio(row_left[left_on], row_right[right_on]) if score > threshold and score > best_score: best_score = score best_match_index = j if best_match_index is not None: merged_row = pd.concat([row_left, df_right.loc[best_match_index]]) merged_rows.append(merged_row) return pd.DataFrame(merged_rows)

12. ¿Cómo se usa la función `eval()` de Pandas para realizar operaciones aritméticas en columnas, y cuáles son las ventajas de usarla sobre los operadores estándar?

La función pandas.eval() evalúa una cadena que describe operaciones en DataFrames y Series de Pandas. Se utiliza principalmente para operaciones aritméticas que involucran columnas. Por ejemplo, df.eval('A + B * C') calcula 'A + B * C' para cada fila, donde A, B y C son nombres de columnas en el DataFrame df. También puede asignar el resultado a una columna nueva o existente: df.eval('D = A + B * C', inplace=True).

Las ventajas sobre los operadores estándar incluyen:

- Rendimiento:

eval()puede ser más rápido, especialmente para DataFrames más grandes, porque evita la creación de matrices intermedias temporales, aprovechando NumExpr en segundo plano (si está instalado) para realizar operaciones vectorizadas. - Legibilidad: Las expresiones complejas pueden ser más legibles cuando se escriben como una sola cadena dentro de

eval()en comparación con la concatenación de múltiples operaciones de Pandas. La representación de cadena a menudo puede reflejar la expresión matemática más de cerca. - Uso de memoria: eval reduce el uso de memoria para operaciones más grandes al optimizar los pasos. Usando operaciones estándar, se crean matrices temporales para cada paso en el cálculo, lo que aumenta la sobrecarga de memoria.

Considere este ejemplo:

import pandas as pd import numpy as np # DataFrame de muestra df = pd.DataFrame({'A': np.random.rand(1000), 'B': np.random.rand(1000), 'C': np.random.rand(1000)}) # Usando eval() df['D'] = df.eval('A + B * C') # Usando operadores estándar df['E'] = df['A'] + df['B'] * df['C'] # ambas columnas D y E tendrán el mismo resultado, pero eval() es más rápido y usa menos memoria

13. Explique cómo leer y escribir datos en una base de datos SQL utilizando Pandas, incluyendo el manejo de diferentes tipos de datos y la ejecución de consultas SQL.

Pandas puede interactuar con bases de datos SQL utilizando la biblioteca sqlalchemy (para conexiones a bases de datos) y las funciones pandas.read_sql y pandas.to_sql. Para leer datos, primero establece una conexión a la base de datos utilizando sqlalchemy. Luego, utiliza pandas.read_sql para ejecutar consultas SQL y cargar los resultados en un DataFrame de Pandas. pandas.read_sql infiere automáticamente los tipos de datos del esquema de la base de datos SQL. Ejemplo:

import pandas as pd from sqlalchemy import create_engine engine = create_engine('sqlite:///:memory:') # Conectar a una base de datos (por ejemplo, SQLite en memoria) df = pd.DataFrame({'col1': [1, 2], 'col2': ['a', 'b']}) df.to_sql('test_table', engine, if_exists='replace', index=False) # Escribir DataFrame a SQL df_read = pd.read_sql('SELECT * FROM test_table', engine) # Leer datos de SQL print(df_read)

Para escribir datos, crea un DataFrame de Pandas y utiliza la función pandas.to_sql. Especifica el nombre de la tabla, el motor y cómo manejar las tablas existentes (if_exists='replace' para sobrescribir, if_exists='append' para agregar). Pandas gestiona las conversiones de tipos de datos de los tipos de Pandas a los tipos de SQL. Si necesitas más control, puedes especificar el argumento dtype en to_sql con un diccionario que mapee los nombres de las columnas a los tipos de datos de SQLAlchemy. Para consultas SQL directas, se puede utilizar engine.execute().

14. ¿Cómo puedes crear una función de agregación personalizada en Pandas para calcular una estadística que no está disponible en las funciones de agregación integradas?

Puedes crear una función de agregación personalizada en Pandas utilizando el método agg() junto con una función definida por el usuario. Esta función debe tomar una Serie como entrada y devolver un único valor agregado. Por ejemplo, para calcular el rango (máximo - mínimo) de una columna, puedes definir una función range_func(x): return x.max() - x.min() y luego aplicarla usando df['nombre_columna'].agg(range_func).

Alternativamente, puedes usar una función lambda para un enfoque más conciso si la lógica es simple. Por ejemplo: df['nombre_de_la_columna'].agg(lambda x: x.max() - x.min()). La clave es que la función pasada reduce la Serie a un único valor escalar, que representa la estadística agregada. Esto permite cálculos flexibles más allá de las funciones incorporadas de Pandas.

15. Describe cómo realizar una operación de remuestreo de series temporales en Pandas, incluyendo diferentes frecuencias de remuestreo y métodos de interpolación.

En Pandas, el remuestreo de series temporales se realiza utilizando el método resample() en un DataFrame o Serie con un DateTimeIndex. La funcionalidad principal implica especificar una nueva frecuencia (por ejemplo, 'D' para diario, 'W' para semanal, 'M' para mensual). Por ejemplo, df.resample('W').mean() remuestrea el DataFrame df a frecuencia semanal y calcula la media para cada semana. Diferentes funciones de agregación como sum(), min(), max(), count() se pueden aplicar después de resample().

Los valores faltantes introducidos durante el upsampling (aumentando la frecuencia) se pueden manejar usando la interpolación. Los métodos comunes incluyen:

ffill(): Relleno hacia adelante (propaga la última observación válida hacia adelante).bfill(): Relleno hacia atrás (usa la siguiente observación válida para llenar el hueco).interpolate(): Usa varias técnicas de interpolación, como la interpolación lineal (method='linear') o la interpolación polinómica (method='polynomial',order=2). Por ejemplo,df.resample('H').interpolate()remuestrea a frecuencia horaria y rellena los valores faltantes usando interpolación lineal. Ejemplo de código:df.resample('D').asfreq().fillna(method='ffill')

16. ¿Cómo se manejan los datos categóricos en Pandas, incluyendo la codificación de variables categóricas y su uso en modelos de aprendizaje automático?

Pandas ofrece varias formas de manejar datos categóricos. Para empezar, puedes convertir una columna a un tipo categórico usando astype('category'). Esto es eficiente en memoria, especialmente para columnas con muchos valores repetidos. Para la codificación, puedes usar técnicas como:

- Codificación One-Hot:

pd.get_dummies(df, columns=['nombre_columna'])crea nuevas columnas para cada categoría. Esto es adecuado para datos nominales. - Codificación de Etiqueta:

df['nombre_columna'].astype('category').cat.codesasigna un valor numérico único a cada categoría. También se puede usarLabelEncoderde Scikit-learn. Tenga cuidado al aplicarlo a datos nominales, ya que podría implicar una relación ordinal donde no existe. - Codificación Ordinal: Si la variable categórica tiene un orden significativo, asigne enteros basados en ese orden. Puede usar un mapeo de diccionario y la función

map().

Para usar datos categóricos en modelos de aprendizaje automático, muchos algoritmos requieren entrada numérica. Por lo tanto, la codificación es crucial. La codificación one-hot se usa comúnmente con modelos lineales, mientras que los modelos basados en árboles a veces pueden manejar características con codificación de etiqueta directamente o beneficiarse de la codificación ordinal si las categorías tienen un orden lógico. Considere los requisitos del algoritmo y la naturaleza de sus datos al elegir un método de codificación.

17. Explique cómo usar el objeto Pandas `Styler` para formatear y dar estilo a DataFrames para su presentación, incluyendo formato condicional y estilos CSS personalizados.

El objeto Pandas Styler le permite personalizar visualmente los DataFrames. Puede acceder al objeto Styler usando df.style. Admite el formato condicional usando métodos como applymap (elemento por elemento) y apply (columna/fila/tabla por tabla). Estos métodos toman funciones que devuelven estilos CSS basados en los valores de los datos.

Para aplicar CSS personalizado, puedes usar set_properties o set_table_styles. set_properties aplica estilos en línea a celdas individuales, mientras que set_table_styles te permite establecer estilos usando selectores CSS. Ejemplo:

def color_negative_red(val): color = 'red' if val < 0 else 'black' return 'color: %s' % color s = df.style.applymap(color_negative_red).set_properties(**{'font-weight': 'bold'}) s

Este fragmento de código demuestra el formateo condicional para colorear los valores negativos en rojo y establecer la negrita para todas las celdas. s es el dataframe con estilo que se puede renderizar en varios formatos de salida.

18. ¿Cómo se puede crear una visualización de mapa de calor de un DataFrame de Pandas usando Seaborn o Matplotlib, y cómo se interpreta el mapa de calor?

Para crear una visualización de mapa de calor de un DataFrame de Pandas, puedes usar la función heatmap() de Seaborn o la función imshow() de Matplotlib junto con la asignación de color apropiada. Con Seaborn, es sencillo: sns.heatmap(dataframe.corr(), annot=True, cmap='viridis') donde dataframe es tu DataFrame de Pandas, annot=True muestra los valores de correlación en cada celda, y cmap establece el esquema de color. Matplotlib requiere un poco más de configuración. Puedes usar plt.imshow(dataframe.corr(), cmap='viridis') seguido de la configuración de marcas y etiquetas para los ejes.

Interpretar el mapa de calor implica observar la intensidad del color. Cada celda representa la correlación (o cualquier otra métrica) entre dos variables. Los colores más oscuros o brillantes (dependiendo del mapa de color) indican correlaciones positivas o negativas más fuertes. annot=True ayuda a ver los valores directamente. Por ejemplo, una celda brillante podría sugerir una fuerte correlación positiva, mientras que una celda oscura sugiere una fuerte correlación negativa. Los valores cercanos a cero indican poca o ninguna correlación.

19. Describe cómo realizar un análisis de red usando Pandas y NetworkX, incluyendo la creación de un grafo a partir de un DataFrame y el cálculo de métricas de red.

Para realizar un análisis de red usando Pandas y NetworkX, normalmente se comienza con datos que representan las conexiones entre nodos, a menudo almacenados en un DataFrame de Pandas. Se puede crear un grafo usando networkx.from_pandas_edgelist(df, source='columna_que_contiene_el_nodo_fuente', target='columna_que_contiene_el_nodo_destino', edge_attr='columna_que_contiene_atributos_de_arista'). Después de crear el grafo, se pueden calcular varias métricas de red como la centralidad de grado (usando networkx.degree_centrality(grafo)), la centralidad de intermediación (usando networkx.betweenness_centrality(grafo)), y los caminos más cortos (usando networkx.shortest_path(grafo, source='nodo1', target='nodo2')).

Por ejemplo:

import pandas as pd import networkx as nx # DataFrame de ejemplo data = {'source': ['A', 'A', 'B', 'C'], 'target': ['B', 'C', 'C', 'D'], 'weight': [1, 2, 3, 4]} df = pd.DataFrame(data) # Crear grafo desde DataFrame G = nx.from_pandas_edgelist(df, source='source', target='target', edge_attr='weight') # Calcular centralidad de grado degree_centrality = nx.degree_centrality(G) print(f"Centralidad de Grado: {degree_centrality}")

20. ¿Cómo se usa la función Pandas qcut() para discretizar una variable continua en cuantiles y cómo se manejan los casos extremos con valores duplicados?

La función Pandas qcut() discretiza una variable continua en cubos de igual tamaño basados en el rango o cuantiles de la muestra. Toma los datos de la serie o de tipo array y el número de cuantiles (q) como entrada. qcut() devuelve un objeto categórico o una serie cuyos valores son nombres/intervalos de categorías.

Manejar valores duplicados es importante. Por defecto, qcut() genera un DuplicateBoundError si los límites de los bins no son únicos. Para manejar esto, se usa el parámetro duplicates: 'raise' (por defecto) genera el error; 'drop' elimina los duplicados resultando en tamaños de bin desiguales. Por ejemplo:

import pandas as pd data = [1, 2, 2, 3, 4, 5] q = 4 # número deseado de cuantiles #Si duplicates='raise' y existen duplicados, generará un error #pd.qcut(data, q, duplicates='raise') #Si duplicates='drop', los límites duplicados serán eliminados. pd.qcut(data, q, duplicates='drop')

21. Explique cómo realizar un análisis geográfico usando Pandas y GeoPandas, incluyendo la lectura y escritura de datos geoespaciales y la realización de operaciones espaciales.

Pandas maneja datos tabulares, mientras que GeoPandas lo extiende para manejar datos geoespaciales. Primero, instálalos: pip install pandas geopandas. Para leer datos geoespaciales (por ejemplo, Shapefile, GeoJSON), use geopandas.read_file('ruta/al/archivo.shp'). Esto crea un GeoDataFrame, similar a un DataFrame de Pandas pero con una columna 'geometry' que contiene datos espaciales (puntos, líneas, polígonos). La escritura es similar: gdf.to_file('ruta/al/salida.geojson', driver='GeoJSON').

Las operaciones espaciales incluyen:

- Uniones espaciales:

geopandas.sjoin(gdf1, gdf2, how='inner', op='intersects')combina datos basados en relaciones espaciales. - Análisis de proximidad: Use

gdf.distance(other_geometry)para encontrar distancias entre geometrías. Es posible que deba reproyectar los datos a un sistema de referencia de coordenadas (CRS) apropiado utilizandogdf.to_crs('EPSG:4326')antes de realizar operaciones espaciales para garantizar la precisión, particularmente para los cálculos de distancia.

22. ¿Cómo se puede crear un panel de control usando Pandas y Plotly o Bokeh, incluyendo widgets interactivos y actualizaciones de datos?

Para crear un panel de control con Pandas, Plotly/Bokeh y widgets interactivos, normalmente usaría un framework como Dash (para Plotly) o el servidor Bokeh. Comenzaría cargando y procesando sus datos con Pandas. Luego, use Plotly o Bokeh para crear gráficos iniciales. A continuación, integre widgets interactivos (desplegables, deslizadores, etc.) utilizando los componentes del framework elegido. Estos widgets activarían retrollamadas que actualizan los gráficos en función de las selecciones del usuario.

Por ejemplo, usando Dash:

- Crear un DataFrame de Pandas.

- Crear una figura de Plotly a partir del DataFrame.

- Definir el diseño de Dash con

dcc.Graph(para el gráfico) ydcc.Dropdown(para el widget). - Escribir una función de callback que actualice la propiedad

figurededcc.Graphbasada en la propiedadvaluededcc.Dropdown. Esto implica filtrar/transformar el DataFrame de Pandas basado en la selección del dropdown y recrear la figura de Plotly.

23. Describa cómo realizar un análisis de texto usando Pandas y NLTK o SpaCy, incluyendo tokenización, stemming y análisis de sentimiento.

El análisis de texto con Pandas, NLTK/SpaCy implica varios pasos. Primero, cargar los datos de texto en un DataFrame de Pandas. Luego, limpiar el texto eliminando la puntuación y convirtiéndolo a minúsculas. A continuación, realizar la tokenización utilizando word_tokenize de NLTK o el tokenizer de SpaCy. Para el stemming, usar PorterStemmer o LancasterStemmer de NLTK para reducir las palabras a su forma raíz. Para el análisis de sentimiento, usar VADER (Valence Aware Dictionary and sEntiment Reasoner) de NLTK o la integración de SpaCy con bibliotecas como TextBlob. Las puntuaciones del análisis de sentimiento se pueden agregar como nuevas columnas en el DataFrame de Pandas.

Ejemplo:

import pandas as pd import nltk from nltk.sentiment.vader import SentimentIntensityAnalyzer nltk.download('vader_lexicon') data = {'text': ['¡Esta es una gran película!', 'Odio este producto.']} df = pd.DataFrame(data) sid = SentimentIntensityAnalyzer() df['sentiment_scores'] = df['text'].apply(lambda text: sid.polarity_scores(text)) print(df)

24. ¿Cómo se utiliza el tipo de datos Categorical de Pandas para representar datos ordinales o nominales, y en qué se diferencia de una columna de objeto estándar?

El tipo de datos Categorical de Pandas se utiliza para representar datos que tienen un número fijo de valores posibles (categorías). Almacena eficientemente cadenas (u otros objetos) asignándolos a códigos enteros, especialmente útil para columnas con muchos valores repetidos.

Para datos ordinales, puedes especificar el parámetro ordered=True, lo que le indica a Pandas que las categorías tienen un orden significativo. Esto permite comparaciones como data['columna'] > 'categoría_a' si las categorías están ordenadas. Para datos nominales, ordered=False (el valor predeterminado), lo que implica que no hay un orden inherente. Las columnas Categorical difieren de las columnas de objeto estándar principalmente en el uso de memoria y las operaciones admitidas. Categorical usa menos memoria y operaciones como .describe() están optimizadas. Las columnas de objeto almacenan cada valor de cadena individualmente, consumiendo más memoria, particularmente cuando hay valores repetidos presentes. Usar Categorical puede mejorar el rendimiento y reducir el uso de memoria cuando se trata de datos con un conjunto limitado de valores.

25. Explique cómo realizar un análisis de supervivencia utilizando Pandas y Lifelines, incluyendo la estimación de curvas de supervivencia y la comparación de diferentes grupos.

El análisis de supervivencia examina el tiempo hasta que ocurre un evento. Usando Pandas y Lifelines en Python, puedes realizar este análisis de manera efectiva. Primero, carga tus datos en un DataFrame de Pandas, asegurándote de tener columnas para 'tiempo' (tiempo hasta el evento o censura) y 'evento' (1 si el evento ocurrió, 0 si está censurado). Usa KaplanMeierFitter de Lifelines para estimar la función de supervivencia. Ajusta el modelo con kmf.fit(durations = df['tiempo'], event_observed = df['evento']). Para trazar la curva de supervivencia, usa kmf.plot_survival_function().

Para comparar diferentes grupos, como tratamiento vs. control, crea ajustes de Kaplan-Meier separados para cada grupo. Por ejemplo, filtra el DataFrame para cada grupo, ajusta un KaplanMeierFitter a cada uno, y luego traza sus funciones de supervivencia en los mismos ejes para comparar visualmente. Estadísticamente, puedes comparar los grupos usando una prueba log-rank proporcionada en Lifelines utilizando logrank_test(durations_A, durations_B, event_observed_A, event_observed_B). Esta prueba evalúa si existe una diferencia estadísticamente significativa entre las curvas de supervivencia de los dos grupos. El valor p indicará la significancia, es decir, si p < 0.05 (generalmente) las curvas de supervivencia de los grupos son estadísticamente diferentes.

26. ¿Cómo puedes crear un sistema de recomendación usando Pandas y scikit-learn, incluyendo filtrado colaborativo y filtrado basado en contenido?

Puedes construir un sistema de recomendación básico usando Pandas y scikit-learn combinando filtrado colaborativo y basado en contenido. Para el filtrado colaborativo, usarías Pandas para crear una matriz de interacción usuario-ítem (por ejemplo, calificaciones de usuarios para ítems). pairwise_distances de Scikit-learn puede entonces calcular similitudes de usuarios o ítems basadas en esta matriz. Las recomendaciones se generan encontrando usuarios o ítems similares. Aquí hay un ejemplo:

import pandas as pd from sklearn.metrics.pairwise import cosine_similarity # matriz usuario-elemento (usuarios x elementos) calificaciones = pd.DataFrame({'user_id': [1, 1, 2, 2, 3, 3], 'item_id': [1, 2, 1, 3, 2, 3], 'rating': [5, 3, 4, 2, 1, 5]}) matriz_usuario_elemento = calificaciones.pivot_table(index='user_id', columns='item_id', values='rating').fillna(0) similitud_usuario = cosine_similarity(matriz_usuario_elemento) similitud_usuario_df = pd.DataFrame(similitud_usuario, index=matriz_usuario_elemento.index, columns=matriz_usuario_elemento.index) # Para obtener la similitud de elementos similitud_elemento = cosine_similarity(matriz_usuario_elemento.T) similitud_elemento_df = pd.DataFrame(similitud_elemento, index=matriz_usuario_elemento.columns, columns=matriz_usuario_elemento.columns)

Para el filtrado basado en contenido, Pandas ayuda a gestionar las características de los elementos (por ejemplo, género, descripción). TfidfVectorizer de Scikit-learn convierte las características de texto en representaciones numéricas. cosine_similarity luego determina las similitudes de los elementos basadas en los vectores de características. Las recomendaciones son elementos similares a los que el usuario ha gustado. Un sistema híbrido combina ambos enfoques. También puede usar los modelos de regresión de scikit-learn para predecir las calificaciones de los elementos basándose en las características del usuario y del elemento, ofreciendo otro enfoque para las recomendaciones.

27. Describa cómo realizar una previsión de series temporales utilizando Pandas y Prophet o ARIMA, incluyendo el ajuste y la evaluación del modelo.

Pronóstico de series temporales con Pandas y Prophet o ARIMA implica la preparación de datos, el ajuste del modelo y la evaluación. Primero, cargue sus datos de series temporales en un DataFrame de Pandas, asegurándose de que la columna de tiempo se establezca como el índice. Con Prophet, el DataFrame necesita dos columnas llamadas 'ds' (fecha y hora) e 'y' (el valor de la serie temporal). Para ARIMA, probablemente necesitará asegurar la estacionariedad mediante la diferenciación o transformaciones. Luego, cree una instancia y ajuste el modelo. Para Prophet: model = Prophet(); model.fit(df). Para ARIMA (después de determinar los órdenes p, d, q): model = ARIMA(df['value'], order=(p,d,q)); model_fit = model.fit().

A continuación, genere pronósticos. Con Prophet, cree un DataFrame futuro usando model.make_future_dataframe(periods=n) y prediga usando forecast = model.predict(future). Para ARIMA, use model_fit.forecast(steps=n). Finalmente, evalúe el modelo. Para ambos, calcule métricas de error como el Error Absoluto Medio (MAE), el Error Cuadrático Medio (MSE) o la Raíz del Error Cuadrático Medio (RMSE) comparando los valores predichos con los valores reales de un conjunto de validación reservado. También puede visualizar el pronóstico contra los datos reales para evaluar el rendimiento. Por ejemplo, from sklearn.metrics import mean_squared_error; mse = mean_squared_error(actual, predicted).

28. ¿Cómo se utiliza el objeto Index de Pandas para optimizar el acceso y filtrado de datos, y en qué se diferencia de una columna estándar?

El objeto Index de Pandas es crucial para optimizar el acceso a los datos porque permite búsquedas rápidas basadas en etiquetas. A diferencia de las columnas estándar, el Index está diseñado para una búsqueda y recuperación eficientes; Pandas lo utiliza para alinear datos durante las operaciones y seleccionar rápidamente subconjuntos de datos. Al filtrar, el uso del Index puede ser significativamente más rápido que filtrar en una columna normal, especialmente para conjuntos de datos grandes, ya que el Index a menudo se implementa utilizando estructuras de datos optimizadas como tablas hash o árboles B.

Las diferencias clave incluyen:

- Unicidad e Inmutabilidad: Los valores del

Indexsuelen ser (aunque no siempre) únicos e inmutables, lo que garantiza búsquedas fiables. - Alineación de datos: Se utiliza para la alineación automática de datos durante las operaciones (por ejemplo, uniones de

DataFrame). - Búsquedas rápidas: Permite la recuperación de datos altamente optimizada por etiqueta en comparación con la iteración a través de una columna. Por ejemplo, acceder a

df.loc[index_label]es mucho más rápido quedf[df['columna'] == valor]cuandoindex_labelestá en elIndex.

29. Explique cómo realizar la detección de anomalías utilizando Pandas e isolation forest o one-class SVM, incluyendo el entrenamiento del modelo y la selección del umbral.

La detección de anomalías utilizando Pandas e Isolation Forest (o One-Class SVM) implica varios pasos. Primero, cargue sus datos en un DataFrame de Pandas. Luego, preprocese los datos escalando las características numéricas utilizando StandardScaler o MinMaxScaler de sklearn.preprocessing. A continuación, entrene su modelo de detección de anomalías, por ejemplo, IsolationForest de sklearn.ensemble o OneClassSVM de sklearn.svm, utilizando los datos preprocesados. Para Isolation Forest: model = IsolationForest(contamination=0.05); model.fit(data). Para One-Class SVM: model = OneClassSVM(nu=0.05); model.fit(data). El parámetro contamination (para Isolation Forest) y el parámetro nu (para One-Class SVM) estiman la proporción de valores atípicos en el conjunto de datos.

Para determinar el umbral de anomalía, prediga las puntuaciones de anomalía (Isolation Forest) o los valores de la función de decisión (One-Class SVM) para sus datos de entrenamiento. Para Isolation Forest, las anomalías tienen puntuaciones más bajas. Para One-Class SVM, las anomalías tienen valores de función de decisión más bajos. Luego, decida un umbral para separar los puntos de datos normales y anómalos. Un enfoque común es seleccionar un percentil de las puntuaciones de anomalía como umbral. Por ejemplo, podría usar el percentil 5 de las puntuaciones de anomalía como su umbral, clasificando cualquier punto de datos con una puntuación de anomalía por debajo de este umbral como una anomalía. Específicamente, scores = model.decision_function(data); threshold = np.percentile(scores, 5). Finalmente, use el modelo entrenado y el umbral seleccionado para clasificar los nuevos puntos de datos como normales o anómalos.

30. ¿Cómo se puede crear una tubería de datos utilizando Pandas y Dask o Spark, incluyendo la carga, transformación y almacenamiento de datos?

Una tubería de datos que utiliza Pandas, Dask y Spark implica varias etapas: cargar, transformar y almacenar datos. Pandas es adecuado para conjuntos de datos más pequeños y análisis exploratorios. Para conjuntos de datos más grandes, se puede usar Dask o Spark para el procesamiento paralelo. Aquí hay un esquema conceptual:

- Carga de datos: Cargar datos de diversas fuentes (CSV, bases de datos, etc.) usando Pandas (por ejemplo,

pd.read_csv()). Para conjuntos de datos más grandes, usardd.read_csv()de Dask ospark.read.csv()de Spark. Dask y Spark pueden leer datos en paralelo. - Transformación de datos:

- Pandas: Usar DataFrames de Pandas para limpiar, filtrar y diseñar características (por ejemplo,

df.dropna(),df['new_column'] = ...). - Dask: Usar DataFrames de Dask (creados con

dd.from_pandas()) para operaciones similares en conjuntos de datos mayores que la memoria. Dask paralelizará estas operaciones. - Spark: Usar DataFrames de Spark y transformaciones tipo SQL (por ejemplo,

df.select(),df.filter(),df.withColumn()). Spark usa evaluación perezosa y ejecución de consultas optimizada.

- Pandas: Usar DataFrames de Pandas para limpiar, filtrar y diseñar características (por ejemplo,

- Almacenamiento de datos: Almacenar los datos transformados en una ubicación de destino (por ejemplo, CSV, Parquet, base de datos). Usar

df.to_csv()para Pandas. Para Dask, usardd.to_parquet(). Para Spark usardf.write.parquet(). Parquet es a menudo una buena opción para conjuntos de datos grandes debido a su formato de almacenamiento columnar.

Por ejemplo, usando Dask:

import pandas as pd import dask.dataframe as dd

Cargar datos usando pandas

df_pandas = pd.read_csv('large_data.csv')

Crear DataFrame Dask desde DataFrame Pandas

df_dask = dd.from_pandas(df_pandas, npartitions=4) # Determinar tamaño de partición razonable

Transformar los datos (ejemplo: filtrado)

df_transformed = df_dask[df_dask['nombre_columna'] > 10]

Guardar los datos transformados

df_transformed.to_parquet('transformed_data.parquet', single_file=True)

Recuerde elegir Dask o Spark dependiendo de sus requerimientos de escala e infraestructura. Dask es a menudo más fácil de integrar con los flujos de trabajo existentes de Pandas, mientras que Spark está diseñado para la computación distribuida a gran escala.

Preguntas de entrevista avanzadas sobre Pandas

1. ¿Cómo puede optimizar el código de Pandas para la velocidad y el uso de memoria cuando se trata de conjuntos de datos grandes?

Al optimizar el código de Pandas para conjuntos de datos grandes, considere estas estrategias:

- Usa tipos de datos apropiados: Emplea tipos numéricos más pequeños (por ejemplo,

int16en lugar deint64) y el tipo de datoscategorypara columnas con pocos valores únicos.df['columna'] = df['columna'].astype('category') - Fragmentación: Lee los datos en fragmentos más pequeños usando

pd.read_csv(..., chunksize=...)para procesar los datos iterativamente. - Vectorización: Utiliza las operaciones vectorizadas integradas de Pandas en lugar de iterar a través de las filas.

df['nueva_columna'] = df['columna1'] + df['columna2']es mucho más rápido que iterar. - Evita copias innecesarias: Usa

inplace=Truedonde sea apropiado para modificar los DataFrames directamente. Ten en cuenta la indexación encadenada que a menudo crea copias. En su lugar, usa.locpara la asignación directa.df.loc[row_indexer, col_indexer] = valor - Estructuras de datos dispersas: Cuando los datos contienen muchos ceros, considera el uso de estructuras de datos dispersas para reducir el consumo de memoria.

- Formatos de archivo optimizados: Utiliza formatos de archivo que sean más eficientes que CSV como Parquet o Feather.

- Numba/Cython: Para operaciones computacionalmente intensivas, usa Numba o Cython para compilar código Python a código de máquina para mejoras significativas de velocidad.

2. Explique la diferencia entre .loc e .iloc en Pandas, y cuándo usar cada uno.

.loc e .iloc se utilizan ambos para seleccionar datos en DataFrames de Pandas, pero difieren en cómo hacen referencia a los datos.

.loc utiliza la indexación basada en etiquetas, lo que significa que se seleccionan datos basándose en las etiquetas (nombres) de las filas y columnas. .iloc utiliza la indexación basada en enteros, lo que significa que se seleccionan datos basándose en las posiciones enteras de las filas y columnas. Por ejemplo, df.loc['etiqueta_fila', 'etiqueta_columna'] selecciona el elemento en la etiqueta especificada, mientras que df.iloc[posición_fila, posición_columna] selecciona el elemento en la posición entera especificada. Use .loc cuando conoce las etiquetas y desea seleccionar en función de ellas. Use .iloc cuando desee seleccionar por índice numérico independientemente de las etiquetas, lo cual es útil para iterar a través de los datos sin tener en cuenta los nombres de filas/columnas.

3. Describa cómo manejar los datos faltantes en Pandas, incluyendo las técnicas de imputación.

Manejar los datos faltantes en Pandas a menudo implica identificar y luego eliminar o imputar los valores faltantes, representados como NaN. df.isnull() y df.notnull() ayudan a identificar los valores faltantes. df.dropna() elimina filas o columnas con datos faltantes. El parámetro axis controla si se eliminan filas (axis=0) o columnas (axis=1), y how='any' (predeterminado) elimina si falta algún valor, mientras que how='all' elimina solo si faltan todos los valores. thresh puede especificar el número mínimo de valores no faltantes para mantener una fila/columna. Para la imputación, df.fillna() reemplaza los valores faltantes. Las técnicas de imputación comunes incluyen rellenar con un valor constante, la media, la mediana o la moda de la columna. Ejemplo: df['nombre_columna'].fillna(df['nombre_columna'].mean(), inplace=True) reemplaza los valores NaN en nombre_columna con la media de la columna.

4. ¿Cómo realizaría una ordenación multi-índice en Pandas y por qué podría usarla?

Para realizar una ordenación multi-índice en Pandas, usaría el método sort_index() en un DataFrame o Serie que tenga un MultiIndex. Puede especificar los niveles por los que desea ordenar utilizando el parámetro level, que acepta un nombre o número de nivel (o una lista de ellos). El parámetro ascending controla el orden de clasificación para cada nivel; puede proporcionar un booleano o una lista de booleanos correspondientes a cada nivel que está ordenando.

Puede utilizar una ordenación multi-índice cuando sus datos tienen una estructura jerárquica. Por ejemplo, podría tener datos de ventas indexados por región y luego por categoría de producto. Ordenar por región y luego por categoría de producto le permite analizar fácilmente el rendimiento de las ventas dentro de cada región y comparar las ventas de productos en diferentes regiones. Facilita tareas como la agrupación, la agregación y la creación de visualizaciones significativas.

5. Explique cómo usar `pd.Grouper` para la agregación personalizada basada en el tiempo.

`pd.Grouper` permite la agrupación flexible basada en el tiempo en pandas, particularmente útil cuando el remuestreo no es suficiente. En lugar de depender de una frecuencia fija como 'D' (diaria), `pd.Grouper` le permite definir intervalos de agrupación personalizados o basar los grupos en columnas específicas. Normalmente, lo utiliza dentro de `groupby()` para definir cómo deben agregarse las filas.

Por ejemplo, puede agrupar datos cada 5 días usando pd.Grouper(key='columna_fecha', freq='5D') o agrupar por semanas a partir del miércoles usando pd.Grouper(key='columna_fecha', freq='W-WED'). El argumento key especifica la columna por la que agrupar, y freq establece la frecuencia de agrupación. También puede agrupar por los valores de una columna específica con pd.Grouper(column='columna_categoría') que agrupará por los valores únicos encontrados en columna_categoría en lugar del índice de fecha y hora. Luego, seguiría esto con una función de agregación como sum(), mean(), etc.

6. ¿Cómo se combinan eficientemente múltiples DataFrames de Pandas con diferentes estructuras?

La combinación eficiente de DataFrames de Pandas con diferentes estructuras a menudo implica comprender los requisitos específicos y elegir el método apropiado.

Para una concatenación simple, pd.concat() es un buen punto de partida. Puede manejar DataFrames con diferentes columnas y estructuras de índice usando los parámetros join y axis. Para manejar uniones basadas en columnas comunes, la función pd.merge() (o df.merge()) es útil. Los parámetros clave son how (especificando el tipo de unión - 'inner', 'outer', 'left', 'right'), on (especificando la(s) columna(s) para unir), left_on y right_on (cuando las columnas de unión tienen nombres diferentes). Cuando las columnas no coinciden exactamente, considere renombrar usando df.rename() antes de fusionar. Combinar pd.concat() y pd.merge() puede resolver escenarios complejos.

7. Explica cómo aplicar una función personalizada a un DataFrame de Pandas que depende de múltiples columnas usando apply.

Para aplicar una función personalizada a un DataFrame de Pandas que depende de múltiples columnas usando apply, necesitas pasar axis=1 al método apply. Esto asegura que la función se aplique por filas, permitiendo el acceso a múltiples columnas dentro de cada fila. Dentro de la función personalizada, puedes acceder a los valores de diferentes columnas referenciando los nombres de las columnas como atributos de la fila.

Por ejemplo:

def mi_funcion_personalizada(fila): columna1 = fila['nombre_columna_1'] columna2 = fila['nombre_columna_2'] # Tu lógica aquí usando columna1 y columna2 return columna1 + columna2 df['nueva_columna'] = df.apply(mi_funcion_personalizada, axis=1)

En este ejemplo, mi_funcion_personalizada toma una fila como entrada, accede a 'nombre_columna_1' y 'nombre_columna_2', realiza alguna operación y devuelve un valor que luego se almacena en 'nueva_columna'.

8. Describe cómo realizar un cálculo de ventana móvil en una Serie o DataFrame de Pandas.

Para realizar un cálculo de ventana móvil en una Serie o DataFrame de Pandas, se utiliza el método .rolling(). Este método crea un objeto Rolling, que luego se puede usar para aplicar varias funciones de agregación.

Por ejemplo:

import pandas as pd # Ejemplo de Serie s = pd.Series([1, 2, 3, 4, 5]) # Ventana móvil de tamaño 3, calculando la media rolling_mean = s.rolling(window=3).mean() print(rolling_mean)

Los parámetros clave incluyen window (el tamaño de la ventana móvil), min_periods (el número mínimo de observaciones requeridas para tener un valor) y center (si la ventana está centrada). Las funciones de agregación comunes utilizadas después de .rolling() son .mean(), .sum(), .std() y .apply() para funciones personalizadas.

9. ¿Cómo se pueden crear tablas dinámicas y tabulaciones cruzadas utilizando Pandas y cuáles son sus diferencias?

Pandas ofrece pivot_table() y crosstab() para crear tablas dinámicas y tabulaciones cruzadas. pivot_table() es una función de propósito general que agrega datos basados en el índice, columnas y valores especificados, utilizando una función de agregación dada (como media, suma, etc.). Puede manejar datos numéricos y categóricos, y los valores faltantes pueden ser gestionados.

crosstab() está específicamente diseñado para calcular una tabla de frecuencia (tabulación cruzada) entre dos o más variables categóricas. Muestra la distribución de frecuencia de diferentes combinaciones de categorías. Si bien pivot_table necesita una función de agregación explícita para sus 'valores', crosstab esencialmente calcula los conteos (frecuencias) por defecto. Por ejemplo:

import pandas as pd data = {'A': ['foo', 'foo', 'bar', 'bar', 'foo', 'bar'], 'B': ['one', 'one', 'two', 'one', 'two', 'two'], 'C': [1, 2, 3, 4, 5, 6]} df = pd.DataFrame(data) pivot_table = pd.pivot_table(df, values='C', index='A', columns='B', aggfunc='sum') crosstab = pd.crosstab(df['A'], df['B']) print(pivot_table) print(crosstab)

10. Explique cómo usar Pandas con pipelines de scikit-learn para el preprocesamiento y modelado de datos.

Los DataFrames de Pandas se pueden integrar directamente en los pipelines de scikit-learn. Esto es útil porque los transformadores y estimadores de scikit-learn están diseñados para funcionar con arrays de NumPy. Pandas proporciona estructuras de datos y operaciones que a menudo son necesarias durante el preprocesamiento de datos. Puede usar ColumnTransformer para aplicar diferentes pasos de preprocesamiento a diferentes columnas de su DataFrame y luego pasar el resultado a un modelo de scikit-learn.

Aquí hay un ejemplo básico:

import pandas as pd from sklearn.compose import ColumnTransformer from sklearn.preprocessing import StandardScaler, OneHotEncoder from sklearn.linear_model import LogisticRegression from sklearn.pipeline import Pipeline # DataFrame de ejemplo data = {'numerical': [1, 2, 3, 4, 5], 'categorical': ['A', 'B', 'A', 'C', 'B'], 'target': [0, 1, 0, 1, 0]} df = pd.DataFrame(data) # Definir pasos de preprocesamiento para características numéricas y categóricas características_numéricas = ['numerical'] transformador_numérico = Pipeline(steps=[('scaler', StandardScaler())]) características_categóricas = ['categorical'] transformador_categórico = Pipeline(steps=[('onehot', OneHotEncoder(handle_unknown='ignore'))]) # Crear un ColumnTransformer preprocesador = ColumnTransformer(transformers=[('num', transformador_numérico, características_numéricas),('cat', transformador_categórico, características_categóricas)]) # Crear la tubería modelo = Pipeline(steps=[('preprocessor', preprocesador),('classifier', LogisticRegression())]) # Ajustar el modelo X = df.drop('target', axis=1) y = df['target'] modelo.fit(X, y) # Hacer predicciones predicciones = model.predict(X) print(predicciones)

11. ¿Cómo convertirías un DataFrame de Pandas a un formato de matriz dispersa y cuándo es esto útil?

Puedes convertir un DataFrame de Pandas a un formato de matriz dispersa utilizando la biblioteca scipy.sparse en conjunto con los métodos de DataFrame. El enfoque común implica primero convertir el DataFrame a un array de NumPy y luego usar un constructor de matriz dispersa como csc_matrix (Columna Dispersa Comprimida) o csr_matrix (Fila Dispersa Comprimida). Por ejemplo:

import pandas as pd import scipy.sparse as sparse data = {'col1': [1, 0, 0, 2, 0], 'col2': [0, 0, 3, 0, 0], 'col3': [0, 4, 0, 0, 5]} df = pd.DataFrame(data) sparse_matrix = sparse.csc_matrix(df.values)

Esta conversión es particularmente útil cuando se trata de DataFrames que contienen un gran número de valores cero o faltantes. Las matrices dispersas almacenan eficientemente solo los elementos distintos de cero, lo que reduce significativamente el uso de memoria y el costo computacional para operaciones como la multiplicación de matrices o la resolución de sistemas lineales. Esto es común en escenarios como sistemas de recomendación (interacciones usuario-elemento), análisis de texto (matrices término-documento) o análisis de redes donde la mayoría de las entradas son cero.

12. Describe cómo escribir un DataFrame de Pandas en una base de datos usando SQLAlchemy y manejar problemas potenciales.

Para escribir un DataFrame de Pandas en una base de datos usando SQLAlchemy, puedes usar el método to_sql() proporcionado por Pandas. Este método requiere un objeto de motor SQLAlchemy para establecer la conexión. Por ejemplo:

import pandas as pd from sqlalchemy import create_engine # Crea un motor SQLAlchemy engine = create_engine('dialect+driver://user:password@host:port/database') # Ejemplo DataFrame data = {'col1': [1, 2], 'col2': [3, 4]} df = pd.DataFrame(data) # Escribe el DataFrame en la base de datos df.to_sql('nombre_tabla', engine, if_exists='replace', index=False)

Los problemas y soluciones potenciales incluyen:

- La tabla ya existe: Use el parámetro

if_exists('fail','replace'o'append') para manejar casos donde la tabla ya existe. - Inconsistencias de tipos de datos: Asegúrese de que los tipos de datos en el DataFrame coincidan con el esquema de la tabla de la base de datos. Puede que necesite convertir columnas usando

.astype()antes de escribir. - Inyección SQL: Use consultas parametrizadas (manejadas automáticamente por SQLAlchemy) para evitar vulnerabilidades de inyección SQL.

- DataFrames grandes: Para DataFrames muy grandes, considere escribir en fragmentos usando el parámetro