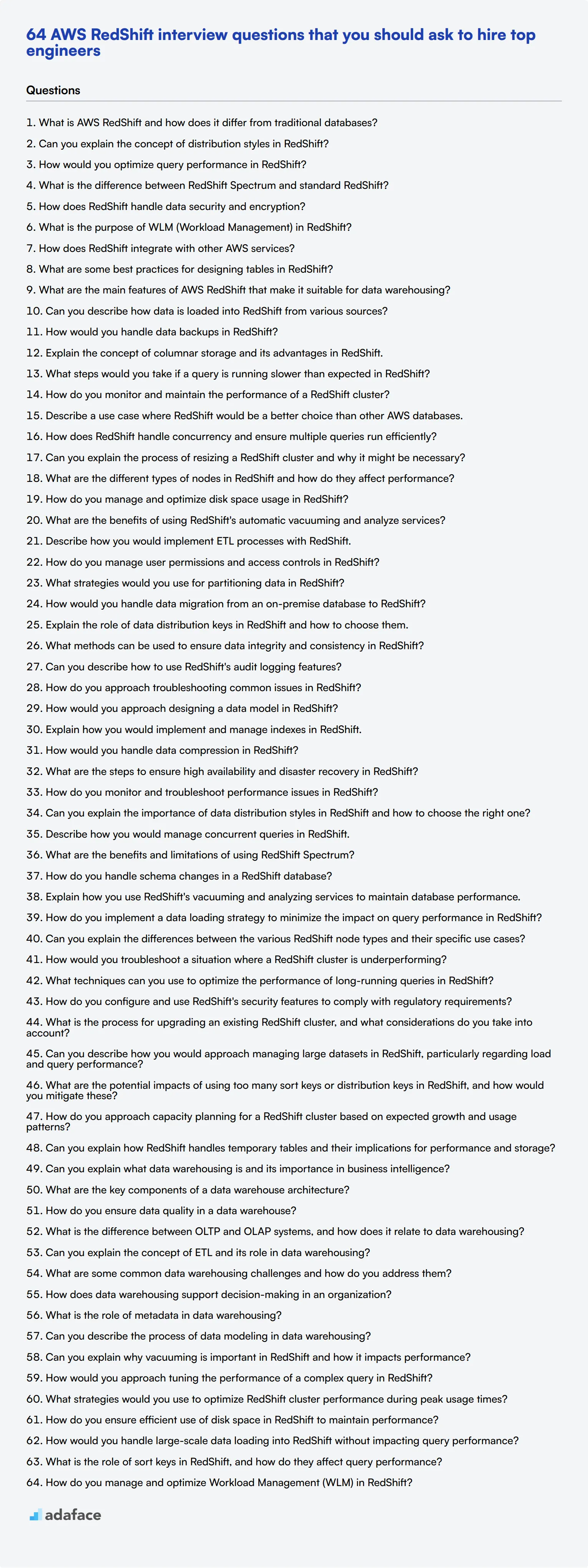

64 preguntas de entrevista de AWS RedShift que deberías hacer para contratar a los mejores ingenieros

Contratar a los candidatos adecuados para los roles de AWS RedShift no es sencillo, dadas las habilidades especializadas requeridas. Estas habilidades implican una combinación de almacenamiento de datos, optimización del rendimiento y análisis de datos, que hemos discutido en nuestras publicaciones relacionadas.

Esta publicación de blog desglosa las preguntas esenciales de la entrevista de AWS RedShift en varios niveles de habilidad, desde analistas de datos junior hasta administradores de bases de datos senior. También cubrimos preguntas centradas en conceptos de almacenamiento de datos y optimización del rendimiento para brindarle un conjunto de herramientas completo para sus entrevistas.

Usando esta guía, puede optimizar su proceso de entrevista e identificar el mejor talento de manera eficiente. Para garantizar aún más la calidad de los candidatos, considere usar nuestra prueba en línea de AWS antes de realizar las entrevistas.

Tabla de contenidos

8 preguntas y respuestas generales de la entrevista de AWS RedShift para evaluar a los solicitantes

20 preguntas de la entrevista de AWS RedShift para preguntar a los analistas de datos junior

10 preguntas intermedias de la entrevista de AWS RedShift y respuestas para preguntar a los ingenieros de datos de nivel medio.

10 preguntas avanzadas de la entrevista de AWS RedShift para preguntar a los administradores de bases de datos senior

9 preguntas y respuestas de la entrevista de AWS RedShift relacionadas con los conceptos de almacenamiento de datos

7 preguntas y respuestas de la entrevista de AWS RedShift relacionadas con la optimización del rendimiento

¿Qué habilidades de AWS RedShift debe evaluar durante la fase de la entrevista?

3 consejos para usar las preguntas de la entrevista de AWS RedShift

Contrate a los mejores talentos de AWS RedShift con pruebas de habilidades y entrevistas específicas

Descargue la plantilla de preguntas de la entrevista de AWS RedShift en múltiples formatos

8 preguntas y respuestas generales de la entrevista de AWS RedShift para evaluar a los solicitantes

¿Listo para sumergirse en el mundo de AWS RedShift? Estas 8 preguntas generales de entrevista le ayudarán a evaluar la comprensión de los candidatos de esta poderosa solución de almacenamiento de datos. Utilice estas preguntas para evaluar el conocimiento y las habilidades de resolución de problemas de los solicitantes, asegurándose de encontrar la opción adecuada para su equipo. Recuerde, los mejores candidatos no solo sabrán las respuestas, sino que también entenderán el "por qué" detrás de ellas.

1. ¿Qué es AWS RedShift y en qué se diferencia de las bases de datos tradicionales?

AWS RedShift es un servicio de almacenamiento de datos totalmente administrado, a escala de petabytes, en la nube. Está diseñado para analizar grandes volúmenes de datos utilizando SQL estándar y herramientas de Business Intelligence (BI) existentes.

A diferencia de las bases de datos tradicionales, RedShift está orientado a columnas, lo que lo hace particularmente eficiente para consultas analíticas. También utiliza el procesamiento paralelo masivo (MPP) para distribuir consultas entre múltiples nodos, lo que permite una ejecución de consultas más rápida en conjuntos de datos grandes.

Busque candidatos que puedan explicar la escalabilidad de RedShift, las ventajas de rendimiento y su papel en el análisis de big data. Las respuestas sólidas abordarán la rentabilidad y la integración con otros servicios de AWS.

2. ¿Puede explicar el concepto de estilos de distribución en RedShift?

Los estilos de distribución en RedShift determinan cómo se distribuyen los datos entre los nodos de cómputo en un clúster. Hay tres estilos de distribución principales:

- AUTO: RedShift asigna el mejor estilo de distribución en función de los datos.

- EVEN: Los datos se distribuyen uniformemente entre las particiones, independientemente de los valores de cualquier columna en particular.

- KEY: Los datos se distribuyen de acuerdo con los valores de una columna.

- ALL: Se distribuye una copia de toda la tabla a cada nodo de cómputo.

Los candidatos ideales deben ser capaces de explicar cuándo es más apropiado cada estilo. Por ejemplo, la distribución KEY es útil para las operaciones de unión (join), mientras que ALL es mejor para tablas de dimensiones más pequeñas que se unen con frecuencia a tablas de hechos más grandes.

3. ¿Cómo optimizaría el rendimiento de las consultas en RedShift?

Optimizar el rendimiento de las consultas en RedShift implica varias estrategias:

- Elegir la clave de clasificación y el estilo de distribución correctos

- Usar codificaciones de compresión apropiadas

- Vaciar y analizar tablas regularmente

- Evitar consultas entre regiones

- Usar tipos de datos de columna apropiados

- Aprovechar RedShift Spectrum para tablas externas

Busque candidatos que puedan explicar estos conceptos y proporcionar ejemplos de cómo los han implementado. Las respuestas sólidas también podrían mencionar herramientas de monitoreo como AWS CloudWatch para identificar cuellos de botella en el rendimiento.

4. ¿Cuál es la diferencia entre RedShift Spectrum y RedShift estándar?

RedShift Spectrum es una extensión de RedShift que le permite ejecutar consultas SQL directamente en exabytes de datos no estructurados en Amazon S3, sin tener que cargar o transformar los datos primero.

RedShift estándar, por otro lado, requiere que los datos se carguen en su propio almacenamiento administrado antes de poder consultarlos. Spectrum es ideal para consultar datos que no cambian con frecuencia o para datos que son demasiado grandes para cargarlos prácticamente en RedShift.

Los candidatos fuertes deberían poder discutir los casos de uso de cada uno y explicar cómo Spectrum puede complementar a RedShift estándar en una estrategia de almacenamiento de datos.

5. ¿Cómo maneja RedShift la seguridad y el cifrado de datos?

RedShift proporciona varias capas de seguridad:

- Cifrado en reposo utilizando cifrado AES-256

- Cifrado en tránsito utilizando SSL

- Control de acceso a nivel de columna

- Aislamiento de red VPC

- AWS Identity and Access Management (IAM) para el control de acceso

- AWS CloudTrail para la auditoría

Busque candidatos que puedan explicar estas características y discutir las mejores prácticas para implementar una estrategia de seguridad integral en RedShift. También deben estar al tanto de las certificaciones de cumplimiento que RedShift admite.

6. ¿Cuál es el propósito de WLM (Gestión de Carga de Trabajo) en RedShift?

La Gestión de Carga de Trabajo (WLM) en RedShift se utiliza para gestionar el rendimiento del sistema y la experiencia del usuario cuando se ejecutan múltiples consultas simultáneamente. Permite definir múltiples colas de consultas y enrutar las consultas a las colas apropiadas en función de los grupos de usuarios o de las consultas.

WLM ayuda a:

- Priorizar las consultas importantes

- Evitar que las consultas de larga duración dominen los recursos del sistema

- La ejecución simultánea de consultas cortas y largas

Los candidatos fuertes deben ser capaces de explicar cómo han utilizado WLM para optimizar el rendimiento del clúster y gestionar diversas cargas de trabajo. También podrían mencionar la función WLM automática y sus beneficios.

7. ¿Cómo se integra RedShift con otros servicios de AWS?

RedShift se integra perfectamente con varios servicios de AWS, mejorando sus capacidades y facilidad de uso:

- S3: para la carga y descarga de datos

- Glue: para los procesos ETL

- Athena: para consultas federadas

- QuickSight: para la visualización

- Kinesis: para la ingestión de datos en streaming

- Lambda: para la automatización de tareas

- CloudWatch: para la supervisión

Busque candidatos que puedan proporcionar ejemplos de cómo han aprovechado estas integraciones en escenarios del mundo real. Las respuestas sólidas podrían discutir los beneficios de este enfoque de ecosistema en la construcción de soluciones integrales de ingeniería de datos.

8. ¿Cuáles son algunas de las mejores prácticas para diseñar tablas en RedShift?

Al diseñar tablas en RedShift, se deben considerar varias prácticas recomendadas:

- Elija claves de distribución apropiadas para minimizar el movimiento de datos

- Use claves de ordenamiento para mejorar el rendimiento de las consultas

- Use codificaciones de compresión apropiadas

- Implemente la compresión a nivel de columna

- Use tipos de datos apropiados para minimizar el almacenamiento

- Desnormalice los datos cuando sea apropiado para el rendimiento

Los candidatos ideales deberían poder explicar el razonamiento detrás de estas prácticas y proporcionar ejemplos de cómo las han implementado. También deberían ser capaces de discutir las compensaciones involucradas en las diferentes decisiones de diseño.

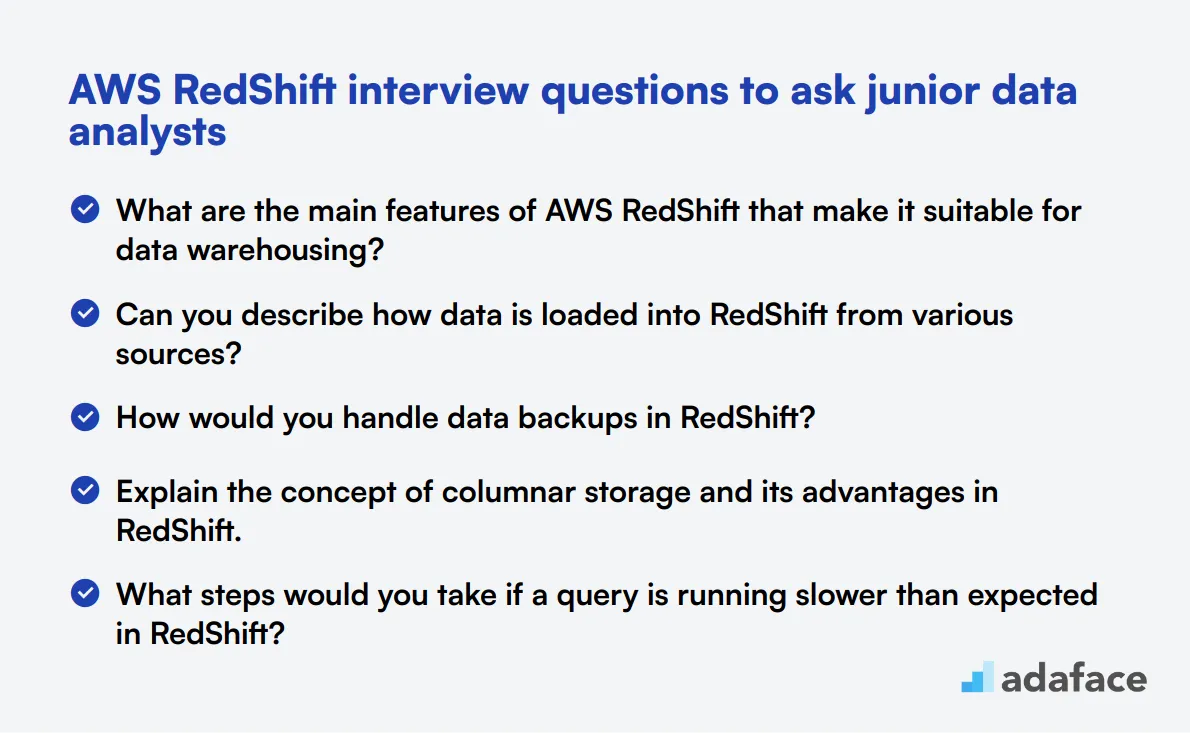

20 preguntas de entrevista de AWS RedShift para hacer a analistas de datos junior

Para asegurar que sus candidatos a analistas de datos junior tengan una sólida comprensión de AWS RedShift, use esta lista de preguntas específicas durante las entrevistas. Estas preguntas le ayudarán a evaluar sus habilidades técnicas y su comprensión de los conceptos clave, asegurando que estén listos para afrontar los desafíos del puesto. Para obtener más detalles sobre las responsabilidades típicas de un analista de datos, consulte esta descripción del puesto.

- ¿Cuáles son las principales características de AWS RedShift que lo hacen adecuado para el almacenamiento de datos?

- ¿Puede describir cómo se cargan los datos en RedShift desde varias fuentes?

- ¿Cómo manejaría las copias de seguridad de datos en RedShift?

- Explique el concepto de almacenamiento columnar y sus ventajas en RedShift.

- ¿Qué pasos tomaría si una consulta se ejecuta más lentamente de lo esperado en RedShift?

- ¿Cómo monitorea y mantiene el rendimiento de un clúster RedShift?

- Describa un caso de uso donde RedShift sería una mejor opción que otras bases de datos de AWS.

- ¿Cómo maneja RedShift la concurrencia y asegura que múltiples consultas se ejecuten eficientemente?

- ¿Puede explicar el proceso de cambio de tamaño de un clúster RedShift y por qué podría ser necesario?

- ¿Cuáles son los diferentes tipos de nodos en RedShift y cómo afectan el rendimiento?

- ¿Cómo gestiona y optimiza el uso del espacio en disco en RedShift?

- ¿Cuáles son los beneficios de usar los servicios de vacuuming y análisis automáticos de RedShift?

- Describa cómo implementaría los procesos ETL con RedShift.

- ¿Cómo gestiona los permisos de usuario y los controles de acceso en RedShift?

- ¿Qué estrategias utilizaría para particionar datos en RedShift?

- ¿Cómo manejaría la migración de datos desde una base de datos local a RedShift?

- Explique el papel de las claves de distribución de datos en RedShift y cómo elegirlas.

- ¿Qué métodos se pueden utilizar para garantizar la integridad y la consistencia de los datos en RedShift?

- ¿Puede describir cómo usar las funciones de registro de auditoría de RedShift?

- ¿Cómo aborda la solución de problemas comunes en RedShift?

10 preguntas y respuestas intermedias de entrevista de AWS RedShift para preguntar a ingenieros de datos de nivel medio.

Para determinar si sus solicitantes tienen las habilidades adecuadas para administrar y optimizar AWS RedShift, hágales algunas de estas 10 preguntas intermedias de entrevista de AWS RedShift. Estas preguntas le ayudarán a evaluar sus conocimientos prácticos y habilidades de resolución de problemas esenciales para ingenieros de datos de nivel medio.

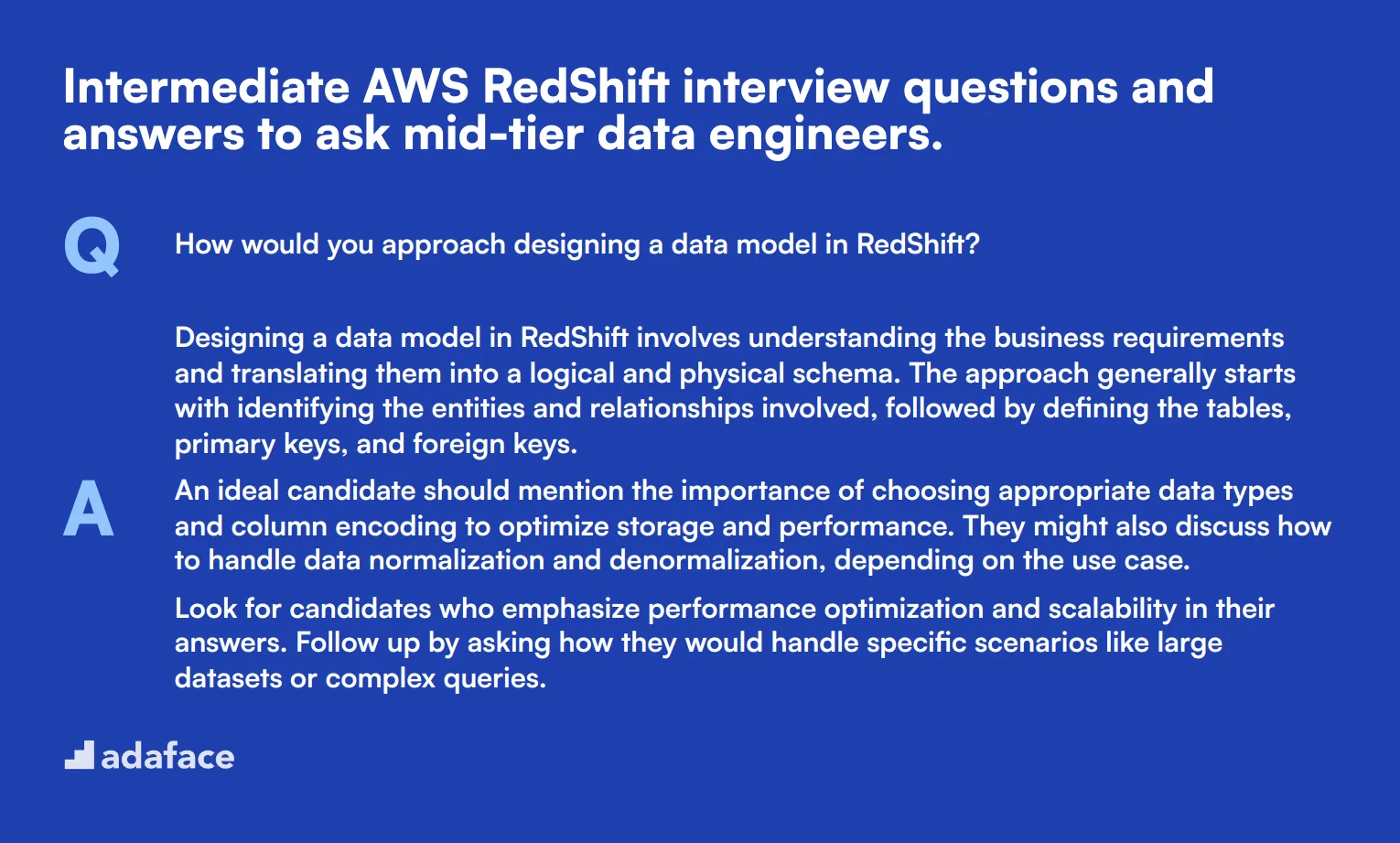

1. ¿Cómo abordaría el diseño de un modelo de datos en RedShift?

El diseño de un modelo de datos en RedShift implica comprender los requisitos del negocio y traducirlos en un esquema lógico y físico. El enfoque generalmente comienza con la identificación de las entidades y relaciones involucradas, seguido de la definición de las tablas, claves primarias y claves externas.

Un candidato ideal debería mencionar la importancia de elegir tipos de datos y codificación de columnas apropiados para optimizar el almacenamiento y el rendimiento. También podrían discutir cómo manejar la normalización y desnormalización de datos, dependiendo del caso de uso.

Busque candidatos que enfaticen la optimización del rendimiento y la escalabilidad en sus respuestas. Haga un seguimiento preguntando cómo manejarían escenarios específicos como conjuntos de datos grandes o consultas complejas.

2. Explique cómo implementaría y administraría los índices en RedShift.

En RedShift, los índices funcionan de manera diferente en comparación con las bases de datos tradicionales. El mecanismo principal para la indexación es a través de claves de clasificación y claves de distribución. Las claves de clasificación ayudan a acelerar el rendimiento de las consultas al pre-clasificar los datos, mientras que las claves de distribución determinan cómo se distribuyen los datos entre los nodos.

Los candidatos deben explicar cómo elegir las claves de clasificación en función de los patrones de consulta, como el uso de claves de clasificación compuestas para consultas que filtran en múltiples columnas. También deben discutir la selección de claves de distribución para equilibrar los datos de manera uniforme entre los nodos, minimizando el movimiento de datos durante la ejecución de la consulta.

Las respuestas sólidas incluirán consideraciones para tareas de mantenimiento como aspirar y analizar tablas para mantener los índices efectivos. Busque candidatos que puedan articular estos conceptos claramente y que tengan experiencia práctica en la gestión de índices en RedShift.

3. ¿Cómo manejaría la compresión de datos en RedShift?

La compresión de datos en RedShift es un aspecto vital de la optimización del almacenamiento y la mejora del rendimiento de las consultas. RedShift admite varias codificaciones de compresión, como LZO, Zstandard y Run Length Encoding (RLE), entre otras.

Los candidatos deben discutir el uso del comando ANALYZE COMPRESSION para determinar la mejor codificación de compresión para cada columna. También deben mencionar cómo aplicar la compresión al crear o modificar tablas y los beneficios de usar diferentes tipos de codificación según las características de los datos de la columna.

Busque candidatos que puedan explicar las compensaciones entre los diferentes métodos de compresión y su impacto en el rendimiento. Haga un seguimiento preguntando cómo han implementado la compresión en proyectos anteriores.

4. ¿Cuáles son los pasos para garantizar la alta disponibilidad y la recuperación ante desastres en RedShift?

Garantizar la alta disponibilidad en RedShift implica configurar clústeres en múltiples Zonas de Disponibilidad (AZ) y usar características como la conmutación por error automática. La recuperación ante desastres puede gestionarse mediante snapshots automatizados y copias de snapshots entre regiones.

Los candidatos deben explicar cómo configurar snapshots automatizados y definir los periodos de retención de snapshots. También podrían discutir la configuración de la replicación entre regiones para asegurar que los datos estén disponibles incluso en caso de una interrupción regional.

Las respuestas ideales incluirán un enfoque en las pruebas y la validación regulares de los planes de recuperación ante desastres. Busque candidatos que tengan experiencia con estas características y puedan proporcionar ejemplos de cómo las han implementado en roles anteriores.

5. ¿Cómo supervisa y soluciona problemas de rendimiento en RedShift?

La supervisión del rendimiento en RedShift implica el uso de herramientas como AWS CloudWatch, la consola de RedShift y las tablas del sistema para rastrear métricas como la utilización de la CPU, el uso del espacio en disco y el rendimiento de las consultas.

Los candidatos deben mencionar el uso de las tablas del sistema STL y SVV para diagnosticar problemas de rendimiento. También podrían discutir la configuración de alarmas en CloudWatch para métricas específicas y el uso de la Consola de gestión de AWS para visualizar las tendencias de rendimiento.

Busque explicaciones detalladas de los pasos de resolución de problemas, como la identificación de consultas de ejecución lenta y la aplicación de optimizaciones. Haga un seguimiento preguntando sobre escenarios específicos en los que hayan resuelto cuellos de botella de rendimiento.

6. ¿Puede explicar la importancia de los estilos de distribución de datos en RedShift y cómo elegir el correcto?

Los estilos de distribución de datos en RedShift, como EVEN, KEY y ALL, determinan cómo se distribuyen los datos entre los nodos. Estos estilos impactan el rendimiento de las consultas y los tiempos de carga de datos.

Los candidatos deben explicar los escenarios en los que cada estilo de distribución es apropiado. Por ejemplo, usar la distribución EVEN para tablas sin una clave de distribución clara o la distribución KEY para tablas con joins frecuentes en una columna específica. La distribución ALL podría usarse para tablas más pequeñas y con joins frecuentes.

Las respuestas sólidas incluirán ejemplos prácticos y consideraciones para elegir el estilo de distribución correcto. Busque candidatos que puedan articular el impacto de estas elecciones en el rendimiento y la escalabilidad.

7. Describa cómo gestionaría las consultas concurrentes en RedShift.

La gestión de consultas concurrentes en RedShift implica configurar la configuración de Gestión de Carga de Trabajo (WLM) para asignar recursos de manera efectiva. Esto incluye definir colas de consultas y configurar la asignación de memoria y la configuración de tiempo de espera.

Los candidatos deben discutir cómo crear diferentes colas WLM para diferentes tipos de cargas de trabajo, como consultas de corta y larga duración. También podrían mencionar el establecimiento de límites de concurrencia y el uso de las tablas del sistema WLM para supervisar y ajustar la configuración de WLM.

Busque candidatos que tengan experiencia práctica en la configuración de WLM y puedan proporcionar ejemplos de optimización de la concurrencia en entornos de producción. Haga un seguimiento preguntando cómo manejarían problemas específicos de concurrencia.

8. ¿Cuáles son los beneficios y las limitaciones de usar RedShift Spectrum?

RedShift Spectrum permite consultar datos almacenados en S3 sin cargarlos en RedShift. Esto es beneficioso para acceder a conjuntos de datos grandes y de acceso poco frecuente e integrar RedShift con otros servicios de análisis de AWS.

Los candidatos deben explicar los beneficios, como el ahorro de costos al reducir la necesidad de almacenamiento extenso en RedShift y la capacidad de consultar datos en formatos abiertos como Parquet y ORC. También deben mencionar limitaciones como posibles compensaciones de rendimiento y la necesidad de una gestión adecuada del esquema en las tablas externas.

Busque candidatos que puedan articular cuándo usar RedShift Spectrum de manera efectiva y proporcionar ejemplos de su uso en escenarios del mundo real. Haga un seguimiento preguntando sobre su experiencia con la integración de RedShift Spectrum en sus proyectos.

9. ¿Cómo se gestionan los cambios de esquema en una base de datos RedShift?

La gestión de los cambios de esquema en RedShift implica la planificación y ejecución de actualizaciones con la mínima interrupción del entorno de producción. Esto incluye la alteración de tablas, la adición o eliminación de columnas y la actualización de índices.

Los candidatos deben discutir técnicas como el uso de tablas temporales para realizar cambios de esquema y luego intercambiarlas con las tablas existentes. También podrían mencionar la importancia de hacer copias de seguridad de los datos antes de realizar cambios significativos en el esquema y el uso del comando ALTER TABLE.

Las respuestas sólidas se centrarán en minimizar el tiempo de inactividad y garantizar la integridad de los datos. Busque candidatos que tengan experiencia en la gestión de cambios de esquema y puedan proporcionar ejemplos de cómo han gestionado estos cambios de forma eficaz.

10. Explique cómo utiliza los servicios de vacuuming y análisis de RedShift para mantener el rendimiento de la base de datos.

Vacuuming y el análisis son tareas de mantenimiento esenciales en RedShift para recuperar espacio en disco y optimizar el rendimiento de las consultas. El comando VACUUM ayuda a reorganizar los datos y eliminar las filas eliminadas, mientras que el comando ANALYZE actualiza las estadísticas de la tabla.

Los candidatos deben explicar los diferentes tipos de vacuuming, como FULL, SORT ONLY y DELETE ONLY, y sus casos de uso adecuados. También podrían discutir la programación de estas tareas durante las horas de menor actividad y el uso de scripts automatizados o AWS Data Pipeline para el mantenimiento regular.

Busque candidatos que puedan articular los beneficios de estas tareas y proporcionar ejemplos de su implementación para mantener el rendimiento de la base de datos. Haga un seguimiento preguntando cómo monitorean la efectividad de vacuuming y el análisis.

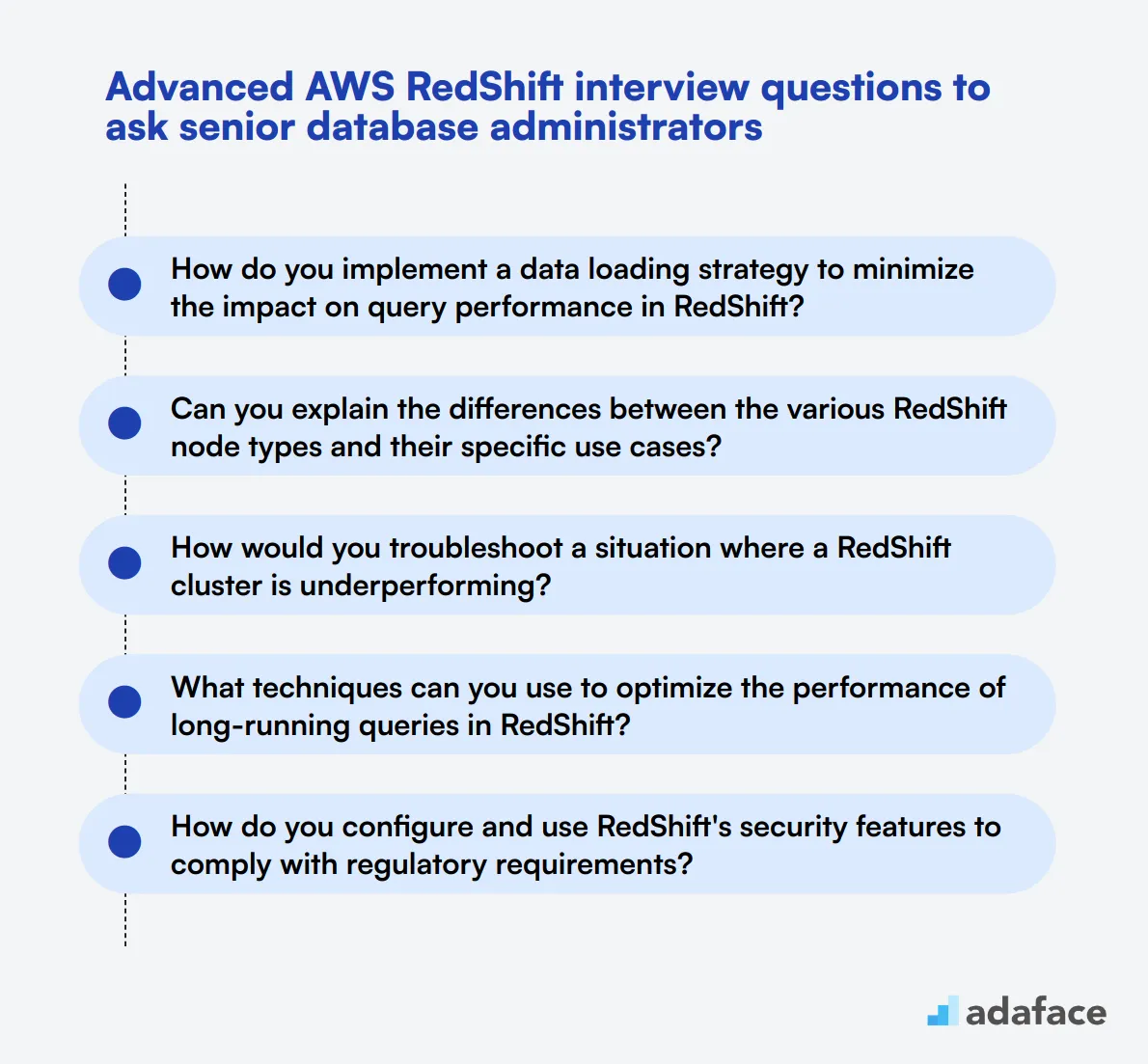

10 preguntas avanzadas de entrevista sobre AWS RedShift para hacer a administradores de bases de datos senior

Para evaluar la experiencia técnica avanzada de los candidatos para roles de AWS RedShift, use esta lista concisa de preguntas de entrevista. Estas preguntas están diseñadas para descubrir la profundidad del conocimiento y la experiencia práctica de un candidato en la gestión de entornos de bases de datos complejos. Esto puede ayudar a garantizar que encuentre la opción adecuada para la descripción del puesto de administrador de bases de datos.

- ¿Cómo implementa una estrategia de carga de datos para minimizar el impacto en el rendimiento de las consultas en RedShift?

- ¿Puede explicar las diferencias entre los diversos tipos de nodos de RedShift y sus casos de uso específicos?

- ¿Cómo solucionaría una situación en la que un clúster RedShift no está funcionando correctamente?

- ¿Qué técnicas puede utilizar para optimizar el rendimiento de las consultas de larga duración en RedShift?

- ¿Cómo configura y utiliza las funciones de seguridad de RedShift para cumplir con los requisitos reglamentarios?

- ¿Cuál es el proceso para actualizar un clúster RedShift existente y qué consideraciones tiene en cuenta?

- ¿Puede describir cómo abordaría la gestión de grandes conjuntos de datos en RedShift, particularmente en lo que respecta a la carga y el rendimiento de las consultas?

- ¿Cuáles son los posibles impactos de usar demasiadas claves de ordenamiento o claves de distribución en RedShift, y cómo los mitigaría?

- ¿Cómo aborda la planificación de la capacidad de un clúster RedShift en función del crecimiento y los patrones de uso esperados?

- ¿Puede explicar cómo RedShift maneja las tablas temporales y sus implicaciones para el rendimiento y el almacenamiento?

9 preguntas y respuestas de entrevista de AWS RedShift relacionadas con conceptos de almacenamiento de datos

Para asegurarse de que sus candidatos comprendan los conceptos esenciales de almacenamiento de datos dentro de AWS RedShift, utilice estas preguntas de entrevista. Esta lista le ayudará a determinar si tienen el conocimiento necesario para manejar tareas de almacenamiento de datos de manera efectiva, asegurándose de que están listos para enfrentar desafíos del mundo real.

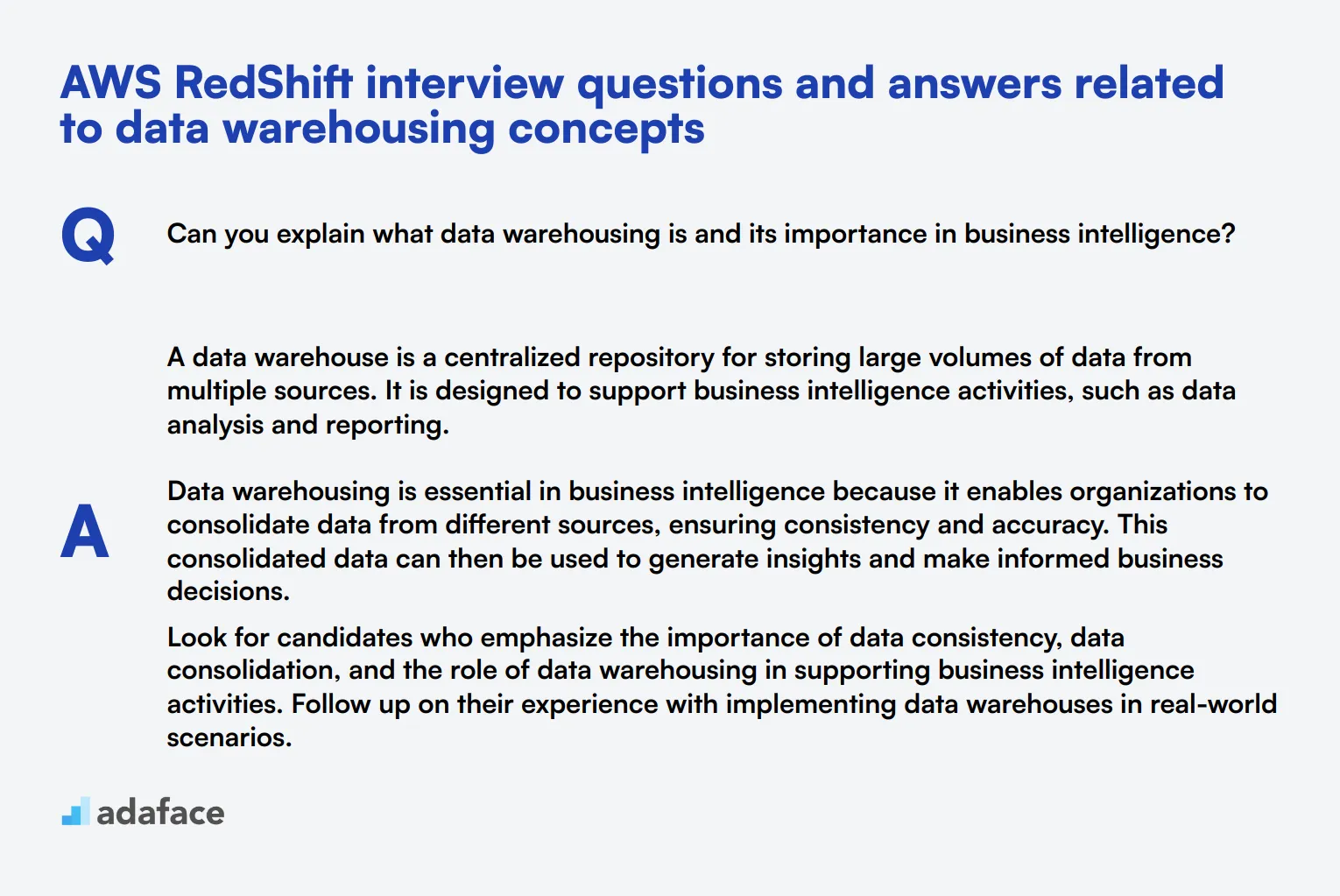

1. ¿Puede explicar qué es el almacenamiento de datos y su importancia en la inteligencia empresarial?

Un almacén de datos es un repositorio centralizado para almacenar grandes volúmenes de datos de múltiples fuentes. Está diseñado para apoyar actividades de inteligencia empresarial, como el análisis de datos y la generación de informes.

El almacenamiento de datos es esencial en la inteligencia empresarial porque permite a las organizaciones consolidar datos de diferentes fuentes, garantizando la coherencia y la precisión. Estos datos consolidados se pueden utilizar para generar información y tomar decisiones comerciales informadas.

Busque candidatos que enfaticen la importancia de la coherencia de los datos, la consolidación de datos y el papel del almacenamiento de datos en el apoyo a las actividades de inteligencia empresarial. Haga un seguimiento de su experiencia con la implementación de almacenes de datos en escenarios del mundo real.

2. ¿Cuáles son los componentes clave de una arquitectura de almacén de datos?

Los componentes clave de una arquitectura de almacén de datos incluyen la capa de origen de datos, el área de preparación de datos, la capa de almacenamiento de datos y la capa de presentación de datos.

-

Capa de origen de datos: Aquí es donde se extraen los datos de varias fuentes, como bases de datos, archivos planos o aplicaciones.

-

Área de preparación de datos: Aquí es donde los datos se limpian, transforman y cargan en el almacén de datos.

-

Capa de almacenamiento de datos: Este es el repositorio central donde se almacenan los datos, a menudo utilizando un sistema de gestión de bases de datos relacionales.

-

Capa de presentación de datos: Aquí es donde se accede y analiza la información mediante herramientas de inteligencia empresarial.

Un candidato ideal debe ser capaz de explicar cada componente y su función dentro de la arquitectura. También deben proporcionar ejemplos de la vida real de cómo han trabajado con cada componente.

3. ¿Cómo se asegura la calidad de los datos en un data warehouse?

Asegurar la calidad de los datos en un data warehouse implica varias prácticas como el perfilado de datos, la limpieza de datos, la validación de datos y el monitoreo continuo.

-

Perfilado de datos: Analizar datos de diversas fuentes para comprender su estructura, contenido y calidad.

-

Limpieza de datos: Identificar y rectificar errores o inconsistencias en los datos.

-

Validación de datos: Verificar que los datos cargados en el data warehouse cumplen con los criterios de calidad predefinidos.

-

Monitoreo continuo: Monitorear continuamente la calidad de los datos para identificar y abordar cualquier problema de manera oportuna.

Los candidatos fuertes discutirán su experiencia con estas prácticas y pueden proporcionar ejemplos de herramientas que han utilizado para el perfilado y la limpieza de datos. Busque su capacidad para articular un enfoque claro y sistemático para mantener la calidad de los datos.

4. ¿Cuál es la diferencia entre los sistemas OLTP y OLAP, y cómo se relaciona esto con el almacenamiento de datos (data warehousing)?

Los sistemas OLTP (Procesamiento de Transacciones en Línea) están diseñados para gestionar datos transaccionales y respaldar las operaciones diarias. Se centran en el procesamiento rápido de consultas y en el mantenimiento de la integridad de los datos en entornos de acceso múltiple.

Los sistemas OLAP (Procesamiento Analítico en Línea), por otro lado, están diseñados para consultar y analizar grandes volúmenes de datos. Apoyan consultas complejas y se utilizan principalmente en el almacenamiento de datos (data warehousing) para inteligencia empresarial y generación de informes.

Los candidatos deben destacar que los sistemas OLTP están optimizados para consultas transaccionales, mientras que los sistemas OLAP están optimizados para consultas analíticas. Se busca una comprensión de cómo los datos de los sistemas OLTP se transforman y se cargan en los sistemas OLAP para su análisis.

5. ¿Puede explicar el concepto de ETL y su papel en el almacenamiento de datos?

ETL significa Extraer, Transformar, Cargar. Es un proceso utilizado para mover datos de múltiples fuentes a un almacén de datos.

-

Extraer: Recuperar datos de diferentes sistemas fuente.

-

Transformar: Convertir los datos extraídos en un formato adecuado para el análisis, lo que puede incluir la limpieza, agregación y resumen de datos.

-

Cargar: Cargar los datos transformados en el almacén de datos para su almacenamiento y análisis.

Un candidato ideal debe explicar cómo ETL asegura que los datos se muevan de forma precisa y eficiente al almacén de datos. Busque su experiencia con herramientas ETL y su capacidad para discutir los desafíos específicos que han enfrentado y superado en los procesos ETL.

6. ¿Cuáles son algunos desafíos comunes del almacenamiento de datos y cómo los aborda?

Los desafíos comunes del almacenamiento de datos incluyen la integración de datos, la calidad de los datos, la escalabilidad y el rendimiento.

-

Integración de datos: Combinar datos de varias fuentes puede ser complejo. Aborde esto utilizando procesos ETL robustos y herramientas de integración de datos.

-

Calidad de los datos: Asegurar una alta calidad de los datos es fundamental. Implemente técnicas de perfilado, limpieza y validación de datos.

-

Escalabilidad: A medida que aumentan los volúmenes de datos, el almacén debe escalar. Utilice arquitecturas y tecnologías escalables como AWS RedShift.

-

Rendimiento: Optimizar el rendimiento de las consultas es fundamental. La indexación, el particionamiento y las técnicas de optimización de consultas pueden ayudar.

Los candidatos deben demostrar una comprensión profunda de estos desafíos y discutir su experiencia al abordarlos. Busque ejemplos específicos y soluciones que hayan implementado en roles anteriores.

7. ¿Cómo el almacenamiento de datos apoya la toma de decisiones en una organización?

El almacenamiento de datos apoya la toma de decisiones al proporcionar un repositorio central de datos integrados de diversas fuentes. Esto permite un análisis y generación de informes de datos completos.

Con un almacén de datos, las organizaciones pueden generar informes precisos y oportunos, identificar tendencias y patrones, y tomar decisiones basadas en datos. Esto conduce a una mayor eficiencia operativa, mejores conocimientos sobre los clientes y planificación estratégica.

Busque candidatos que puedan articular la relación directa entre el almacenamiento de datos y los resultados comerciales. Deben proporcionar ejemplos de cómo el almacenamiento de datos ha mejorado la toma de decisiones en sus roles anteriores.

8. ¿Cuál es el papel de los metadatos en el almacenamiento de datos?

Los metadatos en el almacenamiento de datos son datos sobre datos. Proporcionan información sobre la fuente, la estructura, las transformaciones y el uso de los datos.

Los metadatos ayudan a los usuarios a comprender el contexto y el linaje de los datos, lo que facilita su gestión, uso y análisis. También respaldan la gobernanza de datos y garantizan la consistencia en todo el almacén de datos.

Los candidatos deben explicar la importancia de los metadatos para garantizar la calidad y la usabilidad de los datos. Busque su experiencia con herramientas de gestión de metadatos y su capacidad para discutir cómo han utilizado los metadatos para mejorar los procesos de almacenamiento de datos.

9. ¿Puede describir el proceso de modelado de datos en el almacenamiento de datos?

El modelado de datos en el almacenamiento de datos implica diseñar la estructura del almacén de datos para soportar el almacenamiento y la recuperación eficientes de datos. Esto incluye la creación de esquemas, tablas y relaciones entre tablas.

Hay dos tipos principales de modelos de datos: Esquema de Estrella y Esquema de Copo de Nieve. El Esquema de Estrella tiene una tabla de hechos central conectada a tablas de dimensiones, mientras que el Esquema de Copo de Nieve normaliza las tablas de dimensiones en múltiples tablas relacionadas.

Busque candidatos que puedan explicar estos esquemas y sus casos de uso. Deben discutir su experiencia con herramientas y técnicas de modelado de datos y proporcionar ejemplos de modelos de datos que hayan diseñado en roles anteriores.

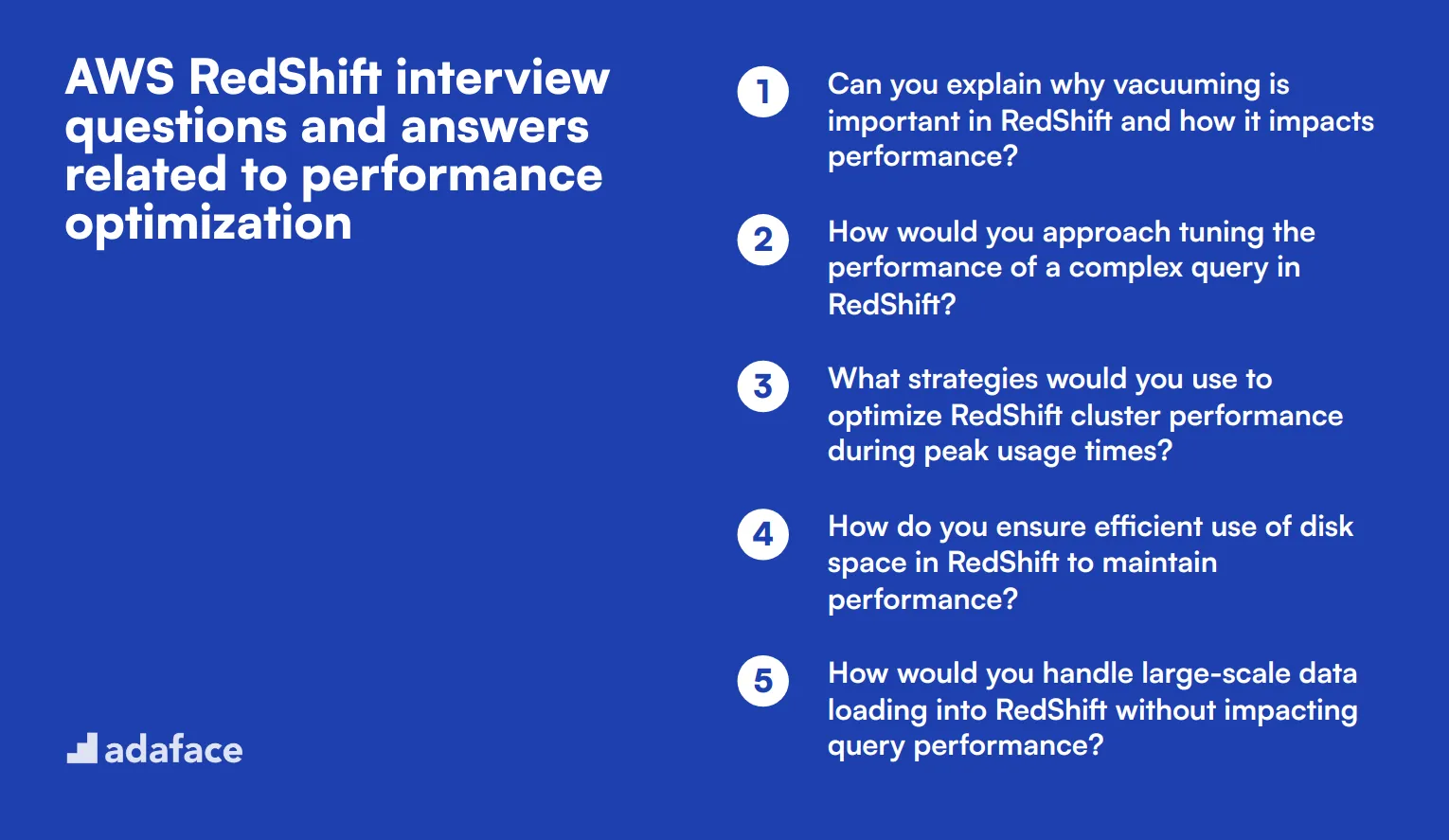

7 preguntas y respuestas de entrevista de AWS RedShift relacionadas con la optimización del rendimiento

Para evaluar si sus candidatos tienen las habilidades adecuadas para optimizar el rendimiento de AWS RedShift, profundice en estas 7 preguntas de entrevista. Estas preguntas están diseñadas para ayudarle a identificar su comprensión de las estrategias y enfoques clave de optimización del rendimiento para RedShift.

1. ¿Puede explicar por qué el vacuuming es importante en RedShift y cómo impacta el rendimiento?

El vacuuming en RedShift es crucial porque ayuda a recuperar espacio y ordenar datos. Con el tiempo, a medida que se insertan, actualizan o eliminan datos, se pueden crear huecos y fragmentación dentro de las tablas. El vacuuming organiza los datos, elimina las filas eliminadas y asegura que los datos se almacenen en bloques contiguos.

Un candidato debe explicar que el vacuuming regular puede conducir a un procesamiento de consultas más eficiente, ya que la base de datos puede leer los datos más rápidamente cuando están bien organizados. Busque candidatos que enfaticen la importancia de programar las operaciones de vacuuming durante los períodos de bajo uso para minimizar el impacto en el rendimiento de los usuarios activos.

2. ¿Cómo abordaría la optimización del rendimiento de una consulta compleja en RedShift?

Para optimizar el rendimiento de una consulta compleja en RedShift, se debe comenzar por analizar el plan de ejecución de la consulta para identificar cuellos de botella. Esto implica examinar los estilos de distribución de datos, las claves de clasificación y el uso de índices apropiados.

La optimización de consultas complejas también puede implicar la división de la consulta en partes más pequeñas y manejables, el uso de tablas temporales para almacenar resultados intermedios y evitar operaciones costosas como cruces (cross joins) y agregaciones grandes. Un candidato ideal debería discutir la importancia de monitorear regularmente el rendimiento de las consultas y ajustar las estrategias en función de los cambios en los datos y los patrones de uso.

3. ¿Qué estrategias utilizaría para optimizar el rendimiento del clúster de RedShift durante los momentos de uso pico?

Durante los momentos de uso pico, las estrategias de optimización del rendimiento para un clúster de RedShift incluyen escalar el clúster agregando más nodos, optimizar las cargas de trabajo de las consultas a través de la Gestión de Cargas de Trabajo (WLM) y asegurar una distribución eficiente de los datos para evitar el sesgo de datos.

Los candidatos también deben mencionar la importancia de monitorear las métricas de rendimiento del sistema y gestionar proactivamente las colas de recursos para asegurar que las consultas de alta prioridad obtengan los recursos necesarios. Busque respuestas que resalten el uso de herramientas de escalado y ajuste automatizados proporcionadas por AWS para gestionar los recursos de manera eficiente.

4. ¿Cómo asegura el uso eficiente del espacio en disco en RedShift para mantener el rendimiento?

El uso eficiente del espacio en disco en RedShift se puede asegurar mediante el uso de codificaciones de compresión para reducir la huella de almacenamiento y mediante la eliminación regular de datos innecesarios y la recuperación de espacio a través de procesos de limpieza (vacuuming).

Los candidatos también deben discutir la importancia de monitorear el uso del espacio en disco y ajustar las claves de distribución y clasificación para optimizar el almacenamiento de datos. Una respuesta ideal incluiría estrategias para el monitoreo continuo y la gestión proactiva para evitar que los problemas de espacio en disco afecten el rendimiento.

5. ¿Cómo manejaría la carga de datos a gran escala en RedShift sin afectar el rendimiento de las consultas?

Para manejar la carga de datos a gran escala en RedShift sin afectar el rendimiento de las consultas, se debe usar el comando COPY con la configuración adecuada, como especificar el formato de archivo correcto y usar el paralelismo para distribuir la carga en múltiples nodos.

Los candidatos deben mencionar la preparación de los datos en Amazon S3, el uso de compresión de datos y evitar índices y restricciones innecesarios durante la carga inicial. Una respuesta ideal también cubriría la importancia de realizar la validación y las comprobaciones de calidad de los datos antes de la carga final para garantizar la integridad de los datos.

6. ¿Cuál es el papel de las claves de ordenación (sort keys) en RedShift y cómo afectan el rendimiento de las consultas?

Las claves de ordenación (sort keys) en RedShift determinan el orden en el que los datos se almacenan físicamente dentro de una tabla. Juegan un papel importante en la optimización del rendimiento de las consultas, especialmente para las consultas que involucran escaneos de rango restringido o aquellas que filtran en las columnas de claves de ordenación.

Los candidatos deben explicar que elegir la clave de ordenación correcta puede reducir drásticamente la cantidad de datos escaneados por una consulta, lo que lleva a un rendimiento de consulta más rápido. Una respuesta ideal del candidato incluiría una discusión sobre los tipos de claves de ordenación (compuestas e intercaladas) y sus casos de uso específicos.

7. ¿Cómo gestiona y optimiza la gestión de la carga de trabajo (WLM) en RedShift?

Gestionar y optimizar la gestión de la carga de trabajo (WLM) en RedShift implica configurar las colas de WLM para asignar recursos de manera efectiva en función de las prioridades de las consultas. Esto se puede lograr configurando diferentes colas para diferentes tipos de cargas de trabajo, como consultas de corta duración y procesos ETL de larga duración.

Los candidatos deben discutir la importancia de monitorear el uso de la cola y ajustar las configuraciones en función de las métricas de rendimiento. Una respuesta ideal incluiría estrategias para equilibrar la asignación de recursos, gestionar la concurrencia y garantizar que las consultas críticas obtengan los recursos necesarios sin ser retrasadas por tareas de menor prioridad.

¿Qué habilidades de AWS RedShift debería evaluar durante la fase de entrevista?

Si bien es imposible evaluar todos los aspectos de la experiencia de un candidato en AWS RedShift en una sola entrevista, centrarse en las habilidades principales puede proporcionar información valiosa. Para las entrevistas de AWS RedShift, ciertas áreas clave merecen una atención especial para evaluar la competencia y el potencial de un candidato.

SQL y almacenamiento de datos

La competencia en SQL es fundamental para trabajar con AWS RedShift, ya que es el lenguaje principal para consultar y manipular datos. Una sólida comprensión de los conceptos de almacenamiento de datos también es crucial para comprender la arquitectura de RedShift y optimizar su rendimiento.

Para evaluar esta habilidad, considere usar una prueba de codificación SQL que incluya preguntas específicas de RedShift. Esto puede ayudar a filtrar a los candidatos en función de sus conocimientos prácticos de SQL y su comprensión del almacenamiento de datos.

Durante la entrevista, puede hacer preguntas específicas para evaluar el conocimiento de SQL y el almacenamiento de datos del candidato. Aquí hay una pregunta de ejemplo:

¿Puede explicar la diferencia entre un esquema de estrella y un esquema de copo de nieve en el almacenamiento de datos, y cuándo podría elegir uno sobre el otro en un entorno AWS RedShift?

Busque respuestas que demuestren la comprensión de los conceptos de modelado dimensional y su aplicación en RedShift. Una buena respuesta debe cubrir la estructura de cada esquema, sus pros y sus contras, y las consideraciones para el rendimiento de las consultas y la integridad de los datos en RedShift.

Optimización del rendimiento

La optimización del rendimiento de RedShift es clave para mantener soluciones de almacenamiento de datos eficientes y rentables. Los candidatos deben estar familiarizados con las características únicas de RedShift y las mejores prácticas para la optimización de consultas y la distribución de datos.

Para evaluar el conocimiento de la optimización del rendimiento de un candidato, considere hacer una pregunta como esta:

¿Qué estrategias emplearía para mejorar el rendimiento de las consultas en AWS RedShift y cómo identificaría los cuellos de botella del rendimiento?

Busque respuestas que mencionen técnicas como la selección adecuada de la clave de distribución, la optimización de la clave de clasificación, las operaciones de vacuum y análisis, y el uso del plan de consulta y las tablas del sistema de RedShift para el análisis del rendimiento. Los candidatos fuertes también podrían discutir la configuración de la gestión de la carga de trabajo (WLM) y el escalado de la concurrencia.

ETL e Integración de Datos

El uso eficaz de AWS RedShift a menudo implica la integración de datos de diversas fuentes. Comprender los procesos ETL y cómo cargar datos de manera eficiente en RedShift es crucial para mantener un almacén de datos robusto.

Para evaluar el conocimiento de un candidato sobre ETL e integración de datos, podría preguntar:

¿Cómo diseñaría un proceso ETL para cargar grandes volúmenes de datos en AWS RedShift desde S3, garantizando un rendimiento óptimo y la integridad de los datos?

Las respuestas sólidas deben cubrir el uso del comando COPY, la compresión de datos, las tablas de almacenamiento provisional y las técnicas de carga paralela. Los candidatos también podrían discutir la validación de datos, el manejo de errores y el uso de servicios de AWS como Glue o Data Pipeline para orquestar el proceso ETL.

3 consejos para usar las preguntas de la entrevista de AWS RedShift

Antes de comenzar a implementar lo que ha aprendido, aquí están nuestros mejores consejos para usar eficazmente las preguntas de la entrevista de AWS RedShift.

1. Incorpore pruebas de habilidades antes de las entrevistas

Usar pruebas de habilidades antes de las entrevistas puede ayudar a filtrar a los candidatos que carecen de las habilidades técnicas necesarias. Este paso asegura que solo los candidatos calificados avancen en el proceso de contratación.

Para los roles de AWS RedShift, considere usar pruebas como la Prueba en línea de AWS y la Prueba de ciencia de datos. Estas pruebas brindan una evaluación clara de las habilidades y el conocimiento de un candidato.

Los beneficios de usar pruebas de habilidades incluyen un proceso de entrevista más optimizado y una mayor probabilidad de encontrar candidatos que se ajusten bien al rol. Estas pruebas pueden ahorrar tiempo y recursos al identificar a los mejores talentos desde el principio.

2. Compile cuidadosamente las preguntas de su entrevista

Es importante ser selectivo al compilar las preguntas de su entrevista. No tendrá tiempo para preguntar todo, así que concéntrese en las preguntas que más importan para el puesto.

Incluya una combinación de preguntas técnicas y de habilidades blandas para obtener una comprensión completa del candidato. Por ejemplo, las preguntas relacionadas con SQL y análisis de datos pueden ser muy relevantes.

3. Siempre haga preguntas de seguimiento

Simplemente usar preguntas de entrevista pre-preparadas no es suficiente. Las preguntas de seguimiento le ayudan a evaluar la profundidad de conocimiento de un candidato y pueden revelar si están fingiendo.

Por ejemplo, si le pregunta a un candidato cómo optimizar un clúster de RedShift, una buena pregunta de seguimiento podría ser: "¿Puede explicar una situación en la que tuvo que optimizar un clúster y los pasos que siguió?" Esto le ayuda a comprender su experiencia práctica y su enfoque de resolución de problemas.

Contrate a los mejores talentos de AWS RedShift con pruebas de habilidades y entrevistas específicas

¿Busca contratar a alguien con habilidades en AWS RedShift? Asegúrese de evaluar sus habilidades con precisión. La mejor manera de hacerlo es utilizando pruebas de habilidades. Considere usar nuestra prueba en línea de AWS o prueba en línea de SQL para evaluar el conocimiento de los candidatos.

Después de usar estas pruebas para preseleccionar a los mejores solicitantes, puede continuar con entrevistas específicas. Para los siguientes pasos en su proceso de contratación, consulte nuestra plataforma de evaluación en línea para optimizar su flujo de trabajo de reclutamiento y encontrar el talento adecuado para su equipo.

Prueba de evaluación en línea de AWS

30 minutos | 12 MCQs

La prueba de evaluación en línea de AWS evalúa a los candidatos por su capacidad para implementar, administrar y escalar servidores virtuales (con servicios como EC2 y ECS), operar y escalar servicios de almacenamiento (con servicios como S3, RDS y DynamoDB) y administrar el flujo de tráfico de aplicaciones (con servicios como Route 53 y CloudFront).

[

Probar la prueba de evaluación en línea de AWS

](https://www.adaface.com/assessment-test/aws-online-test)

Descargue la plantilla de preguntas para entrevistas de AWS RedShift en múltiples formatos

Deberías abarcar conocimientos generales, conceptos de almacenamiento de datos, optimización del rendimiento y preguntas específicas según el rol para analistas junior, ingenieros de nivel medio y administradores senior.

Las preguntas específicas según el rol ayudan a evaluar el nivel de competencia del candidato y su idoneidad para las responsabilidades específicas del puesto al que postula.

Evita hacer preguntas demasiado genéricas, descuidar la optimización del rendimiento y no evaluar tanto los conocimientos teóricos como las habilidades prácticas.

Haz preguntas específicas sobre la optimización de consultas, los estilos de distribución de datos y las mejores prácticas para mantener clústeres de RedShift.

Una buena respuesta debe demostrar comprensión, experiencia práctica y la capacidad de proporcionar ejemplos. También debe alinearse con las mejores prácticas en la gestión de AWS RedShift.

Utiliza estas preguntas para evaluar las habilidades técnicas, las capacidades de resolución de problemas y la experiencia relevante, luego combina esto con otras evaluaciones como pruebas de habilidades y ejercicios prácticos.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento