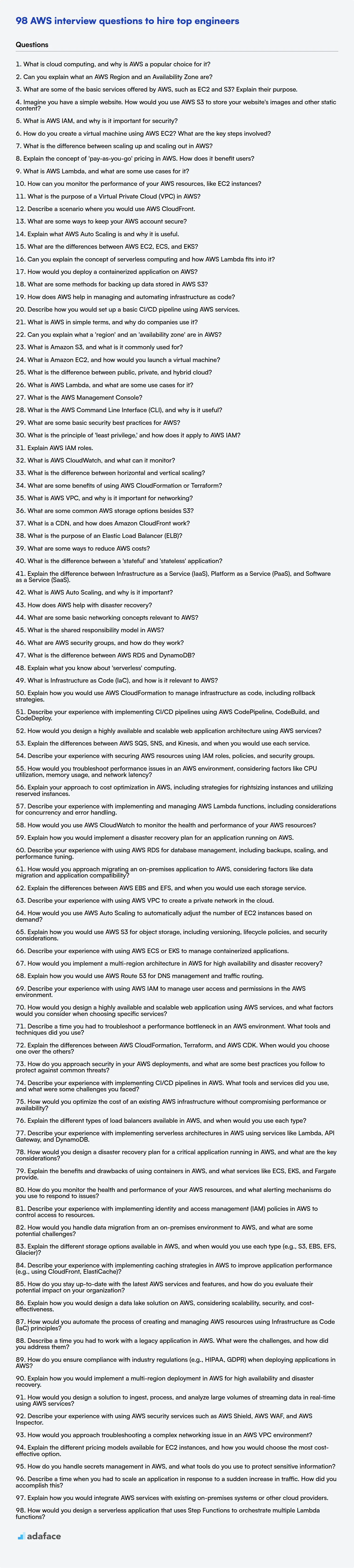

98 preguntas de entrevista de AWS para contratar a los mejores ingenieros

La contratación para roles de Amazon Web Services (AWS) requiere un ojo agudo para el talento, asegurando que los candidatos posean la combinación adecuada de habilidades de computación en la nube y experiencia práctica. Para evaluar eficazmente a los posibles empleados, los reclutadores y los gerentes de contratación necesitan un conjunto específico de preguntas de entrevista para medir su comprensión y habilidades.

Esta publicación de blog proporciona una lista seleccionada de preguntas de entrevista de AWS, que abarcan desde niveles de recién graduados hasta experimentados, incluidas preguntas de opción múltiple (MCQ). Hemos estructurado estas preguntas para cubrir una gama de servicios y conceptos de AWS, diseñadas para ayudarlo a evaluar a los candidatos en diferentes niveles de habilidad.

Al utilizar estas preguntas, puede optimizar su proceso de entrevista y asegurarse de contratar el mejor talento de AWS; para un enfoque más basado en datos, considere usar una prueba en línea de AWS antes de la entrevista para evaluar a los candidatos rápidamente.

Tabla de contenido

Preguntas de entrevista de AWS para recién graduados

Preguntas de entrevista de AWS para junior

Preguntas de entrevista intermedias de AWS

Preguntas de entrevista de AWS para experimentados

MCQ de AWS

¿Qué habilidades de AWS debe evaluar durante la fase de entrevista?

Optimice la contratación de AWS con pruebas de habilidades y preguntas de entrevista específicas

Descargue la plantilla de preguntas de entrevista de AWS en múltiples formatos

Preguntas de entrevista de AWS para recién graduados

1. ¿Qué es la computación en la nube y por qué AWS es una opción popular para ella?

La computación en la nube es la prestación de servicios informáticos, incluidos servidores, almacenamiento, bases de datos, redes, software, análisis e inteligencia, a través de Internet ("la nube") para ofrecer una innovación más rápida, recursos flexibles y economías de escala. En lugar de poseer y mantener sus propios centros de datos, las empresas pueden acceder a estos recursos a pedido de un proveedor de nube.

AWS (Amazon Web Services) es una opción popular para la computación en la nube por varias razones:

- Servicios maduros y completos: AWS ofrece una amplia gama de servicios, que cubren casi todas las necesidades de TI concebibles, y ha sido líder en el mercado de la nube durante mucho tiempo.

- Escalabilidad y flexibilidad: AWS permite a las empresas escalar fácilmente los recursos hacia arriba o hacia abajo según la demanda, pagando solo por lo que utilizan.

- Infraestructura global: AWS tiene una red global de centros de datos, que proporciona alta disponibilidad y baja latencia para los usuarios de todo el mundo.

- Rentabilidad: El modelo de pago por uso y los precios competitivos de AWS pueden reducir significativamente los costos de TI.

- Seguridad: AWS invierte fuertemente en seguridad, proporcionando una plataforma segura para que las empresas ejecuten sus aplicaciones.

2. ¿Puede explicar qué es una región de AWS y una zona de disponibilidad?

Una región de AWS es un área geográfica. Cada región contiene múltiples ubicaciones aisladas conocidas como zonas de disponibilidad. Piense en una región como una ciudad y en las zonas de disponibilidad como barrios distintos dentro de esa ciudad, pero con su propia infraestructura independiente, como energía y redes.

Las zonas de disponibilidad (AZ) están físicamente separadas y aisladas entre sí. Están diseñadas para ser tolerantes a fallos. Esto significa que si una AZ falla, las otras AZ de la región deberían seguir funcionando. Al distribuir sus aplicaciones en múltiples AZ, puede proteger sus aplicaciones de un único punto de fallo.

3. ¿Cuáles son algunos de los servicios básicos ofrecidos por AWS, como EC2 y S3? Explique su propósito.

AWS ofrece una amplia gama de servicios. Dos fundamentales son EC2 y S3.

EC2 (Elastic Compute Cloud) proporciona servidores virtuales en la nube. Piense en ello como el alquiler de ordenadores a demanda. Elige el sistema operativo, la CPU, la memoria, el almacenamiento y las redes, y luego puedes ejecutar tus aplicaciones en estos servidores virtuales. EC2 es altamente configurable y escalable.

S3 (Simple Storage Service) es almacenamiento de objetos. Le permite almacenar y recuperar cualquier cantidad de datos, en cualquier momento y desde cualquier lugar. S3 se utiliza para almacenar archivos, copias de seguridad, medios y más. Es un almacenamiento de objetos altamente duradero, escalable y seguro y, a menudo, se utiliza como base para muchos otros servicios de AWS.

4. Imagine que tiene un sitio web sencillo. ¿Cómo utilizaría AWS S3 para almacenar las imágenes y otros contenidos estáticos de su sitio web?

Yo usaría AWS S3 para almacenar imágenes y contenido estático creando primero un bucket de S3 en la Consola de administración de AWS. Luego, configuraría los permisos del bucket para permitir el acceso público de lectura a los objetos (imágenes, CSS, archivos JavaScript, etc.). Después, subiría todos los activos estáticos del sitio web a este bucket. Finalmente, actualizaría el HTML del sitio web para hacer referencia a estos activos usando la URL del bucket de S3. Por ejemplo, una etiqueta de imagen cambiaría de <img src="/images/logo.png"> a <img src="https://my-bucket-name.s3.amazonaws.com/images/logo.png">. Para mejorar el rendimiento y reducir la latencia, también podría configurar Amazon CloudFront para que actúe como una CDN frente al bucket de S3.

5. ¿Qué es AWS IAM y por qué es importante para la seguridad?

AWS IAM (Identity and Access Management) es un servicio web que le permite controlar el acceso a los recursos de AWS. Le permite administrar usuarios, grupos y roles, y definir permisos para especificar qué acciones pueden realizar en qué recursos. IAM es un componente fundamental de la seguridad de AWS porque le permite implementar el principio del menor privilegio, otorgando a los usuarios solo los permisos que necesitan para realizar sus trabajos.

IAM es importante para la seguridad porque sin él, dependería de la cuenta raíz para todo el acceso, lo cual es un riesgo importante para la seguridad. IAM le permite:

- Controlar el acceso: Definir quién puede acceder a qué recursos.

- Otorgar el mínimo privilegio: Permitir solo el acceso necesario.

- Gestión centralizada: Gestionar usuarios y permisos en un solo lugar.

- Cumplimiento: Cumplir con los requisitos normativos controlando el acceso a datos confidenciales.

6. ¿Cómo se crea una máquina virtual utilizando AWS EC2? ¿Cuáles son los pasos clave involucrados?

La creación de una máquina virtual (instancia) EC2 implica varios pasos clave a través de la Consola de administración de AWS, CLI o SDK. Primero, debe seleccionar una Amazon Machine Image (AMI), que sirve como plantilla para su instancia, definiendo el sistema operativo, el software y la configuración. A continuación, elige un tipo de instancia, que determina los recursos de hardware asignados (CPU, memoria, almacenamiento, red). Luego, configura los detalles de la instancia, como la configuración de red (VPC, subred), el rol de IAM y los datos de usuario (scripts de inicio).

Después de configurar los detalles, agrega almacenamiento (volúmenes EBS), configura los grupos de seguridad (reglas de firewall) y revisa su configuración. Finalmente, lanza la instancia y selecciona o crea un par de claves para el acceso SSH. Conectarse a su instancia generalmente implica usar SSH, con su clave privada. ssh -i your_key.pem ec2-user@your_instance_public_ip.

7. ¿Cuál es la diferencia entre escalar verticalmente y escalar horizontalmente en AWS?

Escalar verticalmente (escalado vertical) implica aumentar los recursos de una sola instancia o servidor. Por ejemplo, actualizar la CPU, la RAM o el almacenamiento de un servidor. Escalar horizontalmente (escalado horizontal) implica agregar más instancias o servidores a su sistema. Esto distribuye la carga de trabajo entre múltiples máquinas.

Diferencias clave: El escalado vertical tiene limitaciones porque solo se pueden aumentar los recursos de una sola máquina hasta cierto punto. El escalado horizontal es generalmente más escalable y resistente, ya que el fallo de una instancia no derriba todo el sistema, aunque puede ser más complejo de implementar debido a la necesidad de balanceo de carga y sincronización de datos entre instancias.

8. Explique el concepto de precios de 'pago por uso' en AWS. ¿Cómo beneficia a los usuarios?

El modelo de precios de 'pago por uso' de AWS significa que solo paga por los recursos informáticos que realmente utiliza. En lugar de contratos fijos o costos iniciales, se le cobra en función del consumo, como pagar por la electricidad. Si no utiliza un servicio, no lo paga. Esto se aplica a servicios como EC2 (tiempo de computación), S3 (almacenamiento), Lambda (ejecuciones de funciones) y otros.

Este modelo beneficia a los usuarios al:

- Optimización de costos: Evitar el aprovisionamiento excesivo y pagar por recursos no utilizados. Escalar vertical u horizontalmente según sea necesario y solo pagar por lo que se requiere.

- Flexibilidad y escalabilidad: Ajustar fácilmente el uso de recursos según la demanda sin compromisos a largo plazo.

- Reducción del gasto de capital: Eliminar la necesidad de invertir y mantener su propia infraestructura.

- Experimentación: Probar fácilmente nuevos servicios e ideas sin costos iniciales significativos. Esto fomenta la innovación y permite una rápida creación de prototipos.

9. ¿Qué es AWS Lambda y cuáles son algunos casos de uso?

AWS Lambda es un servicio de computación sin servidor que le permite ejecutar código sin aprovisionar ni administrar servidores. Solo paga por el tiempo de cómputo que consume, lo que lo convierte en una solución rentable para muchas aplicaciones. Las funciones de Lambda se basan en eventos, lo que significa que se activan por eventos de otros servicios de AWS o aplicaciones personalizadas.

Algunos casos de uso para AWS Lambda incluyen:

- Procesamiento de datos: como imágenes, videos o archivos de registro.

- Creación de API sin servidor: utilizando API Gateway para activar funciones de Lambda.

- Procesamiento de flujo en tiempo real: utilizando Kinesis o DynamoDB Streams para activar funciones de Lambda.

- Automatización de tareas: como copias de seguridad, monitoreo y gestión de infraestructura.

- Chatbots: Procesamiento de mensajes en tiempo real.

- Extensión de otros servicios de AWS: Agregando lógica personalizada a los buckets de S3 u otros servicios de AWS a través de activadores de Lambda.

10. ¿Cómo puede monitorear el rendimiento de sus recursos de AWS, como las instancias EC2?

Monitorearía el rendimiento de los recursos de AWS, particularmente las instancias EC2, principalmente usando Amazon CloudWatch. CloudWatch recopila métricas como la utilización de la CPU, el uso de la memoria, la E/S del disco y el tráfico de red. Puedo configurar alarmas de CloudWatch para activar notificaciones o acciones automatizadas cuando se superan umbrales específicos. Para una monitorización más profunda a nivel de sistema operativo, el agente de CloudWatch se puede instalar en las instancias EC2 para recopilar métricas personalizadas.

Además, AWS proporciona herramientas como CloudWatch Logs para centralizar los registros de las instancias EC2 y otros servicios, lo que facilita la resolución de problemas y la auditoría. AWS Trusted Advisor proporciona recomendaciones para optimizar la utilización de recursos y mejorar la seguridad. Para la monitorización a nivel de aplicación, integraría servicios como AWS X-Ray para rastrear las solicitudes e identificar cuellos de botella de rendimiento dentro de mis aplicaciones que se ejecutan en instancias EC2.

11. ¿Cuál es el propósito de una Virtual Private Cloud (VPC) en AWS?

Una Virtual Private Cloud (VPC) en AWS le permite aprovisionar una sección lógicamente aislada de la nube de AWS donde puede lanzar recursos de AWS en una red virtual que usted define. Le da control sobre su entorno de red virtual, incluida la selección de sus propios rangos de direcciones IP, la creación de subredes y la configuración de tablas de enrutamiento y puertas de enlace de red. Esencialmente, es como tener su propio centro de datos dentro de AWS.

El propósito de una VPC es proporcionar seguridad, aislamiento y control mejorados sobre sus recursos de AWS. Le permite crear redes privadas dentro de AWS, aislar sus aplicaciones de la Internet pública y conectar su VPC a su red local utilizando VPN o Direct Connect. Esto ayuda a mantener el cumplimiento, proteger datos confidenciales y crear entornos de nube híbrida.

12. Describa un escenario en el que usaría AWS CloudFront.

Usaría AWS CloudFront para mejorar el rendimiento y la disponibilidad de un sitio web o aplicación que sirva contenido a usuarios de todo el mundo. Por ejemplo, considere una empresa de medios que aloja videos e imágenes. Al usar CloudFront, el contenido se almacena en caché en ubicaciones de borde más cercanas a los usuarios.

Cuando un usuario solicita contenido, CloudFront lo entrega desde la ubicación de borde más cercana, reduciendo la latencia y mejorando la experiencia del usuario. Esto también ayuda a descargar el tráfico del servidor de origen (por ejemplo, un bucket de S3 o una instancia de EC2), mejorando su rendimiento general y reduciendo los costos. Además, CloudFront proporciona funciones de seguridad integradas como protección contra DDoS y cifrado SSL/TLS, mejorando aún más la postura de seguridad de la aplicación.

13. ¿Cuáles son algunas formas de mantener segura su cuenta de AWS?

Asegurar una cuenta de AWS implica múltiples capas. Habilite la autenticación multifactor (MFA) para todos los usuarios de IAM, especialmente aquellos con privilegios administrativos. Use contraseñas seguras y únicas y rótelas regularmente. Aplique el principio del mínimo privilegio otorgando a los usuarios solo los permisos que necesitan para realizar sus tareas utilizando roles de IAM.

Supervise la actividad de la cuenta con CloudTrail y CloudWatch para detectar comportamientos sospechosos. Revise y actualice periódicamente los grupos de seguridad para restringir el acceso a la red. Utilice AWS Config para rastrear las configuraciones de los recursos e identificar desviaciones de los estados deseados. Habilite AWS Security Hub para obtener una vista centralizada de su postura de seguridad. Considere el uso de servicios como AWS GuardDuty para la detección de amenazas y AWS Trusted Advisor para obtener recomendaciones de mejores prácticas. Finalmente, audite periódicamente su cuenta y las políticas de IAM.

14. Explique qué es AWS Auto Scaling y por qué es útil.

AWS Auto Scaling ajusta automáticamente el número de recursos informáticos según la demanda. Ayuda a mantener la disponibilidad de la aplicación y le permite escalar su capacidad de Amazon EC2 hacia arriba o hacia abajo automáticamente de acuerdo con las condiciones que defina. Esto garantiza que solo pague por los recursos que realmente está utilizando, optimizando los costos.

Auto Scaling es útil porque asegura que las aplicaciones tengan la cantidad correcta de capacidad de cómputo en un momento dado. Esto mejora la disponibilidad de la aplicación, maneja los picos de tráfico sin problemas y reduce la sobrecarga operativa al automatizar el proceso de escalado. También mejora la tolerancia a fallas al reemplazar automáticamente las instancias en mal estado.

15. ¿Cuáles son las diferencias entre AWS EC2, ECS y EKS?

AWS EC2, ECS y EKS son todos servicios informáticos, pero satisfacen diferentes necesidades. EC2 proporciona máquinas virtuales, lo que le brinda control total sobre el sistema operativo y la infraestructura. Usted gestiona todo, desde la aplicación de parches hasta el escalado. Es ideal para aplicaciones heredadas o cuando necesita configuraciones específicas del sistema operativo.

ECS (Elastic Container Service) es el servicio de orquestación de contenedores de AWS. Le permite ejecutar, administrar y escalar contenedores Docker. ECS es una opción sin servidor (Fargate), donde AWS maneja la infraestructura subyacente, o usando instancias EC2. EKS (Elastic Kubernetes Service) también es un servicio de orquestación de contenedores, específicamente para Kubernetes. EKS simplifica la implementación, gestión y escalado de clústeres de Kubernetes en AWS. La elección entre ECS y EKS a menudo se reduce a si desea utilizar el ecosistema Kubernetes (EKS) o prefiere el servicio de contenedores nativo de AWS (ECS).

16. ¿Puede explicar el concepto de computación sin servidor y cómo encaja AWS Lambda en él?

La computación sin servidor es un modelo de ejecución de computación en la nube donde el proveedor de la nube administra dinámicamente la asignación de recursos del servidor. No tiene que aprovisionar ni administrar servidores. Simplemente carga su código y el proveedor lo ejecuta en respuesta a los activadores. Esto permite a los desarrolladores centrarse únicamente en escribir código sin preocuparse por la infraestructura subyacente.

AWS Lambda es un servicio de computación sin servidor ofrecido por Amazon Web Services (AWS). Le permite ejecutar código sin aprovisionar ni administrar servidores. Lambda ejecuta su código solo cuando es necesario y se escala automáticamente. Solo paga por el tiempo de cómputo que consume. Las funciones de Lambda generalmente se activan por eventos, como cambios en los datos de un bucket de S3 o una solicitud HTTP a través de API Gateway. Lambda admite varios lenguajes de programación, incluidos Python, Java y Node.js.

17. ¿Cómo implementaría una aplicación en contenedor en AWS?

Implementaría una aplicación en contenedor en AWS utilizando varios servicios, eligiendo la mejor opción en función de los requisitos como escalabilidad, costo y sobrecarga operativa. Las opciones incluyen:

- Amazon ECS (Elastic Container Service): Un servicio de orquestación de contenedores totalmente administrado. Definiría los contenedores de mi aplicación en una definición de tarea, crearía un clúster y luego implementaría las tareas en el clúster. ECS ofrece control y flexibilidad.

- Amazon EKS (Elastic Kubernetes Service): Un servicio Kubernetes administrado, útil si ya estoy familiarizado con Kubernetes o necesito sus funciones avanzadas. Crearía un clúster EKS e implementaría mi aplicación utilizando manifiestos de Kubernetes.

- AWS Fargate: Un motor de computación sin servidor para contenedores que funciona tanto con ECS como con EKS. Elegiría Fargate para evitar administrar instancias de EC2. Simplemente cree una definición de tarea (para ECS) o implemente pods de Kubernetes, y Fargate maneja la infraestructura subyacente.

- AWS App Runner: Un servicio totalmente administrado que crea y ejecuta aplicaciones web en contenedores y API. Esta es la opción más sencilla, que solo requiere la imagen del contenedor. App Runner maneja automáticamente el escalado y el equilibrio de carga.

La elección depende de las necesidades de la aplicación y mi nivel de comodidad con las tecnologías subyacentes. Por ejemplo, si la simplicidad es primordial, AWS App Runner sería una buena opción. Para obtener más control y compatibilidad con Kubernetes, EKS es adecuado. Si estoy usando ECS y quiero evitar la gestión de servidores, Fargate es el camino a seguir.

18. ¿Cuáles son algunos métodos para hacer copias de seguridad de los datos almacenados en AWS S3?

Existen varios métodos para hacer copias de seguridad de datos en AWS S3. El Versionado de S3 es una forma sencilla y eficaz de mantener múltiples versiones de sus objetos, protegiéndolos contra la eliminación o sobrescritura accidental. Habilitarlo en un bucket mantiene automáticamente las versiones anteriores de los objetos cuando se modifican o eliminan. Otro enfoque común es la replicación entre regiones (CRR) o la replicación en la misma región (SRR). CRR replica asincrónicamente objetos a otra región de AWS, proporcionando capacidades de recuperación ante desastres. SRR replica objetos dentro de la misma región, útil para el cumplimiento o la reducción de la latencia.

Más allá de esto, puede utilizar AWS Backup para administrar y automatizar centralmente las copias de seguridad en varios servicios de AWS, incluido S3. Esto le permite definir políticas y programaciones de copia de seguridad. Finalmente, también se pueden emplear soluciones de copia de seguridad de terceros y scripts personalizados que aprovechan el AWS SDK para crear copias de seguridad en S3 u otras ubicaciones de almacenamiento. Por ejemplo, usar el comando aws s3 sync para copiar datos a otro bucket de S3.

19. ¿Cómo ayuda AWS a administrar y automatizar la infraestructura como código?

AWS proporciona varios servicios que facilitan la gestión y automatización de la infraestructura como código (IaC). AWS CloudFormation le permite definir y aprovisionar la infraestructura de AWS utilizando plantillas declarativas escritas en JSON o YAML. Estas plantillas describen el estado deseado de su infraestructura, y CloudFormation se encarga del aprovisionamiento y la configuración. AWS también ofrece AWS CDK (Cloud Development Kit), que le permite definir su infraestructura en la nube en lenguajes de programación familiares como Python, TypeScript, Java y .NET. CDK luego sintetiza este código en plantillas de CloudFormation.

Además, servicios como AWS Systems Manager se pueden utilizar para automatizar tareas como la aplicación de parches, la gestión de la configuración y la implementación de software en su infraestructura. Todo esto se puede orquestar mediante código. AWS CodePipeline ayuda a crear pipelines CI/CD para implementar automáticamente los cambios en la infraestructura cuando se realizan cambios en el código IaC. Esto ayuda en las pruebas y despliegues automatizados. AWS Config le permite auditar y evaluar las configuraciones de sus recursos de AWS para garantizar el cumplimiento y la consistencia de la infraestructura.

20. Describa cómo configuraría un pipeline CI/CD básico utilizando los servicios de AWS.

Utilizaría AWS CodePipeline, CodeBuild y CodeDeploy para un pipeline CI/CD básico. Primero, CodePipeline orquesta todo el proceso, activando acciones basadas en los cambios de código en un repositorio de origen como AWS CodeCommit o GitHub. Cuando se detectan cambios, CodePipeline inicia un proyecto CodeBuild. CodeBuild compila el código, ejecuta pruebas unitarias y crea artefactos implementables como imágenes de Docker o archivos zip. Finalmente, CodePipeline activa CodeDeploy para implementar estos artefactos en entornos objetivo como instancias EC2, clústeres ECS o funciones Lambda.

Para configurar esto, definiría un pipeline de CodePipeline con etapas para la fuente, la construcción y la implementación. La etapa de fuente se integra con el repositorio. La etapa de construcción especifica el proyecto de CodeBuild, incluyendo el entorno de construcción (por ejemplo, sistema operativo, tiempo de ejecución del lenguaje) y los comandos de construcción (definidos en un archivo buildspec.yml). La etapa de implementación se integra con CodeDeploy, especificando el grupo de implementación (entorno de destino) y la configuración de implementación (estrategia de implementación, como actualizaciones azul/verde o continuas). Usaría roles de IAM con el menor privilegio para otorgar a cada servicio los permisos necesarios. Por ejemplo, CodeBuild requiere permisos para acceder al repositorio de origen y subir artefactos a S3.

Preguntas de entrevista de AWS para principiantes

1. ¿Qué es AWS en términos sencillos y por qué las empresas lo utilizan?

AWS (Amazon Web Services) es como una colección gigante de computadoras y software que Amazon alquila. En lugar de comprar y administrar sus propios servidores y centros de datos, las empresas pueden usar AWS para almacenar datos, ejecutar aplicaciones y realizar todo tipo de tareas informáticas.

Las empresas utilizan AWS por varias razones:

- Ahorro de costos: A menudo es más barato que construir y mantener su propia infraestructura.

- Escalabilidad: Pueden aumentar o disminuir fácilmente su potencia de cómputo según sea necesario.

- Confiabilidad: AWS tiene una red global de centros de datos, por lo que los servicios están altamente disponibles.

- Flexibilidad: AWS ofrece una amplia gama de servicios, desde almacenamiento simple hasta aprendizaje automático complejo.

2. ¿Puede explicar qué es una 'región' y una 'zona de disponibilidad' en AWS?

En AWS, una región es un área geográfica. Cada región está completamente aislada de otras regiones, lo que proporciona tolerancia a fallos y estabilidad. Elegir una región cercana a sus usuarios puede reducir la latencia.

Una zona de disponibilidad (AZ) es una ubicación físicamente distinta dentro de una región de AWS. Cada región consta de múltiples AZ, que están aisladas entre sí pero conectadas a través de enlaces de baja latencia. Esto le permite crear aplicaciones de alta disponibilidad mediante la implementación de recursos en múltiples AZ. Si una AZ falla, su aplicación puede seguir ejecutándose en otra AZ.

3. ¿Qué es Amazon S3 y para qué se utiliza comúnmente?

Amazon S3 (Simple Storage Service) es un servicio de almacenamiento en la nube basado en la web, escalable y de alta velocidad, diseñado para la copia de seguridad en línea y el archivado de datos y programas de aplicación. Es almacenamiento de objetos, lo que significa que los datos se almacenan como objetos dentro de buckets. Piense en los buckets como carpetas y en los objetos como archivos.

S3 se utiliza comúnmente para:

- Copia de seguridad y recuperación ante desastres: Almacenar copias de seguridad de datos con fines de recuperación.

- Almacenamiento y distribución de contenido: Alojar contenido estático de sitios web (HTML, CSS, JavaScript, imágenes, videos) y distribuirlo globalmente a través de Amazon CloudFront.

- Archivo de datos: Almacenar datos a los que se accede con poca frecuencia a bajo costo.

- Análisis de Big Data: Almacenar grandes conjuntos de datos para su procesamiento con servicios como Amazon EMR.

- Alojamiento de aplicaciones: Almacenar datos y artefactos de aplicaciones.

4. ¿Qué es Amazon EC2 y cómo lanzaría una máquina virtual?

Amazon Elastic Compute Cloud (EC2) es un servicio web que proporciona capacidad de cómputo redimensionable en la nube. Esencialmente, le permite alquilar servidores virtuales (instancias) para ejecutar sus aplicaciones.

Para lanzar una máquina virtual (instancia EC2), normalmente haría lo siguiente:

- Elija una Amazon Machine Image (AMI), que es una plantilla que contiene el sistema operativo, las aplicaciones y los datos.

- Seleccione un tipo de instancia, que determina la CPU, la memoria, el almacenamiento y la capacidad de red.

- Configure la configuración de red, como VPC y subred.

- Configure grupos de seguridad para controlar el tráfico entrante y saliente.

- Asigne un rol de IAM para otorgar permisos a la instancia.

- Inicie la instancia.

- Conéctese a la instancia usando SSH (para Linux) o RDP (para Windows).

5. ¿Cuál es la diferencia entre la nube pública, privada e híbrida?

La infraestructura de la nube pública es propiedad y está operada por un proveedor externo, lo que hace que recursos como servidores y almacenamiento estén disponibles para muchos usuarios a través de Internet. Los usuarios comparten la misma infraestructura y los servicios se facturan según el uso, lo que ofrece escalabilidad y rentabilidad. La nube privada, por el contrario, es una infraestructura dedicada a una sola organización. Puede estar alojada en las instalaciones o por un tercero, pero los recursos no se comparten. Esta opción proporciona un mayor control y seguridad, pero generalmente conlleva mayores costos.

La nube híbrida combina entornos de nube pública y privada, lo que permite compartir datos y aplicaciones entre ellos. Este enfoque ofrece flexibilidad, lo que permite a las organizaciones aprovechar los beneficios de ambos modelos. Por ejemplo, los datos confidenciales se pueden mantener en la nube privada, mientras que las cargas de trabajo menos confidenciales pueden ejecutarse en la nube pública para lograr eficiencia de costos y escalabilidad. La orquestación entre estas nubes es crucial para una estrategia exitosa de nube híbrida.

6. ¿Qué es AWS Lambda y cuáles son algunos casos de uso?

AWS Lambda es un servicio de computación sin servidor que le permite ejecutar código sin aprovisionar ni administrar servidores. Carga su código como una función y Lambda lo ejecuta en respuesta a eventos, como cambios en los datos de un bucket de S3, mensajes que llegan a una cola o solicitudes HTTP. Solo paga por el tiempo de computación que consume.

Algunos casos de uso incluyen:

- Procesamiento de datos en tiempo real: Procesamiento de flujos de datos de fuentes como dispositivos IoT o flujos de clics.

- Aplicaciones web: Creación de backends sin servidor para aplicaciones web y móviles.

- Chatbots: Potenciando interfaces conversacionales.

- Automatización de tareas: Automatización de tareas administrativas como el análisis de registros, copias de seguridad y trabajos programados.

- Extensión de otros servicios de AWS: Desencadenamiento de funciones Lambda desde servicios como S3, DynamoDB, SNS y SQS para agregar lógica personalizada. Por ejemplo, cambiar el tamaño de las imágenes cuando se cargan en S3.

- APIs sin servidor: Creación de APIs RESTful usando API Gateway y Lambda. El código podría escribirse usando cualquier tiempo de ejecución compatible como

Node.js,Python,JavaoGo.

7. ¿Qué es la Consola de administración de AWS?

La Consola de administración de AWS es una interfaz basada en web que le permite acceder y administrar Amazon Web Services (AWS). Proporciona una ubicación central para interactuar con todos los servicios de AWS que está autorizado a usar. Piense en ella como una interfaz gráfica de usuario (GUI) para AWS, que le permite realizar tareas como lanzar instancias EC2, configurar buckets S3, configurar bases de datos con RDS y monitorear sus recursos usando CloudWatch sin necesidad de escribir código o usar la línea de comandos.

Es la forma principal en que muchos usuarios interactúan inicialmente con AWS, especialmente para el aprendizaje y la exploración. Si bien la AWS CLI y los SDK proporcionan enfoques más programáticos y automatizados, la consola ofrece una representación visual y una guía paso a paso para muchas tareas comunes, lo que facilita la comprensión de la plataforma en la nube.

8. ¿Qué es la Interfaz de Línea de Comandos (CLI) de AWS y por qué es útil?

La Interfaz de Línea de Comandos (CLI) de AWS es una herramienta unificada para administrar sus servicios de AWS desde la línea de comandos. Le permite controlar múltiples servicios de AWS y automatizarlos a través de scripts. En lugar de usar la Consola de administración de AWS (interfaz web), puede interactuar con los servicios de AWS directamente usando comandos en su terminal.

Es útil porque proporciona una forma de automatizar tareas, administrar la infraestructura como código e integrar los servicios de AWS en sus flujos de trabajo existentes. Algunos casos de uso clave incluyen la creación de scripts de implementaciones, la creación y gestión de recursos (como instancias EC2 o buckets S3) y la automatización de copias de seguridad. Es particularmente beneficioso para los desarrolladores y administradores de sistemas que prefieren un enfoque programático para administrar su infraestructura de AWS.

9. ¿Cuáles son algunas de las mejores prácticas básicas de seguridad para AWS?

Algunas de las mejores prácticas de seguridad básicas para AWS incluyen: habilitar la autenticación multifactor (MFA) para todas las cuentas de usuario, especialmente la cuenta raíz. Use roles de IAM en lugar de almacenar credenciales directamente en aplicaciones o instancias EC2. Revise y rote regularmente las claves de IAM. Emplee el principio del mínimo privilegio, otorgando a los usuarios solo los permisos que necesitan. Habilite AWS CloudTrail para registrar las llamadas a la API con fines de auditoría y supervise estos registros. Use grupos de seguridad y ACL de red para controlar el tráfico de red que entra y sale de sus instancias.

Además, mantenga su software actualizado parcheando instancias EC2 y aplicaciones con regularidad. Utilice servicios de seguridad de AWS como AWS Shield para la protección contra DDoS, AWS WAF para filtrar el tráfico web malicioso y configure AWS Config para monitorear y evaluar las configuraciones de sus recursos de AWS. Escanee regularmente su entorno en busca de vulnerabilidades utilizando herramientas como Amazon Inspector.

10. ¿Qué es el principio de "privilegio mínimo" y cómo se aplica a AWS IAM?

El principio de privilegio mínimo (PoLP) significa otorgar a un usuario o servicio solo el nivel mínimo de acceso necesario para realizar su trabajo o función. Es una práctica de seguridad fundamental. En AWS IAM, esto se traduce en la creación de roles y políticas de IAM que otorgan a los usuarios y servicios de AWS solo los permisos específicos que necesitan, y nada más.

Por ejemplo, en lugar de otorgar a un usuario la política AdministratorAccess, crearía una política personalizada que le permita solo leer desde un bucket de S3 específico o invocar una función Lambda en particular. Esto limita el potencial radio de explosión de cualquier infracción de seguridad o configuración incorrecta accidental. Siguiendo PoLP, reduce el riesgo de acceso no autorizado, filtraciones de datos e incumplimientos de cumplimiento.

11. Explique los roles de AWS IAM.

Los roles de IAM son identidades de AWS que puede asumir para obtener acceso temporal a los recursos de AWS. A diferencia de los usuarios de IAM, los roles no están permanentemente asociados con una persona o aplicación específica. En cambio, una entidad (como una instancia EC2, una función Lambda o incluso un usuario de IAM) asume el rol para obtener credenciales de seguridad temporales.

Los roles definen un conjunto de permisos, similar a las políticas de usuario de IAM. Cuando una entidad asume un rol, obtiene acceso temporal basado en los permisos definidos en las políticas del rol. Este acceso temporal elimina la necesidad de almacenar credenciales a largo plazo (como claves de acceso) en instancias EC2 o dentro de aplicaciones, mejorando la seguridad. Las políticas de confianza definen quién puede asumir el rol.

12. ¿Qué es AWS CloudWatch y qué puede monitorear?

AWS CloudWatch es un servicio de monitoreo y observabilidad que le proporciona datos e información útil para monitorear sus aplicaciones, responder a los cambios en el rendimiento de todo el sistema, optimizar el uso de los recursos y obtener una vista unificada del estado operativo. Recopila datos de monitoreo y operativos en forma de registros, métricas y eventos.

CloudWatch puede monitorear varios recursos y aplicaciones de AWS, incluyendo:

- Instancias EC2: Utilización de CPU, E/S de disco, tráfico de red, comprobaciones de estado.

- Bases de datos RDS: Utilización de CPU, conexiones de base de datos, uso de espacio en disco.

- Funciones Lambda: Recuento de invocaciones, tasa de error, duración de la ejecución.

- Métricas personalizadas: Métricas específicas de la aplicación que usted define y publica.

- Registros: Registros de aplicaciones y del sistema para la depuración y la solución de problemas.

- Información de contenedores: Métricas relacionadas con el rendimiento de los contenedores.

- Eventos de CloudWatch/EventBridge: Monitorear los eventos del servicio AWS y activar acciones.

13. ¿Cuál es la diferencia entre el escalado horizontal y vertical?

El escalado horizontal significa agregar más máquinas a tu conjunto existente de recursos, mientras que el escalado vertical significa agregar más potencia (CPU, RAM) a una máquina existente.

- Escalado Horizontal: Escalado horizontal. Distribuye la carga entre múltiples máquinas. Mayor disponibilidad a través de la redundancia. Puede ser más complejo de implementar debido a problemas de sistemas distribuidos.

- Escalado Vertical: Escalado vertical. Aumenta los recursos de una sola máquina. Más sencillo de implementar inicialmente, pero tiene limitaciones al alcanzar los máximos de hardware.

14. ¿Cuáles son algunos beneficios de usar AWS CloudFormation o Terraform?

AWS CloudFormation y Terraform ofrecen beneficios de infraestructura como código (IaC). Permiten definir tu infraestructura de manera declarativa, típicamente usando YAML/JSON (CloudFormation) o HashiCorp Configuration Language (HCL) (Terraform). Esto permite el control de versiones, la repetibilidad y una colaboración más fácil.

Algunos beneficios clave incluyen: Infraestructura como código: Definir y administrar la infraestructura usando código. Control de versiones: Rastrear los cambios en las configuraciones de la infraestructura. Automatización: Automatizar el aprovisionamiento y la gestión de la infraestructura. Consistencia: Asegurar implementaciones consistentes de infraestructura en todos los entornos. Reducción de costos: Optimizar la utilización de recursos y evitar errores manuales.

15. ¿Qué es AWS VPC y por qué es importante para la red?

AWS VPC (Nube Privada Virtual) le permite aprovisionar una sección lógicamente aislada de la Nube de AWS donde puede lanzar recursos de AWS en una red virtual que usted define. Tiene control total sobre su entorno de red virtual, incluida la selección de sus propios rangos de direcciones IP, la creación de subredes y la configuración de tablas de enrutamiento y puertas de enlace de red. VPC es un componente fundamental para la red en la nube segura y escalable.

Es importante porque proporciona:

- Aislamiento: Puede crear una red privada que está aislada de otros clientes de AWS.

- Control: Tiene control total sobre la configuración de su red.

- Seguridad: Las VPC se pueden asegurar mediante grupos de seguridad y ACL de red.

- Escalabilidad: Puede escalar fácilmente su red a medida que crecen sus necesidades.

- Personalización: Capacidad de usar sus propios rangos de direcciones IP, crear subredes, configurar tablas de enrutamiento y puertas de enlace de red.

16. ¿Cuáles son algunas opciones de almacenamiento comunes de AWS además de S3?

Además de S3, AWS ofrece varias otras opciones de almacenamiento que satisfacen diversas necesidades. EBS (Elastic Block Storage) proporciona volúmenes de almacenamiento a nivel de bloques para usarlos con instancias de EC2, de forma similar a un disco duro. EFS (Elastic File System) ofrece un sistema de archivos NFS totalmente administrado para el almacenamiento de archivos compartido en varias instancias de EC2. AWS Storage Gateway conecta entornos locales con el almacenamiento de AWS, lo que permite escenarios de nube híbrida.

Otras opciones incluyen Glacier para el almacenamiento de archivos de archivo a largo plazo, Snowball/ Snowcone/ Snowmobile para transferencias de datos a escala de petabytes y FSx que proporciona sistemas de archivos compartidos totalmente administrados con compatibilidad nativa con sistemas de archivos populares como Windows File Server, Lustre y OpenZFS.

17. ¿Qué es una CDN y cómo funciona Amazon CloudFront?

Una CDN (Red de Entrega de Contenido) es una red de servidores distribuida geográficamente que almacena en caché contenido estático (imágenes, videos, archivos CSS, JavaScript, etc.) y lo entrega a los usuarios en función de su ubicación. Esto reduce la latencia y mejora los tiempos de carga de los sitios web.

Amazon CloudFront es el servicio de CDN de Amazon. Cuando un usuario solicita contenido, CloudFront enruta la solicitud a la ubicación perimetral (servidor) más cercana que tiene el contenido en caché. Si el contenido no está en caché, CloudFront lo recupera del servidor de origen (por ejemplo, un bucket de S3 o una instancia EC2), lo almacena en caché en la ubicación perimetral y luego lo entrega al usuario. Las solicitudes subsiguientes de usuarios cercanos se sirven directamente desde la caché de la ubicación perimetral. Puede configurar el comportamiento de almacenamiento en caché, TTL (Time To Live) y reglas de invalidación para controlar cuánto tiempo se almacena el contenido en caché. CloudFront también es compatible con la entrega de contenido dinámico, a través de funciones como Lambda@Edge y CloudFront Functions.

18. ¿Cuál es el propósito de un Elastic Load Balancer (ELB)?

El propósito de un Elastic Load Balancer (ELB) es distribuir el tráfico de red entrante entre múltiples destinos, como instancias EC2, contenedores y direcciones IP, en una o más Zonas de Disponibilidad. Esto aumenta la disponibilidad y la tolerancia a fallos de sus aplicaciones. Los ELB garantizan que ningún destino individual se vea abrumado por el tráfico, lo que evita cuellos de botella en el rendimiento y posibles interrupciones del servicio.

Esencialmente, actúa como un único punto de contacto para los clientes y enruta el tráfico a los servidores de backend en buen estado. Los ELB se escalan automáticamente para manejar los cambios en el tráfico entrante, lo que proporciona un rendimiento constante y sin problemas. Los diferentes tipos de ELB, como los Application Load Balancers (ALB) y los Network Load Balancers (NLB), son adecuados para diferentes tipos de tráfico y casos de uso. Los ALB gestionan el tráfico HTTP/HTTPS, mientras que los NLB están diseñados para tráfico TCP/UDP de alto rendimiento.

19. ¿Cuáles son algunas formas de reducir los costos de AWS?

Para reducir los costos de AWS, considere varias estrategias. Ajuste el tamaño de sus instancias EC2 y use instancias reservadas o planes de ahorro para cargas de trabajo predecibles. Utilice instancias spot para aplicaciones tolerantes a fallos. Optimice el almacenamiento utilizando políticas de ciclo de vida para S3 y eliminando volúmenes EBS no utilizados.

Otras optimizaciones incluyen aprovechar AWS Cost Explorer para identificar los factores que impulsan los costos, implementar el escalado automático para ajustar dinámicamente los recursos y utilizar AWS Lambda o Fargate para la computación sin servidor. Revise y elimine regularmente los recursos no utilizados, como instantáneas obsoletas o balanceadores de carga no utilizados. Considere usar AWS Budgets para configurar umbrales de costos y alertas.

20. ¿Cuál es la diferencia entre una aplicación 'con estado' y 'sin estado'?

Una aplicación con estado recuerda los datos (estado) del cliente de una solicitud a la siguiente. Este estado se almacena normalmente en el servidor. Las solicitudes posteriores del mismo cliente dependen de este estado almacenado para funcionar correctamente. Considere una aplicación de carrito de compras. Los artículos que agrega a su carrito se almacenan en el servidor, por lo que cuando navega a otra página y regresa a su carrito, los artículos aún están allí.

Por el contrario, una aplicación sin estado trata cada solicitud como una transacción independiente. No retiene ningún dato del cliente entre las solicitudes. Cada solicitud contiene toda la información necesaria para que el servidor la entienda y la procese. Las API RESTful suelen ser sin estado. Por ejemplo, cada llamada a la API para obtener información del producto debe incluir el ID del producto porque el servidor no 'recuerda' qué producto estaba mirando anteriormente. Si echamos un vistazo al protocolo que utiliza la web, HTTP, podemos ver que es inherentemente sin estado.

21. Explica la diferencia entre Infraestructura como Servicio (IaaS), Plataforma como Servicio (PaaS) y Software como Servicio (SaaS).

IaaS (Infraestructura como Servicio) le proporciona los componentes básicos fundamentales de la infraestructura informática: servidores, máquinas virtuales, almacenamiento, redes y sistemas operativos, a través de Internet. Usted gestiona el sistema operativo, el almacenamiento, las aplicaciones implementadas y quizás algunos componentes de red seleccionados. Piense en ello como el alquiler del hardware.

PaaS (Plataforma como Servicio) proporciona una plataforma que permite a los clientes desarrollar, ejecutar y gestionar aplicaciones sin la complejidad de construir y mantener la infraestructura. Usted gestiona las aplicaciones y los datos. El proveedor se encarga del sistema operativo, los servidores, el almacenamiento y las redes. Considérelo como el alquiler de las herramientas y el banco de trabajo.

SaaS (Software como Servicio) le proporciona un producto completo que es ejecutado y gestionado por el proveedor de servicios. Simplemente utiliza el software. Ejemplos incluyen Gmail, Salesforce y Dropbox. El proveedor gestiona todo, desde la aplicación hasta la infraestructura.

22. ¿Qué es AWS Auto Scaling y por qué es importante?

AWS Auto Scaling es un servicio que ajusta automáticamente el número de recursos informáticos en su entorno AWS en función de la demanda. Ayuda a mantener la disponibilidad de la aplicación y le permite pagar solo por los recursos que utiliza, escalando verticalmente durante las horas pico y reduciendo la escala durante los períodos de baja demanda.

Auto Scaling es importante porque asegura que su aplicación pueda manejar cargas de trabajo variables, evitando cuellos de botella de rendimiento o fallos durante el alto tráfico. También optimiza los costos al reducir el uso de recursos cuando la demanda es baja, lo que genera ahorros significativos.

23. ¿Cómo ayuda AWS con la recuperación ante desastres?

AWS ofrece un conjunto completo de servicios para respaldar diversas estrategias de recuperación ante desastres (DR). Le permite replicar su infraestructura y datos en las instalaciones o basados en la nube a una región de AWS diferente, lo que garantiza la continuidad del negocio en caso de un desastre. Algunos servicios clave de AWS utilizados para DR incluyen:

- AWS Backup: Servicio de respaldo centralizado para varios recursos de AWS (EBS, RDS, etc.) y cargas de trabajo locales.

- Amazon S3: Almacenamiento duradero y escalable para copias de seguridad y replicación de datos.

- Amazon EC2: Se utiliza para aprovisionar recursos informáticos en la región de recuperación.

- AWS CloudEndure Disaster Recovery: Automatiza la replicación de toda su pila de aplicaciones a AWS.

- AWS Site-to-Site VPN/Direct Connect: Establece conexiones seguras entre su entorno local y AWS.

- AWS Route 53: Servicio DNS utilizado para la conmutación por error al enrutar el tráfico a la región de recuperación. La flexibilidad y escalabilidad de AWS le permiten implementar diferentes enfoques de DR, que van desde la simple copia de seguridad y restauración hasta configuraciones activas-activas, según sus requisitos de objetivo de tiempo de recuperación (RTO) y objetivo de punto de recuperación (RPO).

24. ¿Cuáles son algunos conceptos básicos de redes relevantes para AWS?

Algunos conceptos fundamentales de redes cruciales para entender AWS incluyen las VPC (Virtual Private Clouds), que son redes aisladas dentro de AWS. Aspectos clave de las VPC son las subredes (públicas y privadas), las tablas de enrutamiento (que controlan el flujo de tráfico) y los grupos de seguridad (que actúan como cortafuegos virtuales). Entender los bloques CIDR para la asignación de direcciones IP también es importante.

Además, conceptos como DNS (Sistema de Nombres de Dominio), enrutamiento, balanceo de carga y seguridad de red son directamente aplicables. Los servicios de AWS se basan en gran medida en estos principios para la comunicación entre instancias, el acceso a Internet y la garantía de una implementación de aplicaciones segura y fiable. Conceptos como NAT (Traducción de Direcciones de Red) y VPN (Redes Privadas Virtuales) se utilizan para casos de uso específicos, como permitir que las instancias privadas accedan a Internet y conectar redes locales a AWS, respectivamente.

25. ¿Qué es el modelo de responsabilidad compartida en AWS?

El modelo de responsabilidad compartida de AWS define las obligaciones de seguridad entre AWS y el cliente. AWS es responsable de la seguridad de la nube, incluida la infraestructura, el hardware y el software que ejecuta los servicios de AWS. El cliente es responsable de la seguridad en la nube. Esto incluye la gestión del sistema operativo, la plataforma, los datos, las aplicaciones, la gestión de identidades y accesos, y cualquier cosa que el cliente ponga en la nube.

Específicamente, AWS se encarga de la seguridad física, la red y la virtualización. Los clientes gestionan sus datos, sistemas operativos, aplicaciones y configuraciones de grupos de seguridad. La responsabilidad del cliente variará según el servicio utilizado. Por ejemplo, con EC2, el cliente tiene más responsabilidad que con un servicio totalmente gestionado como S3 o DynamoDB.

26. ¿Qué son los grupos de seguridad de AWS y cómo funcionan?

Los grupos de seguridad de AWS actúan como cortafuegos virtuales para sus instancias EC2. Controlan el tráfico entrante y saliente a nivel de instancia. Por defecto, un grupo de seguridad deniega todo el tráfico entrante y permite todo el tráfico saliente.

Los grupos de seguridad funcionan definiendo reglas que especifican el tráfico permitido. Estas reglas tienen estado, lo que significa que si permite el tráfico entrante en un puerto específico, el tráfico saliente correspondiente se permite automáticamente. Puede especificar el protocolo (TCP, UDP, ICMP), el rango de puertos y la dirección IP/bloque CIDR de origen o destino para cada regla. Se pueden asociar múltiples grupos de seguridad con una instancia, y las reglas de todos los grupos asociados se combinan para determinar la política de acceso efectiva.

27. ¿Cuál es la diferencia entre AWS RDS y DynamoDB?

AWS RDS y DynamoDB son servicios de base de datos, pero difieren significativamente en sus modelos subyacentes y casos de uso. RDS es un servicio de base de datos relacional que admite motores como MySQL, PostgreSQL, SQL Server, etc. Los datos se almacenan en tablas con esquemas predefinidos, se admiten transacciones ACID y se pueden realizar uniones. DynamoDB, por otro lado, es una base de datos NoSQL, específicamente un almacén de clave-valor y documentos. Está diseñado para alta escalabilidad, disponibilidad y rendimiento con un esquema flexible.

La diferencia clave radica en el modelo de datos y el enfoque de escalabilidad. RDS proporciona almacenamiento de datos estructurados y una fuerte consistencia, lo que lo hace adecuado para aplicaciones que requieren consultas complejas y datos relacionales. DynamoDB ofrece flexibilidad de esquema y escalabilidad horizontal, lo que lo hace ideal para aplicaciones que necesitan manejar grandes volúmenes de datos y alto tráfico, como juegos, tecnología publicitaria e IoT. DynamoDB intercambia la consistencia fuerte por la disponibilidad y la tolerancia a las particiones (teorema CAP), las lecturas eventualmente consistentes son por defecto y las lecturas fuertemente consistentes son una opción.

28. Explica lo que sabes sobre la computación 'sin servidor'.

La computación sin servidor es un modelo de ejecución de computación en la nube donde el proveedor de la nube gestiona dinámicamente la asignación de recursos de la máquina. Tú, como desarrollador, solo escribes e implementas código sin preocuparte por la infraestructura subyacente. El proveedor escala automáticamente los recursos hacia arriba o hacia abajo según la demanda, y normalmente se te cobra solo por el tiempo de cómputo que consume tu código.

Los beneficios clave incluyen la reducción de la sobrecarga operativa (sin servidores que administrar), el escalado automático y la rentabilidad (pago por uso). Los casos de uso comunes son aplicaciones basadas en eventos, APIs y servicios de backend. AWS Lambda, Azure Functions y Google Cloud Functions son plataformas serverless populares.

29. ¿Qué es Infraestructura como Código (IaC) y cómo es relevante para AWS?

Infraestructura como Código (IaC) es la práctica de gestionar y aprovisionar la infraestructura a través de archivos de definición legibles por máquina, en lugar de la configuración manual o herramientas de configuración interactivas. Esto permite que la infraestructura sea tratada como código de software, lo que permite el control de versiones, pruebas automatizadas y despliegues repetibles.

En el contexto de AWS, IaC es muy relevante porque AWS proporciona una amplia gama de servicios que se pueden automatizar por completo utilizando herramientas como AWS CloudFormation, Terraform, AWS CDK (Cloud Development Kit) y otras. Por ejemplo, puede definir todo su entorno AWS (instancias EC2, buckets S3, VPCs, etc.) en una plantilla de CloudFormation e implementarlo con un solo comando, lo que garantiza la consistencia y reduce el riesgo de error humano. Estas herramientas permiten a los desarrolladores crear entornos de prueba fácilmente o implementar actualizaciones de producción de forma fiable en su infraestructura. El código puede ser tratado como:

Recursos: MyEC2Instance: Type: AWS::EC2::Instance Properties: ImageId: ami-0c55b60b9c137b9d8 InstanceType: t2.micro

Preguntas de entrevista intermedias de AWS

1. Explique cómo usaría AWS CloudFormation para administrar la infraestructura como código, incluidas las estrategias de reversión.

AWS CloudFormation me permite definir y aprovisionar la infraestructura de AWS como código utilizando plantillas (YAML o JSON). Estas plantillas describen los recursos, sus propiedades y dependencias. Definiría mi infraestructura (por ejemplo, instancias EC2, VPC, bases de datos) en una plantilla de CloudFormation. Luego, usaría la CLI de AWS o la Consola de administración para crear un stack a partir de esa plantilla. CloudFormation se encarga del aprovisionamiento y la configuración de estos recursos en el orden especificado.

Para las estrategias de reversión, CloudFormation revierte automáticamente al estado estable anterior si la creación o actualización de la pila falla. También puedo configurar un comportamiento de reversión personalizado utilizando desencadenadores de reversión basados en alarmas de CloudWatch. Esto me permite revertir automáticamente la pila si una métrica crítica, como la utilización de la CPU, excede un cierto umbral después de la implementación. Finalmente, puedo implementar una implementación azul/verde usando CloudFormation para minimizar el tiempo de inactividad durante las actualizaciones. Si el nuevo entorno (verde) falla las comprobaciones de estado, puedo volver fácilmente al entorno original (azul) actualizando la pila de CloudFormation con la configuración original.

2. Describa su experiencia con la implementación de pipelines CI/CD utilizando AWS CodePipeline, CodeBuild y CodeDeploy.

Tengo experiencia en el diseño e implementación de pipelines CI/CD utilizando AWS CodePipeline, CodeBuild y CodeDeploy para automatizar los lanzamientos de software. He configurado CodePipeline para activar compilaciones en los commits de código a repositorios como CodeCommit y GitHub. CodeBuild se utiliza para compilar el código, ejecutar pruebas unitarias y de integración, y empaquetar la aplicación en artefactos desplegables, a menudo utilizando especificaciones de compilación definidas en buildspec.yml. Estos artefactos se almacenan luego en S3.

Para el despliegue, he utilizado CodeDeploy para desplegar estos artefactos en instancias EC2, clústeres ECS y funciones Lambda. Tengo experiencia con diferentes estrategias de despliegue como blue/green y despliegues progresivos para minimizar el tiempo de inactividad. Estoy familiarizado con la escritura de archivos AppSpec (appspec.yml) para definir pasos de despliegue como detener la aplicación, instalar dependencias e iniciar la nueva versión. También he integrado herramientas de monitoreo y mecanismos de reversión automatizados en estos pipelines.

3. ¿Cómo diseñaría una arquitectura de aplicación web altamente disponible y escalable utilizando los servicios de AWS?

Para diseñar una arquitectura de aplicación web altamente disponible y escalable en AWS, aprovecharía varios servicios clave. Para alta disponibilidad, usaría Elastic Load Balancer (ELB) para distribuir el tráfico entre múltiples instancias EC2 en diferentes Zonas de Disponibilidad. Estas instancias formarían parte de un Grupo de Auto Scaling (ASG), configurado para escalar automáticamente el número de instancias según la demanda. Los datos se almacenarían en Amazon RDS (Servicio de Base de Datos Relacional), configurado para la implementación Multi-AZ para garantizar la conmutación por error de la base de datos. Para escalabilidad, la aplicación se diseñaría con microservicios débilmente acoplados, potencialmente utilizando Amazon ECS/EKS para la orquestación de contenedores. Los mecanismos de almacenamiento en caché como Amazon ElastiCache (Memcached o Redis) mejorarían aún más el rendimiento.

Además, Amazon S3 almacenaría recursos estáticos, y Amazon CloudFront se utilizaría como CDN para la entrega rápida de contenido a nivel mundial. El monitoreo y el registro serían cruciales, empleando Amazon CloudWatch para métricas y alarmas, y AWS CloudTrail para la auditoría. Se seguirían los principios de Infraestructura como Código (IaC), utilizando AWS CloudFormation o Terraform para aprovisionar y gestionar toda la infraestructura de manera repetible y automatizada.

4. Explique las diferencias entre AWS SQS, SNS y Kinesis, y cuándo utilizaría cada servicio.

AWS SQS (Simple Queue Service) es un servicio de cola de mensajes totalmente administrado que le permite desacoplar y escalar microservicios, sistemas distribuidos y aplicaciones sin servidor. Se utiliza principalmente para la comunicación asíncrona donde los mensajes se almacenan temporalmente hasta que un consumidor está listo para procesarlos. SNS (Simple Notification Service) es un servicio de mensajería pub/sub totalmente administrado. Se utiliza para transmitir mensajes a múltiples suscriptores (por ejemplo, correo electrónico, SMS, puntos finales HTTP). Kinesis, por otro lado, es una plataforma para la transmisión de datos en AWS, que ofrece servicios como Kinesis Data Streams, Kinesis Data Firehose y Kinesis Data Analytics.

Utilice SQS cuando necesite una cola de mensajes confiable con entrega garantizada, por ejemplo, para procesar pedidos o enviar correos electrónicos. Utilice SNS cuando necesite transmitir mensajes a múltiples suscriptores para notificaciones o arquitecturas de distribución. Utilice Kinesis cuando necesite ingerir, procesar y analizar datos de transmisión en tiempo real, como flujos de clics de sitios web, registros de aplicaciones o datos de sensores de IoT.

5. Describa su experiencia con la protección de recursos de AWS mediante roles de IAM, políticas y grupos de seguridad.

Tengo una amplia experiencia en la protección de recursos de AWS mediante roles de IAM, políticas y grupos de seguridad. He utilizado roles de IAM para otorgar permisos a instancias de EC2, funciones de Lambda y otros servicios de AWS, lo que les permite acceder a otros recursos de AWS sin necesidad de codificar credenciales. Esto incluye la creación de roles con el principio del mínimo privilegio, otorgando solo los permisos necesarios para realizar tareas específicas. Por ejemplo, una función de Lambda que escribe registros en CloudWatch solo necesita los permisos logs:CreateLogGroup, logs:CreateLogStream y logs:PutLogEvents.

También he utilizado grupos de seguridad para controlar el tráfico entrante y saliente hacia instancias de EC2 y otros recursos. He configurado grupos de seguridad para permitir solo puertos y protocolos específicos de fuentes autorizadas, creando efectivamente un cortafuegos virtual. También he trabajado con ACL de red para controlar el tráfico a nivel de subred, proporcionando una capa adicional de seguridad. Al construir infraestructura en la nube, siempre sigo las mejores prácticas de AWS en materia de seguridad.

6. ¿Cómo solucionaría los problemas de rendimiento en un entorno de AWS, considerando factores como la utilización de la CPU, el uso de la memoria y la latencia de la red?

Para solucionar problemas de rendimiento en AWS, comenzaría por monitorear métricas clave utilizando CloudWatch. Para la CPU, configuraría alarmas para que se activen cuando la utilización exceda un cierto umbral (por ejemplo, 80%) e investigaría los procesos que consumen más CPU utilizando top o htop en la instancia EC2. El uso elevado de memoria se examinaría de manera similar, buscando fugas de memoria o código ineficiente. Para la latencia de la red, herramientas como traceroute o mtr pueden ayudar a identificar cuellos de botella. Los registros de flujo de VPC también pueden proporcionar información sobre los patrones de tráfico de la red.

A continuación, analizaría los registros (CloudWatch Logs o registros de S3) de varios servicios de AWS (EC2, Lambda, API Gateway, etc.) para identificar errores u operaciones lentas. Herramientas como X-Ray pueden rastrear las solicitudes a través de servicios distribuidos. Según los hallazgos, tomaría medidas correctivas como escalar recursos, optimizar el código, mejorar las consultas a la base de datos o configurar mecanismos de almacenamiento en caché. Las pruebas de rendimiento regulares son cruciales para evitar problemas futuros.

7. Explique su enfoque para la optimización de costos en AWS, incluyendo estrategias para el dimensionamiento correcto de instancias y la utilización de instancias reservadas.

Mi enfoque en la optimización de costos en AWS implica varias estrategias clave. En primer lugar, me concentro en el dimensionamiento correcto de instancias mediante el monitoreo continuo de la utilización de CPU, el uso de memoria y la entrada/salida de red utilizando herramientas como CloudWatch y AWS Compute Optimizer. Esto ayuda a identificar instancias sobreaprovisionadas que se pueden reducir a tipos o familias de instancias más pequeñas y rentables. También considero el uso de AWS Auto Scaling para ajustar dinámicamente la capacidad de las instancias en función de la demanda. En segundo lugar, aprovecho las Instancias Reservadas (RI) y los Planes de Ahorro para cargas de trabajo predecibles. Al analizar los patrones de uso históricos, determino el número óptimo de RI o Planes de Ahorro para comprar, asegurando descuentos significativos en comparación con los precios bajo demanda. Es fundamental evaluar los patrones de uso con regularidad, ajustando la estrategia de RI para mantenerse al día con las necesidades cambiantes del negocio. Finalmente, evalúo el precio de las instancias spot para cargas de trabajo que pueden tolerar interrupciones.

8. Describa su experiencia con la implementación y gestión de funciones AWS Lambda, incluidas las consideraciones para la concurrencia y el manejo de errores.

Tengo amplia experiencia en la implementación y gestión de funciones AWS Lambda para diversos casos de uso, incluyendo arquitecturas basadas en eventos, backends de API y pipelines de procesamiento de datos. Soy experto en la escritura de funciones Lambda en Python, Node.js y Java, y estoy familiarizado con el framework serverless para el despliegue y la infraestructura como código.

Al diseñar funciones Lambda, priorizo la concurrencia y el manejo de errores. Para la concurrencia, considero factores como la asignación de memoria, el tiempo de espera de la función y la concurrencia aprovisionada para optimizar el rendimiento y evitar la limitación. Para el manejo de errores, implemento mecanismos robustos como bloques try-except con registro y colas de mensajes fallidos (DLQs) para capturar y procesar las invocaciones fallidas. Utilizo métricas y registros de CloudWatch para monitorear el rendimiento de las funciones e identificar posibles problemas, y aprovecho AWS X-Ray para rastrear las solicitudes a través de aplicaciones distribuidas que utilizan Lambda. También utilizo herramientas como Sentry para monitorear errores. Aquí hay un ejemplo simple en Python para el manejo de errores:

import json def lambda_handler(event, context): try: # Tu código aquí result = { 'statusCode': 200, 'body': json.dumps('¡Éxito!') } return result except Exception as e: print(f"Error: {e}") # Enviar error a DLQ o servicio de monitoreo return { 'statusCode': 500, 'body': json.dumps('Error al procesar la solicitud') }

9. ¿Cómo usaría AWS CloudWatch para monitorear la salud y el rendimiento de sus recursos de AWS?

Aprovecharía AWS CloudWatch de varias maneras para monitorear la salud y el rendimiento de los recursos de AWS. Principalmente, usaría CloudWatch Metrics para rastrear indicadores clave de rendimiento (KPI) como la utilización de la CPU, el uso de la memoria, la E/S del disco y el tráfico de red para las instancias EC2, las bases de datos RDS y otros servicios de AWS. Estas métricas proporcionan una línea base y me permiten identificar anomalías o tendencias que indiquen problemas potenciales.

También usaría CloudWatch Logs para recopilar, monitorear y analizar datos de registro de diversas fuentes, incluidas aplicaciones, sistemas operativos y servicios de AWS. Mediante la creación de filtros de métricas, puedo extraer puntos de datos específicos de los registros y generar alarmas basadas en umbrales predefinidos. Además, puedo configurar CloudWatch Alarms para notificarme automáticamente (a través de SNS, por ejemplo) cuando las métricas superen los umbrales especificados, lo que permite la identificación y resolución proactiva de cuellos de botella o fallos de rendimiento. Los paneles de CloudWatch proporcionan una vista centralizada de todos los datos de monitoreo, lo que facilita la resolución de problemas y la optimización del rendimiento.

10. Explique cómo implementaría un plan de recuperación ante desastres para una aplicación que se ejecuta en AWS.

Un plan de recuperación ante desastres (DR) para una aplicación de AWS implica varias estrategias clave. Primero, implemente la replicación de datos en múltiples Zonas de Disponibilidad (AZ) o Regiones utilizando servicios como la replicación entre regiones de S3 o las implementaciones multi-AZ de RDS. Esto garantiza la durabilidad y disponibilidad de los datos incluso si falla una AZ. Segundo, automatice la infraestructura como código (IaC) utilizando CloudFormation o Terraform para recrear rápidamente la pila de la aplicación en una región diferente.

Además, realice copias de seguridad periódicas de los datos y configuraciones críticas. Pruebe el plan de DR periódicamente para validar su efectividad e identificar posibles debilidades. Utilice servicios de AWS como Route 53 para la conmutación por error de DNS para redirigir el tráfico a la región de recuperación. Finalmente, supervise la aplicación y la infraestructura continuamente para detectar fallos con prontitud y activar el proceso de DR automáticamente utilizando alarmas de CloudWatch y funciones Lambda.

11. Describa su experiencia con el uso de AWS RDS para la gestión de bases de datos, incluidas las copias de seguridad, el escalado y el ajuste del rendimiento.

Tengo experiencia en el uso de AWS RDS para la gestión de bases de datos, específicamente con MySQL y PostgreSQL. Para las copias de seguridad, he implementado programaciones de copias de seguridad automatizadas y he probado los procedimientos de restauración para la recuperación ante desastres. El escalado se manejó tanto verticalmente (actualizaciones del tamaño de la instancia) como horizontalmente (réplicas de lectura para cargas de trabajo intensivas en lectura). También he utilizado RDS Proxy para gestionar las conexiones a la base de datos y reducir los tiempos de conmutación por error.

En cuanto a la optimización del rendimiento, he utilizado herramientas como Performance Insights para identificar consultas lentas y optimizarlas mediante la creación de índices. El monitoreo de métricas de CloudWatch, como la utilización de la CPU, el consumo de memoria y la E/S de disco, fue crucial para identificar proactivamente posibles cuellos de botella. También he ajustado parámetros de la base de datos como innodb_buffer_pool_size para MySQL para mejorar el rendimiento en función de la carga de trabajo observada.

12. ¿Cómo abordaría la migración de una aplicación local a AWS, considerando factores como la migración de datos y la compatibilidad de la aplicación?

La migración de una aplicación local a AWS implica un enfoque por fases. Primero, evalúe la arquitectura, las dependencias y el volumen de datos de la aplicación para determinar la mejor estrategia de migración (rehost, replatform, refactor, repurchase o retire). La migración de datos es crítica; las opciones incluyen el uso de AWS DMS, Snowball o S3 para transferir datos, eligiendo el método apropiado en función del tamaño de los datos, la velocidad de transferencia y la tolerancia al tiempo de inactividad. La compatibilidad de la aplicación debe verificarse, lo que podría requerir modificaciones de código o actualizaciones de middleware para garantizar que la aplicación funcione correctamente en el entorno de AWS.

A continuación, cree un plan de migración que describa los pasos involucrados, incluyendo pruebas y procedimientos de reversión. Considere el uso de servicios de AWS como CloudFormation o Terraform para implementaciones de infraestructura como código. La seguridad es primordial, por lo que implemente medidas de seguridad apropiadas, como roles de IAM y grupos de seguridad. Después de la migración, supervise continuamente el rendimiento de la aplicación y optimice los recursos para garantizar la rentabilidad y escalabilidad. Elija servicios como CloudWatch para el monitoreo y Auto Scaling para el escalado según la demanda.

13. Explique las diferencias entre AWS EBS y EFS, y cuándo usaría cada servicio de almacenamiento.

AWS EBS (Elastic Block Storage) y EFS (Elastic File System) son ambos servicios de almacenamiento, pero atienden a diferentes necesidades. EBS es almacenamiento en bloque, conectado directamente a una sola instancia de EC2. Piense en ello como un disco duro. Es ideal para casos de uso que requieren acceso de baja latencia desde una sola instancia, como sistemas operativos, bases de datos y aplicaciones que requieren acceso directo al almacenamiento en bloque.

EFS, por otro lado, es un sistema de archivos de red que puede ser montado por múltiples instancias de EC2 concurrentemente. Es adecuado para almacenamiento de archivos compartidos, repositorios de contenido y aplicaciones que necesitan acceso compartido a los mismos datos. EBS es generalmente más económico y rápido para el uso de una sola instancia, mientras que EFS proporciona escalabilidad y accesibilidad a través de múltiples instancias.

14. Describe su experiencia con el uso de AWS VPC para crear una red privada en la nube.

Tengo experiencia en el uso de AWS VPC para crear redes privadas en la nube para varios proyectos. He configurado VPC con bloques CIDR personalizados, subredes (tanto públicas como privadas), tablas de enrutamiento y grupos de seguridad para controlar el tráfico de red. También he trabajado con VPC Peering para conectar diferentes VPC y he utilizado VPN Gateways o Direct Connect para establecer conexiones seguras entre redes locales y VPC.

Específicamente, tengo experiencia práctica con:

- Creación de VPC y subredes: Definición de bloques CIDR y tamaños de subredes apropiados según los requisitos de la aplicación.

- Configuración de tablas de enrutamiento: Configuración de rutas para dirigir el tráfico entre subredes, a Internet (a través de una puerta de enlace de Internet) y a otras VPC.

- Implementación de grupos de seguridad y ACL de red: Control del tráfico entrante y saliente a nivel de instancia y subred.

- Configuración de NAT Gateways: Permiso a las instancias en subredes privadas para acceder a Internet sin estar expuestas directamente.

- Utilización de VPC Peering y VPN Gateways: Establecimiento de conexiones seguras y privadas entre VPC y redes locales. Por ejemplo, una vez configuré una puerta de enlace VPN para conectar una VPC de desarrollo a nuestra red corporativa utilizando túneles IPsec, asegurando que solo los usuarios autorizados pudieran acceder al entorno de desarrollo. También he utilizado AWS CloudFormation para automatizar la creación y gestión de VPC.

15. ¿Cómo usaría AWS Auto Scaling para ajustar automáticamente el número de instancias EC2 según la demanda?

Usaría AWS Auto Scaling creando primero una configuración de lanzamiento o una plantilla de lanzamiento que defina el tipo de instancia EC2, la AMI, los grupos de seguridad y otras configuraciones de la instancia. Luego, crearía un grupo de Auto Scaling (ASG) y configuraría su capacidad deseada, capacidad mínima y capacidad máxima. Para ajustar dinámicamente el número de instancias, definiría políticas de escalado basadas en métricas de CloudWatch, como la utilización de la CPU o el tráfico de red.

Por ejemplo, una política de escalado podría configurarse para agregar instancias EC2 cuando la utilización promedio de la CPU en todas las instancias del ASG supera el 70% y eliminar instancias cuando cae por debajo del 30%. Estas políticas pueden usar escalado simple (por ejemplo, agregar una instancia) o escalado por pasos (por ejemplo, agregar instancias según la magnitud de la alarma). También consideraría usar el escalado de seguimiento de objetivos para mantener un valor objetivo específico para una métrica, como la utilización promedio de la CPU al 50%.

16. Explique cómo usaría AWS S3 para el almacenamiento de objetos, incluyendo versionado, políticas de ciclo de vida y consideraciones de seguridad.

Usaría AWS S3 para el almacenamiento de objetos debido a su escalabilidad, durabilidad y rentabilidad. El versionado se habilitaría para preservar versiones anteriores de los objetos, protegiendo contra la eliminación o sobrescritura accidental. Las políticas de ciclo de vida automatizarían las transiciones de objetos, moviendo datos a los que se accede con poca frecuencia a clases de almacenamiento más económicas como S3 Standard-IA o Glacier después de un período especificado. Esto optimiza los costos de almacenamiento en función de los patrones de acceso.

La seguridad es primordial. Las políticas de bucket y los roles de IAM controlarían los permisos de acceso, asegurando que solo los usuarios y servicios autorizados puedan acceder a los recursos de S3. El cifrado en reposo (usando SSE-S3 o SSE-KMS) y en tránsito (usando HTTPS) protegería la confidencialidad de los datos. Los registros de acceso se habilitarían para la auditoría y el monitoreo de seguridad. MFA Delete agregaría una capa adicional de seguridad contra la eliminación accidental o maliciosa.

17. Describa su experiencia con el uso de AWS ECS o EKS para administrar aplicaciones en contenedores.

Tengo experiencia usando AWS ECS para administrar aplicaciones en contenedores. Lo he usado para desplegar y escalar aplicaciones, definiendo definiciones de tareas, servicios y clústeres utilizando tanto la Consola de administración de AWS como herramientas de Infraestructura como código (IaC) como Terraform. He configurado el balanceo de carga utilizando Application Load Balancers (ALB) para distribuir el tráfico entre las tareas, y he implementado políticas de auto-escalado basadas en la utilización de CPU y memoria. También tengo experiencia en la configuración de tuberías CI/CD con herramientas como Jenkins y AWS CodePipeline para automatizar la construcción, prueba e implementación de imágenes de contenedores en ECS.

Aunque tengo menos experiencia práctica con EKS, entiendo sus conceptos básicos y cómo aprovecha Kubernetes para la orquestación de contenedores. He estudiado su arquitectura y sé que ofrece más flexibilidad y control en comparación con ECS, aunque a costa de una mayor complejidad operativa. Estoy familiarizado con conceptos de Kubernetes como pods, implementaciones y servicios, y conozco las diferentes opciones de red y consideraciones de seguridad al usar EKS. Estoy ansioso por ampliar mi experiencia práctica con EKS.

18. ¿Cómo implementaría una arquitectura multirregional en AWS para alta disponibilidad y recuperación ante desastres?

Para implementar una arquitectura multirregional en AWS para alta disponibilidad (HA) y recuperación ante desastres (DR), aprovecharía varios servicios de AWS. Para HA, usaría servicios como Route 53 para la conmutación por error basada en DNS, asegurando que el tráfico se dirija a una región en buen estado. Los Application Load Balancers (ALB) distribuirían el tráfico dentro de cada región. La replicación de datos usando servicios como DynamoDB Global Tables o la replicación entre regiones para buckets de S3 también es importante para garantizar la consistencia de los datos entre regiones. Las implementaciones Multi-AZ de RDS ofrecen HA dentro de una región.

Para la recuperación ante desastres (DR), implementaría una estrategia que implica copias de seguridad periódicas (instantáneas de RDS, instantáneas de EBS) en una región separada. AWS CloudFormation o Terraform pueden automatizar el aprovisionamiento de la infraestructura en la región de DR. En caso de una falla regional, Route 53 conmutaría por error a la región de DR, y la infraestructura se aprovisionaría, lo que permitiría que la aplicación reanude sus operaciones. Probar regularmente el proceso de conmutación por error es crucial para garantizar su efectividad.

19. Explique cómo usaría AWS Route 53 para la gestión de DNS y el enrutamiento del tráfico.

Usaría AWS Route 53 para la gestión de DNS creando zonas alojadas para mis dominios. Dentro de estas zonas, definiría registros DNS como A, CNAME, MX y TXT para que apunten a mis servidores de aplicaciones, equilibradores de carga u otros servicios de AWS. Route 53 admite varias políticas de enrutamiento para la gestión del tráfico.