78 Preguntas de entrevista sobre almacenamiento de datos para hacer a los candidatos

El almacenamiento de datos es un campo complejo que requiere una combinación única de habilidades técnicas y analíticas. Para encontrar el talento adecuado para su organización, es crucial hacer las preguntas correctas en la entrevista que evalúen el conocimiento, la experiencia y las habilidades de resolución de problemas de un candidato en el almacenamiento de datos.

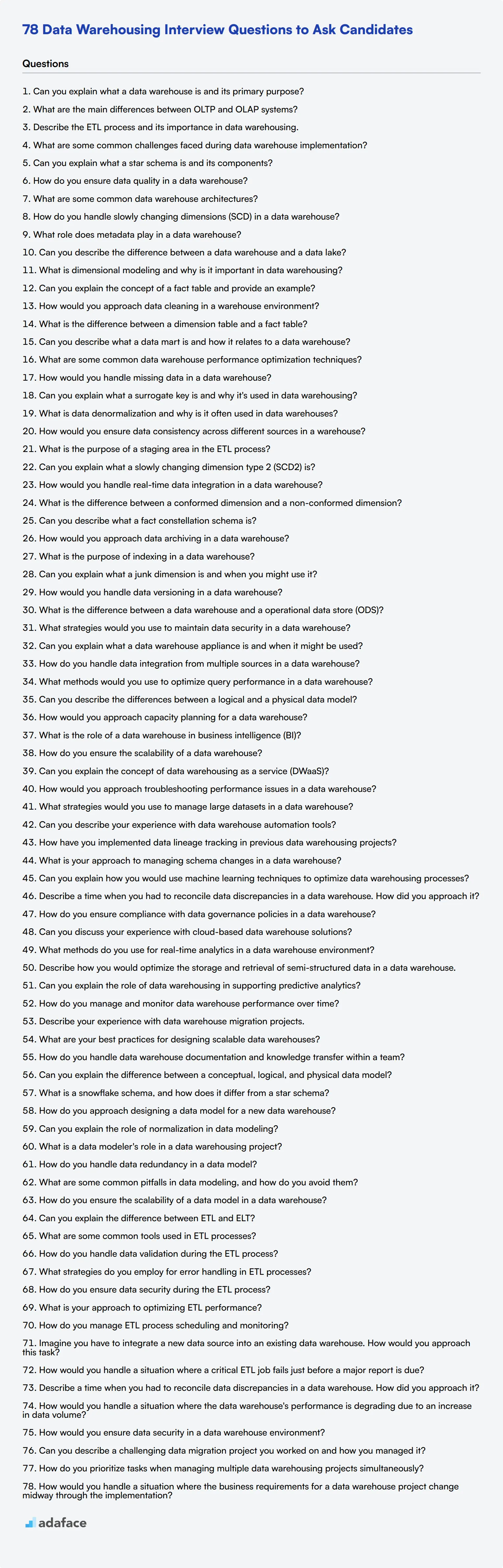

Esta publicación de blog proporciona una lista completa de preguntas de entrevista sobre almacenamiento de datos adaptadas a diferentes niveles de experiencia, desde analistas junior hasta senior. Hemos categorizado las preguntas en niveles básico, intermedio y avanzado, así como en áreas específicas como modelado de datos, procesos ETL y escenarios situacionales.

Al usar estas preguntas, puede evaluar de manera efectiva la experiencia de los candidatos en el almacenamiento de datos y tomar decisiones de contratación informadas. Además, considere incorporar una evaluación de habilidades de almacenamiento de datos antes de la etapa de la entrevista para optimizar su proceso de reclutamiento e identificar a los mejores talentos de manera más eficiente.

Tabla de contenido

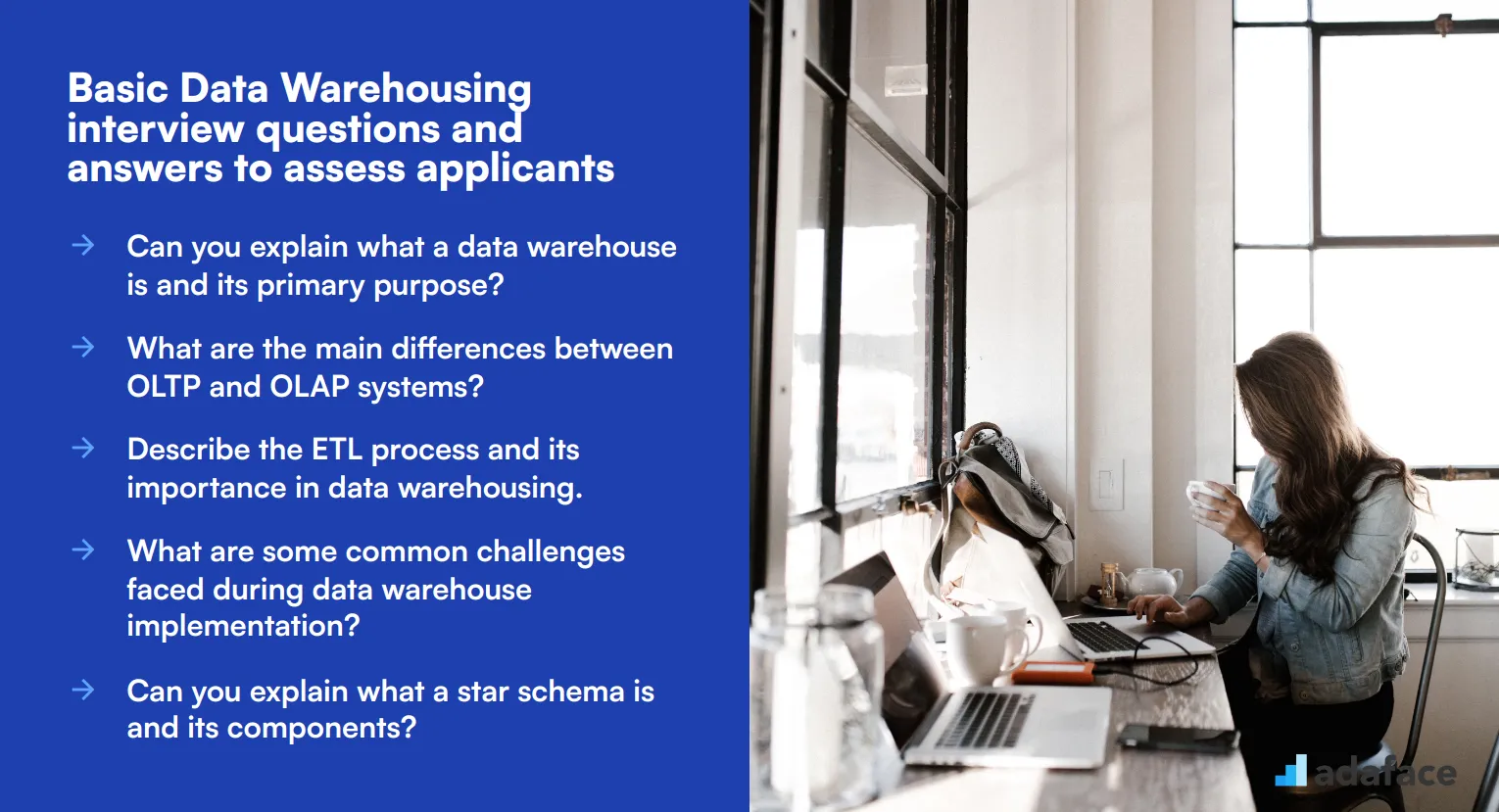

10 preguntas y respuestas básicas de la entrevista sobre almacenamiento de datos para evaluar a los solicitantes

20 preguntas de la entrevista sobre almacenamiento de datos para preguntar a los analistas junior

10 preguntas y respuestas intermedias de la entrevista sobre almacenamiento de datos para preguntar a los analistas de nivel medio

15 preguntas avanzadas de la entrevista sobre almacenamiento de datos para preguntar a los analistas senior

8 preguntas y respuestas de la entrevista sobre almacenamiento de datos relacionadas con el modelado de datos

7 preguntas y respuestas de la entrevista sobre almacenamiento de datos relacionadas con los procesos ETL

8 preguntas situacionales de la entrevista sobre almacenamiento de datos con respuestas para contratar a los mejores analistas

¿Qué habilidades de almacenamiento de datos debe evaluar durante la fase de la entrevista?

Consejos para entrevistas efectivas sobre almacenamiento de datos

Use preguntas de entrevista y pruebas de habilidades de almacenamiento de datos para contratar analistas talentosos

Descargue la plantilla de preguntas de entrevista sobre almacenamiento de datos en múltiples formatos

10 preguntas y respuestas básicas para entrevistas sobre almacenamiento de datos para evaluar a los candidatos

Para evaluar eficazmente si un candidato posee las habilidades y conocimientos fundamentales para un puesto en Almacenamiento de Datos, utilice estas preguntas de entrevista. Están diseñadas para ayudarle a evaluar rápidamente la comprensión de un solicitante y ver si es el adecuado para su equipo.

1. ¿Puede explicar qué es un data warehouse y cuál es su propósito principal?

Un data warehouse es un repositorio centralizado que almacena grandes volúmenes de datos de múltiples fuentes. Su propósito principal es proporcionar una imagen coherente del negocio en un momento dado, agregando y organizando datos de una manera que está optimizada para la consulta y el análisis.

Busque candidatos que puedan articular claramente el papel de un data warehouse para facilitar las actividades de inteligencia empresarial, como la elaboración de informes, el análisis de datos y el apoyo a la toma de decisiones. Deben mencionar que los data warehouses están diseñados para operaciones de lectura intensiva y son esenciales para el análisis de datos históricos.

2. ¿Cuáles son las principales diferencias entre los sistemas OLTP y OLAP?

Los sistemas OLTP (Online Transaction Processing) están diseñados para gestionar datos transaccionales, lo que implica un gran número de transacciones cortas en línea. Se centran en la velocidad, la eficiencia y la integridad de los datos al procesar las operaciones diarias.

Los sistemas OLAP (Online Analytical Processing), por otro lado, están diseñados para la consulta y el análisis en lugar del procesamiento de transacciones. Los sistemas OLAP facilitan consultas complejas y el análisis de datos, lo que ayuda en los procesos de toma de decisiones.

Los candidatos fuertes deberían ser capaces de resaltar estas diferencias clave y enfatizar que los sistemas OLTP están optimizados para tareas operativas, mientras que los sistemas OLAP están optimizados para el análisis de datos y la elaboración de informes.

3. Describa el proceso ETL y su importancia en el almacenamiento de datos.

ETL significa Extraer, Transformar, Cargar. Es el proceso de extraer datos de diversas fuentes, transformarlos en un formato o estructura adecuado para la consulta y el análisis, y luego cargarlos en el data warehouse.

El proceso ETL es crucial en el almacenamiento de datos porque asegura que los datos sean precisos, consistentes y utilizables para las actividades de inteligencia de negocios. Ayuda a integrar y consolidar datos de diferentes fuentes, lo que facilita su análisis y la obtención de conocimientos.

Busque candidatos que puedan proporcionar una explicación clara y concisa de cada paso del proceso ETL y que comprendan su importancia para mantener la calidad y la fiabilidad de los datos dentro de un data warehouse.

4. ¿Cuáles son algunos de los desafíos comunes que se enfrentan durante la implementación de un data warehouse?

Los desafíos comunes durante la implementación de un data warehouse incluyen problemas de integración de datos, garantizar la calidad de los datos, gestionar grandes volúmenes de datos y mantener la seguridad y privacidad de los datos.

Otros desafíos pueden implicar alinear el diseño del data warehouse con los requisitos del negocio, optimizar el rendimiento y garantizar la escalabilidad para manejar el crecimiento futuro de los datos.

Los candidatos ideales deben ser capaces de discutir estos desafíos y proporcionar ejemplos de cómo los han abordado o mitigado en sus funciones anteriores. También deben demostrar una comprensión de las mejores prácticas para la implementación exitosa de un almacén de datos.

5. ¿Puede explicar qué es un esquema de estrella y sus componentes?

Un esquema de estrella es un tipo de esquema de base de datos que se utiliza comúnmente en el almacenamiento de datos. Consiste en una tabla de hechos central que contiene datos cuantitativos (como ventas o ingresos), rodeada de tablas de dimensiones que contienen atributos descriptivos relacionados con los datos de la tabla de hechos.

La tabla de hechos y las tablas de dimensiones están conectadas por relaciones de clave externa, formando un patrón en forma de estrella cuando se visualiza, de ahí el nombre 'esquema de estrella'.

Los candidatos deben ser capaces de explicar esto claramente e idealmente proporcionar un ejemplo para ilustrar su comprensión. Busque una discusión sobre los beneficios de usar un esquema de estrella, como la simplicidad, el rendimiento mejorado de las consultas y la facilidad de uso en la generación de informes y análisis.

6. ¿Cómo asegura la calidad de los datos en un almacén de datos?

Asegurar la calidad de los datos en un almacén de datos implica varias prácticas, como el perfilado de datos, la limpieza de datos, la validación de datos y el monitoreo continuo.

El perfilado de datos ayuda a comprender los datos e identificar cualquier inconsistencia o anomalía. La limpieza de datos implica la corrección o eliminación de registros inexactos de los datos. La validación de datos garantiza que los datos cumplan con los estándares y reglas de negocio requeridos.

Busque candidatos que enfaticen la importancia de mantener una alta calidad de datos y describan técnicas o herramientas específicas que hayan utilizado para lograrlo. También deben mencionar el papel de la gobernanza y las auditorías periódicas en el mantenimiento de la calidad de los datos.

7. ¿Cuáles son algunas arquitecturas comunes de almacenes de datos?

Las arquitecturas comunes de almacenes de datos incluyen la arquitectura de una sola capa, la arquitectura de dos capas y la arquitectura de tres capas.

La arquitectura de una sola capa tiene como objetivo minimizar la cantidad de datos almacenados eliminando la redundancia. La arquitectura de dos capas separa el almacén de datos de los sistemas operativos, mejorando el rendimiento y la escalabilidad. La arquitectura de tres capas agrega una capa adicional, típicamente un data mart, entre el almacén de datos y los usuarios finales, mejorando la accesibilidad y el rendimiento de los datos.

Los candidatos deben ser capaces de explicar estas arquitecturas y discutir sus ventajas y desventajas. También deben mencionar escenarios donde cada arquitectura podría ser apropiada.

8. ¿Cómo se gestionan las dimensiones de cambio lento (SCD) en un almacén de datos?

Las Dimensiones de Cambio Lento (SCD) son dimensiones que cambian lentamente con el tiempo, en lugar de hacerlo según un cronograma regular. Hay varios métodos para manejar SCD, comúnmente conocidos como Tipo 1, Tipo 2 y Tipo 3.

El Tipo 1 implica sobrescribir los datos antiguos con datos nuevos. El Tipo 2 crea un nuevo registro para cada cambio, preservando los datos históricos. El Tipo 3 agrega nuevas columnas para rastrear los cambios y preservar algunos datos históricos.

Los candidatos deben ser capaces de explicar estos métodos y discutir sus pros y contras. También deben proporcionar ejemplos de cuándo podría usarse cada método y cómo han implementado el manejo de SCD en sus proyectos anteriores.

9. ¿Qué papel juega la metadatos en un data warehouse?

Los metadatos en un data warehouse proporcionan información sobre los datos, incluyendo su origen, estructura, transformaciones y uso. Ayuda a organizar, gestionar y comprender los datos almacenados en el almacén.

Los metadatos son esenciales para la gobernanza de datos, la calidad de los datos y para garantizar que los usuarios puedan encontrar y utilizar los datos de manera efectiva. Incluyen metadatos técnicos (detalles sobre el modelo de datos y los procesos ETL) y metadatos de negocio (definiciones, reglas y descripciones).

Busque candidatos que comprendan la importancia de los metadatos y puedan explicar cómo se utilizan para mejorar la gestión y usabilidad de los datos. También deben mencionar cualquier herramienta o práctica que hayan utilizado para gestionar los metadatos de manera efectiva.

10. ¿Puede describir la diferencia entre un almacén de datos (data warehouse) y un lago de datos (data lake)?

Un almacén de datos es un repositorio centralizado que almacena datos estructurados de diversas fuentes, optimizado para consultas y análisis. Por lo general, implica un esquema predefinido y se utiliza para actividades de inteligencia empresarial.

Un lago de datos, por otro lado, es un repositorio de almacenamiento que puede contener grandes volúmenes de datos sin procesar en su formato nativo, incluidos datos estructurados, semiestructurados y no estructurados. Los lagos de datos se utilizan para el análisis de big data, el aprendizaje automático y la exploración de datos.

Los candidatos deben poder explicar estas diferencias y discutir escenarios donde cada uno podría ser apropiado. También deben mencionar los beneficios y desafíos asociados con los almacenes de datos y los lagos de datos.

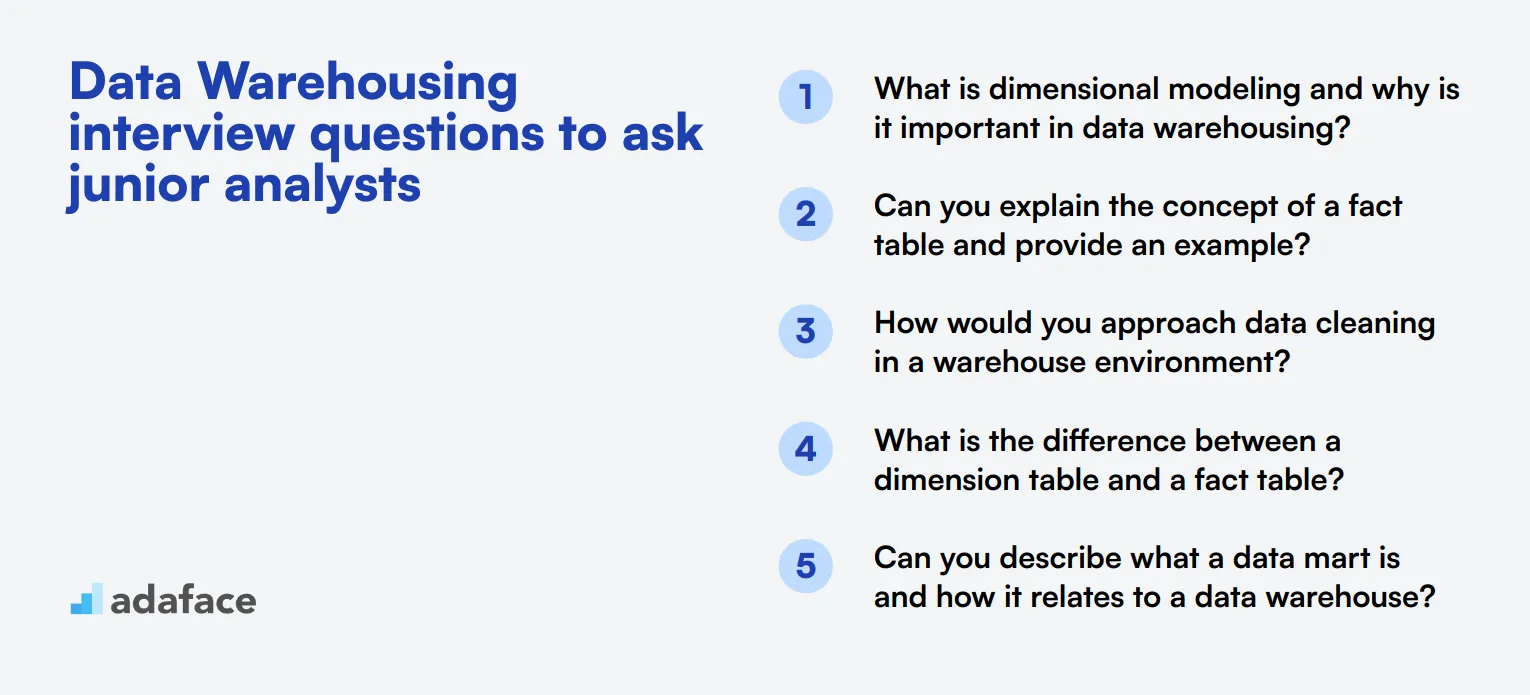

20 preguntas de entrevista sobre almacenamiento de datos para analistas junior

Para evaluar el conocimiento fundamental de los analistas de datos junior en almacenamiento de datos, considere usar estas 20 preguntas de entrevista. Estas preguntas están diseñadas para evaluar la comprensión básica y las habilidades prácticas, lo que le ayudará a identificar a los candidatos con el potencial de crecer en este campo.

- ¿Qué es el modelado dimensional y por qué es importante en el almacenamiento de datos? 2. ¿Puede explicar el concepto de una tabla de hechos y proporcionar un ejemplo? 3. ¿Cómo abordaría la limpieza de datos en un entorno de almacenamiento de datos? 4. ¿Cuál es la diferencia entre una tabla de dimensiones y una tabla de hechos? 5. ¿Puede describir qué es un data mart y cómo se relaciona con un data warehouse? 6. ¿Cuáles son algunas técnicas comunes de optimización del rendimiento del data warehouse? 7. ¿Cómo manejaría los datos faltantes en un data warehouse? 8. ¿Puede explicar qué es una clave sustituta y por qué se utiliza en el almacenamiento de datos? 9. ¿Qué es la desnormalización de datos y por qué se utiliza a menudo en los data warehouses? 10. ¿Cómo aseguraría la consistencia de los datos en diferentes fuentes en un data warehouse? 11. ¿Cuál es el propósito de un área de preparación en el proceso ETL? 12. ¿Puede explicar qué es una dimensión de cambio lento tipo 2 (SCD2)? 13. ¿Cómo manejaría la integración de datos en tiempo real en un data warehouse? 14. ¿Cuál es la diferencia entre una dimensión conformada y una dimensión no conformada? 15. ¿Puede describir qué es un esquema de constelación de hechos? 16. ¿Cómo abordaría el archivo de datos en un data warehouse? 17. ¿Cuál es el propósito de la indexación en un data warehouse? 18. ¿Puede explicar qué es una dimensión basura y cuándo podría usarla? 19. ¿Cómo manejaría el versionado de datos en un data warehouse? 20. ¿Cuál es la diferencia entre un data warehouse y un almacén de datos operativo (ODS)?

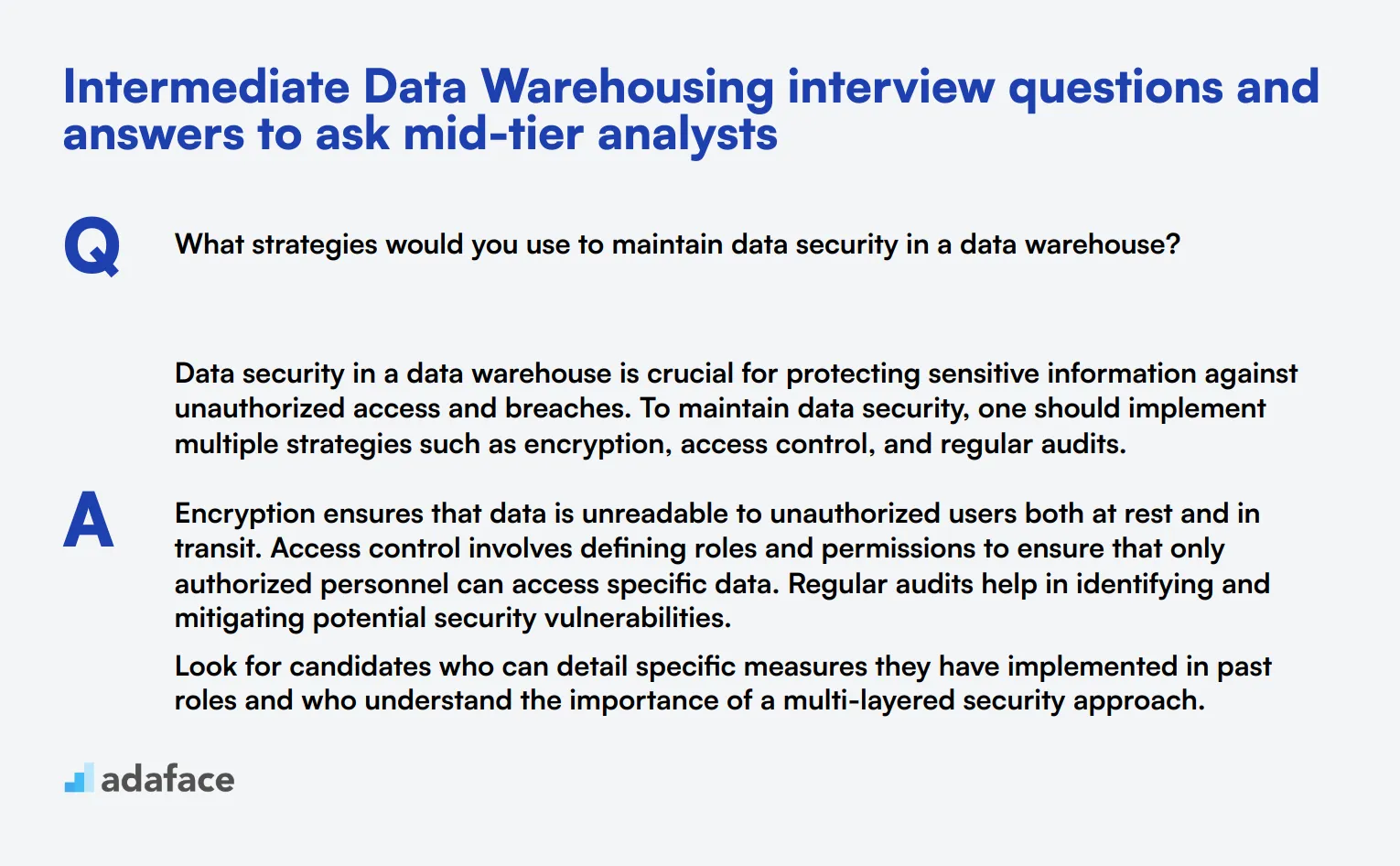

10 preguntas y respuestas intermedias de entrevista sobre almacenamiento de datos para preguntar a analistas de nivel medio

Para asegurar que sus analistas de nivel medio tengan las habilidades adecuadas, estas 10 preguntas y respuestas intermedias de entrevista sobre almacenamiento de datos le ayudarán a identificar a los candidatos con la experiencia y el conocimiento correctos. Utilice estas preguntas para profundizar un poco más en su comprensión y capacidades sin ser demasiado técnico.

1. ¿Qué estrategias utilizaría para mantener la seguridad de los datos en un data warehouse?

La seguridad de los datos en un data warehouse es crucial para proteger la información confidencial contra accesos no autorizados y violaciones. Para mantener la seguridad de los datos, se deben implementar múltiples estrategias como el cifrado, el control de acceso y las auditorías periódicas.

El cifrado asegura que los datos sean ilegibles para usuarios no autorizados, tanto en reposo como en tránsito. El control de acceso implica definir roles y permisos para asegurar que solo el personal autorizado pueda acceder a datos específicos. Las auditorías periódicas ayudan a identificar y mitigar posibles vulnerabilidades de seguridad.

Busque candidatos que puedan detallar medidas específicas que hayan implementado en roles anteriores y que comprendan la importancia de un enfoque de seguridad de múltiples capas.

2. ¿Puede explicar qué es un dispositivo de almacenamiento de datos (data warehouse appliance) y cuándo podría utilizarse?

Un dispositivo de almacenamiento de datos es un conjunto integrado de hardware y software diseñado específicamente para el almacenamiento de datos. Típicamente incluye almacenamiento optimizado, potencia de procesamiento y sistemas de gestión de bases de datos adaptados para el procesamiento y análisis de datos de alto rendimiento.

Los dispositivos de almacenamiento de datos se utilizan a menudo en entornos que requieren una implementación rápida, escalabilidad y alto rendimiento con una configuración mínima. Las organizaciones eligen estos dispositivos para reducir la complejidad de la configuración y el mantenimiento de un almacén de datos.

Los candidatos ideales deben ser capaces de discutir los beneficios de usar un dispositivo de almacenamiento de datos y proporcionar ejemplos de escenarios en los que lo hayan utilizado o recomendarían su uso.

3. ¿Cómo maneja la integración de datos de múltiples fuentes en un almacén de datos?

Manejar la integración de datos de múltiples fuentes implica combinar datos de diferentes bases de datos, aplicaciones o sistemas en un único almacén unificado. Este proceso a menudo se basa en herramientas ETL (Extracción, Transformación, Carga) para extraer datos de los sistemas de origen, transformarlos a un formato adecuado y cargarlos en el almacén de datos.

Los pasos clave incluyen la elaboración de perfiles de datos para comprender los datos de origen, la limpieza de datos para garantizar la calidad y el mapeo de datos para alinear diferentes formatos de datos. También es esencial programar actualizaciones regulares de datos para mantener el almacén actualizado.

Un candidato eficaz debe demostrar familiaridad con varias herramientas y metodologías ETL e ilustrar su capacidad para gestionar con éxito proyectos complejos de integración de datos.

4. ¿Qué métodos utilizaría para optimizar el rendimiento de las consultas en un data warehouse?

Para optimizar el rendimiento de las consultas en un data warehouse, se pueden emplear varios métodos. La indexación, la partición y las vistas materializadas son técnicas comúnmente utilizadas.

La indexación mejora la velocidad de las consultas al permitir una recuperación de datos más rápida. La partición divide las tablas grandes en piezas más pequeñas y manejables, lo que puede reducir la cantidad de datos escaneados durante una consulta. Las vistas materializadas almacenan resultados precalculados de las consultas y pueden acelerar significativamente los cálculos complejos.

Busque candidatos que puedan proporcionar ejemplos de cómo han utilizado estos métodos en proyectos anteriores y que demuestren una comprensión de cuándo y por qué se debe aplicar cada técnica.

5. ¿Puede describir las diferencias entre un modelo de datos lógico y uno físico?

Un modelo de datos lógico representa la estructura abstracta de los datos, centrándose en las relaciones y reglas sin considerar cómo se almacenarán físicamente los datos. Incluye entidades, atributos y relaciones y se utiliza para definir los requisitos comerciales.

En contraste, un modelo de datos físico traduce el modelo lógico en un esquema de base de datos específico. Considera los aspectos técnicos, incluyendo tablas, columnas, tipos de datos, índices y restricciones. El modelo físico se utiliza para implementar la base de datos en un sistema de gestión de bases de datos específico.

Los candidatos deben ser capaces de explicar la importancia de ambos modelos y cómo transicionan de uno a otro. También deben proporcionar ejemplos de su experiencia en la creación y el uso de estos modelos en proyectos de almacenamiento de datos.

6. ¿Cómo abordaría la planificación de la capacidad para un data warehouse?

La planificación de la capacidad para un data warehouse implica estimar los requisitos de almacenamiento, procesamiento y memoria para asegurar un rendimiento y escalabilidad óptimos. Incluye el análisis de los volúmenes de datos actuales, las tendencias de crecimiento y la carga de trabajo esperada.

Los pasos clave incluyen la evaluación de las políticas de retención de datos, las técnicas de compresión y el crecimiento futuro de los datos. También implica considerar los requisitos de rendimiento para las consultas y las cargas de datos. Es esencial revisar y ajustar regularmente el plan de capacidad para adaptarse a las necesidades cambiantes.

Busque candidatos que puedan discutir su experiencia con la planificación de la capacidad y que demuestren una comprensión del equilibrio entre el costo, el rendimiento y la escalabilidad en su proceso de planificación.

7. ¿Cuál es el papel de un almacén de datos en la inteligencia empresarial (IE)?

Un almacén de datos desempeña un papel central en la inteligencia empresarial al proporcionar una fuente de datos consolidada y consistente para informes y análisis. Agrega datos de diversas fuentes, lo que permite a las organizaciones obtener información y tomar decisiones informadas.

En IE, un almacén de datos admite consultas complejas, análisis de datos históricos e identificación de tendencias. Sirve como base para herramientas de visualización de datos, paneles de control y sistemas de informes, lo que facilita una mejor toma de decisiones basada en datos.

Los candidatos deben explicar cómo han utilizado almacenes de datos para respaldar iniciativas de IE y proporcionar ejemplos de cómo la IE se ha beneficiado de un entorno de almacenamiento de datos bien estructurado.

8. ¿Cómo asegura la escalabilidad de un almacén de datos?

Asegurar la escalabilidad de un almacén de datos implica diseñarlo para manejar el aumento de los volúmenes de datos y las cargas de usuarios sin comprometer el rendimiento. Las estrategias clave incluyen el uso de arquitecturas escalables, la optimización del almacenamiento de datos y la implementación de técnicas eficientes de indexación y particionamiento.

Las soluciones basadas en la nube pueden ofrecer escalabilidad elástica, lo que permite ajustar dinámicamente los recursos según la demanda. Además, el empleo de la computación distribuida y el procesamiento en paralelo puede mejorar la escalabilidad.

Busque candidatos que puedan discutir su experiencia con tecnologías de almacenamiento de datos escalables y proporcionar ejemplos de cómo han escalado los almacenes de datos para satisfacer las crecientes necesidades organizativas.

9. ¿Puede explicar el concepto de almacenamiento de datos como servicio (DWaaS)?

El Almacenamiento de Datos como Servicio (DWaaS) es un servicio basado en la nube que proporciona capacidades de almacenamiento de datos sin la necesidad de una infraestructura local. Ofrece almacenamiento, procesamiento y gestión de datos escalables, lo que permite a las organizaciones centrarse en el análisis de datos en lugar del mantenimiento de la infraestructura.

Las soluciones DWaaS suelen incluir herramientas ETL, servicios de integración de datos y plataformas de análisis. Proporcionan flexibilidad, rentabilidad y facilidad de uso, lo que las hace atractivas para las organizaciones que buscan aprovechar el almacenamiento de datos sin inversiones iniciales significativas.

Los candidatos deben explicar los beneficios de DWaaS, como la escalabilidad, el ahorro de costes y la reducción del mantenimiento, y proporcionar ejemplos de su experiencia con plataformas DWaaS como Amazon Redshift o Google BigQuery.

10. ¿Cómo abordaría la solución de problemas de rendimiento en un almacén de datos?

La solución de problemas de rendimiento en un almacén de datos requiere un enfoque sistemático para identificar y resolver los cuellos de botella. Los pasos clave incluyen el análisis del rendimiento de las consultas, la comprobación de las estrategias de indexación y la revisión de los métodos de almacenamiento y partición de datos.

Las herramientas de supervisión pueden proporcionar información sobre la utilización de los recursos, los tiempos de ejecución de las consultas y los registros del sistema. La identificación y la solución de consultas ineficientes, la optimización de los índices y la garantía de una distribución adecuada de los datos son esenciales para mejorar el rendimiento.

Los candidatos deben demostrar su experiencia con herramientas y técnicas de resolución de problemas y proporcionar ejemplos de cómo han resuelto con éxito problemas de rendimiento en proyectos anteriores.

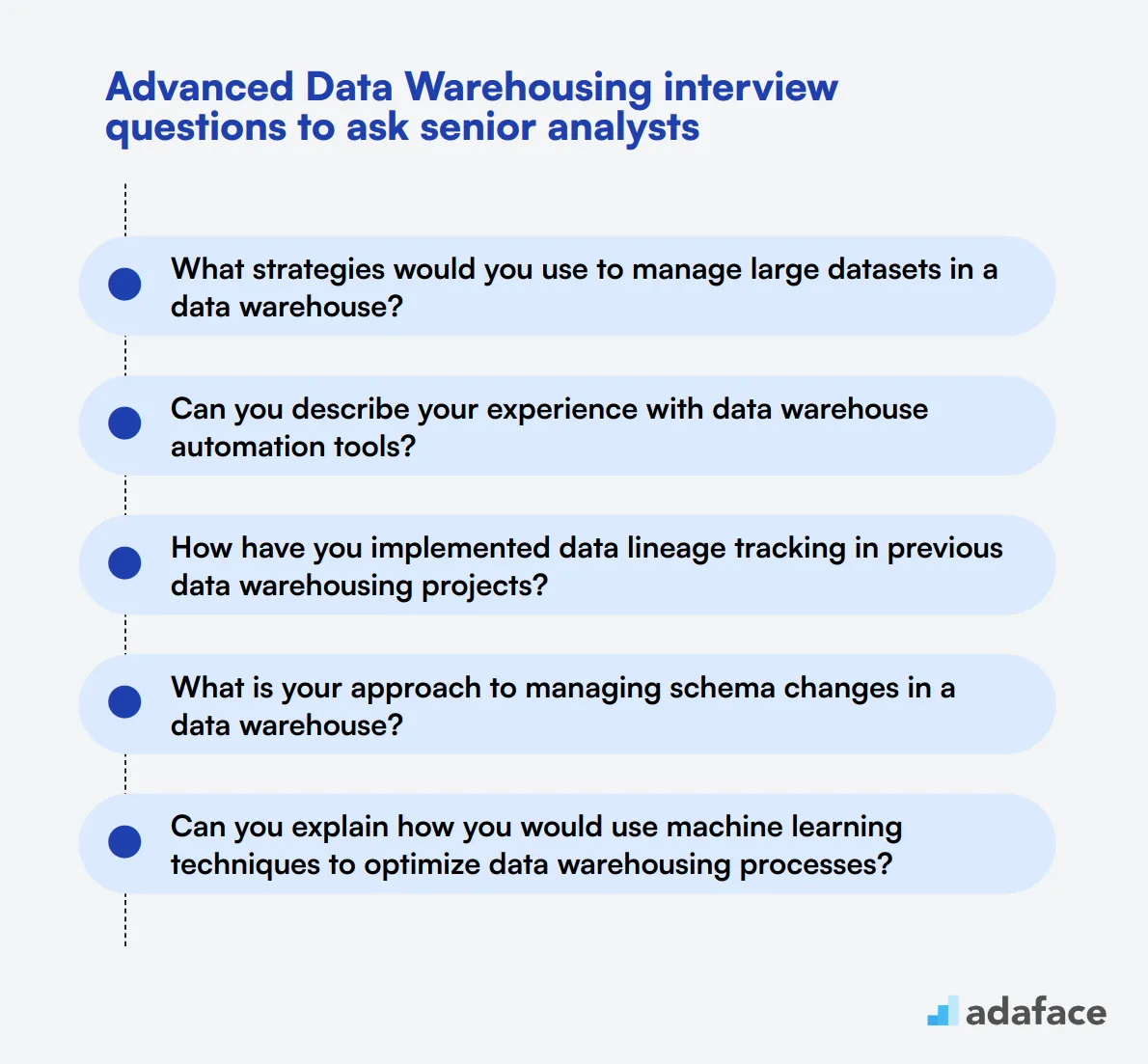

15 preguntas avanzadas de entrevista sobre almacenamiento de datos para hacer a analistas senior

Para asegurarse de identificar a los candidatos más calificados para puestos de analista senior, utilice esta lista de preguntas avanzadas de entrevista sobre almacenamiento de datos. Las preguntas están diseñadas para examinar la comprensión profunda y la experiencia práctica de un candidato en el almacenamiento de datos. Para obtener más información sobre roles específicos, también puede encontrar útil la descripción del puesto de trabajo de arquitecto de datos.

- ¿Qué estrategias usaría para gestionar grandes conjuntos de datos en un data warehouse? 2. ¿Puede describir su experiencia con herramientas de automatización de data warehouse? 3. ¿Cómo ha implementado el seguimiento del linaje de datos en proyectos de data warehousing anteriores? 4. ¿Cuál es su enfoque para gestionar los cambios de esquema en un data warehouse? 5. ¿Puede explicar cómo usaría técnicas de aprendizaje automático para optimizar los procesos de data warehousing? 6. Describa una situación en la que tuvo que conciliar discrepancias de datos en un data warehouse. ¿Cómo la abordó? 7. ¿Cómo garantiza el cumplimiento de las políticas de gobernanza de datos en un data warehouse? 8. ¿Puede hablar sobre su experiencia con soluciones de data warehouse basadas en la nube? 9. ¿Qué métodos utiliza para el análisis en tiempo real en un entorno de data warehouse? 10. Describa cómo optimizaría el almacenamiento y la recuperación de datos semiestructurados en un data warehouse. 11. ¿Puede explicar el papel del data warehousing en el soporte del análisis predictivo? 12. ¿Cómo gestiona y monitorea el rendimiento del data warehouse a lo largo del tiempo? 13. Describa su experiencia con proyectos de migración de data warehouse. 14. ¿Cuáles son sus mejores prácticas para diseñar data warehouses escalables? 15. ¿Cómo maneja la documentación del data warehouse y la transferencia de conocimiento dentro de un equipo?

8 preguntas y respuestas de entrevistas sobre almacenamiento de datos relacionadas con el modelado de datos

En el mundo del almacenamiento de datos, el modelado de datos es una habilidad crítica que asegura que sus datos se estructuran de manera eficiente para un acceso y análisis óptimos. Use estas preguntas para evaluar la comprensión de un candidato sobre los conceptos de modelado de datos y su capacidad para aplicarlos en escenarios prácticos.

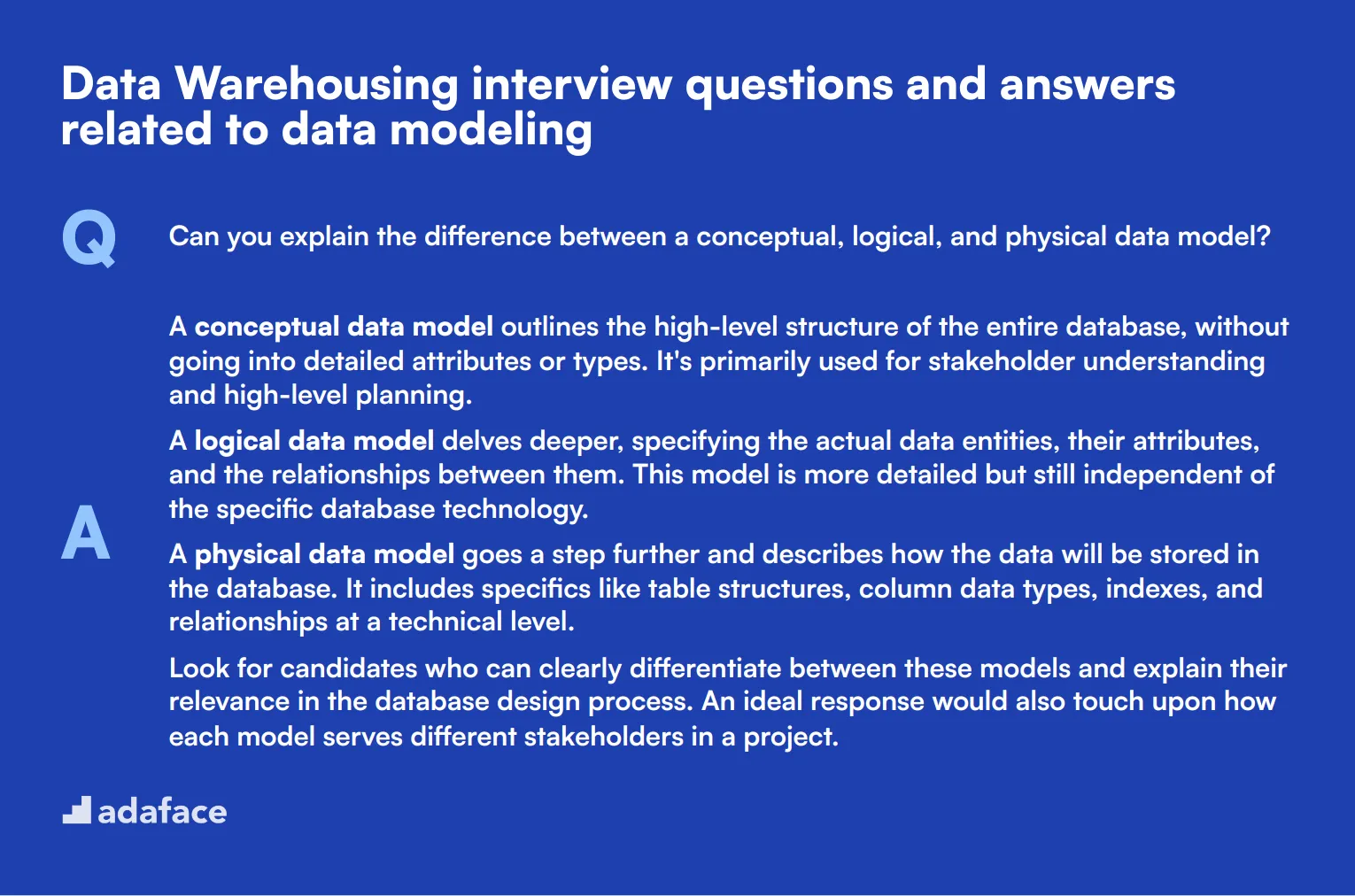

1. ¿Puede explicar la diferencia entre un modelo de datos conceptual, lógico y físico?

Un modelo de datos conceptual describe la estructura de alto nivel de toda la base de datos, sin entrar en detalles de atributos o tipos. Se utiliza principalmente para la comprensión de las partes interesadas y la planificación de alto nivel.

Un modelo de datos lógico profundiza, especificando las entidades de datos reales, sus atributos y las relaciones entre ellas. Este modelo es más detallado, pero aún independiente de la tecnología específica de la base de datos.

Un modelo de datos físico va un paso más allá y describe cómo se almacenarán los datos en la base de datos. Incluye detalles como las estructuras de las tablas, los tipos de datos de las columnas, los índices y las relaciones a nivel técnico.

Busque candidatos que puedan diferenciar claramente entre estos modelos y explicar su relevancia en el proceso de diseño de la base de datos. Una respuesta ideal también abordaría cómo cada modelo sirve a diferentes partes interesadas en un proyecto.

2. ¿Qué es un esquema de copo de nieve y en qué se diferencia de un esquema de estrella?

Un esquema de copo de nieve es una extensión del esquema de estrella donde las tablas de dimensiones se normalizan en múltiples tablas relacionadas. Esto reduce la redundancia y puede hacer que la base de datos sea más organizada, pero también puede hacer que las consultas sean más complejas.

En contraste, un esquema de estrella consiste en una tabla de hechos central rodeada de tablas de dimensiones desnormalizadas, lo que lo hace más simple y rápido para las consultas. Sin embargo, puede conducir a la redundancia de datos.

Los candidatos deben ser capaces de discutir los pros y los contras de cada tipo de esquema y proporcionar ejemplos de cuándo cada uno sería apropiado. Una respuesta ideal también abordaría los impactos en el rendimiento y las consideraciones de mantenimiento.

3. ¿Cómo aborda el diseño de un modelo de datos para un nuevo data warehouse?

El diseño de un modelo de datos comienza con la comprensión de los requisitos del negocio. Esto implica identificar entidades clave, sus atributos y cómo se relacionan entre sí según los procesos del negocio.

A continuación, los candidatos deben redactar un modelo conceptual para delinear la estructura de alto nivel, seguido de un modelo lógico para detallar las entidades y las relaciones. El paso final es la creación de un modelo físico para especificar el esquema real de la base de datos.

Busque candidatos que enfaticen la importancia de la retroalimentación iterativa y la validación con las partes interesadas durante todo el proceso de diseño. Una respuesta ideal también mencionaría el uso de herramientas y técnicas para garantizar la integridad de los datos y la optimización del rendimiento.

4. ¿Puede explicar el papel de la normalización en el modelado de datos?

La normalización es el proceso de organizar datos para reducir la redundancia y mejorar la integridad de los datos. Implica dividir tablas grandes en tablas más pequeñas y relacionadas y definir relaciones entre ellas.

El objetivo principal es asegurar que cada dato se almacene solo una vez, lo que reduce el riesgo de anomalías e inconsistencias. La normalización generalmente sigue una serie de reglas llamadas formas normales, cada una abordando tipos específicos de redundancia. Los candidatos deben ser capaces de explicar las compensaciones entre la normalización y la desnormalización, particularmente en el contexto del rendimiento y la eficiencia de las consultas en un data warehouse. Una respuesta ideal demostraría una comprensión de cuándo aplicar cada técnica. ### 5. ¿Cuál es el papel de un modelador de datos en un proyecto de almacenamiento de datos? Un modelador de datos es responsable de definir la estructura del data warehouse, asegurando que cumpla con los requisitos del negocio y soporte la recuperación eficiente de datos. Esto implica la creación de modelos de datos conceptuales, lógicos y físicos. Trabajan en estrecha colaboración con las partes interesadas para comprender las necesidades de datos, garantizar la integridad de los datos y optimizar la base de datos para el rendimiento. Su función también incluye el mantenimiento de la documentación y la evolución del modelo de datos a medida que cambian los requisitos del negocio.

Busque candidatos que puedan articular la importancia de la colaboración con otros miembros del equipo, como arquitectos de datos y analistas de negocios. Una respuesta ideal destacaría herramientas y técnicas específicas que hayan utilizado en proyectos anteriores.

6. ¿Cómo maneja la redundancia de datos en un modelo de datos?

La redundancia de datos se puede minimizar mediante la normalización, que implica organizar los datos en múltiples tablas relacionadas y reducir los duplicados. Sin embargo, en un data warehouse, cierto nivel de redundancia puede ser aceptable por razones de rendimiento.

Otro enfoque es utilizar técnicas de deduplicación de datos y asegurar que se sigan los principios de gestión de datos maestros para mantener una única fuente de verdad.

Los candidatos deben demostrar una comprensión del equilibrio entre rendimiento y eficiencia de almacenamiento. Una respuesta ideal incluiría ejemplos de cómo han gestionado la redundancia en proyectos anteriores y cualquier herramienta o método que emplearon.

7. ¿Cuáles son algunos errores comunes en el modelado de datos y cómo los evita?

Los errores comunes incluyen la sobre-normalización, que puede llevar a consultas complejas y una reducción del rendimiento; la sub-normalización, que resulta en redundancia de datos; y no involucrar a las partes interesadas en el proceso de diseño, lo que lleva a modelos que no satisfacen las necesidades del negocio.

Para evitar estos errores, es crucial mantener un equilibrio entre la normalización y el rendimiento, involucrar a las partes interesadas de forma temprana y con frecuencia, y validar continuamente el modelo en función de los requisitos del negocio.

Busque candidatos que puedan proporcionar ejemplos específicos de cómo han afrontado estos desafíos en el pasado. Una respuesta ideal también mencionaría cualquier práctica recomendada o marcos de trabajo que sigan para garantizar modelos de datos robustos.

8. ¿Cómo asegura la escalabilidad de un modelo de datos en un data warehouse?

La escalabilidad se puede asegurar diseñando el modelo de datos para manejar el aumento de los volúmenes de datos y las consultas de los usuarios sin una degradación significativa del rendimiento. Esto incluye el uso de indexación eficiente, partición de tablas grandes y optimización del rendimiento de las consultas.

También es importante considerar el crecimiento futuro de los datos y los cambios comerciales durante la fase de diseño inicial. Actualizar regularmente el modelo y la arquitectura para adaptarse a los nuevos requisitos es crucial.

Los candidatos deben demostrar una comprensión tanto de los aspectos técnicos como de los comerciales de la escalabilidad. Una respuesta ideal incluiría ejemplos de cómo han diseñado modelos escalables en el pasado, junto con cualquier técnica o herramienta específica que utilizaron.

7 preguntas y respuestas de entrevistas sobre almacenamiento de datos relacionadas con los procesos ETL

Para determinar si sus candidatos tienen un conocimiento sólido de los procesos ETL, hágales algunas de estas preguntas de entrevista. Estas consultas le ayudarán a evaluar su comprensión de la extracción, transformación y carga de datos, habilidades cruciales para cualquier función de almacenamiento de datos.

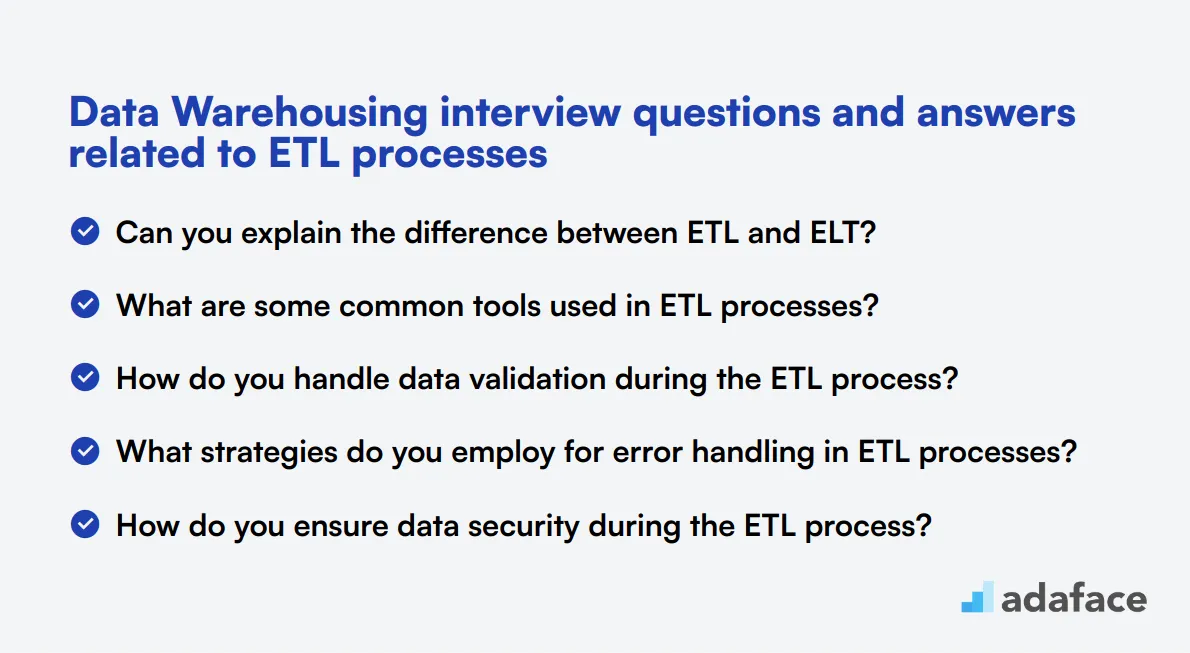

1. ¿Puede explicar la diferencia entre ETL y ELT?

ETL significa Extraer, Transformar, Cargar, e implica extraer datos de diversas fuentes, transformarlos a un formato o estructura adecuada y luego cargarlos en un almacén de datos. ELT, por otro lado, significa Extraer, Cargar, Transformar, donde los datos se extraen y cargan primero en el almacén de datos antes de que tenga lugar cualquier transformación.

En ETL, la transformación ocurre fuera del almacén de datos, mientras que en ELT, ocurre dentro del almacén de datos. Esto a menudo hace que ELT sea más adecuado para grandes volúmenes de datos, aprovechando el poder de las capacidades de procesamiento del almacén de datos.

Busque candidatos que comprendan los matices y puedan articular escenarios donde un enfoque podría ser más beneficioso que el otro.

2. ¿Cuáles son algunas herramientas comunes utilizadas en los procesos ETL?

Las herramientas ETL comunes incluyen Informatica PowerCenter, Talend, Apache Nifi, Microsoft SQL Server Integration Services (SSIS) e IBM InfoSphere DataStage. Estas herramientas ayudan a automatizar los procesos ETL, haciendo que la integración de datos sea más eficiente y confiable.

Los candidatos también deben mencionar opciones de código abierto como Apache Camel o opciones más especializadas como Matillion para procesos ETL basados en la nube. La elección de la herramienta a menudo depende de los requisitos específicos del proyecto, como el volumen de datos, la complejidad y la pila tecnológica existente.

Los candidatos fuertes no solo enumerarán herramientas, sino que también proporcionarán información sobre sus fortalezas y debilidades, lo que le ayudará a identificar su experiencia práctica con estas tecnologías.

3. ¿Cómo gestiona la validación de datos durante el proceso ETL?

La validación de datos en ETL implica garantizar que los datos que se extraen, transforman y cargan cumplan con los estándares de calidad. Esto se puede hacer a través de una variedad de comprobaciones, como verificar los formatos de datos, verificar si faltan valores y asegurar la consistencia de los datos entre las fuentes.

A menudo se utilizan herramientas y scripts automatizados de validación de datos para agilizar este proceso. Por ejemplo, el uso de sumas de comprobación o funciones hash puede ayudar a verificar la integridad de los datos durante la transferencia. Además, la implementación de reglas de validación dentro de la herramienta ETL puede detectar errores al principio del proceso.

Busque candidatos que mencionen técnicas y herramientas específicas que hayan utilizado para la validación de datos, así como su enfoque para manejar errores cuando se detectan.

4. ¿Qué estrategias emplea para la gestión de errores en los procesos ETL?

Las estrategias efectivas de gestión de errores en ETL implican el registro de errores, la identificación de la causa raíz y la implementación de acciones correctivas. Esto puede incluir mecanismos de reintento, procedimientos de respaldo y registro detallado de errores para capturar el contexto del error.

Algunas herramientas ETL tienen capacidades integradas de manejo de errores, como las transformaciones de manejo de errores de Informatica o las configuraciones de salida de errores de SSIS. Estas se pueden usar para redirigir datos erróneos a tablas o archivos de errores para una mayor investigación.

Los candidatos deben demostrar un enfoque sistemático para el manejo de errores y proporcionar ejemplos de cómo han resuelto problemas específicos en proyectos anteriores.

5. ¿Cómo garantiza la seguridad de los datos durante el proceso ETL?

Garantizar la seguridad de los datos durante ETL implica cifrar los datos durante la transferencia, implementar controles de acceso y seguir las mejores prácticas para el manejo de datos. Esto incluye el uso de protocolos seguros como HTTPS o SFTP para la transferencia de datos y el cifrado de campos de datos confidenciales.

Los controles de acceso deben aplicarse en múltiples niveles, incluyendo la herramienta ETL, los sistemas de origen y el almacén de datos. El control de acceso basado en roles (RBAC) puede ayudar a garantizar que solo los usuarios autorizados puedan acceder o modificar los datos.

Los candidatos deben mencionar medidas específicas que han tomado para proteger los datos y cualquier estándar de cumplimiento que hayan seguido, como GDPR o HIPAA.

6. ¿Cuál es su enfoque para optimizar el rendimiento de ETL?

Optimizar el rendimiento de ETL implica diversas técnicas, incluyendo métodos eficientes de extracción de datos, procesamiento paralelo y carga incremental. Reducir la cantidad de datos procesados, filtrando registros innecesarios desde el principio, también puede mejorar significativamente el rendimiento.

El uso de optimizaciones específicas de la base de datos, como la indexación y la partición, puede mejorar el rendimiento de las fases de transformación y carga. Además, aprovechar el procesamiento en memoria y los marcos de computación distribuida como Apache Spark puede impulsar aún más el rendimiento.

Busque candidatos que puedan discutir optimizaciones específicas que hayan implementado y el impacto que estas tuvieron en el rendimiento de ETL.

7. ¿Cómo gestiona la programación y el monitoreo del proceso ETL?

La programación y el monitoreo de los procesos ETL típicamente implican el uso de las funciones de programación integradas en las herramientas ETL o programadores externos como Apache Airflow o trabajos Cron. El monitoreo efectivo incluye la configuración de alertas para fallos de trabajos y problemas de rendimiento.

Las herramientas ETL a menudo proporcionan paneles e registros para rastrear el estado de los trabajos ETL. La implementación de notificaciones automatizadas y mecanismos de reintento puede ayudar a abordar rápidamente cualquier problema que surja.

Los candidatos deben demostrar familiaridad con las herramientas de programación y las técnicas para monitorear los procesos ETL, junto con ejemplos de cómo han mantenido las tuberías ETL en roles anteriores.

8 preguntas situacionales de entrevista sobre Almacenamiento de Datos con respuestas para la contratación de los mejores analistas

Para determinar si sus candidatos tienen la conciencia situacional y las habilidades para resolver problemas necesarias para un almacenamiento de datos eficaz, puede hacerles estas 8 preguntas de entrevista específicas. Estas preguntas le ayudarán a evaluar cómo los candidatos manejan escenarios y desafíos del mundo real que pueden surgir en su organización.

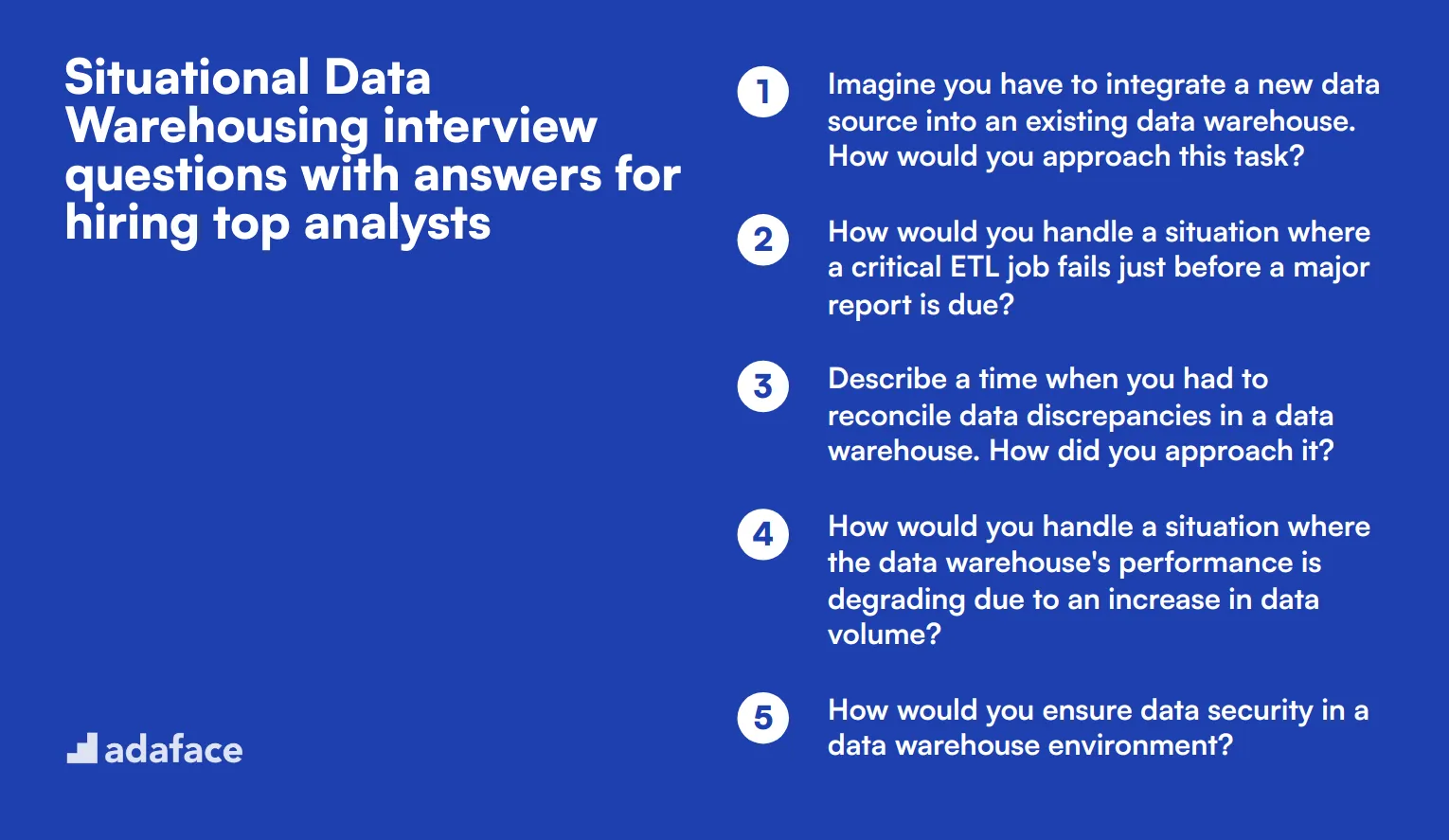

1. Imagine que tiene que integrar una nueva fuente de datos en un data warehouse existente. ¿Cómo abordaría esta tarea?

Primero, realizaría un análisis exhaustivo de la nueva fuente de datos para comprender su estructura, calidad y relevancia para el data warehouse existente. Esto implica identificar los elementos de datos clave y cualquier discrepancia o conflicto potencial con el modelo de datos actual.

A continuación, establecería un plan de integración de datos que incluya la asignación de datos, las reglas de transformación y un proceso ETL claro. Este plan también tendría en cuenta la validación y las pruebas de datos para garantizar que los nuevos datos se integren sin problemas sin comprometer la calidad o integridad de los datos existentes.

Busque candidatos que enfaticen la importancia del análisis exhaustivo, la planificación meticulosa y las pruebas rigurosas en su enfoque. Haga un seguimiento preguntando sobre herramientas o métodos específicos que utilizarían para gestionar la integración de datos.

2. ¿Cómo manejaría una situación en la que un trabajo ETL crítico falla justo antes de que venza un informe importante?

En tal escenario, mi primer paso sería diagnosticar rápidamente la causa raíz del fallo, ya sea debido a un problema de datos, un error del sistema o un cuello de botella de rendimiento. Revisaría los registros y los mensajes de error para identificar el problema exacto.

Una vez que se identifica el problema, lo solucionaría inmediatamente si se trata de un problema menor o implementaría una solución temporal para garantizar que los datos necesarios para el informe estén disponibles. Si es necesario, me comunicaría con las partes interesadas para gestionar las expectativas y proporcionar un calendario revisado para la entrega del informe.

Un candidato ideal demostrará un sentido de urgencia, habilidades efectivas para la resolución de problemas y capacidad de comunicación clara. También debería resaltar su experiencia con el uso de herramientas de monitoreo y alerta para minimizar el impacto de tales fallos.

3. Describe una vez que tuviste que conciliar discrepancias de datos en un data warehouse. ¿Cómo lo abordaste?

Cuando me enfrento a discrepancias de datos, mi primer paso es identificar la fuente y la naturaleza de las discrepancias. Esto implica comparar datos en diferentes sistemas o fuentes de datos para comprender dónde y por qué se producen las inconsistencias.

A continuación, implementaría un proceso de conciliación que incluya la validación, corrección y documentación de datos. Esto podría implicar escribir scripts para automatizar el proceso de comparación y corrección o actualizar manualmente los datos basándose en fuentes verificadas.

Los reclutadores deben buscar candidatos que enfaticen un enfoque sistemático y exhaustivo de la conciliación de datos. Realice un seguimiento preguntando sobre herramientas o técnicas específicas que hayan utilizado para optimizar el proceso.

4. ¿Cómo manejaría una situación en la que el rendimiento del almacén de datos se degrada debido a un aumento en el volumen de datos?

Para abordar la degradación del rendimiento, comenzaría por analizar la carga de trabajo actual e identificar los cuellos de botella. Esto podría implicar revisar el rendimiento de las consultas, las estrategias de indexación y la utilización del hardware.

Basándome en el análisis, implementaría técnicas de optimización del rendimiento, como la partición de tablas grandes, la optimización de consultas y la adición o actualización de índices. Además, podría considerar la ampliación de los recursos de hardware o la exploración de soluciones basadas en la nube para gestionar el aumento del volumen de datos de forma más eficiente.

Los candidatos deben demostrar un enfoque proactivo de la gestión del rendimiento y una sólida comprensión de diversas técnicas de optimización. Busque ejemplos específicos de cómo han mejorado con éxito el rendimiento del almacén de datos en el pasado.

5. ¿Cómo garantizaría la seguridad de los datos en un entorno de almacén de datos?

Garantizar la seguridad de los datos comienza con la implementación de controles de acceso robustos para restringir el acceso a los datos solo a los usuarios autorizados. Esto implica la configuración de roles de usuario, permisos y la revisión periódica de los registros de acceso.

Además, me aseguraría de que los datos estén encriptados tanto en reposo como en tránsito. Esto incluye el uso de protocolos de encriptación y métodos seguros de transferencia de datos. Las auditorías de seguridad regulares y las evaluaciones de vulnerabilidades también son fundamentales para identificar y mitigar los riesgos de seguridad potenciales.

Un candidato ideal destacará su experiencia con diversas medidas de seguridad de datos y enfatizará la importancia del monitoreo y la auditoría continuos. Posteriormente, preguntará sobre herramientas y protocolos de seguridad específicos que hayan utilizado.

6. ¿Puede describir un proyecto de migración de datos desafiante en el que trabajó y cómo lo gestionó?

En un proyecto de migración de datos desafiante, mi primer paso fue desarrollar un plan de migración integral que incluyera el mapeo de datos, scripts de migración y un cronograma detallado. Este plan también contemplaba la validación y las pruebas de datos para garantizar la precisión y la integridad.

A lo largo del proyecto, mantuve una comunicación clara con todas las partes interesadas para gestionar las expectativas y proporcionar actualizaciones periódicas sobre el progreso. También establecí un plan de reversión para abordar cualquier problema que pudiera surgir durante el proceso de migración.

Busque candidatos que demuestren sólidas habilidades de gestión de proyectos, atención al detalle y comunicación efectiva. Realice un seguimiento preguntando sobre los desafíos específicos que enfrentaron y cómo los superaron.

7. ¿Cómo prioriza las tareas al gestionar múltiples proyectos de almacenamiento de datos simultáneamente?

Al gestionar múltiples proyectos, priorizo las tareas en función de su impacto, urgencia y dependencias. Comienzo creando un plan de proyecto detallado para cada proyecto, delineando los hitos clave, los entregables y los plazos.

Utilizo herramientas de gestión de proyectos para realizar un seguimiento del progreso y garantizar que todas las tareas estén alineadas con los objetivos generales del proyecto. Las revisiones periódicas con el equipo y las partes interesadas me ayudan a estar al tanto de cualquier problema potencial y a realizar los ajustes necesarios para mantener todo en marcha.

Los candidatos deben demostrar sólidas habilidades organizativas y de gestión del tiempo. Realice un seguimiento preguntando sobre herramientas o métodos específicos que utilizan para gestionar múltiples proyectos de manera efectiva.

8. ¿Cómo manejaría una situación en la que los requisitos comerciales de un proyecto de almacenamiento de datos cambian a mitad de la implementación?

En tal situación, mi primer paso sería comprender a fondo los nuevos requisitos y evaluar su impacto en el plan del proyecto existente. Esto implica interactuar con las partes interesadas para aclarar los cambios y sus implicaciones.

A continuación, actualizaría el plan del proyecto para incorporar los nuevos requisitos, incluida la revisión de los plazos, los recursos y los entregables. La comunicación clara con el equipo y las partes interesadas es crucial para garantizar que todos estén alineados y conscientes de los cambios.

Busque candidatos que enfaticen la flexibilidad, las sólidas habilidades de comunicación y la capacidad de gestionar el cambio de manera efectiva. Haga un seguimiento preguntando sobre instancias específicas en las que gestionaron con éxito los requisitos cambiantes.

¿Qué habilidades de almacenamiento de datos debe evaluar durante la fase de entrevista?

Si bien es imposible evaluar todos los aspectos de la experiencia en almacenamiento de datos de un candidato en una sola entrevista, es crucial centrarse en las habilidades básicas. Estas áreas clave le ayudarán a evaluar la competencia de un candidato y su potencial adaptación a su equipo de almacenamiento de datos.

SQL

SQL es la columna vertebral del almacenamiento de datos. Es esencial para consultar, manipular y gestionar grandes conjuntos de datos dentro de un entorno de almacenamiento de datos.

Para evaluar las habilidades en SQL, considere usar una prueba online de SQL que incluye preguntas de opción múltiple (MCQ) relevantes. Esto puede ayudar a filtrar a los candidatos en función de su competencia en SQL.

Durante la entrevista, haga preguntas específicas para evaluar la experiencia en SQL del candidato. Aquí hay un ejemplo:

¿Puede explicar la diferencia entre un LEFT JOIN y un INNER JOIN y proporcionar un escenario en el que usaría cada uno?

Busque una explicación clara de cómo funcionan estas uniones y ejemplos prácticos de su aplicación en escenarios de almacenamiento de datos. Esto revelará la comprensión del candidato sobre los fundamentos de SQL y su capacidad para aplicarlos en situaciones del mundo real.

Modelado de datos

El modelado de datos es crucial para diseñar estructuras de almacén de datos eficientes y escalables. Implica la creación de representaciones lógicas y físicas de datos para respaldar los requisitos comerciales.

Para evaluar las habilidades de modelado de datos, puede usar una prueba de modelado de datos que cubre conceptos clave y las mejores prácticas.

Durante la entrevista, haga una pregunta que evalúe la comprensión del candidato sobre los principios de modelado de datos:

Describa las diferencias entre el esquema estrella y el esquema de copo de nieve en el diseño de un almacén de datos. ¿Cuándo elegiría uno sobre el otro?

Busque una explicación exhaustiva de ambos esquemas, incluida su estructura, ventajas y desventajas. El candidato debe demostrar una comprensión de cuándo es más apropiado cada esquema según las necesidades específicas del negocio y la complejidad de los datos.

Procesos ETL

Los procesos ETL (Extracción, Transformación, Carga) son fundamentales para el almacenamiento de datos. Implican mover datos de diversas fuentes al almacén, garantizando la calidad y consistencia de los datos.

Para evaluar las habilidades de ETL, considere usar una prueba en línea de ETL que cubra varios aspectos del proceso ETL.

Durante la entrevista, haga una pregunta que evalúe la experiencia práctica del candidato con ETL:

Describa un problema ETL desafiante que haya encontrado y cómo lo resolvió. ¿Qué herramientas o técnicas utilizó?

Busque una explicación detallada del problema, el enfoque adoptado para resolverlo y las herramientas o técnicas específicas utilizadas. Esto revelará las habilidades de resolución de problemas del candidato y su experiencia práctica con los procesos ETL en escenarios del mundo real.

Consejos para Entrevistas Efectivas sobre Almacenamiento de Datos

Antes de comenzar a aplicar lo que has aprendido, aquí hay algunos consejos para que tus entrevistas sobre Almacenamiento de Datos sean más efectivas y reveladoras.

1. Incorpora Pruebas de Habilidades en tu Proceso de Selección

Las pruebas de habilidades pueden proporcionar datos objetivos sobre las capacidades de un candidato antes de la etapa de la entrevista. Ayudan a filtrar a los candidatos no calificados y te permiten concentrarte en los más prometedores.

Para los roles de Almacenamiento de Datos, considera usar pruebas que evalúen las habilidades de SQL, el conocimiento de modelado de datos y la comprensión de los procesos ETL. También podrías querer evaluar su familiaridad con herramientas específicas como Teradata o Informatica.

Al usar estas pruebas, puedes crear una lista corta de candidatos que hayan demostrado las habilidades técnicas requeridas para el puesto. Este enfoque ahorra tiempo y garantiza que tus entrevistas se dediquen a discutir temas más complejos y a evaluar la adecuación cultural.

2. Prepara un Conjunto Equilibrado de Preguntas para la Entrevista

El tiempo es limitado durante las entrevistas, por lo que es crucial elegir preguntas que cubran aspectos clave del Almacenamiento de Datos. Apunta a una mezcla de preguntas técnicas, de resolución de problemas y basadas en la experiencia.

Incluya preguntas sobre modelado de datos, procesos ETL y optimización de bases de datos. Además, considere agregar preguntas sobre inteligencia empresarial para evaluar su comprensión de cómo los almacenes de datos respaldan la toma de decisiones.

No olvide evaluar habilidades blandas como la comunicación y el trabajo en equipo, que son importantes para colaborar con las partes interesadas y otros miembros del equipo.

3. Domine el arte de las preguntas de seguimiento

Las preguntas preparadas son un buen comienzo, pero las preguntas de seguimiento pueden revelar la verdadera profundidad de conocimiento y experiencia de un candidato. Le ayudan a distinguir entre los candidatos que han memorizado respuestas y los que realmente entienden los conceptos.

Por ejemplo, después de preguntar sobre las técnicas de modelado de datos, podría hacer un seguimiento con una pregunta sobre cómo han manejado un desafío específico en un proyecto anterior. Este enfoque le permite evaluar sus habilidades de resolución de problemas y la aplicación del conocimiento en el mundo real.

Utilice preguntas de entrevista sobre almacenamiento de datos y pruebas de habilidades para contratar analistas talentosos

Si está buscando contratar a alguien con habilidades de almacenamiento de datos, debe asegurarse de que posea la experiencia necesaria. La mejor manera de hacerlo es utilizando pruebas de habilidades como nuestro Prueba en línea de almacén de datos o Prueba de modelado de datos.

Al utilizar estas pruebas, puede preseleccionar a los solicitantes más calificados e invitarlos a entrevistas. Para comenzar, puede registrarse o explorar nuestra plataforma de evaluación en línea para obtener más detalles.

Examen en línea de Data Warehouse

40 minutos | 18 preguntas de opción múltiple (MCQ)

El examen en línea de Data Warehouse utiliza preguntas de opción múltiple basadas en escenarios para evaluar a los candidatos en su experiencia en el almacenamiento de datos, lo que implica diseñar, construir y mantener almacenes, bases de datos y data marts.

Intenta el Examen en línea de Data Warehouse

Descarga la plantilla de preguntas para la entrevista de almacenamiento de datos en múltiples formatos

Las habilidades clave incluyen dominio de SQL, experiencia con procesos ETL, modelado de datos y familiaridad con herramientas de almacenamiento de datos.

Haga preguntas sobre sus proyectos anteriores de modelado de datos, las herramientas que utilizaron y su enfoque para resolver desafíos de datos complejos.

Las herramientas ETL comunes incluyen Informatica, Talend, Microsoft SSIS y Apache Nifi.

Las preguntas situacionales revelan las habilidades de resolución de problemas de un candidato, su enfoque de escenarios del mundo real y cómo manejan la presión.

La combinación de preguntas técnicas y situacionales proporciona una visión holística de las habilidades, la experiencia y el conocimiento teórico de un candidato.

Concéntrese en habilidades técnicas avanzadas, capacidades de liderazgo, experiencia en gestión de proyectos y su capacidad para asesorar a los miembros junior del equipo.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento