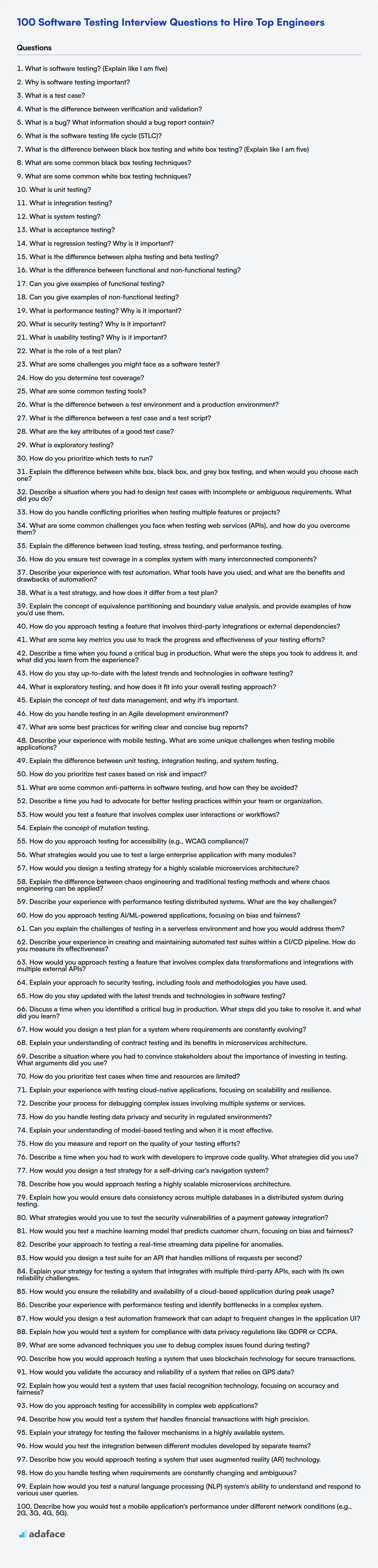

100 Preguntas de la Entrevista sobre Pruebas de Software para Contratar a los Mejores Ingenieros

Entrevistar a los evaluadores de software puede ser un desafío; encontrar candidatos que realmente entiendan los principios y prácticas de las pruebas requiere un plan sólido. Una lista bien preparada de preguntas de entrevista garantiza que pueda evaluar a fondo los conocimientos y habilidades de un candidato, como se discute en nuestra publicación sobre las habilidades requeridas para un evaluador de software.

Esta publicación de blog proporciona una lista seleccionada de preguntas de entrevista sobre pruebas de software, que cubren niveles básicos a expertos, junto con preguntas de opción múltiple, para ayudarlo a evaluar a los candidatos de manera efectiva. Hemos dividido las preguntas en cuatro categorías: básico, intermedio, avanzado y experto.

Al usar estas preguntas, obtendrá información sobre la destreza de las pruebas de los candidatos e identificará a los mejores talentos, pero antes de la entrevista, también puede usar la prueba de ingeniero de control de calidad de Adaface para examinar a los candidatos rápidamente.

Índice

Preguntas de entrevista básicas sobre pruebas de software

Preguntas de entrevista intermedias sobre pruebas de software

Preguntas de entrevista avanzadas sobre pruebas de software

Preguntas de entrevista para expertos en pruebas de software

Cuestionario de pruebas de software

¿Qué habilidades de pruebas de software debe evaluar durante la fase de entrevista?

Contrate a evaluadores de software capacitados con las evaluaciones correctas

Descargue la plantilla de preguntas de entrevista sobre pruebas de software en múltiples formatos

1. ¿Qué son las pruebas de software? (Explique como si tuviera cinco años)

¡Imagina que estás construyendo un juguete realmente genial! Las pruebas de software son como jugar con el juguete antes de dárselo a tus amigos para asegurarte de que funcione. Lo pinchamos, lo empujamos y tratamos de romperlo de diferentes maneras. Si se rompe, se lo decimos al constructor del juguete para que pueda arreglarlo antes de que alguien se ponga triste o frustrado jugando con él. ¡De esa manera, todos se divierten mucho con el juguete!

Las pruebas son realmente importantes. Significa que estamos comprobando si el programa de la computadora hace lo que queremos que haga. Al igual que comprobar si tus zapatos te quedan bien antes de correr una carrera, nos aseguramos de que todo esté bien antes de que sea hora de usar el programa. Podemos comprobar si las cosas funcionan de la manera correcta, no se rompen cuando hacemos algo inesperado y son seguras de usar.

2. ¿Por qué son importantes las pruebas de software?

Las pruebas de software son cruciales porque ayudan a garantizar la calidad, fiabilidad y rendimiento de las aplicaciones de software. Identifican errores, fallos y defectos antes de que el software se lance a los usuarios finales, lo que previene posibles fallos, pérdida de datos y vulnerabilidades de seguridad. La detección y resolución temprana de problemas ahorra tiempo y recursos, minimizando los costos de desarrollo y mejorando la satisfacción del usuario.

En última instancia, las pruebas de software efectivas contribuyen a generar confianza en el software y en la organización que lo respalda. Sin pruebas exhaustivas, el riesgo de lanzar software defectuoso aumenta significativamente, lo que puede llevar a consecuencias negativas como pérdidas financieras, daños a la reputación e incluso responsabilidades legales.

3. ¿Qué es un caso de prueba?

Un caso de prueba es un conjunto específico de condiciones y entradas bajo las cuales un evaluador determinará si una aplicación, un sistema de software o una de sus funciones está funcionando como se espera. Documenta los pasos detallados, los datos de entrada, las precondiciones, los resultados esperados y las poscondiciones para un escenario de prueba específico.

Esencialmente, es una única ejecución para validar un requisito específico. Un caso de prueba bien escrito asegura que las pruebas se realicen metódica y minuciosamente. Los casos de prueba son atómicos, lo que significa que cada caso prueba una cosa específica.

4. ¿Cuál es la diferencia entre verificación y validación?

La verificación es el proceso de comprobar que el software cumple con los requisitos especificados, asegurando "¿Estamos construyendo el producto correctamente?". Se centra en la implementación y confirma si el código, el diseño, la arquitectura, etc., cumplen con las especificaciones iniciales. Las actividades involucradas son revisiones, inspecciones y pruebas. En esencia, su objetivo es detectar defectos al principio del ciclo de desarrollo.

La validación, por otro lado, confirma que el software satisface las necesidades y el uso previsto del usuario, preguntando "¿Estamos construyendo el producto correcto?". Evalúa el software en un entorno del mundo real para asegurar que funcione como se espera y satisfaga al cliente. Las pruebas de aceptación y los comentarios de los usuarios son partes cruciales de la validación. Validar con éxito un producto significa que es adecuado para su propósito y cumple con las expectativas de las partes interesadas.

5. ¿Qué es un error? ¿Qué información debe contener un informe de error?

Un error es un defecto o fallo en una aplicación de software que hace que produzca un resultado incorrecto o inesperado, o que se comporte de maneras no deseadas. Es una desviación del comportamiento esperado o requerido.

Un buen informe de error debe contener la siguiente información:

- Resumen: Una descripción concisa del error.

- Pasos para reproducir: Pasos detallados que activan consistentemente el error.

- Resultado esperado: Lo que debería suceder si el código funcionara correctamente.

- Resultado real: Lo que realmente sucedió.

- Severidad: Qué tan crítico es el error (por ejemplo, crítico, mayor, menor).

- Prioridad: Qué tan rápido se necesita arreglar el error (por ejemplo, alta, media, baja).

- Entorno: Información sobre el sistema donde se encontró el error (por ejemplo, sistema operativo, navegador, hardware).

- Versión: La versión específica del software donde existe el error.

- Archivos adjuntos: Cualquier archivo relevante, como capturas de pantalla, archivos de registro o fragmentos de código. Por ejemplo, un fragmento de código como este:

def add(a, b): return a - b # Bug: Should be a + b

6. ¿Qué es el ciclo de vida de las pruebas de software (STLC)?

El Ciclo de Vida de las Pruebas de Software (STLC) es una serie secuencial de actividades realizadas para llevar a cabo las pruebas de software. Asegura que la aplicación de software cumpla con los estándares de calidad y los requisitos del negocio. Incluye varias fases como: Análisis de Requisitos, Planificación de Pruebas, Desarrollo de Casos de Prueba, Configuración del Entorno, Ejecución de Pruebas y Cierre del Ciclo de Pruebas.

El objetivo principal del STLC es definir un conjunto de pasos que se pueden seguir para garantizar que el proceso de pruebas de software sea efectivo y eficiente. El STLC ayuda a los evaluadores a identificar y corregir defectos al principio del proceso de desarrollo, lo que puede ahorrar tiempo y dinero.

7. ¿Cuál es la diferencia entre las pruebas de caja negra y las pruebas de caja blanca? (Explica como si tuviera cinco años)

Imagina que tienes un coche de juguete. Las pruebas de caja negra son como jugar con el coche sin saber cómo funciona por dentro. Simplemente lo empujas, giras las ruedas y ves si se mueve. No lo abres para mirar el motor ni los engranajes. Las pruebas de caja blanca son como desmontar el coche y mirar todas las piezas. Compruebas si el motor está conectado correctamente, si los engranajes giran bien y si todo está montado como debería.

Entonces, las pruebas de caja negra tratan de probar lo que el juguete hace, y las pruebas de caja blanca tratan de probar cómo el juguete lo hace.

8. ¿Cuáles son algunas técnicas comunes de pruebas de caja negra?

Las técnicas comunes de pruebas de caja negra incluyen:

- Particionamiento de equivalencia: Dividir los datos de entrada en particiones, asumiendo que el sistema se comportará de manera similar para todos los datos dentro de una partición.

- Análisis de valores límite: Probar los valores límite de los dominios de entrada, ya que los errores a menudo ocurren en los bordes de estos dominios.

- Pruebas de tablas de decisión: Crear tablas de decisión para representar una lógica compleja y probar diferentes combinaciones de condiciones y acciones.

- Pruebas de transición de estados: Probar los diferentes estados de un sistema y las transiciones entre esos estados en función de varias entradas o eventos.

- Pruebas de casos de uso: Derivar casos de prueba directamente de los casos de uso para asegurar que el sistema cumpla con su funcionalidad prevista desde la perspectiva del usuario.

- Adivinación de errores: Una técnica donde los evaluadores usan su experiencia e intuición para adivinar dónde podrían ocurrir errores.

9. ¿Cuáles son algunas técnicas comunes de pruebas de caja blanca?

Las técnicas de pruebas de caja blanca examinan la estructura interna y el código de una aplicación de software. Algunas técnicas comunes incluyen:

- Cobertura de sentencias: Asegura que cada sentencia en el código se ejecute al menos una vez.

- Cobertura de ramas: Asegura que cada rama (por ejemplo, sentencias

if/else) se ejecute. - Cobertura de caminos: Asegura que cada camino posible a través del código se ejecute. Esta es la más exhaustiva, pero también la más compleja.

- Cobertura de condiciones: Prueba cada condición lógica en un programa para determinar el resultado de cada una. Por ejemplo, en el fragmento de código

if (x > 0 && y < 10), se probarían tanto las condicionesx > 0comoy < 10para obtener resultados verdaderos y falsos. - Pruebas de flujo de datos: Examina cómo se mueven los datos a través del sistema para identificar problemas como variables no inicializadas.

10. ¿Qué son las pruebas unitarias?

Las pruebas unitarias son un método de prueba de software en el que se prueban unidades o componentes individuales de una aplicación de software de forma aislada. El propósito es validar que cada unidad del código del software funcione como está diseñado. Una unidad puede ser una función, un método, un módulo u un objeto.

Durante las pruebas unitarias, se crean casos de prueba para verificar el comportamiento de la unidad en diferentes condiciones. Estas pruebas suelen ser automatizadas y se ejecutan con frecuencia, a menudo como parte de un proceso de integración continua. Los beneficios incluyen la detección temprana de errores, una depuración más fácil y una mejor calidad del código. Aquí hay un ejemplo de python usando pytest:

def add(x, y): return x + y # test_add.py import pytest from your_module import add def test_add_positive(): assert add(2, 3) == 5

11. ¿Qué son las pruebas de integración?

Las pruebas de integración son un tipo de prueba de software donde unidades o componentes individuales de un sistema se combinan y se prueban como un grupo. El propósito es verificar que las diferentes unidades interactúan correctamente y que los datos se pasan adecuadamente entre ellas. Se centra en probar las interfaces entre los módulos para asegurar que trabajen juntos armoniosamente. Las pruebas de integración ayudan a descubrir problemas como problemas de comunicación de datos, suposiciones incorrectas hechas por los desarrolladores sobre las interacciones de los módulos e incompatibilidades de interfaz. Se pueden realizar de varias maneras, incluyendo enfoques de arriba hacia abajo, de abajo hacia arriba y big-bang.

12. ¿Qué son las pruebas del sistema?

Las pruebas del sistema son un tipo de prueba de software que valida el producto de software completo e integrado. Verifica que todos los componentes funcionen como se espera y que el sistema cumpla con sus requisitos generales. Estas pruebas se realizan típicamente después de las pruebas de integración y antes de las pruebas de aceptación.

Las pruebas del sistema a menudo implican probar la funcionalidad, el rendimiento, la seguridad y la usabilidad del sistema. Los evaluadores pueden utilizar diversas técnicas, incluyendo pruebas de caja negra (donde la estructura interna del sistema no se conoce) y pruebas de caja blanca (donde la estructura interna es conocida), para evaluar exhaustivamente el comportamiento del sistema.

13. ¿Qué es la prueba de aceptación?

La prueba de aceptación es un tipo de prueba de software que se realiza para determinar si un sistema satisface sus criterios de aceptación. Se enfoca en validar la funcionalidad de extremo a extremo del sistema, asegurando que cumpla con los requisitos del negocio y que sea utilizable por los usuarios o partes interesadas previstos. A menudo es la fase final de prueba realizada antes de lanzar el software a producción.

El objetivo es confirmar que el sistema se comporta como se espera en un escenario del mundo real. A diferencia de otros tipos de pruebas, las pruebas de aceptación a menudo son realizadas por usuarios finales o expertos en el dominio en lugar de desarrolladores o evaluadores. Los tipos comunes de pruebas de aceptación incluyen las Pruebas de Aceptación del Usuario (UAT), las Pruebas de Aceptación del Negocio (BAT) y las Pruebas de Aceptación Operacional (OAT).

14. ¿Qué son las pruebas de regresión? ¿Por qué son importantes?

Las pruebas de regresión consisten en volver a ejecutar pruebas funcionales y no funcionales para asegurar que el software previamente desarrollado y probado todavía funcione después de un cambio. Los cambios podrían incluir mejoras, correcciones de errores, cambios de configuración o incluso la migración a un entorno diferente. Esencialmente, verifica que el nuevo código no afecte negativamente a las funciones existentes.

Es crucial porque ayuda a mantener la estabilidad y confiabilidad del software. Sin ella, las correcciones de errores o las nuevas funciones podrían introducir accidentalmente nuevos problemas o reintroducir los antiguos. Esto asegura que la funcionalidad existente permanezca intacta, minimiza los riesgos asociados con los cambios de código y ayuda a entregar un producto de calidad. Al repetir las pruebas, verifica la consistencia del software.

15. ¿Cuál es la diferencia entre las pruebas alfa y las pruebas beta?

Las pruebas alfa y beta son dos tipos de pruebas de software que se realizan antes de que un producto se lance al público en general, pero difieren en varios aspectos clave. Las pruebas alfa suelen ser realizadas internamente por el equipo de desarrollo o un grupo selecto de usuarios internos. El objetivo es identificar errores, defectos y problemas de usabilidad al principio del ciclo de desarrollo. El entorno suele estar controlado y la atención se centra en la funcionalidad y el rendimiento.

Las pruebas beta, por otro lado, son realizadas por un grupo más grande de usuarios externos que son representativos del público objetivo. El objetivo es recopilar comentarios sobre la usabilidad, la fiabilidad y la experiencia general del usuario del producto en un entorno del mundo real. Los evaluadores beta proporcionan comentarios sobre cómo funciona el producto en condiciones de uso normales, lo que ayuda a identificar problemas que pueden no haber sido evidentes durante las pruebas internas. Las pruebas beta a menudo ocurren después de las pruebas alfa cuando el software es más estable.

16. ¿Cuál es la diferencia entre las pruebas funcionales y no funcionales?

Las pruebas funcionales verifican que cada función de la aplicación de software opere de acuerdo con la especificación de requisitos. Se centra en lo que hace el sistema, validando las acciones y los resultados. Los ejemplos incluyen pruebas unitarias, de integración, de sistema y de aceptación.

Las pruebas no funcionales, por otro lado, comprueban aspectos como el rendimiento, la seguridad, la usabilidad y la fiabilidad. Evalúa cómo funciona el sistema, centrándose en la experiencia del usuario y las características operativas en lugar de las características específicas. Los ejemplos incluyen pruebas de rendimiento, carga, estrés, seguridad y usabilidad.

17. ¿Puede dar ejemplos de pruebas funcionales?

Las pruebas funcionales verifican que cada función de una aplicación de software opera de acuerdo con la especificación de requisitos. Los ejemplos incluyen probar la funcionalidad de inicio de sesión de un sitio web ingresando credenciales válidas e inválidas y verificando la respuesta del sistema. Otro ejemplo es probar el proceso de pago de un carrito de compras agregando artículos, aplicando descuentos y confirmando que los detalles del pedido y el procesamiento del pago funcionan correctamente.

Específicamente, los ejemplos incluyen:

- Pruebas unitarias: Probar funciones o módulos individuales.

- Pruebas de integración: Probar la interacción entre diferentes módulos.

- Pruebas del sistema: Probar todo el sistema en su conjunto.

- Pruebas de aceptación: Pruebas realizadas por usuarios finales para validar que se cumplen los requisitos.

- Asegurar que una aplicación de calculadora realice correctamente la suma, la resta, la multiplicación y la división.

- Validar que un motor de búsqueda devuelva resultados relevantes para palabras clave dadas.

18. ¿Puede dar ejemplos de pruebas no funcionales?

Las pruebas no funcionales se enfocan en aspectos como el rendimiento, la seguridad, la usabilidad y la confiabilidad en lugar de características específicas. Los ejemplos incluyen:

- Pruebas de rendimiento: Verificar los tiempos de respuesta, el rendimiento y la estabilidad bajo diversas condiciones de carga (por ejemplo, pruebas de estrés, pruebas de carga, pruebas de resistencia).

- Pruebas de seguridad: Identificar vulnerabilidades y garantizar la confidencialidad, integridad y disponibilidad de los datos (por ejemplo, pruebas de penetración, escaneo de vulnerabilidades).

- Pruebas de usabilidad: Evaluar qué tan fácil es de usar y entender el sistema por usuarios reales. Esto podría incluir pruebas A/B o entrevistas con usuarios.

- Pruebas de fiabilidad: Evaluar la capacidad del sistema para funcionar sin fallas durante un período específico (por ejemplo, inyección de fallos, pruebas de recuperación).

- Pruebas de accesibilidad: Verificar que la aplicación sea utilizable por personas con discapacidades, conforme a estándares como WCAG.

- Pruebas de escalabilidad: Determinar la capacidad del sistema para manejar cantidades crecientes de trabajo o datos.

19. ¿Qué son las pruebas de rendimiento? ¿Por qué son importantes?

Las pruebas de rendimiento evalúan la velocidad, la estabilidad y la escalabilidad de una aplicación de software bajo varias cargas de trabajo. Garantiza que el sistema pueda manejar el tráfico de usuarios esperado, el volumen de datos y las tasas de transacción sin retrasos o errores inaceptables.

Es importante porque ayuda a identificar cuellos de botella, prevenir problemas de rendimiento en producción, asegurar una experiencia de usuario positiva y validar que el sistema cumple con los requisitos de rendimiento definidos. Esto puede ahorrar costos asociados con el tiempo de inactividad o la insatisfacción del cliente.

20. ¿Qué son las pruebas de seguridad? ¿Por qué son importantes?

Las pruebas de seguridad son un tipo de prueba de software que descubre vulnerabilidades, amenazas y riesgos en una aplicación de software y previene ataques maliciosos de intrusos. Ayuda a determinar si el sistema protege los datos y mantiene la funcionalidad según lo previsto.

Es importante porque ayuda a:

- Identificar las debilidades antes de que los atacantes puedan explotarlas.

- Proteger datos confidenciales.

- Asegurar el cumplimiento de las regulaciones.

- Mantener la confianza del usuario y evitar daños a la reputación.

- Reducir el riesgo de pérdidas financieras debido a las brechas de seguridad.

21. ¿Qué son las pruebas de usabilidad? ¿Por qué son importantes?

Las pruebas de usabilidad son un método para evaluar un producto o servicio probándolo con usuarios representativos. Durante una prueba, los participantes intentan completar tareas típicas mientras los observadores observan, escuchan y toman notas. El objetivo es identificar cualquier problema de usabilidad, recopilar datos cualitativos y cuantitativos y determinar la satisfacción general del participante con el producto.

Es importante porque ayuda a garantizar que un producto sea fácil de usar, eficiente y satisfactorio para sus usuarios previstos. Esto puede llevar a una mayor adopción por parte del usuario, menores costos de soporte, una mejor satisfacción del cliente y, en última instancia, un producto más exitoso. Identificar los problemas de usabilidad al principio del proceso de desarrollo puede ahorrar tiempo y recursos al evitar rediseños costosos más adelante.

22. ¿Cuál es el papel de un plan de pruebas?

Un plan de pruebas sirve como plano para el proceso de pruebas. Define el alcance, los objetivos, los recursos y el cronograma de las actividades de prueba. Su función principal es describir la estrategia para verificar que un producto de software cumple con sus requisitos y es apto para su propósito.

Específicamente, el plan de pruebas típicamente cubre: Objetivos de la prueba, Alcance de la prueba, Enfoque de prueba, Entorno de prueba, Criterios de entrada y salida, Asignación de recursos y Cronograma. Al documentar estos aspectos, el plan de pruebas ayuda a asegurar un esfuerzo de prueba estructurado, consistente y eficiente, y permite una mejor comunicación y colaboración entre las partes interesadas.

23. ¿Cuáles son algunos desafíos que podrías enfrentar como evaluador de software?

Como evaluador de software, anticipo enfrentar varios desafíos. Un desafío clave es mantenerse actualizado con las tecnologías en constante evolución, las metodologías de prueba y las prácticas de desarrollo. Esto requiere un aprendizaje y adaptación continuos. Otro desafío potencial incluye trabajar con requisitos incompletos o ambiguos, lo que puede dificultar el diseño y la ejecución de casos de prueba. La comunicación y colaboración con desarrolladores, propietarios de productos y otras partes interesadas también puede presentar obstáculos, particularmente al resolver opiniones o prioridades contradictorias, o al tratar con plazos ajustados.

Otros desafíos comunes son mantener un alto nivel de objetividad y evitar sesgos durante las pruebas, informar con precisión los defectos y proporcionar comentarios constructivos, y asegurar una cobertura de prueba suficiente dentro de las limitaciones de tiempo y recursos. La priorización de los casos de prueba, cuando se enfrenta a un conjunto de pruebas grande y un tiempo limitado, puede ser difícil. Tratar con sistemas complejos e identificar las causas raíz de los problemas en tales sistemas puede ser un desafío. Finalmente, la creación y el mantenimiento de conjuntos de pruebas automatizadas eficaces es esencial para las pruebas de regresión y requiere fuertes habilidades técnicas y una planificación cuidadosa.

24. ¿Cómo se determina la cobertura de la prueba?

La cobertura de la prueba se determina midiendo hasta qué punto el código base ha sido ejecutado por las pruebas. Existen varias métricas para cuantificar esto.

Las técnicas comunes incluyen la cobertura de líneas (porcentaje de líneas ejecutadas), la cobertura de ramas (porcentaje de ramas de código tomadas), la cobertura de sentencias (porcentaje de sentencias ejecutadas) y la cobertura de condiciones (porcentaje de sub-expresiones booleanas evaluadas tanto a verdadero como a falso). Herramientas como JaCoCo (Java), Coverage.py (Python) o llvm-cov (C++) pueden recopilar automáticamente estos datos durante la ejecución de las pruebas. El análisis de los informes generados por estas herramientas identifica áreas del código que no están suficientemente probadas, lo que permite la creación de nuevas pruebas para mejorar la cobertura y reducir el riesgo.

25. ¿Cuáles son algunas herramientas de prueba comunes?

Se utilizan comúnmente varias herramientas de prueba en el desarrollo de software. Algunas opciones populares incluyen:

- Selenium: Una herramienta muy utilizada para automatizar las pruebas de navegadores web. Es compatible con múltiples navegadores y lenguajes de programación.

- JUnit: Un marco de pruebas unitarias para Java.

- pytest: Un marco de pruebas popular y versátil para Python.

- TestNG: Un marco de pruebas para Java, inspirado en JUnit y NUnit, pero que introduce nuevas funcionalidades.

- Cypress: Una herramienta moderna de pruebas front-end construida para la web. Proporciona pruebas más rápidas, fáciles y confiables para cualquier cosa que se ejecute en un navegador.

- JMeter: Un proyecto de Apache que puede utilizarse como herramienta de pruebas de carga para analizar y medir el rendimiento de aplicaciones web o una variedad de servicios.

- Postman: Una popular herramienta de pruebas de API utilizada para probar peticiones HTTP.

26. ¿Cuál es la diferencia entre un entorno de prueba y un entorno de producción?

Un entorno de prueba es una réplica del entorno de producción utilizado para las pruebas de software antes del lanzamiento. Su propósito es identificar errores y asegurar que la aplicación funcione como se espera sin afectar a los usuarios en vivo. A menudo contiene datos de prueba y puede tener diferentes configuraciones o servicios simulados.

La producción, por otro lado, es el entorno en vivo donde la aplicación se implementa para los usuarios finales. Contiene datos reales de usuarios y está diseñado para alta disponibilidad, rendimiento y seguridad. Los cambios en producción suelen estar muy controlados y monitorizados.

27. ¿Cuál es la diferencia entre un caso de prueba y un script de prueba?

Un caso de prueba es un conjunto detallado de pasos, condiciones y entradas para verificar una característica o funcionalidad específica. Describe qué se necesita probar, incluido el resultado esperado. Los casos de prueba a menudo se escriben en un documento estructurado o en un sistema de gestión de pruebas.

Por otro lado, un script de prueba es la implementación de un caso de prueba. Es el código real o las instrucciones automatizadas que ejecutan los pasos definidos en el caso de prueba. Los scripts de prueba traducen el 'qué' en 'cómo' utilizando lenguajes de programación o herramientas de automatización para interactuar con el sistema bajo prueba y validar los resultados. Por ejemplo, si un caso de prueba dice 'Verificar la funcionalidad de inicio de sesión', un script de prueba podría usar Selenium para automatizar el proceso de inicio de sesión y asegurar que el usuario se haya conectado correctamente.

28. ¿Cuáles son los atributos clave de un buen caso de prueba?

Un buen caso de prueba posee varios atributos clave. Principalmente, debe ser claro y conciso, describiendo los pasos exactos y el resultado esperado sin ambigüedad. Debe ser repetible, produciendo el mismo resultado cada vez que se ejecuta, e independiente de otros casos de prueba para evitar fallos en cascada. Además, un buen caso de prueba debe ser mantenible, fácil de actualizar a medida que el sistema evoluciona. También debe ser rastreable hasta los requisitos para garantizar una cobertura exhaustiva.

Fundamentalmente, un buen caso de prueba debe ser completo, cubriendo todas las condiciones relevantes, incluyendo entradas válidas e inválidas, condiciones de contorno y manejo de errores. Considere el uso de técnicas como la partición de equivalencia y el análisis de valores límite para lograr la integridad. Finalmente, debe ser eficiente, ejecutándose en un plazo razonable y no consumiendo recursos excesivos.

29. ¿Qué es la prueba exploratoria?

Las pruebas exploratorias son un enfoque de pruebas de software donde el diseño y la ejecución de las pruebas ocurren simultáneamente. Los evaluadores exploran el software para aprender sobre él, identificar posibles problemas, y diseñar y ejecutar pruebas sobre la marcha, en lugar de depender de casos de prueba preescritos. Enfatiza la habilidad, la intuición y la experiencia del evaluador para descubrir defectos inesperados y proporciona flexibilidad para adaptar las pruebas basadas en la información emergente.

Las pruebas exploratorias son particularmente útiles cuando los requisitos son vagos, incompletos o cambian rápidamente, o cuando necesita evaluar rápidamente la calidad de un sistema. También son beneficiosas para encontrar problemas sutiles o inesperados que podrían pasarse por alto con las pruebas basadas en scripts.

30. ¿Cómo prioriza qué pruebas ejecutar?

Priorizar las pruebas depende del contexto, pero generalmente considero el riesgo, el impacto y la frecuencia. Priorizo las pruebas que cubren la funcionalidad crítica o las características de uso frecuente, ya que las fallas en estas áreas tienen un mayor impacto. También se priorizan las pruebas para los cambios recientes en el código o las correcciones de errores para garantizar la estabilidad y prevenir regresiones. También ejecuto pruebas basadas en el riesgo. ¿Qué áreas del sistema son más propensas a fallar? Priorice las pruebas que cubren esas áreas.

Específicamente, priorizaría las pruebas en el siguiente orden:

- Pruebas de humo: Asegurar que la funcionalidad básica esté funcionando.

- Pruebas de regresión: Verificar las correcciones de errores y evitar regresiones.

- Pruebas de camino crítico: Enfocarse en los procesos comerciales principales.

- Pruebas de áreas de alto riesgo: Cubrir áreas propensas a fallas.

- Pruebas exploratorias: Descubrir problemas inesperados.

La selección de pruebas también se puede automatizar mediante herramientas etiquetando las pruebas según el riesgo, la prioridad o los componentes afectados.

Preguntas de entrevista de Software Testing intermedio

1. Explique la diferencia entre las pruebas de caja blanca, caja negra y caja gris, y ¿cuándo elegiría cada una?

Las pruebas de caja blanca implican probar la estructura interna y el código de una aplicación de software. Los evaluadores necesitan conocimiento del código para diseñar casos de prueba, centrándose en la cobertura del código y las rutas lógicas. Se elige cuando es fundamental realizar pruebas exhaustivas del funcionamiento interno, como en algoritmos complejos o sistemas críticos para la seguridad.

Las pruebas de caja negra, por otro lado, tratan la aplicación como una 'caja negra', centrándose en las entradas y salidas sin conocimiento de la implementación interna. Los casos de prueba se diseñan en función de los requisitos y las especificaciones. Esto es adecuado para realizar pruebas desde la perspectiva del usuario o cuando el código interno es inaccesible o irrelevante para los objetivos de las pruebas. Las pruebas de caja gris son un enfoque híbrido donde los evaluadores tienen un conocimiento parcial de la estructura interna. Esto permite realizar pruebas más específicas basadas en el diseño arquitectónico, los diagramas de flujo de datos o los esquemas de bases de datos. Es útil cuando un cierto nivel de conocimiento interno puede mejorar la efectividad de las pruebas sin la sobrecarga de las pruebas completas de caja blanca.

2. Describe una situación en la que tuvo que diseñar casos de prueba con requisitos incompletos o ambiguos. ¿Qué hizo?

En un puesto anterior, me encontré con un proyecto donde los requisitos para un nuevo módulo de informes estaban definidos vagamente. Para abordar esto, primero prioricé la aclaración de las ambigüedades comunicándome directamente con los analistas de negocio y las partes interesadas. Hice preguntas dirigidas para comprender la funcionalidad prevista, las fuentes de datos y los resultados esperados de los informes. Cuando la aclaración directa no era posible de inmediato, hice suposiciones informadas basadas en mi comprensión de módulos similares y las mejores prácticas de la industria, documentando estas suposiciones claramente en la documentación de los casos de prueba.

A continuación, diseñé casos de prueba que cubrían escenarios tanto positivos como negativos, así como condiciones límite. Debido a que los requisitos eran cambiantes, creé un conjunto de pruebas flexible que era fácilmente adaptable. Esto incluyó la escritura de casos de prueba modulares que podían modificarse rápidamente a medida que los requisitos evolucionaban. También me centré en las pruebas exploratorias para descubrir problemas inesperados y utilicé los resultados de las sesiones exploratorias para refinar mis casos de prueba y aclarar aún más los requisitos. Me comuniqué continuamente con el equipo de desarrollo y las partes interesadas sobre mi progreso, suposiciones y hallazgos, asegurando que todos estuviéramos alineados a medida que el proyecto avanzaba.

3. ¿Cómo gestionas prioridades conflictivas al probar múltiples características o proyectos?

Cuando me enfrento a prioridades de prueba conflictivas, primero trato de comprender el impacto comercial y la urgencia de cada característica o proyecto. Luego me comunicaría con las partes interesadas, como los gerentes de producto y los desarrolladores, para comprender sus perspectivas y la justificación de las prioridades. Basándome en la información recopilada, trabajaría con el equipo para reevaluar y potencialmente re-priorizar las tareas. Esto a menudo implica negociar plazos o alcance, y comunicar claramente cualquier riesgo o retraso potencial asociado con el plan ajustado.

Si la re-priorización no es posible, me concentraría en la gestión eficaz del tiempo y la asignación de recursos. Esto podría implicar dividir las tareas grandes en partes más pequeñas y manejables, aprovechar la automatización cuando sea posible (por ejemplo, pruebas automatizadas) y colaborar estrechamente con otros evaluadores para distribuir la carga de trabajo de manera eficiente. Comunicar regularmente el progreso y cualquier obstáculo a las partes interesadas garantiza la transparencia y permite realizar ajustes oportunos si es necesario.

4. ¿Cuáles son algunos desafíos comunes que enfrentas al probar servicios web (API) y cómo los superas?

Probar los servicios web (APIs) presenta varios desafíos. Un problema común es lidiar con la validación de datos. Asegurar que la API maneje correctamente varios tipos de datos, condiciones de borde y entradas no válidas requiere pruebas exhaustivas, lo cual puede abordarse implementando conjuntos de pruebas completos con pruebas parametrizadas y técnicas de fuzzing. Otro desafío es verificar los mecanismos de autenticación y autorización; una implementación incorrecta puede conducir a vulnerabilidades de seguridad. Esto se puede superar utilizando herramientas como Postman o herramientas especializadas de prueba de seguridad de API para simular diferentes roles y permisos de usuario, validando que los controles de acceso se apliquen correctamente.

Otros desafíos incluyen manejar peticiones asíncronas, lidiar con formatos de datos complejos (como estructuras JSON anidadas) y asegurar el rendimiento bajo carga. Las pruebas de peticiones asíncronas se pueden realizar simulando servicios externos o usando colas de mensajes. Para formatos de datos complejos, utilice herramientas de validación de esquemas y bibliotecas dentro de los marcos de prueba para afirmar la estructura de la respuesta. Las pruebas de rendimiento se pueden abordar con herramientas como JMeter o Gatling para simular escenarios de alto tráfico y medir los tiempos de respuesta y el rendimiento, lo que lleva a la identificación de cuellos de botella de rendimiento y la optimización de la API.

5. Explique la diferencia entre pruebas de carga, pruebas de estrés y pruebas de rendimiento.

Las pruebas de carga evalúan el comportamiento de un sistema bajo condiciones esperadas. Simula el número anticipado de usuarios y transacciones concurrentes para determinar los tiempos de respuesta, el rendimiento y la utilización de recursos. El objetivo es identificar cuellos de botella y asegurar que el sistema pueda manejar el uso normal.

Por otro lado, las pruebas de estrés llevan el sistema más allá de sus límites al simular condiciones extremas, como un aumento repentino en el tráfico de usuarios o un período prolongado de alta demanda. El objetivo es encontrar el punto de ruptura del sistema, identificar vulnerabilidades y evaluar su capacidad para recuperarse de fallas. Las pruebas de rendimiento son un término más amplio que abarca tanto las pruebas de carga como las de estrés, junto con otras pruebas como las pruebas de resistencia y escalabilidad, para evaluar varios aspectos del rendimiento de un sistema.

6. ¿Cómo se asegura la cobertura de las pruebas en un sistema complejo con muchos componentes interconectados?

Asegurar la cobertura de las pruebas en un sistema complejo implica un enfoque multifacético. Primero, identifique los componentes críticos y sus interacciones a través de técnicas como el análisis de dependencias y la evaluación de riesgos. Luego, priorice los esfuerzos de prueba en función del riesgo y el impacto.

Emplee una combinación de tipos de pruebas: pruebas unitarias para componentes individuales, pruebas de integración para interacciones entre componentes y pruebas de extremo a extremo para validar la funcionalidad de todo el sistema. Utilice herramientas de cobertura de código para medir el porcentaje de código ejecutado por las pruebas, pero recuerde que una alta cobertura de código no significa necesariamente una prueba exhaustiva. También, incorpore técnicas como pruebas basadas en propiedades para generar varios escenarios y entradas de datos para verificar los casos límite. Considere el uso de pruebas de contrato para asegurar que los servicios se adhieran a los contratos acordados. Finalmente, implemente tuberías de integración continua y entrega continua (CI/CD) que ejecuten automáticamente pruebas ante cambios de código para detectar regresiones de forma temprana.

7. Describa su experiencia con la automatización de pruebas. ¿Qué herramientas ha utilizado y cuáles son los beneficios y desventajas de la automatización?

Tengo experiencia en el diseño, implementación y mantenimiento de pruebas automatizadas para diversas aplicaciones de software. Mi experiencia incluye la automatización de pruebas unitarias, de integración y de extremo a extremo. He trabajado con herramientas como Selenium, Cypress y Jest. También he utilizado herramientas de CI/CD como Jenkins y GitHub Actions para integrar pruebas automatizadas en la tubería de desarrollo. Para las pruebas de API, he utilizado herramientas como Postman y bibliotecas como Supertest (Node.js). La elección de la herramienta generalmente depende de las necesidades del proyecto y la pila tecnológica.

Los beneficios de la automatización de pruebas incluyen una mayor cobertura de las pruebas, ciclos de retroalimentación más rápidos y una reducción del esfuerzo manual, lo que en última instancia conduce a un software de mayor calidad. Sin embargo, las desventajas incluyen la inversión inicial en la configuración del marco de automatización, la necesidad de un mantenimiento continuo a medida que evoluciona la aplicación y la posibilidad de falsos positivos si las pruebas no se diseñan correctamente. Además, la automatización a veces puede ser frágil, por lo que se necesita un diseño cuidadoso para garantizar que las pruebas no fallen innecesariamente.

8. ¿Qué es una estrategia de pruebas y en qué se diferencia de un plan de pruebas?

Una estrategia de pruebas es un documento de alto nivel que describe el enfoque general de las pruebas para un proyecto o producto. Define el qué y el por qué de las pruebas, incluyendo los tipos de pruebas a realizar, los niveles de prueba y los objetivos y el alcance generales. Es un documento orientativo que asegura que las pruebas se alinean con los objetivos de negocio y los objetivos generales del proyecto.

Un plan de pruebas, por otro lado, es un documento más detallado que especifica cómo se llevará a cabo la prueba. Incluye detalles como cronogramas de pruebas, recursos, configuración del entorno de pruebas, requisitos de datos de prueba, criterios de entrada/salida y casos de prueba o escenarios específicos a ejecutar. El plan de pruebas pone en funcionamiento la estrategia de prueba, proporcionando una hoja de ruta concreta para el equipo de pruebas.

9. Explique el concepto de partición de equivalencia y análisis de valores límite, y proporcione ejemplos de cómo los usaría.

La partición de equivalencia es una técnica de prueba de caja negra que divide los datos de entrada en particiones (o clases) de modo que todos los miembros de una partición dada probablemente sean tratados de la misma manera por el software. Probamos un valor de cada partición, asumiendo que si un valor de la partición funciona, todos los demás también funcionarán. Esto reduce el número de casos de prueba necesarios. Por ejemplo, si un campo acepta edades entre 18 y 65, creamos tres particiones: menos de 18, 18-65 y mayor de 65. Luego probamos un valor de cada partición como 17, 30 y 70.

El análisis de valores límite se centra en probar los valores en los bordes del dominio de entrada. Se basa en la idea de que los errores a menudo ocurren en los límites de los rangos de entrada. Usando el mismo ejemplo de edad, probaríamos los valores límite: 17, 18, 65 y 66. Esto significa probar el mínimo, justo por encima del mínimo, el valor nominal, justo por debajo del máximo y los valores máximos. Por ejemplo, si tuviéramos un método calculateDiscount(int quantity), donde el descuento cambia para cantidades de 1-10, 11-20 y 21-30. Usaríamos el análisis de valores límite y probaríamos con los valores: 0, 1, 10, 11, 20, 21, 30 y 31. Es probable que estos valores expongan mejor los errores que los valores aleatorios.

10. ¿Cómo aborda la prueba de una característica que involucra integraciones de terceros o dependencias externas?

Al probar características con integraciones de terceros, me concentro en aislar y simular las dependencias externas para garantizar pruebas confiables y predecibles. Utilizo herramientas como bibliotecas de simulación o virtualización de servicios para simular el comportamiento del servicio de terceros. Esto me permite probar varios escenarios, incluyendo el éxito, el fracaso y los casos extremos, sin interactuar realmente con el servicio real, lo que evita la inestabilidad de las pruebas y la dependencia de sistemas externos.

Mi enfoque implica definir contratos o interfaces claros para la integración, probar la lógica de mapeo y transformación de datos, y verificar los mecanismos de manejo de errores. Específicamente, usaría bibliotecas como requests-mock en Python o Mockito en Java para simular las llamadas a la API externa. Además, prestaría especial atención a las pruebas de limitación de frecuencia, autenticación y validación de datos para asegurar que la integración se comporte como se espera en diferentes condiciones.

11. ¿Cuáles son algunas métricas clave que utiliza para rastrear el progreso y la efectividad de sus esfuerzos de prueba?

Las métricas clave para rastrear el progreso y la efectividad de las pruebas incluyen: Cobertura de pruebas (porcentaje de código o requisitos cubiertos por las pruebas), Tasa de ejecución de pruebas (porcentaje de pruebas ejecutadas), Tasa de aprobado/fallido de pruebas (porcentaje de pruebas que pasan frente a las que fallan), Densidad de defectos (número de defectos encontrados por unidad de código o tiempo), y Eficiencia de eliminación de defectos (porcentaje de defectos encontrados durante las pruebas frente a los encontrados en producción).

También hago un seguimiento de las métricas relacionadas con el Tiempo del Ciclo de Prueba (tiempo necesario para completar un ciclo de prueba) y el Tiempo Medio de Detección (MTTD) y el Tiempo Medio de Resolución (MTTR) de los defectos. Estas métricas ayudan a identificar cuellos de botella, mejorar los procesos de prueba y, en última instancia, entregar software de mayor calidad más rápido. El seguimiento de estas es primordial para un programa de garantía de calidad exitoso. Las herramientas que se utilizan a menudo para calcular estas métricas son JIRA, TestRail y scripts de informes personalizados que utilizan lenguajes como Python.

12. Describa una situación en la que encontró un error crítico en producción. ¿Cuáles fueron los pasos que tomó para abordarlo y qué aprendió de la experiencia?

Durante un evento de ventas de alto tráfico, nuestro sistema de monitoreo nos alertó sobre un aumento repentino en la colocación fallida de pedidos. Investigando los registros, identifiqué rápidamente una condición de carrera en el servicio de actualización de inventario que causaba la doble venta de artículos de stock limitado. Esto fue crítico ya que impactó directamente los ingresos y la satisfacción del cliente.

Inmediatamente, alerté al equipo de guardia e implementamos una solución temporal desactivando la función problemática, lo que evitó más fallos en los pedidos. Paralelamente, trabajé en una solución permanente, introduciendo un bloqueo distribuido para serializar las actualizaciones del inventario. Después de pruebas exhaustivas en un entorno de staging, la solución se implementó en producción. También emitimos reembolsos a los clientes afectados e implementamos una mejor monitorización y alertas para detectar problemas similares antes. El aprendizaje clave fue la importancia de las pruebas rigurosas de concurrencia y la monitorización proactiva en sistemas distribuidos.

13. ¿Cómo te mantienes al día con las últimas tendencias y tecnologías en las pruebas de software?

Me mantengo al día a través de una variedad de canales. Leo regularmente blogs y publicaciones de la industria como el blog de Martin Fowler y el Ministry of Testing. También sigo a personas influyentes y líderes de opinión clave en plataformas como LinkedIn y Twitter. Suscribirme a boletines relevantes, como los de los proveedores de herramientas de prueba, me ayuda a estar informado sobre las nuevas características de los productos y las metodologías de prueba.

Además, participo activamente en comunidades y foros en línea como Stack Overflow y r/softwaretesting de Reddit para aprender de las experiencias de otros y discutir las tendencias actuales. También asisto a seminarios web, talleres y conferencias cuando es posible. Finalmente, la aplicación práctica experimentando con nuevas herramientas y técnicas en proyectos personales o en el trabajo es crucial. Por ejemplo, recientemente exploré el uso de pytest con la biblioteca requests para pruebas de API y documenté mis hallazgos.

14. ¿Qué es el testing exploratorio y cómo encaja en tu enfoque general de pruebas?

El testing exploratorio es un enfoque de pruebas de software donde el diseño y la ejecución de pruebas ocurren simultáneamente. En lugar de depender de casos de prueba preescritos, los evaluadores diseñan y ejecutan pruebas dinámicamente basándose en su comprensión del sistema, los resultados de pruebas anteriores y las áreas potenciales de riesgo. Enfatiza el aprendizaje sobre la aplicación mientras se prueba, fomentando la creatividad y la adaptabilidad.

En mi enfoque general de pruebas, las pruebas exploratorias complementan métodos más estructurados como las pruebas basadas en requisitos y las pruebas de regresión. Las uso para descubrir problemas inesperados y obtener una comprensión más profunda del comportamiento de la aplicación, especialmente en áreas no cubiertas por los casos de prueba existentes. Es más efectivo cuando se combina con otras estrategias de prueba para lograr una cobertura de prueba integral. A menudo se utiliza para generar nuevos casos de prueba que pueden automatizarse para futuras pruebas de regresión.

15. Explique el concepto de gestión de datos de prueba y por qué es importante.

La gestión de datos de prueba (TDM) abarca las estrategias y prácticas utilizadas para planificar, diseñar, generar, adquirir, almacenar, controlar y mantener los datos utilizados para las pruebas de software. Es importante porque una TDM eficaz impacta directamente en la calidad, velocidad y costo de las pruebas. Sin ella, las pruebas pueden ser inexactas, consumir mucho tiempo y ser costosas. Por ejemplo, las pruebas con datos de producción podrían exponer información confidencial y, sin datos consistentes, las pruebas no son repetibles.

La TDM garantiza que los datos correctos estén disponibles en el formato correcto en el momento adecuado para las pruebas. Esto puede implicar la creación de datos sintéticos, el enmascaramiento de datos de producción o el uso de técnicas de virtualización de datos. Los beneficios incluyen una mejor cobertura de las pruebas, una reducción del riesgo de filtración de datos y ciclos de ejecución de pruebas más rápidos.

16. ¿Cómo gestiona las pruebas en un entorno de desarrollo Agile?

En un entorno de desarrollo Agile, las pruebas son una actividad continua y colaborativa integrada a lo largo de todo el ciclo de vida del desarrollo de software. Enfatizamos las pruebas tempranas y frecuentes, desplazando las pruebas hacia la izquierda. Esto significa involucrar a los evaluadores desde las etapas iniciales de planificación y diseño para identificar posibles problemas y proporcionar comentarios sobre los requisitos. Adoptamos el desarrollo impulsado por pruebas (TDD) y el desarrollo impulsado por el comportamiento (BDD) cuando es apropiado.

Nuestro enfoque de pruebas es iterativo, con actividades de prueba que ocurren en cada sprint. Automatizamos las pruebas (unitarias, de integración, de extremo a extremo) para garantizar una retroalimentación rápida y pruebas de regresión. La colaboración entre desarrolladores, evaluadores y las partes interesadas del negocio es crucial para definir los criterios de aceptación y garantizar que el software entregado satisfaga las necesidades del usuario. También valoramos las pruebas exploratorias para descubrir problemas inesperados.

17. ¿Cuáles son algunas de las mejores prácticas para escribir informes de errores claros y concisos?

- Usar un título claro y descriptivo: Resumir el problema concisamente. Mal: "Algo está roto". Bien: "Botón de inicio de sesión no responde en Chrome v115".

- Proporcionar los pasos para reproducir: Enumere los pasos exactos necesarios para activar el error. Las listas numeradas son útiles.

- Describir los resultados esperados y reales: Indicar claramente lo que debería suceder y lo que realmente sucedió.

- Incluir información relevante del entorno: Sistema operativo, versión del navegador, dispositivo, etc. Usar un bloque de código para mostrar archivos de configuración o comandos utilizados.

- Adjuntar capturas de pantalla o videos: La evidencia visual puede ser invaluable.

- Especificar la gravedad/prioridad: Indicar el impacto del error.

- Ser conciso y evitar detalles irrelevantes: Ceñirse a los hechos.

- Usar un formato consistente: Esto ayuda con la legibilidad y la organización.

18. Describe su experiencia con las pruebas móviles. ¿Cuáles son algunos desafíos únicos al probar aplicaciones móviles?

Tengo experiencia en pruebas de aplicaciones móviles tanto en plataformas iOS como Android. Mi experiencia incluye la creación y ejecución de planes de prueba, la redacción de casos de prueba, la realización de pruebas funcionales, de regresión, de rendimiento y de usabilidad. He utilizado herramientas como Appium y Espresso para pruebas automatizadas, y Charles Proxy para el análisis del tráfico de red.

Las pruebas móviles presentan desafíos únicos como: versiones de sistemas operativos y tipos de dispositivos fragmentados que aumentan la matriz de pruebas y dificultan la garantía de consistencia. Las condiciones de la red (2G/3G/4G/5G/WiFi) son muy variables, lo que impacta en el rendimiento y la estabilidad. Las interrupciones (llamadas, SMS, notificaciones) pueden interrumpir el flujo de la aplicación. El consumo de batería y la gestión de recursos son consideraciones críticas que requieren especial atención.

19. Explique la diferencia entre pruebas unitarias, pruebas de integración y pruebas del sistema.

Las pruebas unitarias se centran en verificar componentes o funciones individuales de una aplicación de software de forma aislada. El objetivo es asegurar que cada unidad de código funcione como se espera. Las pruebas de integración, por otro lado, prueban la interacción entre diferentes unidades o módulos que ya han sido probados unitariamente. Verifica que estas unidades funcionen correctamente cuando se combinan.

Las pruebas del sistema son el proceso de probar un sistema completamente integrado para verificar que cumple con sus requisitos especificados. Implica probar todo el sistema de principio a fin, simulando escenarios del mundo real y validando que todos los componentes funcionen como se espera y que el sistema cumpla su propósito general.

20. ¿Cómo prioriza los casos de prueba en función del riesgo y el impacto?

Priorizar los casos de prueba basándose en el riesgo y el impacto implica identificar las áreas con mayor probabilidad de fallar (riesgo) y aquellas fallas que causan los problemas más significativos (impacto). El riesgo se evalúa típicamente considerando la probabilidad de fallo y el daño potencial que podría causar. El impacto considera factores como la criticidad del negocio, la integridad de los datos y la experiencia del usuario. Los casos de prueba de alto riesgo y alto impacto obtienen la mayor prioridad. Por ejemplo, las pruebas que cubren funcionalidades centrales como el inicio de sesión o el procesamiento de pagos deberían priorizarse porque los fallos allí impactan significativamente en todo el sistema. Específicamente, crearía una matriz de evaluación de riesgos. Esta matriz tendría 'probabilidad' en un eje e 'impacto' en el otro. Ejemplos de criterios de probabilidad incluyen 'muy probable', 'probable', 'posible', 'improbable', 'muy improbable'. Los criterios de impacto podrían ser 'crítico', 'mayor', 'moderado', 'menor', 'insignificante'. Cada caso de prueba se evalúa y se coloca dentro de la matriz, lo que permite una priorización clara de mayor a menor riesgo. Las pruebas de regresión que cubren el código modificado recientemente también se priorizarían altamente, porque los cambios recientes aumentan el riesgo de introducir errores. ### 21. ¿Cuáles son algunos anti-patrones comunes en las pruebas de software y cómo se pueden evitar?

Los anti-patrones comunes en las pruebas de software incluyen el Anti-Patrón del Cono de Helado, donde la mayor parte del esfuerzo de pruebas se concentra en las pruebas de la interfaz de usuario, dejando las capas subyacentes sin probar. Esto se evita mediante el desplazamiento a la izquierda, implementando una pirámide de pruebas con más pruebas unitarias e integración. Otro es el anti-patrón de Gestión de Champiñones, que mantiene a los desarrolladores en la oscuridad sobre el progreso de las pruebas. Evite esto promoviendo la transparencia y la colaboración con paneles compartidos y comunicación regular. El Descuido del Aislamiento de Pruebas también puede causar inestabilidad: asegúrese de que sus pruebas estén aisladas utilizando mocks/stubs. Finalmente, Ignorar los Casos Extremos conduce a errores en producción; evítelos utilizando el análisis de valores límite y la partición de equivalencia al diseñar las pruebas.

22. Describa una vez que tuvo que abogar por mejores prácticas de prueba dentro de su equipo u organización.

Al principio de mi carrera, me uní a un equipo que dependía en gran medida de las pruebas manuales y carecía de cobertura de pruebas automatizadas para componentes críticos. Reconociendo el creciente riesgo de regresiones y la naturaleza consumidora de tiempo de los esfuerzos manuales, abogué por la introducción de pruebas unitarias e integración automatizadas. Comencé demostrando el valor a través de una prueba de concepto, escribiendo pruebas unitarias para un módulo central que se modificaba con frecuencia. Presenté los resultados, destacando la mayor confianza en los cambios de código y la reducción del tiempo dedicado a las pruebas de regresión manuales.

Para superar la resistencia, también organicé un taller para enseñar a los miembros del equipo los conceptos básicos del marco de pruebas que estábamos utilizando, lo que ayudó a obtener aceptación. Con el tiempo, aumentamos gradualmente la cobertura de las pruebas y nos orientamos hacia un enfoque de desarrollo más impulsado por las pruebas. También creé una biblioteca compartida de utilidades de pruebas para nuestro equipo.

23. ¿Cómo probaría una función que involucra interacciones o flujos de trabajo complejos del usuario?

Para las interacciones complejas del usuario, me centraría en una combinación de tipos de pruebas. Primero, dividiría el flujo de trabajo en unidades más pequeñas y comprobables y usaría pruebas unitarias para verificar la lógica de los componentes individuales. Luego, escribiría pruebas de integración para asegurarme de que estos componentes funcionen correctamente juntos. Finalmente, emplearía pruebas de extremo a extremo, simulando escenarios reales de usuario, para validar todo el flujo de trabajo de principio a fin. Usaría un enfoque basado en datos utilizando múltiples conjuntos de datos de entrada.

Además, exploraría el uso de pruebas exploratorias para descubrir problemas inesperados o casos extremos. También, consideraría las pruebas de aceptación del usuario (UAT) para obtener retroalimentación de usuarios reales, especialmente cuando se trata de aspectos de usabilidad o experiencia del usuario. También podría automatizar el proceso para ejecutar diferentes conjuntos de datos de entrada para cada interacción.

24. Explique el concepto de pruebas de mutación.

Las pruebas de mutación son un tipo de prueba de software en el que se introducen pequeños errores artificiales (mutaciones) en el código fuente de un programa. Cada versión mutada del código se llama mutante. El objetivo es determinar si sus pruebas existentes pueden detectar estas mutaciones. Si sus pruebas fallan en un mutante, significa que sus pruebas son efectivas para detectar ese tipo de error.

Si sus pruebas no fallan en un mutante, indica que la mutación es equivalente al código original (lo que significa que no cambia el comportamiento) o, lo que es más importante, que sus pruebas son insuficientes y necesitan ser mejoradas para cubrir ese escenario. Las mutaciones comunes incluyen cambiar operadores aritméticos (+ a -), operadores relacionales (> a <), o negar condiciones (if (x) a if (!x)). El porcentaje de mutantes eliminados (las pruebas fallan) frente al número total de mutantes es la puntuación de mutación, que refleja la calidad del conjunto de pruebas.

25. ¿Cómo aborda las pruebas de accesibilidad (por ejemplo, el cumplimiento de las WCAG)?

Abordo las pruebas de accesibilidad entendiendo primero las directrices relevantes, como las WCAG (Web Content Accessibility Guidelines). Luego, empleo una combinación de técnicas de prueba automatizadas y manuales. Herramientas automatizadas como WAVE, axe DevTools y Lighthouse pueden identificar rápidamente problemas comunes como la falta de texto alternativo, el bajo contraste de color y estructuras de encabezado incorrectas.

Para las pruebas manuales, utilizo lectores de pantalla (NVDA, VoiceOver), navegación solo con teclado y analizadores de contraste de color para simular la experiencia de los usuarios con discapacidades. También validaré las etiquetas de los formularios, los atributos ARIA y aseguraré un orden de enfoque adecuado. Es importante involucrar a los usuarios con discapacidades en el proceso de prueba para obtener comentarios directos e identificar problemas que las pruebas automatizadas y manuales podrían pasar por alto.

26. ¿Qué estrategias utilizaría para probar una aplicación empresarial grande con muchos módulos?

Probar una aplicación empresarial grande requiere un enfoque estratégico. Priorizaría las pruebas basadas en el riesgo, centrándome en los módulos con el mayor impacto y probabilidad de fallo. Esto implica identificar funcionalidades críticas y puntos de integración. Es necesaria una combinación de tipos de prueba, incluyendo pruebas unitarias para componentes individuales, pruebas de integración para las interacciones de los módulos, pruebas del sistema para validar la funcionalidad de extremo a extremo y pruebas de aceptación del usuario (UAT) para asegurar que cumple con los requisitos del negocio. Las pruebas de rendimiento (carga y estrés) también son cruciales para asegurar la escalabilidad.

Además, un enfoque por fases puede ser efectivo. Esto podría implicar pruebas por etapas, como primero los módulos principales, seguido por componentes menos críticos. La automatización de pruebas es esencial para las pruebas de regresión, especialmente después de los cambios de código. Utilice una herramienta de gestión de pruebas para rastrear casos de prueba, resultados y defectos. La comunicación y colaboración efectivas entre los equipos de desarrollo, pruebas y negocio son vitales para un proceso de pruebas exitoso. Considere el uso de frameworks de mocking como Mockito (Java) para aislar componentes para las pruebas unitarias.

Preguntas de entrevista sobre pruebas de software avanzadas

1. ¿Cómo diseñaría una estrategia de pruebas para una arquitectura de microservicios altamente escalable?

Una estrategia de pruebas para una arquitectura de microservicios altamente escalable debe emplear un enfoque piramidal, priorizando las pruebas automatizadas. Comience con pruebas unitarias para validar componentes individuales de microservicios de forma aislada. Luego, implemente pruebas de integración para verificar las interacciones entre los servicios, centrándose en las pruebas de contrato para garantizar que las API se adhieran a las especificaciones definidas. Para la escalabilidad, las pruebas de carga y rendimiento son cruciales, simulando un alto tráfico de usuarios para identificar cuellos de botella. Finalmente, las pruebas de extremo a extremo simulan escenarios de usuario reales en múltiples servicios.

El monitoreo y el registro también son clave. Incorpore ingeniería del caos para inyectar fallos y probar la resiliencia. Automatice la implementación y las pruebas utilizando tuberías CI/CD para asegurar una retroalimentación más rápida. Desplace las pruebas hacia la izquierda involucrando a los equipos de desarrollo en las actividades de prueba al principio del SDLC.

2. Explique la diferencia entre la ingeniería del caos y los métodos de prueba tradicionales y dónde se puede aplicar la ingeniería del caos?

La ingeniería del caos y las pruebas tradicionales difieren significativamente en su enfoque. Las pruebas tradicionales tienen como objetivo verificar el comportamiento esperado siguiendo casos de prueba predefinidos y validando las salidas contra entradas conocidas. Se centra en encontrar errores en condiciones controladas. La ingeniería del caos, por otro lado, introduce proactivamente fallos del mundo real y condiciones inesperadas en un sistema para identificar debilidades y mejorar la resiliencia. Se trata de romper cosas a propósito para aprender cómo reaccionan.

La ingeniería del caos se aplica mejor en sistemas complejos y distribuidos, como arquitecturas de microservicios o aplicaciones basadas en la nube, donde el comportamiento emergente y las interacciones inesperadas son comunes. Es particularmente valiosa para probar los mecanismos de recuperación de fallos, los sistemas de monitoreo y la resiliencia de la infraestructura. Si bien aún se necesitan pruebas tradicionales para la verificación funcional, la ingeniería del caos las aumenta al revelar vulnerabilidades que las pruebas estándar podrían pasar por alto.

3. Describa su experiencia con las pruebas de rendimiento de sistemas distribuidos. ¿Cuáles son los desafíos clave?

Mi experiencia con las pruebas de rendimiento de sistemas distribuidos implica el uso de herramientas como JMeter, Gatling y Locust para simular la carga de usuarios y analizar el comportamiento del sistema bajo estrés. He trabajado en la prueba de arquitecturas de microservicios, colas de mensajes (como Kafka) y bases de datos distribuidas. Un flujo de trabajo típico incluye la definición de objetivos de rendimiento (latencia, rendimiento), la creación de escenarios de prueba realistas, la ejecución de pruebas, el monitoreo de métricas clave (CPU, memoria, E/S de red) y la identificación de cuellos de botella.

Los desafíos clave incluyen: Complejidad: Los sistemas distribuidos tienen muchas partes móviles, lo que dificulta identificar la causa raíz de los problemas de rendimiento. Configuración del entorno: Replicar un entorno similar a la producción para las pruebas puede ser costoso y complejo. Consistencia de datos: Asegurar la integridad de los datos en nodos distribuidos durante una alta carga es crucial. Monitoreo: Recopilar y analizar métricas de varios componentes requiere una infraestructura de monitoreo sólida. Coordinación: Coordinar las pruebas y analizar los resultados entre múltiples equipos y sistemas puede ser un desafío. Latencia de la red: Los problemas de red se vuelven más pronunciados. Condiciones de carrera: Es fundamental estar atento a las condiciones de carrera que pueden ocurrir bajo una alta carga y que pueden no ser evidentes en las pruebas.

4. ¿Cómo aborda las pruebas de aplicaciones impulsadas por IA/ML, centrándose en el sesgo y la equidad?

Probar aplicaciones de IA/ML para detectar sesgos y equidad requiere un enfoque multifacético. Primero, el sesgo de los datos es una preocupación principal. Necesitamos examinar rigurosamente los datos de entrenamiento en busca de una representación sesgada, asegurando que se utilicen conjuntos de datos diversos y representativos. Métricas como el impacto dispar y la paridad estadística pueden ayudar a cuantificar el sesgo en los resultados. En segundo lugar, el sesgo del modelo debe abordarse utilizando diferentes arquitecturas de modelos, técnicas de regularización y algoritmos conscientes de la equidad diseñados para mitigar el sesgo durante el entrenamiento. Finalmente, durante la evaluación, use conjuntos de datos de prueba diversos y evalúe el rendimiento en diferentes grupos demográficos, midiendo las métricas de equidad relevantes para identificar y abordar posibles sesgos en las predicciones del modelo. Utilice técnicas como las pruebas A/B para comparar las salidas del modelo en diferentes grupos demográficos. Documente los hallazgos e itere en el modelo y los datos.

5. ¿Puede explicar los desafíos de las pruebas en un entorno sin servidor y cómo los abordaría? Las pruebas en un entorno sin servidor presentan desafíos únicos debido a su naturaleza distribuida y basada en eventos. Los métodos de prueba tradicionales a menudo se quedan cortos. Los desafíos clave incluyen: Sin estado: Las funciones sin servidor suelen ser sin estado, lo que dificulta el seguimiento del estado y la depuración de problemas. Arquitectura basada en eventos: Probar los flujos de eventos y garantizar la activación y el manejo adecuados de los eventos puede ser complejo. Pruebas de integración: Validar las interacciones entre diferentes funciones y servicios sin servidor es crucial, pero difícil de configurar. Inicios en frío: La latencia introducida por los inicios en frío puede afectar el rendimiento y requiere pruebas específicas. Observabilidad limitada: El monitoreo y la depuración pueden ser difíciles debido a la falta de registros y métricas de servidor tradicionales.

Para abordar estos desafíos, emplearía estrategias como: Pruebas unitarias: probar rigurosamente funciones individuales de forma aislada utilizando mocks para simular dependencias. Pruebas de integración: utilizando herramientas como AWS SAM Local o Serverless Framework para implementar y probar funciones localmente o en un entorno de prueba, centrándose en flujos de trabajo de extremo a extremo. Pruebas de contrato: verificar que las funciones se adhieran a los contratos definidos para los datos de entrada y salida. Pruebas de rendimiento: simular cargas de trabajo realistas para identificar problemas de inicio en frío y cuellos de botella de rendimiento. Monitoreo y registro: utilizando herramientas de monitoreo específicas para serverless (por ejemplo, AWS CloudWatch, Datadog) para obtener visibilidad del comportamiento y el rendimiento de las funciones. Usar frameworks de pruebas diseñados para serverless: como Jest, Mocha o Chai con los plugins apropiados.

6. Describa su experiencia en la creación y el mantenimiento de suites de pruebas automatizadas dentro de una tubería CI/CD. ¿Cómo mide su efectividad?

Tengo una amplia experiencia en la creación y el mantenimiento de suites de pruebas automatizadas integradas dentro de las tuberías CI/CD utilizando herramientas como Jenkins, GitLab CI y Azure DevOps. Mi enfoque implica definir una estrategia de prueba clara que abarque pruebas unitarias, de integración y de extremo a extremo. Utilizo frameworks de pruebas como JUnit, pytest, Selenium y Cypress para escribir y ejecutar estas pruebas. Las suites están diseñadas para proporcionar retroalimentación rápida durante el ciclo de desarrollo, asegurando la calidad del código y previniendo regresiones. Por ejemplo, una tubería típica activaría pruebas unitarias en cada commit, pruebas de integración en las solicitudes de extracción y pruebas de extremo a extremo durante las implementaciones en entornos de prueba.

Mido la efectividad de los conjuntos de pruebas automatizadas a través de varias métricas clave. Estas incluyen: Cobertura de Pruebas (porcentaje de código cubierto por las pruebas), Tiempo de Ejecución de las Pruebas (cuánto tiempo tardan las pruebas en ejecutarse), Tasa de Aprobación de las Pruebas (porcentaje de pruebas que pasan), Tasa de Detección de Defectos (número de defectos encontrados por las pruebas automatizadas antes de la producción) y Tiempo Medio de Detección (MTTD) de fallos. El análisis de estas métricas ayuda a identificar áreas de mejora en el conjunto de pruebas, como agregar pruebas faltantes u optimizar las existentes. Se integran herramientas de análisis de código como SonarQube para medir la calidad y la complejidad del código, lo que informa aún más la estrategia de pruebas.

7. ¿Cómo abordaría la prueba de una característica que implica transformaciones complejas de datos e integraciones con múltiples API externas?

Probar una característica con transformaciones complejas de datos y múltiples integraciones de API requiere un enfoque multifacético. Primero, me centraría en probar unitariamente las funciones individuales de transformación de datos para asegurar que manejen correctamente varios escenarios de entrada, incluidos los casos extremos y las condiciones de error. La simulación de llamadas a API externas es crucial aquí, lo que me permite aislar la lógica de transformación. Por ejemplo, usar bibliotecas como unittest.mock en Python para simular respuestas de API y verificar que las transformaciones produzcan la salida esperada.

Luego, implementaría pruebas de integración para verificar las interacciones entre diferentes componentes y las API externas. Esto implica la configuración de entornos de prueba que imitan el entorno de producción lo más fielmente posible. Se pueden utilizar herramientas como Postman o frameworks especializados en pruebas de API para enviar peticiones a las API reales y validar las respuestas. También usaría pruebas de contrato para garantizar que los datos que se envían y reciben de las API se ajusten a los esquemas acordados. Finalmente, las pruebas de extremo a extremo deben cubrir todo el flujo de la funcionalidad, asegurando que el sistema en su conjunto funcione como se espera.

8. Explique su enfoque para las pruebas de seguridad, incluyendo herramientas y metodologías que ha utilizado.

Mi enfoque para las pruebas de seguridad es multifacético, abarcando el escaneo de vulnerabilidades, las pruebas de penetración y las auditorías de seguridad. Priorizo la identificación de posibles debilidades en sistemas y aplicaciones antes de que puedan ser explotadas. Normalmente empiezo con el escaneo de vulnerabilidades utilizando herramientas como Nessus, OpenVAS, o Nmap para detectar automáticamente vulnerabilidades conocidas. Esto es seguido por las pruebas de penetración, donde simulo ataques del mundo real para evaluar el impacto de esas vulnerabilidades. Se utilizan herramientas como Burp Suite, OWASP ZAP, y Metasploit para realizar estas pruebas. Las metodologías que sigo incluyen la Guía de pruebas de OWASP y las directrices del NIST.

Más allá de las herramientas técnicas, también realizo auditorías de seguridad, revisando código, configuraciones y controles de acceso para asegurar que se adhieran a las mejores prácticas de seguridad. Herramientas de análisis de código estático como SonarQube se pueden utilizar para identificar posibles fallos de seguridad en el código. El objetivo general es asegurar un enfoque en capas para la seguridad, combinando herramientas automatizadas con análisis manual para proporcionar una cobertura completa. También enfatizo la importancia de las pruebas de seguridad continuas como parte integral del ciclo de vida del desarrollo de software, para detectar y solucionar vulnerabilidades desde el principio.

9. ¿Cómo se mantiene al día con las últimas tendencias y tecnologías en pruebas de software?

Me mantengo al día a través de una variedad de canales. Sigo activamente blogs y sitios web de la industria como Ministry of Testing, Guru99, y blogs de proveedores relevantes (por ejemplo, BrowserStack, Sauce Labs). También participo en comunidades y foros en línea como Stack Overflow y subreddits relevantes (r/softwaretesting) para aprender de otros profesionales y comprender los desafíos y soluciones comunes. Me suscribo a boletines informativos y asisto a seminarios web/conferencias enfocadas en pruebas de software para aprender sobre nuevas herramientas, técnicas y mejores prácticas.

Específicamente, a menudo investigo áreas como marcos de automatización de pruebas (Selenium, Cypress, Playwright), herramientas de pruebas de rendimiento (JMeter, LoadView) y tecnologías emergentes como las pruebas impulsadas por IA y las plataformas de pruebas de bajo código. Cuando aprendo algo nuevo, trato de aplicarlo prácticamente en un proyecto personal o contribuir a proyectos de código abierto. Esto me ayuda a solidificar mi comprensión y a mantenerme al día con el panorama en evolución de las pruebas de software.

10. Discuta una vez que identificó un error crítico en producción. ¿Qué pasos tomó para resolverlo y qué aprendió?

Durante un período de alto tráfico, nuestro sistema de monitoreo nos alertó de un aumento repentino en las tasas de error para un servicio crítico de procesamiento de pagos. Inmediatamente revisé los registros y descubrí una NullPointerException que ocurría intermitentemente. El seguimiento de la pila apuntaba a un despliegue de código reciente que introdujo una nueva función relacionada con los cálculos de descuentos. Parecía que en algunos casos extremos, un objeto de descuento no se inicializaba correctamente, lo que provocaba el error.

Para resolver esto, primero alerté al equipo de guardia e inicié una reversión a la versión estable anterior del servicio. Esto mitigó inmediatamente la tasa de errores y estabilizó el sistema. Luego, reproduje el error en un entorno de prueba, identifiqué la causa raíz en el código e implementé una solución que incluía comprobaciones nulas adecuadas e inicialización de objetos. Antes de implementar la solución en producción, la probé a fondo con diferentes escenarios de entrada. Luego implementamos la versión parcheada con monitoreo continuo para garantizar la estabilidad. Aprendí la importancia de las pruebas unitarias e integración exhaustivas, especialmente para los casos extremos y el manejo de valores nulos. Además, esta experiencia reforzó el valor de tener sistemas robustos de monitoreo y alerta para identificar y responder rápidamente a los problemas de producción.

11. ¿Cómo diseñaría un plan de pruebas para un sistema donde los requisitos están en constante evolución?

Al tratar con requisitos en constante evolución, mi plan de pruebas priorizaría la flexibilidad y la adaptabilidad. Utilizaría un enfoque de pruebas ágil, centrándome en las pruebas continuas y los ciclos de retroalimentación. Esto incluye:

- Diseño de pruebas incremental: En lugar de crear un plan de pruebas exhaustivo por adelantado, las pruebas se diseñan y ejecutan en pequeños incrementos, alineados con cada iteración o sprint.

- Pruebas basadas en el riesgo: Priorizar las pruebas en función de la probabilidad y el impacto de posibles fallos. Esto asegura que las funcionalidades críticas se prueben a fondo, incluso con tiempo limitado.

- Pruebas automatizadas: Depender en gran medida de pruebas automatizadas (unitarias, de integración y de interfaz de usuario cuando sea factible) para garantizar una retroalimentación rápida y pruebas de regresión. Las herramientas y los marcos de trabajo deben ser fácilmente adaptables a los cambios de código.

- Pruebas exploratorias: Incorporar pruebas exploratorias para descubrir problemas inesperados que podrían pasarse por alto en los casos de prueba predefinidos. Esto puede revelar comportamientos matizados en sistemas que cambian rápidamente.

- Comunicación y colaboración: Mantener una estrecha comunicación con los desarrolladores y los propietarios de productos para comprender los nuevos requisitos y los cambios de forma rápida. La participación temprana ayuda a diseñar pruebas efectivas y reduce las posibilidades de descubrir defectos tardíamente.

- Integración continua/Entrega continua (CI/CD): Integrar las pruebas en la tubería CI/CD para garantizar que cada cambio de código se pruebe y valide automáticamente.

12. Explica tu comprensión de las pruebas de contrato y sus beneficios en la arquitectura de microservicios.