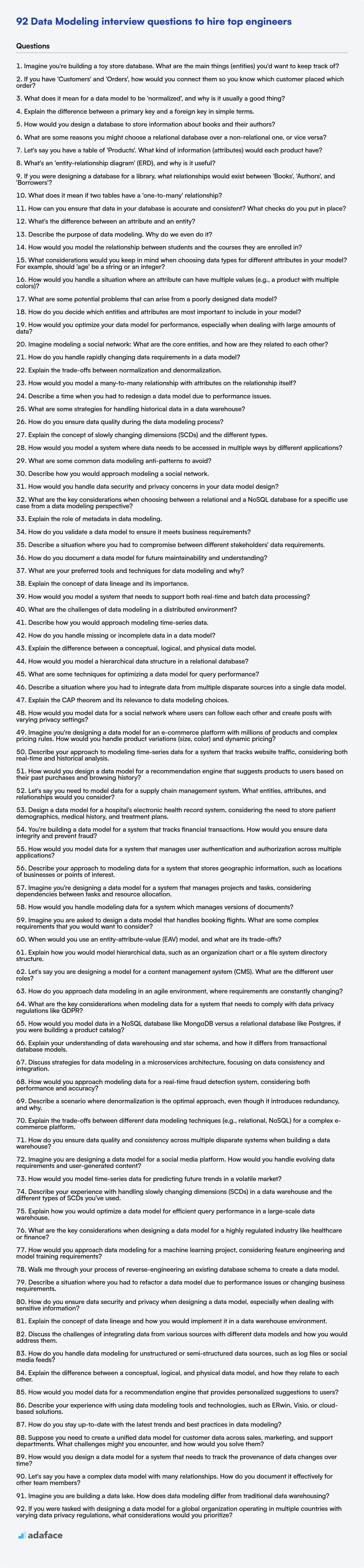

92 preguntas de entrevista sobre modelado de datos para contratar a los mejores ingenieros

El modelado de datos es el núcleo de cualquier organización basada en datos, transformando datos en bruto en estructuras comprensibles que impulsan las decisiones. Los reclutadores que buscan contratar a modeladores de datos de primer nivel necesitan una forma de evaluar a los candidatos de manera efectiva, pero encontrar buenas preguntas puede ser difícil.

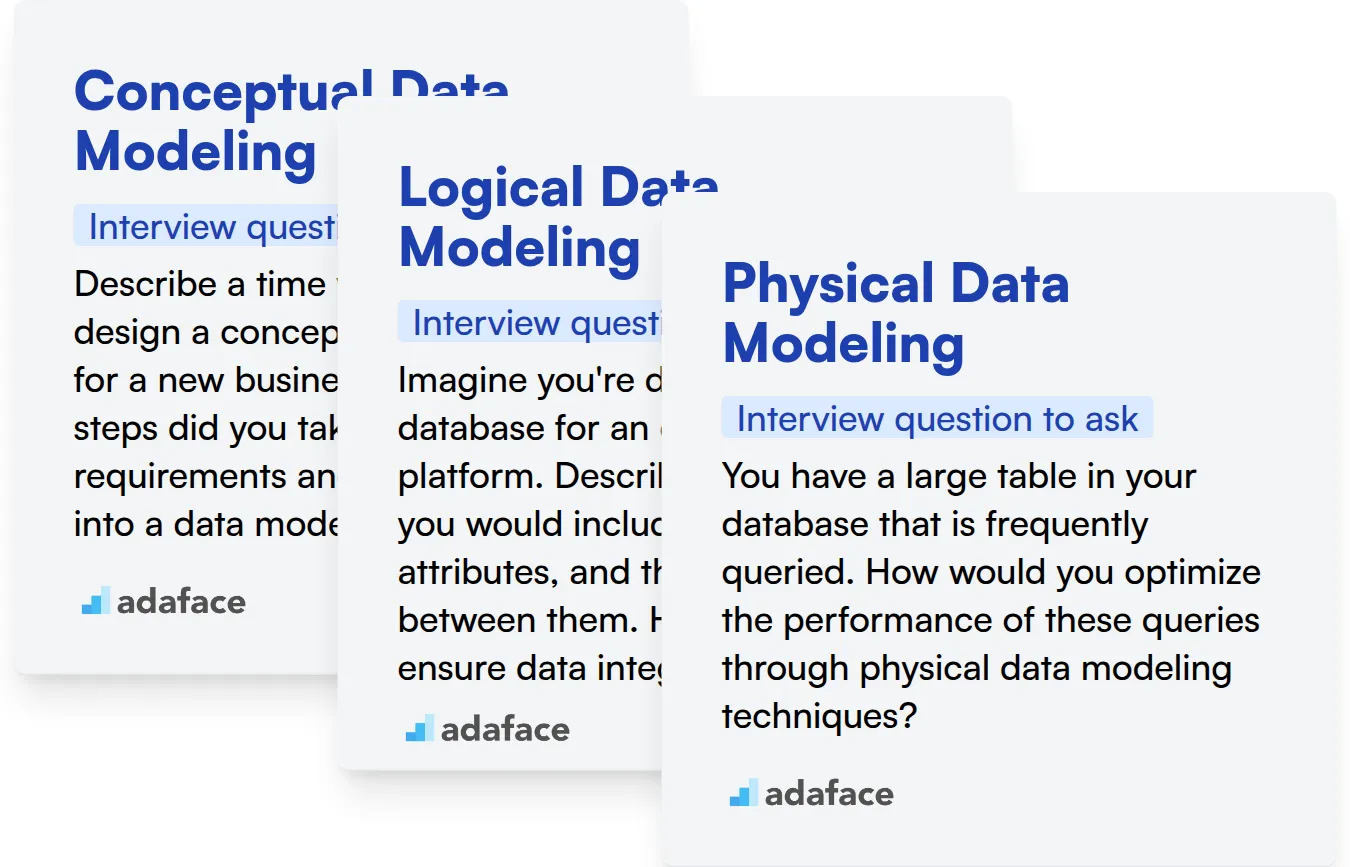

Esta entrada de blog proporciona un tesoro de preguntas de entrevista sobre modelado de datos categorizadas por nivel de habilidad: básico, intermedio, avanzado y experto, junto con preguntas de opción múltiple. Su objetivo es ayudar a los reclutadores y gerentes de contratación a evaluar el dominio de un candidato en el pensamiento lógico, las relaciones de datos y el diseño de bases de datos, como alguien que busca las habilidades requeridas para un modelador de datos.

Al usar estas preguntas, podrá determinar rápidamente si un candidato tiene las habilidades que su equipo necesita y, para acelerar el proceso, considere usar una Prueba de Modelado de Datos para filtrar a los candidatos antes de la entrevista.

Tabla de contenido

Preguntas básicas de la entrevista sobre modelado de datos

Preguntas intermedias de la entrevista sobre modelado de datos

Preguntas avanzadas de la entrevista sobre modelado de datos

Preguntas de la entrevista para expertos en modelado de datos

Preguntas de opción múltiple sobre modelado de datos

¿Qué habilidades de modelado de datos debe evaluar durante la fase de entrevista?

Contrate a expertos en modelado de datos con pruebas de habilidades y preguntas de entrevista específicas

Descargue la plantilla de preguntas de la entrevista sobre modelado de datos en múltiples formatos

1. Imagine que está construyendo una base de datos para una juguetería. ¿Cuáles son las principales cosas (entidades) que le gustaría rastrear?

En una base de datos de juguetería, principalmente querría rastrear estas entidades:

- Juguetes: Detalles como nombre, descripción, precio, fabricante, rango de edad, categoría (por ejemplo, figuras de acción, juegos de mesa) y cantidad en stock. Un ID único sería importante.

- Clientes: Información como nombre, dirección, correo electrónico, número de teléfono e historial de compras. Un ID de cliente único es clave.

- Pedidos: Datos sobre cada pedido, incluyendo la fecha del pedido, ID del cliente, artículos pedidos (enlazando con los juguetes), importe total y dirección de envío.

- Proveedores: Información sobre las empresas que suministran los juguetes, incluyendo nombre, dirección, persona de contacto y juguetes suministrados.

2. Si tienes 'Clientes' y 'Pedidos', ¿cómo los conectarías para saber qué cliente realizó qué pedido?

La forma estándar de conectar 'Clientes' y 'Pedidos' es mediante una relación de clave externa. Añadirías una columna IDCliente a la tabla Pedidos. Esta columna IDCliente haría referencia a la clave primaria (normalmente IDCliente) en la tabla Clientes.

Esto te permite identificar fácilmente qué cliente realizó cada pedido. Por ejemplo, en SQL:

SELECT * FROM Orders WHERE CustomerID = 123;

recuperaría todos los pedidos realizados por el cliente con CustomerID 123.

3. ¿Qué significa que un modelo de datos esté 'normalizado' y por qué suele ser algo bueno?

La normalización en el modelado de datos es el proceso de organizar los datos para reducir la redundancia y mejorar la integridad de los datos. Típicamente implica dividir una base de datos en dos o más tablas y definir las relaciones entre ellas. El objetivo es aislar los datos de modo que las modificaciones a un atributo se puedan hacer en una sola tabla.

La normalización suele ser algo bueno porque minimiza la duplicación de datos, lo que ahorra espacio de almacenamiento y reduce el riesgo de inconsistencias. También facilita la consulta y actualización de datos, lo que puede mejorar el rendimiento de las aplicaciones que utilizan la base de datos. Seguir las reglas de normalización como la Forma Normal de Boyce-Codd (BCNF) es crucial para un diseño de base de datos robusto. Sin embargo, en algunos casos, la desnormalización podría considerarse por razones de rendimiento, a costa de una mayor complejidad en la gestión de la consistencia de los datos.

4. Explica la diferencia entre una clave primaria y una clave foránea en términos sencillos.

Una clave primaria identifica de forma única cada registro en una tabla. Debe contener un valor único para cada fila y no puede contener valores nulos. Piense en ello como una identificación de estudiante: ningún estudiante puede tener la misma identificación.

Una clave foránea, por otro lado, es un campo en una tabla que se refiere a la clave primaria de otra tabla. Establece un enlace entre las dos tablas. Esencialmente crea una relación al hacer referencia a un registro único en una tabla diferente. Por ejemplo, una tabla de 'cursos' podría tener una clave foránea que haga referencia a la tabla de 'estudiantes' (usando la identificación del estudiante). Esto indica qué estudiante está tomando cada curso. Las claves foráneas hacen cumplir la integridad referencial, asegurando que las relaciones entre las tablas permanezcan consistentes.

5. ¿Cómo diseñaría una base de datos para almacenar información sobre libros y sus autores?

Diseñaría una base de datos con dos tablas: Libros y Autores. La tabla Libros tendría columnas como id_libro (INT, CLAVE PRIMARIA), título (VARCHAR), isbn (VARCHAR), fecha_publicación (DATE) y id_autor (INT, CLAVE FORÁNEA que hace referencia a la tabla Autores). La tabla Autores contendría id_autor (INT, CLAVE PRIMARIA), nombre (VARCHAR) y opcionalmente otros campos como fecha_nacimiento o biografía.

Existe una relación uno a muchos entre autores y libros, usando id_autor como clave foránea en la tabla Libros. Esta estructura permite consultas eficientes para libros de un autor específico o para autores de un libro en particular. Considere los índices en columnas consultadas con frecuencia como título, id_autor e isbn para mejorar el rendimiento. Por ejemplo, usando SQL:

CREATE TABLE Autores ( id_autor INT PRIMARY KEY, nombre VARCHAR(255) ); CREATE TABLE Libros ( id_libro INT PRIMARY KEY, título VARCHAR(255), id_autor INT, FOREIGN KEY (id_autor) REFERENCES Autores(id_autor) );

6. ¿Cuáles son algunas razones por las que podría elegir una base de datos relacional sobre una no relacional, o viceversa?

Elegir entre bases de datos relacionales y no relacionales depende en gran medida de las necesidades de la aplicación. Las bases de datos relacionales (como PostgreSQL o MySQL) sobresalen cuando la consistencia e integridad de los datos son primordiales. Hacen cumplir esquemas, admiten transacciones ACID y son adecuados para aplicaciones con relaciones complejas entre las entidades de datos, como sistemas financieros o gestión de inventario. SQL ofrece potentes capacidades de consulta para datos relacionales. El uso de claves externas, joins y características como las transacciones es importante para mantener la integridad de los datos. Son una buena opción cuando se trata de datos estructurados.

Las bases de datos no relacionales (bases de datos NoSQL como MongoDB o Cassandra) ofrecen mayor flexibilidad y escalabilidad, especialmente para manejar datos no estructurados o semiestructurados. A menudo se prefieren para aplicaciones con altas cargas de lectura/escritura, modelos de datos en rápida evolución o la necesidad de escalabilidad horizontal. Los ejemplos incluyen plataformas de redes sociales, almacenamiento de datos de IoT y sistemas de gestión de contenido. Los datos no relacionales no imponen restricciones, es responsabilidad de los desarrolladores de la aplicación garantizar la integridad de los datos.

7. Digamos que tienes una tabla de 'Productos'. ¿Qué tipo de información (atributos) tendría cada producto?

Cada producto en una tabla de 'Productos' probablemente tendría atributos como:

- product_id: Un identificador único para el producto (INT, CLAVE PRIMARIA)

- product_name: El nombre del producto (VARCHAR)

- description: Una breve descripción del producto (TEXT)

- category_id: Una clave foránea que referencia una tabla 'Categorías' (INT, CLAVE FORÁNEA)

- price: El precio del producto (DECIMAL/NUMERIC)

- stock_quantity: El número de unidades actualmente en stock (INT)

- manufacturer: La empresa que fabrica el producto (VARCHAR)

- image_url: URL a una imagen del producto (VARCHAR)

- created_at: Marca de tiempo de cuando se añadió el producto (TIMESTAMP)

- updated_at: Marca de tiempo de cuando el producto se actualizó por última vez (TIMESTAMP)

Estos atributos cubren la identificación básica, la categorización, el precio, la disponibilidad y la procedencia del producto. Dependiendo del dominio específico, otros atributos como el peso, las dimensiones, el color o el material también podrían ser relevantes.

8. ¿Qué es un 'diagrama entidad-relación' (DER) y por qué es útil?

Un Diagrama Entidad-Relación (DER) es una representación visual de los datos dentro de un sistema. Ilustra las entidades (objetos o conceptos sobre los cuales se almacenan datos), sus atributos (propiedades de las entidades) y las relaciones entre esas entidades. Los DER utilizan notaciones específicas para representar estos componentes.

Los ERD son útiles por varias razones. Principalmente, ayudan en el diseño de bases de datos al proporcionar un plano claro para estructurar los datos. También mejoran la comunicación entre desarrolladores, administradores de bases de datos y partes interesadas, asegurando que todos comprendan el modelo de datos. Además, ayudan a identificar posibles redundancias o inconsistencias de datos al principio del proceso de desarrollo, lo que conduce a un esquema de base de datos más eficiente y robusto. Finalmente, los ERD actúan como documentación, proporcionando una valiosa referencia para el mantenimiento y las mejoras futuras.

9. Si estuvieras diseñando una base de datos para una biblioteca, ¿qué relaciones existirían entre 'Libros', 'Autores' y 'Prestatarios'?

En una base de datos de biblioteca, existirían las siguientes relaciones:

- Libros y Autores: Una relación de muchos a muchos. Un libro puede tener múltiples autores (por ejemplo, colaboraciones), y un autor puede escribir múltiples libros. Esto normalmente se implementaría utilizando una tabla de enlace (por ejemplo,

AutoresLibros) que almacena elIDLibroy elIDAutorcomo claves foráneas. - Libros y Prestatarios: Una relación de muchos a muchos. Un libro puede ser prestado por múltiples prestatarios a lo largo del tiempo, y un prestatario puede tomar prestados múltiples libros. Esto a menudo se representa utilizando una tabla

Prestamos. Cada registro en la tablaPrestamosvincularía unIDLibroy unIDPrestatariojunto con otros detalles relacionados comofecha_prestamo,fecha_devolucion,fecha_vencimiento, etc. Esto permite rastrear quién prestó qué libro y cuándo.

10. ¿Qué significa si dos tablas tienen una relación 'uno a muchos'?

Una relación de uno a muchos entre dos tablas, digamos Tabla A y Tabla B, significa que un registro en la Tabla A puede estar relacionado con múltiples registros en la Tabla B, pero cada registro en la Tabla B solo puede estar relacionado con un registro en la Tabla A.

Por ejemplo, considere una base de datos con tablas Clientes y Pedidos. Un cliente puede realizar múltiples pedidos, pero cada pedido pertenece a un solo cliente. En este caso, la relación de Clientes a Pedidos es de uno a muchos.

11. ¿Cómo puede asegurar que los datos en su base de datos sean precisos y consistentes? ¿Qué controles implementa?

Para asegurar la precisión y consistencia de los datos, implemento varias comprobaciones en diferentes niveles. A nivel de base de datos, utilizo restricciones como NOT NULL, UNIQUE, PRIMARY KEY, FOREIGN KEY y CHECK para garantizar la integridad de los datos. También utilizo la validación de datos durante la entrada de datos, a menudo dentro de la capa de aplicación, para verificar tipos de datos, formatos y rangos antes de que lleguen a la base de datos. Los procedimientos almacenados y los disparadores (triggers) también se pueden utilizar para reglas de validación complejas y la corrección automatizada de datos. Las auditorías de datos periódicas que involucran la perfilación de datos y la comparación con conjuntos de datos conocidos ayudan a identificar y corregir inconsistencias.

Además, las copias de seguridad de datos y los planes de recuperación ante desastres son cruciales para mantener la integridad de los datos en caso de eventos imprevistos. Implementar la auditoría para rastrear los cambios en los datos. El versionado de datos también se puede emplear. El cifrado de datos puede ser útil en algunos casos donde la integridad de los datos es primordial y necesita ser protegida de intentos maliciosos.

12. ¿Cuál es la diferencia entre un atributo y una entidad?

Una entidad es un objeto o concepto del mundo real que existe y puede distinguirse de otros objetos. Piense en ello como una tabla en una base de datos. Un atributo, por otro lado, es una característica o propiedad que describe una entidad. Es una columna en esa tabla.

Por ejemplo, un Cliente es una entidad. Los atributos de la entidad Cliente podrían incluir customer_id, nombre, dirección y número_de_teléfono. Los atributos proporcionan detalles sobre la entidad, mientras que la entidad representa la cosa en sí.

13. Describe el propósito del modelado de datos. ¿Por qué lo hacemos?

El propósito del modelado de datos es crear una representación visual de los datos y sus relaciones dentro de un sistema de información. Lo hacemos para comprender y definir los requisitos de datos, garantizar la consistencia de los datos y optimizar el diseño de la base de datos. El modelado de datos ayuda a mejorar la comunicación entre las partes interesadas (desarrolladores, analistas de negocios, administradores de bases de datos) y facilita el almacenamiento y la recuperación eficientes de datos.

Específicamente, el modelado de datos:

- Aclara los requisitos de datos y las reglas de negocio.

- Proporciona un esquema para la construcción de la base de datos.

- Asegura la integridad y la consistencia de los datos.

- Mejora la accesibilidad y usabilidad de los datos.

- Facilita el análisis y la generación de informes de datos.

14. ¿Cómo modelaría la relación entre los estudiantes y los cursos en los que están inscritos?

Modelaría la relación entre estudiantes y cursos como una relación de muchos a muchos. Esto significa que un estudiante puede inscribirse en múltiples cursos y un curso puede tener múltiples estudiantes inscritos.

Para representarlo en una base de datos, usaría una base de datos relacional con tres tablas: estudiantes, cursos y inscripciones. La tabla estudiantes almacenaría información del estudiante (por ejemplo, ID del estudiante, nombre). La tabla cursos almacenaría información del curso (por ejemplo, ID del curso, título, descripción). La tabla inscripciones serviría como una tabla de unión, que contiene claves externas que hacen referencia tanto a estudiantes como a cursos (ID del estudiante, ID del curso), vinculando efectivamente a los estudiantes con sus cursos inscritos. Esto permite una consulta eficiente de las relaciones estudiante-curso.

15. ¿Qué consideraciones tendría en cuenta al elegir los tipos de datos para diferentes atributos en su modelo? Por ejemplo, ¿debería la 'edad' ser una cadena o un entero?

Al elegir los tipos de datos, considere el espacio de almacenamiento, la integridad de los datos y el rendimiento. Para la 'edad', un entero es mejor que una cadena porque la edad es inherentemente un número, lo que permite operaciones matemáticas (edad promedio, comparaciones de edad) y un almacenamiento eficiente. Usar un entero también refuerza la integridad de los datos, evitando que se ingresen valores no numéricos. Sin embargo, si necesita almacenar rangos de edad (por ejemplo, '25-30'), una cadena podría ser más adecuada. Además, ciertos sistemas podrían usar solo cadenas, lo que obligaría a almacenar la 'edad' como una cadena.

Las consideraciones incluyen:

- Tamaño de almacenamiento: Los números enteros generalmente ocupan menos espacio que las cadenas.

- Integridad de los datos: El uso de tipos apropiados (como enteros para la edad) evita datos no válidos.

- Rendimiento: Los cálculos numéricos son más rápidos en los enteros que en las cadenas.

- Uso de datos: Piense en cómo se usarán los datos. ¿Necesitará realizar cálculos o simplemente mostrar los datos?

- Restricciones del sistema: La base de datos y el lenguaje de programación pueden tener limitaciones de tipo. Ejemplo de código:

edad = 25(entero) vs.edad = "25"(cadena).

16. ¿Cómo manejaría una situación en la que un atributo puede tener múltiples valores (por ejemplo, un producto con múltiples colores)?

Hay varias formas de manejar atributos con múltiples valores, dependiendo del contexto (base de datos, código de la aplicación, etc.). Un enfoque común es usar una tabla separada para almacenar los atributos con múltiples valores. Por ejemplo, si tenemos una tabla productos y una tabla colores, podemos crear una tabla colores_productos para vincular los productos a sus respectivos colores. Esta tabla tendría columnas como id_producto e id_color como claves foráneas.

Otra opción es serializar los múltiples valores en una única cadena dentro de la tabla del producto. Esto podría implicar el uso de una lista separada por comas o una matriz JSON. Sin embargo, consultar y gestionar estos valores serializados puede ser más complejo que usar una tabla separada. Por ejemplo, el atributo color se puede almacenar como una cadena JSON ["rojo", "azul", "verde"]. Si bien esto es simple, puede dificultar la consulta directa de productos de un color específico. Es probable que necesite usar funciones JSON dentro de la consulta, lo que podría afectar el rendimiento dependiendo del sistema de base de datos.

17. ¿Cuáles son algunos problemas potenciales que pueden surgir de un modelo de datos mal diseñado?

Un modelo de datos mal diseñado puede generar numerosos problemas. La redundancia de datos es un problema importante, donde la misma información se almacena varias veces, desperdiciando espacio de almacenamiento y aumentando el riesgo de inconsistencias. Las inconsistencias dificultan la garantía de la exactitud y confiabilidad de los datos, lo que afecta la generación de informes y la toma de decisiones. Además, los modelos complejos y mal estructurados pueden hacer que la consulta y recuperación de datos sean ineficientes y lentas, lo que perjudica el rendimiento de la aplicación.

Además, un modelo mal diseñado puede dificultar la aplicación de restricciones de integridad de datos. Por ejemplo, si las relaciones entre entidades no están definidas correctamente, pueden ocurrir registros huérfanos o asociaciones de datos incorrectas. Los cambios de esquema y el desarrollo de aplicaciones se vuelven más complejos y costosos debido a la rigidez y la falta de escalabilidad del modelo. Finalmente, sin las consideraciones adecuadas de gobierno de datos en torno a la seguridad y el control de acceso, un modelo de datos mal diseñado puede exponer inadvertidamente información sensible.

18. ¿Cómo decides qué entidades y atributos son más importantes para incluir en tu modelo?

Prioriza las entidades y atributos que respaldan directamente los procesos comerciales principales y responden a preguntas comerciales clave. Comienza por identificar los objetivos principales que el modelo necesita abordar. Luego, considera la disponibilidad de datos, la calidad de los datos y el nivel de detalle requerido. Las entidades que representan conceptos centrales (por ejemplo, cliente, producto, pedido) son típicamente esenciales.

Los atributos deben incluirse en función de su relevancia para los objetivos comerciales. Pregúntese si el atributo es necesario para cálculos, informes, filtrado o toma de decisiones. Es útil involucrar a las partes interesadas de diferentes departamentos (por ejemplo, ventas, marketing, operaciones) para obtener diversas perspectivas y garantizar que el modelo capture la información más crítica. Evite incluir atributos redundantes, irrelevantes o de calidad cuestionable. Refine iterativamente el modelo basándose en las pruebas y los comentarios.

19. ¿Cómo optimizaría su modelo de datos para el rendimiento, especialmente al tratar con grandes cantidades de datos?

Para optimizar un modelo de datos para el rendimiento con grandes conjuntos de datos, me centraría en varias áreas clave. En primer lugar, la indexación es crucial. Agregar índices a las columnas consultadas con frecuencia acelera drásticamente la recuperación de datos. Sin embargo, es importante evitar la sobreindexación, ya que puede ralentizar las operaciones de escritura. En segundo lugar, considere la partición de datos o el sharding. Esto implica dividir los datos en fragmentos más pequeños y manejables, potencialmente distribuidos entre varios servidores. Esto reduce la cantidad de datos que se deben escanear para cada consulta.

Otras técnicas incluyen: elegir tipos de datos apropiados (usando el tipo de datos más pequeño que pueda representar con precisión los datos), desnormalización (agregar cuidadosamente datos redundantes para reducir la necesidad de uniones) y emplear mecanismos de almacenamiento en caché para almacenar datos a los que se accede con frecuencia en la memoria. Además, el diseño eficiente de consultas es primordial. El uso de EXPLAIN para analizar los planes de ejecución de consultas ayuda a identificar cuellos de botella. Por ejemplo, evitar SELECT * y usar nombres de columna específicos mejora el rendimiento. Elegir la tecnología de base de datos adecuada para el caso de uso también es crucial, ya sea una base de datos relacional como PostgreSQL con soporte JSONB, o una solución NoSQL si la estructura de datos se ajusta. La evaluación y el monitoreo regulares del rendimiento de la base de datos son clave para identificar y abordar los cuellos de botella de rendimiento.

20. Imagina modelar una red social: ¿Cuáles son las entidades principales y cómo se relacionan entre sí?

Las entidades principales en un modelo de red social son principalmente Usuarios y Publicaciones. Los usuarios se relacionan entre sí a través de Amistades (o Seguimientos). Los usuarios crean publicaciones. Las publicaciones pueden estar relacionadas con otras publicaciones a través de Comentarios o Compartir. Opcionalmente, Grupos puede ser otra entidad principal, donde los usuarios son miembros y las publicaciones pueden asociarse con grupos específicos.

Estas entidades se relacionan de la siguiente manera:

- Usuario crea Publicación

- Usuario es amigo de Usuario (Amistad).

- Usuario es miembro de Grupo.

- Publicación tiene Comentario.

- Publicación es compartida por Usuario.

- Publicación pertenece a Grupo (opcional).

Preguntas de la entrevista de modelado de datos intermedio

1. ¿Cómo se gestionan los requisitos de datos que cambian rápidamente en un modelo de datos?

Gestionar los requisitos de datos que cambian rápidamente implica una combinación de técnicas de modelado flexibles y prácticas sólidas de gestión del cambio. Empezaría por comprender la naturaleza y la frecuencia de los cambios. Algunos enfoques incluyen el empleo de técnicas de esquema en lectura (como bases de datos NoSQL) o el uso de diseños de esquema más adaptables (como columnas JSON en bases de datos relacionales) para dar cabida a estructuras de datos en evolución.

Otras estrategias incluyen:

- Control de versiones: Mantener versiones del modelo de datos y scripts de migración.

- Virtualización de datos: Abstraer la fuente de datos del consumidor.

- Metodologías ágiles: Adoptar un proceso de desarrollo iterativo.

- Gestión del cambio: Establecer un proceso claro para evaluar, aprobar e implementar los cambios en el modelo de datos.

- Pruebas automatizadas: Asegurar que los cambios no rompan la funcionalidad existente. Por ejemplo, si se añaden nuevos campos a un objeto JSON, asegurar que los procesos posteriores puedan manejarlos correctamente. Las pruebas unitarias se pueden implementar en lenguajes como Python para validar la integridad de los datos y el cumplimiento del esquema después de los cambios del modelo.

2. Explique las compensaciones entre la normalización y la desnormalización.

La normalización tiene como objetivo reducir la redundancia de datos y mejorar la integridad de los datos al organizar los datos en múltiples tablas relacionadas. Esto minimiza el espacio de almacenamiento y simplifica las actualizaciones, ya que los datos se almacenan en un solo lugar. Sin embargo, la normalización puede generar consultas más complejas que impliquen múltiples uniones, lo que podría ralentizar el rendimiento de la lectura.

La desnormalización, por el contrario, introduce redundancia al agregar datos a una tabla que están presentes en otra. Esto acelera las operaciones de lectura, ya que se necesitan menos uniones. La desventaja es el aumento del espacio de almacenamiento, las posibles inconsistencias de datos si las actualizaciones no se gestionan cuidadosamente en múltiples ubicaciones y operaciones de escritura más complejas para mantener la integridad de los datos. La elección entre la normalización y la desnormalización implica equilibrar el rendimiento de lectura y escritura con la integridad de los datos y los costos de almacenamiento. A menudo, una combinación de ambos enfoques es óptima, adaptando el diseño de la base de datos a las necesidades específicas de la aplicación.

3. ¿Cómo modelarías una relación de muchos a muchos con atributos en la propia relación?

Para modelar una relación de muchos a muchos con atributos en la propia relación, normalmente usarías una tabla de unión (también llamada entidad asociativa o tabla puente). Esta tabla almacena claves externas que hacen referencia a ambas tablas que participan en la relación de muchos a muchos. Además de estas claves externas, la tabla de unión incluye columnas que representan los atributos específicos de la relación.

Por ejemplo, considera estudiantes y cursos con una relación de muchos a muchos donde deseas registrar la calificación que un estudiante recibió en un curso en particular. Tendrías una tabla Estudiantes, una tabla Cursos y una tabla de unión EstudiantesCursos. La tabla EstudiantesCursos tendría claves externas a Estudiantes y Cursos y una columna adicional llamada Calificación para almacenar la calificación que el estudiante recibió para ese curso. La clave principal de EstudiantesCursos normalmente sería una clave compuesta de las dos claves externas que apuntan a las tablas Estudiantes y Cursos. El código para definir la tabla de unión EstudiantesCursos en SQL podría ser similar a esto: CREATE TABLE EstudiantesCursos (StudentID INT, CourseID INT, Calificación VARCHAR(2), PRIMARY KEY (StudentID, CourseID), FOREIGN KEY (StudentID) REFERENCES Estudiantes(StudentID), FOREIGN KEY (CourseID) REFERENCES Cursos(CourseID));

4. Describe una vez cuando tuviste que rediseñar un modelo de datos debido a problemas de rendimiento.

Una vez trabajé en un sistema que rastreaba la actividad del usuario para una gran plataforma de comercio electrónico. El modelo de datos inicial almacenaba todos los eventos de actividad en una sola tabla masiva. A medida que el volumen de datos crecía, consultar esta tabla se volvía increíblemente lento, lo que afectaba el rendimiento del panel y la generación de informes. Diagnosticamos el problema como proveniente de escaneos de tabla completos e indexación ineficiente en la tabla monolítica.

Para abordar esto, rediseñamos el modelo de datos para dividir los datos de actividad en función de los rangos de tiempo (por ejemplo, tablas mensuales). También introdujimos tablas de resumen que pre-agregaban patrones de consulta comunes. Esto implicó migrar los datos existentes, actualizar nuestras tuberías ETL y modificar nuestra lógica de consulta. El resultado fue una mejora significativa en el rendimiento de las consultas y redujo la carga en la base de datos, resolviendo los cuellos de botella de rendimiento. CREATE INDEX activity_time ON activity_table (event_time); antes no era suficiente.

5. ¿Cuáles son algunas estrategias para manejar datos históricos en un data warehouse?

Las estrategias para manejar datos históricos en un data warehouse giran en torno a la gestión de grandes volúmenes de datos, manteniendo al mismo tiempo el rendimiento de las consultas y la integridad de los datos. El particionamiento es crucial; divida los datos en función del tiempo (por ejemplo, mensual, anual) para mejorar la velocidad de las consultas y simplificar el archivo. La agregación y el resumen de datos reducen las necesidades de almacenamiento al crear tablas resumidas para períodos de informes comunes. El archivo de datos mueve los datos más antiguos y de acceso menos frecuente a un almacenamiento más barato, a la vez que los conserva para el cumplimiento o el análisis a largo plazo.

Además, considere las dimensiones de cambio lento (SCD) para rastrear los cambios de datos a lo largo del tiempo. SCD Tipo 1 sobrescribe los datos antiguos, el Tipo 2 crea nuevos registros con fechas efectivas y el Tipo 3 almacena un historial limitado en los registros existentes. Elija el tipo de SCD en función de sus necesidades de informes y de la cantidad de contexto histórico que necesita preservar. La implementación de políticas de gestión del ciclo de vida de los datos ayuda a automatizar estos procesos y garantiza que los datos se almacenen y gestionen de forma adecuada en función de su antigüedad y valor.

6. ¿Cómo se garantiza la calidad de los datos durante el proceso de modelado de datos?

Garantizar la calidad de los datos durante el modelado de datos implica varios pasos clave. En primer lugar, me centro en definir definiciones de datos claras y consistentes, incluidos los tipos de datos, las restricciones y las reglas de validación. Esto ayuda a prevenir inconsistencias y errores al entrar en el modelo. La creación de perfiles de datos también es importante para comprender los datos existentes e identificar posibles problemas como valores faltantes o valores atípicos.

Segundo, enfatizo la colaboración con las partes interesadas para recopilar requisitos precisos y garantizar que el modelo se alinee con las necesidades del negocio. Esto incluye la participación de expertos en el dominio y administradores de datos en el proceso de diseño. Se realizan pruebas y validaciones rigurosas durante todo el proceso de modelado para identificar y corregir cualquier problema de calidad de datos antes de la implementación. También priorizo la gobernanza de datos y la documentación para mantener la calidad de los datos a lo largo del tiempo.

7. Explique el concepto de dimensiones de cambio lento (SCD) y los diferentes tipos.

Las dimensiones de cambio lento (SCD) gestionan los cambios en los datos de las dimensiones a lo largo del tiempo en un data warehouse. En lugar de sobrescribir los datos antiguos, las SCD conservan la información histórica. Los diferentes tipos de SCD gestionan los cambios de varias maneras.

Existen varios tipos de SCD:

- Tipo 0 (Mantener Original): El valor del atributo de dimensión nunca cambia. El valor del atributo permanece sin cambios.

- Tipo 1 (Sobrescribir): El nuevo valor reemplaza al valor antiguo. El historial no se conserva.

- Tipo 2 (Añadir Nueva Fila): Se añade una nueva fila a la tabla de dimensión con el nuevo valor y las fechas de vigencia. Comúnmente implica indicadores como

start_date,end_dateyis_currentpara identificar la fila activa. Esto es importante para un análisis histórico preciso. - Tipo 3 (Añadir Nuevo Atributo): Se añade una nueva columna a la tabla de dimensión para almacenar el nuevo valor. Puede volverse engorroso con muchos atributos cambiantes.

- Tipo 4 (Tabla de Historial): El historial se guarda en una tabla de historial separada.

- Tipo 6 (Combinación de Tipo 1, 2 y 3): Se emplea una combinación de los tipos de SCD 1, 2 y 3.

8. ¿Cómo modelaría un sistema donde los datos necesitan ser accedidos de múltiples maneras por diferentes aplicaciones?

Modelaría el sistema utilizando una arquitectura de microservicios con un lago de datos o un data warehouse en su núcleo. Cada microservicio expone APIs específicas adaptadas a las necesidades de la aplicación a la que sirve. El lago de datos actúa como un repositorio central, ingiriendo datos de diversas fuentes en su formato bruto.

Para permitir un acceso eficiente a los datos, usaría tecnologías como:

- APIs (REST/GraphQL): Para permitir que los microservicios consulten el lago de datos o el almacén de datos.

- Colas de mensajes (Kafka, RabbitMQ): Para el procesamiento asíncrono de datos y la comunicación entre servicios.

- Persistencia políglota: Usar diferentes tecnologías de bases de datos basadas en los requisitos de cada servicio (por ejemplo, NoSQL para alto volumen, SQL para datos relacionales). Un ejemplo sería usar PostgreSQL para gestionar datos relacionales y usar MongoDB para el almacenamiento de documentos.

- Virtualización de datos: Para crear una vista unificada de los datos en múltiples sistemas, sin moverlos físicamente. Esto se puede hacer usando tecnologías como Apache Drill o Presto.

9. ¿Cuáles son algunos anti-patrones comunes de modelado de datos que se deben evitar?

Varios anti-patrones de modelado de datos pueden causar problemas con el rendimiento, el mantenimiento y la integridad de los datos. Algunos comunes incluyen:

- División de atributos: Almacenar múltiples datos en una sola columna (por ejemplo, almacenar el nombre y el apellido en una columna 'nombre'). Esto dificulta las consultas y la generación de informes.

- Modelado EAV (Entidad-Atributo-Valor) sin una buena razón: Excesivamente flexible pero puede ser extremadamente lento para las consultas. Solo debe usarse cuando los atributos son verdaderamente desconocidos y variables.

- Asociaciones Polimórficas: Una única columna de clave externa que hace referencia a múltiples tablas. Complejo y difícil de hacer cumplir la integridad.

- Números Mágicos: Usar códigos numéricos arbitrarios para representar valores de datos, en lugar de usar códigos descriptivos o tablas de búsqueda. Difícil de entender y mantener.

- Uso indebido de índices: Demasiados índices pueden ralentizar las operaciones de escritura. La falta de índices puede ralentizar las operaciones de lectura. Los índices definidos incorrectamente también son un problema.

- Ignorar la normalización: No normalizar los datos puede llevar a la redundancia, anomalías de actualización y anomalías de inserción.

- Sobrenormalización: Demasiadas tablas que se vuelven difíciles de consultar de manera efectiva. Ir demasiado lejos en la dirección opuesta de Ignorar la normalización.

- Usar nulos en exceso: Puede oscurecer el significado y hacer que las consultas sean más complejas. Considere representaciones alternativas o valores predeterminados.

- Dependencias circulares: Tablas que dependen unas de otras, lo que podría provocar problemas de consistencia de los datos y actualizaciones.

10. Describe cómo abordaría el modelado de una red social.

Modelaría una red social utilizando una estructura de datos de grafo. Cada usuario se representaría como un nodo, y las conexiones entre usuarios (por ejemplo, amistades, seguimientos) se representarían como aristas. Probablemente usaría una lista de adyacencia o una matriz de adyacencia para almacenar el grafo, dependiendo de la densidad esperada de la red. Por ejemplo, una red social donde cada persona conoce a todos será densa, y una red social como Twitter sería dispersa. Para el almacenamiento y las consultas, una base de datos de grafos como Neo4j sería muy adecuada, especialmente al tratar con consultas de relaciones complejas (por ejemplo, encontrar amigos de amigos). Alternativamente, una base de datos relacional como PostgreSQL con extensiones de grafos también podría funcionar.

Para implementar las funcionalidades principales, me centraría en características como agregar/eliminar usuarios, establecer/eliminar conexiones y recorrer el grafo para encontrar relaciones. Las APIs para buscar usuarios, sugerir conexiones y mostrar información de la red serían clave. También se considerarían la escalabilidad para un gran número de usuarios y conexiones, lo que podría implicar la partición del grafo o el empleo de marcos de procesamiento de grafos distribuidos como GraphX de Apache Spark.

11. ¿Cómo abordaría las preocupaciones sobre la seguridad y la privacidad de los datos en el diseño de su modelo de datos?

La seguridad y la privacidad de los datos son primordiales en el diseño del modelo de datos. Abordaría estas preocupaciones a través de varias estrategias, comenzando con la minimización de datos, asegurando que solo recopilamos y almacenamos los datos necesarios. El cifrado de datos en reposo y en tránsito es crucial, utilizando algoritmos de cifrado fuertes. Los mecanismos de control de acceso, como el control de acceso basado en roles (RBAC), restringirían el acceso a los datos en función de los roles de los usuarios.

Además, implementaría técnicas de enmascaramiento y anonimización de datos para entornos que no sean de producción y con fines de informes. Las auditorías de seguridad y las pruebas de penetración periódicas identificarían vulnerabilidades. El modelo de datos se diseñaría con principios de privacidad por diseño, adhiriéndose a regulaciones como GDPR y CCPA. Finalmente, una clara política de retención de datos definirá cuánto tiempo se almacenan los datos y cuándo se eliminan de forma segura. Por ejemplo, considere una tabla usuarios con una columna contraseña. Nunca deberíamos almacenar la contraseña en texto plano, sino utilizar un algoritmo de hash fuerte como bcrypt.

12. ¿Cuáles son las consideraciones clave al elegir entre una base de datos relacional y una NoSQL para un caso de uso específico desde una perspectiva de modelado de datos?

Al elegir entre bases de datos relacionales y NoSQL desde una perspectiva de modelado de datos, considere varios aspectos clave. Las bases de datos relacionales sobresalen cuando la integridad y la consistencia de los datos son primordiales, lo que requiere propiedades ACID. Hacen cumplir esquemas estrictos, asegurando que los datos se ajusten a relaciones predefinidas. Los datos suelen estar normalizados para reducir la redundancia. Por lo tanto, son adecuados para casos de uso con relaciones complejas y requisitos transaccionales, como sistemas financieros.

Las bases de datos NoSQL, por otro lado, ofrecen flexibilidad y escalabilidad para manejar datos no estructurados o semiestructurados. A menudo priorizan la disponibilidad y la tolerancia a la partición sobre la consistencia fuerte (propiedades BASE). Diferentes modelos NoSQL (documento, clave-valor, gráfico, familia de columnas) se adaptan a varias estructuras de datos y patrones de acceso. Las bases de datos NoSQL son adecuadas para casos de uso que requieren alto rendimiento, desarrollo rápido y la capacidad de adaptarse a estructuras de datos en evolución, como feeds de redes sociales o datos de IoT.

13. Explique el papel de los metadatos en el modelado de datos.

Los metadatos desempeñan un papel crucial en el modelado de datos al proporcionar contexto e información sobre los propios datos. Esencialmente, describe los datos, facilitando su comprensión, gestión y utilización. Los metadatos definen características como tipos de datos, relaciones, fuentes, definiciones y reglas de negocio. Es como un diccionario de datos, que ofrece información sobre lo que representa cada elemento de datos y cómo se relaciona con otros elementos dentro del modelo.

Sin metadatos, los modelos de datos son difíciles de interpretar y mantener. Algunas formas específicas en que los metadatos apoyan el modelado de datos incluyen:

- Descubrimiento de datos: Permite a los usuarios encontrar y comprender fácilmente el propósito de los conjuntos de datos.

- Calidad de los datos: Ayuda a identificar y resolver problemas de calidad de datos a través de reglas de validación y linaje de datos.

- Gobernanza de datos: Apoya las iniciativas de gobernanza de datos al proporcionar una comprensión clara de la propiedad y las responsabilidades de los datos.

- Integración de datos: Facilita los esfuerzos de integración de datos al proporcionar una comprensión común de los formatos y estructuras de datos en diferentes sistemas.

14. ¿Cómo valida un modelo de datos para asegurar que cumple con los requisitos del negocio?

La validación de un modelo de datos con respecto a los requisitos del negocio implica varios pasos clave. Primero, colabore con las partes interesadas para comprender y documentar a fondo sus necesidades, casos de uso y expectativas de datos. Traduzca estos requisitos en criterios de validación específicos, como tipos de datos, restricciones, relaciones y reglas de calidad de datos. Las reglas de calidad de datos podrían ser cosas como asegurar que un campo no sea nulo o esté dentro de un rango específico.

A continuación, implemente comprobaciones de validación dentro del modelo de datos o las aplicaciones asociadas. Esto podría implicar el uso de restricciones de la base de datos, lógica de validación a nivel de aplicación o herramientas dedicadas a la calidad de los datos. Pruebe regularmente el modelo de datos con datos de muestra que representen escenarios del mundo real, verificando que se adhiera a los criterios definidos y gestione los casos extremos de forma adecuada. Finalmente, itere sobre el modelo de datos basándose en los comentarios y los resultados de la validación, asegurando que satisfaga continuamente las necesidades cambiantes del negocio.

15. Describa una situación en la que tuvo que llegar a un acuerdo entre los diferentes requisitos de datos de las partes interesadas.

En un proyecto reciente, nuestro equipo de marketing quería datos de actividad del sitio web muy detallados y en tiempo real para campañas publicitarias personalizadas, mientras que el equipo de ingeniería estaba preocupado por el impacto en el rendimiento de este seguimiento detallado en nuestra plataforma de comercio electrónico principal. El departamento legal también planteó preocupaciones sobre la recopilación de datos de información personal (PII) y el cumplimiento del RGPD. Para abordar esto, facilité una serie de reuniones para comprender las necesidades y limitaciones de cada equipo. Llegamos a un acuerdo mediante la implementación de fuentes de datos agregadas y casi en tiempo real que aún proporcionaban información valiosa para el marketing, minimizaban la sobrecarga de rendimiento y enmascaraban cualquier información confidencial del usuario antes de que llegara a la plataforma de marketing.

Específicamente, en lugar de rastrear cada evento de clic individual, acordamos rastrear métricas agregadas como vistas de página por sesión de usuario y categorías de productos visitadas. También implementamos un retraso de 15 minutos en la transferencia de datos y utilizamos técnicas de anonimización de datos para garantizar el cumplimiento. Este compromiso permitió a marketing mejorar la efectividad de las campañas, respetando las limitaciones técnicas y adhiriéndose a las regulaciones de privacidad de datos. Esto permitió a todos los interesados lograr un objetivo común.

16. ¿Cómo se documenta un modelo de datos para su futura mantenibilidad y comprensión?

Para documentar un modelo de datos de manera efectiva, me concentraría en crear documentación clara y completa que se adapte a diversas audiencias. Esto incluye:

- Diccionario de datos: Un repositorio central que define cada atributo/campo, su tipo de datos, restricciones (por ejemplo, nulabilidad, unicidad) y una explicación descriptiva de su propósito.

- Diagrama de relación de entidades (ERD): Una representación visual de las entidades dentro del modelo de datos y las relaciones entre ellas. Esto proporciona una visión general de alto nivel.

- Diagramas de flujo de datos (DFD): Estos son diagramas que describen cómo fluyen los datos a través del sistema, proporcionando contexto para el papel del modelo de datos en la aplicación en su conjunto.

- Documentación de la API (si corresponde): Si el modelo de datos se expone a través de una API, es esencial una documentación exhaustiva que describa los endpoints, los formatos de solicitud/respuesta y los métodos de autenticación.

- Control de versiones: Mantener un historial de versiones del modelo de datos, rastreando los cambios y su justificación a lo largo del tiempo. Esto es importante cuando el modelo de datos tiene modificaciones durante el ciclo de vida del producto. Por ejemplo, en el código, podríamos incluir una sección para rastrear los cambios:

Versión 1.0 - Modelo de datos inicial para la información del cliente.

# Versión 1.1 - Se agregó el campo 'número_de_teléfono' a la tabla 'clientes'.

- Convenciones de nomenclatura: Establecer y adherirse a convenciones de nomenclatura consistentes para tablas, columnas y relaciones. Esto promueve la legibilidad y reduce la ambigüedad.

17. ¿Cuáles son sus herramientas y técnicas preferidas para el modelado de datos y por qué?

Mis herramientas y técnicas preferidas para el modelado de datos dependen de la complejidad y el alcance del proyecto. Generalmente, comienzo con el modelado conceptual utilizando herramientas como draw.io o Lucidchart para visualizar entidades, relaciones y atributos. Para el modelado lógico y físico, prefiero usar herramientas dedicadas de modelado de bases de datos como ERwin Data Modeler o dbdiagram.io. Estas herramientas permiten la ingeniería directa e inversa, la generación de scripts DDL y la aplicación de restricciones de integridad de datos.

En cuanto a las técnicas, favorezco una combinación de modelado Entidad-Relación (ER) y modelado dimensional, especialmente para el almacenamiento de datos. El modelado ER ayuda a comprender las relaciones entre las entidades y a diseñar bases de datos normalizadas. El modelado dimensional (esquema de estrella, esquema de copo de nieve) es útil para optimizar los datos para la generación de informes y el análisis. También enfatizo la importancia de la normalización de datos para reducir la redundancia y mejorar la consistencia de los datos. Para bases de datos NoSQL, me concentro en comprender los patrones de acceso a los datos y diseñar el modelo de datos en consecuencia, favoreciendo la desnormalización cuando es apropiado para mejorar el rendimiento de lectura.

18. Explique el concepto de linaje de datos y su importancia.

El linaje de datos es esencialmente un mapa del recorrido de los datos, que rastrea su origen, transformaciones y destinos. Muestra cómo los datos se mueven a través de sistemas y procesos, proporcionando un registro claro y auditable de su ciclo de vida. Esto incluye dónde se originaron los datos, qué cambios sufrieron (transformaciones, agregaciones, etc.) y dónde se almacenan o utilizan finalmente.

La importancia del linaje de datos radica en su capacidad para mejorar la calidad de los datos, garantizar el cumplimiento y facilitar una mejor toma de decisiones. Específicamente:

- Calidad de los datos: Al comprender el recorrido de los datos, podemos identificar y corregir errores o inconsistencias introducidas durante el procesamiento.

- Cumplimiento: El linaje ayuda a cumplir con los requisitos reglamentarios al demostrar la procedencia de los datos y garantizar la responsabilidad.

- Auditoría: El linaje permite rastrear los datos hasta su origen, lo cual es crucial para la auditoría y la resolución de problemas.

- Análisis de impacto: Si se realizan cambios en una fuente de datos, el linaje ayuda a comprender el impacto posterior en otros sistemas e informes.

- Confianza: Comprender los orígenes genera confianza en la precisión de la información.

19. ¿Cómo modelaría un sistema que necesita soportar el procesamiento de datos tanto en tiempo real como por lotes?

La mejor opción es una arquitectura híbrida. Los datos en tiempo real fluirían a través de un sistema de procesamiento de flujo como Kafka/Pulsar, procesados por herramientas como Flink/Spark Streaming, y almacenados en una base de datos de baja latencia (por ejemplo, Cassandra, Redis). Los datos por lotes se procesarían periódicamente utilizando un marco como Spark/Hadoop y se almacenarían en un almacén de datos (por ejemplo, Snowflake, BigQuery).

Consideraciones clave incluyen:

- Ingesta de datos: Tuberías separadas o una tubería unificada con enrutamiento.

- Almacenamiento de datos: Elija bases de datos optimizadas para las respectivas cargas de trabajo.

- Transformación de datos: Aplique las transformaciones apropiadas para los casos de uso en tiempo real y por lotes.

- Orquestación: Herramientas como Airflow pueden gestionar trabajos de procesamiento por lotes.

- Monitoreo: Implemente un monitoreo integral para ambos sistemas.

20. ¿Cuáles son los desafíos del modelado de datos en un entorno distribuido?

El modelado de datos en un entorno distribuido introduce complejidades que no se encuentran típicamente en los sistemas centralizados. Un desafío significativo es mantener la consistencia de los datos en múltiples nodos. A medida que los datos se distribuyen en diferentes máquinas, asegurar que todos los nodos tengan la información más actualizada y precisa se vuelve difícil, lo que podría generar conflictos e inconsistencias en los datos. Diferentes nodos podrían tener interpretaciones o representaciones variables de los mismos datos, y la latencia de la red puede exacerbar estos problemas.

Otro desafío es la gestión de la partición y distribución de datos. Determinar la forma óptima de dividir y distribuir los datos entre los nodos para maximizar el rendimiento de las consultas y minimizar la transferencia de datos es crucial. Esto a menudo implica considerar factores como la localidad de los datos, la replicación de datos y los patrones de consulta específicos de la aplicación. Una partición de datos incorrecta puede provocar cuellos de botella en el rendimiento, un aumento del tráfico de red y dificultades para realizar operaciones de unión en conjuntos de datos distribuidos.

21. Describe cómo abordaría el modelado de datos de series temporales.

Al abordar el modelado de datos de series temporales, comenzaría por visualizar los datos para comprender sus características, como la tendencia, la estacionalidad y la estacionariedad. Luego realizaría un análisis de datos exploratorio (EDA), incluyendo pruebas estadísticas como la prueba de Dickey-Fuller aumentada (ADF) para evaluar la estacionariedad. Si los datos no son estacionarios, aplicaría diferencias o transformaciones para lograr la estacionariedad.

Luego, elegiría un modelo adecuado. Para series temporales simples, los modelos ARIMA son un buen punto de partida. Si hay estacionalidad presente, los modelos SARIMA son más apropiados. Para patrones complejos, podría considerar modelos de aprendizaje automático como LSTMs o Prophet. La evaluación del modelo implica el uso de métricas como el Error Cuadrático Medio (MSE), la Raíz del Error Cuadrático Medio (RMSE) o el Error Absoluto Medio (MAE) en un conjunto de datos de retención. Finalmente, el ajuste del modelo se realizaría mediante validación cruzada.

22. ¿Cómo se manejan los datos faltantes o incompletos en un modelo de datos?

Manejar datos faltantes o incompletos es una parte crucial de la modelización de datos. Se pueden emplear varias estrategias, y el mejor enfoque depende del contexto específico y del impacto en el análisis de datos.

Las estrategias comunes incluyen:

- Imputación: Reemplazar los valores faltantes con valores estimados (por ejemplo, media, mediana, moda o el uso de modelos de aprendizaje automático más avanzados).

- Eliminación: Eliminar filas o columnas con datos faltantes (usar con precaución, ya que puede provocar pérdida de datos).

- Creación de una nueva categoría: Introducir una nueva categoría para representar explícitamente los valores faltantes. Esto es útil cuando la ausencia de datos en sí misma es informativa.

- Uso de algoritmos que manejan datos faltantes: Algunos algoritmos pueden manejar inherentemente los valores faltantes sin requerir imputación o eliminación.

- Validación de datos: Implementar reglas de validación de datos en el punto de entrada para evitar que se agreguen datos incompletos en primer lugar.

23. Explique la diferencia entre un modelo de datos conceptual, lógico y físico.

Los modelos de datos conceptual, lógico y físico representan diferentes niveles de abstracción en el diseño de bases de datos. El modelo conceptual proporciona una vista de alto nivel orientada al negocio, centrándose en qué datos son importantes y las relaciones entre las entidades de datos. Es independiente de la tecnología y a menudo se representa utilizando diagramas entidad-relación (ERD) que son fáciles de entender para las partes interesadas.

El modelo lógico refina el modelo conceptual definiendo los elementos de datos, sus tipos de datos y las relaciones con más detalle. Todavía permanece independiente de los sistemas de gestión de bases de datos (SGBD) específicos, pero prepara el modelo para la implementación. Las claves (primaria, foránea) suelen definirse en esta etapa. El modelo físico representa la implementación del modelo de datos en un SGBD específico. Incluye estructuras de tabla, tipos de datos, índices, restricciones y otros detalles específicos del SGBD. Este modelo define cómo se almacenan y acceden físicamente a los datos.

24. ¿Cómo modelarías una estructura de datos jerárquica en una base de datos relacional?

Una estructura de datos jerárquica se puede modelar en una base de datos relacional utilizando varios enfoques. El más común es el modelo de lista de adyacencia. Esto implica tener una tabla con una columna parent_id que hace referencia al id de otro registro en la misma tabla. El nodo raíz tendría un valor NULL en la columna parent_id.

Otras opciones incluyen el modelo de enumeración de ruta, donde cada nodo almacena la ruta completa a la raíz. El modelo de conjunto anidado utiliza valores numéricos para representar la jerarquía, lo que permite una recuperación eficiente de los descendientes, pero hace que las modificaciones sean complejas. Finalmente, una tabla de cierre almacena explícitamente todas las relaciones ancestro-descendiente, ofreciendo consultas rápidas de ancestros/descendientes a costa de un mayor almacenamiento y complejidad de inserción/actualización. Ejemplo de SQL para lista de adyacencia:

CREATE TABLE categories ( id INT PRIMARY KEY, name VARCHAR(255), parent_id INT, FOREIGN KEY (parent_id) REFERENCES categories(id) );

25. ¿Cuáles son algunas técnicas para optimizar un modelo de datos para el rendimiento de las consultas?

Varias técnicas pueden optimizar un modelo de datos para un rendimiento de consulta más rápido. La normalización reduce la redundancia, pero la desnormalización, que introduce cierta redundancia, puede acelerar las lecturas al reducir la necesidad de uniones. La indexación de las columnas clave mejora significativamente la velocidad de la consulta al permitir que la base de datos localice rápidamente las filas relevantes.

Otras aproximaciones incluyen la partición de tablas grandes en piezas más pequeñas y manejables. Considere el uso de tablas de resumen (vistas materializadas) para precalcular agregaciones, evitando cálculos costosos durante las consultas. La optimización de los tipos de datos (por ejemplo, usar INT en lugar de VARCHAR para los ID numéricos) también puede reducir el espacio de almacenamiento y mejorar la velocidad de comparación. Finalmente, analice los planes de ejecución de consultas regularmente para identificar y abordar los cuellos de botella de rendimiento.

26. Describa una situación en la que tuvo que integrar datos de múltiples fuentes dispares en un único modelo de datos.

En un puesto anterior, trabajé en un proyecto para consolidar datos de clientes de nuestro CRM, plataforma de automatización de marketing y sistema de comercio electrónico en una vista unificada del cliente. Cada sistema tenía sus propias estructuras de datos e identificadores. Para lograr esto, primero perfilamos los datos en cada sistema para comprender los tipos de datos, la calidad y las relaciones. Luego, definimos un modelo de datos común que pudiera representar los atributos y comportamientos clave del cliente.

El proceso de integración implicó extraer datos de cada fuente, transformarlos para que se ajustaran al modelo de datos común (por ejemplo, estandarizando formatos de direcciones, mapeando IDs de productos) y luego cargarlos en un almacén de datos central. Usamos Python y Pandas para el proceso ETL. La deduplicación de datos fue un desafío importante, por lo que implementamos algoritmos de coincidencia difusa (como la distancia de Levenshtein) para identificar y fusionar registros de clientes duplicados basados en direcciones de correo electrónico, nombres y direcciones físicas. La salida final fue una vista única del cliente que permitió un marketing y un servicio al cliente más efectivos.

27. Explique el teorema CAP y su relevancia para las elecciones de modelado de datos.

El teorema CAP establece que es imposible que un almacén de datos distribuido garantice simultáneamente los tres siguientes: Consistencia (todos los nodos ven los mismos datos al mismo tiempo), Disponibilidad (cada solicitud recibe una respuesta, sin garantía de que contenga la versión más reciente de la información) y Tolerancia a particiones (el sistema continúa operando a pesar de particiones arbitrarias debido a fallas de la red). En esencia, solo puede elegir dos de tres.

Al diseñar modelos de datos, debe considerar las implicaciones del teorema CAP. Si la alta disponibilidad es crítica (sistema AP), podría elegir un modelo de datos que permita la consistencia eventual (por ejemplo, utilizando técnicas como el bloqueo optimista o la resolución de conflictos). Si la consistencia fuerte es primordial (sistema CP), podría sacrificar algo de disponibilidad durante las particiones de red, asegurando la integridad de los datos. La elección impacta en las opciones de modelado de datos, como las estrategias de replicación de datos, los modelos de transacción y los mecanismos de resolución de conflictos. Los modelos de datos para sistemas CA son posibles en configuraciones no distribuidas.

Preguntas de entrevista sobre modelado de datos avanzado

1. ¿Cómo modelaría los datos para una red social donde los usuarios pueden seguirse entre sí y crear publicaciones con diferentes configuraciones de privacidad?

Podemos modelar los datos usando varias entidades: Usuarios, Publicaciones y Seguidos.

- Usuarios: Cada usuario tendría un ID único, información de perfil (nombre, biografía, etc.) y credenciales de seguridad. Podemos almacenar esto en una tabla

usuarioscon columnas comouser_id,nombre_usuario,correo_electronico,datos_perfil(blob JSON). - Publicaciones: Cada publicación tendría un ID único, el ID de usuario del autor, el contenido de la publicación, una marca de tiempo y una configuración de privacidad. Las configuraciones de privacidad podrían ser una enum (

publico,amigos,solo_yo). Una tablapublicacionestendría columnas comopost_id,user_id,contenido,timestamp,privacidad. - Seguimientos: Esta entidad modela la relación seguidor-seguido. Una tabla

seguimientostendríafollower_idyfollowee_id, representando un borde dirigido en el gráfico social.follower_idsigue afollowee_id.

Las consultas implicarían unir estas tablas. Por ejemplo, para obtener el feed de un usuario, seleccionaríamos las publicaciones donde user_id está en el conjunto de IDs que el usuario sigue, o donde la publicación es pública, o donde la publicación está marcada como 'amigos' y los dos usuarios son amigos. La amistad se puede derivar de la tabla de seguimientos verificando bordes bidireccionales.

2. Imagine que está diseñando un modelo de datos para una plataforma de comercio electrónico con millones de productos y reglas de precios complejas. ¿Cómo manejaría las variaciones del producto (tamaño, color) y los precios dinámicos?

Para las variaciones de producto, usaría una combinación de una tabla principal Producto y una tabla VarianteProducto. Producto almacena información general (nombre, descripción), mientras que VarianteProducto contiene datos específicos de la variación (tamaño, color, SKU, precio). La tabla VarianteProducto tendría una clave externa que hace referencia a la tabla Producto, creando una relación de uno a muchos. Los atributos específicos de un producto se gestionarán en otra tabla a la que se hace referencia en la tabla Producto. Los atributos pueden ser cosas como color, tamaño, etc. Los precios dinámicos podrían implementarse utilizando una tabla ReglaDePrecio. Esta tabla define reglas basadas en varios factores (hora del día, segmento de cliente, cantidad comprada). Cada regla especificaría un ajuste de precio (porcentaje o cantidad fija). Un servicio evaluaría estas reglas en tiempo de ejecución para determinar el precio final. La tabla VarianteProducto puede tener un campo que indique si se aplica el precio dinámico.

- La tabla

Productoalmacenaría información general, y VarianteProductoalmacena información sobre variaciones como precio, tamaño, peso, SKU, etc.

3. Describe su enfoque para modelar datos de series temporales para un sistema que rastrea el tráfico del sitio web, considerando tanto el análisis en tiempo real como el histórico.

Mi enfoque implica el uso de una combinación de técnicas dependiendo de los requisitos específicos del análisis en tiempo real e histórico. Para el monitoreo del tráfico en tiempo real, probablemente usaría el procesamiento de datos en streaming con herramientas como Apache Kafka o Kinesis para ingerir datos y bases de datos de series temporales como InfluxDB o TimescaleDB para almacenar y consultar los datos de manera eficiente. Las métricas se calcularían y visualizarían en tiempo real utilizando paneles. Se podrían utilizar algoritmos como el Suavizado Exponencial o ARIMA para la detección de anomalías, con el fin de identificar picos o caídas repentinas en el tráfico.

Para el análisis histórico, aprovecharía los datos almacenados en la base de datos de series temporales o, posiblemente, los trasladaría a un almacén de datos como Snowflake o BigQuery para el almacenamiento a largo plazo y el análisis complejo. Se podrían emplear modelos de series temporales más sofisticados como Prophet o modelos de aprendizaje profundo (por ejemplo, LSTM) para pronosticar patrones de tráfico futuros, identificar tendencias y realizar análisis de causa raíz de eventos pasados. La ingeniería de características sería crucial, incorporando elementos como la estacionalidad, el día de la semana y los días festivos para mejorar la precisión del modelo.

4. ¿Cómo diseñaría un modelo de datos para un motor de recomendación que sugiere productos a los usuarios en función de sus compras y su historial de navegación?

Un modelo de datos para un motor de recomendación podría incluir estas entidades clave:

- Usuarios:

user_id(INT, clave primaria),user_profile(JSON - información demográfica, preferencias). - Productos:

product_id(INT, clave primaria),product_name(VARCHAR),categoría(VARCHAR),precio(DECIMAL),product_attributes(JSON - color, tamaño, etc.). - Compras:

purchase_id(INT, clave primaria),user_id(INT, clave foránea que hace referencia a Usuarios),product_id(INT, clave foránea que hace referencia a Productos),purchase_date(TIMESTAMP),cantidad(INT). - Historial de Navegación:

session_id(INT, clave primaria),user_id(INT, clave foránea que hace referencia a Usuarios),product_id(INT, clave foránea que hace referencia a Productos),timestamp(TIMESTAMP). - Interacciones con Productos:

interaction_id(INT, clave primaria),user_id(INT, clave foránea que hace referencia a Usuarios),product_id(INT, clave foránea que hace referencia a Productos),interaction_type(ENUM - vista, agregar_al_carrito, lista_de_deseos),timestamp(TIMESTAMP).

Esta estructura captura información del usuario, detalles del producto, historial de compras, comportamiento de navegación y otras interacciones. Los campos user_profile y product_attributes utilizan JSON para permitir el almacenamiento de datos flexible y extensible. Las relaciones se mantienen mediante claves externas, lo que permite consultas eficientes para algoritmos de recomendación.

5. Digamos que necesita modelar datos para un sistema de gestión de la cadena de suministro. ¿Qué entidades, atributos y relaciones consideraría?

Las entidades incluirían: Proveedores, Productos, Clientes, Pedidos, Envíos, Almacenes. Proveedores tendrían atributos como nombre, dirección, información de contacto y tiempo de entrega. Productos podrían tener nombre, descripción, SKU, precio y peso. Clientes tienen nombre, dirección y datos de contacto. Pedidos tienen fecha del pedido, número del pedido, ID del cliente y monto total. Envíos podrían tener ID del envío, fecha de envío, fecha de entrega esperada y número de seguimiento. Almacenes tendrían ubicación, capacidad e información de contacto.

Las relaciones incluyen: Proveedores suministran Productos (uno a muchos), Clientes realizan Pedidos (uno a muchos), Pedidos contienen Productos (muchos a muchos, a menudo representados por una tabla order_item), Pedidos generan Envíos (uno a muchos), y Envíos se originan en Almacenes (uno a muchos), y Productos se almacenan en Almacenes (muchos a muchos).

6. Diseñe un modelo de datos para el sistema de registro de salud electrónico de un hospital, considerando la necesidad de almacenar datos demográficos del paciente, historial médico y planes de tratamiento.

Un modelo de datos básico de EHR podría incluir varias entidades clave. Paciente almacenaría datos demográficos (nombre, dirección, fecha de nacimiento, información de contacto), con una clave primaria patient_id. HistorialMédico rastrearía condiciones, alergias e inmunizaciones, vinculado a Paciente a través de patient_id. Encuentro representa una visita e incluye fecha/hora, motivo y médico tratante. Diagnóstico vincula Encuentro a un sistema de codificación médica estándar (por ejemplo, ICD-10). PlanDeTratamiento detalla las prescripciones, terapias y citas de seguimiento, también vinculado a Encuentro. Medicamento almacena información sobre los medicamentos, incluyendo la dosis y la frecuencia. Todos los datos se relacionan con los pacientes.

Para la integridad de los datos y las relaciones, se definirían las claves primarias y foráneas. Los tipos de datos específicos (por ejemplo, fechas, cadenas de texto, números enteros) se elegirían apropiadamente para cada atributo para asegurar la exactitud y consistencia de los datos. El sistema se puede extender aún más para almacenar resultados de laboratorio, informes de radiología, información de facturación, etc.

7. Estás construyendo un modelo de datos para un sistema que rastrea transacciones financieras. ¿Cómo asegurarías la integridad de los datos y prevenirías el fraude?

Para garantizar la integridad de los datos y prevenir el fraude en un sistema de transacciones financieras, implementaría varias medidas. La integridad de los datos se garantizaría mediante: validación de datos (verificando tipos de datos, formatos y rangos), restricciones de la base de datos (claves primarias, claves foráneas, restricciones únicas, restricciones no nulas) y gestión de transacciones (propiedades ACID). La prevención del fraude implicaría: detección de anomalías (identificando patrones de transacciones inusuales), sistemas basados en reglas (marcando transacciones basadas en reglas predefinidas), autenticación de múltiples factores y cifrado de datos confidenciales, como los números de cuenta.

8. ¿Cómo modelaría los datos para un sistema que gestiona la autenticación y autorización de usuarios en múltiples aplicaciones?

Modelaría los datos con tablas para Usuarios, Aplicaciones, Roles y Permisos, y tablas para gestionar las relaciones entre ellas. La tabla Usuarios almacenaría las credenciales de usuario e información básica. La tabla Aplicaciones enumeraría todas las aplicaciones integradas con el sistema de autenticación. Los Roles definirían conjuntos de permisos, y los Permisos representarían acciones específicas que un usuario puede realizar. Tablas como UserRoles (vinculando usuarios a roles) y RolePermissions (vinculando roles a permisos) establecerían la lógica de autorización. Además, una tabla ApplicationPermissions que vincule la aplicación a los permisos permitidos, puede permitir un control granular sobre las acciones permitidas dentro de la aplicación.

Para gestionar la autenticación en múltiples aplicaciones, se podría utilizar una tabla central Sesiones que almacene tokens de sesión, IDs de usuario e IDs de aplicación. Esto permite el seguimiento de las sesiones de usuario activas por aplicación. Para manejar los permisos específicos de la aplicación, la tabla RolesAplicación permite definir roles que son específicos de la aplicación, evitando así la contaminación del espacio de nombres global. Aquí hay un ejemplo:

CREATE TABLE RolesUsuario ( user_id UUID, role_id UUID, application_id UUID NULLABLE -- Contexto de aplicación específico o rol global PRIMARY KEY (user_id, role_id, application_id) );

9. Describa su enfoque para modelar datos para un sistema que almacena información geográfica, como ubicaciones de negocios o puntos de interés.

Mi enfoque para modelar datos para un sistema de información geográfica (SIG) implica el uso de una base de datos espacial, como PostGIS (extensión de PostgreSQL) o GeoPackage. Representaría las ubicaciones como tipos de datos geométricos (por ejemplo, POINT, POLYGON) con un identificador de referencia espacial (SRID) para asegurar la correcta interpretación del sistema de coordenadas. Los atributos para negocios o puntos de interés (nombre, dirección, tipo, etc.) se almacenarían como columnas regulares de la base de datos. Los índices espaciales son cruciales para las consultas eficientes, por lo que crearía índices en la columna de geometría.

Por ejemplo, considere una tabla negocios:

CREATE TABLE negocios ( id SERIAL PRIMARY KEY, nombre VARCHAR(255), dirección VARCHAR(255), tipo VARCHAR(50), ubicación GEOGRAPHY(Point, 4326) ); CREATE INDEX negocios_ubicacion_idx ON negocios USING GIST (ubicación);

Esto permite consultas espaciales eficientes como encontrar negocios a una cierta distancia de un punto dado. El tipo GEOGRAPHY maneja automáticamente los cálculos esféricos, y SRID 4326 representa WGS 84, un sistema de coordenadas geográficas común.

10. Imagine que está diseñando un modelo de datos para un sistema que gestiona proyectos y tareas, considerando las dependencias entre las tareas y la asignación de recursos.

Un buen modelo de datos incluiría tablas de Proyectos, Tareas, Recursos y Dependencias. Proyectos tendría detalles del proyecto (ID, nombre, descripción, estado). Tareas almacenaría detalles de las tareas (ID, ID del proyecto, nombre, descripción, estado, ID del recurso asignado). Recursos almacena información de recursos (ID, nombre, tipo, disponibilidad). Dependencias vincula tareas (ID, ID de la tarea predecesora, ID de la tarea sucesora, tipo de dependencia) permitiendo la representación de las relaciones. La asignación de recursos se gestionaría vinculando Tareas a Recursos a través del ID del recurso asignado en la tabla Tareas.

Las consideraciones clave incluyen tipos de datos (enteros para IDs, cadenas para nombres/descripciones, fechas para plazos), indexación para el rendimiento (especialmente en columnas de clave externa) y relaciones entre tablas (uno a muchos para proyecto-tareas, tarea-recurso). Una base de datos relacional (por ejemplo, PostgreSQL, MySQL) sería adecuada para esta estructura. El uso de claves externas garantiza la integridad de los datos y facilita las consultas eficientes.

11. ¿Cómo manejaría el modelado de datos para un sistema que gestiona versiones de documentos?

Modelaría los datos con una entidad central Documento que contenga metadatos (título, autor, etc.) y una relación uno a muchos con una entidad VersiónDocumento. Cada VersiónDocumento almacenaría el contenido, el número de versión y la marca de tiempo. Usaría una base de datos relacional, quizás con una tabla versiones que contenga:

document_id(clave foránea a la tabladocuments)version_number(entero, incrementando)content(texto o blob)created_at(marca de tiempo)

Esto permite la recuperación eficiente de versiones específicas o la última versión, y permite rastrear fácilmente el historial del documento. También se podrían implementar optimizaciones como la diferenciación de contenido entre versiones para reducir el almacenamiento.

12. Imagine que se le pide que diseñe un modelo de datos que gestione la reserva de vuelos. ¿Cuáles son algunos requisitos complejos que querría considerar?

Algunos requisitos complejos para un modelo de datos de reserva de vuelos incluirían la gestión de vuelos de varias escalas (con escalas y posibles aerolíneas diferentes), la gestión de clases de tarifas y la disponibilidad en diferentes vuelos y fechas (incluyendo precios dinámicos), y el tratamiento de servicios complementarios como equipaje, selección de asientos y comidas. También es fundamental modelar reglas y restricciones de enrutamiento complejas impuestas por las aerolíneas, como los tiempos máximos de conexión o combinaciones específicas de aeropuertos. Otras consideraciones incluyen la representación precisa de las reglas de tarifas (por ejemplo, cargos por cambio, políticas de cancelación), la integración con sistemas externos para actualizaciones del estado de los vuelos en tiempo real y la garantía de la coherencia de los datos en diferentes sistemas al reservar vuelos.

13. ¿Cuándo usarías un modelo entidad-atributo-valor (EAV) y cuáles son sus ventajas y desventajas?

Un modelo entidad-atributo-valor (EAV) es útil cuando necesitas almacenar datos donde los atributos no se conocen de antemano, son dispersos o varían significativamente entre las entidades. Imagina un sistema donde estás recopilando mediciones científicas muy variables o rastreando propiedades de elementos con un conjunto de características muy abierto. EAV te permite agregar nuevos atributos sin alterar el esquema de la base de datos.

Sin embargo, los modelos EAV introducen ventajas y desventajas. Consultar datos EAV puede ser complejo e ineficiente, a menudo requiriendo múltiples uniones (joins) para recuperar el conjunto completo de atributos de una sola entidad. Esto puede generar problemas de rendimiento, especialmente con conjuntos de datos grandes. Además, la validación e integridad de los datos pueden ser más difíciles de aplicar en comparación con un modelo relacional tradicional, y cosas simples como la creación de índices para atributos específicos se vuelve más difícil. Considera si la flexibilidad supera los costos de rendimiento y complejidad.

14. Explique cómo modelaría datos jerárquicos, como un organigrama o la estructura de directorios de un sistema de archivos.

Los datos jerárquicos, como los organigramas o los sistemas de archivos, se pueden modelar utilizando algunos enfoques diferentes. Un método común y sencillo es utilizar el modelo de lista de adyacencia. En este modelo, cada nodo en la jerarquía almacena una referencia directa (generalmente una clave externa) a su nodo padre. Por ejemplo, en un sistema de archivos, cada directorio tendría un parent_directory_id que apunta a su padre. El nodo raíz tiene un NULL o un valor especial en la columna de ID del padre.

Alternativamente, para escenarios que requieren la recuperación eficiente de un subárbol completo, se podría preferir el modelo de conjunto anidado o el modelo de ruta materializada. Los conjuntos anidados utilizan dos números para representar la posición de cada nodo en la jerarquía (valores izquierdo y derecho), lo que permite la selección de subárboles con una consulta de rango simple. Las rutas materializadas almacenan la ruta completa desde la raíz hasta el nodo como una cadena, lo que facilita las consultas basadas en rutas. Por ejemplo, la ruta de un archivo /home/usuario/documentos/informe.pdf se almacenaría directamente. La elección depende del caso de uso específico y la frecuencia de diferentes tipos de consultas.

15. Digamos que está diseñando un modelo para un sistema de gestión de contenidos (CMS). ¿Cuáles son los diferentes roles de usuario?

Los diferentes roles de usuario en un CMS pueden incluir:

- Administrador: Tiene control total sobre el CMS, incluyendo la gestión de usuarios, la configuración del sistema y la gestión de contenido.

- Editor: Puede crear, editar y publicar contenido. Puede tener restricciones en la publicación en secciones específicas o acceso a la configuración del sistema.

- Autor: Puede crear y enviar contenido para revisión, pero no puede publicarlo directamente.

- Colaborador: Puede agregar contenido, pero no tiene permiso para publicar o editar contenido existente.

- Visualizador/Suscriptor: Solo puede ver el contenido, posiblemente con acceso restringido según el nivel de suscripción.

16. ¿Cómo aborda el modelado de datos en un entorno ágil, donde los requisitos cambian constantemente?