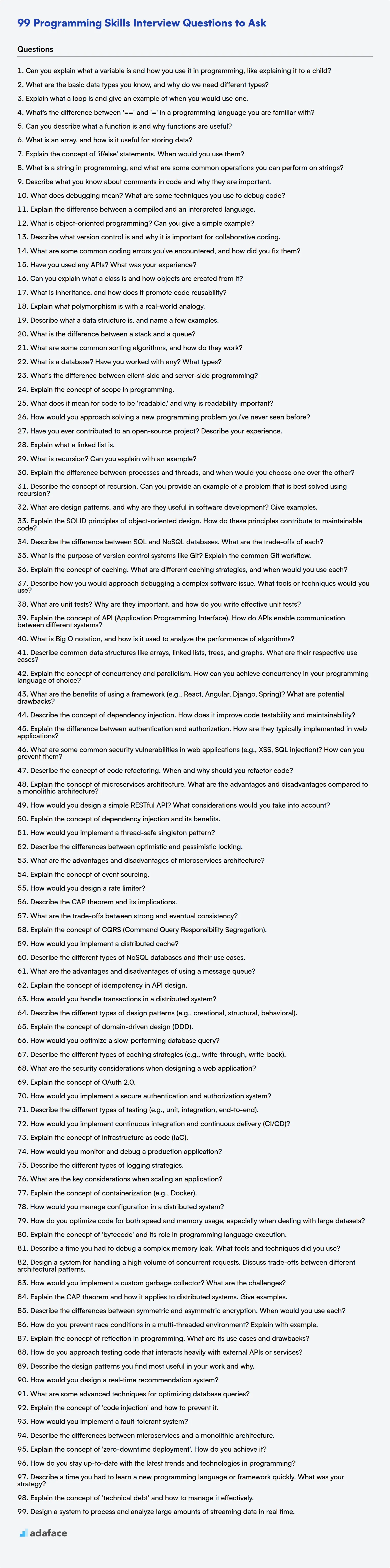

99 Preguntas de Entrevista de Habilidades de Programación para Hacer

Evaluar las habilidades de programación durante las entrevistas puede ser una tarea desalentadora, especialmente con el panorama tecnológico en constante evolución; es difícil saber por dónde empezar. Requiere una planificación cuidadosa y las preguntas correctas para diferenciar a los candidatos fuertes de aquellos que solo hablan.

Esta publicación de blog proporciona una colección estructurada de preguntas de entrevista de programación, categorizadas por nivel de dificultad, que van desde básico hasta experto, junto con preguntas de opción múltiple (MCQ). Las preguntas están diseñadas para evaluar la comprensión de un candidato de los conceptos fundamentales, la resolución de problemas y las habilidades de codificación, de manera muy similar a las que se evalúan en nuestro artículo sobre habilidades requeridas para un desarrollador de software.

Al usar estas preguntas, puede identificar a los candidatos que no solo poseen el conocimiento teórico sino que también pueden aplicarlo de manera efectiva en escenarios del mundo real y si necesita agilizar esto, considere usar las evaluaciones en línea de Adaface para evaluar a los candidatos antes de la entrevista.

Tabla de contenidos

Preguntas de entrevista sobre habilidades básicas de programación

Preguntas de entrevista sobre habilidades intermedias de programación

Preguntas de entrevista sobre habilidades avanzadas de programación

Preguntas de entrevista sobre habilidades de experto en programación

MCQ de habilidades de programación

¿Qué habilidades de programación debe evaluar durante la fase de entrevista?

3 consejos para maximizar sus preguntas de entrevista sobre habilidades de programación

Optimice la contratación con evaluaciones de programación específicas

Descargue la plantilla de preguntas de la entrevista de Habilidades de Programación en múltiples formatos

Preguntas de la entrevista de Habilidades de Programación Básicas

1. ¿Puedes explicar qué es una variable y cómo la usas en programación, como si se lo explicaras a un niño?

Imagina que una variable es como una caja etiquetada. Puedes meter cosas dentro de la caja, y la etiqueta te dice qué hay dentro. En programación, una variable es un nombre que le damos a un lugar en la memoria de la computadora donde podemos guardar información, como números, palabras o listas. Podemos usar el nombre para recuperar la información más tarde.

Por ejemplo, podríamos tener una variable llamada edad:

edad = 10 print(edad) # Esto imprimirá 10

Aquí, edad es la etiqueta de la caja, y 10 es la información que metemos dentro. Podemos cambiar lo que hay dentro de la caja más tarde si queremos. Entonces, las variables nos permiten almacenar y recordar cosas en nuestros programas.

2. ¿Cuáles son los tipos de datos básicos que conoces y por qué necesitamos diferentes tipos?

Los tipos de datos básicos incluyen:

- Entero: Números enteros (por ejemplo, 10, -5, 0).

- Flotante/Doble: Números con decimales (por ejemplo, 3.14, -2.5).

- Booleano: Representa valores de verdad (verdadero o falso).

- Carácter: Letras individuales, símbolos o dígitos (por ejemplo, 'a', '$', '7').

- Cadena: Secuencia de caracteres (por ejemplo, "Hola", "Mundo").

Necesitamos diferentes tipos de datos porque nos permiten representar varios tipos de información de manera eficiente y precisa en un programa. Cada tipo ocupa una cantidad diferente de memoria y admite diferentes operaciones. Usar el tipo de datos correcto asegura la integridad de los datos, el uso optimizado de la memoria y permite que el compilador o intérprete realice las operaciones apropiadas en los datos. Por ejemplo, se puede realizar aritmética con int y float, pero no con string, mientras que se puede concatenar string, pero no int.

3. Explique qué es un bucle y dé un ejemplo de cuándo usaría uno.

Un bucle es una construcción de programación que permite que un bloque de código se ejecute repetidamente. El código dentro del bucle continúa ejecutándose siempre que se cumpla una determinada condición. Hay diferentes tipos de bucles, como los bucles for, los bucles while y los bucles do...while, cada uno adecuado para diferentes situaciones.

Por ejemplo, usaría un bucle para iterar a través de los elementos de una matriz, procesando cada elemento a su vez. En Python:

my_array = [1, 2, 3, 4, 5] for element in my_array: print(element)

Este código imprimiría cada número en my_array en la consola. Los bucles son fundamentales para automatizar tareas repetitivas.

4. ¿Cuál es la diferencia entre '==' y '=' en un lenguaje de programación con el que esté familiarizado?

En la mayoría de los lenguajes de programación, == es el operador de igualdad, mientras que = es el operador de asignación. == compara dos valores para ver si son iguales, devolviendo un resultado booleano (verdadero o falso). Por ejemplo, x == y verifica si el valor de x es igual al valor de y.

Por otro lado, = asigna un valor a una variable. Por ejemplo, x = 5 asigna el valor 5 a la variable x. No realiza una comparación; cambia el valor almacenado en la variable del lado izquierdo.

5. ¿Puedes describir qué es una función y por qué las funciones son útiles?

Una función es un bloque de código reutilizable que realiza una tarea específica. Toma entradas (argumentos), las procesa y, a menudo, devuelve una salida. Piensa en ello como un mini-programa dentro de un programa más grande. Ejemplo en Python:

def add(x, y): return x + y

Las funciones son útiles por varias razones. Promueven la reutilización del código, evitando la repetición. Mejoran la organización y la legibilidad del código al dividir problemas complejos en partes más pequeñas y manejables. También facilitan las pruebas y la depuración, ya que se pueden aislar y probar funciones individuales. Finalmente, permiten la modularidad, lo que permite reutilizar fácilmente funciones en diferentes partes de su programa o incluso en otros proyectos.

6. ¿Qué es un array y cómo es útil para almacenar datos?

Un array es una estructura de datos que almacena una colección de elementos del mismo tipo de datos en ubicaciones de memoria contiguas. Es como una lista numerada, donde se puede acceder a cada elemento utilizando su índice (posición) a partir de 0.

Los arrays son útiles para almacenar y administrar datos cuando necesita acceder a elementos rápidamente en función de su posición. Algunos ejemplos incluyen:

- Almacenamiento de una lista de nombres de estudiantes.

- Representación de una matriz de números.

- Implementación de algoritmos que requieren acceso frecuente a elementos por índice (por ejemplo, algoritmos de clasificación).

int numbers[5] = {10, 20, 30, 40, 50}; // Ejemplo en C++

7. Explica el concepto de sentencias 'if/else'. ¿Cuándo las usarías?

Una declaración if/else es una estructura de control de flujo fundamental en programación. Permite ejecutar diferentes bloques de código según si una condición es verdadera o falsa. La parte if especifica una condición. Si esa condición es verdadera, se ejecuta el bloque de código asociado con la declaración if. Si la condición es falsa, se ejecuta el bloque de código asociado con la declaración else (si está presente).

Usarías las declaraciones if/else siempre que necesites que tu programa tome decisiones basadas en diferentes condiciones. Por ejemplo, para verificar si un usuario ha ingresado credenciales válidas, para realizar diferentes acciones según el rol del usuario o para manejar diferentes escenarios según los datos de entrada. Aquí tienes un ejemplo simple:

if x > 10: print("x es mayor que 10") else: print("x no es mayor que 10")

8. ¿Qué es una cadena en programación y cuáles son algunas operaciones comunes que puedes realizar con cadenas?

En programación, una cadena es una secuencia de caracteres, típicamente utilizada para representar texto. Las cadenas son a menudo inmutables, lo que significa que sus valores no se pueden cambiar después de la creación. Son un tipo de dato fundamental en la mayoría de los lenguajes de programación.

Las operaciones comunes realizadas en cadenas incluyen:

- Concatenación: Combinar dos o más cadenas (por ejemplo,

'hola' + ' mundo'resulta en'hola mundo') - Subcadenas: Extraer una porción de una cadena (por ejemplo,

'hola'[0:2]resulta en'ho') - Longitud: Determinar el número de caracteres en una cadena (por ejemplo,

len('hola')devuelve4) - Búsqueda: Encontrar el índice de una subcadena dentro de una cadena (por ejemplo,

'hola'.find('la')devuelve2) - Reemplazo: Reemplazar una subcadena con otra cadena (por ejemplo,

'hola'.replace('l', 'x')resulta en'hoxa') - Conversión de mayúsculas/minúsculas: Convertir una cadena a mayúsculas o minúsculas (por ejemplo,

'hola'.upper()resulta en'HOLA') - Recorte: Eliminar espacios en blanco iniciales o finales (por ejemplo,

' hola '.strip()resulta en'hola') - División: Dividir una cadena en una lista de subcadenas basada en un delimitador (por ejemplo,

'hola mundo'.split(' ')resulta en['hola', 'mundo'])

9. Describa lo que sabe sobre los comentarios en el código y por qué son importantes.

Los comentarios en el código son notas explicativas agregadas al código fuente, pero son ignoradas por el compilador o intérprete. Sirven como documentación, ayudando a los desarrolladores (incluyéndote a ti mismo en el futuro) a comprender el propósito, la funcionalidad y la lógica de secciones de código específicas.

Los comentarios son importantes por varias razones:

- Legibilidad mejorada: Hacen que el código sea más fácil de entender, especialmente los algoritmos complejos o la lógica intrincada.

- Mantenimiento: Simplifican la depuración y las modificaciones, ya que los desarrolladores pueden comprender rápidamente la intención del código.

- Colaboración: Facilitan el trabajo en equipo al permitir que los desarrolladores compartan conocimientos y contexto sobre el código.

- Documentación: Sirven como una forma de documentación interna que explica qué hace el código, por qué se escribió de esa manera y cómo usarlo. Ejemplo:

Esta función calcula el área de un rectángulo

def calcular_area(longitud, anchura):

return longitud * anchura

10. ¿Qué significa depurar (debugging)? ¿Qué técnicas utilizas para depurar código?

Depurar (Debugging) es el proceso de identificar y solucionar errores (bugs) en el código de software. Implica localizar, analizar y corregir sistemáticamente el código defectuoso para asegurar que el programa funcione como se espera.

Algunas técnicas que utilizo para depurar incluyen:

- Sentencias de impresión/registro (logging): Insertar sentencias

printologpara mostrar los valores de las variables y el flujo de ejecución del código. - Depuradores (Debuggers): Utilizar depuradores interactivos como

pdb(Python),gdb(C/C++) o depuradores de IDE para recorrer el código paso a paso, inspeccionar variables y establecer puntos de interrupción (breakpoints). - Revisión de código: Pedir a los colegas que revisen el código para identificar posibles errores.

- Pruebas unitarias: Escribir y ejecutar pruebas unitarias para aislar y probar componentes individuales del código.

- Reproducir el error: Comprender cómo ocurre el error e intentar recrearlo de manera consistente.

- Usar control de versiones:

git bisectse puede utilizar para encontrar la confirmación (commit) que introdujo el error. - Leer mensajes de error: Analizar cuidadosamente los mensajes de error, los seguimientos de pila (stack traces) y los registros para comprender la naturaleza y la ubicación del problema.

11. Explique la diferencia entre un lenguaje compilado y uno interpretado.

Los lenguajes compilados, como C++ o Java, se traducen directamente a código de máquina por un compilador antes de la ejecución. Esto crea un archivo ejecutable independiente. Debido a que el código se pre-traduce, los programas compilados generalmente se ejecutan más rápido. Los lenguajes interpretados, como Python o JavaScript, se ejecutan línea por línea por un intérprete. El intérprete lee cada línea de código y la ejecuta inmediatamente.

Aquí hay un desglose de las diferencias clave:

- Compilación: Programa completo traducido antes de la ejecución.

- Interpretación: Código traducido y ejecutado línea por línea.

- Velocidad: Los lenguajes compilados tienden a ser más rápidos.

- Portabilidad: Los lenguajes interpretados son generalmente más portátiles ya que dependen de que el intérprete esté disponible en el sistema de destino. Los lenguajes compilados pueden requerir recompilación para diferentes arquitecturas.

- Depuración: Los lenguajes interpretados a menudo ofrecen una depuración más interactiva.

12. ¿Qué es la programación orientada a objetos? ¿Puede dar un ejemplo simple?

La programación orientada a objetos (POO) es un paradigma de programación basado en "objetos", que contienen datos, en forma de campos (a menudo conocidos como atributos), y código, en forma de procedimientos (a menudo conocidos como métodos). La POO se centra en agrupar datos y métodos que operan en esos datos dentro de los objetos. Los principios clave incluyen: Encapsulación: Ocultar el estado interno y requerir la interacción a través de métodos. Herencia: Crear nuevas clases (planos para objetos) a partir de clases existentes, heredando sus propiedades y comportamientos. Polimorfismo: Permitir que objetos de diferentes clases respondan a la misma llamada de método a su manera.

Ejemplo: Considere un objeto Dog (Perro). Podría tener atributos como breed (raza), age (edad) y color. Los métodos podrían incluir bark() (ladrar), eat() (comer) y sleep() (dormir). Se puede crear un tipo diferente de objeto como Cat (Gato) y puede tener propiedades similares como age y color, pero diferentes métodos como meow() (maullar).

class Dog: def init(self, breed, age): self.breed = breed self.age = age def bark(self): print("Woof!") dog1 = Dog("Labrador", 3) dog1.bark() # Output: Woof! (Salida: ¡Guau!)

13. Describa qué es el control de versiones y por qué es importante para la codificación colaborativa.

El control de versiones es un sistema que registra los cambios realizados en un archivo o conjunto de archivos a lo largo del tiempo para que pueda recuperar versiones específicas más adelante. Es como tener un botón de "deshacer" para toda su base de código, lo que le permite volver a estados anteriores, comparar cambios y realizar un seguimiento de quién hizo qué modificaciones.

Es vital para la codificación colaborativa porque permite que varios desarrolladores trabajen en el mismo proyecto simultáneamente sin sobrescribir los cambios de los demás. He aquí por qué es importante:

- Colaboración: Facilita el desarrollo paralelo, la fusión de cambios de código y la resolución eficiente de conflictos.

- Seguimiento: Mantiene un historial de todos los cambios, lo que le permite identificar cuándo y por qué se realizaron modificaciones específicas.

- Reversión: Le permite revertir fácilmente a versiones anteriores si algo sale mal.

- Ramificación: Le permite crear líneas separadas de desarrollo para nuevas funciones o correcciones de errores sin afectar la base de código principal. Ejemplo usando la ramificación

git:

git checkout -b feature/new-feature

- Auditoría: Proporciona un registro de auditoría de todos los cambios con fines de cumplimiento y depuración.

14. ¿Cuáles son algunos errores de codificación comunes que ha encontrado y cómo los corrigió?

Algunos errores de codificación comunes que he encontrado incluyen errores de desfasamiento en uno en bucles y acceso a arrays, los cuales suelo depurar revisando cuidadosamente las condiciones del bucle y los índices del array, a veces usando un depurador para recorrer el código paso a paso. Otro problema frecuente son las excepciones de puntero nulo, a menudo causadas por variables no inicializadas o valores nulos inesperados devueltos por las funciones. Para solucionar esto, utilizo la programación defensiva, agregando comprobaciones nulas y asegurando que las variables estén correctamente inicializadas. Por ejemplo:

if (myObject != null) { myObject.doSomething(); }

El uso incorrecto del tipo de datos también es algo que veo regularmente, especialmente con lenguajes que no imponen fuertemente el tipado estático. Esto generalmente implica usar el tipo de variable incorrecto o asumir que una función devuelve un tipo específico cuando no es así. Utilizo revisiones de código, pruebas exhaustivas (¡pruebas unitarias!) y funciones IDE para detectar estos errores.

15. ¿Has utilizado alguna API? ¿Cuál fue tu experiencia?

Sí, he utilizado APIs extensamente. Mi experiencia ha sido generalmente positiva, permitiéndome integrar varios servicios y funcionalidades en aplicaciones. He trabajado principalmente con APIs RESTful, utilizando métodos HTTP como GET, POST, PUT y DELETE para interactuar con los recursos. Los métodos de autenticación que he encontrado incluyen claves API, OAuth 2.0 y JWT.

Específicamente, tengo experiencia trabajando con APIs para servicios como:

- Pasarelas de pago (Stripe, PayPal)

- Servicios de mapas (Google Maps API)

- Plataformas de redes sociales (Twitter API, Facebook Graph API)

- Servicios de correo electrónico (SendGrid, Mailgun)

- Plataformas de análisis de datos.

Me siento cómodo con el análisis de respuestas JSON, el manejo de errores y la implementación de la limitación de la tasa para asegurar el uso adecuado de la API. También estoy familiarizado con la documentación de las API utilizando herramientas como Swagger.

16. ¿Puede explicar qué es una clase y cómo se crean objetos a partir de ella?

Una clase es un modelo o plantilla para crear objetos. Define las propiedades (atributos) y comportamientos (métodos) que tendrán los objetos de esa clase. Piense en ello como un cortador de galletas; la clase es el cortador y los objetos son las galletas.

Los objetos se crean a partir de una clase usando la palabra clave new (en muchos lenguajes como Java y JavaScript) seguida del nombre de la clase. Este proceso se llama instanciación. Por ejemplo, let myObject = new MyClass(); crea un nuevo objeto myObject basado en el modelo MyClass. Cada objeto creado a partir de una clase es una instancia independiente con su propio conjunto de valores de atributos. Se puede acceder a estos valores y modificarlos usando los métodos del objeto o accediendo directamente a los atributos (dependiendo de los modificadores de acceso definidos en la clase). La Programación Orientada a Objetos es el paradigma de programación más popular en los sistemas modernos.

17. ¿Qué es la herencia y cómo promueve la reutilización del código?

La herencia es un concepto fundamental en la programación orientada a objetos (POO) donde una nueva clase (subclase o clase derivada) hereda propiedades y comportamientos de una clase existente (superclase o clase base). Establece una relación "es-un/una" entre la subclase y la superclase.

La herencia promueve la reutilización del código al permitir que las subclases reutilicen la funcionalidad de sus superclases. En lugar de reescribir el código, una subclase puede heredar los métodos y atributos de su superclase, y luego extenderlos o modificarlos según sea necesario. Esto reduce la redundancia, facilita el mantenimiento del código y promueve una base de código más organizada y eficiente. Por ejemplo:

class Animal: def init(self, nombre): self.nombre = nombre def speak(self): print("Sonido genérico de animal") class Perro(Animal): def speak(self): print("¡Guau!")

En este ejemplo, Perro hereda de Animal y reutiliza el método __init__. También anula el método speak para proporcionar su propia implementación específica. Sin herencia, tendríamos que reescribir la inicialización del atributo nombre en la clase Perro.

18. Explica qué es el polimorfismo con una analogía del mundo real.

Polimorfismo, en términos sencillos, significa 'muchas formas'. Una analogía del mundo real es el concepto de un vehículo. Un vehículo puede ser un coche, una bicicleta o un camión. Cada uno de estos es un tipo diferente de vehículo, pero todos comparten la interfaz común de ser un medio de transporte. El concepto de 'vehículo' es polimórfico porque puede adoptar muchas formas.

Otra analogía es un control remoto. Diferentes dispositivos (televisor, reproductor de DVD, sistema de sonido) pueden ser controlados por un mando a distancia, pero cada dispositivo responde de manera diferente a la misma pulsación de botón (por ejemplo, el botón de 'encendido'). El control remoto (la interfaz) exhibe polimorfismo porque la misma acción (presionar un botón) da como resultado diferentes comportamientos dependiendo del objeto con el que interactúa.

19. Describa qué es una estructura de datos y nombre algunos ejemplos.

Una estructura de datos es una forma de organizar y almacenar datos en una computadora para que puedan ser utilizados de manera eficiente. Define la relación entre los datos, las operaciones que se pueden realizar sobre los datos y cómo se almacenan los datos en la memoria. Esencialmente, es un plano de cómo gestionar los datos para tareas específicas.

Los ejemplos incluyen:

- Arrays

- Listas enlazadas

- Pilas

- Colas

- Árboles

- Grafos

- Tablas hash

Aquí hay un ejemplo de cómo se podría definir una pila simple en Python:

class Stack: def init(self): self.items = [] def push(self, item): self.items.append(item) def pop(self): if not self.is_empty(): return self.items.pop() else: return None def is_empty(): return len(self.items) == 0

20. ¿Cuál es la diferencia entre una pila y una cola?

Tanto una pila como una cola son estructuras de datos lineales que gestionan una colección de elementos, pero difieren en cómo se añaden y se eliminan los elementos.

Una pila sigue el principio LIFO (Last-In, First-Out). Piense en ello como una pila de platos; el último plato que pones es el primero que quitas. Las operaciones incluyen push (añadir un elemento a la cima) y pop (eliminar el elemento superior).

Una cola sigue el principio FIFO (First-In, First-Out), similar a una fila en una tienda. El primer elemento añadido es el primero que se elimina. Las operaciones incluyen enqueue (añadir un elemento a la parte trasera) y dequeue (eliminar el elemento de la parte delantera).

21. ¿Cuáles son algunos algoritmos de ordenación comunes y cómo funcionan?

Algunos algoritmos de ordenación comunes son:

- Ordenamiento de burbuja: Itera repetidamente a través de la lista, compara elementos adyacentes y los intercambia si están en el orden incorrecto. Simple, pero ineficiente para grandes conjuntos de datos.

- Ordenamiento por inserción: Construye la matriz final ordenada un elemento a la vez. Es eficiente para conjuntos de datos pequeños o datos casi ordenados.

- Ordenamiento por selección: Encuentra repetidamente el elemento mínimo de la parte no ordenada y lo coloca al principio. Simple, pero generalmente funciona peor que el ordenamiento por inserción.

- Ordenamiento por mezcla: Divide la lista desordenada en n sublistas, cada una con un elemento (una lista de un elemento se considera ordenada). Luego, fusiona repetidamente sublistas para producir nuevas sublistas ordenadas hasta que solo quede una sublista. Eficiente y estable.

- Ordenamiento rápido: Elige un elemento como pivote y particiona la matriz dada alrededor del pivote elegido. Aunque tiene un rendimiento en el peor de los casos de

O(n^2), su rendimiento en el caso promedio esO(n log n), lo que lo hace muy eficiente en la práctica. - Ordenamiento por montón: Utiliza una estructura de datos de montón binario para ordenar los elementos. Tiene un rendimiento garantizado de

O(n log n).

La forma en que funcionan varía, pero la idea principal es comparar elementos y reorganizarlos en función de un orden definido (por ejemplo, ascendente o descendente). Los algoritmos difieren significativamente en su eficiencia, complejidad espacial y estabilidad.

22. ¿Qué es una base de datos? ¿Has trabajado con alguna? ¿De qué tipos?

Una base de datos es una colección organizada de información estructurada, o datos, típicamente almacenada electrónicamente en un sistema informático. Las bases de datos están diseñadas para permitir el almacenamiento, la recuperación, la modificación y la eliminación eficiente de datos. He trabajado con varios tipos de bases de datos, incluidas bases de datos relacionales como MySQL y PostgreSQL, y bases de datos NoSQL como MongoDB.

Específicamente, con MySQL y PostgreSQL he utilizado SQL para la manipulación de datos, incluyendo sentencias SELECT, INSERT, UPDATE, y DELETE. También he trabajado con índices, procedimientos almacenados y diseño de esquemas de bases de datos. Con MongoDB, he utilizado su lenguaje de consulta para interactuar con los datos, realizando operaciones CRUD utilizando estructuras basadas en documentos.

23. ¿Cuál es la diferencia entre la programación del lado del cliente y la del lado del servidor?

La programación del lado del cliente se ocupa de lo que sucede en el navegador web del usuario. Se centra principalmente en la interfaz de usuario y la experiencia del usuario. Las tecnologías utilizadas aquí son típicamente HTML, CSS y JavaScript. Por ejemplo, la animación de un clic de botón o la validación de un formulario antes de enviar datos al servidor ocurren en el lado del cliente. El código se ejecuta directamente en el navegador.

La programación del lado del servidor, por otro lado, maneja la lógica de la aplicación y la gestión de datos en un servidor remoto. Gestiona bases de datos, autenticación de usuarios y otros procesos de backend. Lenguajes como Python, Java, Node.js y PHP se utilizan comúnmente. Cuando inicias sesión en un sitio web, el servidor verifica tus credenciales; esa es una operación del lado del servidor. El servidor procesa las solicitudes del cliente y envía las respuestas apropiadas.

24. Explica el concepto de alcance en programación.

El alcance (scope) en programación se refiere a la región de un programa donde una variable o enlace en particular es accesible. Esencialmente, define el ciclo de vida y la visibilidad de las variables. Típicamente hay diferentes niveles de alcance: alcance global (accesible desde cualquier lugar del programa), alcance de función o local (accesible solo dentro de la función) y alcance de bloque (accesible solo dentro de un bloque de código específico como una declaración if o un bucle).

Entender el alcance es crucial para evitar conflictos de nombres, gestionar la memoria eficientemente y escribir código mantenible. Por ejemplo, si declara una variable x dentro de una función, generalmente es distinta de una variable x declarada fuera de la función (a menos que se utilicen palabras clave específicas como global). Esto ayuda a prevenir modificaciones no deseadas y hace que el código sea más fácil de razonar. Lenguajes como Javascript usan cierres (closures) para acceder a las variables en la función padre cuando están anidadas.

25. ¿Qué significa que el código sea 'legible' y por qué es importante la legibilidad?

La legibilidad del código se refiere a la facilidad con la que otros desarrolladores (o tu futuro yo) pueden entender el propósito y la funcionalidad del código. El código legible es claro, conciso y bien estructurado. Minimiza la ambigüedad y facilita el seguimiento de la lógica. Por ejemplo, el uso de nombres descriptivos de variables como num_clientes en lugar de solo x mejora enormemente la legibilidad.

La legibilidad es crucial porque impacta directamente la mantenibilidad, la colaboración y la depuración. Cuando el código es fácil de entender, es más fácil de modificar, corregir errores e integrar con otras partes del sistema. El código poco legible, por otro lado, aumenta el riesgo de errores, dificulta la incorporación de nuevos miembros del equipo y ralentiza el proceso de desarrollo. Además, la refactorización de código críptico puede introducir efectos secundarios no deseados y, en general, es más costosa y requiere más tiempo. En última instancia, el código legible conduce a una mayor eficiencia y a la reducción de costos.

26. ¿Cómo abordaría la solución de un nuevo problema de programación que nunca ha visto antes?

Primero, intentaría entender completamente el problema. Esto incluye aclarar los requisitos, identificar las entradas y las salidas esperadas, y considerar los casos límite. Podría dividir el problema en subproblemas más pequeños y manejables.

Luego, exploraría posibles soluciones. Esto a menudo implica investigar algoritmos o estructuras de datos existentes que podrían ser aplicables. Consideraría las compensaciones de diferentes enfoques (por ejemplo, complejidad temporal frente a complejidad espacial). Para un problema relacionado con la codificación, podría escribir pseudocódigo o dibujar diagramas para visualizar la solución. Finalmente, implementaría la solución, la probaría a fondo y la refactorizaría según fuera necesario. Si me enfrentara a desafíos, buscaría en la web problemas y soluciones similares o usaría herramientas o bibliotecas en línea según fuera necesario. Además, dividiría el problema de codificación en una serie de tareas de codificación más pequeñas y las abordaría una por una para construir lentamente la solución final.

27. ¿Alguna vez has contribuido a un proyecto de código abierto? Describe tu experiencia.

Sí, he contribuido a algunos proyectos de código abierto. Una experiencia que destaca es mi contribución a una biblioteca de Python llamada data-toolkit. Envié una solicitud de extracción que mejoró la eficiencia de una función central utilizada para la validación de datos. Específicamente, optimicé la expresión regular utilizada para validar las direcciones de correo electrónico, reduciendo el tiempo de ejecución en aproximadamente un 15%.

El proceso implicó bifurcar el repositorio, implementar el cambio, agregar pruebas unitarias y enviar una solicitud de extracción. Los mantenedores del proyecto revisaron mi código, proporcionaron comentarios (principalmente con respecto a la cobertura de las pruebas) y, después de abordar sus inquietudes, mi solicitud de extracción fue fusionada. Fue una experiencia valiosa en la colaboración con otros desarrolladores y la adhesión a los estándares de codificación dentro de un proyecto más grande. data-toolkit es una biblioteca muy valiosa y ampliamente utilizada, por lo que contribuir a ella fue una gran experiencia.

28. Explica qué es una lista enlazada.

Una lista enlazada es una estructura de datos lineal donde los elementos, llamados nodos, están enlazados entre sí por punteros. A diferencia de las matrices, los elementos no se almacenan en ubicaciones de memoria contiguas. Cada nodo contiene dos partes: los datos y un puntero (o enlace) al siguiente nodo de la secuencia. El puntero del último nodo generalmente apunta a null, lo que indica el final de la lista.

Algunas ventajas de las listas enlazadas incluyen el tamaño dinámico (pueden crecer o disminuir durante el tiempo de ejecución) y la inserción/eliminación eficiente de elementos en cualquier posición (en comparación con las matrices, donde puede ser necesario desplazar elementos). Las operaciones comunes en una lista enlazada incluyen el recorrido, la inserción, la eliminación y la búsqueda. Existen diferentes tipos de listas enlazadas, como las listas enlazadas simples, las listas enlazadas dobles (donde cada nodo también tiene un puntero al nodo anterior) y las listas enlazadas circulares (donde el último nodo apunta al primer nodo).

29. ¿Qué es la recursividad? ¿Puedes explicar con un ejemplo?

La recursividad es una técnica de programación donde una función se llama a sí misma dentro de su propia definición. Es como un conjunto de muñecas rusas, donde cada muñeca contiene una versión más pequeña de sí misma. Para evitar bucles infinitos, una función recursiva debe tener un caso base, que es una condición que detiene la recursividad.

Por ejemplo, calcular el factorial de un número se puede hacer de forma recursiva:

def factorial(n): if n == 0: # Caso base return 1 else: return n * factorial(n-1) # Llamada recursiva

En este ejemplo, factorial(n) llama a factorial(n-1) hasta que n es 0, momento en el que devuelve 1, y la recursión se detiene.

Preguntas de la entrevista de habilidades intermedias de programación

1. Explica la diferencia entre procesos e hilos, y cuándo elegirías uno sobre el otro?

Tanto los procesos como los hilos son formas de lograr la concurrencia, pero difieren significativamente. Un proceso es un entorno de ejecución independiente con su propio espacio de memoria, mientras que un hilo es una unidad de ejecución ligera dentro de un proceso, que comparte el espacio de memoria del proceso. Los procesos tienen una sobrecarga mayor debido a los espacios de memoria separados y la comunicación entre procesos, pero proporcionan un mejor aislamiento, lo que significa que si un proceso falla, normalmente no afecta a otros. Los hilos son más eficientes debido a los recursos compartidos, lo que permite un cambio de contexto y una comunicación más rápidos. Sin embargo, una falla en un hilo puede potencialmente derribar todo el proceso debido a la memoria compartida.

Elegirías procesos cuando necesitas un fuerte aislamiento y tolerancia a fallos (por ejemplo, ejecutar múltiples aplicaciones independientes). Los hilos son preferibles para tareas que pueden beneficiarse de recursos compartidos y una comunicación más rápida, como las tareas ligadas a la entrada/salida (por ejemplo, manejar múltiples solicitudes de clientes en un servidor web) o escenarios donde se necesita concurrencia dentro de una única aplicación. Sin embargo, usar hilos requiere una cuidadosa sincronización para evitar condiciones de carrera.

2. Describe el concepto de recursión. ¿Puedes proporcionar un ejemplo de un problema que se resuelve mejor usando recursión?

La recursión es una técnica de programación donde una función se llama a sí misma dentro de su propia definición. Esto crea un comportamiento similar a un bucle, pero en lugar de iterar, la función descompone un problema en subproblemas más pequeños y similares a sí mismos hasta que alcanza un caso base, que detiene la recursión. Cada llamada recursiva añade una nueva capa a la pila de llamadas, por lo que es importante asegurar que el caso base se alcance eventualmente para evitar un error de desbordamiento de la pila.

Un ejemplo clásico, adecuado para la recursión, es calcular el factorial de un número. Así es como podría implementarse en código:

def factorial(n): if n == 0: # Caso base return 1 else: return n * factorial(n-1) # Llamada recursiva

3. ¿Qué son los patrones de diseño y por qué son útiles en el desarrollo de software? Dé ejemplos.

Los patrones de diseño son soluciones reutilizables a problemas que ocurren comúnmente en el diseño de software. Representan las mejores prácticas que los desarrolladores pueden aplicar para resolver desafíos de diseño recurrentes. Son como planos que se pueden personalizar para resolver problemas específicos en un proyecto.

Los patrones de diseño son útiles porque promueven la reutilización del código, mejoran la legibilidad del código y reducen el tiempo de desarrollo. También ayudan a garantizar que el software esté bien estructurado y sea fácil de mantener. Los ejemplos incluyen:

- Singleton: Asegura que solo exista una instancia de una clase.

- Factory (Fábrica): Proporciona una interfaz para crear objetos sin especificar la clase exacta a crear.

- Observer (Observador): Define una dependencia de uno a muchos entre objetos, de modo que cuando un objeto cambia de estado, todos sus dependientes son notificados y actualizados automáticamente.

- Strategy (Estrategia): Define una familia de algoritmos, encapsula cada uno y los hace intercambiables. La estrategia permite que el algoritmo varíe independientemente de los clientes que lo utilizan.

Ejemplo de código que muestra el patrón de estrategia:

interface PaymentStrategy { void pagar(int cantidad); } class CreditCardPayment implements PaymentStrategy { private String numeroTarjeta; private String fechaExpiracion; private String cvv; public CreditCardPayment(String numeroTarjeta, String fechaExpiracion, String cvv) { this.numeroTarjeta = numeroTarjeta; this.fechaExpiracion = fechaExpiracion; this.cvv = cvv; } @Override public void pagar(int cantidad) { System.out.println("Pagado " + cantidad + " usando Tarjeta de Crédito: " + numeroTarjeta); } } class PayPalPayment implements PaymentStrategy { private String correoElectronico; private String contraseña; public PayPalPayment(String correoElectronico, String contraseña) { this.correoElectronico = correoElectronico; this.contraseña = contraseña; } @Override public void pagar(int cantidad) { System.out.println("Pagado " + cantidad + " usando PayPal: " + correoElectronico); } } class ShoppingCart { private PaymentStrategy estrategiaPago; public void setPaymentStrategy(PaymentStrategy estrategiaPago) { this.estrategiaPago = estrategiaPago; } public void checkout(int cantidad) { estrategiaPago.pagar(cantidad); } } public class Main { public static void main(String[] args) { ShoppingCart cart = new ShoppingCart(); // Pagar con Tarjeta de Crédito cart.setPaymentStrategy(new CreditCardPayment("1234-5678-9012-3456", "12/24", "123")); cart.checkout(100); // Pagar con PayPal cart.setPaymentStrategy(new PayPalPayment("usuario@ejemplo.com", "contraseña")); cart.checkout(50); } }

4. Explique los principios SOLID del diseño orientado a objetos. ¿Cómo contribuyen estos principios al código mantenible?

Los principios SOLID son un conjunto de cinco principios de diseño destinados a hacer que los diseños de software sean más comprensibles, flexibles y mantenibles. Son:

- Principio de Responsabilidad Única (SRP): Una clase debe tener una sola razón para cambiar.

- Principio Abierto/Cerrado (OCP): Las entidades de software deben estar abiertas para la extensión, pero cerradas para la modificación.

- Principio de Sustitución de Liskov (LSP): Los subtipos deben ser sustituibles por sus tipos base sin alterar la corrección del programa.

- Principio de Segregación de Interfaz (ISP): Los clientes no deben verse obligados a depender de interfaces que no utilizan.

- Principio de Inversión de Dependencia (DIP): Depender de abstracciones, no de concreciones.

Al adherirse a estos principios, el código se vuelve más modular, reutilizable y comprobable. Los cambios se localizan, lo que reduce el riesgo de introducir errores y simplifica el mantenimiento. Por ejemplo, SRP ayuda a evitar clases grandes y complejas que son difíciles de entender y modificar. OCP le permite agregar nueva funcionalidad sin alterar el código existente, minimizando el riesgo de romper cosas. DIP promueve el acoplamiento suelto, lo que facilita el cambio de dependencias sin afectar a otras partes del sistema. En resumen, SOLID contribuye a un código que es más fácil de entender, modificar y probar, lo que lleva a un software más mantenible.

5. Describe la diferencia entre las bases de datos SQL y NoSQL. ¿Cuáles son las compensaciones de cada una?

Las bases de datos SQL son relacionales, utilizando un esquema estructurado para definir datos y relaciones. Utilizan SQL (Lenguaje de Consulta Estructurado) para consultar y manipular datos. Las bases de datos NoSQL, por otro lado, son no relacionales y vienen en varios tipos (documento, clave-valor, gráfico, columnar), ofreciendo esquemas flexibles. A menudo utilizan diferentes lenguajes o métodos de consulta.

Las compensaciones: Las bases de datos SQL garantizan la integridad y consistencia de los datos (propiedades ACID), pero pueden ser menos escalables y menos flexibles con los cambios de esquema. Las bases de datos NoSQL proporcionan alta escalabilidad, disponibilidad y flexibilidad, pero pueden sacrificar algo de consistencia (propiedades BASE). Elegir entre ellas depende de los requisitos específicos de la aplicación; SQL es mejor cuando se necesita una fuerte consistencia, y NoSQL destaca en el manejo de grandes volúmenes de datos no estructurados con alta velocidad y variedad.

6. ¿Cuál es el propósito de los sistemas de control de versiones como Git? Explique el flujo de trabajo común de Git.

Los sistemas de control de versiones como Git son herramientas esenciales para gestionar los cambios en el código y otros archivos a lo largo del tiempo. Permiten a los equipos colaborar eficazmente, realizar un seguimiento de las revisiones, volver a estados anteriores y experimentar con nuevas características sin interrumpir la base de código principal. Git proporciona una forma estructurada de gestionar el desarrollo paralelo, identificar quién hizo cambios específicos y resolver conflictos que pueden surgir cuando varias personas trabajan en los mismos archivos.

Un flujo de trabajo común de Git a menudo implica los siguientes pasos:

- Clonar: Obtener una copia local de un repositorio desde un servidor remoto.

- Rama: Crear una nueva rama para aislar los cambios de una característica o corrección de errores específica.

- Modificar: Realizar cambios en los archivos del directorio de trabajo.

- Preparar (Stage): Seleccionar los archivos modificados para incluirlos en el siguiente commit (usando

git add). - Confirmar (Commit): Registrar los cambios preparados con un mensaje descriptivo (usando

git commit). - Empujar (Push): Subir la rama local al repositorio remoto (usando

git push). - Solicitud de extracción (Pull Request): Enviar la rama para su revisión y fusión en la rama principal (por ejemplo,

mainomaster). - Fusionar (Merge): Integrar los cambios de la rama en la rama principal después de una revisión exitosa (usando

git merge).

7. Explique el concepto de almacenamiento en caché (caching). ¿Cuáles son las diferentes estrategias de almacenamiento en caché y cuándo usaría cada una?

El almacenamiento en caché (caching) es una técnica para almacenar datos a los que se accede con frecuencia en una ubicación de almacenamiento temporal (la caché) para mejorar el rendimiento. Cuando se necesitan los mismos datos nuevamente, se pueden recuperar de la caché mucho más rápido que recuperándolos de la fuente original. Esto reduce la latencia, mejora la capacidad de respuesta y disminuye la carga en la fuente de datos original.

Las estrategias de caché comunes incluyen: Write-Through (escritura directa), donde los datos se escriben simultáneamente tanto en la caché como en el almacenamiento principal. Garantiza la consistencia de los datos, pero puede ser más lento. Write-Back (escritura diferida), donde los datos se escriben inicialmente solo en la caché y posteriormente se escriben en el almacenamiento principal. Es más rápido, pero corre el riesgo de pérdida de datos si falla la caché. Cache-Aside (cache lateral), donde la aplicación comprueba primero la caché; si los datos están allí (acierto de caché), se devuelven; de lo contrario (fallo de caché), la aplicación los obtiene del almacenamiento principal, los almacena en la caché y luego los devuelve. Use Write-Through cuando la consistencia de los datos es primordial. Use Write-Back cuando el rendimiento es crítico y la pérdida ocasional de datos es aceptable. Use Cache-Aside cuando desee un control explícito sobre la lógica de almacenamiento en caché y desee evitar afectar el rendimiento de la escritura con la sincronización de la caché. Además, las CDN (Redes de Entrega de Contenido) son buenas para almacenar en caché contenido estático como imágenes y videos más cerca del usuario.

8. Describe cómo abordaría la depuración de un problema de software complejo. ¿Qué herramientas o técnicas usaría?

Al depurar un problema complejo, empiezo por intentar reproducir el problema de forma fiable. Una vez reproducible, recopilo la mayor cantidad de información posible: registros, mensajes de error, entrada del usuario, estado del sistema. Luego formulo una hipótesis sobre la causa raíz. Usaría herramientas como depuradores (gdb, pdb), herramientas de análisis de registros (grep, awk, Splunk) y analizadores de red (Wireshark) dependiendo de la naturaleza del problema. Las herramientas de análisis de código como analizadores estáticos y analizadores de rendimiento también son útiles.

A continuación, pruebo mi hipótesis modificando el código o el entorno y observando los resultados. Empleo técnicas como la búsqueda binaria (aislando la sección de código problemática) y la depuración del pato de goma. Si la hipótesis es incorrecta, la refino basándome en nueva evidencia. Priorizo aislar el área problemática y escribir pruebas específicas para confirmar las correcciones y prevenir regresiones.

9. ¿Qué son las pruebas unitarias? ¿Por qué son importantes y cómo se escriben pruebas unitarias efectivas?

Las pruebas unitarias son pruebas pequeñas y aisladas que verifican que los componentes o funciones individuales (unidades) del código funcionan como se espera. Son importantes porque ayudan a detectar errores al principio del ciclo de desarrollo, facilitan la refactorización y sirven como documentación de cómo debe comportarse el código.

Para escribir pruebas unitarias efectivas:

- Concéntrese en una unidad a la vez: Cada prueba debe verificar un aspecto específico de una sola función o clase.

- Escriba pruebas claras y concisas: Las pruebas deben ser fáciles de entender y mantener.

- Use nombres descriptivos: Los nombres de las pruebas deben indicar claramente lo que están probando.

- Pruebe las condiciones límite y los casos extremos: Asegúrese de que el código maneje las entradas inusuales correctamente.

- Siga el patrón Arrange-Act-Assert: Organice los datos de prueba, Actúe llamando al código bajo prueba y Afirme que los resultados son los esperados.

- Busque una alta cobertura de código: Si bien la cobertura del 100% no siempre es necesaria, esfuércese por probar la mayor cantidad de código posible.

10. Explique el concepto de API (Interfaz de Programación de Aplicaciones). ¿Cómo permiten las API la comunicación entre diferentes sistemas?

Una API (Interfaz de Programación de Aplicaciones) es un conjunto de reglas y especificaciones que los programas de software pueden seguir para comunicarse entre sí. Actúa como intermediario, permitiendo que diferentes sistemas de software intercambien datos y funcionalidades sin necesidad de conocer los detalles de implementación subyacentes entre sí. Piense en ello como el menú de un restaurante: el menú (API) enumera los platos (funciones) que puede pedir, y no necesita saber cómo el chef (el sistema) los prepara.

Las APIs permiten la comunicación al definir puntos finales (URLs) y formatos de datos (a menudo JSON o XML) específicos para peticiones y respuestas. Un sistema envía una petición a un punto final de la API, y la API procesa la petición y devuelve una respuesta. Por ejemplo, si tiene una función para obtener datos de usuario, se puede exponer a través de un punto final de la API /usuarios/{id}. Un sistema puede llamar al punto final, recibir y usar la información del usuario.

11. ¿Qué es la notación Big O, y cómo se utiliza para analizar el rendimiento de los algoritmos?

La notación Big O es una notación matemática utilizada para describir el comportamiento límite de una función cuando el argumento tiende hacia un valor particular o infinito. En informática, se utiliza para clasificar algoritmos según cómo su tiempo de ejecución o los requisitos de espacio crecen a medida que aumenta el tamaño de la entrada. Se centra en el límite superior de la complejidad del algoritmo, representando el peor de los casos.

Big O ayuda a analizar el rendimiento de los algoritmos al proporcionar una forma estandarizada de comparar algoritmos independientemente del hardware o implementaciones específicas. Por ejemplo, O(n) (tiempo lineal) significa que el tiempo de ejecución crece linealmente con el tamaño de la entrada n, mientras que O(1) (tiempo constante) significa que el tiempo de ejecución permanece constante independientemente del tamaño de la entrada. Las complejidades comunes incluyen O(log n), O(n log n), O(n^2) y O(2^n). Analizar algoritmos usando Big O ayuda a los desarrolladores a elegir la solución más eficiente para un problema y tamaño de entrada dados.

12. Describe las estructuras de datos comunes como arrays, listas enlazadas, árboles y grafos. ¿Cuáles son sus casos de uso respectivos?

Los arrays son bloques contiguos de memoria que contienen elementos del mismo tipo. Ofrecen acceso rápido a los elementos a través de su índice (O(1)). Los casos de uso comunes incluyen el almacenamiento de listas de elementos donde el tamaño se conoce de antemano, la implementación de pilas y colas y la representación de matrices.

Las listas enlazadas, por otro lado, utilizan nodos que contienen datos y un puntero al siguiente nodo. La inserción y eliminación son eficientes (O(1) si tiene un puntero al nodo), pero acceder a un elemento requiere recorrer la lista (O(n)). Los casos de uso incluyen la implementación de pilas y colas, la representación de listas dinámicas donde el tamaño no se conoce y la implementación de tablas hash.

Los árboles son estructuras de datos jerárquicas donde cada nodo puede tener múltiples hijos. Los árboles binarios, donde cada nodo tiene como máximo dos hijos, son comunes. Los árboles permiten una búsqueda y ordenación eficientes. Los casos de uso comunes incluyen la representación de datos jerárquicos (sistemas de archivos, organigramas), la implementación de árboles de búsqueda (árboles de búsqueda binaria, árboles AVL, árboles rojo-negro) y el análisis de expresiones. Los grafos son colecciones de nodos (vértices) conectados por aristas. Pueden representar relaciones complejas entre objetos. Los casos de uso incluyen redes sociales, mapeo de rutas, representación de dependencias y modelado de redes informáticas. Los grafos pueden representarse mediante matrices de adyacencia o listas de adyacencia.

13. Explique el concepto de concurrencia y paralelismo. ¿Cómo se puede lograr la concurrencia en su lenguaje de programación elegido?

La concurrencia significa que múltiples tareas progresan aparentemente de forma simultánea, incluso si en realidad se turnan para usar un único procesador. El paralelismo, por otro lado, significa que múltiples tareas se están ejecutando realmente al mismo tiempo, normalmente en múltiples procesadores o núcleos.

En Python, la concurrencia se puede lograr a través de varios mecanismos. threading proporciona una forma de crear y administrar hilos, lo que permite que múltiples funciones se ejecuten concurrentemente dentro de un solo proceso (aunque limitado por el Global Interpreter Lock (GIL) para tareas ligadas a la CPU). asyncio proporciona un bucle de eventos que administra corrutinas, lo que permite la programación asíncrona para tareas ligadas a E/S. Por ejemplo:

import asyncio async def mi_corutina(): await asyncio.sleep(1) # Simula una operación de E/S print("Corrutina terminada") async def principal(): await asyncio.gather(mi_corutina(), mi_corutina()) asyncio.run(principal())

Este código utiliza asyncio para ejecutar dos corrutinas concurrentemente, sin bloquear el hilo principal mientras espera E/S.

14. ¿Cuáles son los beneficios de usar un framework (por ejemplo, React, Angular, Django, Spring)? ¿Cuáles son los posibles inconvenientes?

Los frameworks ofrecen numerosas ventajas, incluyendo ciclos de desarrollo más rápidos debido a componentes reutilizables y patrones establecidos. También promueven la consistencia del código y la mantenibilidad, a menudo proporcionando características de seguridad integradas y ecosistemas gestionados activamente. Por ejemplo, la arquitectura basada en componentes de React permite actualizaciones sencillas de la interfaz de usuario, mientras que el ORM de Django simplifica las interacciones con la base de datos.

Sin embargo, existen inconvenientes. Una curva de aprendizaje pronunciada es común, y se requiere conocimiento específico del framework. Los frameworks pueden introducir bloat, lo que lleva a una sobrecarga de rendimiento si no se utilizan juiciosamente. La dependencia excesiva de un framework también puede limitar la flexibilidad y potencialmente encerrar a los desarrolladores en una pila tecnológica específica. Por ejemplo, migrar de Angular a React puede ser una tarea importante.

15. Describa el concepto de inyección de dependencias. ¿Cómo mejora la capacidad de prueba y el mantenimiento del código?

La Inyección de Dependencias (DI) es un patrón de diseño donde las dependencias de un componente se le proporcionan, en lugar de que el componente las cree por sí mismo. Esta 'inyección' típicamente ocurre a través de un constructor, un método setter o una interfaz. Esencialmente, en lugar de que una clase cree sus propias dependencias, esas dependencias se pasan desde una fuente externa. Esto promueve el acoplamiento débil.

DI mejora la capacidad de prueba y el mantenimiento de varias maneras:

- Capacidad de prueba: DI permite reemplazar fácilmente las dependencias reales con objetos simulados durante las pruebas. Esto aísla la unidad bajo prueba y permite pruebas más enfocadas y confiables.

- Mantenimiento: Debido a que los componentes están débilmente acoplados, es menos probable que los cambios en un componente afecten a otros. Esto facilita la modificación, extensión y refactorización del código. El aumento de la reutilización es otro beneficio.

16. Explica la diferencia entre autenticación y autorización. ¿Cómo se implementan típicamente en aplicaciones web?

La autenticación verifica quién es un usuario, mientras que la autorización determina a qué puede acceder. La autenticación es como mostrar tu identificación para entrar a un edificio; la autorización es como tener una llave para habitaciones específicas dentro de ese edificio.

En aplicaciones web, la autenticación se implementa típicamente utilizando técnicas como:

- Nombre de usuario/contraseña: El método más común, a menudo mejorado con hashing y salting.

- Autenticación multifactor (MFA): Agrega una capa adicional de seguridad (por ejemplo, código SMS, aplicación de autenticación).

- OAuth/OIDC: Delega la autenticación a un tercero de confianza (por ejemplo, Google, Facebook).

- SAML: Otro protocolo para identidad federada y inicio de sesión único (SSO).

La autorización a menudo se gestiona utilizando:

- Control de acceso basado en roles (RBAC): Asignación de usuarios a roles con permisos específicos.

- Control de acceso basado en atributos (ABAC): Uso de atributos de usuario y atributos de recursos para definir reglas de acceso. Un ejemplo de bloque

if(en pseudocódigo) podría ser:

if user.role == "admin" and resource.owner == user.id: allow_access else: deny_access

- Listas de control de acceso (ACL): Especificación de permisos para usuarios o grupos individuales en recursos específicos.

17. ¿Cuáles son algunas vulnerabilidades de seguridad comunes en aplicaciones web (por ejemplo, XSS, inyección SQL)? ¿Cómo puedes prevenirlas?

Algunas vulnerabilidades comunes de aplicaciones web incluyen Cross-Site Scripting (XSS), donde se inyectan scripts maliciosos en sitios web que son vistos por otros usuarios. La prevención implica la validación de la entrada, la codificación/escapado de la salida y el uso de una Política de seguridad de contenido (CSP). Otra vulnerabilidad común es la inyección SQL, donde los atacantes insertan código SQL malicioso en consultas de bases de datos. Los métodos de prevención incluyen el uso de consultas parametrizadas o declaraciones preparadas, el empleo del principio de mínimo privilegio para el acceso a la base de datos y la validación de la entrada. Otras vulnerabilidades incluyen Cross-Site Request Forgery (CSRF), autenticación defectuosa, configuración de seguridad incorrecta y deserialización insegura.

18. Describe el concepto de refactorización de código. ¿Cuándo y por qué deberías refactorizar el código?

La refactorización de código es el proceso de reestructurar el código de computadora existente, cambiando su estructura interna, sin cambiar su comportamiento externo. Se trata de mejorar la legibilidad del código, reducir la complejidad y facilitar su mantenimiento y extensión, todo sin alterar lo que el código hace.

Deberías refactorizar cuando el código exhibe olores de código (por ejemplo, código duplicado, métodos largos, clases grandes), cuando agregar una nueva característica requiere un esfuerzo significativo debido a una mala estructura de código, o cuando corregir un error es difícil debido a una lógica compleja. La refactorización mejora la mantenibilidad, reduce la deuda técnica y hace que la base de código sea más comprensible y adaptable a futuros cambios. Por ejemplo, podrías extraer un método para eliminar código duplicado o renombrar una variable para mejorar la claridad. El uso de técnicas como extraer método o mover campo mejora la calidad del código. La refactorización no se trata de agregar nueva funcionalidad; se trata puramente de mejorar el código existente.

19. Explica el concepto de arquitectura de microservicios. ¿Cuáles son las ventajas y desventajas en comparación con una arquitectura monolítica?

La arquitectura de microservicios es un enfoque donde una aplicación se estructura como una colección de servicios pequeños y autónomos, modelados en torno a un dominio de negocio. Cada servicio es implementable, escalable y mantenible de forma independiente. Se comunican a través de mecanismos ligeros, a menudo una API de recursos HTTP. En comparación con una arquitectura monolítica, donde toda la aplicación se construye como una sola unidad grande, los microservicios ofrecen varias ventajas.

Las ventajas incluyen: mayor agilidad, escalabilidad más fácil, implementación independiente, diversidad tecnológica y mejor aislamiento de fallos. Las desventajas incluyen: mayor complejidad, sobrecarga operativa (gestión de muchos servicios), desafíos de depuración distribuida y potencial de sobrecarga de comunicación entre servicios y latencia. Los monolitos, aunque menos flexibles, son más simples de desarrollar, implementar y monitorear inicialmente.

20. ¿Cómo diseñarías una API RESTful simple? ¿Qué consideraciones tomarías en cuenta?

Para diseñar una API RESTful simple, comenzaría definiendo los recursos que expone (por ejemplo, usuarios, productos, pedidos). Para cada recurso, determinaría los métodos HTTP relevantes: GET (recuperar), POST (crear), PUT (actualizar), DELETE (eliminar). Los endpoints deben nombrarse usando sustantivos (por ejemplo, /usuarios/{id}) en lugar de verbos. Los datos se intercambiarían usando JSON.

Las consideraciones clave incluyen: Autenticación/Autorización (por ejemplo, claves API, OAuth), Versionado (por ejemplo, usando /v1/usuarios), Manejo de errores (devolviendo códigos de estado HTTP y mensajes de error significativos), Limitación de velocidad para prevenir abusos, y Documentación (por ejemplo, usando OpenAPI/Swagger). Por ejemplo, una solicitud para crear un nuevo usuario podría verse así:

POST /usuarios Content-Type: application/json { "name": "John Doe", "email": "john.doe@example.com" }

Preguntas de entrevista sobre habilidades de programación avanzadas

1. Explica el concepto de inyección de dependencias y sus beneficios.

La Inyección de Dependencias (DI) es un patrón de diseño donde un componente recibe sus dependencias de fuentes externas en lugar de crearlas por sí mismo. Esto promueve el acoplamiento débil y hace que el código sea más testeable y mantenible. En esencia, las dependencias se "inyectan" en el componente.

Los beneficios incluyen una mayor reutilización del código, pruebas simplificadas (mediante el uso de dependencias simuladas), una mejor capacidad de mantenimiento (debido al acoplamiento débil) y una mejor legibilidad del código. El uso de DI facilita el cambio de dependencias sin modificar los componentes dependientes. Marcos populares como Spring y Angular hacen un uso intensivo de DI.

2. ¿Cómo implementaría un patrón singleton seguro para subprocesos?

Un singleton seguro para subprocesos se puede implementar utilizando varias técnicas. Un enfoque común es el patrón de bloqueo de doble verificación junto con la palabra clave volatile en Java. Primero, la variable de instancia se declara volatile para asegurar la visibilidad de las actualizaciones entre subprocesos. El método getInstance() primero verifica si la instancia es nula sin ningún bloqueo. Si lo es, adquiere un bloqueo en el objeto de la clase. Dentro del bloque bloqueado, vuelve a verificar si la instancia es nula antes de crearla. Esta doble verificación asegura que la instancia solo se cree una vez.

public class Singleton { private static volatile Singleton instancia; private Singleton() {} public static Singleton getInstance() { if (instancia == null) { synchronized (Singleton.class) { if (instancia == null) { instancia = new Singleton(); } } } return instancia; } }

Otra forma de hacerlo es usar la inicialización estática. La JVM garantiza que la inicialización estática es segura para hilos. Por lo tanto, simplemente creando la instancia como un campo estático se asegura la seguridad de los hilos sin bloqueo explícito.

public class Singleton { private static final Singleton instancia = new Singleton(); private Singleton() {} public static Singleton getInstance() { return instancia; } }

3. Describe las diferencias entre el bloqueo optimista y el pesimista.

El bloqueo optimista asume que los conflictos son raros. Lee datos, realiza cálculos y luego verifica si los datos han sido modificados desde que se leyeron. Si no lo han sido, la actualización se aplica; de lo contrario, la actualización falla y la transacción generalmente se reintenta. Esto a menudo se implementa utilizando números de versión o marcas de tiempo. En código, podría verse así:

//Lee la entidad con la versión 1 Entity entidad = entityRepository.findById(id); //Modifica la entidad entidad.setData("nuevos datos"); //Intenta guardar la entidad actualizada. si la versión no coincide, se lanza una excepción entityRepository.save(entidad);

Por otro lado, el bloqueo pesimista asume que los conflictos son comunes. Bloquea los datos antes de leerlos para evitar que otras transacciones los modifiquen hasta que se libere el bloqueo. Este enfoque garantiza la consistencia de los datos, pero puede reducir la concurrencia. Los sistemas de bases de datos a menudo proporcionan mecanismos para el bloqueo pesimista, como SELECT ... FOR UPDATE.

4. ¿Cuáles son las ventajas y desventajas de la arquitectura de microservicios?

Los microservicios ofrecen varias ventajas. Promueven la implementación independiente, lo que permite a los equipos lanzar actualizaciones sin afectar a toda la aplicación. Esto conduce a ciclos de desarrollo más rápidos y una mayor agilidad. Cada servicio se puede escalar de forma independiente, optimizando la utilización de recursos y el costo. Además, los microservicios permiten la diversidad tecnológica; diferentes servicios se pueden construir con diferentes tecnologías que se adapten mejor a sus tareas específicas. El aislamiento de fallos es otro beneficio: si un servicio falla, no necesariamente derriba toda la aplicación.

Sin embargo, los microservicios también tienen desventajas. La mayor complejidad de un sistema distribuido puede hacer que el desarrollo, las pruebas y la implementación sean más difíciles. La sobrecarga de comunicación entre servicios puede introducir latencia. Mantener la consistencia de los datos en múltiples bases de datos requiere una cuidadosa coordinación. La observabilidad se vuelve crucial, ya que la depuración de problemas en un entorno distribuido puede ser difícil. Además, la configuración inicial y los costos de infraestructura suelen ser más altos en comparación con las aplicaciones monolíticas.

5. Explique el concepto de event sourcing.

Event sourcing es un patrón de diseño donde el estado de una aplicación se determina por una secuencia de eventos. En lugar de almacenar el estado actual de una entidad, almacenamos una secuencia inmutable y de solo anexión de todos los eventos que han afectado a esa entidad. El estado actual se puede derivar reproduciendo estos eventos.

Los aspectos clave incluyen:

- Eventos como fuente de la verdad: Los eventos se conservan y representan hechos que han ocurrido.

- Inmutabilidad: Los eventos nunca se modifican ni se eliminan.

- Reproducibilidad: El estado actual se puede reconstruir en cualquier momento reproduciendo los eventos.

- Beneficios: Auditabilidad, consultas temporales, depuración e integración más fácil con arquitecturas basadas en eventos.

6. ¿Cómo diseñaría un limitador de frecuencia?

Un limitador de velocidad puede diseñarse utilizando varios algoritmos. Un enfoque común implica el uso de un depósito de fichas (token bucket) o una ventana deslizante. El algoritmo del depósito de fichas funciona agregando fichas a un depósito a una velocidad fija. Cada solicitud consume una ficha. Si el depósito está vacío, la solicitud se descarta o se retrasa. El algoritmo de la ventana deslizante rastrea las solicitudes dentro de un intervalo de tiempo. Si el número de solicitudes excede un umbral dentro de la ventana, las solicitudes posteriores se limitan la velocidad. La implementación a menudo implica un mecanismo de almacenamiento en caché (como Redis) para almacenar el estado del depósito/ventana y operaciones atómicas para garantizar la seguridad de los subprocesos.

Las consideraciones clave incluyen la definición del límite de velocidad (solicitudes por segundo/minuto), la elección de un algoritmo, el manejo de solicitudes rechazadas (devolver error, reintentar) y garantizar la escalabilidad y la tolerancia a fallos. Por ejemplo:

ejemplo simplificado de bucket de tokens

import time

class RateLimiter:

def __init__(self, capacidad, tasa_de_recarga):

self.capacidad = capacidad

self.tokens = capacidad

self.tasa_de_recarga = tasa_de_recarga

self.última_recarga = time.time()

def allow_request(self):

self._refill()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def _refill(self):

now = time.time()

tiempo_transcurrido = now - self.última_recarga

nuevos_tokens = tiempo_transcurrido * self.tasa_de_recarga

self.tokens = min(self.capacidad, self.tokens + nuevos_tokens)

self.última_recarga = now

7. Describe el teorema CAP y sus implicaciones.

El teorema CAP, también conocido como teorema de Brewer, establece que es imposible para un almacén de datos distribuido proporcionar simultáneamente más de dos de las siguientes tres garantías: Consistencia (todos los nodos ven los mismos datos al mismo tiempo), Disponibilidad (cada solicitud recibe una respuesta, sin garantía de que contenga la versión más reciente de los datos) y Tolerancia a la partición (el sistema continúa funcionando a pesar de la partición arbitraria debido a fallas de la red).

Las implicaciones incluyen la necesidad de hacer concesiones al diseñar sistemas distribuidos. Por ejemplo, en un sistema que prioriza la disponibilidad y la tolerancia a particiones (AP), la consistencia de los datos podría sacrificarse temporalmente. Por el contrario, un sistema que prioriza la consistencia y la tolerancia a particiones (CP) podría quedar no disponible durante una partición de red. La elección entre CA, AP o CP depende de los requisitos específicos de la aplicación y la importancia relativa de cada garantía. La mayoría de los sistemas del mundo real necesitan ser tolerantes a particiones, dejando la elección entre disponibilidad y consistencia. Sistemas como Cassandra eligen AP, mientras que sistemas como MongoDB eligen CP.

8. ¿Cuáles son las compensaciones entre la consistencia fuerte y la eventual?

La consistencia fuerte garantiza que cualquier operación de lectura devolverá la escritura más reciente. Esto tiene el costo de una latencia más alta y una disponibilidad reducida, especialmente en sistemas distribuidos. A menudo requiere sincronización entre múltiples nodos, lo que puede ralentizar las operaciones. Las particiones de red pueden afectar severamente la capacidad del sistema para servir solicitudes, ya que todos los nodos deben estar de acuerdo con el estado más reciente.

La consistencia eventual, por otro lado, permite que las lecturas devuelvan datos obsoletos temporalmente. Esto prioriza la disponibilidad y una latencia más baja. Si bien eventualmente converge al estado correcto, existe una ventana de inconsistencia. Este enfoque es adecuado para sistemas donde las lecturas obsoletas ocasionales son aceptables, como las fuentes de redes sociales o los catálogos de productos de comercio electrónico. La compensación es la necesidad de manejar posibles conflictos y la reconciliación de datos cuando las actualizaciones se propagan.

9. Explique el concepto de CQRS (Separación de Responsabilidad de Comando y Consulta).

CQRS (Separación de Responsabilidad de Comando y Consulta) es un patrón que separa las operaciones de lectura y escritura para un almacén de datos. En lugar de usar el mismo modelo de datos tanto para consultar (lecturas) como para actualizar (escrituras), CQRS usa modelos separados. Esta separación le permite optimizar cada lado de forma independiente.

- Comandos: Manejan operaciones de escritura (por ejemplo, crear, actualizar, eliminar). Representan la intención de cambiar el estado del sistema.

- Consultas: Manejan operaciones de lectura. Recuperan datos sin modificar el estado del sistema. CQRS se usa a menudo junto con Event Sourcing. En tales casos, el lado de 'escritura' agregará eventos a un almacén de eventos, y el lado de 'lectura' proyectará estos eventos en modelos de lectura optimizados para la consulta. Un ejemplo simple es tener modelos de datos separados para las escrituras de "Cliente" (por ejemplo, que contengan todos los detalles del cliente) y las lecturas de "Resumen del cliente" (por ejemplo, que contengan solo el nombre y la identificación del cliente) para su visualización en una lista.

10. ¿Cómo implementaría una caché distribuida?

Una caché distribuida se puede implementar utilizando varios enfoques. Una solución común implica un clúster de servidores de caché y una estrategia de distribución. El hashing, específicamente el hashing consistente, se usa a menudo para mapear claves a servidores de caché específicos. Esto asegura que los datos se distribuyan uniformemente y minimiza la interrupción cuando se agregan o eliminan servidores.

Los detalles de la implementación a menudo involucran tecnologías como Redis o Memcached, que brindan soporte integrado para la agrupación en clústeres y la replicación de datos. Alternativamente, podría construir una solución personalizada utilizando un almacén de clave-valor (por ejemplo, Cassandra, DynamoDB) junto con una biblioteca de almacenamiento en caché. Necesita administrar la consistencia de los datos entre los nodos. Se pueden utilizar técnicas como write-through, write-back y read-through caching dependiendo de los requisitos de la aplicación. El ejemplo de código ConsistentHashing.java se muestra a continuación:

public class ConsistentHashing { private final TreeMap<Integer, String> circle = new TreeMap<>(); private final int numberOfReplicas; public ConsistentHashing(int numberOfReplicas, Collection<String> nodos) { this.numberOfReplicas = numberOfReplicas; for (String node : nodos) { addNode(node); } } public void addNode(String node) { for (int i = 0; i < numberOfReplicas; i++) { int hash = hash(node + i); circle.put(hash, node); } } public void removeNode(String node) { for (int i = 0; i < numberOfReplicas; i++) { int hash = hash(node + i); circle.remove(hash); } } public String get(String key) { if (circle.isEmpty()) { return null; } int hash = hash(key); if (!circle.containsKey(hash)) { SortedMap<Integer, String> tailMap = circle.tailMap(hash); hash = tailMap.isEmpty() ? circle.firstKey() : tailMap.firstKey(); } return circle.get(hash); } private int hash(String key) { // Simple hash function (use a better one in production) return Math.abs(key.hashCode()); } }

11. Describe los diferentes tipos de bases de datos NoSQL y sus casos de uso.

Las bases de datos NoSQL son bases de datos no relacionales que ofrecen esquemas flexibles y escalabilidad. Los tipos clave incluyen:

- Clave-Valor: Almacena datos como pares clave-valor. Ejemplos: Redis, Memcached. Casos de uso: Caché, gestión de sesiones.

- Documento: Almacena datos como documentos similares a JSON. Ejemplos: MongoDB, Couchbase. Casos de uso: Gestión de contenido, catálogos.

- Familia de Columnas: Almacena datos en familias de columnas. Ejemplos: Cassandra, HBase. Casos de uso: Datos de series temporales, análisis.

- Gráfico: Almacena datos como nodos y aristas. Ejemplos: Neo4j, Amazon Neptune. Casos de uso: Redes sociales, motores de recomendación. Estos tipos de bases de datos se seleccionan comúnmente cuando se necesita velocidad y escalabilidad, en lugar de una consistencia transaccional estricta como en los SGBD relacionales.

12. ¿Cuáles son las ventajas y desventajas de usar una cola de mensajes?

Las colas de mensajes ofrecen varias ventajas. Proporcionan comunicación asíncrona, desacoplando los servicios y aumentando la resiliencia del sistema. Este desacoplamiento permite el escalado independiente de los servicios y una mejor tolerancia a fallos, ya que los fallos en un servicio no necesariamente se propagan a otros. Las colas de mensajes también permiten un manejo eficiente del tráfico de ráfaga al almacenar en búfer los mensajes y suavizar las cargas de procesamiento.

Sin embargo, las colas de mensajes también tienen desventajas. Introducen complejidad en el diseño del sistema y requieren infraestructura adicional para el software de encolado de mensajes. Asegurar la entrega de mensajes y manejar el orden de los mensajes puede ser un desafío. La depuración de sistemas distribuidos que se basan en colas de mensajes puede ser más difícil que la depuración de aplicaciones monolíticas. Finalmente, las colas de mensajes pueden introducir latencia, ya que los mensajes deben ser serializados, transmitidos y deserializados.

13. Explique el concepto de idempotencia en el diseño de API.

La idempotencia en el diseño de API significa que una operación, cuando se llama varias veces con la misma entrada, produce el mismo resultado que si se llamara solo una vez. Asegura que las solicitudes repetidas tengan el mismo efecto que una sola solicitud, evitando efectos secundarios no deseados.

Por ejemplo, una solicitud PUT para actualizar un recurso debe ser idempotente. Si la primera solicitud actualiza correctamente el recurso, las solicitudes idénticas subsiguientes no deben cambiar el recurso. Por otro lado, una solicitud POST para crear un nuevo recurso típicamente no es idempotente porque cada llamada crea un nuevo recurso. Para lograr la idempotencia, las API a menudo utilizan identificadores únicos (por ejemplo, UUIDs) proporcionados por el cliente. Si la API recibe una solicitud con un ID existente, devuelve el recurso existente en lugar de crear un duplicado.

14. ¿Cómo manejaría las transacciones en un sistema distribuido?

Manejar transacciones en un sistema distribuido es complejo debido al teorema CAP. Los enfoques comunes incluyen el uso del commit de dos fases (2PC), que garantiza la atomicidad pero puede sufrir problemas de rendimiento y puntos únicos de fallo. Otro enfoque es el uso de la consistencia eventual con técnicas como las transacciones de compensación. Esto implica ejecutar transacciones locales y luego, si es necesario, ejecutar acciones de compensación para deshacer los efectos de las transacciones fallidas. Esto ofrece mejor disponibilidad y escalabilidad, pero requiere un diseño cuidadoso para garantizar la consistencia de los datos.

Alternativamente, podrías usar el patrón Saga, que divide una transacción distribuida en una secuencia de transacciones locales. Cada transacción local actualiza la base de datos y publica un evento. Otros servicios escuchan estos eventos y ejecutan sus propias transacciones locales. Si una de las transacciones locales falla, la saga ejecuta transacciones de compensación para deshacer los cambios realizados por las transacciones locales precedentes. Las sagas se pueden implementar usando coreografía (los servicios se comunican directamente entre sí) u orquestación (un orquestador central gestiona la saga).

15. Describe los diferentes tipos de patrones de diseño (por ejemplo, creacionales, estructurales, de comportamiento).

Los patrones de diseño se clasifican en tres tipos principales:

- Patrones creacionales: Tratan con mecanismos de creación de objetos, tratando de crear objetos de una manera adecuada a la situación. Ejemplos incluyen Singleton, Factory Method, Abstract Factory, Builder y Prototype.

- Patrones estructurales: Tratan con las relaciones entre objetos, enfocándose en cómo se componen las clases y los objetos para formar estructuras más grandes. Ejemplos incluyen Adapter, Bridge, Composite, Decorator, Facade, Flyweight y Proxy.

- Patrones de comportamiento: Tratan con algoritmos y la asignación de responsabilidades entre objetos, enfocándose en cómo los objetos interactúan y distribuyen responsabilidades. Ejemplos incluyen Chain of Responsibility, Command, Interpreter, Iterator, Mediator, Memento, Observer, State, Strategy, Template Method y Visitor.

16. Explique el concepto de diseño impulsado por el dominio (DDD).

El diseño impulsado por el dominio (DDD) es un enfoque de desarrollo de software que se centra en comprender y modelar el dominio empresarial. Enfatiza la estrecha colaboración entre expertos técnicos (desarrolladores) y expertos del dominio (partes interesadas del negocio) para crear un sistema de software que refleje con precisión los conceptos y procesos del dominio. La idea central es estructurar el código de una manera que refleje el dominio empresarial del mundo real que representa, lo que facilita la comprensión, el mantenimiento y la evolución.