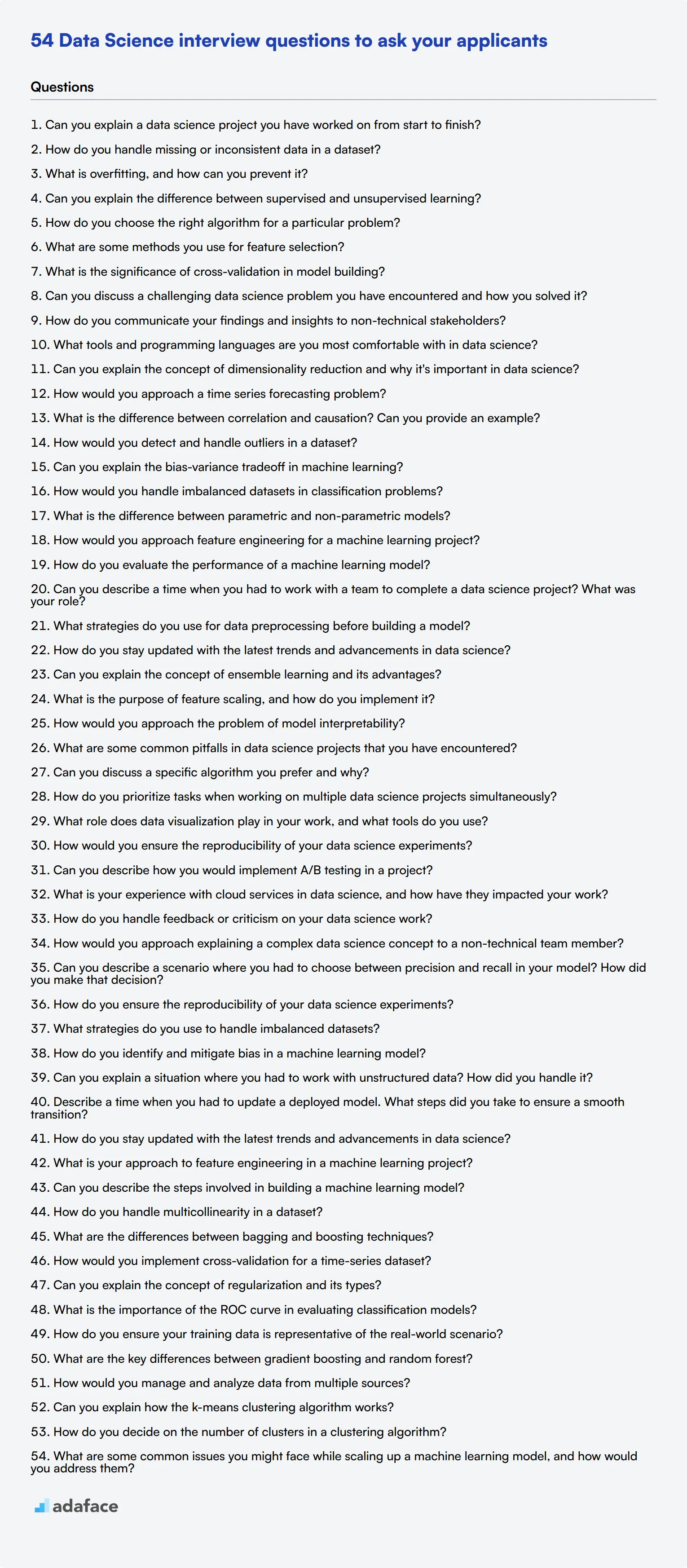

54 preguntas de entrevista de ciencia de datos para hacer a tus solicitantes

Realizar entrevistas para puestos de Data Science puede ser abrumador, especialmente dada la profundidad y amplitud técnica del campo. Contratar al candidato adecuado asegura que su negocio aproveche los datos de manera efectiva y mantenga una ventaja competitiva, como se describe en las habilidades clave requeridas para un científico de datos.

En esta publicación, proporcionamos una variedad de preguntas de entrevista de Data Science adaptadas a diferentes niveles de experiencia, desde candidatos junior hasta senior. También hemos incluido preguntas centradas en conceptos y metodologías técnicas para brindarle un conjunto de herramientas completo para sus entrevistas.

Usando estas preguntas, puede evaluar mejor la experiencia y el ajuste de los candidatos para el puesto. Para optimizar aún más su proceso de contratación, considere usar nuestro Test de Data Science antes de realizar las entrevistas.

Tabla de contenido

10 preguntas comunes de entrevista de Data Science para hacer a sus solicitantes

8 preguntas y respuestas de entrevista de Data Science para evaluar a los científicos de datos junior

15 preguntas y respuestas de entrevista de Data Science intermedias para hacer a los científicos de datos de nivel medio

9 preguntas y respuestas avanzadas de entrevista de Data Science para evaluar a los científicos de datos senior

12 preguntas de entrevista de Data Science sobre conceptos y metodologías técnicas

¿Qué habilidades de Data Science debe evaluar durante la fase de entrevista?

Optimice su proceso de contratación con pruebas de habilidades de ciencia de datos y preguntas de entrevista específicas

Descargue la plantilla de preguntas de entrevista de ciencia de datos en múltiples formatos

10 preguntas comunes de entrevista de ciencia de datos para hacer a sus solicitantes

Para evaluar eficazmente la competencia de sus solicitantes en ciencia de datos, considere usar estas preguntas comunes de entrevista. Le ayudarán a identificar si los candidatos poseen las habilidades y conocimientos necesarios para el puesto. Para obtener información detallada sobre las responsabilidades de un científico de datos, puede consultar la descripción del puesto de científico de datos.

- ¿Puede explicar un proyecto de ciencia de datos en el que haya trabajado de principio a fin?

- ¿Cómo maneja los datos faltantes o inconsistentes en un conjunto de datos?

- ¿Qué es el sobreajuste y cómo puede prevenirlo?

- ¿Puede explicar la diferencia entre aprendizaje supervisado y no supervisado?

- ¿Cómo elige el algoritmo correcto para un problema en particular?

- ¿Cuáles son algunos métodos que utiliza para la selección de características?

- ¿Cuál es la importancia de la validación cruzada en la construcción de modelos?

- ¿Puede discutir un problema desafiante de ciencia de datos que haya encontrado y cómo lo resolvió?

- ¿Cómo comunica sus hallazgos e ideas a las partes interesadas no técnicas?

- ¿Con qué herramientas y lenguajes de programación se siente más cómodo en la ciencia de datos?

8 preguntas y respuestas de entrevistas de ciencia de datos para evaluar a los científicos de datos junior

¿Listo para poner a prueba a sus científicos de datos junior? Estas ocho preguntas lo ayudarán a evaluar sus conocimientos fundamentales y sus habilidades para resolver problemas. Úselas para evaluar la comprensión de los candidatos sobre los conceptos clave y su capacidad para aplicar los principios de la ciencia de datos en escenarios del mundo real. ¡Recuerde, el objetivo es evaluar el potencial, no solo la experiencia actual!

1. ¿Puede explicar el concepto de reducción de dimensionalidad y por qué es importante en la ciencia de datos?

La reducción de dimensionalidad es una técnica utilizada para reducir el número de características en un conjunto de datos, conservando la mayor cantidad posible de información importante. Es crucial en la ciencia de datos por varias razones:

• Mejora el rendimiento del modelo al reducir el ruido y el sobreajuste • Acelera el tiempo de cálculo • Ayuda con la visualización de datos al reducir las dimensiones a 2D o 3D • Aborda la "maldición de la dimensionalidad" en conjuntos de datos de alta dimensión

Busque candidatos que puedan explicar el concepto claramente y proporcionar ejemplos de técnicas de reducción de dimensionalidad como PCA o t-SNE. Las respuestas sólidas también abordarán las compensaciones entre la pérdida de información y la eficiencia computacional.

2. ¿Cómo abordaría un problema de pronóstico de series de tiempo?

Un enfoque sólido para el pronóstico de series de tiempo típicamente involucra los siguientes pasos:

- Exploración y visualización de datos para comprender patrones, tendencias y estacionalidad

- Preprocesamiento de datos, incluyendo el manejo de valores faltantes y valores atípicos

- Descomposición de la serie de tiempo en componentes de tendencia, estacionales y residuales

- Selección de modelos apropiados (por ejemplo, ARIMA, Prophet o LSTM)

- Entrenamiento del modelo y ajuste de hiperparámetros

- Evaluación del rendimiento del modelo utilizando métricas como RMSE o MAPE

- Hacer predicciones y evaluar la incertidumbre del pronóstico

Preste atención a los candidatos que mencionen la importancia del preprocesamiento de datos y la selección de modelos basada en las características específicas de la serie temporal. Las respuestas sólidas también discutirán los desafíos de los datos de series temporales, como la autocorrelación y la no estacionariedad.

3. ¿Cuál es la diferencia entre correlación y causalidad? ¿Puede proporcionar un ejemplo?

La correlación se refiere a una relación estadística entre dos variables, lo que indica que tienden a cambiar juntas. La causalidad, por otro lado, implica que los cambios en una variable causan directamente cambios en otra.

Un ejemplo clásico es la correlación entre las ventas de helados y los incidentes de ahogamiento. Si bien existe una correlación positiva entre los dos, las ventas de helados no causan ahogamientos. En cambio,, ambos aumentan durante los meses de verano debido al clima más cálido.

Busque candidatos que puedan distinguir claramente entre los dos conceptos y proporcionar sus propios ejemplos. Las respuestas sólidas también mencionarán la frase "la correlación no implica causalidad" y discutirán métodos para establecer la causalidad, como ensayos controlados aleatorios o experimentos naturales.

4. ¿Cómo detectaría y gestionaría los valores atípicos en un conjunto de datos?

La detección y gestión de valores atípicos es un paso crucial en el preprocesamiento de datos. Algunos métodos comunes para la detección de valores atípicos incluyen:

• Métodos estadísticos: puntuación Z, RIC (Rango Intercuartílico) • Técnicas de visualización: diagramas de caja, diagramas de dispersión • Enfoques de aprendizaje automático: Bosque de Aislamiento, Factor de Valor Atípico Local

Una vez detectados, los valores atípicos se pueden gestionar: • Eliminándolos si se deben a errores • Transformando los datos (por ejemplo, transformación logarítmica) • Limitándolos a un cierto valor (winsorización) • Utilizando métodos estadísticos robustos que son menos sensibles a los valores atípicos

Evalúe a los candidatos en función de su comprensión de los diferentes métodos de detección y su capacidad para explicar cuándo y por qué utilizar cada enfoque para gestionar los valores atípicos. Las respuestas sólidas también considerarán el impacto del tratamiento de valores atípicos en el análisis general.

5. ¿Puede explicar la compensación entre sesgo y varianza en el aprendizaje automático?

La compensación entre sesgo y varianza es un concepto fundamental en el aprendizaje automático que describe la relación entre la complejidad de un modelo y su rendimiento en los datos de entrenamiento y prueba.

• Sesgo: El error introducido al aproximar un problema del mundo real con un modelo simplificado. Un sesgo alto puede conducir al subajuste. • Varianza: La sensibilidad del modelo a pequeñas fluctuaciones en los datos de entrenamiento. Una varianza alta puede conducir al sobreajuste.

Busque candidatos que puedan explicar que el aumento de la complejidad del modelo normalmente reduce el sesgo pero aumenta la varianza, y viceversa. Las respuestas sólidas discutirán cómo esta compensación afecta la selección del modelo y la importancia de encontrar el equilibrio adecuado para lograr un rendimiento óptimo en datos no vistos.

6. ¿Cómo manejaría conjuntos de datos desequilibrados en problemas de clasificación?

Manejar conjuntos de datos desequilibrados es crucial para construir modelos de clasificación efectivos. Algunos enfoques comunes incluyen:

- Técnicas de remuestreo: • Sobremuestreo de la clase minoritaria (por ejemplo, SMOTE) • Submuestreo de la clase mayoritaria • Combinación de ambos (por ejemplo, SMOTEENN)

- Enfoques algorítmicos: • Usar algoritmos que manejen bien el desequilibrio (por ejemplo, árboles de decisión) • Ajustar los pesos de clase

- Métodos de conjunto: • Bagging, boosting con un enfoque en la clase minoritaria

- Cambiar la métrica de rendimiento: • Usar F1-score, ROC AUC o curva de precisión-exhaustividad en lugar de exactitud

Evalúe a los candidatos en función de su comprensión de las diferentes técnicas y su capacidad para explicar cuándo usar cada enfoque. Las respuestas sólidas también discutirán la importancia de elegir métricas de evaluación apropiadas para conjuntos de datos desequilibrados.

7. ¿Cuál es la diferencia entre modelos paramétricos y no paramétricos?

Los modelos paramétricos asumen una forma funcional específica para la relación entre las características y la variable objetivo, con un número fijo de parámetros. Ejemplos incluyen la regresión lineal y la regresión logística. Los modelos no paramétricos, por otro lado, no hacen fuertes suposiciones sobre la forma de la función de mapeo y pueden flexionar su complejidad según sea necesario. Ejemplos incluyen árboles de decisión y k-vecinos más cercanos.

Diferencias clave: • Los modelos paramétricos suelen ser más simples y rápidos de entrenar • Los modelos no paramétricos pueden capturar relaciones más complejas, pero pueden requerir más datos • Los modelos paramétricos son más interpretables, mientras que los modelos no paramétricos pueden ser vistos como 'cajas negras'

Busque candidatos que puedan explicar estas diferencias claramente y proporcionar ejemplos de cada tipo de modelo. Las respuestas sólidas también discutirán las compensaciones entre los dos enfoques y cuándo usar cada uno en escenarios del mundo real.

8. ¿Cómo abordaría la ingeniería de características para un proyecto de aprendizaje automático?

La ingeniería de características es el proceso de crear nuevas características o transformar las existentes para mejorar el rendimiento del modelo. Un buen enfoque típicamente implica:

- Comprendiendo el dominio y el problema

- Explorando los datos para identificar patrones y relaciones

- Creando nuevas características basadas en el conocimiento del dominio

- Transformando características existentes (por ejemplo, transformación logarítmica, binning)

- Codificando variables categóricas

- Manejando datos temporales y espaciales

- Selección de características para identificar las características más relevantes

Evaluar a los candidatos en función de su capacidad para explicar la importancia de la ingeniería de características y proporcionar ejemplos específicos de técnicas que han utilizado. Las respuestas sólidas también discutirán la naturaleza iterativa de la ingeniería de características y su impacto en el rendimiento del modelo.

15 preguntas y respuestas intermedias de entrevistas de ciencia de datos para hacer a científicos de datos de nivel intermedio

Para evaluar si los candidatos poseen las habilidades y la experiencia necesarias para los roles de ciencia de datos de nivel intermedio, utilice este conjunto de preguntas de entrevista específicas. Estas preguntas le ayudarán a evaluar sus conocimientos técnicos y su aplicación en el mundo real en la ciencia de datos. Para obtener información más detallada sobre roles relacionados, no dude en explorar nuestra descripción de puesto de científico de datos.

- ¿Cómo evalúa el rendimiento de un modelo de aprendizaje automático?

- ¿Puede describir una ocasión en la que tuvo que trabajar con un equipo para completar un proyecto de ciencia de datos? ¿Cuál fue su papel?

- ¿Qué estrategias utiliza para el preprocesamiento de datos antes de construir un modelo?

- ¿Cómo se mantiene al día con las últimas tendencias y avances en la ciencia de datos?

- ¿Puede explicar el concepto de aprendizaje de conjunto y sus ventajas?

- ¿Cuál es el propósito del escalado de características y cómo lo implementa?

- ¿Cómo abordaría el problema de la interpretabilidad del modelo?

- ¿Cuáles son algunos de los errores comunes en los proyectos de ciencia de datos que ha encontrado?

- ¿Puede discutir un algoritmo específico que prefiera y por qué?

- ¿Cómo prioriza las tareas cuando trabaja en múltiples proyectos de ciencia de datos simultáneamente?

- ¿Qué papel juega la visualización de datos en su trabajo y qué herramientas utiliza?

- ¿Cómo garantizaría la reproducibilidad de sus experimentos de ciencia de datos?

- ¿Puede describir cómo implementaría las pruebas A/B en un proyecto?

- ¿Cuál es su experiencia con los servicios en la nube en la ciencia de datos y cómo han impactado su trabajo?

- ¿Cómo maneja los comentarios o críticas sobre su trabajo de ciencia de datos?

9 preguntas y respuestas avanzadas para entrevistas de ciencia de datos para evaluar a científicos de datos sénior

Para evaluar a científicos de datos sénior, es fundamental hacer preguntas que vayan más allá de lo básico y profundicen en sus conocimientos avanzados y capacidades de resolución de problemas. Esta lista de preguntas avanzadas para entrevistas lo ayudará a identificar a los candidatos que pueden abordar desafíos complejos de ciencia de datos e impulsar sus proyectos hacia el éxito.

1. ¿Cómo abordaría la explicación de un concepto complejo de ciencia de datos a un miembro del equipo no técnico?

Una explicación eficaz comienza por simplificar el concepto en ideas fundamentales que cualquiera pueda entender. Por ejemplo, en lugar de utilizar jerga técnica, utilice analogías o ejemplos del mundo real que sean fáciles de entender. El objetivo es hacer que el concepto sea accesible sin diluir su importancia.

Además, las ayudas visuales como gráficos y diagramas pueden facilitar la comprensión. También es fundamental evaluar periódicamente la comprensión del miembro del equipo y ajustar su explicación en consecuencia.

Busque candidatos que demuestren paciencia, adaptabilidad y excelentes habilidades de comunicación. La capacidad de traducir conceptos complejos a términos sencillos es crucial para garantizar la colaboración interfuncional.

2. ¿Puede describir un escenario en el que tuvo que elegir entre precisión y exhaustividad en su modelo? ¿Cómo tomó esa decisión?

La precisión y la exhaustividad son métricas cruciales, y la elección entre ellas depende del contexto específico del problema. Por ejemplo, en un sistema de diagnóstico médico, la exhaustividad (identificar todos los verdaderos positivos) podría priorizarse para garantizar que no se pasen por alto posibles casos, incluso si eso significa tener algunos falsos positivos.

Por el contrario, en un sistema de detección de spam, la precisión podría ser más crítica para evitar marcar correos electrónicos legítimos como spam. La decisión implica comprender las compensaciones y el impacto de los falsos positivos y los falsos negativos en el contexto dado.

Los candidatos ideales deben demostrar una sólida comprensión de estas métricas y proporcionar una justificación clara y basada en el contexto para su decisión. También deben ser capaces de discutir las implicaciones de su elección en el rendimiento general del sistema.

3. ¿Cómo asegura la reproducibilidad de sus experimentos de ciencia de datos?

La reproducibilidad es fundamental para verificar los resultados y construir sobre el trabajo anterior. Para asegurar la reproducibilidad, es esencial mantener una documentación clara de las fuentes de datos, los pasos de preprocesamiento y los parámetros del modelo utilizados en los experimentos.

El uso de sistemas de control de versiones como Git para rastrear los cambios en la base de código y las versiones de datos también puede ayudar. Además, las herramientas de contenedorización como Docker pueden crear entornos consistentes que replican la configuración del experimento en diferentes sistemas.

Los reclutadores deben buscar candidatos que enfaticen la documentación meticulosa y el uso del control de versiones y la contenedorización. Estas prácticas son vitales para la colaboración y el éxito de los proyectos a largo plazo.

4. ¿Qué estrategias utiliza para manejar conjuntos de datos desequilibrados?

Los conjuntos de datos desequilibrados pueden sesgar el rendimiento del modelo. Una estrategia es utilizar técnicas como el sobremuestreo de la clase minoritaria o el submuestreo de la clase mayoritaria para equilibrar el conjunto de datos. Por ejemplo, el algoritmo SMOTE (Técnica de sobremuestreo de la minoría sintética) puede generar muestras sintéticas de la clase minoritaria.

Otro enfoque es utilizar diferentes métricas de evaluación como la puntuación F1, las curvas de precisión-exhaustividad o el área bajo la curva de precisión-exhaustividad en lugar de la exactitud. Además, algoritmos como los métodos de conjunto (ensemble) pueden adaptarse para manejar mejor el desequilibrio de clases.

Los candidatos deben demostrar una comprensión profunda de estas técnicas y proporcionar ejemplos de cómo las han aplicado con éxito en proyectos anteriores. Su capacidad para elegir y justificar la estrategia correcta basándose en el contexto específico es fundamental.

5. ¿Cómo identifica y mitiga el sesgo en un modelo de aprendizaje automático?

La identificación del sesgo comienza con la comprensión de los datos y el contexto en el que se utilizará el modelo. El análisis de datos exploratorio puede revelar posibles sesgos en el conjunto de datos, como la sobrerrepresentación de ciertos grupos.

Las estrategias de mitigación incluyen técnicas como el remuestreo de los datos, el uso de algoritmos conscientes de la equidad y la incorporación de conocimientos del dominio para ajustar el modelo. El seguimiento continuo del rendimiento del modelo en diferentes subgrupos también es esencial.

Busque candidatos que puedan discutir ejemplos específicos de sesgo que hayan encontrado y cómo lo abordaron. Su enfoque debe reflejar un compromiso con la IA ética y la equidad en sus modelos.

6. ¿Puede explicar una situación en la que tuvo que trabajar con datos no estructurados? ¿Cómo lo manejó?

Los datos no estructurados, como texto, imágenes o audio, presentan desafíos únicos. El primer paso suele ser preprocesar los datos, lo que podría implicar técnicas como la tokenización para datos de texto o la extracción de características para imágenes.

Por ejemplo, en un proyecto de análisis de texto, podría utilizar técnicas de procesamiento del lenguaje natural (PNL) para convertir el texto en formatos estructurados como incrustaciones de palabras (word embeddings). Herramientas y bibliotecas como NLTK o spaCy pueden ser inestimables en este proceso.

Los candidatos deben demostrar su experiencia con herramientas y técnicas específicas para el manejo de datos no estructurados. Su capacidad para preprocesar y extraer características significativas de tales datos es crucial para la construcción de modelos efectivos.

7. Describa una situación en la que tuvo que actualizar un modelo implementado. ¿Qué pasos siguió para asegurar una transición fluida?

La actualización de un modelo implementado implica varios pasos para garantizar la continuidad y la precisión. En primer lugar, es importante validar exhaustivamente el nuevo modelo utilizando un conjunto de datos de retención o validación cruzada para asegurar que funcione mejor que el actual.

A continuación, implementar el nuevo modelo de forma escalonada, inicialmente en un entorno de prueba y gradualmente en producción, puede ayudar a detectar cualquier problema imprevisto. El monitoreo del rendimiento del modelo después de la implementación también es esencial para abordar rápidamente cualquier discrepancia.

Los reclutadores deben buscar candidatos que enfaticen la validación rigurosa y las estrategias de implementación cuidadosas. Su enfoque debe minimizar las interrupciones y asegurar la confiabilidad del modelo actualizado.

8. ¿Cómo se mantiene al día con las últimas tendencias y avances en la ciencia de datos?

Mantenerse actualizado es crucial en el campo de la ciencia de datos, que evoluciona rápidamente. Leer regularmente artículos de investigación, asistir a conferencias y participar en seminarios web son algunas formas efectivas de mantenerse al tanto de los últimos desarrollos.

Además, interactuar con la comunidad de ciencia de datos a través de plataformas como GitHub, Stack Overflow o foros especializados puede proporcionar información valiosa y fomentar el aprendizaje continuo.

Los candidatos ideales deben demostrar un enfoque proactivo para el aprendizaje y mantenerse actualizados. Su participación en la comunidad y su dedicación al desarrollo profesional son indicadores clave de su compromiso con el campo.

9. ¿Cuál es su enfoque para la ingeniería de características en un proyecto de aprendizaje automático?

La ingeniería de características implica la creación de nuevas características a partir de datos sin procesar que representen mejor el problema subyacente para el modelo. Este proceso puede impactar significativamente el rendimiento del modelo. Las técnicas pueden incluir agregación, normalización y la creación de términos de interacción.

Por ejemplo, en una tarea de predicción de ventas minoristas, la creación de características como 'crecimiento de ventas mes a mes' o 'indicador de temporada de vacaciones' puede proporcionar contexto adicional. El conocimiento del dominio juega un papel crucial en la identificación de características significativas.

Los candidatos deben ilustrar su enfoque metódico para la ingeniería de características y proporcionar ejemplos de cómo han mejorado el rendimiento del modelo a través de la creación innovadora de características. Su capacidad para aprovechar el conocimiento del dominio es un activo valioso.

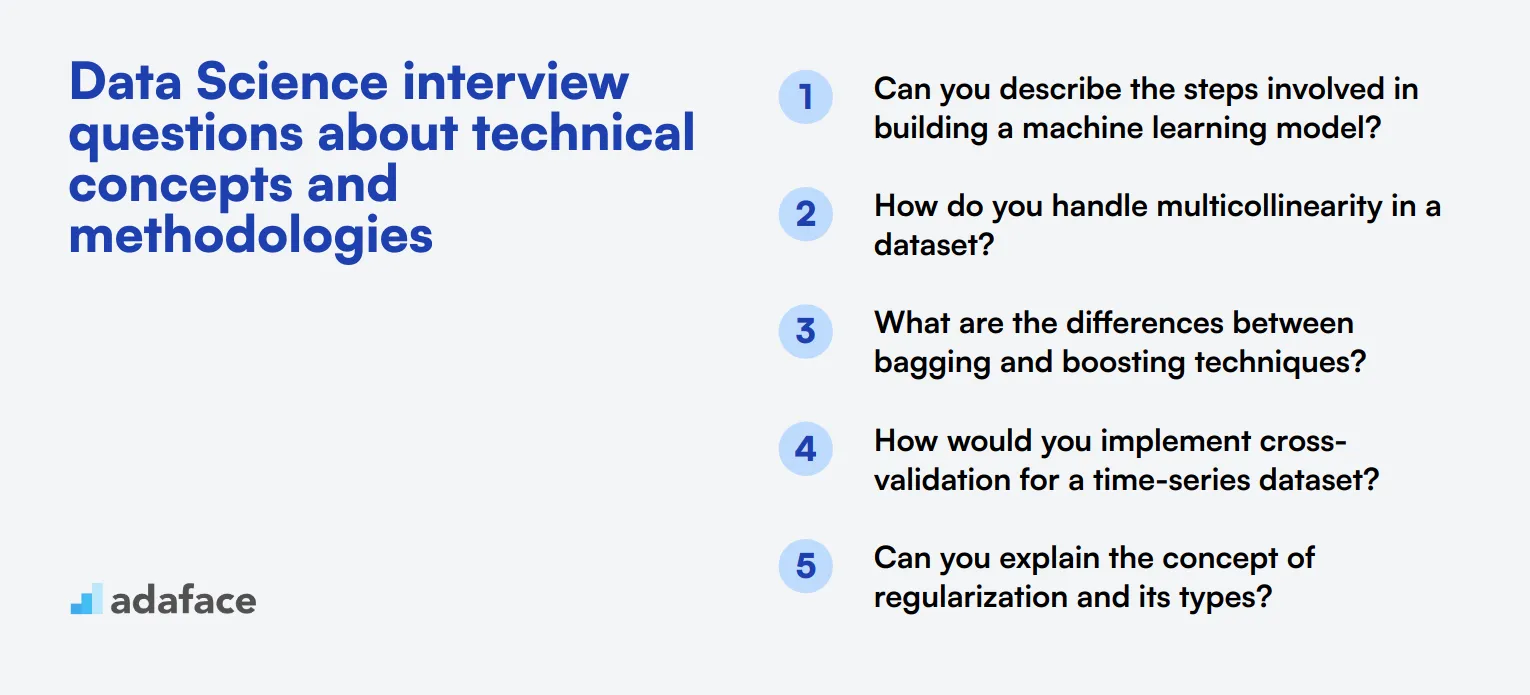

12 preguntas de entrevista de ciencia de datos sobre conceptos técnicos y metodologías

Para evaluar si sus candidatos tienen una sólida comprensión de los conceptos técnicos y metodologías en ciencia de datos, considere usar esta lista de preguntas de entrevista específicas. Estas preguntas están diseñadas para evaluar su profundidad de comprensión y habilidades para resolver problemas, asegurando que identifique a la persona adecuada para su equipo. Para obtener más detalles sobre los roles laborales, consulte la descripción del puesto de científico de datos.

- ¿Puede describir los pasos involucrados en la construcción de un modelo de aprendizaje automático?

- ¿Cómo maneja la multicolinealidad en un conjunto de datos?

- ¿Cuáles son las diferencias entre las técnicas de bagging y boosting?

- ¿Cómo implementaría la validación cruzada para un conjunto de datos de series temporales?

- ¿Puede explicar el concepto de regularización y sus tipos?

- ¿Cuál es la importancia de la curva ROC en la evaluación de modelos de clasificación?

- ¿Cómo se asegura de que sus datos de entrenamiento sean representativos del escenario del mundo real?

- ¿Cuáles son las diferencias clave entre el gradient boosting y el random forest?

- ¿Cómo gestionaría y analizaría datos de múltiples fuentes?

- ¿Puede explicar cómo funciona el algoritmo de clustering k-means?

- ¿Cómo decide el número de clusters en un algoritmo de clustering?

- ¿Cuáles son algunos problemas comunes que podría enfrentar al escalar un modelo de aprendizaje automático y cómo los abordaría?

¿Qué habilidades de ciencia de datos deberías evaluar durante la fase de entrevista?

Si bien es difícil evaluar cada aspecto de las habilidades de un candidato en ciencia de datos en una sola entrevista, concentrarse en las habilidades básicas es esencial. Las siguientes áreas clave proporcionan una base sólida para evaluar a los candidatos de ciencia de datos de manera efectiva.

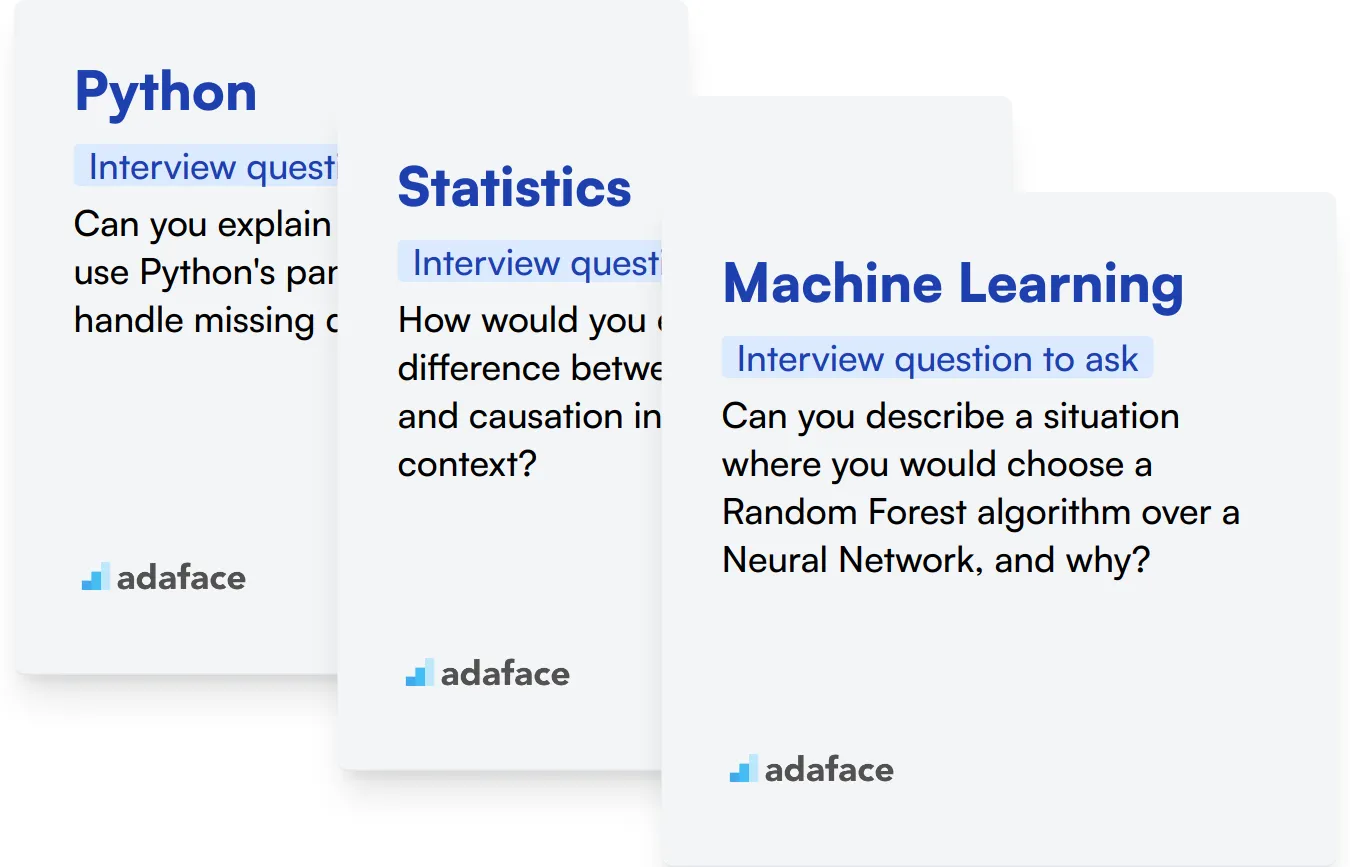

Python

Python es un lenguaje de programación fundamental en la ciencia de datos. Ofrece una amplia gama de bibliotecas y marcos diseñados específicamente para la manipulación, el análisis y las tareas de aprendizaje automático de datos.

Para evaluar la competencia en Python, considera usar una prueba de evaluación con preguntas de opción múltiple relevantes. Esto puede ayudar a filtrar a los candidatos en función de sus habilidades en Python de manera eficiente.

Durante la entrevista, puede hacer preguntas específicas para evaluar la experiencia del candidato en Python. Aquí hay un ejemplo de pregunta:

¿Puede explicar cómo usaría la biblioteca pandas de Python para manejar datos faltantes en un conjunto de datos?

Busque respuestas que demuestren la comprensión de funciones de pandas como dropna(), fillna(), o interpolate(). El candidato debe explicar los pros y los contras de diferentes enfoques y cuándo usar cada método.

Estadísticas

Una base sólida en estadística es crucial para los científicos de datos. Les permite interpretar datos, tomar decisiones informadas y validar sus hallazgos.

Considere usar una evaluación integral de ciencia de datos que incluya conceptos estadísticos para evaluar el conocimiento de los candidatos en esta área.

Para evaluar la comprensión estadística durante la entrevista, puede hacer una pregunta como:

¿Cómo explicaría la diferencia entre correlación y causalidad en un contexto de análisis de datos?

Busque respuestas que distingan claramente entre correlación (una relación estadística entre variables) y causalidad (una variable que influye directamente en otra). El candidato debe proporcionar ejemplos y explicar por qué esta distinción es importante en la interpretación de datos.

Aprendizaje automático

El aprendizaje automático es fundamental en muchas aplicaciones de ciencia de datos. Los candidatos deben comprender varios algoritmos, sus aplicaciones y cómo implementarlos eficazmente.

Para evaluar los conocimientos de aprendizaje automático, puede utilizar una prueba en línea de aprendizaje automático que cubre conceptos clave y aplicaciones prácticas.

Durante la entrevista, puede hacer una pregunta para evaluar la comprensión práctica del candidato sobre el aprendizaje automático:

¿Puede describir una situación en la que elegiría un algoritmo de Bosque Aleatorio en lugar de una Red Neuronal, y por qué?

Busque respuestas que demuestren comprensión de las fortalezas y debilidades de ambos algoritmos. El candidato debe mencionar factores como la interpretabilidad, el manejo de relaciones no lineales y el tamaño del conjunto de datos en su explicación.

Optimice su proceso de contratación con pruebas de habilidades de ciencia de datos y preguntas de entrevista específicas

Si busca contratar a alguien con habilidades en ciencia de datos, es importante verificar estas habilidades con precisión para asegurarse de que está considerando a los mejores candidatos.

La forma más directa de evaluar estas habilidades es a través de pruebas de habilidades especializadas. Adaface ofrece una variedad de pruebas de ciencia de datos, pruebas de aprendizaje automático y otras que están diseñadas para medir eficazmente las capacidades de los solicitantes.

Después de administrar estas pruebas, puede preseleccionar con confianza a los mejores candidatos para las entrevistas, asegurándose de que solo los candidatos más calificados avancen en su proceso de contratación.

Para comenzar, regístrese en la plataforma de Adaface a través de este enlace, donde podrá acceder a nuestras pruebas y optimizar su estrategia de reclutamiento.

Prueba de evaluación de ciencia de datos

35 minutos | 18 preguntas de opción múltiple (MCQ)

La prueba de evaluación de ciencia de datos evalúa la competencia de un candidato en estadística, probabilidad, modelos de regresión lineal y no lineal y su capacidad para analizar datos y aprovechar Python/R para extraer información de los datos.

[

Prueba el Test de Evaluación de Ciencia de Datos

](https://www.adaface.com/assessment-test/data-science-test)

Descarga la plantilla de preguntas para entrevistas de Ciencia de Datos en múltiples formatos

Utiliza una combinación de preguntas técnicas, problemas prácticos y discusiones sobre proyectos pasados para evaluar sus habilidades y experiencia.

Concéntrate en el conocimiento estadístico, las habilidades de programación, los conceptos de aprendizaje automático, la manipulación de datos y las habilidades de resolución de problemas.

Ajusta la complejidad de las preguntas según el nivel de experiencia del candidato, desde conceptos básicos para los junior hasta temas avanzados para los senior.

Sí, incluir ejercicios prácticos puede ayudar a evaluar la capacidad de un candidato para aplicar sus conocimientos a problemas del mundo real.

Pídeles que expliquen conceptos complejos de Ciencia de Datos en términos sencillos o que presenten los resultados de un proyecto hipotético.

Next posts

- 70 preguntas de entrevista para consultores funcionales de SAP para hacer a los candidatos

- 46 preguntas de entrevista para consultores SAP FICO para hacer a los candidatos

- 79 Preguntas de entrevista para arquitectos de información para contratar a los mejores talentos

- 60 preguntas de entrevista para Gerentes de Éxito del Cliente para hacer a tus candidatos

- 67 preguntas de entrevista para especialistas en SEO para contratar al mejor talento