Test Duration

40 minsDifficulty Level

Moderate

Questions

- 5 Site Reliability Engineering MCQs

- 5 DevOps MCQs

- 3 Docker MCQs

- 3 Kubernetes MCQs

Availability

Ready to useThe Site Reliability Engineer (SRE) Test uses scenario-based questions to evaluate knowledge of cloud technologies, system design, automation, and troubleshooting skills. It assesses understanding of infrastructure as code, continuous integration and deployment, and monitoring systems. The test also measures proficiency in scripting languages and hands-on coding for infrastructure problem-solving. It further includes real-world situations to examine critical thinking and incident management abilities.

Covered skills:

Test Duration

40 minsDifficulty Level

Moderate

Questions

Availability

Ready to useThe Site Reliability Test helps recruiters and hiring managers identify qualified candidates from a pool of resumes, and helps in taking objective hiring decisions. It reduces the administrative overhead of interviewing too many candidates and saves time by filtering out unqualified candidates at the first step of the hiring process.

The test screens for the following skills that hiring managers look for in candidates:

Use Adaface tests trusted by recruitment teams globally. Adaface skill assessments measure on-the-job skills of candidates, providing employers with an accurate tool for screening potential hires.

We have a very high focus on the quality of questions that test for on-the-job skills. Every question is non-googleable and we have a very high bar for the level of subject matter experts we onboard to create these questions. We have crawlers to check if any of the questions are leaked online. If/ when a question gets leaked, we get an alert. We change the question for you & let you know.

How we design questionsThese are just a small sample from our library of 15,000+ questions. The actual questions on this Site Reliability Test will be non-googleable.

| 🧐 Question | |||||

|---|---|---|---|---|---|

|

Medium

Error Budget Management

|

Solve

|

||||

|

|

|||||

|

Medium

Incident Response Procedure

|

Solve

|

||||

|

|

|||||

|

Medium

Service Balancer Decision-making

|

Solve

|

||||

|

|

|||||

|

Medium

Resource Analysis

|

Solve

|

||||

|

|

|||||

|

Medium

Streamlined DevOps

|

Solve

|

||||

|

|

|||||

|

Medium

Docker Multistage Build Analysis

|

Solve

|

||||

|

|

|||||

|

Easy

Docker Networking and Volume Mounting Interplay

|

Solve

|

||||

|

|

|||||

|

Medium

Dockerfile Optimization

|

Solve

|

||||

|

|

|||||

|

Medium

Dockerfile Updates

|

Solve

|

||||

|

|

|||||

|

Medium

Efficient Dockerfile

|

Solve

|

||||

|

|

|||||

|

Medium

ConfigMap and Secrets Interaction

|

Solve

|

||||

|

|

|||||

|

Medium

Ingress from namespace

|

Solve

|

||||

|

|

|||||

|

Medium

Pod Affinity and Resource Quota Compliance

|

Solve

|

||||

|

|

|||||

|

Easy

Resource limits

|

Solve

|

||||

|

|

|||||

| 🧐 Question | 🔧 Skill | ||

|---|---|---|---|

|

Medium

Error Budget Management

|

3 mins Site Reliability Engineering

|

Solve

|

|

|

Medium

Incident Response Procedure

|

3 mins Site Reliability Engineering

|

Solve

|

|

|

Medium

Service Balancer Decision-making

|

2 mins Site Reliability Engineering

|

Solve

|

|

|

Medium

Resource Analysis

|

3 mins DevOps

|

Solve

|

|

|

Medium

Streamlined DevOps

|

2 mins DevOps

|

Solve

|

|

|

Medium

Docker Multistage Build Analysis

|

3 mins Docker

|

Solve

|

|

|

Easy

Docker Networking and Volume Mounting Interplay

|

3 mins Docker

|

Solve

|

|

|

Medium

Dockerfile Optimization

|

2 mins Docker

|

Solve

|

|

|

Medium

Dockerfile Updates

|

2 mins Docker

|

Solve

|

|

|

Medium

Efficient Dockerfile

|

2 mins Docker

|

Solve

|

|

|

Medium

ConfigMap and Secrets Interaction

|

2 mins Kubernetes

|

Solve

|

|

|

Medium

Ingress from namespace

|

3 mins Kubernetes

|

Solve

|

|

|

Medium

Pod Affinity and Resource Quota Compliance

|

2 mins Kubernetes

|

Solve

|

|

|

Easy

Resource limits

|

3 mins Kubernetes

|

Solve

|

| 🧐 Question | 🔧 Skill | 💪 Difficulty | ⌛ Time | ||

|---|---|---|---|---|---|

|

Error Budget Management

|

Site Reliability Engineering

|

Medium | 3 mins |

Solve

|

|

|

Incident Response Procedure

|

Site Reliability Engineering

|

Medium | 3 mins |

Solve

|

|

|

Service Balancer Decision-making

|

Site Reliability Engineering

|

Medium | 2 mins |

Solve

|

|

|

Resource Analysis

|

DevOps

|

Medium | 3 mins |

Solve

|

|

|

Streamlined DevOps

|

DevOps

|

Medium | 2 mins |

Solve

|

|

|

Docker Multistage Build Analysis

|

Docker

|

Medium | 3 mins |

Solve

|

|

|

Docker Networking and Volume Mounting Interplay

|

Docker

|

Easy | 3 mins |

Solve

|

|

|

Dockerfile Optimization

|

Docker

|

Medium | 2 mins |

Solve

|

|

|

Dockerfile Updates

|

Docker

|

Medium | 2 mins |

Solve

|

|

|

Efficient Dockerfile

|

Docker

|

Medium | 2 mins |

Solve

|

|

|

ConfigMap and Secrets Interaction

|

Kubernetes

|

Medium | 2 mins |

Solve

|

|

|

Ingress from namespace

|

Kubernetes

|

Medium | 3 mins |

Solve

|

|

|

Pod Affinity and Resource Quota Compliance

|

Kubernetes

|

Medium | 2 mins |

Solve

|

|

|

Resource limits

|

Kubernetes

|

Easy | 3 mins |

Solve

|

With Adaface, we were able to optimise our initial screening process by upwards of 75%, freeing up precious time for both hiring managers and our talent acquisition team alike!

Brandon Lee, Head of People, Love, Bonito

It's very easy to share assessments with candidates and for candidates to use. We get good feedback from candidates about completing the tests. Adaface are very responsive and friendly to deal with.

Kirsty Wood, Human Resources, WillyWeather

We were able to close 106 positions in a record time of 45 days! Adaface enables us to conduct aptitude and psychometric assessments seamlessly. My hiring managers have never been happier with the quality of candidates shortlisted.

Amit Kataria, CHRO, Hanu

We evaluated several of their competitors and found Adaface to be the most compelling. Great library of questions that are designed to test for fit rather than memorization of algorithms.

Swayam Narain, CTO, Affable

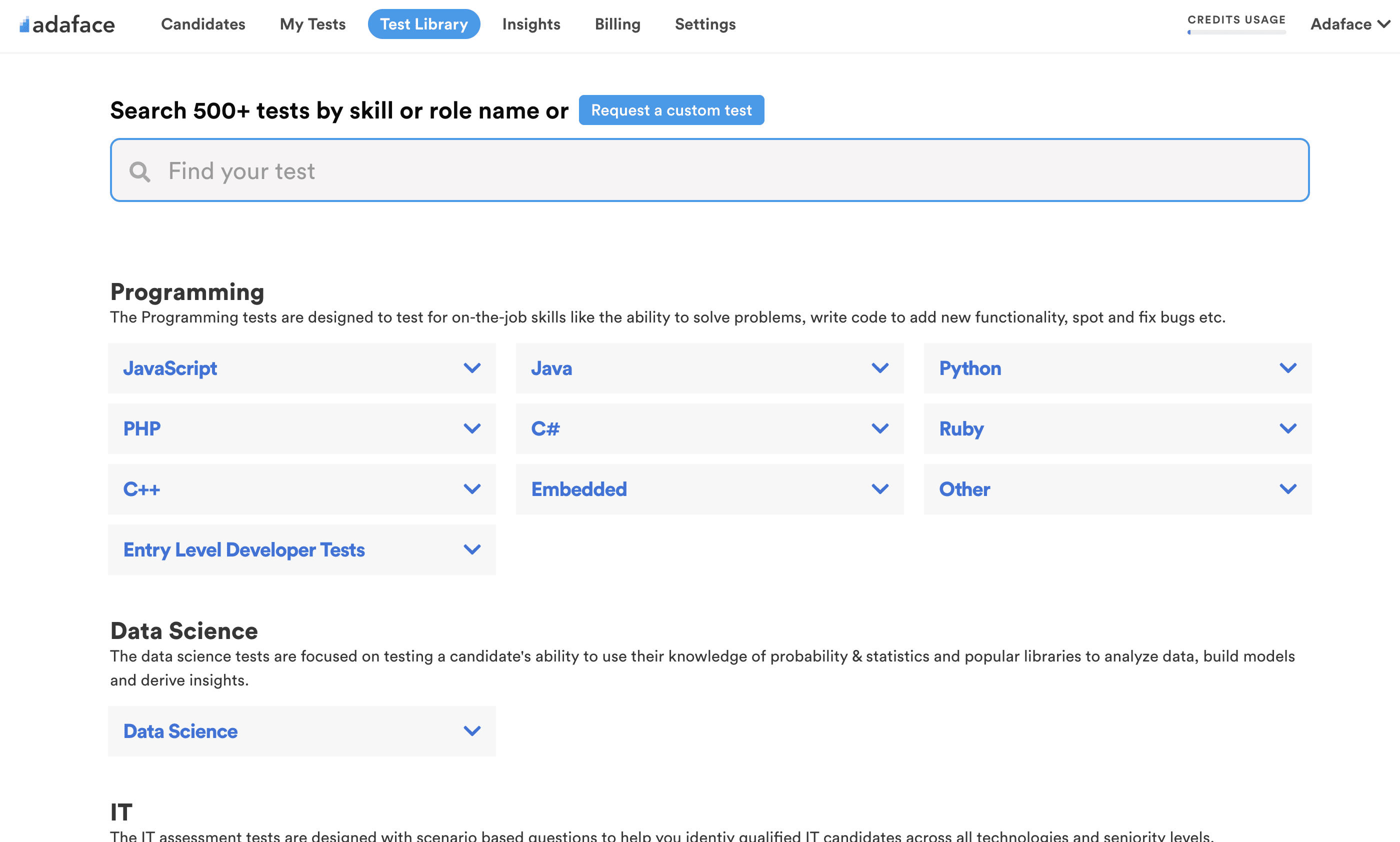

The Adaface test library features 500+ tests to enable you to test candidates on all popular skills- everything from programming languages, software frameworks, devops, logical reasoning, abstract reasoning, critical thinking, fluid intelligence, content marketing, talent acquisition, customer service, accounting, product management, sales and more.

The Site Reliability Test evaluates candidates' skills in site reliability engineering, focusing on system design, infrastructure, CI/CD, and related areas. It's used by recruiters to find candidates proficient in maintaining reliable and scalable systems.

Yes, you can create a custom test that includes AWS questions. We also offer a dedicated AWS DevOps Test to assess AWS skills in detail.

For senior roles, the test evaluates:

Use our assessment as a pre-screening tool at the start of your hiring process. Add a link to the test in your job post or invite candidates via email.

The main DevOps tests include:

Yes, absolutely. Custom assessments are set up based on your job description, and will include questions on all must-have skills you specify. Here's a quick guide on how you can request a custom test.

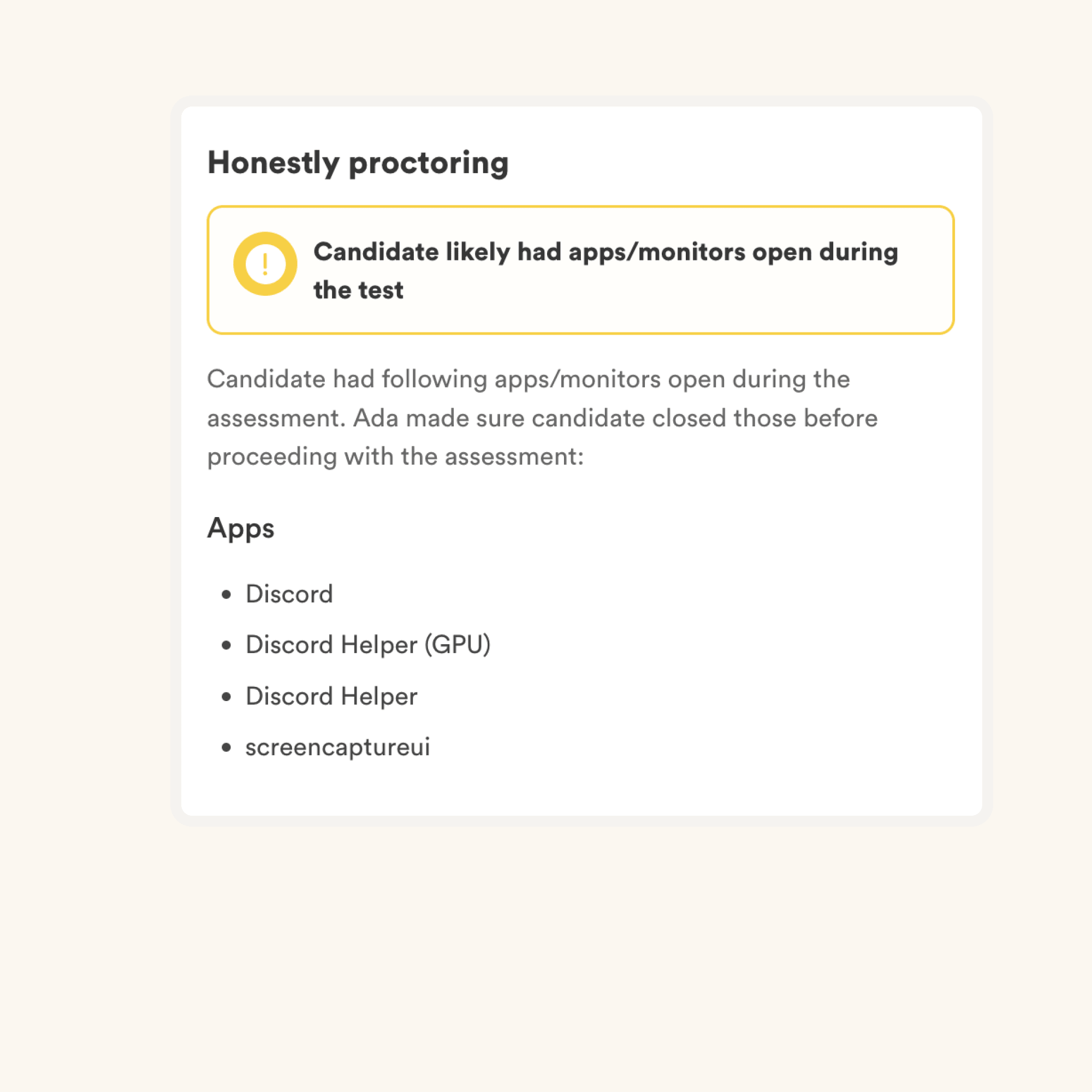

We have the following anti-cheating features in place:

Read more about the proctoring features.

The primary thing to keep in mind is that an assessment is an elimination tool, not a selection tool. A skills assessment is optimized to help you eliminate candidates who are not technically qualified for the role, it is not optimized to help you find the best candidate for the role. So the ideal way to use an assessment is to decide a threshold score (typically 55%, we help you benchmark) and invite all candidates who score above the threshold for the next rounds of interview.

Each Adaface assessment is customized to your job description/ ideal candidate persona (our subject matter experts will pick the right questions for your assessment from our library of 10000+ questions). This assessment can be customized for any experience level.

Yes, it makes it much easier for you to compare candidates. Options for MCQ questions and the order of questions are randomized. We have anti-cheating/ proctoring features in place. In our enterprise plan, we also have the option to create multiple versions of the same assessment with questions of similar difficulty levels.

No. Unfortunately, we do not support practice tests at the moment. However, you can use our sample questions for practice.

You can check out our pricing plans.

Yes, you can sign up for free and preview this test.

Here is a quick guide on how to request a custom assessment on Adaface.